Материалы по тегу: habana

|

13.05.2024 [11:12], Сергей Карасёв

Supermicro представила ИИ-серверы на базе Intel Gaudi3 и AMD Instinct MI300XКомпания Supermicro анонсировала новые серверы для задач ИИ и НРС. Дебютировали системы высокой плотности с жидкостным охлаждением, а также устройства, оборудованные высокопроизводительными ускорителями AMD, Intel и NVIDIA.

Источник изображений: Supermicro В частности, представлены серверы SYS-421GE-TNHR2-LCC и AS-4125GS-TNHR2-LCC в форм-факторе 4U, оснащённые СЖО. Первая из этих моделей рассчитана на установку двух процессоров Intel Xeon Emerald Rapids или Xeon Sapphire Rapids (до 385 Вт), а также 32 модулей DDR5-5600. Второй сервер поддерживает два чипа AMD EPYC 9004 Genoa с показателем TDP до 400 Вт и 24 модуля DDR5-4800. Обе новинки могут быть оборудованы восемью ускорителями NVIDIA H100 (SXM). В одной стойке могут размещаться до восьми серверов, что в сумме даст 64 ускорителя. При этом общая заявленная производительность такого кластера на операциях FP16 превышает 126 Пфлопс. Серверы оборудованы восемью фронтальными отсеками для SFF-накопителей NVMe. Питание обеспечивают четыре блока мощностью 5250 Вт с сертификатом Titanium. Слоты расширения выполнены по схеме 8 × PCIe 5.0 x16 LP и 2 × PCIe 5.0 x16 FHHL. На ISC 2024 компания Supermicro также демонстрирует сервер типоразмера 8U, оборудованный ускорителями Intel Gaudi3. Это одна из первых систем такого рода. Кроме того, представлена система AS-8125GS-TNMR2 формата 8U, рассчитанная на восемь ускорителей AMD Instinct MI300X. Этот сервер может комплектоваться двумя процессорами EPYC 9004 с TDP до 400 Вт, 24 модулями оперативной памяти DDR5-4800, фронтальными накопителями SFF (16 × NVMe и 2 × SATA), двумя модулями M.2 NVMe. Установлены шесть блоков питания на 3000 Вт с сертификатом Titanium. Наконец, Supermicro готовит серверы формата 4U с жидкостным охлаждением, которые могут оснащаться восемью ускорителями NVIDIA H100 и H200. Компания демонстрирует на конференции ISC 2024 и другие системы для приложений ИИ, а также задач НРС.

15.04.2024 [15:15], Сергей Карасёв

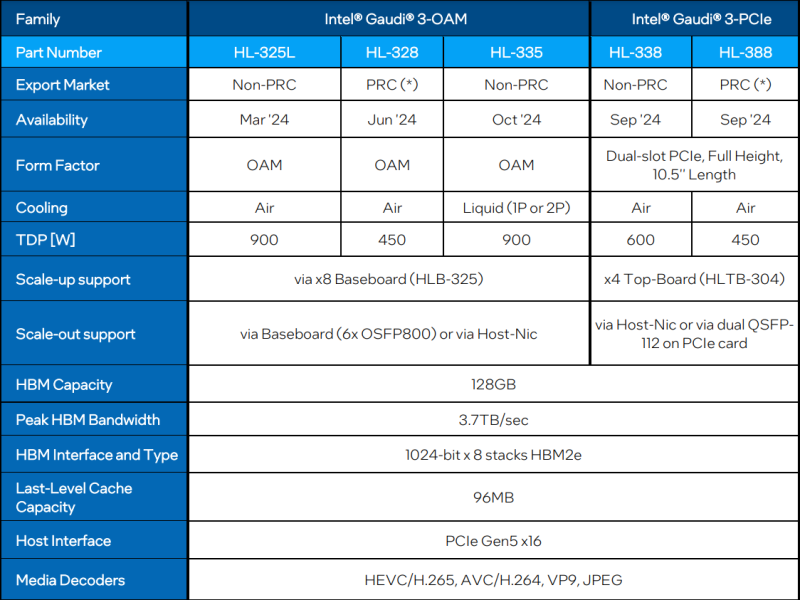

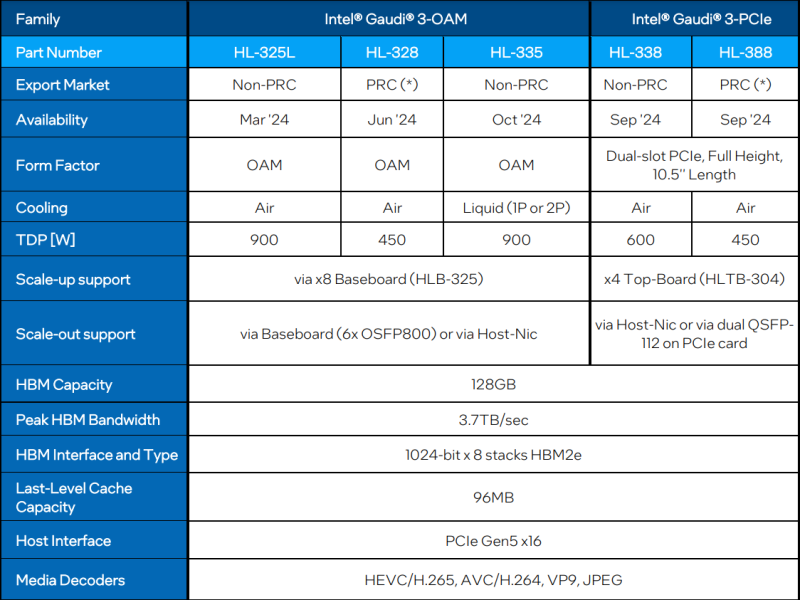

Intel готовит «урезанные» версии ИИ-ускорителя Gaudi3 для КитаяКорпорация Intel, как отмечает ресурс The Register, готовит специализированные модификации ИИ-ускорителя Gaudi3 для китайского рынка. Эти варианты из-за санкционных ограничений со стороны США будут отличаться от стандартных версий пониженным TDP и «урезанной» производительностью. Intel официально представила Gaudi3 менее недели назад. Изделие имеет чиплетную компоновку: оно состоит из двух одинаковых кристаллов с быстрым интерконнектом. В оснащение входят 128 Гбайт памяти HBM2e. Заявленная производительность FP8 и BF16 достигает 1835 Тфлопс (MME — блоки матричной математики). В семейство Gaudi3 входят ОАМ-версии HL-325L и HL-335 с показателем TDP в 900 Вт, а также PCIe-вариант HL-338 с TDP на уровне 600 Вт. Для Китая Intel предложит ОАМ-ускоритель HL-328 и PCIe-модификацию HL-388 — их поставки начнутся в июне и сентябре нынешнего года соответственно. Как и обычные изделия, ускорители для китайских заказчиков содержат два кристалла, а конфигурация памяти не изменилась — 128 Гбайт HBM2e с пропускной способностью 3,7 Тбайт/с. Вместе с тем величина TDP в обоих случаях снижена до 450 Вт. В соответствии с экспортными ограничениями со стороны США, в Китай запрещаются поставки чипов с производительностью BF16 более 150 Тфлопс. Как именно Intel ограничивает быстродействие в китайских версиях Gaudi3, не ясно. Это может достигаться за счёт снижения тактовой частоты или какого-то другого метода. При этом возможность объединения таких ускорителей в группы остаётся. Отмечается также, что в Китай, по всей видимости, не будут поставляться варианты Gaudi3 с жидкостным охлаждением. NVIDIA уже дважды меняла характеристики ускорителей, чтобы обойти санкции США в отношении Китая, причём компания успела выпустить существенный объём продукции, которую в итоге пришлось направить на другие рынки. Многие китайские компании успели накопить запасы ускорителей, которых хватит на ближайшие пару лет. AMD, как выяснилось, тоже подготовила «урезанную» версию ускорителя Instinct MI309, но Министерство торговли США всё равно не разрешило поставлять её Китаю.

12.04.2024 [21:28], Сергей Карасёв

Dell сумела сократить сроки поставок ИИ-серверов, но теперь компания полагается не только на ускорители NVIDIA, но и на Intel Gaudi3Компании Dell, по сообщению The Register, удалось сократить сроки поставок серверов для задач ИИ в несколько раз. Речь идёт о высокопроизводительных системах с ускорителями на основе GPU, в том числе NVIDIA H100. Спрос на них настолько высок, что производители не справляются с потоком заказов. О текущей ситуации в отрасли рассказал руководитель тайваньского подразделения Dell Теренс Ляо (Terence Liao). В конце 2023 года срок поставок серверов Dell, оборудованных ускорителями H100, составлял в среднем 39 недель, или около 8–9 месяцев. По словам Ляо, с февраля 2024-го отгрузки продукции NVIDIA значительно улучшились, и Dell смогла уменьшить сроки поставок серверов до 8–12 недель, или 2–3 месяцев. Таким образом, время выполнения заказов уменьшилось в три–четыре раза. Тем не менее, дефицит высокопроизводительных ИИ-ускорителей сохраняется. Связано это в том числе с возможностями TSMC по выпуску чипов с применением технологии CoWoS (Chip on Wafer on Substrate). Именно компоновка CoWoS применяется при изготовлении Н100. В сентябре 2023 года спрос на передовые технологии упаковки чипов был настолько высоким, что TSMC заявила о способности удовлетворить только 80 % заказов. Вместе с тем TSMC сообщила о намерении расширить производственные мощности CoWoS на 20 % — это поможет смягчить проблему дефицита ИИ-ускорителей. Между тем Dell приходится искать альтернативы ускорителям NVIDIA. В частности, она намерена использовать ИИ-ускорители Intel Gaudi3. Поддержка Gaudi3 заявлена для сервера Dell XE9680, который также поддерживает ускорители AMD Instinct MI300X. Эта ИИ-платформа наделена 32 слотами для модулей памяти DDR5, восемью разъёмами PCIe 5.0 и шестью портами OSFP 800GbE. Возможна установка 16 накопителей EDSFF3.

10.04.2024 [22:45], Алексей Степин

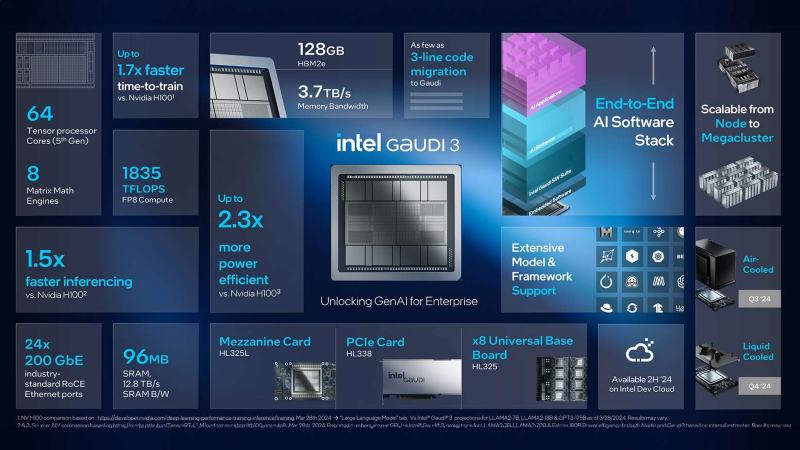

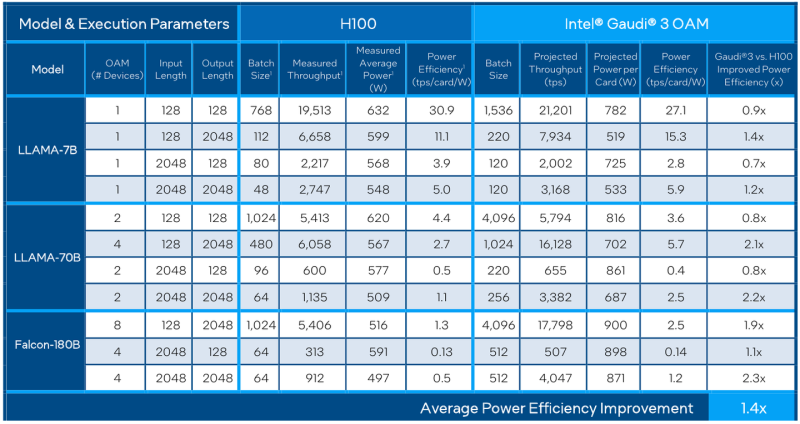

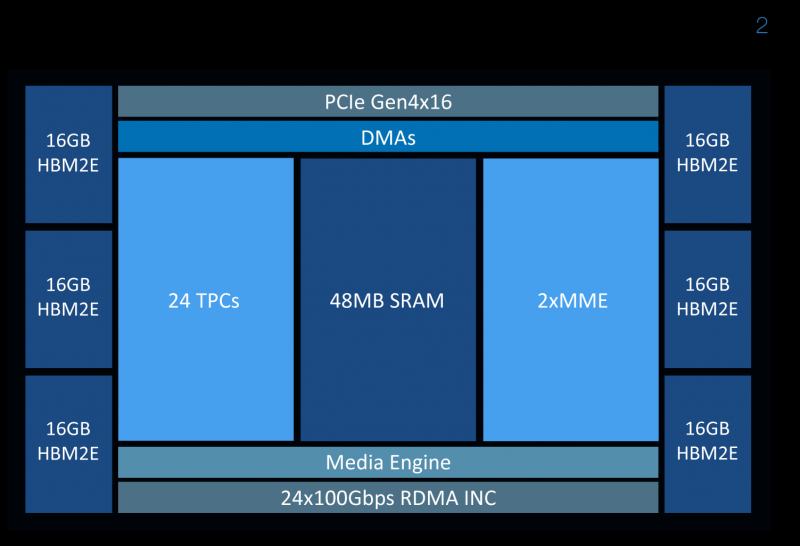

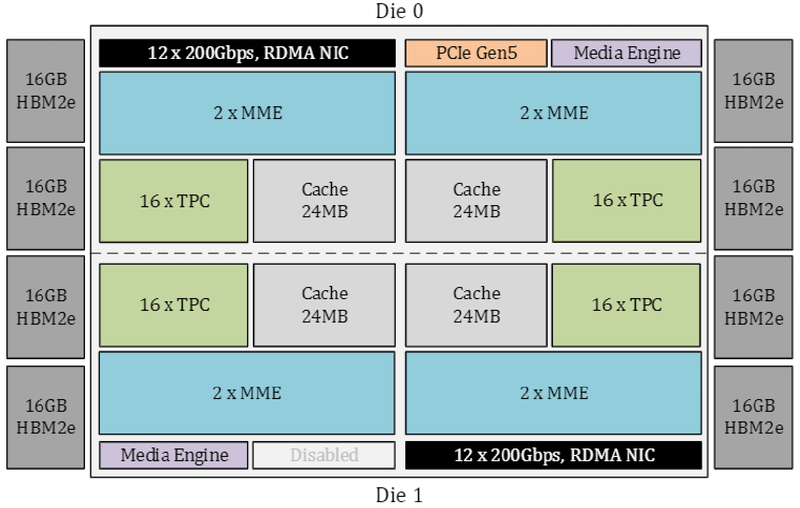

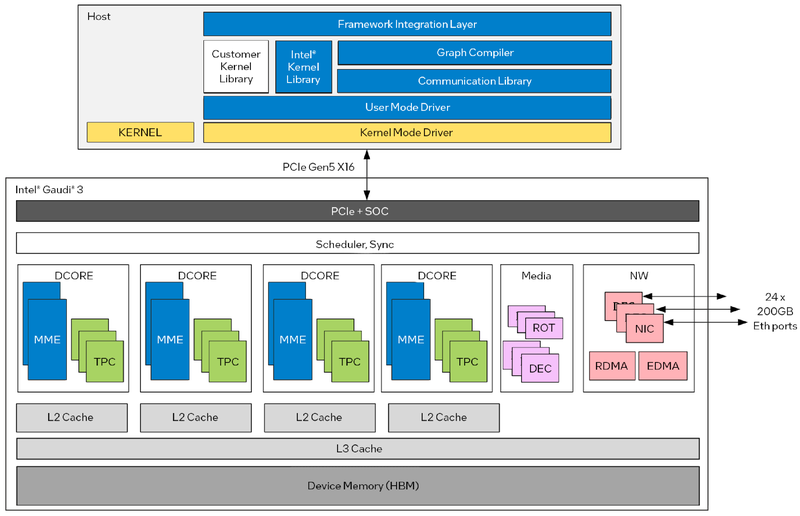

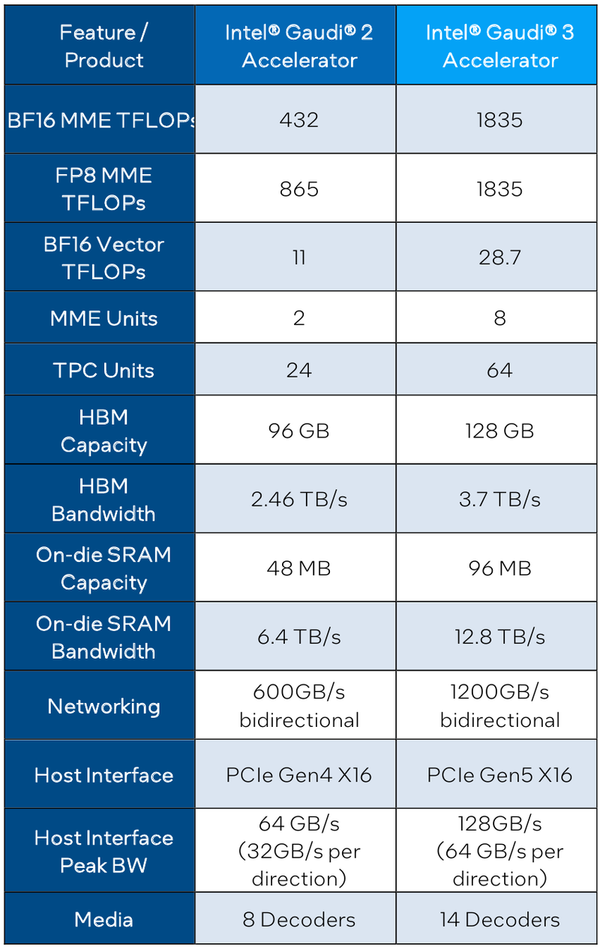

Intel Gaudi3 готов бросить вызов ИИ-ускорителям NVIDIAС момента анонса ускорителей Intel Habana Gaudi2 минуло два года и всё это время они достойно сражались с решениями NVIDIA, хоть и уступая в чистой производительности, но нередко выигрывая по показателю быстродействия в пересчёте на доллар. Теперь пришло время нового поколения — корпорация Intel анонсировала выпуск чипов Gaudi3 и ускорителей на их основе. Новый ИИ-процессор Gaudi3 взял на вооружение 5-нм техпроцесс TSMC, а также получил чиплетную компоновку, которая, впрочем, на логическом уровне никак себя не проявляет — Gaudi3 с точки зрения хоста остаётся монолитным ускорителем. Был увеличен с 96 до 128 Гбайт объём набортной памяти, но это по-прежнему HBM2e в отличие от решений основного соперника, давно перешедшего на HBM3. Intel выступила с достаточно серьёзным заявлением о 50 % превосходстве новинки в инференс-сценариях над NVIDIA H100, а также о 40 % преимуществе в энергоэффективности при существенно меньшей стоимости. Звучит многообещающе, особенно на фоне сочетания высоких цен с дефицитом со стороны «зелёных». Физически, как уже упоминалось, Gaudi3 состоит из двух одинаковых кристаллов, «сшитых» между собой быстрым низколатентным интерконнектом. Архитектурно чип подобен предшественнику и по-прежнему включает блоки матричной математики (MME) и кластеры программируемых тензорных процессоров (TPC), имеющих доступ к разделу быстрой памяти SRAM. Однако в сравнении с Gaudi2 количество блоков серьёзно выросло: вместо 2 MME в составе Gaudi3 теперь 8 таких блоков, а число тензорных процессоров увеличилось с 24 до 64. Вдвое, то есть с 48 до 96 Мбайт, вырос объём SRAM, а её пропускная способность возросла с 6,4 Тбайт/с до 12,8 Тбайт/с. Логически Gaudi3 делится на ядра DCORE (Deep Learning Core), в состав каждого входит два движка MME, 16 тензорных ядер и 24 Мбайт кеша L2.

Блок-схема Gaudi3 Усилен также блок медиадвижков, их в новом чипе 14 против 8 у Gaudi2. Всё это не могло не сказаться на тепловыделении: несмотря на применение 5-нм техпроцесса теплопакет у флагманского варианта составляет целых 900 Вт, хотя в новом модельном ряду есть и не столь горячие версии с TDP 600 и 450 Вт. Последний вариант предназначен для экспорта в КНР.

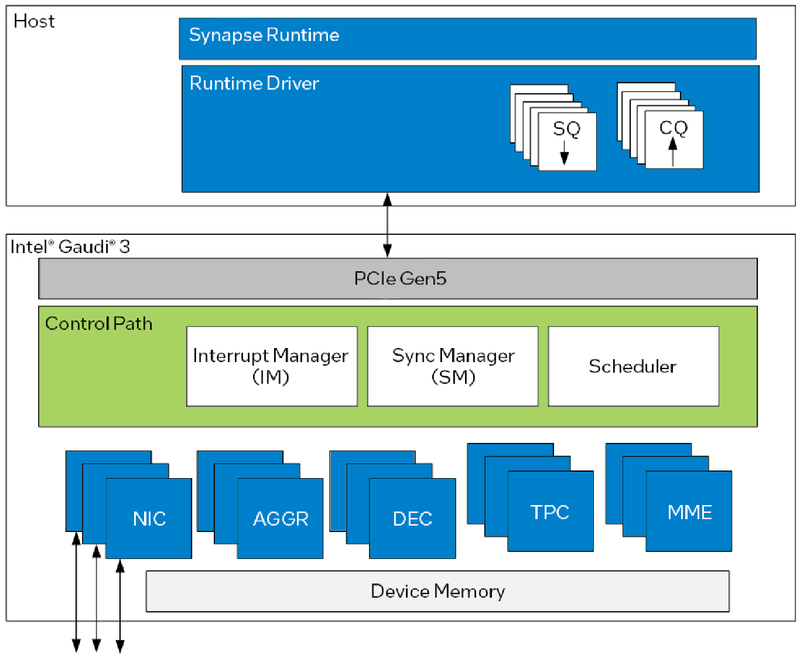

Архитектура Gaudi3 и его программная прослойка Поскольку объём HBM2e был увеличен с 96 до 128 Гбайт, в сборке используется не шесть, а восемь 16-Гбайт кристаллов, что позволило увеличить ПСП с 2,46 до 3,7 Тбайт/с. Работает память на частоте 3,6 ГГц. В составе Gaudi3 также имеется специализированный программируемый блок управления. Он отвечает за формирование очередей, управление прерываниями, синхронизацию, работу планировщика и имеет выход непосредственно на шину PCIe.

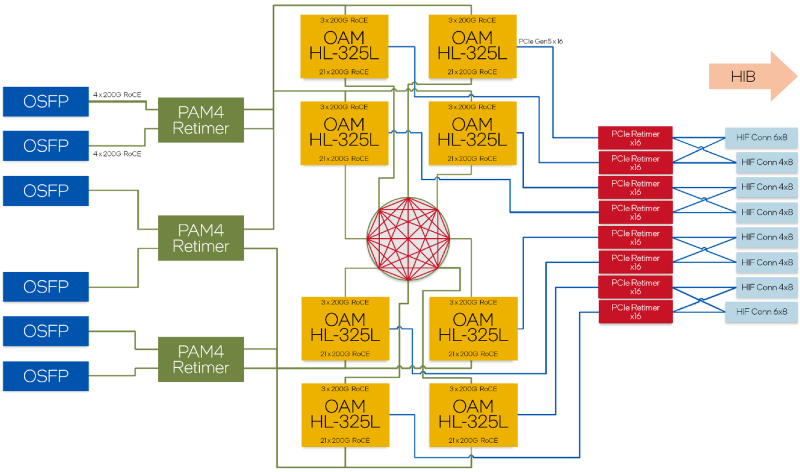

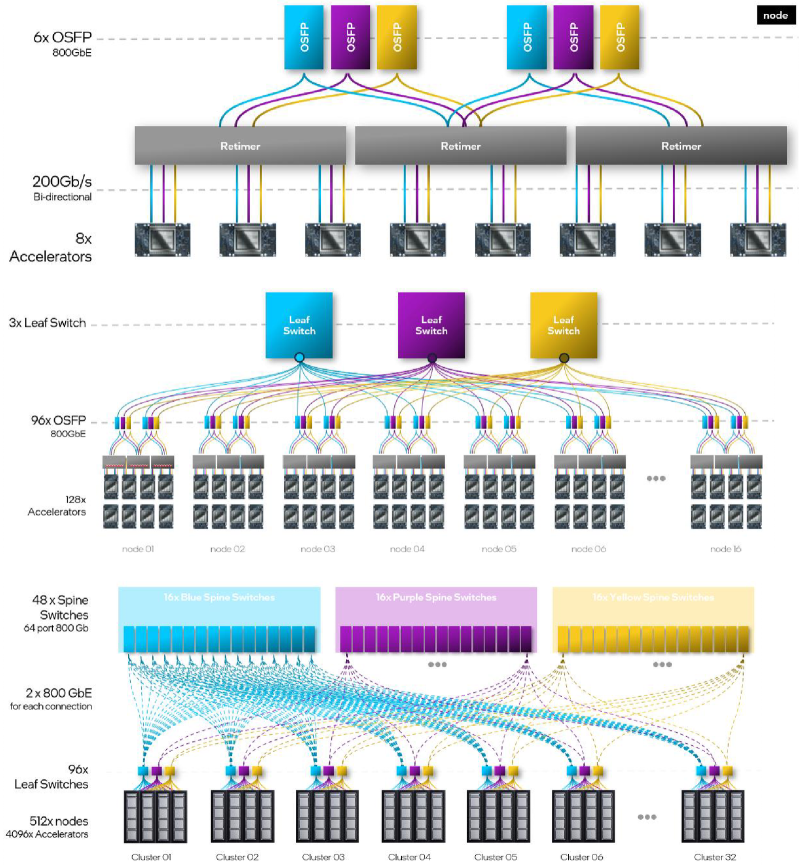

Управляющая подсистема (Control Path) Gaudi3 Сетевая часть всё ещё состоит из 24 контроллеров Ethernet (c RoCE), но появилась поддержка скорости 200 Гбит/с, а значит, вдвое возросла и совокупная производительность сети. Intel подчёркивает, что для масштабирования кластеров на базе Gaudi3 нужна обычная Ethernet-фабрика (а ещё лучше Ultra Ethernet) и нет никакой привязки к конкретному вендору, что является упрёком NVIDIA с её InfiniBand. Наконец, в качестве хост-интерфейса на смену PCI Express 4.0 пришёл PCI Express 5.0 (x16), что также означает подросшую с 64 до 128 Гбайт/с пропускную способность.

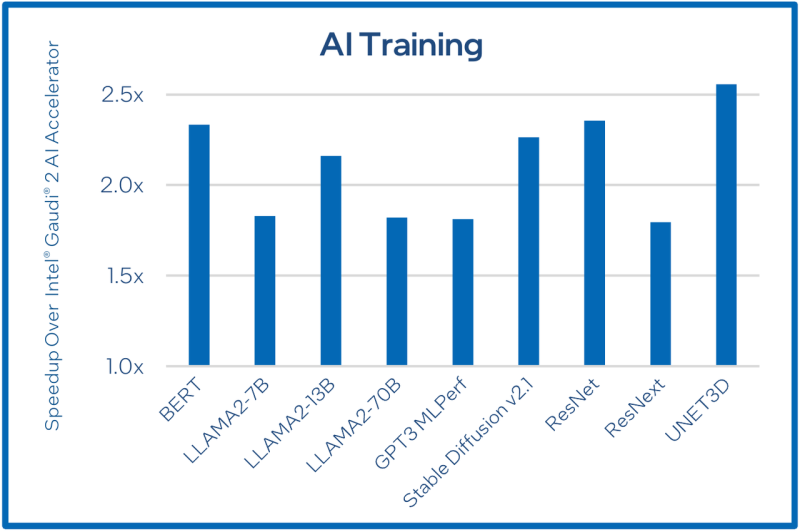

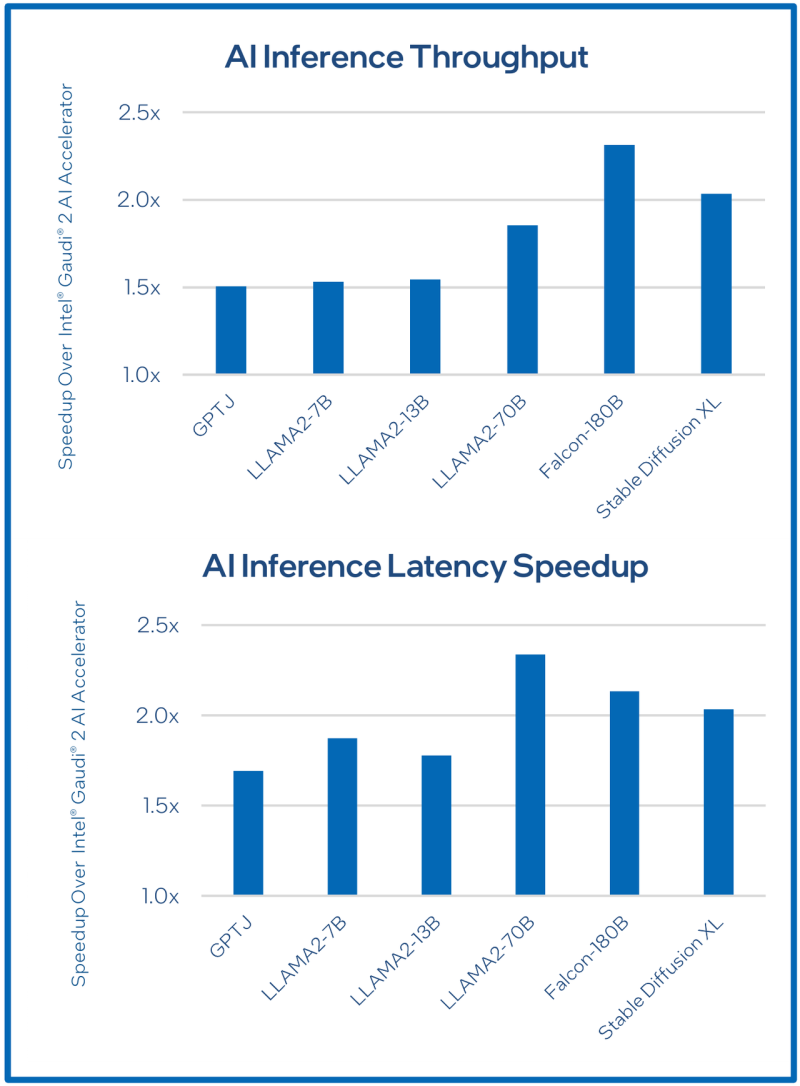

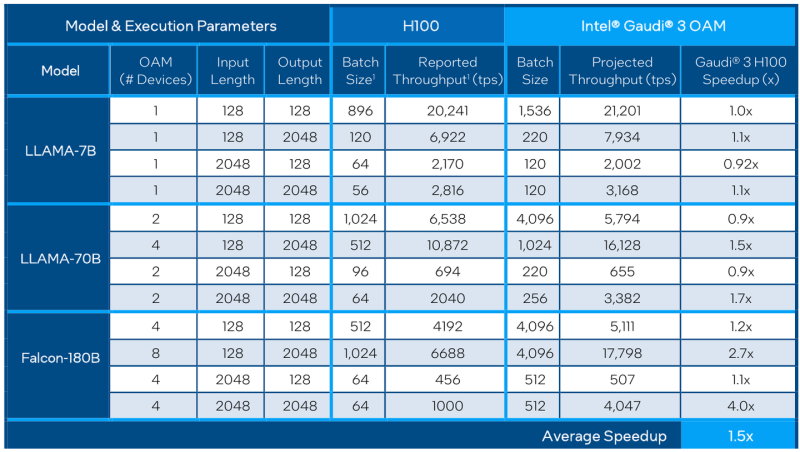

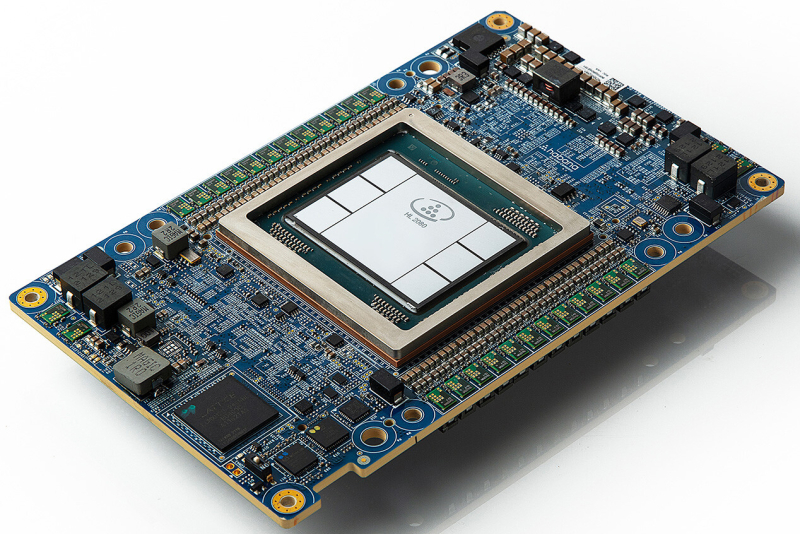

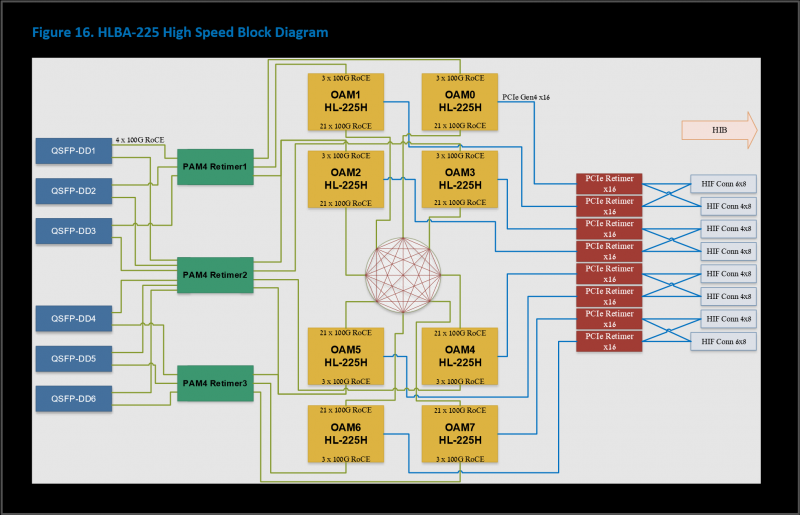

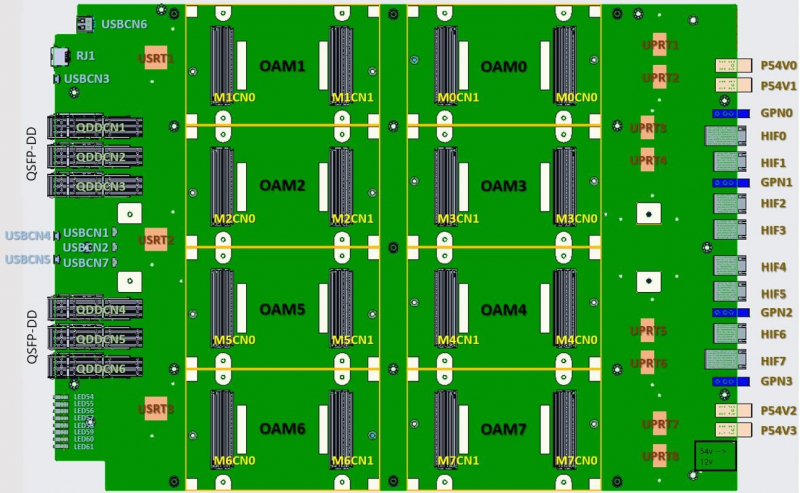

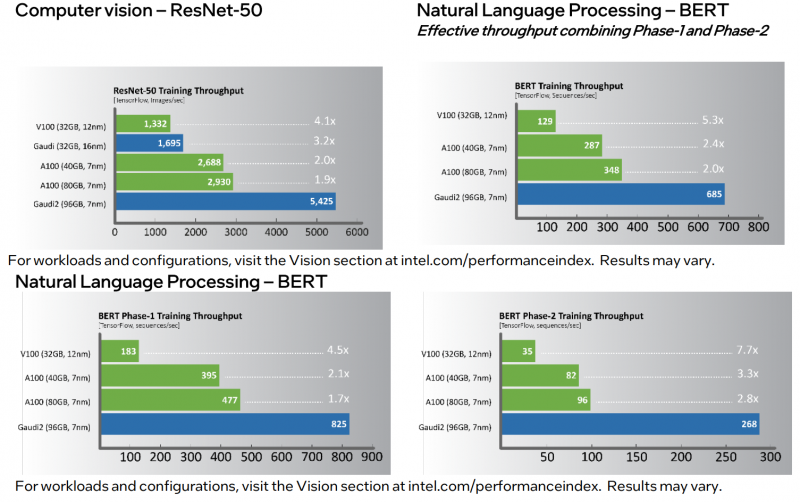

Сравнительные характеристики Gaudi2 и Gaudi3 Все эти улучшения позволяют Intel говорить о теоретической производительности в 2–4 раза более высокой, нежели было достигнуто в поколении Gaudi2. Наибольший прирост заявлен для операций с форматом BF16 на MME, что вполне закономерно, учитывая большее количество самих MME. На практике результаты, демонстрируемые Gaudi3, выглядят также достаточно многообещающе: в тестах на обучение популярных нейросетей преимущество над Gaudi2 ни разу не составило менее 1,5x, а в отдельных случаях даже превысило 2,5x. В инференс-тестах отрыв оказался чуть меньше, но и здесь минимальна разница составляет полтора раза. Что немаловажно для инференс-сценариев, серьёзно улучшились показатели латентности. Отчасти это заслуга не только серьёзно подросших «мускул» нового процессора, но и наличие большего объёма HBM, что позволяет разместить в памяти больше параметров и расширить контекстное окно. Опубликовала Intel и результаты сравнительного тестирования Gaudi3 против NVIDIA H100 в MLPerf, где новинка действительно выступила весьма достойно, в худшем случае демонстрируя 90% от производительности H100, а в отдельных тестах опережая конкурента более чем в 2,5 раза. Примерно так же распределились результаты и в тестах на энергоэффективность. Что же касается инженерно-технической реализации, то на этот раз Intel представила сразу несколько вариантов ускорителей на базе Gaudi3, отличающихся как теплопакетом, так и конструктивом. Самым быстрым вариантом в семействе является модуль HL-325L OCP. Он выполнен в формате мезонинной платы OCP OAM 2.0 и поддерживает теплопакет 900 Вт для воздушного охлаждения и 1200 Вт — для жидкостного. Для этой модели была специально разработана новая UBB-плата HLB-325L, приходящая на смену HLBA-225. Она поддерживает установку восьми ускорителей HL-325L, причём 21 сетевое подключение на каждом из них позволяет реализовать интерконнект по схеме «все со всеми», а оставшиеся подключения сведены через PAM4-ретаймеры в шесть 800GbE-портов OSFP для дальнейшего масштабирования кластера. Имеется и вывод PCI Express 5.0 с помощью PCIe-ретаймеров, также установленных на плате. HLB-325L рассчитана на питание 54 В, которое в последнее время становится всё популярнее в новых ЦОД и HPC-системах. Другой вариант Gaudi3 — ускоритель HL-338. Он представляет собой стандартную плату расширения PCIe с двумя внешними портами QSFP112 400GbE. Поддерживаются теплопакеты вплоть до 600 Вт при стандартном воздушном охлаждении. Дополнительный мостик HLTB-304, устанавливаемая поверх четырёх ускорителей HL-338, обеспечивает интерконнект за счёт 18 набортных линков 200GbE. Такая реализация кластера на базе Gaudi3 по понятным причинам будет несколько менее производительной, нежели вариант с OAM-модулями, но позволит обойтись стандартными аппаратными средствами и корпусами серверов. Первые пробные партии ускорителей на базе Gaudi3 поступят избранным партнёрам Intel уже в этом полугодии. Вариант OAM с воздушным охлаждением уже тестируется в квалификационных лабораториях компании, а образцы с жидкостным охлаждением появятся позднее в этом квартале. В новинке заинтересованы Dell, HPE, Lenovo и Supermicro. Массовые поставки стартуют в III квартале 2024 года. Последними на рынке появятся PCIe-версии, их поставки намечены на IV квартал.

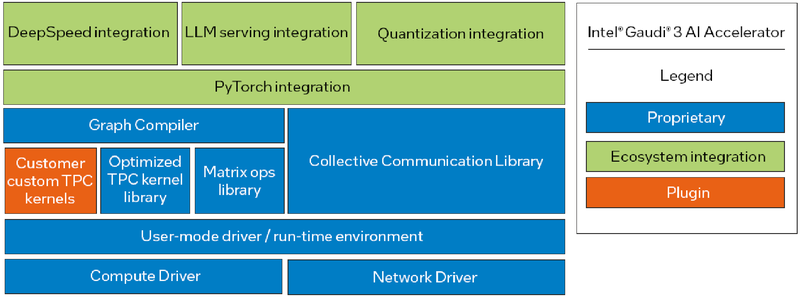

Программная экосистема Intel Gaudi Intel Gaudi3 выглядит весьма неплохо. В нём устранены узкие места, свойственные Gaudi2, что позволяет тягаться на равных с NVIDIA H100 и H200, и даже заметно превосходить их в некоторых сценариях. Однако NVIDIA уже анонсировала архитектуру Blackwell. Впрочем, основная борьба развернётся не на аппаратном, а на программном уровне — Intel вслед за AMD упростила работу с PyTorch, что позволит перенести множество нагрузок на Gaudi. А там, глядишь, и UXL станет хоть какой-то альтернативой CUDA.

28.03.2024 [14:31], Сергей Карасёв

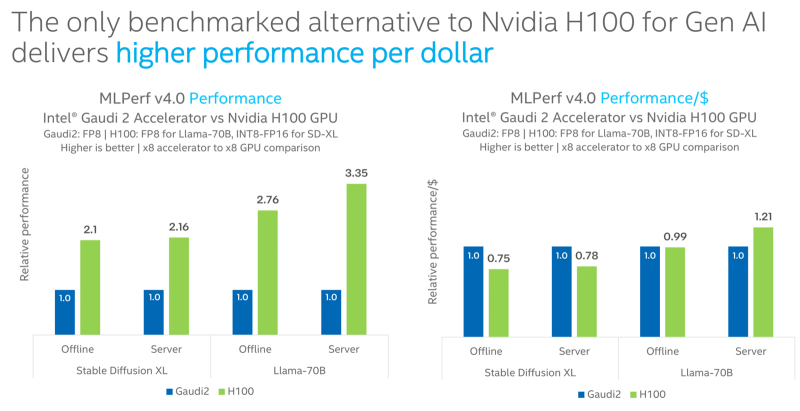

Intel Gaudi2 остаётся единственным конкурентом NVIDIA H100 в бенчмарке MLPerf InferenceКорпорация Intel сообщила о том, что её ИИ-ускоритель Habana Gaudi2 остаётся единственной альтернативой NVIDIA H100, протестированной в бенчмарке MLPerf Inference 4.0. При этом, как утверждается, Gaudi2 обеспечивает высокое быстродействие в расчёте на доллар, хотя именно чипы NVIDIA являются безоговорочными лидерами. Отмечается, что для платформы Gaudi2 компания Intel продолжает расширять поддержку популярных больших языковых моделей (LLM) и мультимодальных моделей. В частности, для MLPerf Inference v4.0 корпорация представила результаты для Stable Diffusion XL и Llama v2-70B. Согласно результатам тестов, в случае Stable Diffusion XL ускоритель H100 превосходит по производительности Gaudi2 в 2,1 раза в оффлайн-режиме и в 2,16 раза в серверном режиме. При обработке Llama v2-70B выигрыш оказывается более значительным — в 2,76 раза и 3,35 раза соответственно. Однако на большинстве этих задач (кроме серверного режима Llama v2-70B) решение Gaudi2 выигрывает у H100 по показателю быстродействия в расчёте на доллар. В целом, ИИ-ускоритель Gaudi2 в Stable Diffusion XL показал результат в 6,26 и 6,25 выборок в секунду для оффлайн-режима и серверного режима соответственно. В случае Llama v2-70B достигнут показатель в 8035,0 и 6287,5 токенов в секунду соответственно. Говорится также, что серверные процессоры Intel Xeon Emerald Rapids благодаря улучшениям аппаратной и программной составляющих в бенчмарке MLPerf Inference v3.1 демонстрируют в среднем в 1,42 раза более высокие значения по сравнению с чипами Xeon Sapphire Rapids. Например, для GPT-J с программной оптимизацией и для DLRMv2 зафиксирован рост быстродействия примерно в 1,8 раза.

10.05.2022 [22:46], Игорь Осколков

Intel анонсировала ИИ-ускорители Habana Gaudi2 и GrecoНа мероприятии Intel Vision было анонсировано второе поколение ИИ-ускорителей Habana: Gaudi2 для задач глубокого обучения и Greco для инференс-систем. Оба чипа теперь производятся с использованием 7-нм, а не 16-нм техпроцесса, но это далеко не единственное улучшение. Gaudi2 выпускается в форм-факторе OAM и имеет TDP 600 Вт. Это почти вдвое больше 350 Вт, которые были у Gaudi, но второе поколение чипов значительно отличается от первого. Так, объём набортной памяти увеличился втрое, т.е. до 96 Гбайт, и теперь это HBM2e, так что в итоге и пропускная способность выросла с 1 до 2,45 Тбайт/с. Объём SRAM вырос вдвое, до 48 Мбайт. Дополняют память DMA-движки, способные преобразовывать данные в нужную форму на лету. В Gaudi2 имеется два основных типа вычислительных блоков: Matrix Multiplication Engine (MME) и Tensor Processor Core (TPC). MME, как видно из названия, предназначен для ускорения перемножения матриц. TPC же являются программируемыми VLIW-блоками для работы с SIMD-операциями. TPC поддерживают все популярные форматы данных: FP32, BF16, FP16, FP8, а также INT32, INT16 и INT8. Есть и аппаратные декодеры HEVC, H.264, VP9 и JPEG. Особенностью Gaudi2 является возможность параллельной работы MME и TPC. Это, по словам создателей, значительно ускоряет процесс обучения моделей. Фирменное ПО SynapseAI поддерживает интеграцию с TensorFlow и PyTorch, а также предлагает инструменты для переноса и оптимизации готовых моделей и разработки новых, SDK для TPC, утилиты для мониторинга и оркестрации и т.д. Впрочем, до богатства программной экосистемы как у той же NVIDIA пока далеко. Интерфейсная часть новинок включает PCIe 4.0 x16 и сразу 24 (ранее было только 10) 100GbE-каналов с RDMA ROcE v2, которые используются для связи ускорителей между собой как в пределах одного узла (по 3 канала каждый-с-каждым), так и между узлами. Intel предлагает плату HLBA-225 (OCP UBB) с восемью Gaudi2 на борту и готовую ИИ-платформу, всё так же на базе серверов Supermicro X12, но уже с новыми платами, и СХД DDN AI400X2. Наконец, самое интересное — сравнение производительности. В ряде популярных нагрузок новинка оказывается быстрее NVIDIA A100 (80 Гбайт) в 1,7–2,8 раз. На первый взгляд результат впечатляющий. Однако A100 далеко не новы. Более того, в III квартале этого года ожидается выход ускорителей H100, которые, по словам NVIDIA, будут в среднем от трёх до шести раз быстрее A100, а благодаря новым функциям прирост в скорости обучения может быть и девятикратным. Ну и в целом H100 являются более универсальными решениями. Gaudi2 уже доступны клиентам Habana, а несколько тысяч ускорителей используются самой Intel для дальнейшей оптимизации ПО и разработки чипов Gaudi3. Greco будут доступны во втором полугодии, а их массовое производство намечено на I квартал 2023 года, так что информации о них пока немного. Например, сообщается, что ускорители стали намного менее прожорливыми по сравнению с Goya и снизили TDP с 200 до 75 Вт. Это позволило упаковать их в стандартную HHHL-карту расширения с интерфейсом PCIe 4.0 x8. Объём набортной памяти всё так же равен 16 Гбайт, но переход от DDR4 к LPDDR5 позволил впятеро повысить пропускную способность — с 40 до 204 Гбайт/с. Зато у самого чипа теперь 128 Мбайт SRAM, а не 40 как у Goya. Он поддерживает форматы BF16, FP16, (U)INT8 и (U)INT4. На борту имеются кодеки HEVC, H.264, JPEG и P-JPEG. Для работы с Greco предлагается тот же стек SynapseAI. Сравнения производительности новинки с другими инференс-решениями компания не предоставила.  Впрочем, оба решения Habana выглядят несколько запоздалыми. В отставании на ИИ-фронте, вероятно, отчасти «виновата» неудачная ставка на решения Nervana — на смену так и не вышедшим ускорителям NNP-T для обучения пришли как раз решения Habana, да и новых инференс-чипов NNP-I ждать не стоит. Тем не менее, судьба Habana даже внутри Intel не выглядит безоблачной, поскольку её решениям придётся конкурировать с серверными ускорителями Xe, а в случае инференс-систем даже с Xeon. |

|