Материалы по тегу: epyc

|

22.05.2024 [00:00], Алексей Степин

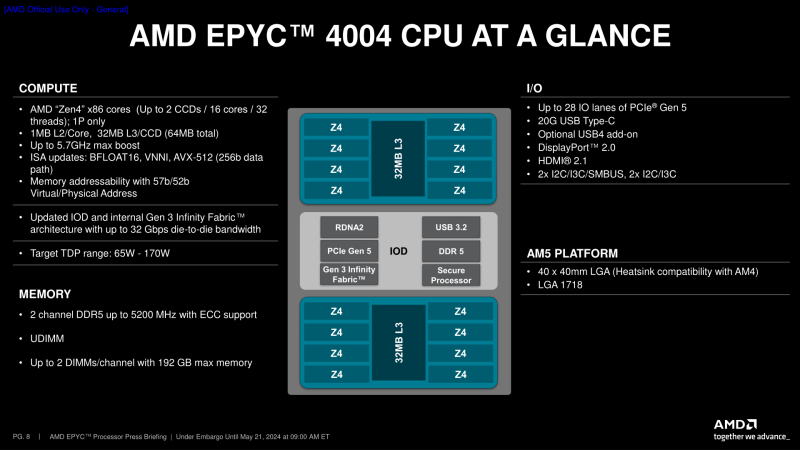

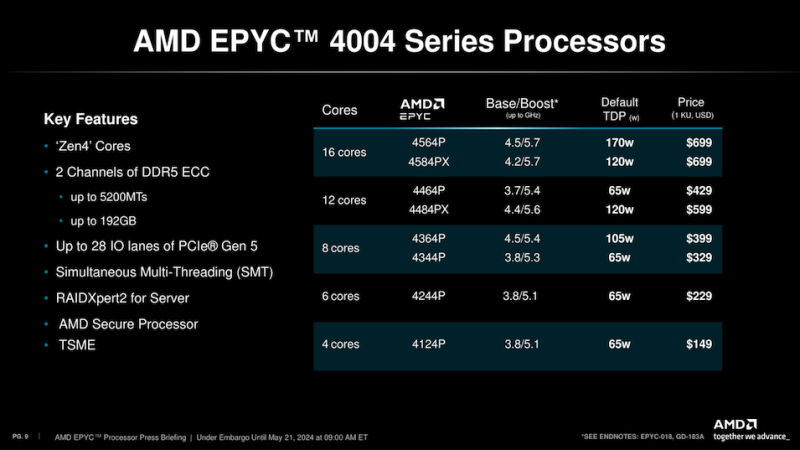

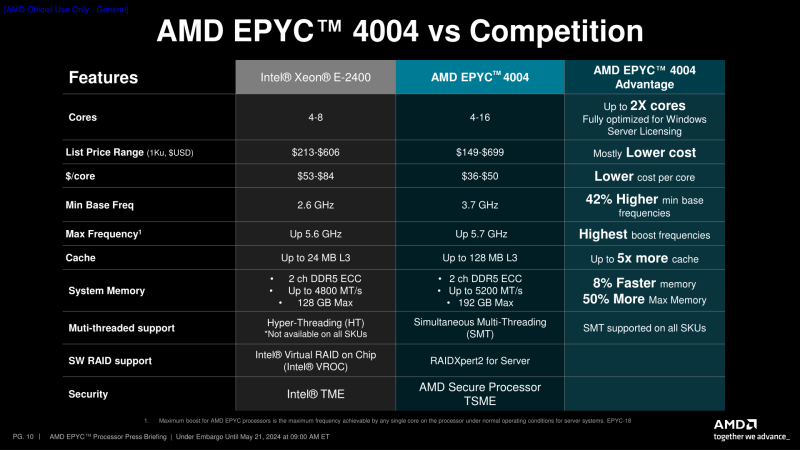

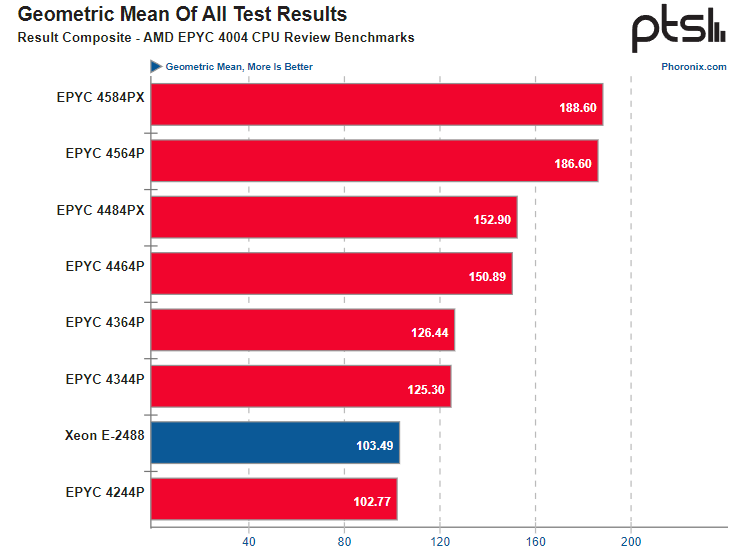

EPYC для самых маленьких: AMD представила серверные процессоры EPYC 4004 для сокета AM5AMD продолжает активно расширять серию серверных процессоров EPYC, причём не только «вверх», но и «вниз». Первой ласточкой стал выпуск упрощённых моделей EPYC 8004 Siena с ядрами Zen4c для периферийных вычислений, а сегодня компания анонсировала ещё более доступные односокетные EPYC 4004, стоимость которых начинается со $149. EPYC 4004 целиком построены на базе Ryzen 7000 и используют тот же разъём AM5. Этим анонсом AMD закрывает ещё одну нишу — серверные системы начального уровня, где Intel выступает с модельным рядом Xeon E. Позиционируются такие системы либо как компактные и энергоэффективности решения, например, для выделенных серверов с минимальной удельной стоимостью, либо как корпоративные платформы начального уровня для малого бизнеса. В таких системах ничто не мешает использовать Ryzen 7000, что и делают многие вендоры. Более того, многие уже выпустили обновления BIOS/UEFI, добавляющие таким системам поддержку EPYC 4004. Однако формально Ryzen никогда не были серверным продуктом и, например, лишены поддержки RDIMM. Речь по-прежнему идёт о двухканальной DDR5-5200 в небуферизированных модулях UDIMM. Максимальный объём ограничен 192 Гбайт, но у Xeon E-2400 он ещё меньше и составляет всего 128 Гбайт, да к тому же DDR5-4800. Процессоры предоставляют в распоряжение системы 28 линий PCI Express 5.0, что, больше, чем у Xeon E-2400, насчитывающего всего 16 таких линий. По сути, AMD EPYC 4004 являются перемаркированными Ryzen 7000 с Zen4-ядрами, однако есть отличия: младшая 4-ядерная модель 4124P не имеет «потребительского» аналога. Максимальное количество ядер по-прежнему 16, причём в двух вариантах — 4584PX с 3D V-Cache (128 Мбайт L3-кеша) и обычном 4564P (64 Мбайт L3-кеша). В турборежиме оба флагмана могут разгоняться до 5,7 ГГц, но базовое значение у 4564P выше (4,5 ГГц), ценой повышенного со 120 до 170 Вт теплопакета. Внутри это по-прежнему чиплетные решения с 6-нм IO-блоком, одним-двумя кристаллами с восемью 5-нм ядрами и графикой RDNA2. Вся «серверность» EPYC 4004 сводится к поддержке внешнего BMC-контроллера, возможности создания программных RAID-массивов в RAIDXpert2 for Server и совместимости с современными серверными ОС. Однако у новинок в сравнении с E-2400 есть бонус в виде поддержки AVX-512. Как показывают результаты тесто Phoronix, флагманские модели AMD EPYC 4004 в среднем почти вдвое опережают старший Xeon E-2488, а стоят при этом ненамного больше.

Источник: Phoronix У AMD на этот раз определённо получилось очень удачное решение, аналогов которому по сочетанию стоимости и производительности у конкурента просто нет. Определённую опасность для EPYC 4004 могли бы представлять процессоры Xeon D-2800, имеющие до 22 ядер и полноценную поддержку AVX-512, но это специфические решения для сетевых систем и серверов периферийных вычислений, имеющие существенно более высокую стоимость.

12.05.2024 [21:43], Владимир Мироненко

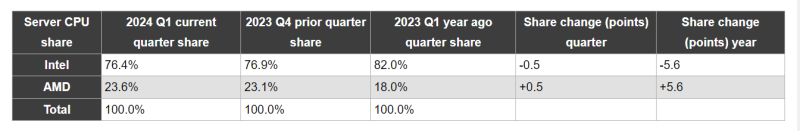

Доля AMD на рынке серверных процессоров выросла в I квартале 2024 года до 23,6 %Согласно данным компании Mercury Research, которая отслеживает рынки полупроводников и компонентов для ПК, Intel продолжает доминировать на рынке чипов для ПК, но AMD завоёвывает позиции на рынках чипов для серверов, десктопов и мобильных устройств, пишет AnandTech. В I квартале 2024 года AMD достигла рекордно высокой доли на рынках процессоров с архитектурой x86 для десктопов и серверных процессоров x86 благодаря успеху продуктов серии Ryzen 8000 и процессоров EPYC Genoa. Хотя доля AMD на рынке настольных компьютеров и ноутбуков в последние годы колебалась, компания неуклонно расширяет присутствие на рынке серверов как по объёмам поставок, так и по росту доходов. В I квартале 2024 года доля AMD на рынке процессоров для серверов увеличилась до 23,6 %, что означает прирост на 0,5 % последовательно и на 5 % год к году, обусловленный ростом числа платформ на базе процессоров AMD EPYC Genoa. Intel продолжает доминировать на рынке серверов с долей 76,4 %, но прогресс AMD вполне очевиден. Доля выручки AMD на рынке серверов на платформе x86 достигла 33 %, что на 5,2 % больше год к году и на 1,2 % больше, чем в предыдущем квартале. Это означает, что компания набирает обороты в производстве hi-end устройств с современными процессорами. Учитывая, что на данный момент у Intel нет прямых конкурентов 96-ядерным и 128-ядерным (Bergamo) процессорам AMD, неудивительно, что AMD удалось добиться увеличения доли на рынке чипов для серверов. «Как мы отметили во время нашего финансового отчёта за I квартал, продажи серверных процессоров выросли по сравнению с прошлым годом благодаря росту внедрения на предприятиях и расширению облачных развертываний», — указала AMD в своём заявлении.

08.05.2024 [13:24], Сергей Карасёв

ИИ-суперкомпьютер в чемодане — GigaIO представила платформу GryfКомпания GigaIO совместно с SourceCode анонсировала вычислительную систему Gryf. Это, как утверждается, первый в мире суперкомпьютер для ИИ-нагрузок, выполненный в виде чемодана на колёсиках. Изделие имеет габариты 228,6 × 355,6 × 622,3 мм и весит около 25 кг. Применяется фирменная система интерконнекта FabreX на базе PCI Express. Конфигурация Gryf предусматривает использование модулей (Sled) четырёх типов: это вычислительный узел (Compute Sled), блок ускорителя (Accelerator Sled), узел хранения (Storage Sled) и сетевой блок (Network Sled). Они могут компоноваться в различных сочетаниях, но общее количество модулей в рамках одного экземпляра Gryf не превышает шести. В состав Compute Sled входят процессор AMD EPYC 7313 Milan (16C/32T; 3,0–3,7 ГГц; 155 Вт), 256 Гбайт DDR4-3200, системный накопитель NVMe M.2 SSD вместимостью 256 Гбайт и два 100GbE-порта QSFP56/QSFP28. Может применяться ОС Linux Rocky 8/9 или Ubuntu 20/24. В свою очередь, Accelerator Sled содержит ускоритель NVIDIA L40S (48 Гбайт). Модуль Storage Sled объединяет восемь накопителей NVMe E1.L SSD суммарной вместимостью 246 Гбайт. Наконец, Network Sled предоставляет два разъёма QSFP56 100GbE и шесть 25GbE-портов SFP28. Вся система получает питание от двух блоков мощностью 2500 Вт каждый. Применены шесть вентиляторов охлаждения диаметром 60 мм. Диапазон рабочих температур — от 10 до +32 °C. Одно устройство Gryf обеспечивает производительность до 91,6 Тфлопс FP32, до 733 Тфлопс FP16 и до 1466 Тфлопс FP8. При этом в единый комплекс могут быть связаны до пяти экземпляров Gryf, что позволяет масштабировать быстродействие для выполнения тех или иных задач.

06.05.2024 [20:05], Сергей Карасёв

AMD начала поставки образцов процессоров EPYC TurinКомпания AMD, по сообщению ресурса AnandTech, обнародовала свежую информацию о планах по выпуску серверных процессов EPYC Turin (7005) на архитектуре Zen 5. Говорится, что образцы этих чипов уже поставляются клиентам, тогда как их официальный выход на рынок состоится во II половине текущего года. По имеющейся информации, изделия EPYC Turin будут использовать существующий сокет SP5 (LGA 6096). Готовятся обычные (Zen 5) и «облачные» (Zen 5c) варианты. В первом случае будут задействованы 16 вычислительных чиплетов CCD (до восьми ядер в каждом), что в сумме даст до 128 ядер. Для «облачных» версий предусмотрено наличие 12 чиплетов CCD (до 16 ядер в каждом), а суммарное количество ядер Zen 5с составит до 192 (384 потока). Как отметила глава AMD Лиза Су (Lisa Su), по сравнению с процессорами предыдущего поколения EPYC Turin обеспечат значительное увеличение производительности и энергоэффективности, что позволит компании укрепить позиции на серверном рынке. По её словам, для новой платформы партнёры AMD проектируют примерно на 30 % больше систем, нежели для EPYC Genoa. Вместе с тем, подчеркивает Су, изделия этих двух поколений какое-то время будут сосуществовать, что поможет клиентам выработать оптимальную стратегию обновления инфраструктуры. По мнению руководителя AMD, переход с Genoa на Turin займёт меньше времени, чем это было в случае Milan и Genoa. В корпоративном секторе, по словам госпожи Су, AMD тесно сотрудничает с Dell, HPE, Lenovo, Supermicro и другими разработчиками серверов. В текущем квартале начнётся массовое производство ряда ИИ-платформ на базе ускорителей Instinct MI300X. AMD прогнозирует, что выручка от поставок GPU-решений для дата-центров в 2024 году превысит $4 млрд. Еще в январе компания называла цифру в $3,5 млрд. Таким образом, AMD рассчитывает на существенное увеличение продаж продуктов для ЦОД.

26.04.2024 [11:46], Сергей Карасёв

HPE построила самый мощный в Польше суперкомпьютер Helios производительностью 35 ПфлопсКомпания HPE сообщила о создании нового суперкомпьютера под названием Helios для Академического компьютерного центра Cyfronet Научно-технического университета AGH в Кракове (Польша). Вычислительный комплекс будет использоваться для решения ресурсоёмких задач, связанных с ИИ. На сегодняшний день Helios — самая высокопроизводительная система в Польше. Она обеспечивает теоретическую пиковую производительность на уровне 35 Пфлопс, что более чем в четыре раза превосходит показатель предыдущего флагманского суперкомпьютера Cyfronet. Пиковое быстродействие на ИИ-операциях достигает 1,8 Эфлопс. В основу Helios положены узлы HPE Cray EX. Комплекс состоит из трёх сегментов. Один из них предназначен для традиционных вычислений, еще один — для рабочих нагрузок, связанных с обработкой больших данных. Третий сегмент оптимизирован для ИИ-задач: он использует суперчипы NVIDIA. Суперкомпьютер планируется применять при реализации проектов в области химии, медицины, создания передовых материалов, астрономии и защиты окружающей среды. Раздел общего назначения использует процессоры AMD EPYC поколения Genoa. Общее количество вычислительных ядер Zen 4 составляет 75 264, объём оперативной памяти DDR5 — 200 Тбайт. Сегмент для работы с большими данными основан на платформе HPE Cray Supercomputing XD665 с чипами EPYC Genoa, памятью DDR5-4800, быстрыми накопителями NVMe и ускорителями NVIDIA H100, суммарное количество которых равно 24.

Источник изображения: HPE Наконец, ИИ-раздел объединяет 440 суперчипов NVIDIA GH200 Grace Hopper для компьютерного моделирования с интенсивным использованием графики, поддержки приложений на основе генеративного ИИ и пр. Все компоненты вычислительного комплекса связаны друг с другом посредством 200G-интерконнекта HPE Slingshot. Комплекс Helios оснащён Lustre-хранилищем общей вместимостью 17,5 Пбайт на базе HPE Cray ClusterStor E1000.

24.04.2024 [14:37], Сергей Карасёв

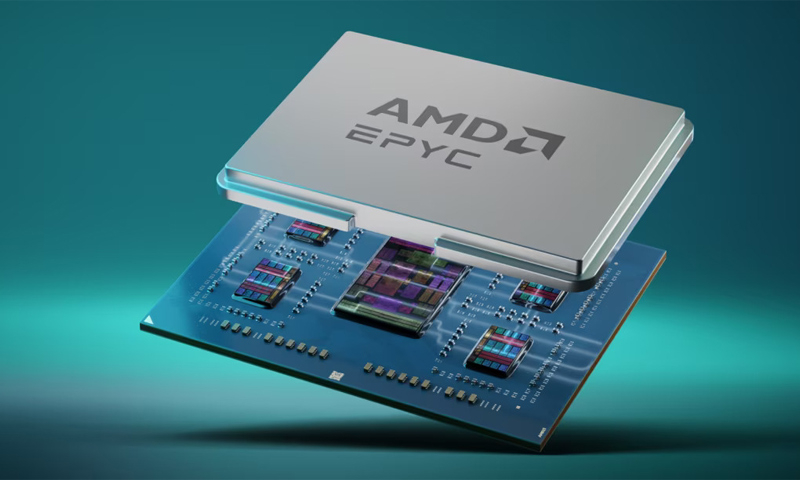

AMD: использование чиплетной архитектуры в процессорах EPYC помогает сократить выбросы парниковых газовДжастин Мюррилл (Justin Murrill), директор по корпоративной ответственности AMD, заявил, что решение компании использовать чиплетную архитектуру в процессорах EPYC позволило снизить глобальные выбросы парниковых газов на десятки тысяч тонн в год. AMD начала внедрение чиплетов около семи лет назад. Применение многокристальной архитектуры вместо монолитных изделий обеспечивает ряд преимуществ. В частности, достигается лучшая гибкость при проектировании изделий благодаря возможности комбинировать различные модули. Кроме того, повышается эффективность управления тепловыделением.

Источник изображения: AMD AMD создаёт процессоры EPYC путём компоновки вычислительных чиплетов CCD вокруг унифицированного чиплета IOD, выполняющего роль хаба ввода-вывода. Компания заявляет, что использование нескольких отдельных чиплетов вместо монолитного кристалла даёт возможность повысить процент выхода годной продукции в расчёте на одну кремниевую пластину. Дело в том, что в случае выявления дефекта отбраковывается сравнительно небольшой чип, а не крупное изделие. В результате сокращаются затраты на производство, снижаются энергетические и сырьевые потери. По словам Мюррилла, изготовление процессоров EPYC четвёртого поколения с восемью отдельными вычислительными чиплетами вместо одного монолитного кристалла позволило избежать 50 тыс. т выбросов CO2 в 2023 году. Однако нужно отметить, что это собственная оценка AMD, основанная на теоретических расчётах. Некоторые участники рынка также говорят о недостатках чиплетной компоновки. Среди минусов, в частности, называется необходимость использования высокоскоростных внутричиповых соединений. Кроме того, меньшее количество микросхем означает меньшее количество межсоединений и, следовательно, меньшую сложность и потенциально более высокую производительность.

13.04.2024 [23:00], Сергей Карасёв

«Ростех» начал поставки серверов и обновлённого интерконнекта «Ангара» для отечественных суперкомпьютеров

amd

epyc

hardware

hpc

ангара

импортозамещение

интерконнект

коммутатор

ницэвт

россия

ростех

сделано в россии

сервер

суперкомпьютер

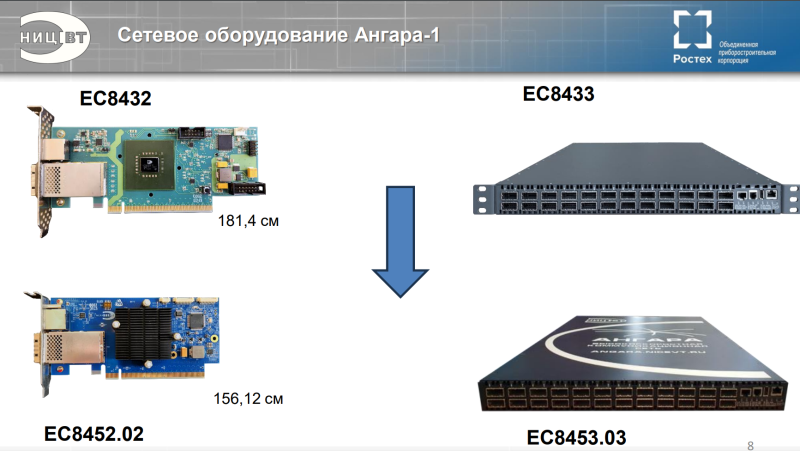

Государственная корпорация «Ростех» объявила о начале поставок оборудования нового поколения для создания отечественных суперкомпьютеров. Речь идёт о высокопроизводительных серверах, 24-портовых коммутаторах и адаптерах интерконнекта «Ангара». В сообщении «Ростеха» говорится, что оборудование стало более компактным по сравнению с предыдущими модификациями. Адаптеры «Ангара» обеспечивают объединение серверов в единый вычислительный кластер для проведения расчётов с высокоинтенсивным обменом информацией и низкими задержками. Новинка разработана специалистами Научно-исследовательского центра электронной вычислительной техники (НИЦЭВТ) в составе холдинга «Росэлектроника» госкорпорации «Ростех». На сайте НИЦЭВТ представлено изделие ЕС8431. Это FHFL-карта с интерфейсом PCIe 2.0 x16, которая обеспечивает до шести (или до восьми при использовании платы расширения) портов для соединения с соседними узлами. Пропускная способность достигает 75 Гбит/с на порт, задержка — 130 нс на хоп. Применяются Samtec-кабели. Поддерживаются топологии сети «кольцо», 2D, 3D и 4D-тор (либо решётка), причём возможно масштабирование до 32 тыс. узлов. Энергопотребление — 30 Вт. Также доступен низкопрофильный 15-Вт адаптер ЕС8432, который по характеристикам в целом повторяет ЕС8431, но имеет только один порт (CXP). Он ориентирован на работу с коммутаторами. И НИЦЭВТ как раз предлагает такое решение — изделие ЕС8433 типоразмера 1U. Оно располагает 24 портами с пропускной способностью до 75 Гбит/с. Возможно масштабирование до 2 тыс. узлов. Энергопотребление не превышает 150 Вт. На мероприятии «Суперкомпьютерные дни в России 2023» НИЦЭВТ также анонсировал более компактный вариант адаптера ЕС8452.02 и 24-портовый коммутатор ЕС8453.03. В сообщении «Ростеха» не уточняется, о каких именно продуктах идёт речь. В маркетплейсе госкорпорации рекомендованная розничная цена коммутатора ЕС8433 составляет 2,8 млн руб., а адаптеров ЕС8431 и ЕС8432 — 396 тыс. руб. и 300 тыс. руб. соответственно. В ассортименте НИЦЭВТ также значится сервер общего назначения Server-NICEVT-044 SP3 на платформе AMD. Он может оснащаться одним или двумя процессорами EPYC Naples/Rome/Milan (от 8 до 48 ядер), до 1 Тбайт RAM, двумя блоками питания с возможностью горячей замены. Возможна установка SSD суммарной вместимостью до 10 Тбайт и HDD общей ёмкостью до 80 Тбайт. Форм-фактор — 2U. Рекомендованная розничная цена составляет 1,2 млн руб. «Мы произвели первые поставки нового поколения сетевого оборудования линейки "Ангара", разработка которого завершилась в 2023 году. Техника установлена на территории двух научно-исследовательских организаций. Устройства позволяют ещё более эффективно выполнять задачи по созданию современных российских суперкомпьютеров для решения сложных научных задач. Сегодня именно от такого оборудования во многом зависит успех и скорость научных изысканий, а значит — и развитие отечественной промышленности», — говорит генеральный директор НИЦЭВТ.

13.03.2024 [17:57], Сергей Карасёв

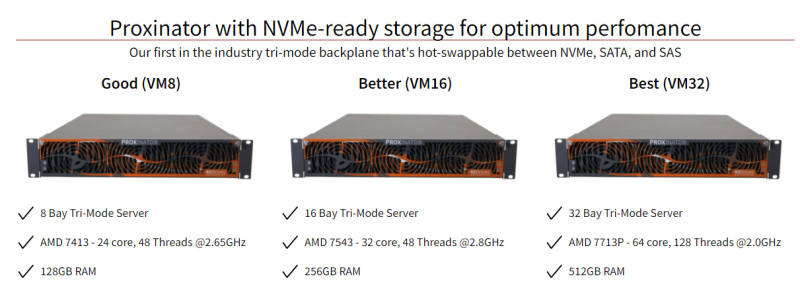

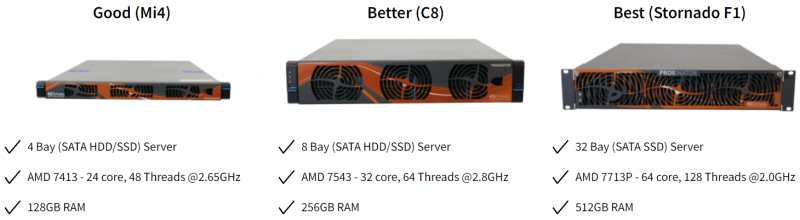

AMD EPYC + Proxmox: 45Drives предложила системы Proxinator в качестве альтернативы VMwareКанадская компания 45Drives анонсировала аппаратные решения семейства Proxinator, предназначенные для создания виртуальной инфратструктуры машин. В основу устройств, рассчитанных на монтаж в стойку, положена аппаратная платформа AMD с процессорами поколения EPYC Milan, дополненная инструментами Proxmox. Отмечается, что после поглощения компании VMware корпорацией Broadcom многие корпоративные пользователи начали искать альтернативные решения. Связано это с кардинальным изменением бизнес-модели VMware. В частности, Broadcom отменила бессрочные лицензии и перевела все продукты на подписную схему. Кроме того, были упразднены скидки и изменён подход к взаимодействию с партнёрами. 45Drives заявляет, что в поисках замены многие корпоративные клиенты не хотят снова становиться зависимыми от проприетарных решений. Системы Proxinator на базе открытого ПО, как утверждается, помогают избежать указанных рисков, одновременно предлагая высокую производительность. Используются платформа виртуализации Proxmox. Говорится, что в максимальной конфигурации на базе одного устройства Proxinator могут быть развёрнуты до 4 тыс. ВМ. В семейство Proxinator входят модели на процессорах AMD EPYC 7413, 7543 и 7713P с 24, 32 и 64 ядрами. Объём оперативной памяти составляет соответственно 128, 256 и 512 Гбайт. При необходимости размер ОЗУ может быть расширен до 2 Тбайт. Возможна установка HDD и SSD с интерфейсами SATA и SAS, а также высокоскоростных модулей NVMe. В зависимости от модификации предусмотрены отсеки для 4, 8, 16 или 32 накопителей. Для систем Proxinator компания 45Drives предлагает техническое обслуживание и всестороннюю поддержку. За $2500 разработчик произведёт настройку, тестирование и миграцию виртуальных машин vSphere. При миграции компания предлагает переиспользовать уже имеющиеся у клиента накопители.

29.02.2024 [14:13], Сергей Карасёв

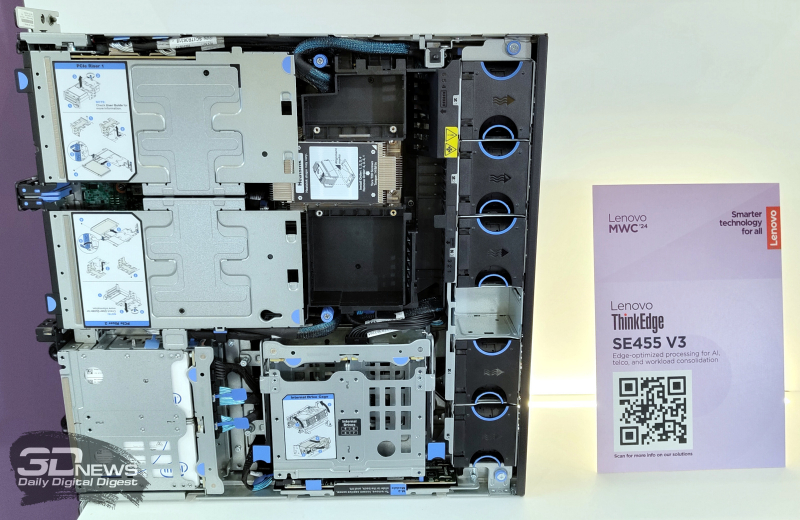

Lenovo представила обновлённые серверы ThinkEdge для ИИ-задач и периферийных вычисленийКомпания Lenovo на выставке MWC 2024 анонсировала новые серверы, предназначенные для решения ИИ-задач и организации периферийных вычислений. Демонстрируются модели ThinkEdge SE455 V3, ThinkEdge SE350 V2 и ThinkEdge SE360 V2. Первая из перечисленных новинок построена на платформе AMD EPYC 8004 Siena с возможностью установки одного процессора с показателем TDP до 225 Вт. Устройство выполнено в формате 2U с глубиной 438 мм. Есть шесть слотов для модулей DDR5-4800, по четыре внешних и внутренних отсека для накопителей SFF (SATA или NVMe). Доступны до шести слотов PCIe — 2 × PCIe 5.0 x16 и 4 × PCIe 4.0 x8. Предусмотрены также два коннектора для SSD типоразмера M.2. Серверы ThinkEdge SE350 V2 и ThinkEdge SE360 V2 выполнены в формате 1U и 2U соответственно. Они рассчитаны на установку одного процессора Intel Xeon D-2700 с TDP до 100 Вт. Первая из этих моделей позволяет задействовать до четырёх SFF-накопителей NVMe/SATA толщиной 7 мм и два SFF-устройства NVMe толщиной 15 мм. Слоты расширения PCIe не предусмотрены. Второй сервер может быть оборудован двум SFF-накопителями NVMe/SATA толщиной 7 мм и восемью устройствами M.2 2280/22110 (NVMe). Имеются два слота PCIe 4.0 x16. Представлены также компьютеры небольшого форм-фактора ThinkEdge SE10 и ThinkEdge SE30 для промышленной автоматизации, IoT-приложений и пр. Эти устройства оснащаются процессорами Intel — вплоть до Atom x6425RE и Core i5-1145GRE соответственно. Первый из этих компьютеров может быть оснащён одним накопителем M.2 PCIe SSD вместимостью до 1 Тбайт, второй — двумя. Ребристая поверхность корпуса выполняет функции радиатора для отвода тепла.

27.02.2024 [21:44], Сергей Карасёв

Gigabyte представила новые серверы для ИИ, 5G и периферийных вычисленийКомпания Gigabyte Technology на MWC 2024 анонсировала новые серверы для ИИ-задач, 5G-сетей, облачных и периферийных вычислений. Дебютировали модели на процессорах AMD и Intel, оснащённые мощными ускорителями. В частности, представлены серверы G593-ZX1/ZX2, оборудованные восемью картами AMD Instinct MI300X для ресурсоёмких вычислений. Кроме того, демонстрируются сервер высокой плотности H223-V10 с поддержкой суперчипа NVIDIA Grace Hopper, модель G383-R80 с четырьмя APU AMD Instinct MI300A и сервер серии G593, оснащённый восемью ускорителями NVIDIA HGX H100. Ещё одна новинка — сервер хранения S183-SH0. Он допускает использование 32 SSD формата E1.S (NVMe), благодаря чему подходит для обработки сложных рабочих нагрузок, таких как большие языковые модели (LLM). Эти серверы также могут быть интегрированы в суперкомпьютерные кластеры и инфраструктуру 5G. На edge-сегмент рассчитан сервер E263-S30 с модульной архитектурой: он может быть адаптирован под различные сценарии использования путём установки необходимых аппаратных компонентов. А модель R163-P32 комплектуется процессором AmpereOne с архитектурой Arm (до 192 ядер Arm с частотой до 3,0 ГГц), что обеспечивает высокую энергетическую эффективность.

На ИИ-приложения и облачные периферийные вычисления ориентированы серверы R243-EG0 и R143-EG0, которые оснащены чипами AMD EPYC 8004 Siena. Для сегмента малого и среднего бизнеса Gigabyte предлагает серверы R113-C10 и R123-X00, наделённые процессорами AMD Ryzen 7000 и Intel Xeon E-2400: эти модели подходят для веб-хостинга, создания гибридных облаков и хранилищ данных. |

|