Материалы по тегу: cloud

|

23.02.2025 [22:52], Владимир Мироненко

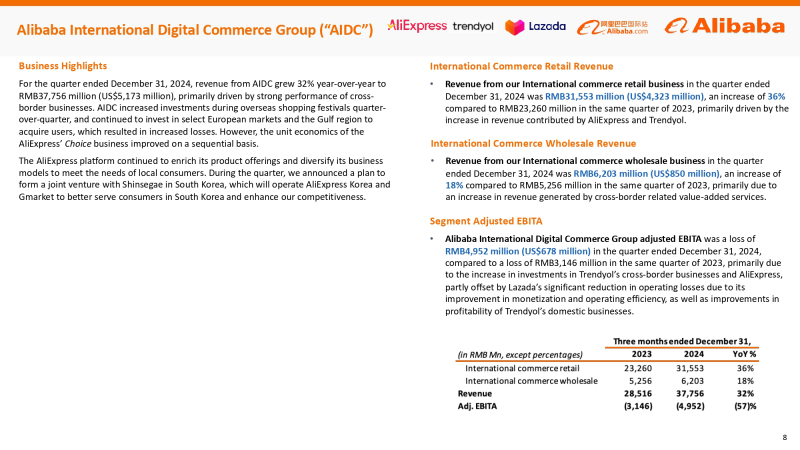

Alibaba в ближайшие три года инвестирует в ИИ и облака $52 млрд — больше, чем за десять лет до этогоAlibaba Group Holding Limited сообщила финансовые результаты III квартала 2024 финансового года, закончившегося 31 декабря 2024 года, которые превысили прогнозы аналитиков. Выручка компании составила ¥280,15 млрд ($38,38 млрд), что на 8 % больше результата аналогичного квартала предыдущего финансового года и выше консенсус-прогноза 17 аналитиков, опрошенных LSEG, в размере ¥279,34 млрд. Инвесторы позитивно оценили квартальные итоги, а также планы китайского технологического гиганта больше инвестировать в электронную коммерцию и ИИ. Благодаря этому на торгах Гонконгской фондовой биржи акции Alibaba поднялись в цене более чем на 10 %, достигнув самого высокого уровня за более чем три года, пишет Reuters. Американские депозитарные расписки компании выросли примерно на 12 % на утренних торгах в Нью-Йорке после публикации результатов, демонстрируя самый большой однодневный процентный прирост с сентября прошлого года, сообщила газета The Wall Street Journal. Согласно Reuters, стоимость акции Alibaba выросла с начала года на 60 %. Чистая прибыль (GAAP), причитающаяся держателям обыкновенных акций, составила ¥48,95 млрд ($6,71 млрд), что значительно превышает прошлогодний результат в размере ¥14,43 млрд ($1,98 млрд) и консенсус-прогноз аналитиков от LSEG в размере ¥40,6 млрд ($5,56 млрд). Чистая прибыль (GAAP) на разводнённую акцию составила ¥2,55 ($0,35). Скорректированная чистая прибыль (Non-GAAP) за квартал составила ¥51,07 млрд ($7,0 млрд), что на 6 % больше результата за III квартал 2023 финансового года. Скорректированная разводнённая прибыль на акцию (Non-GAAP) составила ¥2,67 ($0,37), превысив на 13 % прошлогодний показатель. Скорректированная EBITA выросла на 33 % в годовом исчислении до ¥3,14 млрд ($430 млн). Рост произошёл в основном за счёт сдвига в ассортименте продукции в сторону более прибыльных публичных облачных продуктов и повышения операционной эффективности, что частично компенсировалось ростом инвестиций в развитие клиентской базы и технологий. Международный бизнес электронной коммерции, включающий платформу AliExpress, B2B-площадку Alibaba.com и другие региональные платформы, остался одним из самых быстрорастущих в компании, увеличив выручку на 32 % до ¥37,76 млрд ($5,18 млрд). Выручка подразделения Cloud Intelligence Group компании Alibaba выросла на 13 % с ¥28,07 млрд ($3,85 млрд) в прошлом году до ¥31,74 млрд ($4,35 млрд). Как сообщает компания, рост был обусловлен увеличением внедрения продуктов, связанных с ИИ, выручка от которых сохраняла трехзначный процентный годовой рост шестой квартал подряд. Компания подчеркнула приверженность продвижению мультимодального ИИ и open source. В январе 2025 года Alibaba открыла исходный код Qwen2.5-VL, мультимодальной модели следующего поколения, и запустила флагманскую MoE-модель Qwen2.5-Max. Обе модели доступны пользователям и предприятиям через Qwen Chat и собственную платформу Bailian. С августа 2023 года компания открыла целый ряд различных LLM Qwen. По состоянию на 31 января 2025 года на Hugging Face было разработано более 90 тыс. производных моделей на основе семейства Qwen, что делает его одним из крупнейших семейств ИИ-моделей. Alibaba добилась «значительных успехов» в развитии своего облачного бизнеса в области ИИ после запуска своей флагманской модели Qwen 2.5-Max AI Foundation, сообщила компания Barclays в заметке для инвесторов, добавив, что наблюдается резкий рост спроса на инференс, на который приходится до 70 % всех заказов клиентов. Глава Alibaba Эдди Ву (Eddie Wu) сообщил на встрече с аналитиками, что ИИ — это «та возможность для трансформации отрасли, которая появляется только раз в несколько десятилетий». Он также сказал, что Alibaba вложит в течение следующих трёх лет больше средств в ИИ и облачные вычисления, чем за последнее десятилетие, но не назвал точную сумму. По оценкам Barclays, запланированные инвестиции превысят ¥270 млрд ($37,0 млрд). В этом месяце Alibaba Cloud открыла второй ЦОД в Таиланде в рамках стратегии по расширению присутствия в Юго-Восточной Азии, сообщил ресурс Data Center Dynamics. UPD 24.02.2024: компания официально объявила о намерении инвестировать не менее ¥380 млрд ($52,44 млрд) в облачную и ИИ-инфраструктуру в течение трёх лет.

20.02.2025 [18:24], Владимир Мироненко

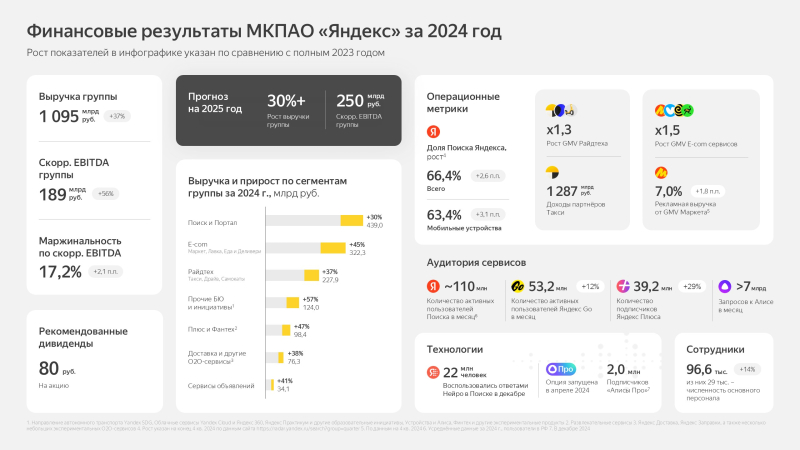

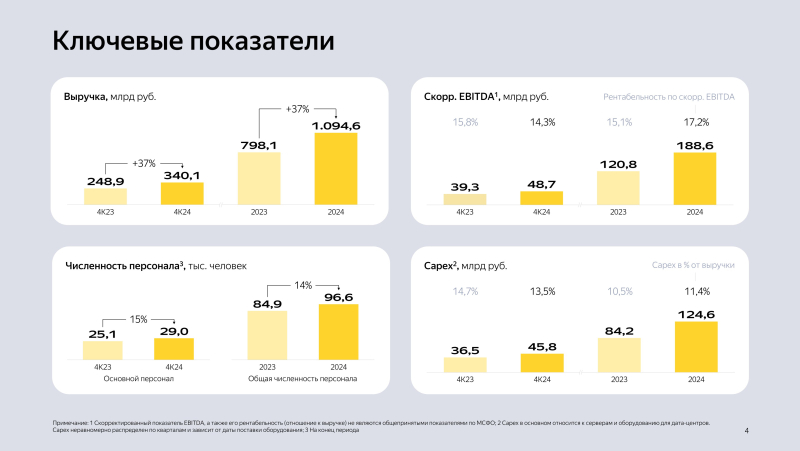

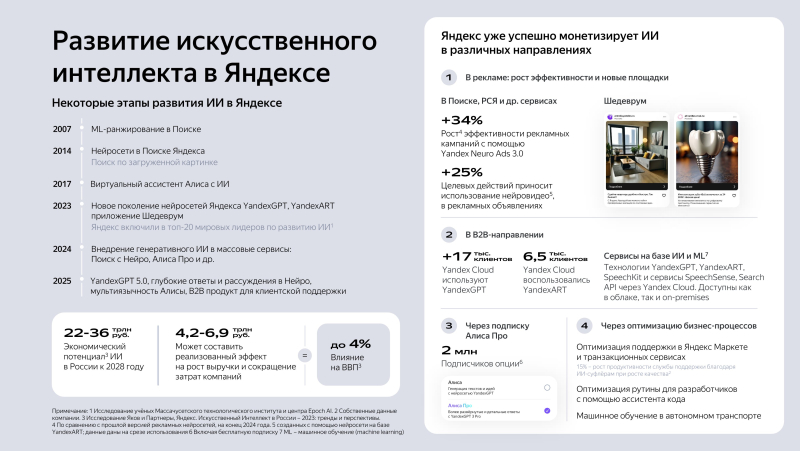

«Яндекс» впервые заработал за год более триллиона рублейМКПАО «Яндекс», российская частная IT-компания, объявила неаудированные финансовые результаты в соответствии с МСФО за IV квартал и весь 2024 год. Следует отметить, что впервые выручка компании за год превысила отметку в 1 трлн руб., составив 1094,6 млрд руб., что на 37 % больше показателя предыдущего года. В IV квартале выручка «Яндекса» составила 340,1 млрд руб., превысив результат годичной давности на 37 %. Скорректированная чистая прибыль увеличилась 85 % до 31,5 млрд руб. с 17 млрд годом ранее. Скорректированный показатель EBITDA вырос на 24 % с 39,3 до 48,7 млрд руб. Рентабельность скорректированного показателя EBITDA немного снизилась — на 1,5 п. п. до 14,3 %. Операционная прибыль выросла на 13 % до 16,3 млрд руб., чистая прибыль составила 15,5 млрд руб., тогда как годом ранее была равна всего 0,7 млрд руб. Численность персонала компании выросла на 14 % до 96,6 тыс. чел. Сегмент «Прочих бизнес-юнитов и инициатив», в котором отражается результат облачной платформы Yandex Cloud, Яндекс 360 и ряда других сервисов, показал рост выручки за квартал на 49 % до 50,3 млрд руб. При этом убыток данного сегмента по скорректированному показателю EBITDA вырос на 111 % до 19,6 млрд руб., а рентабельность скорректированного показателя EBITDA составила −39,1 %, что означает падение на 11,4 п.п. год к году. На данный сегмент пришлось 9 % от общей выручки компании за 2024 год. За 2024 год скорректированный показатель EBITDA вырос год к году на 56 % до 188,6 млрд руб. Операционная прибыль упала на 19 % до 51,5 млрд руб., чистая прибыль снизилась на 79 % до 11,5 млрд руб., скорректированная чистая прибыль выросла на 94 % до 100,9 млрд руб. В 2025 году компания прогнозирует рост выручки более чем на 30 % год к году и скорректированный показатель EBITDA не менее 250 млрд руб. В связи ростом масштаба бизнеса доля капитальных затрат в консолидированной выручке снизится год к году.

17.02.2025 [21:08], Андрей Крупин

VK запустила облачный Data Lakehouse для аналитики и обработки данныхЗанимающаяся разработкой корпоративного ПО компания VK Tech (входит в экосистему VK) сообщила о включении в состав облачной платформы VK Cloud стека инструментов для построения Data Lakehouse и с возможностью подключения к объектным хранилищам Cloud Storage, Managed PosgtreSQL, Managed Clickhouse. Data Lakehouse представляет собой новый архитектурный подход к хранению и анализу данных, который сочетает элементы «озёр данных» (Data Lake) и корпоративного хранилища данных (Data Warehouse). Он позволяет снизить нагрузку на системы хранения данных, удешевить хранение неструктурированных данных и эффективно анализировать их за счёт разделения вычислительных узлов и хранилищ данных. Data Lakehouse на платформе VK Cloud построен на базе S3-совместимого объектного хранилища собственной разработки и SQL-движка Cloud Trino, реализованного на базе Kubernetes. Использование доработанных Open Source-компонентов в составе Data Lakehouse позволяет организациям получить современный стек для работы с крупными проектами, с оплатой только за фактически потреблённые ресурсы, без необходимости покупать лицензии.

Источник изображения: VK Cloud Data Lakehouse доступен для построения как на облачной платформе, так и на собственной инфраструктуре на базе Private Cloud и VK Data Platform. Инфраструктура публичного облака VK Cloud аттестована по требованиям 152-ФЗ (УЗ-1).

08.02.2025 [16:42], Владимир Мироненко

Yandex Cloud повысит цены на облачные сервисы с 1 маяОблачная платформа Yandex Cloud объявила о планах повысить с 1 мая 2025 года тарифы на ряд сервисов, отметив, что это первое повышение цен с 2022 года, рост тарифов не превысит 8 % и коснётся не всех сервисов. Сообщается, что рост цен вызван целым рядом макроэкономических факторов, включая регулярное повышение цен на оборудование, значительное изменение курса рубля и увеличение стоимости разработки и поддержки. В пресс-релизе указано, что индексация для сервисов Compute Cloud, Data Processing и Managed ClickHouse/MongoDB/MySQL/PostgreSQ/Valkey, которые используют устаревшие платформы Intel Broadwell и Intel Cascade Lake/Broadwell + NVIDIA Tesla V100 составит 3 %. Повышение не затронет сервисы Yandex Cloud Marketplace, Postbox, DataLens, Models, SpeechKit, SpeechSense, Tracker, Translate, Vision, другие сервисы, использующие платформу AMD EPYC 9474F, и техническую поддержку на тарифе «Бизнес». Для клиентов в регионе доступности Казахстан цены в тенге сохранятся на прежнем уровне. В будущем компания пообещала корректировать цены в начале календарного года. Как отметили в Forbes, Yandex Cloud повысит тарифы на свои основные услуги. Согласно отчёту платформы за 2023 год, по доле потребления всех сервисов на группу «Инфраструктура и сеть» приходилось 56 %, на сервисы платформы данных — 22 %, на услуги контейнерной разработки — 12 %, на сервисы машинного обучения — 4 %. Выручка Yandex Cloud в 2023 году составила 13,3 млрд руб. В 2024 году, по предварительной оценке, выручка инфраструктурных и платформенных сервисов увеличилась в полтора раза, при этом распределение долей IaaS и PaaS «сохраняется примерно на одинаковом уровне».

Источник изображения: Yandex Cloud По предварительным данным iKS-Consulting, Yandex Cloud в 2024 году заняла третье место среди крупнейших поставщиков облачных инфраструктурных и платформенных услуг, уступив РТК-ЦОД и Cloud.ru. Общий объём рынка облачных сервисов в РФ в 2024 году вырос 165,6 млрд руб., увеличившись год к году на 36,3 %. iKS-Consulting подтвердила Forbes, что последнее крупное повышение цен на облачные услуги произошло на рубеже 2022–2023 гг., когда на фоне санкций подняли цены многие участники рынка. Средняя цена на аренду vCPU тогда выросла на 47 %, а 1 Гбайт vRAM — на 13 %. Forbes опросил участников рынка по поводу их планов по тарифам на облачные услуги в 2025 году и большинство из них сообщило об отсутствии намерений повышать цены. Так, в РТК-ЦОД сообщили, что в 2024 году стоимость базовых сервисов оставалась неизменной, но 2025 году возможен рост тарифов в отдельных категориях, например, в сервисах на базе GPU. В Linx тоже не повышали цены на облачные сервисы в 2024 году и не планируют повышения в 2025 году, но могут повысить цену услуг колокации в диапазоне 15–20 %. В «1C» сообщили, что увеличили цены в 2025 году на облачные сервисы на 14 %, о чём предупреждали ещё в октябре 2024 года. В ГК Softline отметили, что большое количество облачных провайдеров на рынке уже подняли цены на 10–20 % или планируют сделать это в обозримой перспективе. Компания сообщила, что будет вынуждена повысить цены на некоторые ресурсы от 10 % во II половине 2025 года. В ITGobal.com считают, что в целом на рынке облачных услуг России «можно ожидать умеренное увеличение цен на 10–15 % в связи с естественным ростом затрат и инфляцией».

22.01.2025 [23:43], Владимир Мироненко

VK Tech анонсировал изолированную облачную платформу Secure Cloud для госорганизаций и компаний с высокими требованиями к информационной безопасностиVK Tech анонсировал Secure Cloud, защищённое решение на базе VK Cloud, представляющее собой изолированную облачную платформу, предназначенную для создания, развития, поддержки и масштабирования государственных информационных систем (ГИС) и информационных систем персональных данных (ПДн). Платформа Secure Cloud предлагает готовую вычислительную инфраструктуру для органов государственной власти, государственных внебюджетных фондов, федеральных органов исполнительной власти и крупных компаний с высокими требованиями к обеспечению информационной безопасности. Secure Cloud получила аттестат соответствия №3740.00021.2024 от 16 декабря 2024 года по требованиям безопасности информации, предъявляемых к ГИС первого класса защищенности (К1) и ИСПДн второго уровня защищенности персональных данных (УЗ2), что подтверждает её соответствие требованиям нормативных документов ФСТЭК и ФСБ России в области защиты информации и готовность к размещению государственных информационных систем.

Источник изображения: VK Tech Secure Cloud разработана на кодовой базе облачной платформы VK Cloud, сертифицированной ФСТЭК России. Вся инфраструктура построена на российском оборудовании, что служит гарантией её импортонезависимости. В компании также сообщили о планах расширить функциональность платформы, добавив возможность размещения в облаке объектов критической информационной инфраструктуры (КИИ) и платформенных сервисов (PaaS) для работы с КИИ.

15.01.2025 [11:24], Владимир Мироненко

В совет директоров UALink вошли представители Alibaba, Apple и SynopsysКонсорциум Ultra Accelerator Link (UALink) объявил о расширении состава совета директоров представителями Alibaba Cloud, Apple и Synopsys. Новые члены совета будут использовать свои отраслевые знания для продвижения разработки и внедрения в отрасли UALink — высокоскоростного масштабируемого интерконнекта для производительных ИИ-кластеров следующего поколения, указано в пресс-релизе. Фактически UALink занят созданием более открытой альтернативы NVLink. С момента основания в конце октября 2024 года количество участников UALink выросло до более чем 65 компаний, сообщил Куртис Боуман (Kurtis Bowman), председатель совета директоров UALink. Новые участники совета директоров заявили, что совместная работа над интерконнектом для ускорителей будет способствовать повышению эффективности выполнения рабочих нагрузок ИИ. Представитель Apple отметил, что UALink демонстрирует большие перспективы в решении проблем подключения и создании новых возможностей ИИ-индустрии. В консорциум входит широкий круг компаний, от поставщиков облачных услуг и OEM-производителей до разработчиков ПО и полупроводниковых компонентов во главе с AMD, AWS, Astera Labs, Cisco, Google, HPE, Intel, Meta✴ и Microsoft, представляющих основные области разработки решений для повышения производительности нагрузок ИИ.

Источник изображения: UALink Ожидается, что выпуск спецификации UALink 1.0 состоится в I квартале 2025 года. Она предусматривает пропускную способность до 200 Гбит/с на линию и возможность объединения до 1024 ИИ-ускорителей в пределах одного домена.

20.12.2024 [23:39], Владимир Мироненко

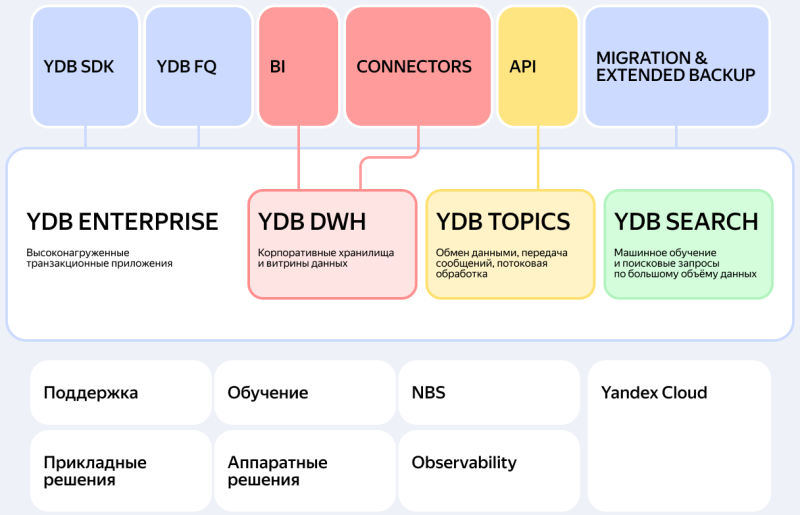

«Яндекс» представил компонент YDB DWH для аналитической обработки данных в СУБД YDB«Яндекс» объявил о выходе нового компонента YDB DWH для поддержки аналитической обработки данных в СУБД YDB собственной разработки. СУБД YDB поддерживает работу со сложными аналитическими запросами (OLAP) — благодаря массивно-параллельной архитектуре (МРР) обеспечивает хранение сотен Тбайт данных и быстрое выполнение запросов, а также горизонтально масштабируется за счёт автоматического партиционирования по объёму и нагрузке. Как сообщается, аналитическая функциональность компонента YDB DWH включает колоночные таблицы с консистентным хранением данных и управление смешанной нагрузкой. Платформа СУБД Яндекса также включает движок выполнения запросов со спиллингом данных на диск, стоимостной оптимизатор и поддержку федеративных SQL-запросов к внешним источникам данных: S3, PostgreSQL, Greenplum, Oracle, MS SQL. Это позволяет создавать корпоративного хранилища данных. В перспективе — поддержка SQL-диалекта PostgreSQL для бесшовной интеграции как для OLAP-, так и OLTP-сценариев. Благодаря запуску YDB DWH, СУБД YDB стала универсальным решением для высокопроизводительной обработки транзакций и аналитических запросов, говорит компания. Подчёркивается, что рынку не хватает универсальных СУБД, способных работать в бизнес-критичных сценариях. Данное решение особенно актуально для финансового, телекоммуникационного и ретейла. По оценке «Яндекса», рынок систем по обработке данных в России в 2025 году составит 55 млрд руб. При этом доля аналитических СУБД будет составлять 32 % общего рынка обработки данных. Помимо YDB DWH, в линейку лицензируемых надстроек СУБД YDB также входит шина данных YDB Topics и надстройка для задач машинного обучения YDB Search. Основной компонент платформы — компонент YDB Enterprise для высокопроизводительной обработки транзакций. Платформа предлагается по коммерческой лицензии для установки в контуре заказчика и как управляемый сервис в Yandex Cloud.

07.12.2024 [18:11], Руслан Авдеев

M1Cloud рассказала о тенденциях на облачном рынке России в уходящем годуВ 2024 году на облачном рынке России сформировался ряд трендов, которые будут определять развитие соответствующей сферы в ближайшие годы. Облачный провайдеров M1Cloud рассказал о ключевых изменениях рынка. По его словам, в 2024 году провайдеры продолжили наладку схем параллельного импорта серверов и СХД иностранных вендоров, благодаря чему сохранились темпы роста облачной инфраструктуры. А крупным компаниям удалось построить облачные сегменты на российском программном и аппаратном обеспечении. Вместе с тем усложнение цепочек поставок вызвало рост спроса на сервисы Bare Metal. Статистика M1Cloud показывает, что более 50 % российских компаний применяют облачные решения, а 30 % намерены дополнить их сервисами Bare Metal. Также в уходящем году отмечено увеличение инвестиций в облачные технологии, в особенности в готовые ИИ-сервисы мультиоблачные системы. Облака начинают интегрировать решения на базе ИИ и Big Data. На этом фоне отмечен рост стартапов, связанных с разработкой решений для облачных сервисов, обеспечения безопасности и управления данными. Сами провайдеры тоже развивают защитные инструменты, в том числе системы предотвращения утечек, а бизнес всё чаще локализует свою информацию в соответствии с требованиями российских законов. Мультиоблачный подход способствует развитию автоматизации и оркестрации. По словам M1Cloud, крупные провайдеры уделяют внимание и развитию в регионах дата-центров и облачных ресурсов. Наконец, растёт количество образовательных программ, связанных с подготовкой специалистов в области облачных технологий, благодаря чему растёт и квалификация работающих в отрасли кадров. В целом российские облака приспосабливаются к текущей обстановке, из-за чего растёт спрос не только на IaaS, но и появляются решения, отвечающие специальным запросам бизнеса. В частности, развиваются отраслевые облачные платформы, сервисы для малых и средних предприятий, инструменты ИИ и ML, внедряются DevOps-подходы и CI/CD, облачные API и микросервисные архитектуры. Как ранее прогнозировала iKS-Consulting, к 2028 году российский рынок облачной инфраструктуры вырастет до 464 млрд руб., а к концу 2024 года может вырасти до 162 млрд руб. с 121,4 млрд руб. в прошлом году.

20.11.2024 [13:04], Руслан Авдеев

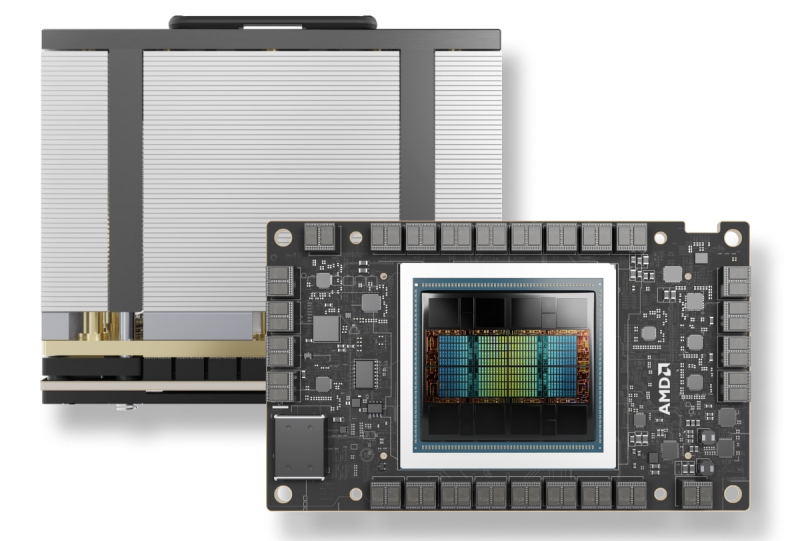

IBM и AMD расширяют сотрудничество: Instinct MI300X появится в облаке IBM CloudКомпания IBM объявила о расширении сотрудничества с AMD для предоставления ускорителей Instinct MI300X в формате «ускорители как услуга» (Accelerators-as-a-Service). По словам IBM, новое решение расширяет возможности и энергоэффективность генеративных ИИ-моделей и HPC-приложений. AMD Instinct MI300X станут доступны в IBM watsonx, а также будут поддерживаться в Red Hat Enterprise Linux AI. Они дополнят портфолио IBM Cloud, уже включающее Intel Gaudi 3 и NVIDIA H100. Ускоритель AMD Instinct MI300X оснащён 192 Гбайт памяти HBM3. И относительно малое количество ускорителей способно обеспечить работу больших ИИ-моделей, что позволяет снизить затраты с сохранением производительности и масштабируемости. Ускорители будут доступны в составе виртуальных серверов и частных виртуальных облаков, а также в контейнеризированных средах IBM Cloud Kubernetes Service и IBM Red Hat OpenShift. Кроме того, для MI300X будут доступны LLM Granite и инструмент InstructLab. Речь идёт в том числе об интеграции программных решений IBM с ПО AMD ROCm. По словам компании, предложенные решения обеспечит клиентов гибкой, безопасной, высокопроизводительной и масштабируемой средой для рабочих нагрузок ИИ. AMD Instinct MI300X станут доступны пользователям IBM Cloud в I половине 2025 года.

15.11.2024 [22:14], Владимир Мироненко

«Яндекс» объединил технологии и инструменты в сфере B2B в одно бизнес-направление«Яндекс» создал новое бизнес-направление Yandex B2B Tech для работы в сфере B2B (Business-to-Business). Новая бизнес-группа объединит соответствующие технологии и инструменты, включая облачные продукты Yandex Cloud и «Яндекс 360». «Яндекса» ожидает, что объём рынка, на котором будет работать новое подразделение, вырастет до 510 млрд руб. в 2028 году с 240 млрд руб. в текущем. Среднегодовой темп роста (CAGR) в этот период составит порядка 21 % Сообщается, что новая структура будет предлагать заказчикам комплексные решения в различных областях, среди них:

Источник изображения: «Яндекс» Корпоративные пользователи смогут воспользоваться сервисами Yandex B2B Tech либо в облаке (*aaS или посредством API), либо на собственных серверах (on-premise). Согласно пресс-релизу «Яндекса», формат on-premise — новый для компании, но она видит спрос на него со стороны клиентов, желающих хранить и обрабатывать данные внутри организации. В этом формате компания уже предоставляет доступ к СУБД YDB, технологии генеративной языковой модели, которая может создавать тексты YandexGPT, технологии распознавания и синтеза речи SpeechKit, а также BI-инструмент DataLens. |

|