Материалы по тегу: ai

|

31.01.2025 [20:57], Руслан Авдеев

ИИ-модели OpenAI и суперкомпьютер Venado встанут на защиту национальной безопасности СШАЛос-Аламосская национальная лаборатория США (LANL) заключила соглашение с OpenAI об использовании моделей серии o на ИИ-суперкомпьютере Venado. Система, оснащённая суперускорителями NVIDIA GH200, среди прочего будет использоваться для исследований в сфере национальной безопасности. Новые модели способны решать всё более сложные научные задачи, в том числе прикладные. В лаборатории подчеркнули, что угрозы для страны становятся всё более сложными и актуальными, поэтому нужны новые подходы для обеспечения её безопасности. Модели OpenAI, в частности вариант o1, позволят более эффективно справляться с задачами и помогут решить некоторые насущные проблемы страны. Venado включат в защищённую секретную сеть, где его ресурсами смогут воспользоваться исследователи из Лос-Аламоса, Ливерморской национальной лаборатории (LLNL) или Сандийских национальных лабораторий (SNL). Сотрудничество этих структур Министерства энергетики США (DoE) с IT-компаниями обеспечит новые возможности для научных исследований. Сообщается, что почти во всех проектах лаборатории ИИ уже используется в том или ином качестве. Ранее LANL сотрудничала с OpenAI над повышением безопасности ИИ и оценкой «способности к рассуждению» модели o1. Теперь модели OpenAI регулярно используются национальными лабораториями в энергетических проектах, разработке новых материалов и создании квантовых алгоритмов. Использование моделей в секретной сети только расширит их возможности и позволит вносить более глубокий вклад в выполнение разных задач. Новые ИИ-модели, по словам LANL, позволят США пересмотреть сами основы научных знаний и достигнуть нового уровня технического прогресса. С их использованием можно найти новые способы лечения и профилактики заболеваний, добиться лидерства в энергетической сфере благодаря раскрытию полного потенциала природных ресурсов и преобразовать энергетическую инфраструктуру страны, лучше выявлять природные и антропогенные угрозы, от биологических до кибернетических или угроз энергосистеме — ещё до их реального возникновения. Также известно о сотрудничестве LANL и OpenAI для оценки возможностей ИИ в биологических исследованиях. Так, по данным The Register, оценивались возможности ИИ для создания биологического оружия. Впрочем, нашлось им и более мирное применение — оценка снижении угрозы ядерной войны и ядерных угроз вообще. Это не единственный из недавних примеров сотрудничества OpenAI с американским правительством. Пару дней назад компания заявила о премьере бота ChatGPT Gov — варианта корпоративной версии ChatGPT Enterprise. Предварительные испытания уже прошли в нескольких организациях для обработки «непубличных конфиденциальных данных».

31.01.2025 [00:00], Руслан Авдеев

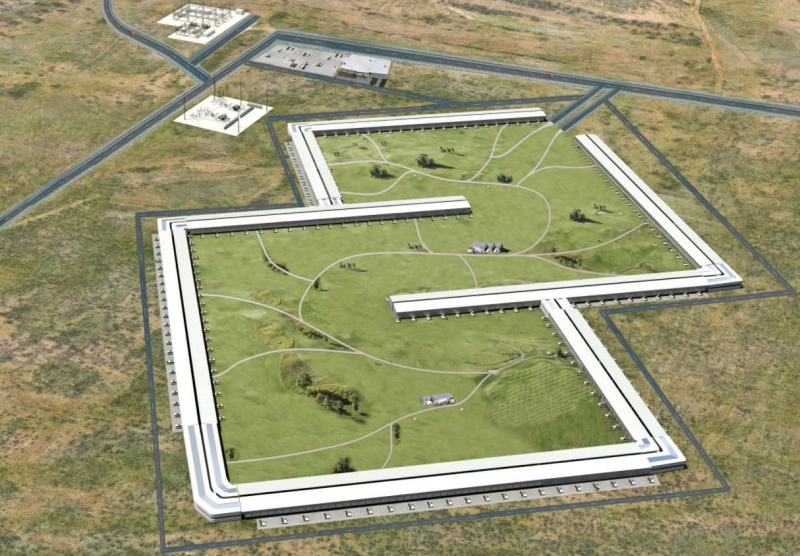

Первая очередь ЦОД для ИИ-мегапроекта Stargate обойдётся всего в $1,1 млрдОфициальные документы пролили свет на некоторые аспекты строительства кампуса Stargate в Техасе. Первая очередь ЦОД, как ожидается, будет завершена к концу 2025 года и обойдётся в $1,1 млрд, сообщает Business Insider. Пока о Stargate известно не очень много. Поданные техасским властям документы свидетельствуют о том, что стройка зарегистрирована под названием Project Ludicrous и расположена по адресу, соответствующему местоположению Lancium Clean Campus — участка площадью 505 га в Абилине (Abilene), принадлежащей компании Lancium. Недавно появилась информация, что кампус будет питаться от газовых и ветряных турбин, а также солнечной электростанции. Владельцем Project Ludicrous названа Abilene DC 1 — дочерняя структура Crusoe Energy, которая в конце 2024 года привлекла $600 млн на строительство в Техасе. Согласно общедоступным официальным документам, арендатором ЦОД, принадлежащего Abilene DC 1 и расположенного в Lancium Clean Campus, является Oracle. Контактным лицом арендатора Project Ludicrous в документах также указан сотрудник Oracle. С июля по декабрь 2024 года представители Project Ludicrous подали техасскому регулятору четыре заявления, касающиеся строительства двух объектов. Строительство первого, одноэтажного объекта площадью 45 тыс. м2 оценивается в $292 млн. Оно началось в июне прошлого года и должно завершиться к лету 2025-го. В документах также фигурируют планы создания помещения для охраны, здания для пожарных насосов, механических и электрических корпусов. Во втором заявлении, поданном в сентябре 2024 года, речь идёт об оснащении стоимостью $140 млн — работы начались в декабре и, вероятно, будут завершены к 15 сентября текущего года. Второй объект полностью аналогичен первому. Его строительство началось осенью прошлого года и завершится в сентябре 2025-го. Оснащение объекта начнётся в марте 2025 года и завершится к 24 декабря, оно оцениваются в $384 млн. Lancium заключила соглашение о застройке с властями Абилина в 2021 году. Изначально кампус Lancium Clean был рассчитан на «зелёные» майнинговые ЦОД, но этот проект так и не был реализован. В ноябре 2024 года Crusoe Energy объявила о планах создания 205-МВт ИИ ЦОД за $3,4 млрд на территории данного кампуса, который уже был сдан в аренду неназванному гиперскейлеру «из списка Fortune 100». Ожидалось, что «заселение» начнётся в первой половине 2025 года. О том, что арендатором станет Oracle, которая сдаст мощности OpenAI, сообщалось и ранее.

30.01.2025 [16:01], Руслан Авдеев

SoftBank не прочь вложить до $25 млрд в OpenAISoftBank Group обсуждает возможные инвестиции до $25 млрд в OpenAI. Потенциально это может сделать ее крупнейшим спонсором ИИ-стартапа на пороге реализации важнейших проектов, сообщает Bloomberg. Как сообщают источники издания, японский инвестор рассчитывает вложить $15-25 млрд, не считая $15 млрд, которые SoftBank выделит на ИИ-суперпроект Stargate (по другим данным, $19 млрд), который реализуется совместно с OpenAI, Oracle и рядом других компаний. Изначально на Stargate намерены выделить в общей сложности $100 млрд с возможностью увеличения вложений до $500 млрд в течение четырёх лет. В развитии примет участие как Softbank, так и её дочерние компании. Впервые Softbank предложила OpenAI $1 млрд ещё в 2019 году, но сделка так и не состоялась. С тех пор компании сблизились и в прошлом месяце стартап получил $500 млн от Vision Fund. Также OpenAI разрешила сотрудникам продать Softbank акции компании на сумму порядка $1,5 млрд. Softbank и OpenAI отказались от комментариев по поводу инвестиций. Microsoft, которая пока является крупнейшим инвестором OpenAI ($13 млрд из $20 млрд, полученных за всё время), тоже отказалась от комментариев. Ранее сообщалось, что компании продолжат сотрудничать как минимум до 2030 года. Игроки рынка ИИ вроде Илона Маска (Elon Musk) ставят под вопрос перспективы Stargate и возможности его финансирования. Маск сомневается в том, что участвующие в проекте компании смогут выполнить взятые на себя обязательства. На конец сентября у SoftBank было $25 млрд свободных средств, а также активы в сотнях стартапов и 90 % акций Arm, которые в теории тоже можно будет внести в качестве взноса. Тем не менее скептицизм по поводу возможности масштабирования проекта Stargate сохраняется.

28.01.2025 [23:00], Руслан Авдеев

Первый ЦОД Stargate получит собственные газовые турбины, солнечную электростанцию и энергохранилище

caterpillar

crusoe energy

general electric

hardware

openai

oracle

softbank

stargate

аккумулятор

ибп

ии

кадры

сша

цод

электропитание

энергетика

Для бесперебойного снабжения электроэнергией американского суперпроекта Stargate, помимо подключения к энергосети, будут использоваться солнечная энергия, природный газ, аккумуляторные энергохранилища и дизель-генераторы, сообщает Datacenter Dynamics. Строительство первого ЦОД уже начато в Техасе. По данным источников Bloomberg, знакомых с планами развития Stargate, часть энергии, вероятно, будет поступать от SB Energy, дочерней структуры компании SoftBank, предлагающей солнечные и аккумуляторные решения. SB Energy уже довольно давно планировала запитать ЦОД в Техасе. В прошлом году компания объявила о трёх соответствующих проектах для дата-центров Google. Речь идёт о «солнечном поясе» Orion Solar Belt — солнечных электростанциях Orion I, Orion II и Orion III суммарной мощностью почти 900 МВт (258 МВТ, 302 МВт и 315 МВт соответственно). OpenAI сообщила журналистам, что рассматриваются различные варианты модернизации энергосистемы Соединённых Штатов с использованием самых разных технологий — от атомной энергетики до аккумуляторных энергохранилищ. Поскольку одной только солнечной энергии для Stargate вряд ли хватит, OpenAI будет использовать и другие источники. Подрядчики Stargate уже подали заявку на строительство электростанции на природном газе мощностью 360,5 МВт и стоимостью около $500 млн. Всего будет задействовано десять газовых турбин — по пять от GE Vernova и Solar Turbines («дочка» Caterpillar). Они напрямую будут питать дата-центр. Заявку подала компания, работающая в интересах Crusoe Energy, которая, в свою очередь, ещё летом начала строительство 205-МВт ИИ ЦОД для Oracle и OpenAI в техасском Абилине (Abilene), также известного как Project Ludicrous. Именно этот кампус, как ожидается, станет первой действующей площадкой Stargate. Кроме того, уже получено разрешение на установку резервных дизель-генераторов. Дополнительно появилась информация о том, что OpenAI ищет для Stargate менеджера по закупкам, ответственного за оборудованиее и работу с поставщиками, и технического руководителя программ, отвечающий за инфраструктурную стратегию. Обе вакансии предполагают широкий круг обязанностей, от соискателей требуется не менее пяти лет опыта работы в крупных проектах. Не так давно OpenAI уже переманила из Meta✴ специалиста по цепочкам поставок для помощи в реализации проекта Stargate.

24.01.2025 [15:23], Руслан Авдеев

Microsoft и OpenAI останутся партнёрами до 2030 годаКомпания Microsoft объявила о новом этапе сотрудничества с OpenAI. В числе прочего пресс-служба IT-гиганта упомянула о взаимодействии в рамках проекта Stargate. По данным Microsoft, партнёрство, развивавшееся с 2019 года, перешло в новую фазу. Не исключено, что публичное заявление компании — ответ на волну слухов, появившихся после изменения политики использования OpenAI облачных ресурсов. Многие буквально уверены, что Редмонд теряет хватку и упускает OpenAI из сферы своего влияния. Возможно, поэтому компания сама спешит сообщить, что если раньше партнёрское соглашение об использовании облаков было эксклюзивным и OpenAI могла пользоваться только ресурсами Microsoft (в одном случае Oracle с оговорками), то теперь она сможет прибегать к помощи сторонних облачных провайдеров чаще. У Microsoft сохранится право «первого отказа» и сначала OpenAI по-прежнему должна обращаться за облачными ресурсами именно к ней, и лишь в случае их недоступности — к другим провайдерам. При этом Microsoft подчёркивает, что OpenAI недавно вновь обязалась использовать Azure в ещё больших масштабах для поддержки своих продуктов и обучения моделей. Также компания напоминает, что ключевые элементы партнёрского соглашения не изменятся до окончания договора в 2030 году. Гиперскейлер сохранит доступ к интеллектуальной собственности OpenAI, предполагается обмен выручкой в соответствии с существующими договорённостями и сохранятся эксклюзивные права Microsoft на API ИИ-стартапа. В частности, Microsoft сохраняет право использовать интеллектуальную собственность OpenAI, включая ИИ-модели, в продуктах вроде Copilot. API OpenAI будут эксклюзивно использоваться в облаке Azure и доступны посредством Azure OpenAI Service. Соглашение означает, что клиенты будут получать доступ к самым передовым моделям на платформе Microsoft напрямую от OpenAI. А выручкой компании будут обмениваться в двухстороннем порядке, это будет на руку обеим благодаря росту использования новых и уже существующих моделей. Наконец, Microsoft подчеркнула, что остаётся главным инвестором OpenAI, обеспечивая компанию средствами и облачными ресурсами для поддержки развития — одной из ключевых выгод самой Microsoft является поступательный рост стоимости ИИ-стартапа. Сейчас OpenAI участвует в многомиллиардном американском ИИ-проекте Stargate совместно с Oracle и SoftBank (помимо Microsoft), поэтому дополнительные ресурсы ей, безусловно, понадобятся.

24.01.2025 [12:10], Сергей Карасёв

OpenAI наняла руководителя цепочки поставок Meta✴ для помощи в реализации проекта StargateКомпания OpenAI, по сообщению ресурса Datacenter Dynamics, наняла на работу Кита Хейде (Keith Heyde), который ранее занимал руководящую должность в Meta✴. На новой позиции он будет участвовать в масштабном проекте Stargate по развитию ИИ-инфраструктуры в США. В Meta✴ Хейде курировал работу цепочки поставок вычислительного оборудования и СХД для систем ИИ. Речь идёт, в частности, о первом ИИ-кластере Meta✴, оснащённом примерно 100 тыс. ускорителей. Он также руководил тремя командами, отвечавшими за взаимодействие с поставщиками стоечных решений и серверов. Хейде проработал в Meta✴ без малого четыре года. До этого он трудился в компании Wing — подразделении Alphabet, которое специализируется на разработке средств доставки товаров при помощи беспилотных летательных аппаратов. В OpenAI Хейде перешёл ещё в ноябре 2024 года, однако известно об этом стало только сейчас. Какие именно функции Хейде будет выполнять в рамках инициативы Stargate, не уточняется. Напомним, в марте прошлого года сообщалось, что по проекту Stargate корпорация Microsoft и OpenAI намерены построить кампус ЦОД стоимостью $100 млрд для решения самых сложных и ресурсоёмких задач в области ИИ. А несколько дней назад стало известно, что название Stargate получит новое совместное предприятие OpenAI, Softbank и Oracle, которое займётся развитием «физической и виртуальной инфраструктуры для поддержки следующего поколения ИИ». В проекте примут участие Microsoft, Arm и Nvidia, а также фонд MGX с Ближнего Востока. На первом этапе SoftBank Group и OpenAI намерены вложить в Stargate по $19 млрд, а общие инвестиции в предприятие в течение четырёх лет, как ожидается, достигнут $500 млрд. По всей видимости, Хейде на новой должности в OpenAI займётся вопросами поставок оборудования. Развёртывание масштабной ИИ-инфраструктуры уже началось в Техасе.

23.01.2025 [22:44], Руслан Авдеев

SoftBank и OpenAI намерены выделить по $19 млрд на ИИ-проект Stargate, но Маск уверен что на это нет денегИлон Маск (Elon Musk) усомнился в наличии денег на реализацию эпохального ИИ-проекта Stargate с участием OpenAI, Oracle и SoftBank, поддерживаемого новым президентом США Дональдом Трампом (Donald Trump). Сами компании выражают уверенность в успехе предприятия, передаёт Bloomberg. SoftBank Group и OpenAI намерены вложить в Stargate по $19 млрд. По сведениям The Information, компании хотят получить по 40 % в новом предприятии. В течение четырёх лет общие инвестиции в проект могут вырасти до $500 млрд. Глава SoftBank Масаёси Сон (Masayoshi Son), руководитель OpenAI Сэм Альтман (Sam Altman) и основатель Oracle Ларри Эллисон (Larry Ellison) на встрече в Белом доме объявили, что в рамках проекта Stargate выделят $100 млрд на строительство дата-центров и другой инфраструктуры, после чего акции участников заметно поднялись в цене. Альтман пояснил, что Stargate похож на «венчурный фонд», в котором OpenAI и SoftBank являются главными партнёрами. Oracle и фонд MGX (создан Mubadala и G42) из ОАЭ внесут по $7 млрд. Остальные деньги привлекут от других партнёров и за счёт заёмного финансирования. Глава SoftBank в прошлом месяце объявил о намерении компании потратить $100 млрд в течение предстоящего президентского срока Трампа. Средства на Stargate, видимо, входят в эту сумму. Ранее сообщалось, что схема финансирования SoftBank предусматривает привлечение гиперскейлеров — тогда десятки миллиардов инвестиций могут перерасти в сотни. По словам Эллисона, некоторые дата-центры для Stargate уже строятся. Впрочем, Илон Маск, не перестающий сводить счёты с OpenAI, утверждает, что у инвесторов нет денег на Stargate. Бизнесмен, возглавивший «техническое подразделение» Белого дома United States DOGE Service, призванное обеспечить эффективность цифровых сервисов, сообщил со ссылкой на «надёжные источники», что у SoftBank в распоряжении не более $10 млрд. По данным Bloomberg, у компании есть ¥3,8 трлн ($25 млрд) непосредственно в валюте и её эквивалентах. Альтман же предложил посетить первую площадку, где работы уже ведутся, и выразил надежду, что Маск сможет сделать верный выбор в новой роли государственного служащего, определив, что важнее — благо его собственных компаний или благо страны. Новый президент США дал понять, что лидерство страны в области ИИ является безусловным приоритетом и что он готов пойти на резкие шаги. Так, уже произошёл фактический отказ от некоторых экологических обязательств в пользу обеспечения энергией ИИ ЦОД и промышленности в целом. Ещё при прежнем президенте США Джо Байдене (Joe Biden) было решено выделить под ИИ-инфраструктуру федеральные земли.

22.01.2025 [17:54], Руслан Авдеев

Microsoft разрешила OpenAI пользоваться облаками конкурентовMicrosoft изменила многолетнее соглашение с компанией OpenAI — теперь ИИ-стартап сможет использовать для своих целей облачные сервисы не только сервисы Microsoft, но и других компаний. Исключительное право Microsoft на обеспечение стартапа облачными ресурсами предусматривалось прежним договором, который был пересмотрен, сообщает Bloomberg. Новое соглашение, действующее до 2030 года, оставляет Microsoft приоритетным поставщиком — ИИ-стартап при поиске вычислительных мощностей для обучения и эксплуатации ИИ-моделей первым делом должен обращаться именно к Microsoft. Ранее компания и вовсе являлась исключительным облачным провайдером для OpenAI, но обстоятельства изменились и в прошлом году она уже одобрила единовременное исключение из правил, позволив OpenAI воспользоваться мощностями Oracle, при этом оставаясь лишь посредником. Также объявлено, что теперь OpenAI сможет строить и собственные ЦОД. Пересмотр соглашения совпал с анонсом проекта Stargate, в рамках которого OpenAI, Softbank Group и Oracle создадут совместное предприятие по строительству в США гигаваттных ИИ ЦОД. Общий объём инвестиций может достичь $500 млрд. О сделке счёл нужным сообщить сам новый президент США Дональд Трамп (Donald Trump). Он же отменил ряд указов оставившего пост Джо Байдена (Joe Biden) и фактически снял многие экологические ограничения в интересах ИИ-проектов и промышленников.

Истчоник изображения: Growtika/unsplash.com Microsoft заявила, что внесёт вклад в технологии совместного предприятия, но не намерена инвестировать в него деньги. Также компания заявила, что OpenAI недавно снова выразила приверженность договорённости использовать Microsoft Azure для поддержки своих продуктов. По данным Bloomberg, ближайший соратник Трампа Илон Маск (Elon Musk) пытается свести с OpenAI собственные счёты, заявив в недавнем судебном иске, что Федеральная комиссия по торговле США (FTC) не напрасно заинтересовалась инвестициями Microsoft в OpenAI в размере $13 млрд и что соглашение между компаниями «неконкурентное». Мультимиллиардер пытается заблокировать реструктуризацию OpenAI, не давая компании окончательно превратиться из формально некоммерческой структуры в полноценный бизнес. Впрочем, здесь интересы Маска и Трампа, вероятно, расходятся, поскольку проект Stargate трудно назвать некоммерческим. 10 января Министерство юстиции присоединилось к FTC и поддержало позицию Маска, заявившего, что советы директоров Microsoft и OpenAI взаимосвязаны и в них сидят одни и те же люди. Маск был одним из сооснователей OpenAI, но позже покинуть компанию и теперь развивает собственный амбициозный проект xAI. OpenAI, сотрудничающая с Microsoft, Oracle и SoftBank является для него серьёзнейшим конкурентом.

22.01.2025 [00:32], Владимир Мироненко

OpenAI, Oracle и Softbank вложат $100 млрд в ИИ-инфраструктуру США, а в перспективе — до $500 млрдПрезидент США Дональд Трамп (Donald Trump) объявил во вторник об инвестициях частного сектора в размере до $500 млрд на финансирование инфраструктуры искусственного интеллекта (ИИ), стремясь превзойти конкурирующие страны в критически важных для бизнеса технологиях, пишет Reuters. Трамп сообщил на брифинге в Белом доме, что OpenAI, Softbank и Oracle планируют создать совместное предприятие под названием Stargate, которое построит «физическую и виртуальную инфраструктуру для поддержки следующего поколения ИИ», включая ЦОД по всей стране. О проекте Stargate по созданию 5-ГВт ИИ ЦОД за $100 млрд сообщалось ещё весной прошлого года, но тогда речь шла о совместном предприятии Microsoft и OpenAI. К президенту присоединились глава SoftBank Масаёси Сон (Masayoshi Son), гендиректор OpenAI Сэм Альтман (Sam Altman) и председатель директоров Oracle Ларри Эллисон (Larry Ellison), чтобы объявить о создании нового предприятия, которое Трамп назвал «крупнейшим проектом инфраструктуры ИИ в истории». Эти компании, наряду с другими акционерами Stargate инвестируют для начала $100 млрд в проект, а оставшиеся инвестиции, как ожидается, будут сделаны в течение следующих четырёх лет. Ожидается, что проект создаст 100 тыс. рабочих мест в США, сказал Трамп.

Источник изображения: Taylor Vick/unsplash.com SoftBank, OpenAI и Oracle указаны как «первоначальные инвесторы в акционерный капитал» в Stargate. Microsoft также участвует в Stargate в качестве технологического партнера, равно как и Arm с Nvidia. Фонд MGX с на Ближнего Востока присоединится к SoftBank в его инвестициях. Первой публичной сделкой MGX была инвестиция в OpenAI. Эллисон сообщил, что первый гигаваттный ЦОД площадью 92,9 тыс. м2 уже строится в техасском Абилине (Abilene). Он сказал, что будет построено двадцать ЦОД, площадью 46,5 тыс. м2 каждый. SoftBank будет нести финансовую ответственность за Stargate, а OpenAI — операционную ответственность. Четвёртый партнёр, MGX, также внесёт свой вклад в финансирование СП. Масаёси Сон станет председателем Stargate, заявила OpenAI. После публикации этой новости акции Oracle подскочили примерно на 7 %, побив рекорд роста в течение дня, установленный 26 декабря прошлого года. Акции Oracle увеличились за последний год примерно на 56 %. Oracle заявила, что проект Stargate «обеспечит американское лидерство в области ИИ, создаст сотни тысяч рабочих мест в Америке и принесет огромную экономическую выгоду всему миру. Этот проект не только поддержит реиндустриализацию Соединенных Штатов, но и предоставит стратегические возможности для защиты национальной безопасности Америки и ее союзников». Ранее в этом месяце миллиардер Хуссейн Саджвани (Hussain Sajwani) из ОАЭ пообещал , что его компания DAMAC инвестирует $20 млрд в американские ЦОД.

18.01.2025 [22:48], Сергей Карасёв

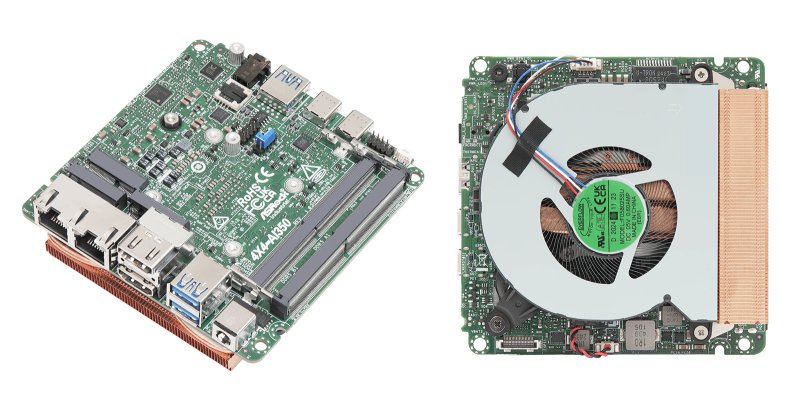

ASRock представила индустриальные мини-ПК и материнские платы на базе Intel Arrow Lake-H и AMD Ryzen 300 AIКомпания ASRock Industrial, по сообщению ресурса CNX-Software, представила индустриальные компьютеры небольшого форм-фактора NUC(S) Ultra 200 Box и материнские платы NUC Ultra 200 на новейших процессорах Intel Core Ultra 200H (Arrow Lake-H). Кроме того, дебютировали аналогичные устройства 4X4 Box AI300 и платы 4X4 AI300 на чипах AMD Ryzen AI 300. Модели NUC Ultra 200 Box, NUCS Ultra 200 Box и платы NUC Ultra 200 в зависимости от модификации комплектуются процессором Core Ultra 7 255H (6P+8E) с частотой до 5,1 ГГц или Core Ultra 5 225H (4P+8E) с частотой до 4,9 ГГц. В первом случае используется узел Intel Arc 140T GPU (74 TOPS), во втором — Intel Arc 130T GPU (63 TOPS). Оба чипа оснащены блоком Intel AI Boost с производительностью 13 TOPS. Новинки поддерживают до 96 Гбайт оперативной памяти DDR5-6400 в виде двух модулей SO-DIMM. Есть по одному разъёму M.2 Key M 2242 (PCIe 4.0 x4) и M.2 Key M 2242/2280 (PCIe 4.0 x4) для NVMe SSD, а также M.2 Key E 2230 (PCIe x1, USB 2.0, CNVi) для контроллера Wi-Fi/Bluetooth. Модели с обозначением NUC и материнские платы также снабжены портом SATA-3. В оснащение входят звуковой кодек Realtek ALC256 и сетевой адаптер 2.5GbE на базе Intel I226LM. Платы и модели NUC оснащены дополнительным портом 2.5GbE на основе Intel I226V. Кроме того, мини-компьютеры несут на борту комбинированный адаптер Wi-Fi 6E (802.11ax) + Bluetooth 5.3. Все изделия располагают двумя выходами HDMI 2.1 TMDS (4096 × 2160 точек @ 60 Гц) и двумя портами DisplayPort 2.1/1.4a, интерфейсом DP++/USB Type-C (4096 × 2160 @ 60 Гц), аудиогнездом на 3,5 мм, портами USB 3.2 Gen2 Type-A (три у NUCS и четыре у NUC), интерфейсом USB4/Thunderbolt 4, портом USB 3.2 Gen2 x2 Type-C. На плате есть разъёмы для двух портов USB 2.0 и последовательного порта RS232/RS422/RS485. Габариты NUC составляют 117,5 × 110,0 × 49 мм, NUCS — 117,5 × 110,0 × 38 мм, плат — 104 × 102 мм. Диапазон рабочих температур у мини-компьютеров простирается от 0 до +40 °C, у плат — от -20 до +70 °C. В свою очередь, компьютеры 4X4 Box AI300 и платы 4X4 AI300 могут комплектоваться процессором AMD Ryzen AI 7 350 (8 ядер; до 5,0 ГГц; AMD Radeon 860M) или AMD Ryzen AI 5 340 (6 ядер; до 4,8 ГГц; AMD Radeon 840M). В обоих случаях задействован нейропроцессор Ryzen AI на архитектуре XDNA 2 с производительностью до 50 TOPS. Объём памяти DDR5-5600 может достигать 96 Гбайт (два модуля SO-DIMM). Изделия наделены коннекторами M.2 Key M 2242 (PCIe 4.0 x4) и M.2 Key M 2242/2280 (PCIe 4.0 x4) для NVMe SSD, а также слотом M.2 Key E 2230 (PCIe x1, USB 2.0) для адаптера Wi-Fi/Bluetooth (мини-компьютеры несут на борту модуль Wi-Fi 6E). В оснащение входят сетевые адаптеры 2.5GbE (Realtek RTL8125BG) и 1GbE (Realtek RTL8111H), звуковой кодек Realtek ALC256. Набор разъёмов включает по два интерфейса HDMI 2.1 (7680 × 4320 @ 60 Гц) и DisplayPort 1.4a / USB Type-C (4096 × 2160 @ 60 Гц), аудиогнездо на 3,5 мм, три порта USB 3.2 Gen2 Type-A, два порта USB4/Thunderbolt 4, два порта USB 2.0 (через коннекторы на плате). Размеры компьютеров составляют 117,5 × 110,0 × 49 мм, плат — 104 × 102 мм. Диапазон рабочих температур — от 0 до +40 °C и от 0 до +70 °C соответственно. |

|