Материалы по тегу: цод

|

29.11.2023 [09:09], Алексей Степин

Экологичные GPU-серверы: HOSTKEY развернула новую площадку в Исландии на базе «зелёного» ЦОД Verne GlobalКомпания HOSTKEY, оказывающая услуги по размещению, аренде и обслуживанию серверного оборудования, объявила о запуске новой хост-площадки, на этот раз не совсем обычной. Речь идёт о дата-центре Verne Global уровня Tier III в Исландии, полностью запитанному от возобновляемых источников энергии. Благодаря тому, что исландский ЦОД питается исключительно от ГЭС и геотермальных станций с низкой стоимостью электроэнергии, а относительно низкая «забортная» температура упрощает и удешевляет охлаждение, его можно назвать действительно «зелёным». Сочетание этих качеств позволяет без лишних затрат размещать в ЦОД мощные серверы, в том числе с ускорителями для ИИ и HPC-задач. Собственно говоря, именно это теперь и предлагает HOSTKEY, причём, как и прежде, она готова принимать оплату в рублях. Речь идёт о серверах — как выделенных (VDS), так и виртуальных (VPS) — с графическими ускорителями. В настоящее время сообщается только о решениях NVIDIA, но спектр доступных GPU достаточно широк — в него входят как игровые видеокарты GeForce RTX 3080/3090/4090, так и профессиональные RTX A4000/A5000/A6000. Некоторые конфигурации включают до четырёх GPU, в том числе с NVLink-подключением. Объём оперативной памяти стартует с отметки 32 Гбайт (VPS) и может достигать 384 Гбайт (выделенный сервер), количество выделенных ядер в VPS-варианте — от 8. Все системы оснащены SSD, а в старших конфигурациях предлагаются NVMe-накопители. В зависимости от конфигурации в системе могут быть использованы процессоры Intel Core i9, AMD Ryzen или AMD EPYC. Доступны индивидуальные конфигурации, а выделенные серверы оснащены IPMI.

Источник: Verne Global Кроме того, есть и традиционные VPS без ускорителей: 1–32 ядра (Intel Xeon E5-26xx или Cascade Lake-SP Refresh 6226R), 1–32 Гбайт RAM, 15–480 Гбайт SSD (в том числе NVMe). Время развёртывания для VPS, по словам HOSTKEY, начинается от 15 минут, а для выделенных вариантов со сложной конфигурации оно не превышает 4 часов. GPU-серверам по умолчанию полагается подключение 1 Гбит/с и 50 Тбайт трафика ежемесячно, а обычным VPS — такое же подключение, но только 3 Тбайт трафика. Как и во всех других регионах, в Исландии доступен маркетплейс, который позволяет быстро развернуть различное ПО. ЦОД Verne Global оснащён системой резервного питания по схеме N+1, предусмотрено двойное резервирование (2N) от источника питания до стойки. Также Verne Global говорит, что на площадке развёрнуты высокочувствительная система HSSD/VESDA с газовым тушением, система круглосуточного наблюдения и обнаружения вторжения, а также предусмотрен зональный контроль доступа. Кампус подключён к кабельным системам DANICE, FARICE-1, Greenland Connect, Hibernia Express, Iceland Connect и Sea-Me-We 5. Заявлена защита от DDoS-атак.

04.10.2023 [14:59], Сергей Карасёв

Без гиперскейлеров: NVIDIA хочет арендовать ЦОД для облачного сервиса DGX CloudКомпания NVIDIA, по сообщению ресурса The Information, ведёт переговоры об аренде площадей у одного из операторов ЦОД, но о ком именно идёт речь, не сообщается. Предполагается, что площадка будет использоваться для поддержания работы собственного облачного сервиса DGX Cloud, предназначенного для обучения передовых моделей для генеративного ИИ. О доступности облака DGX Cloud компания NVIDIA объявила в июле нынешнего года. Тогда сообщалось, что соответствующая вычислительная инфраструктура достанется в первую очередь США и Великобритании. Стоимость доступа к DGX Cloud начинается с $36 999 в месяц. Говорилось, что NVIDIA намерена продвигать DGX Cloud в партнёрстве с ведущими гиперскейлерами. Первым сервис появился в облаке Oracle Cloud Infrastructure (OCI), на очереди Microsoft Azure, Google Cloud Platform и другие. Большая часть выручки в этом случае достаётся именно NVIDIA, а не облакам.

Источник изображения: NVIDIA Теперь же, судя по всему, NVIDIA решила частично отказаться от услуг облачных провайдеров и развернуть DGX Cloud на арендованных ЦОД-площадях. Впрочем, как отмечается, переговоры всё ещё находятся на начальной стадии, а поэтому говорить о том, что NVIDIA сама превратится в гиперскейлера, преждевременно. При этом компания неоднократно упрекали в том, что в последнее время она более благосклонна к небольшим и специализированным облачным провайдерам, которые не пытаются создавать собственные ИИ-ускорители, могущие составить прямую конкуренцию продуктам NVIDIA.

04.08.2023 [16:23], Руслан Авдеев

CoreWeave взяла в долг $2,3 млрд под залог ускорителей NVIDIA, чтобы купить ещё больше ускорителей NVIDIAПровайдер облачной ИИ-инфраструктуры CoreWeave объявил о привлечении $2,3 млрд долгового финансирования под залог ускорителей NVIDIA. По данным Silicon Angle, компания намерена полностью потратить вырученные средства на закупку аппаратного обеспечения от всё той же NVIDIA. Это уже не первый раунд финансирования, суммарно компания привлекла $571 млн, причём от NVIDIA она получила около $100 млн и приоритет в отгрузке новейших ускорителей. Текущая ситуация уникальна тем, что CoreWeave взяла деньги в долг, оставив в качестве залога используемые ею ускорители NVIDIA. Со взрывным ростом интереса к генеративным ИИ-системам, гонка по созданию всё более масштабных и совершенных ИИ-моделей и инфраструктуры для их обучения потребовала огромного количества дополнительных вычислительных мощностей. Обладая большим числом ускорителей NVIDIA ещё со времён своего «увлечения» криптовалютами, CoreWeave способна превзойти конкурирующих облачных провайдеров.

Источник изображения: CoreWeave Компания обеспечивает облачный доступ к самым передовым технологиям NVIDIA, включая ускорители H100. Также доступны A100, A40 и RTX A6000. Эти решения можно использовать для систем ИИ и машинного обучения, работы с графикой и других ресурсоёмких задач. В компании утверждают, что уже обладают одним из крупнейших HGX-кластеров в мире и поддерживает более 3500 ускорителей NVIDIA H100 в своей суперкомпьютерной инфраструктуре. В прошлом месяце компания объявила о строительстве крупного ЦОД в Техасе за $1,6 млрд. Ожидается, что он будет полностью готов к работе в конце текущего года и будет использован для создания ИИ-супероблака.

28.07.2023 [22:25], Руслан Авдеев

Британская Thames Water потребовала от дата-центров сократить расход воды, пригрозив урезать подачу или взвинтить ценыКомпания Thames Water, являющаяся крупнейшей коммунальной службой в Великобритании и занимающаяся водоснабжением и водоотведением для 15 млн человек, выдвинула ультиматум операторам некоторых ЦОД. Как сообщает The Register, им предложено сократить расход воды самостоятельно, или это будет сделано в принудительном порядке. Также не исключается повышение цен в периоды пиковых нагрузок. В прошлом году Thames Water оценила использование воды дата-центрами в зоне обслуживания компании, включающей как большую часть британской столицы, так и долину Темзы на юге Англии. В дальнейшем планировалось снизить использование воды, координируя действия с ЦОД — страна как раз переживала необычайную жару, из-за которой пострадали и сами дата-центры. Теперь, похоже, компания готова прибегнуть и к мерам принуждения, в частности, ограничивать в случае необходимости подачу воды тем, кто расходует её слишком много, или взимать больше в периоды пикового спроса. В июле прошлого года сложилась критическая ситуация — из-за рекордной жары внешние модули систем кондиционирования британских ЦОД буквально приходилось обрызгивать водой из шлангов во избежание перегрева. По имеющимся данным, рассматривается ограничение подачи воды как минимум одному лондонскому оператору ЦОД в периоды пикового потребления — подобные меры необходимы во время летней жары уже нынешнего года на фоне роста потребностей в воде со стороны бизнесов и граждан. Пока неизвестно, рассматривается ли подобная политика в качестве временной меры или ограничения могут ввести навсегда. Также не сообщается, будут ли ограничения тотальными или станут применяться только в районах компактного размещения кластеров ЦОД.

Фото: Benjamin Davies / Unsplash Конечно, в Thames Water утверждают, что предпочли бы добровольное ограничение потребления операторами прежде чем вводить репрессивные меры. ЦОД, например, могли бы изучить возможность переработки и использования сточных вод непосредственно по месту потребления. В Thames Water заявили, что компания также поощряет использование дата-центрами альтернативных источников воды. К счастью, не все ЦОД полагаются на пресную воду, но те, что прибегают к ней, часто тратят порядка 4–19 тыс. м3 ежедневно. Впрочем, это не единственная проблема коммунальных компаний в Англии. В этом году их активно критикуют за сброс неочищенных сточных вод в реки и даже прибрежные морские воды. Кроме того, службы не успевают ремонтировать стареющую инфраструктуру. Из-за этого Thames Water теряет больше любой компании такого профиля в Великобритании — по данным BBC, ежедневно она допускает утечку более 600 тыс. м3, что уже привело к смене её руководства в прошлом месяце.

26.07.2023 [09:09], Владимир Мироненко

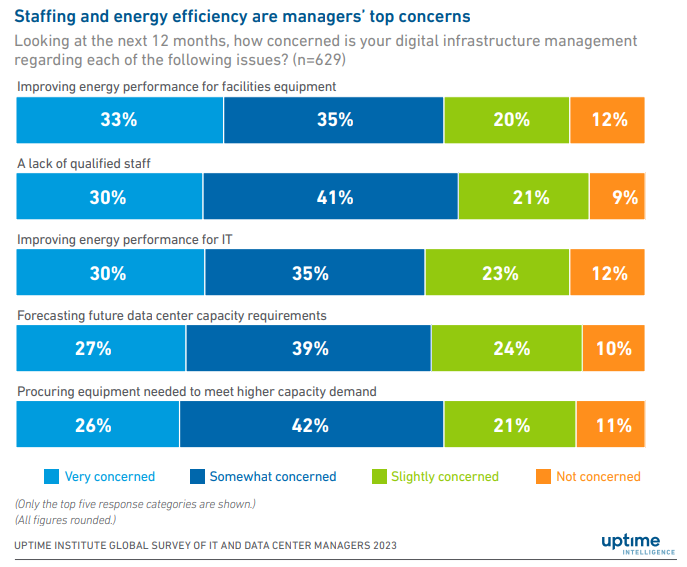

Дата-центрам всё труднее повышать энергоэффективность и соответствовать экологическим требованиямUptime Institute опубликовал данные ежегодного, 13-го по счёту, опроса операторов ЦОД Global DataCenter Survey 2023, который показал, что из-за недостаточного сбора данных об использовании электроэнергии и воды им будет сложно соответствовать новым требованиям и нормативным актам по отчётности в области экологически устойчивого развития. На фоне ужесточения контроля со стороны регулирующих органов за деятельностью отрасли с целью уменьшения вредного воздействия ЦОД на окружающую среду результаты исследования показывают, какую работу необходимо выполнить в данном секторе для улучшения отслеживания объёмов потребляемых ресурсов и генерируемых выбросов. «В нескольких исследованиях, проведённых за последние годы, Uptime Institute отмечал, что сбор и представление данных, связанных с устойчивостью, а также расчёт соответствующих показателей в лучшем случае носят фрагментарный характер. Опрос ещё раз подтверждает это мнение», — говорится в сопроводительной записке. «Многим операторам будет сложно соответствовать новым требованиям к отчётности в области устойчивого развития или требованиям некоторых клиентов и даже общественности». В отчёте указано, что операторы, как правило, фокусируются на мониторинге использования электроэнергии и воды на своих объектах, а не на учёте количества выделяемых ими парниковых газов, по соображениям экономии средств. «Потребление электроэнергии, PUE и расход воды легко отслеживать, и любое улучшение в этих областях часто позволяет сэкономить средства, — говорится в отчёте. — Сокращения выбросов CO2, которое, конечно, может быть частично достигнуто за счёт добросовестного управления энергопотреблением, гораздо сложнее добиться и это приносит меньше непосредственной выгоды». 88 % участников опроса заявили, что следят за потреблением электроэнергии, а 71 % — что контролируют PUE, но менее половины респондентов сообщили о том, что докладывают о потреблении воды или что следят за утилизацией своих серверов. «Отчётность о показателях, связанных с фактическими выбросами CO2, остаётся очень слабой, что говорит о том, что в предстоящие годы потребуются некоторые быстрые восстановительные работы», — указано в отчёте. Впервые за 13 лет участникам также был задан вопрос о ключевых проблемах в управлении, вызывающих у них обеспокоенность. В ответ многие в качестве главной проблемы назвали кадровый вопрос, который со временем многие надеются решить с помощью ИИ, а также необходимость повышения энергоэффективности своих дата-центров. В частности, было отмечено, что по показателю энергоэффективности прогресс застопорился. В течение четырёх–пяти лет среднегодовой показатель PUE остаётся на отметке 1,58–1,59. Это говорит о том, что простые способы улучшения PUE уже исчерпали себя. Для повышения энергоэффективности многих существующих объектов необходимы капитальные работы, дорогостоящие и потенциально опасные. Естественно, более современные объекты имеют лучшие показатели: 16 % респондентов в этом году сообщили о среднегодовом показателе PUE ниже 1,3, в основном в Европе, США и Канаде. В опросе Uptime Institute участвовали более 850 владельцев и операторов центров обработки данных, а также 700 поставщиков и консультантов, которым были заданы вопросы о состоянии отрасли с точки зрения устойчивости, результативности, укомплектования персоналом и регулирования.

22.07.2023 [16:10], Руслан Авдеев

Новый взгляд на экологию: Microsoft разрешили запитать дублинские ЦОД от собственной 170-МВт газовой электростанцииКомпания Microsoft получила разрешение на строительство газовой электростанции на 170 МВт для своего кампуса Grange Castle в пригороде Дублина. Как сообщает DataCenter Dynamics, объект стоимостью €100 млн будет использоваться для повседневного питания ЦОД, а в случае отключения от национальной энергосети станция и 21 дизель-генератор станут единственным источником питания всего кампуса. По данным Business Post, суммарно планируется установить 150 генераторов. Экоактивисты уже выступили против проекта, обвинив IT-гиганта в попытке обойти запрет оператора EirGrid на новые подключения ЦОД к электросетям в Дублине и его окрестностях до 2028 года. Защитники природы подчёркивают, что хотя благодаря собственной электростанции Microsoft ограничит нагрузку на местные энергосети, электростанция будет только способствовать росту углеродного выброса. При этом власти Ирландии всё ещё намерены добиться того, чтобы к 2030 году 80 % энергии в стране должно поступать из возобновляемых источников. Хотя в Ирландии в целом строительство дата-центров не запрещено и даже приветствуется, в Дублине и окрестностях оно ограничено, поскольку здесь и без того уже действует немало ЦОД. Из-за введённых ограничений некоторые крупные компании уже приостановили реализацию ряда проектов. Экоактивисты призывают вообще заблокировать строительство новых ЦОД, утверждая, что это помешает декарбонизации страны. Строительство газовых электростанций может стать временным ответом на ограничения, позволив сделать ЦОД вообще автономными. При этом власти Ирландии ещё в конце 2022 года предостерегли оператора Gas Networks Ireland от заключения новых контрактов с операторами ЦОД, предполагающими обеспечивать свои объекты преимущественно за счёт газовых генераторов для обхода существующих норм. Известно, что Microsoft, для соблюдения существующих в Ирландии правил, не станет эксплуатировать станцию круглосуточно — она будет работать всего по 8 часов в день. Вместе с тем это вряд ли поможет планам компании по полном переводу её ирландских ЦОД на «зелёную» энергию.

16.05.2023 [19:10], Руслан Авдеев

Поллитра воды на полсотни вопросов: ИИ-серверы с ChatGPT потребляют не только много энергии, но и немало воды для охлажденияХотя в генеративных ИИ-моделях вроде GPT-4 или Midjourney отдельные эксперты усматривают много угроз человечеству, далеко не все обращают внимание на важный фактор — не исключено, что скоро ИИ и люди будут конкурировать за обычную пресную воду. Как сообщает The Register, по прогнозам учёных, её будет всё больше требоваться для охлаждения ЦОД. Проблема привлекла внимание учёных Калифорнийского университета в Риверсайде и Техасского университета в Арлингтоне. По оценкам исследователей, обучение языковой модели уровня GPT-3 требует использования около 700 тыс. литров воды — столько тратится на выпуск 320 электромобилей Tesla. Более того, на простой диалог из 20-50 вопросов ChatGPT требуется около 500 мл воды, а с развитием ИИ потребление воды такими системами достигнет огромных масштабов — если заранее не принять меры по оптимизации охлаждения ЦОД.

Источник изображения: Drew Dizzy Graham/unsplash.com При этом эксперты обещают, что к середине века огромные территории в США будут страдать от засухи. Уже сейчас ЦОД крайне неохотно делятся информацией о потреблении воды, при этом используя разные системы подсчёта и, как Google, пытаясь скрыть следы в судебном порядке. В результате учёным приходится при расчётах пользоваться преимущественно косвенными данными. Впрочем, утверждается, что можно повсеместно использовать модель, разработанную SPX Cooling Technologies, и это позволит определить, сколько воды уходить на обучение и эксплуатацию языковых моделей. Но, как считают в Dell'Oro Group, проблема на деле не в ИИ — он не испытывает настоящей жажды. В первую очередь речь идёт о рационализации систем терморегулирования. Даже от того, где находится ЦОД с ИИ, может значительно меняться потребление воды. Многие ЦОД используют не жидкостное охлаждение, а другие варианты. Например, в прошлом месяце Microsoft говорит об использовании систем с нулевым водопотреблением в ЦОД Аризоны — но они потребляют больше энергии. Предлагается немало вариантов — от воздушного до водяного или погружного охлаждения, каждый из которых имеют свои преимущества и недостатки. Впрочем, вендоры вроде Submer и LiquidStack предлагают системы иммерсионного охлаждения, обеспечивающие PUE на уровне менее 1,05, тогда как системы воздушного охлаждения обычно обеспечивают лишь 1,4–1,5.

Источник изображения: redcharlie | @redcharlie1/unsplash.com В научной работе приводятся не только возможные пути оптимизации систем охлаждения, но и рекомендации для того, чтобы ЦОД в принципе выделяли меньше тепла. В частности, речь идёт о том, что дата-центры стоит строить в местах с прохладным климатом вместо жарких азиатских стран, а некоторые задачи можно выполнять во второй половине дня, когда становится прохладнее. Хотя это ограничивает использование солнечных элементов питания, сам собой напрашивается вывод о применении резервных аккумуляторных источников вместо генераторов для накопления энергии днём. Учёные считают, что залогом эффективного использования энергетических систем и охлаждения является большая прозрачность деятельности ЦОД. В Европе, например, пересматривают поправки к Директиве об энергоэффективности, которые заставят отчитываться по многим параметрам всё ЦОД кроме самых мелких. Как заявил один из учёных, «индустрия ЦОД столь скрытна, что иногда трудно получить подходящие данные для построения моделей». Впрочем, учёные опасаются, что у гиперскейлеров может не хватить времени на внедрение качественной отчётности — индустрия ИИ развивается чересчур быстро.

26.04.2023 [19:50], Сергей Карасёв

Meta✴ вынужденно пересмотрела архитектуру своих ЦОД из-за отказа от выпуска собственных ИИ-чипов в пользу ускорителей NVIDIAКомпания Meta✴, по сообщению Reuters, была вынуждена пересмотреть конфигурацию своих дата-центров из-за отставания от конкурентов в плане развития ИИ-платформ. Компания, в частности, решила отказаться от дальнейшего внедрения инференс-чипов собственной разработки. Отмечается, что до прошлого года Meta✴ применяла архитектуру, в которой традиционные CPU соседствуют с кастомизированными решениями. Однако выяснилось, что такой подход менее эффективен по сравнению с применением ускорителей (GPU). При этом ранее компания отказалась от ИИ-ускорителей Qualcomm, указав на недоработки ПО, которые, судя по всему, были устранены только недавно. А с Esperanto, вероятно, отношения у Meta✴ пока не сложились. Впрочем, теперь компании интересен генеративный ИИ, а не только рекомендательные системы, что накладывает иные требования к оборудованию.

Источник изображения: Meta✴ В течение почти всего 2022 года Meta✴ активно инвестировала в развите инфраструктуры, однако в конце года стало известно, что она приостановила строительство целого ряда ЦОД, а затем пересмотрела расходы на дата-центры. Компания решила кардинально переосмыслить архитектуру своих ЦОД, сделав ставку на СЖО. Как теперь выясняется, связано это с тем, что Meta✴ отказалась от собственных ИИ-чипов в пользу ускорителей NVIDIA: объём заказов последних исчисляется «миллиардами долларов». Соответствующую платформу Grand Teton компания показала в конце прошлого года.

Источник изображения: Meta✴ Но ускорители потребляют больше энергии и выделяют больше тепла, нежели CPU или узкоспециализированные ASIC. Кроме того, ускорители должны физически находиться довольно близко друг к другу, хотя с интерконнектом компания тоже уже экспериментирует. Всё это влияет на архитектуру ЦОД. Тем не менее, Meta✴ всё же разрабатывает некий секретный чип, который сгодится и для обучения ИИ-моделей, и для инференса. Ожидается, что это решение увидит свет в 2025 году. Пока что для обучения ИИ компания намерена использовать собственный ИИ-суперкомпьютер RSC и облачные кластеры Microsoft Azure. Похожий путь избрала Microsoft, решившая создать свой ИИ-чип, не отказываясь пока от ускорителей NVIDIA. The Information добавляет, что вице-президент Microsoft по разработке «кремния» Жан Буфархат (Jean Boufarhat) присоединится к Meta✴. Он возглавит команду Facebook✴ Agile Silicon Team (FAST), чтобы помочь компании в реализации проектов по созданию чипов. Ранее Meta✴ переманила из Intel руководителя разработки сетевых решений для дата-центров. У Google и Amazon уже есть свои ИИ-чипы для обучения и инференса.

24.04.2023 [22:02], Руслан Авдеев

С заботой о людях и природе: деревянный дата-центр EcoDataCenter 2 поможет создать новые рабочие места и обеспечить продуктами питания жителей ШвецииПринадлежащая шведскому фонду Areim компания EcoDataCentr, занимающаяся строительством и эксплуатацией экобезопасных ЦОД, намерена возвести в шведском Эстерсунде экоустойчивый дата-центр EcoDataCenter 2. Как сообщает HPC Wire, новый кампус предусматривает внедрение «циркулярной» экосистемы, и в числе прочего, обеспечит «симбиоз» с производителями еды. Известно, что оператор уже реализовал проект EcoDataCenter 1, в рамках которого возведён «первый в мире» ЦОД, построенный полностью из дерева и при участии местной рабочей силы — его избыточное тепло используется при выпуске древесных гранул. Впрочем, теперь речь идёт о значительно более сложном «зелёном» проекте. EcoDataCenter 2 расположится в муниципалитете Эстерсунд (Östersund) — известно, что в местных энергосетях циркулирует только электричество из возобновляемых источников. Проект позволит создать 800–1000 рабочих мест, а «зелёная» энергия, помимо прочего, позволит выращивать в этой местности нехарактерные для местного холодного климата продукты питания. В расчёт принимается и то, какие материалы используются или применяются повторно, как организованы трудовые отношения, какая именно энергия потребляется и другие важные аспекты. Ключевым участником процесса стала компания Wa3rm, на основе идей которой будет строиться «циркулярный» бизнес, именно она будет заниматься производством продуктов питания. В компании заявляют, что проект изначально проектируется с прицелом на реализацию «циркулярной» концепции. По словам оператора ЦОД, поскольку большая часть HPC-вычислений мало зависит от временных задержек, размещение ЦОД для таких проектов можно проектировать именно там, где будет обеспечен наиболее высокий уровень экологической эффективности систем. К 2026 году планируется ввести в эксплуатацию первую очередь проекта мощностью 20 МВт, к 2033 году он должен «разрастись» до 150 МВт. Известно, что похожие проекты, предусматривающие выращивание рыб и омаров, уже реализованы в Японии и Норвегии.

02.04.2023 [08:02], Сергей Карасёв

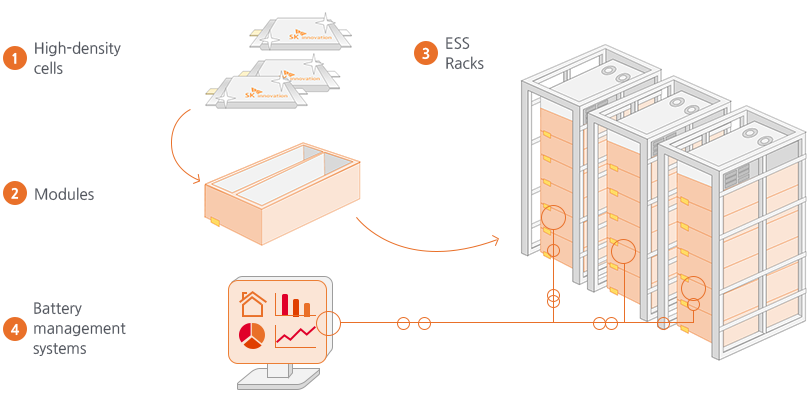

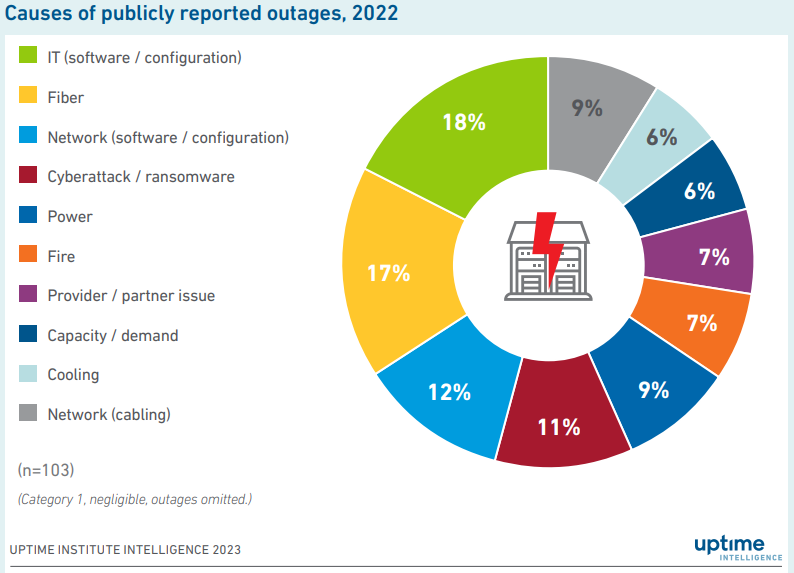

Пожары в дата-центрах вызывают опасения по поводу безопасности Li-Ion аккумуляторовЭксперты Uptime Institute, по сообщению NetworkWorld, предупреждают о возможной опасности использования литий-ионных батарей в ЦОД. По мнению экспертов, такие накопители энергии повышают риск возгорания. В течение последнего времени сразу несколько крупных дата-центров пережили масштабные пожары. Так, в марте 2021 года огонь уничтожил ЦОД французской компании OVHcloud в Страсбурге. Возгорание также произошло на площадке иранской Telecommunication Infrastructure Company (TIC). Кроме того, пожар привёл к самому масштабному в мире сбою ЦОД Kakao: этот инцидент был вызван воспламенением аккумуляторов. Возгорание батарей спровоцировало проблемы в дата-центре Cyxtera и в ЦОД Maxnod.

Изображение: SK On Как отмечает консалтинговая фирма Frost & Sullivan, в настоящее время Li-Ion аккумуляторы широко используются в источниках бесперебойного питания. Ожидается, что к 2025 году на них будет приходиться 38,5 % рынка батарей для ЦОД против 15 % в 2020-м. Такие накопители энергии обладают рядом преимуществ по сравнению со свинцово-кислотными батареями — они компактнее, проще в обслуживании и имеют более продолжительный срок эксплуатации. Обратной стороной медали является повышенная вероятность воспламенения.

Источник: Uptime Institute По оценкам Uptime Institute, примерно 7 % сбоев в ЦОД происходит в связи с пожарами. Причём Li-Ion аккумуляторы крайне плохо поддаются тушению традиционными средствами. Они горят интенсивнее, дольше и при более высокой температуре, нежели свинцово-кислотные изделия. Поэтому такие элементы в случае возгорания могут нанести ЦОД колоссальный ущерб. Отмечается, что даже если оборудование в дата-центре не пострадает непосредственно от огня, дым и продукты горения, попавшие в серверы, в перспективе могут спровоцировать преждевременные отказы. Поэтому, считают специалисты, операторам ЦОД следует сопоставлять выигрыш в энергоэффективности от внедрения литий-ионных батарей с рисками возгорания и сопутствующими убытками. |

|