Материалы по тегу: виртуализация

|

05.03.2026 [22:49], Андрей Крупин

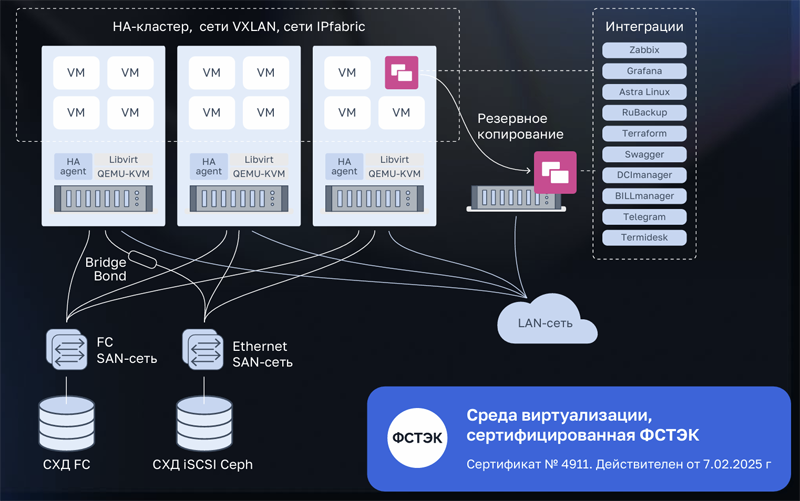

Платформа серверной виртуализации VMmanager дополнилась инструментами резервного копирования RuBackup«Группа Астра» объявила о выпуске комплексного решения, объединяющего платформу серверной виртуализации VMmanager и систему резервного копирования RuBackup. Платформа VMmanager предназначена для решения задач серверной виртуализации и построения отказоустойчивых кластеров — в её составе представлены все необходимые инструменты для создания отказоустойчивой среды виртуализации, включая High Availability, живую миграцию, автоматическую балансировку и поддержку аппаратных систем хранения данных. В свою очередь, RuBackup обеспечивает защиту обрабатываемой информации. Интеграция продуктов выполнена на системном уровне: копирование выполняется безагентно через API гипервизора без остановки приложений, с поддержкой полных, инкрементальных и дифференциальных копий при минимальном влиянии на производительность.

Архитектура платформы серверной виртуализации VMmanager (источник изображения: astra.ru) По словам разработчиков, объединение VMmanager с RuBackup даёт заказчику комплексный эффект. С одной стороны, это операционная и коммерческая эффективность: единая закупка, общая техническая поддержка и снижение совокупной стоимости владения. С другой — технологическая синергия: платформы развиваются с учётом друг друга, а их взаимодействие реализовано до уровня, когда защита данных становится естественной функцией виртуальной среды. Обе разработки имеют сертификаты ФСТЭК России и включены в реестр отечественного ПО Минцифры, что гарантирует соответствие требованиям безопасности и готовность к использованию в государственных и корпоративных проектах.

05.03.2026 [14:21], Владимир Мироненко

Дефицит памяти поможет Broadcom подзаработать, но не так, как вы подумалиВ связи с ростом цен на оперативную память на фоне её дефицита, который, по прогнозам экспертов, сохранится и в 2027 году, VMware (подразделение Broadcom) предложила частное облако VMware Cloud Foundation (VCF) 9.0 в качестве решения, необходимого для работы в новых условиях. VMware заявила, что «традиционный подход, заключающийся в увеличении количества оборудования для решения проблем производительности и масштабируемости, больше не является жизнеспособным». «Broadcom разработала VCF 9.0 специально для решения этой экономической задачи, предложив три различных подхода: снижение совокупной стоимости владения за счёт многоуровневого хранения памяти, отсрочка капитальных затрат за счёт передовых технологий повышения эффективности и обеспечение немедленного внедрения в существующий парк оборудования», — сообщила она. Как отметил The Register, VMware всегда продвигала многоуровневую организацию памяти VCF 9 как возможность снизить затраты на инфраструктуру за счёт уменьшения установленного объёма DRAM путём прозрачного переноса части данных на NVMe. Вместе с тем, не следует забывать, что стоимость SSD также выросла. VMware также признаёт, что её архитектура памяти подходит не для всех рабочих нагрузок и не предназначена для виртуальных машин, чувствительных к задержкам, или очень больших инстансов. Но VMware всё равно утверждает, что «наиболее прямое решение проблемы стремительного роста цен на DRAM — это просто использовать её меньше», а VCF 9.0 позволяет «заменить дорогостоящую DRAM значительно более дешёвым хранилищем NVMe». Многоуровневое распределение памяти VMware в настоящее время превосходит альтернативу в виде CXL, пишет The Register. Кроме того, новые поколения серверных процессоров AMD и Intel создали возможность очередного этапа консолидации нагрузок. Dell утверждает, что её клиенты заменяют семь серверов одной новой машиной; Intel говорит о консолидации 5:1. Новые серверы позволяют запускать огромное количество ВМ, что концентрирует риски и требует огромного количества дорогостоящей памяти. Но VMware и не требует, чтобы в каждом хосте в кластере использовалось многоуровневое распределение памяти. Так что VCF 9 в текущей ситуации действительно может оказаться эффективным средством снижения затрат. В то же время The Register отметил, что многие пользователей vSphere считают VCF 9 очень дорогим продуктом, несмотря на уверения Broadcom в обратном. При этом Broadcom, похоже, в принципе не готова идти на ценовые уступки — или бери, или уходи.

05.03.2026 [09:07], Владимир Мироненко

5G-виртуализация с ИИ-монетизацией: Broadcom представила VMware Telco Cloud Platform 9 с фокусом суверенные облака

5g

6g

vmware

автоматизация

виртуализация

ии

информационная безопасность

конфиденциальность

сети

частное облако

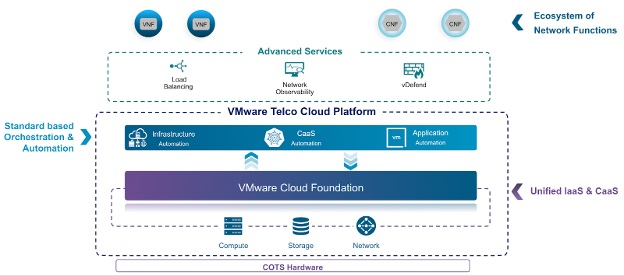

Broadcom представила VMware Telco Cloud Platform 9 — частную облачную платформу для телекоммуникационных ЦОД, которая позволит глобальным телекоммуникационным операторам повысить эффективность оборудования и снизить эксплуатационные расходы при предоставлении суверенных и ИИ-сервисов. Созданная на базе VMware Cloud Foundation 9 с дополнительными возможностями, специфичными для телекоммуникационных компаний, платформа позволит операторам добиться в течение пяти лет совокупной экономии совокупной стоимости владения (TCO) на 40 % по сравнению с изолированными архитектурами; снизить энергопотребление и связанные с ним затраты на 25–30 % за счёт повышения производительности серверов и плотности виртуальных машин. Также сообщается, что благодаря использованию Advanced NVMe Memory Tiering новая платформа позволит достичь до 38 % снижения совокупной стоимости владения (TCO) памятью и серверами, и на 38 % сократить TCO хранилища с помощью функции vSAN ESA Global Deduplication, позволяющей глобально дедуплицировать данные. Кроме того, новая платформа позволит повысить эффективность, управляемость и соответствие нормативным требованиям за счёт интеллектуальной автоматизации, интегрированного управления затратами и соблюдения политик.

Источник изображений: VMware «VMware Telco Cloud Platform 9 позволит телекоммуникационным операторам предоставлять безопасную, суверенную, ориентированную на ИИ инфраструктуру, которая способствует внедрению технологий следующего поколения, ускорению роста доходов и снижению затрат», — заявил Пол Тернер (Paul Turner), главный директор по продуктам подразделения VMware Cloud Foundation. Broadcom отметила, что VMware Telco Cloud Platform развивается, поддерживая как функции ядра сети 4G/5G, так и ресурсоёмкие рабочие ИИ-нагрузки на единой открытой платформе, позволяя операторам предоставлять суверенное облако и ИИ. С целью улучшения монетизации ИИ в Telco Cloud Platform 9 добавят такие возможности, как частный ИИ (Private AI-as-a-Service), GPU-виртуализацию (GPU Virtualization) и GPUaaS (с логической изоляцией конфиденциальных данных). Планы также включают расширенный мониторинг физических и виртуальных GPU. При реализации опции «Частный ИИ как услуга» включение собственных инструментов, таких как хранилище моделей, среда выполнения моделей и векторные базы данных, позволит операторам предлагать клиентам готовые ИИ-среды, обеспечивая при этом строгую изоляцию данных и соответствие нормативным требованиям. vGPU позволят повысить эффективность использования оборудования и снизить затраты. Благодаря этому телекоммуникационным компаниям смогут одновременно запускать высокопроизводительные рабочие нагрузки без необходимости выделения оборудования для каждого пользователя. Также платформа будет поддерживать автоматизированное управление жизненным циклом (LCM), обеспечивая разработчикам развёртывание готовых к производству частных ИИ-сред за считанные минуты, а не недели. Компания также представила «Сервис создания агентов» (Agent Builder) — Low-code платформу, которая упростит создание сложных ИИ-агентов ИИ, автоматизируя оркестрацию моделей, извлечение данных и возможности подключения инструментов. Broadcom отметила, что по мере перехода сетей к модели, ориентированной на ИИ, они должны стать самокорректирующимися и основанными на намерениях. Платформа VMware Telco Cloud Platform обеспечит возможности для автоматизации управления жизненным циклом и оптимизации энергопотребления в ядре 5G и, в конечном итоге, в 6G. Поддержка энергоэффективной инфраструктуры на базе новых процессоров и интеллектуальное планирование ресурсов позволят оптимизировать энергопотребление для энергоёмких приложений 5G и ИИ. Также планируются изменения в работе Kubernetes, с модернизированной моделью управления жизненным циклом CaaS и вариантами обновления, ориентированными на операторов связи. Broadcom внедрит унифицированную автоматизацию на основе GitOps. Планируется использование централизованной панели управления с единым интерфейсом для управления парком, контроля затрат и лицензирования. А ESX Live Patching позволит администраторам применять критически важные обновления безопасности к хостам без необходимости проведения плановых работ или нарушения работы активных ВМ. При этом ИИ-ассистенты помогут оптимизировать процесс подключения к платформе и устранения неполадок. Суверенное облако стало центральным требованием к закупкам для многих рабочих нагрузок государственного сектора и регулируемых отраслей в Европе и других странах. Broadcom заявила, что платформа Telco Cloud Platform 9 будет включать «архитектурные механизмы защиты», соответствующие суверенным требованиям, с акцентом на локальный контроль, проверку и операции в пределах границ.

Также будет использоваться централизованная панель мониторинга SecOps, обеспечена поддержка конфиденциальных вычислений в защищённых анклавах AMD и Intel, и реализовано обеспечение горизонтальной безопасности с использованием VMware vDefend для микросегментации и контроля на основе принципа нулевого доверия.

04.03.2026 [10:00], Сергей Карасёв

«Базис» создаёт собственный протокол передачи данных для удалённой работыКомпания «Базис», лидер российского рынка ПО управления динамической ИТ-инфраструктурой, разрабатывает собственный протокол для доступа к виртуальным рабочим местам — Basis Connect. Протокол станет частью VDI-платформы Basis Workplace версии 3.3 и обеспечит её пользователям качественную передачу изображения и быстрый отклик даже на медленных каналах связи. Первая версия Basis Connect будет доступна заказчикам для тестирования уже в I квартале этого года. Протокол передачи данных является важной частью инфраструктуры виртуальных рабочих столов, он должен обеспечивать быстрый отклик на действия пользователя, поддерживать периферийные устройства, передавать большие объёмы информации, не допускать потери качества аудио- и видеопотоков. От перечисленного зависит, сможет ли сотрудник комфортно взаимодействовать с ресурсоёмкими приложениями (графическими и видеоредакторами, инструментами 2D- и 3D-проектирования), использовать внешние и сетевые устройства, принимать участие в видеоконференциях. Вместе с ростом популярности VDI, растут и требования к продуктам, в том числе к качеству и скорости обмена данными между клиентом и сервером. Подключение сторонних протоколов создаёт ряд дополнительных сложностей при внедрении VDI-платформы: для использования проприетарных решений необходимо приобретать соответствующие лицензии, а протоколы с открытым исходным кодом требуют доработки под требования заказчика и сложны в поддержке. Наличие качественного собственного протокола, который является частью VDI-платформы и не требует дополнительного лицензирования, позволяет провести внедрение быстрее и с меньшим количеством сложностей. При разработке Basis Connect компания ориентируется на задачи, которые необходимо решать заказчикам, и требования, которые они предъявляют к присутствующим на рынке протоколам. В первой публичной версии Basis Connect будет реализована передача изображения, звука и содержимого буфера обмена (текст, файлы, папки, картинки), а также поддержка клавиатуры, мыши, принтеров, сканеров и других периферийных устройств, в том числе USB-токенов для использования сертификатов внутри виртуального рабочего места. В качестве серверной и клиентской ОС для работы с протоколом можно будет использовать популярные российские ОС: АLT Linux 10, Astra Linux 1.8, «РЕД ОС 8». По мере дальнейшего развития Basis Connect будут реализованы гибкие настройки самого протокола — например, в части разграничения прав пользователей — и ряд других возможностей. При этом «Базис» не будет отказываться от поддержки сторонних протоколов, поскольку это одно из преимуществ платформы Basis Workplace, востребованное у заказчиков. «Требования к отечественным VDI-решениям постоянно растут, и мы должны отвечать на вызовы рынка, быть гибкими и функциональными. Поэтому создание собственного протокола — важный шаг в развитии решения Basis Workplace. Мы даём заказчикам возможность использовать качественное совместимое решение без необходимости приобретать лицензии на проприетарные протоколы или дорабатывать протоколы с открытым исходным кодом. Создание Basis Connect потребовало значительных ресурсов, однако успешное решение этой задачи позволило не только улучшить наше продуктовое предложение, но и усилить компетенции команды», — отметил Дмитрий Сорокин, технический директор компании «Базис».

18.02.2026 [11:29], Сергей Карасёв

AWS внедрила вложенную виртуализацию для инстансов EC2Облачная платформа AWS сообщила о том, что некоторые её инстансы EC2 получили поддержку вложенной виртуализации (Nested Virtualization). Это позволяет решать определённые специфичные задачи, например, работать с эмуляторами мобильных приложений или выполнять моделирование автомобильного оборудования. Вложенная виртуализация даёт возможность запускать гипервизор внутри виртуальной машины, которая сама работает на другом гипервизоре. Иными словами, формируется виртуальная машина внутри виртуальной машины. Такой подход ориентирован на разработку и тестирование различных программных решений без использования физических серверов. Метод может быть полезен в производственной среде для контейнеризированных рабочих нагрузок, где часто применяются инструменты вроде Kubernetes и Docker.

Источник изображения: AWS AWS внедрила поддержку вложенной виртуализации в инстансы EC2 C8i, M8i и R8i. Все они базируются на платформе Intel Xeon 6 в кастомном исполнении. В этих процессорах реализована усовершенствованная технология Trust Domain Extensions (TDX), которая обеспечивает улучшенную изоляцию между гостевой ОС и гипервизором. Все экземпляры EC2 работают под управлением собственного гипервизора Amazon Nitro. В целом, архитектура вложенной виртуализации состоит из трех уровней. Это физическая инфраструктура AWS и гипервизор Nitro, формирующие нулевой уровень (L0). На первом уровне (L1) функционирует клиентский экземпляр EC2 с гипервизором. Второй уровень (L2) состоит из одной или нескольких виртуальных машин, созданных в инстансе EC2. В качестве гипервизоров уровня L1 в настоящее время могут использоваться Microsoft Hyper-V и KVM. Вложенная виртуализация доступна во всех регионах присутствия AWS.

11.02.2026 [09:28], Андрей Крупин

«Группа Астра» представила Clouden — решение для централизованного управления гибридной и мультиоблачной инфраструктурой«Группа Астра» вывела на рынок Clouden — решение для централизованного управления гибридной и мультиоблачной инфраструктурой. Разработка отвечает на ключевой запрос рынка — потребность в едином инструменте для управления разнородными средами, включая физические серверы, разные платформы виртуализации и публичные облака. Clouden относится к категории продуктов Cloud Management Platform (CMP). Комплекс поддерживает работу с системами VMmanager, DCImanager, VMware vSphere, VMware vCloud Director + NSX-T, OpenStack, ZVirt, OpenNebula, позволяет автоматизировать развёртывание сервисов для заказчиков, включает инструменты инвентаризации и диагностики оборудования, обеспечивает управление географически распределёнными инфраструктурами и в полной мере отвечает задачам импортозамещения программного обеспечения.

Источник изображения: ispsystem.ru/clouden Clouden обеспечивает сквозную автоматизацию, имеет встроенную BI-аналитику для прогнозирования затрат, портал самообслуживания и гибкую систему тарификации. Платформа включена в реестр Минцифры и предназначена для средних и крупных компаний, государственных структур, а также организаций с распределённой филиальной сетью.

17.12.2025 [09:00], Владимир Мироненко

«Базис» завершил перевод на свою экосистему ИТ-инфраструктуры правительства Московской областиРоссийский разработчик ПО управления динамической ИТ-инфраструктурой ПАО «Группа компаний «Базис» объявил о завершении проекта по внедрению виртуальной инфраструктуры на базе экосистемы решений «Базис» для информационных систем региональных министерств и ведомств правительства Московской области, персонал которых насчитывает более 100 тыс. сотрудников. Решения «Базис» развёрнуты в составе программно-аппаратных комплексов (ПАК). Платформа виртуализации Basis Dynamix Enterprise обеспечивает стабильную работу основных вычислительных мощностей информационных систем подразделений и министерств правительства Московской области, говорится в пресс-релизе. Basis Dynamix Cloud Control отвечает за управление облачной частью инфраструктуры. Basis Virtual Protect обеспечивает интеграцию инструментов для резервного копирования виртуальных сред. Basis Guard поддерживает высокий уровень доступности и отказоустойчивость инфраструктуры. Действуя в рамках единой экосистемы решения «Базиса» позволяют выполнять все задачи, связанные с работой инфраструктуры IT-подразделений администрации региона, и оказывать услуги потребителям.

Источник изображения: mosreg.ru Работа над проектом стартовала в прошлом году. Всего в работе информационных систем администрации региона задействовано 480 серверов-узлов виртуальной инфраструктуры. Генеральный директор ПАО ГК «Базис» Давид Мартиросов отметил, что замена ИТ-инфраструктуры правительства одного из крупнейших по численности населения российских регионов оказалась сложной и масштабной задачей. Впрочем, у группы уже есть опыт успешного выполнения сопоставимых по сложности проектов как для госструктур, так для крупного бизнеса, добавил он.

10.12.2025 [09:39], Владимир Мироненко

HPE позиционирует стек Morpheus в качестве альтернативы VMwareHPE обновила облачный портфель GreenLake и объединила сетевые решения Aruba и Juniper, чтобы предложить клиентам возможности AIOps для обеих платформ, а также высокоскоростное подключение для обработки ИИ-нагрузок. Президент и генеральный директор HPE Антонио Нери (Antonio Neri) заявил, что одной из самых серьёзных проблем является растущая стоимость виртуализации. Именно эту проблему решает платформа Morpheus, передаёт The Register. Технический директор и исполнительный вице-президент по гибридным облакам Фидельма Руссо (Fidelma Russo) сообщила, что ошибочно полагать, что предприятия стремятся просто заменить гипервизор. Она отметила, что компании ищут современную платформу, способную работать с традиционными виртуальными машинами (ВМ), контейнерами и рабочими нагрузками эпохи ИИ с тем же уровнем отказоустойчивости, безопасности и автоматизации, который они ожидают от облака. По словам Руссо, инструменты управления Morpheus и OpsRamp от HPE, а также ПО для аварийного восстановления Zerto представляют собой «полностью интегрированную альтернативную платформу корпоративного уровня, охватывающую ВМ, контейнеры и физическое оборудование». Фактически HPE предлагает альтернативу платформе VMware от Broadcom, хотя Руссо прямо её не назвала. Платформа Morpheus, приобретённая HPE в позапрошлом году, теперь поддерживает программно-определяемые сети (SDN) с нулевым доверием для виртуальных машин с гипервизором HVM (VM Essential) — на базе технологий Juniper Networks, приобретённой HPE в этом году. Также Morpheus предлагает полную поддержку Kubernetes и контейнерных рабочих нагрузок в рамках HVM для унифицированных операций с виртуальными машинами и контейнерами. Интегрированная с Morpheus система управления данными Apstra Data Center Director от Juniper обеспечивает автоматическую настройку коммутаторов при перемещении или миграции виртуальных машин, а OpsRamp интегрируется с Apstra Data Center Director и Compute Ops Management, объединяя управление и аналитику по всему стеку. «Благодаря этой интеграции… у нас теперь полностью автоматизированный стек, который устраняет проблемы, возникающие между виртуальными машинами и устойчивостью сети, что было ещё одним ключевым требованием, о чём мы говорили клиентам», — сообщила Руссо. Сообщается, что теперь поддерживаются распределённые кластеры с серверами в разных локациях, что позволяет поддерживать рабочие нагрузки даже при полном отключении одной из площадок. Синхронная репликация обеспечивается Alletra Peer Persistence. HPE также сообщила, что Morpheus VM Essentials будет работать с Veeam Data Platform v13 для резервного копирования на уровне гипервизора, что обеспечит быстрое восстановление виртуальных машин в частных облачных средах, включая HPE Private Cloud Business Edition.

04.12.2025 [13:58], Владимир Мироненко

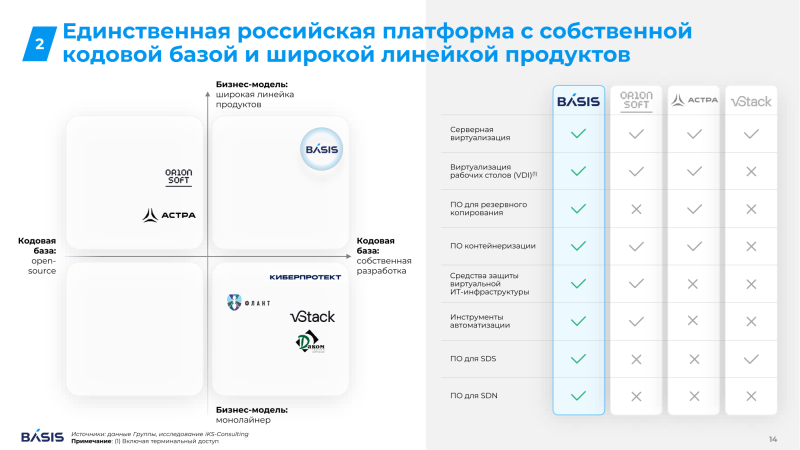

«Базис» объявил ценовой диапазон для своего IPO — первого в ИТ-секторе России в этом годуПАО «Группа компаний «Базис», российский разработчик ПО управления динамической ИТ-инфраструктурой, определило ценовой диапазон предстоящего первичного публичного предложения обыкновенных акций (IPO) с листингом на Московской бирже, который будет находиться в пределах 103–109 руб. за акцию. Соответственно, рыночная капитализация группы может составить 17–18 млрд руб. Индикативный объём размещения заявлен в размере 3 млрд руб. В рамках IPO инвесторам будут предложены акции, принадлежащие действующим миноритарным акционерам — российским технологическим холдингам, которые продолжат участвовать в акционерном капитале «Базис». При этом мажоритарный акционер группы, РТК-ЦОД (контролируется ПАО «Ростелеком»), продавать принадлежащие ему акции не планирует. Цена размещения будет установлена после сбора заявок, который пройдёт с 4 по 9 декабря 2025 года. Торги начнутся 10 декабря 2025 года под тикером BAZA и ISIN RU000A10CTQ0. Акции включены в котировальный список второго уровня Московской биржи. Предложение будет доступно для российских квалифицированных и неквалифицированных инвесторов – физических лиц, а также для институциональных инвесторов, которые смогут подать заявку на приобретение акций через российских брокеров. Для поддержки котировок предусмотрен стабилизационный механизм объёмом около 10 % от размера предложения, который будет действовать в течение 30 календарных дней после начала торгов. Благодаря IPO «Базис» получит рыночную оценку стоимости бизнеса, а также возможности для финансирования дальнейших проектов и сделок M&A в долгосрочной перспективе, в том числе за счёт доступа на рынок акционерного капитала. Также это позволит группе расширить маркетинговые возможности для дальнейшего масштабирования бизнеса; повысить узнаваемость группы и уровень информированности о её продуктовом портфеле на рынке. Генеральный директор «Базиса» Давид Мартиросов отметил, что после объявления о намерении провести IPO группа компаний наблюдает высокую заинтересованность рынка в её инвестиционной истории. «Мы видим, как инвесторы отмечают наше лидирующее положение на рынке, сильные финансовые результаты и устойчивое финансовое положение, подкреплённые высокой долей возобновляемой выручки, уникальностью продуктовой экосистемы на основе собственной кодовой базы и другими преимуществами, которые выгодно отличают нас от других инвестиционных предложений на ИТ-рынке», — сообщил он. «Базис» занимает лидирующие позиции на российском рынке ПО управления динамической ИТ-инфраструктурой с долей 19 % в 2024 году, также лидируя в сегменте виртуализации ИТ-инфраструктуры с долей 26 %. Также «Базис» является одним из ведущих вендоров средств защиты виртуальной ИТ-инфраструктуры и ведущих разработчиков программно-определяемых хранилищ (SDS). Выручка группы за 2022–2024 годы выросла с 1,7 до 4,6 млрд руб. (CAGR — 67 %), OIBDA — до 2,8 млрд руб. при рентабельности 62 %. За девять месяцев 2025 года её выручка выросла год к году на 57 %, достигнув 3,5 млрд руб. Чистая прибыль увеличилась на 35 % до 1,0 млрд руб.

27.11.2025 [16:45], Владимир Мироненко

«Базис» идёт на IPO в декабреПАО «Группа Компаний «Базис» объявила о планах провести первичное публичное предложение обыкновенных акций (IPO) с листингом на Московской бирже, в ходе которого инвесторам будут предложены акции, принадлежащие действующим миноритарным акционерам — российским технологическим холдингам, которые и дальше будут участвовать в акционерном капитале «Базис». Объём и ценовой диапазон предложения будут объявлены непосредственно перед началом букбилдинга в декабре 2025 года. Как сообщается, РТК-ЦОД планирует сохранить за собой контролирующую долю в акционерном капитале «Базис» и продолжит участие в развитии её бизнеса. Предложение будет доступно для российских квалифицированных и неквалифицированных инвесторов – физических лиц, а также для институциональных инвесторов. Проведение IPO позволит «Базису» получить рыночную оценку стоимости бизнеса, расширить возможности для финансирования дальнейших проектов и сделок M&A в долгосрочной перспективе, в том числе за счёт доступа на рынок акционерного капитала. Также это позволит группе расширить маркетинговые возможности для дальнейшего масштабирования бизнеса; повысить узнаваемость Группы и уровень информированности о её продуктовом портфеле на рынке. Также была утверждена программа долгосрочной мотивации (ПДМ) персонала, в рамках которой миноритарные акционеры передали 5 % акционерного капитала для дальнейшего распределения среди ключевых сотрудников и топ-менеджмента «Базиса». «Базис» специализируется на разработке ПО управления динамической инфраструктурой (ПО УДИ). За 9 месяцев 2025 года выручка группы составила 3,5 млрд руб., продемонстрировав рост год к году на 57 %. Показатель OIBDA за этот период увеличился год к году на 42 % до 1,9 млрд руб. при рентабельности по OIBDA в размере 54 %. Чистая прибыль выросла на 35 % до 1,0 млрд руб. Согласно исследованию iKS-Consulting, среднегодовой темп роста (CAGR) рынка ПО УДИ в период с 2024 года до 2031 года составит 16 %, опережая на 5 п.п. темпы роста всего российского рынка ПО. Объём рынка в денежном выражении в 2024 году составил 45 млрд руб. и, как ожидается, вырастет к 2031 году практически втрое до 130 млрд руб. Российские разработчики являются главным драйвером рынка с опережающими темпами роста в 24 % (CAGR в 2024–2031 гг.). По оценке iKS-Consulting, рынок отечественных решений ПО УДИ увеличится с 24 млрд руб. в 2024 году до 106 млрд руб. в 2031 году, что означает рост доли российских разработчиков с 53 до 82 % от общего объёма рынка. Драйверами роста рынка являются развитие облачной и гибридной ИТ-инфраструктуры, популяризация контейнеризированных сред разработки, совершенствование функциональности отечественных продуктов и продолжение миграции критической информационной инфраструктуры (КИИ) и крупного бизнеса на российское ПО. Также существенную роль на рост отечественного рынка ПО УДИ оказывает обязательное импортозамещение и переход объектов КИИ на российские решения к 2030 году. «Базис» является крупнейшим разработчиком на российском рынке ПО управления динамической ИТ-инфраструктурой с долей 19 % в 2024 году. Группа лидирует на рынке ПО виртуализации ИТ-инфраструктуры (серверная виртуализация и VDI), крупнейшем сегменте рынка ПО УДИ, с долей 26 %; занимает вторую позицию на рынке ПО контейнеризации с долей в 20 % и входит в Топ-3 на рынке ПО для резервного копирования среди российских вендоров. Также «Базис» является одним из ведущих вендоров средств защиты виртуальной ИТ-инфраструктуры и ведущих разработчиков программно- определяемых хранилищ (SDS). Все продукты «Базиса» включены в Единый реестр российского ПО и полностью соответствуют требованиям импортонезависимости, надежности и безопасности. Кроме того, ряд продуктов имеет сертификаты ФСТЭК IV уровня доверия. Группа осуществляет продажи через более 230 дистрибьюторов и партнёров, включая 5 дистрибьюторов, более 200 системных интеграторов и более 30 технологических партнёров. Высокое функциональное соответствие экосистемы «Базиса» мировым стандартам создает основу для её выхода на зарубежные рынки. У группы уже есть соглашения с крупными иностранными партнёрами, в частности на рынке Бразилии. В средне- и долгосрочной перспективе приоритет отдан рынкам португалоговорящих стран Латинской Америки и Африки, включая Бразилию, Анголу и Мозамбик. По состоянию на 30 сентября 2025 года общий штат «Базиса» составлял 434 сотрудника, из которых 86 % — ИТ-специалисты, отмечает компания. Дополнительная информация о «Базисе», включая презентацию для инвесторов и эмиссионные документы, доступна на официальном сайте. |

|