Лента новостей

|

27.09.2025 [16:44], Руслан Авдеев

Horizon Fuel Cell представила 3-МВт модуль с водородными топливными элементами для замены дизель-генераторовHorizon Fuel Cell представила 40′ модуль Horizon Packs мощностью 3 МВт для резервного питания дата-центров. По словам компании, её ячейки способно вырабатывать на 100 % больше энергии, чем стандартные элементы с протонообменной мембраной (PEM), и на 300 % — чем твердооксидные топливные элементы (SOFC), набирающие популярность на рынке ЦОД, сообщает Datacenter Dynamics. Как сообщают в Horizon, подобная компактность решения возможна благодаря использованию 400-кВт элементов, созданных для большегрузных автомобилей на водороде. В компании заявляют, что новое контейнерное решение идеально вписывается в инфраструктуру ЦОД благодаря высокой мощности на единицу объёма, компактности и низкому уровню углеродных выбросов — выхлопом в данном случае является обычная вода. Также компания предложила и модули хранения водорода (1 т), которые также размещаются в стандартных 40′ контейнерах. Комплект из нескольких модулей способен обеспечить от 8 до 40 часов резервного электроснабжения, при этом совокупная стоимость владения (TCO) при массовом развёртывании будет сопоставима с таковой у дизельных генераторов.

Источник изображения: Horizon Fuel Cell Horizon основана в 2003 году, штаб-квартира компании расположена в Сингапуре. Компания заявляет об установленной производственной мощности более 1,5 ГВт в год. Сегодня она предлагает широкий спектр топливных ячеек PEM, а также различные решения для хранения водорода. Пока Horizon размещает системы на топливных элементах преимущественно на химических производствах, где водород является побочным продуктов, но не прочь освоить и рынок ЦОД. Топливные элементы на водороде начали набирать популярность на рынке ЦОД среди операторов, ищущих автономные решения с низким уровнем углеродных выбросов. Самым заметным игроком на рынке является Bloom Energy, предлагающая твердооксидные элементы компаниям вроде CoreWeave, AWS и др. В июле 2025 года компания стала первой, заключившей прямое соглашение с гиперскейлером — компанией Oracle по обеспечению энергией всего ЦОД с помощью SOFC. Также она заключила соглашение и с Equinix и американской энергетической группой American Electric Power. Несколько операторов дата-центров также экспериментировали с использованием водородных топливных элементов для резервного питания своих объектов. Так, в 2024 году Microsoft и Caterpillar реализовали специальный демонстрационный проект по питанию ЦОД в Шайенне (Cheyenne, Вайоминг), оборудование успешно снабжала дата-центр энергией в течение двух суток.

27.09.2025 [16:18], Сергей Карасёв

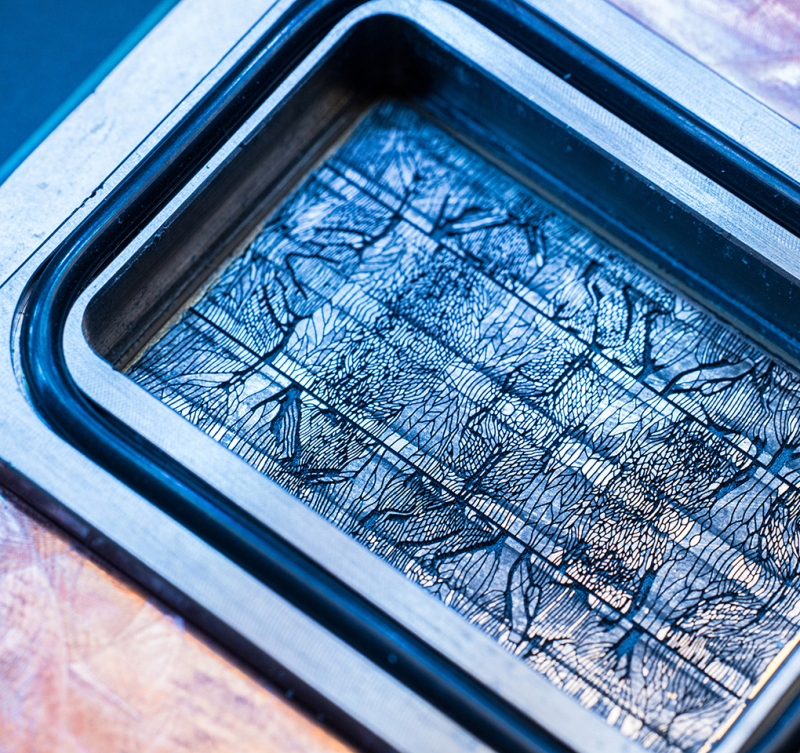

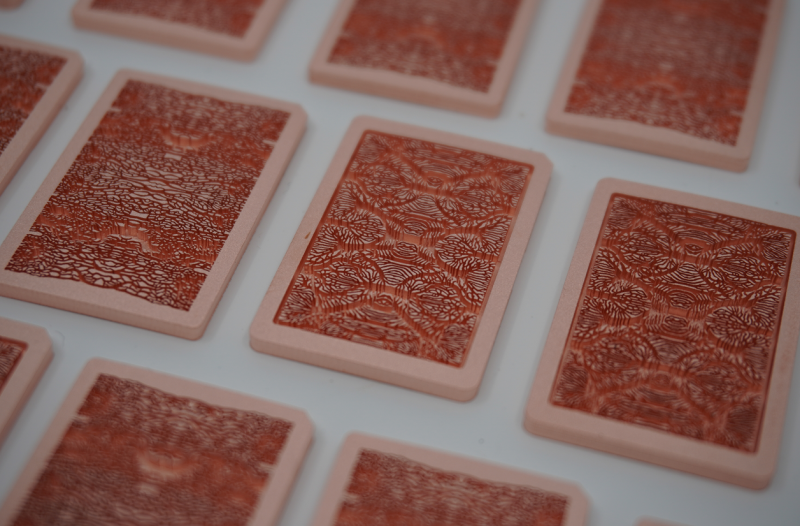

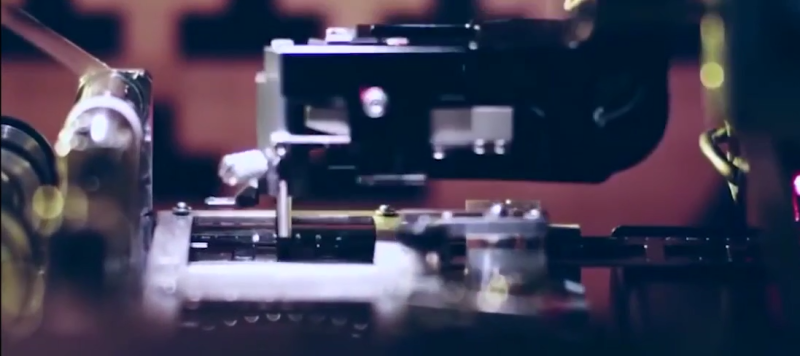

Чип с «сосудами»: Microsoft и Corintis вытравили микроканалы для СЖО прямо в кремнииВедущие разработчики ИИ-ускорителей продолжают наращивать мощность своих устройств, что требует применения передовых систем охлаждения. Речь идёт прежде всего о системах прямого жидкостного охлаждения, способных отводить тепло непосредственно от поверхности чипов. Корпорация Microsoft сообщила о разработке совместно со швейцарским стартапом Corintis альтернативной СЖО, которая охлаждает процессоры изнутри. Новая технология базируется на принципах микрогидродинамики (microfluidic). Подход основан на формировании крошечных каналов на обратной стороне кремниевого кристалла: циркулируя через эти канавки, жидкость эффективно отводит тепло от наиболее горячих зон чипа. Для оптимизации расположения каналов, которые по толщине сопоставимы с человеческим волосом, использовался ИИ. Полученный рисунок вытравленных канавок напоминает прожилки на листе дерева или крыло бабочки. При разработке системы нужно было убедиться, что каналы обеспечивают возможность циркуляции необходимого объема охлаждающей жидкости без засорения, но при этом не ухудшают прочность кристалла из-за своих размеров и расположения. Только за последний год команда Microsoft опробовала четыре разных варианта конструкции. Для практического использования такой СЖО потребовалась разработка герметичного корпуса для чипов. Кроме того, были опробованы различные методы травления каналов: специалистам пришлось создать пошаговую схему добавления этапа травления в стандартный процесс производства чипов. Наконец, была разработана специальная формула охлаждающей жидкости. По заявлениям Microsoft, предложенная технология по сравнению с традиционными водоблоками способна повысить эффективность отвода тепла до трёх раз — в зависимости от нагрузки и конфигурации. При этом максимальный рост температуры кремния внутри GPU снижается на 65 %, хотя этот показатель варьируется в зависимости от типа чипа. Плюс к этому повышается энергоэффективность. В дальнейшем Microsoft намерена изучить возможность внедрения технологии охлаждения нового типа в будущие поколения собственных изделий для дата-центров. Корпорация также сотрудничает с производителями и партнёрами по вопросу использования предложенного решения. Предполагается, что в дальнейшем результаты работы откроют путь к совершенно новым архитектурам микросхем, основанным на 3D-компоновке: в этом случае охлаждающая жидкость сможет протекать через слои в многоярусных чипах. Между тем стартап Corintis, основанный на базе Федеральной политехнической школы Лозанны (EPFL), провёл раунд финансирования Series A, в ходе которого на развитие привлечено $24 млн. Инвестиционную программу возглавил BlueYard Capital при участии Founderful, Acequia Capital, Celsius Industries и XTX Ventures. Таким образом, на сегодняшний день компания получила в общей сложности $33,4 млн. Corintis направит средства на расширение деятельности и дальнейшее развитие новой технологии охлаждения чипов. Будут открыты несколько офисов в США и инженерный центр в Мюнхене.

27.09.2025 [15:34], Андрей Крупин

Российская платформа для разработки GitFlic дополнилась интеграцией с системами управления проектами«Группа Астра» сообщила о выпуске обновления платформы для разработки GitFlic. Новый релиз продукта получил индекс 4.5.0. Ключевым улучшением GitFlic стала ликвидация разрыва между системами контроля версий и управления задачами благодаря интеграции программного комплекса с системами управления проектами — «Яндекс Трекером» и другими популярными трекерами. Теперь упоминание номера задания в коммите или запросе на слияние автоматически создаёт комментарий в связанной системе с деталями изменения. Интеграция поддерживает опции стандартных и расширенных примечаний, а также автоматически переводит статус задачи в финальный после выполнения обращения.

Источник изображения: gitflic.ru GitFlic 4.5.0 обеспечивает сквозную прослеживаемость изменений: участники проекта могут отслеживать всю историю правок, связанных с конкретной задачей, без переключения между интерфейсами. Это повышает дисциплину ведения задач и упрощает аудит процессов разработки. Интеграции доступны для настройки во всех проектах на платформе. «В современной бизнес-среде скорость и слаженность работы команды напрямую влияют на конкурентоспособность продукта. Разрыв между кодом и задачами — это потеря времени и источник ошибок. Интеграции GitFlic с такими отечественными инструментами, как, например, «Яндекс Трекер», устраняют эту пропасть, создавая единое рабочее пространство», — говорится в сообщении «Группы Астра».

27.09.2025 [15:32], Сергей Карасёв

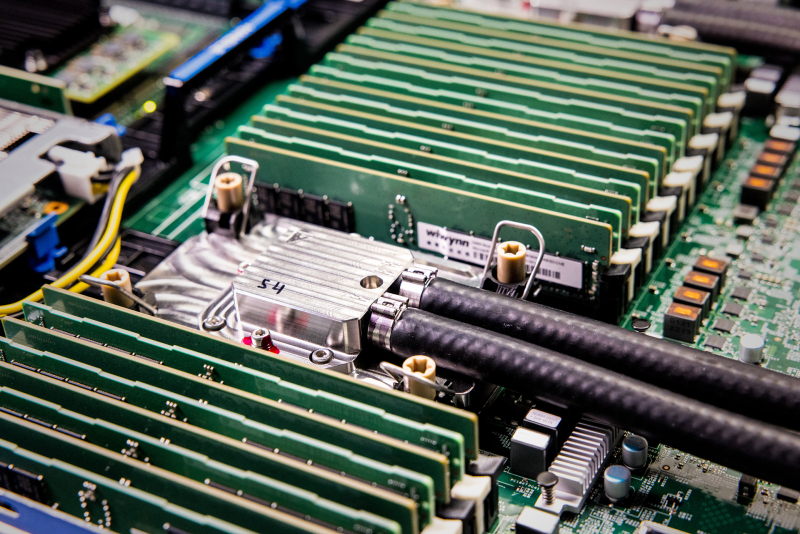

Майнинговая компания Iren увеличила мощность ИИ-облака, закупив тысячи ускорителей NVIDIA и AMD за $674 млнКриптомайнинговая компания Iren (ранее известная как Iris Energy), по сообщению Datacenter Dynamics, увеличила количество ИИ-ускорителей в своём облаке примерно в два раза. Стоимость приобретённого оборудования оценивается в $674 млн. Компании прочат статус серьёзного игрока на рынке неооблаков. Компания находится в процессе перехода от майнинга криптовалют к облачному бизнесу на базе ИИ. В частности, закуплены 7100 ускорителей NVIDIA B300 и 4200 изделий NVIDIA B200, а также 1100 AMD Instinct MI350X. В результате, общее количество ускорителей в составе платформы Iren достигло приблизительно 23 тыс. Новое оборудование в ближайшие месяцы будет развёрнуто в кампусе Iren в городе Принс-Джордже (Prince George) в северной части провинции Британская Колумбия в Канаде. В настоящее время на этой площадке ведётся строительство вычислительного комплекса с жидкостным охлаждением мощностью 10 МВт (ИТ-нагрузка), который сможет поддерживать более 4500 суперускорителей NVIDIA GB300. В конце августа нынешнего года Iren сообщила о приобретении 1200 ускорителей NVIDIA B300 для серверов с воздушным охлаждением и 1200 изделий NVIDIA GB300 для систем с жидкостным охлаждением: стоимость данной партии составила примерно $168 млн. Эти чипы также предназначены для ЦОД в Принс-Джордже. Тогда говорилось, что Iren привлекла финансирование в размере около $96 млн для покупки GB300: средства получены по схеме лизинга сроком на два года. В настоящее время Iren управляет пятью кампусами ЦОД общей мощностью 810 МВт, расположенными в Северной Америке: два в Техасе (США) и три в Британской Колумбии (Канада). Ещё 2,1 ГВт находятся в стадии строительства, причём 2 ГВт из них приходится на новый кампус в Техасе. Как отмечает Дэниел Робертс (Daniel Roberts), соучредитель и содиректор Iren, удвоение парка GPU позволит удовлетворить растущие потребности клиентов в масштабируемых вычислительных мощностях.

26.09.2025 [23:58], Владимир Мироненко

Пожар в южнокорейском ЦОД привёл к отключения более 70 государственных онлайн-сервисовВ пятницу вечером в дата-центре национального информационно-ресурсного агентства Южной Кореи (National Information Resources Service) в Тэджоне (Daejeon) произошёл пожар, что привело к отключению более 70 государственных сервисов, пишет The Korea Times со ссылкой на заявление Министерство внутренних дел и безопасности страны Южной Кореи. Сообщение о возгорании литиевой батареи в дата-центре агентства на пульт пожарной службы в 20:15 по местному времени. На тушении пожара задействовано 70 машин и 73 пожарных. По данным СМИ, все сотрудники были эвакуированы с места происшествия, один человек получил лёгкие травмы. Из-за инцидента была приостановлена работа более чем 70 государственных онлайн-сервисов, включая систему мобильной идентификации и онлайн-платформу для подачи жалоб и петиций, сообщило министерство. Также наблюдаются сбои в работе государственной электронной почты и проблемы с доступом ко многим правительственным веб-сайтам. Премьер-министр Ким Мин Сок (Kim Min-seok) призвал правительство мобилизовать все возможные ресурсы для тушения пожара, а также поручил Министерству внутренних дел и безопасности принять меры для скорейшего восстановления работы онлайн-сервисов. За последние годы из-за возгорания литий-ионных аккумуляторов произошло несколько масштабных пожаров в ЦОД, что вызывает опасения у экспертов по поводу безопасности использования таких источников питания. Южная Корея уже «прославилась» одним из крупнейших в истории индустрии сбоев ЦОД, причиной которого стало возгорание Li-Ion аккумуляторов.

26.09.2025 [22:57], Владимир Мироненко

На базе RISC-V в России пока активно развиваются только микроконтроллерыРоссийский альянс RISC-V, объединяющий крупнейшие компании в области электроники, включая Аквариус», YADRO, «Байкал Электроникс» и др., представил на форуме «Микроэлектроника-2025» планы по внедрению этой архитектуры, передаёт «Коммерсантъ». Согласно данным альянса, с 2024 года российские компании выпустили более 3 млн продуктов на RISC-V-архитектуре. По количеству запущенных на RISC-V в серию чипов прирост отмечен только у микроконтроллеров — с двух чипов, разработанных АО «Микрон» (ГК «Элемент») и АО «НИИЭТ» в 2024 году, до серии микроконтроллеров BE-U1000 от «Байкал Электроникс» и шести прототипов вышеназванных компаний в 2025 году. На основе этих чипов на текущий момент насчитывается больше десяти моделей изделий против пяти в 2024 году. В 2026 году альянс планирует запустить все объявленные прототипы в серийное производство, увеличив количество новых моделей устройств до более чем 30. «Байкал Электроникс» также анонсировала выпуск 1-ГГц ИИ-ускорителя Baikal AI производительностью 30 TOPS при 30-Вт энергопотреблении, который получит управляющее RISC-V-ядро. Управляющие ядра на базе этой архитектуры использует, например, Google в своих TPU. Согласно докладу, на рынке насчитывается четыре линейки лицензированных ядер, разрабатываемых двумя компаниями. Новые ядра появятся не раньше 2026 года. Председатель технологического комитета альянса RISC-V Сергей Якушкин назвал наличие нескольких компаний-разработчиков, а также университетских проектов и ядер с открытым исходным кодом основным преимуществом архитектуры. В связи с этим он отметил снижение риска зависимости от конкретного поставщика для производителей конечных устройств.

26.09.2025 [17:44], Сергей Карасёв

Семь из десяти российских компаний не окупили инвестиции в ИИИсследование, проведенное консалтинговой компанией TRIADA Partners (бывшие партнёры и консультанты Mckinsey & Company), говорит о том, что примерно 70 % российских предприятий пока не смогли окупить инвестиции в ИИ, несмотря на то что они были сделаны несколько лет назад. Аналитики изучили данные по использованию технологий ИИ более 10 крупнейших компаний-клиентов, крупных и средних бизнесов на российском рынке в сегментах горной добычи, металлургии, добычи нефти и строительной отрасли. На этих предприятиях в числе прочего применяются системы на основе генеративного ИИ. По оценкам экспертов, технологии ИИ в том или ином виде используют в своей работе около 70 % компаний в России. Средний срок окупаемости ИИ-проектов составляет 2–3 года, но по прошествии этого времени многие предприятия по-прежнему не могут компенсировать понесённые затраты. Вместе с тем стоимость готовых ИИ-решений, включая модель и поддержку, при заказе у сторонних разработчиков может исчисляться десятками и сотнями миллионов рублей. Причём условия соглашения зачастую предполагают, что клиент должен делиться с разработчиком своими данными, что вызывает опасения в плане безопасности. В целом, бюджет на ИИ-проекты в среднем распределяется следующим образом:

Вопрос окупаемости инвестиций в ИИ, по данным TRIADA Partners, наиболее остро стоит у промышленных компаний, организаций из сфер энергетики, госуправления и обороны. Основными препятствиями аналитики называют отсутствие единой стратегии и координации ИИ-проектов, что приводит к конфликтующим решениям, а также несистемность трансформаций. Эксперты подчёркивают, что одиночные пилотные инициативы «не дают системного эффекта»: для достижения наилучших результатов необходимо охватывать все ключевые и поддерживающие функции — производство, маркетинг, HR, закупки, финансы и пр. Кроме того, в окупаемости инвестиций в технологии ИИ может помочь коммерциализация и вывод собственных разработок на рынок. «Скорость и повсеместность интеграции ИИ имеет обратную сторону — пока не для всех компаний очевидна эффективность таких технологий, правильный алгоритм их внедрения и использования, что приводит к увеличению сроков окупаемости инвестиций. В сложившейся ситуации бизнес находится в поиске решений оптимизировать затраты», — говорит TRIADA Partners.

26.09.2025 [16:52], Руслан Авдеев

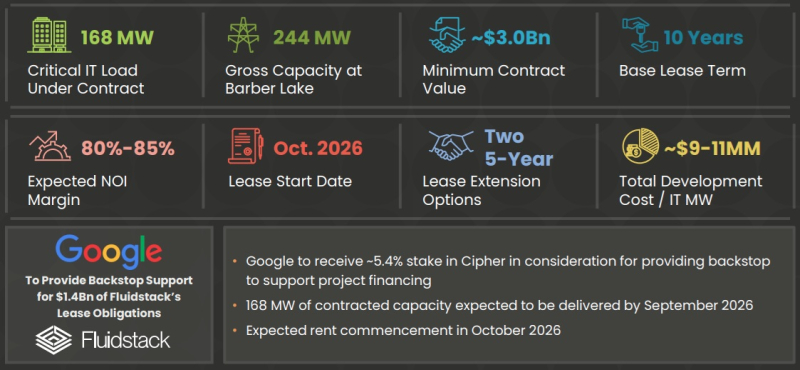

Fluidstack и Google «склонили» к ИИ ещё одного криптомайнера — Cipher Mining сдаст им ЦОДЗанимающийся криптомайнинговыми и HPC-проектами оператор дата-центров Cipher Mining заключил соглашение о предоставлении мощностей ЦОД ИИ-облаку Fluidstack. Параллельно Google выступит инвестором Cipher. Google и FluidStack уже применили аналогичную схему в договоре с криптомайнером TeraWulf. В соответствии с договором колокации Cipher обеспечит для FluidStack 168 МВт IT-мощностей (общая мощность 244 МВт). Речь идёт о строящемся в Колорадо-Сити (Техас) кампусе Barber Lake площадью 240 га и мощностью до 500 МВт, аренда которого должна начаться в октябре 2026 года. Десятилетнее соглашение принесёт Cipher $3 млрд. Предусмотрена возможность продления договора на два дополнительных пятилетних периода, в этом случае стоимость контракта составит уже около $7 млрд. В рамках сделки Google предоставит гарантии по арендным обязательствам Fluidstack на сумму $1,4 млрд для обеспечения долгового финансирования проекта. В ответ Google получает опционы на покупку около 24 млн акций Cipher, в случае их исполнения Google получит долю приблизительно в 5,4 % от акционерного капитала оператора ЦОД. Впрочем, Cipher заявляет, что намерена сохранить полный контроль над проектом и готова при необходимости привлечь внешний капитал для частичного финансирования строительства.

Источник изображения: Cipher Mining В Cipher выразили энтузиазм по поводу партнёрства для создания ИИ ЦОД и рассматривают сделку как знаковое событие, которое укрепит позиции компании на растущем рынке HPC. Также ожидается, что сделка станет лишь первой в серии подобных, поскольку Cipher наращивает мощности и укрепляет свои позиции в этом секторе. В 2021 году компания отделилась от майнингового гиганта Bitfury и вышла на IPO через слияние с компанией Good Works Acquisition Corp. SoftBank инвестировала в Cipher $50 млн, получив право преимущественного выкупа неосвоенного участка Barber Lake. Текущее портофолио Cipher в США включает криптомайнинговые площадки в Одессе (Odessa) и Альборзе (Alborz), а также две площадки в совместной собственности с другими компаниями близ Эндрюса (Andrews), известные как Bear и Chief, передаёт DataCenter Dynamicsc. Также компания недавно приобрела площадку Reveille в техасском Котулле (Cotulla). Изначально будет обеспечена мощность 70 МВт, но возможно масштабирование до 200 МВт. Сейчас он строит площадку Black Pearl в Западном Техасе, способную обеспечить до 300 МВт. В последней презентации Cipher отмечается, что в 2027 году в Техасе должны заработать площадки Mikeska на 500 МВт близ Брейди (Brady), 500-МВт Milsing близ Хьюстона (Houston) и McLennan на 500 МВт близ Уэйко (Waco). Также отмечена площадка Stingray на 100 МВт.

26.09.2025 [14:54], Владимир Мироненко

Лишь около 10 % российских компаний использует серверы с отечественными процессорами

cpu

hardware

ocs distribution

байкал электроникс

импортозамещение

исследование

сделано в россии

эльбрус

В России лишь 10 % компаний используют серверы с отечественными процессорами, сообщили «Ведомости» со ссылкой на исследование дистрибутора IT-оборудования и ПО OCS. У 75 % российских компаний установлены серверы на x86-процессорах Intel и AMD. Порядка 34 % применяют серверы с Arm-чипами. Серверы на российских процессорах «Эльбрус» (VLIW) и «Байкал электроникс» (MIPS, Arm и RISC-V) используют лишь 7 % и 5 % респондентов соответственно. Наименее популярна архитектура RISC, она используется всего в 2 % компаний. Исследование основано на опросе 173 топ-менеджеров крупнейших, крупных и средних компаний металлургической и химической промышленности, телекома, медиарынка, машиностроения, финансов и нефтегазового и угольного комплекса. В опросе можно было выбрать несколько вариантов ответов. По словам представителя OCS, процессоры «Эльбрус» используются в химической отрасли, металлургии, машиностроении, финансах. При этом около половины ответов приходится на представителей химической индустрии, уточнил он. Чипы «Байкал» чаще используют в машиностроении и финансах, добавил собеседник «Ведомостей».

Источник изображения: mcst.ru В Fplus отметили, что спрос на российские CPU исчисляется сотнями штук, тогда как общий объём рынка серверов в 2024 году составлял около 140 тыс. единиц. У «Эльбруса» и «Байкала» есть определённые шансы повысить свою долю на рынке РФ при условии активной государственной поддержки и интенсивное наращивание количества совместимых ПО и драйверов, считают в OCS. В Fplus добавили, что «Эльбрус» и «Байкал» станут пользоваться спросом, если в стране появятся собственные литографы и производство кристаллов, что позволит производить большое количество процессоров.

26.09.2025 [13:28], Руслан Авдеев

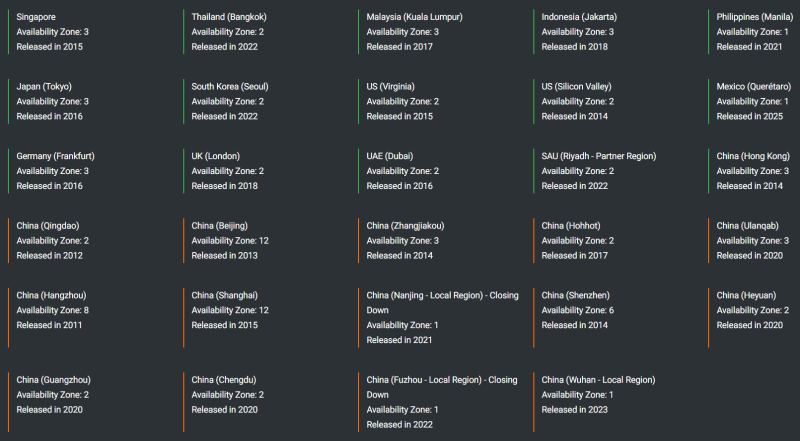

Alibaba Cloud запустит восемь новых ЦОД в Европе, Азии и Северной АмерикеКитайский облачный провайдер Alibaba Cloud (Aliyun) готовится открыть восемь новых ЦОД в разных странах. Анонсирован запуск первых объектов в Бразилии, Франции и Нидерландах, а также расширение присутствия в Мексике, Японии, Южной Корее, Малайзии и ОАЭ. По словам компании, ИИ меняет не только технологии, но и сами методы «создания ценности» и стимулирования роста. Стратегическое расширение глобальной инфраструктуры призвано удовлетворить растущий спрос со стороны «дальновидных» клиентов. В Alibaba Cloud считают, что компания находится в авангарде инноваций в сфере ИИ, развиваясь вместе с клиентами, предлагая комплексные решения на базе искусственного интеллекта и облачных технологий, поддерживающих бизнес в любое время, в любом месте. Компания готова вложить ¥380 млрд ($52,7 млрд) в развитие собственной инфраструктуры, чтобы сохранить лидерские позиции. На сегодня Alibaba Cloud управляет 91 зоной доступности в 29 облачных регионах, включая материковый Китай, Азию, США, Южную Америку, Европу и Ближний Восток. Так, Alibaba вышла на японский рынок в 2016 году, в Токио действуют три зоны доступности. В Сеуле (Южная Корея) имеются две зоны доступности, в Мексике в 2025 году была открыта зона. В Дубае (ОАЭ) Alibaba присутствует с 2016 года, там компания управляет двумя зонами. Также три зоны имеются в Куала-Лумпуре (Малайзия). Ранее в сентябре компания опубликовала финансовый отчёт за I квартал 2026 финансового года, согласно которому совокупная выручка подразделения Alibaba Cloud Intelligence Group составила $4,662 млрд, на 26 % выше год к году. При этом, как сообщают в Alibaba, год к году выручка от ИИ сохранила «трёхзначный» рост — подобный рост сохраняется уже восемь кварталов подряд. Кварталом ранее выручка облачного подразделения составила $4,152 млрд, увеличившись в годовом исчислении на 18 %. |

|