Лента новостей

|

11.06.2024 [18:51], Владимир Мироненко

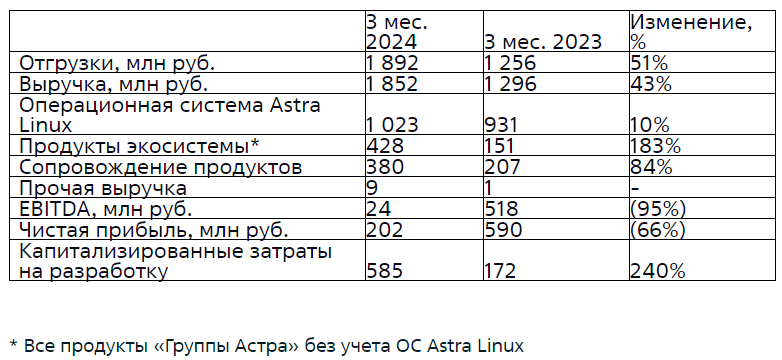

«Группа Астра» увеличила выручку в I квартале на 43 %Российский производитель инфраструктурного программного обеспечения ПАО «Группа Астра» объявил финансовые результаты по МСФО и ключевые операционные показатели за I квартал 2024 года. Выручка компании увеличилась год к году на 43 % до 1,85 млрд руб. Традиционно большую часть выручки «Группы Астра» принесла ОС Astra Linux — 1,02 млрд руб., что на 10 % больше показателя аналогичного периода прошлого года. Вместе с тем значительно выросли доходы от продуктов экосистемы — на 183 % до 428 млн руб., а также от сопровождения продуктов — на 84 % до 380 млн руб. Доля продуктов экосистемы в выручке достигла 23 %, увеличившись год к году в два раза.

Источник: «Группа Астра» Компания сообщила, что отгрузки (передача права на использование лицензионного продукта клиенту или заключённые контракты на услуги) выросли год к году на 51 % до 1,89 млрд руб., объяснив увеличение показателя активной экспансии бизнеса и развитием продуктового предложения. Несмотря на сезонный характер деятельности с более 70 % отгрузок во II полугодии и примерно равномерным распределением затрат в течение года, компания завершила I квартал с прибылью, составившей 202 млн руб., что на 66 % меньше прошлогоднего показателя. Показатель EBITDA сократился год к году на 95 % до 24 млн руб., а капзатраты на разработку выросли на 240 % до 580 млн руб. Для поддержки роста бизнеса компания продолжает увеличивать команду. Штат сотрудников увеличился год к году в 2,5 раза до 2324 человек (более 65 % — ИТ-специалисты).

11.06.2024 [17:09], Руслан Авдеев

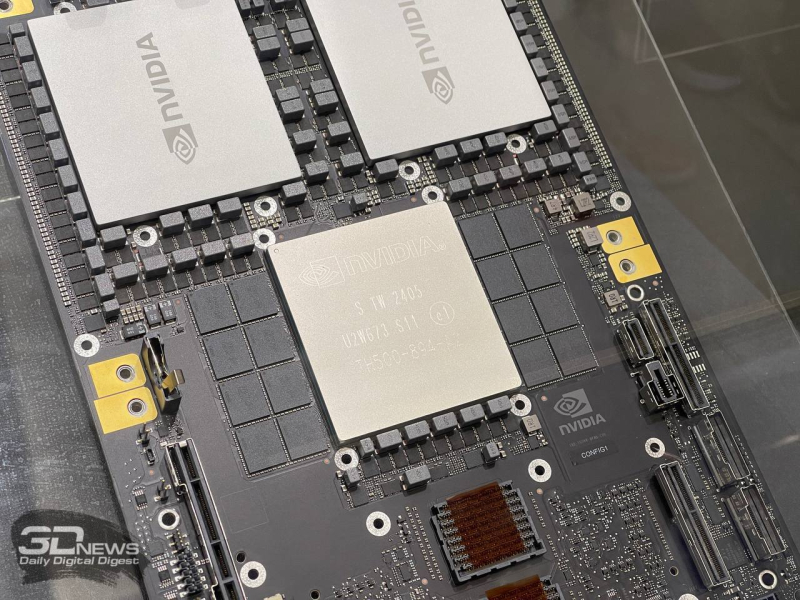

Foxconn построит на Тайване передовой вычислительный центр на базе суперускорителей NVIDIA BlackwellПроизводитель электроники Foxconn намерен построить на острове передовой вычислительный центр в Гаосюне (Тайань). Datacenter Dynamics информирует, что центр, который будет готов в 2026 году, получит 64 суперускорителя NVIDIA Blackwell GB200 NVL72. Foxconn и NVIDIA будут сотрудничать и над созданием «цифровых двойников» для производственных компаний, электромобилей и систем умного города. Проекты будут реализованы на платформе NVIDIA Omniverse. В NVIDIA заявили, что сейчас происходит расцвет новой эры вычислений, ставшей драйвером спроса на дата-центры для генеративного ИИ. Также в компании подчеркнули, что Foxconn является ведущим поставщиком вычислительных решений NVIDIA и одним из ключевых новаторов в деле внедрения генеративного ИИ в промышленности и робототехнике. Используя платформы NVIDIA Omniverse и Isaac, компания задействует передовые ИИ-технологии и систему цифровых двойников для создания передового вычислительного центра в Гаосюне. Основанная в 1974 году компания Foxconn в последнее время стремится расширить долю рынка в полупроводниковой индустрии на фоне медленного роста продаж смартфонов. Дочерняя компания Ingrays выпускает серверы, системы хранения данных и HPC-компоненты, включая HPC-платформы на основе чипов NVIDIA. Ранее появилась информация о том, что компания намерена превратить опосредованно принадлежащий ей завод Sharp по выпуску LCD-панелей в дата-центр, но тот расположен в Япони и к текущему проекту не имеет прямого отношения.

11.06.2024 [15:50], Руслан Авдеев

Amazon, Google и Microsoft готовы построить собственные ЛЭП, чтобы не лишиться ЦОД в ДублинеАмериканские гиперскейлеры призывают ирландское правительство позволить строить собственные частные линии электропередач. Datacenter Dynamics сообщает, что такие энергетические магистрали свяжут дата-центры с объектами возобновляемой энергетики. Благодаря этому можно будет вновь строить дата-центры близ ирландской столицы. Фактически в районе «Большого Дублина» действует мораторий на строительство новых кампусов ЦОД. Государственный оператор энергосетей EirGrid заявил, что пока не будет принимать заявки на подключение новых объектов соответствующего типа до 2028 года. В Ирландии, как и в Нидерландах, больше не рады гиперскейлерам. Но если верить последним сведения, Google, Amazon и Microsoft намерены добиться от властей разрешения напрямую связать свои дата-центры с солнечными и ветряными электростанциями. Компании уверены, что это снизит нагрузку на уже существующие линии в Дублине. Пока же строить линии электропередач в Ирландии имеет право лишь государственная структура Electricity Supply Board (ESB), но гиперскейлеры уверены, что у них получится сделать то же самое дешевле и быстрее.

Источник изображения: Gabriel Ramos/unsplash.com После начала публичных слушаний в прошлом году ирландское правительство пообещало обнародовать политику относительно частных ЛЭП ещё в I квартале 2024 года, но так и не сделало этого. Пока действует мораторий, компании ищут альтернативы. Так, Microsoft и Vantage предпочли построить собственные ТЭС на территории своих кампусов. Изучаются и возможность питания от топливных ячеек и создания энергохранилищ. В соседней Великобритании энергокомпания Octopus, по слухам, построит собственные мачты линий электропередач, чтобы помочь расширить местные электросети. Провайдер уже ведёт переговоры с регулятором Ofgem и надеется, что оператор National Grid откажется от монополии в Англии и Уэльсе.

11.06.2024 [15:22], Сергей Карасёв

3,76 млн ускорителей в 2023 году: NVIDIA захватила 98 % рынка GPU для ЦОДПо оценкам аналитической фирмы Tech Insights, которые приводит ресурс HPC Wire, компания NVIDIA в 2023 году отгрузила приблизительно 3,76 млн ускорителей на базе GPU, ориентированных на ЦОД. Это более чем на 1 млн штук превосходит результат 2022 года, когда поставки таких изделий оценивались в 2,64 млн единиц. С учётом решений AMD и Intel общий объём поставок GPU-ускорителей для ЦОД в 2023 году составил 3,85 млн единиц против примерно 2,67 млн штук в 2022 году. Правда, столь малая доля отгрузок решений AMD и Intel вызывает некоторые сомнения. Как отмечает аналитик Tech Insights Джеймс Сандерс (James Sanders), в настоящее время на рынке не хватает аппаратных ресурсов для удовлетворения всех ИИ-потребностей. А поэтому будет расти спрос на ускорители и специализированные чипы разработчиков, конкурирующих с NVIDIA. Согласно подсчётам TechInsights, по итогам 2023-го NVIDIA контролировала около 98 % мирового рынка ускорителей на базе GPU для дата-центров. Схожий результат компания продемонстрировала и годом ранее. Такой рост связан со стремительным развитием ИИ-приложений и увеличением спроса на НРС-системы. При этом на NVIDIA приходится и 98 % выручки от реализации таких ускорителей: в 2023 году они принесли компании $36,2 млрд, что более чем в три раза превышает прошлогодний показатель в $10,9 млрд. По данным TechInsights, в 2023 году AMD поставила около 50 тыс. ускорителей для ЦОД, а Intel — примерно 40 тыс. единиц (в оригинальном материале HPCWire указаны на порядок более высокие значения; корректировка сделана в соответствии с оставшейся долей в 2 % рынка). В 2024-м, как полагают эксперты, спрос на такие продукты в глобальном масштабе поднимется. Речь, в частности, идёт об ускорителях серии Instinct MI300, разработанных AMD. При этом AMD заявляет, что намерена выпускать новые решения ежегодно: ускоритель MI325X запланирован на 2024 год, MI350 — на 2025-й, а MI400 — на 2026-й. В свою очередь, Intel продвигает изделия Gaudi3. Специализированные ИИ-чипы проектируют и ведущие гиперскейлеры. Так, AWS в конце прошлого года представила ИИ-ускоритель Trainium2, предназначенный для обучения нейронных сетей. Google анонсировала изделия Cloud TPU v5p, а Microsoft — Maia 100. Meta✴ намерена активно внедрять собственные ИИ-ускорители Artemis.

11.06.2024 [14:17], Руслан Авдеев

Alibaba Cloud открыла в Мозамбике второй в Африке облачный регион ALP CloudПодразделение системного интегратора Telkom Group, компания BCX, объединила усилия с Alibaba для организации облачных сервисов Alibaba Cloud в Мозамбике. По данным Datacenter Dynamics, BCX обеспечит хостинг т.н. Africa Local Public (ALP) Cloud в дата-центре в Мапуту. По словам главы BCX, сотрудничество с Alibaba Cloud позволяет предоставлять новейшие технологии при посредничестве местной компании, которая понимает сложности и особенности ведения бизнеса на африканском континенте. В BCX признают чрезвычайную важность цифрового суверенитета для мозамбикского бизнеса, поэтому BCX и запустила облако ALP Cloud в Мапуту. Говорится о нескольких зонах доступности, местной службе поддержки и возможности оплаты в местной валюте. Это уже вторая африканская страна, где появились облачные сервисы Africa Local Public Cloud компании Alibaba. Запуск в Южной Африке состоялся ещё в октябре 2023 года. Китайская компания разместила свои сервисы в двух южноафриканских ЦОД, создав две зоны доступности — в ЦОД BCX в Мидранде и принадлежащем Teraco Data Environment дата-центре в Исандо. Следующий этап внедрения ALP Cloud предусматривает создание зоны доступности в ЦОД в Кейптауне. Также в Южной Африке предлагают свои облачные сервисы Microsoft Azure, Amazon (AWS) и Google. BCX, основанная в 1996 году как Business Connexion, считается одним из крупнейших системных интеграторов в Африке, Telkom Group купила бизнес в 2015 году. BCX анонсировала партнёрство с Alibaba в октябре 2022 года — африканскому контрагенту дали эксклюзивные права распространять продукты и сервисы Alibaba Cloud в Южной Африке. Сегодня Alibaba управляет 89 зонами доступности в 30 регионах по всему миру.

11.06.2024 [13:54], Сергей Карасёв

ByteDance потратит более $2 млрд на ИИ-кампус в МалайзииКитайская холдинговая интернет-компания ByteDance, владеющая в том числе платформой TikTok, по сообщению Datacenter Dynamics, реализует масштабный проект по расширению кампуса ЦОД в Малайзии. Речь идёт о создании хаба, рассчитанного на поддержание ИИ-нагрузок. Об инициативе объявил министр инвестиций, торговли и промышленности Малайзии Тенгку Зафрул Азиз (Tengku Zafrul Aziz) после встречи с вице-президентом TikTok Хеленой Лерш (Helena Lersch). В общей сложности на ИИ-хаб в этой стране ByteDance потратит около $2,13 млрд. Отмечается, что ByteDance является якорным арендатором крупного кампуса ЦОД Bridge Data Centers (BDC) MY06 в технопарке Седенак в Джохоре. Не исключено, что часть средств будет направлена на модернизацию этой площадки. Как сообщил Тенгку Зафрул Азиз, ByteDance вложит примерно $317 млн в расширение возможностей своего дата-центра. Подробности о проекте пока не раскрываются. Комплекс MY06 открылся в 2022 году: мощность площадки на момент ввода в эксплуатацию составляла 110 МВт. По заявлениям BDC, это крупнейший ЦОД такого типа в Малайзии. Однако Yondr Group планирует создать в названном технопарке кампус мощностью 300 МВт. Компания уже получила кредит в размере $150 млн для финансирования строительства объекта. Нужно отметить, что кампусы ЦОД в Малайзии создают ведущие мировые гиперскейлеры. В частности, Google вложит $2 млрд в ЦОД и облако в этой стране, тогда как Microsoft намерена потратить на аналогичные проекты $2,2 млрд. Equinix уже открыла в Малайзии два своих первых дата-центра. Вместе с тем NVIDIA и YTL Power (YTLP), энергетическое подразделение малайзийского конгломерата YTL, занялись созданием ИИ-облака и суперкомпьютеров в стране: общий объём инвестиций составит $4,3 млрд. Таким образом, Малайзия становится всё ближе к тому, чтобы действительно стать новым IT-хабом Юго-Восточной Азии, тогда как соседний Сингапур, по-видимому, продолжит терять лидерские позиции из-за энергетического кризиса.

11.06.2024 [11:55], Сергей Карасёв

ParTec обвинила Microsoft в нарушении патентов в области ИИ-суперкомпьютеровНемецкая компания по производству суперкомпьютерного оборудования ParTec и её лицензионный агент BF exaQC AG, по сообщению ресурса HPC Wire, подали иск против Microsoft. Редмондская корпорация обвиняется в нарушении патентов на технологии, которые применяются при создании мощных современных суперкомпьютеров для задач ИИ. В материалах дела речь идёт о разработках, связанных с динамической модульной системной архитектурой (dMSA). Технология обеспечивает эффективное взаимодействие CPU, GPU и других чипов в составе НРС-систем. Отмечается, что dMSA имеет основополагающее значение при построении мощных вычислительных комплексов для обучения ИИ-моделей и инференса. Важность патентов ParTec AG подтверждается использованием соответствующих разработок в ведущих европейских суперкомпьютерах, таких как Leonardo в Болонье (Италия), Jupiter в Юлихе (Германия) и Meluxina в Люксембурге. Все они построены с применением dMSA и признаны новаторскими платформами, говорит компания.

Источник изображения: pixabay.com Кроме того, ParTec ведёт переговоры о лицензировании своих технологий с известным американским производителем чипов. А с властями США компания обсуждает возможность использования разработок в строящемся крупнейшем в мире суперкомпьютере экзафлопсного уровня. Вероятно, имеется в виду система El Capitan, которая обеспечит производительность более 2 Эфлопс (FP64). Ввод комплекса в эксплуатацию намечен на середину нынешнего года. В рамках разбирательства с Microsoft компания ParTec просит суд наложить запрет на дальнейшее незаконное использование запатентованных технологий. Кроме того, немецкий разработчик требует обязать ответчиков выплатить компенсацию. Корпорация Microsoft ситуацию никак не комментирует.

11.06.2024 [11:51], Сергей Карасёв

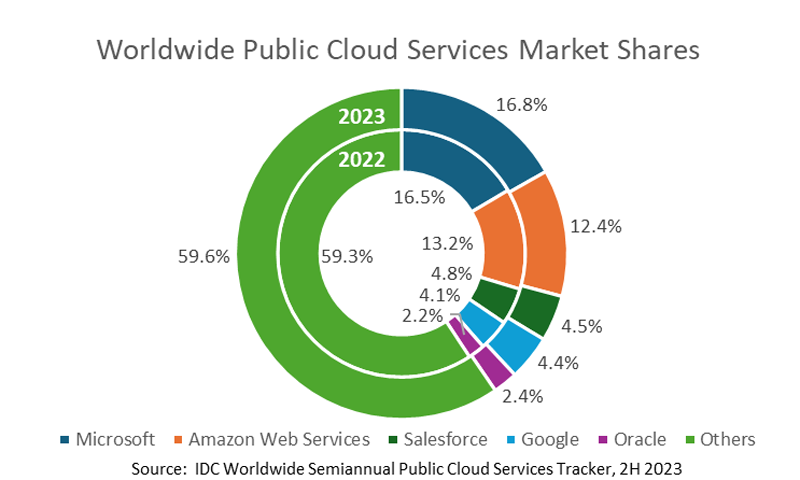

Объём мирового рынка публичных облаков в 2023 году достиг $670 млрд, снова показав быстрый ростКомпания IDC обнародовала результаты исследования мирового рынка публичных облаков в 2023 году. Отрасль продолжает демонстрировать стремительный рост: суммарные затраты по сравнению с 2022-м подскочили на 19,9%, достигнув приблизительно $669,2 млрд. Крупнейшим сегментом остаются платформы SaaS (приложения): на них в 2023 году пришлось около $298,5 млрд, а доля в общем объёме рынка составила 44,6 %. Для сравнения, годом ранее показатели равнялись $254,4 млрд и 45,6 %. Таким образом, отмечен рост затрат на 17,4 % в годовом исчислении. На втором месте в плане расходов находятся сервисы IaaS со $133,4 млрд против $115,5 млрд в 2022 году. Рост составил около 15,6 %, тогда как доля снизилась в годовом исчислении с 20,7 % до 19,9 %.

Источник изображения: IDC Замыкают тройку службы PaaS со $123,3 млрд и долей 18,4 % по сравнению с $95,4 млрд и 17,1 % годом ранее. Рост в годовом исчислении зафиксирован на уровне 29,3 %. Затраты в сегменте SaaS–SIS (SaaS в области системных инфраструктур) год к году увеличились на 22,5 % — с $93,1 млрд до $114,0 млрд. При этом рыночная доля поднялась с 16,7 % до 17,0 %. Суммарная доля пяти ведущих поставщиков публичных облачных услуг — Microsoft, Amazon Web Services (AWS), Salesforce, Google и Oracle — составила 40,5 % по итогам 2023 года. Лидером является Microsoft с результатом 16,8 %, а на втором месте располагается AWS с 12,4 %. IDC прогнозирует, что в 2024 году мировой доход от публичных облаков превысит $800 млрд, что будет соответствовать росту на 20,5 % по отношению к 2023-му. Показатель CAGR (среднегодовой темп роста в сложных процентах) в течение пяти лет ожидается на отметке 19,5 %: в результате, затраты достигнут $1,6 трлн в 2028 году.

11.06.2024 [11:11], Сергей Карасёв

«Аквариус» и «Группа Астра» представили отечественный ПАК для резервного копирования данных«Аквариус» и «Группа Астра» подписали оглашение о сотрудничестве по развитию и продвижению российских программно-аппаратных комплексов (ПАК) системы резервного копирования AQ_ServRuBackup (ПАК СРК AQ_ServRuBackup). В основу ПАК положены аппаратная платформа Aquarius, ОС Astra Linux и ПО для резервного копирования и восстановления данных RuBackup. Говорится о поддержке различных сред виртуализации, в том числе VMmanager. Для ПАК СРК «Аквариус» предусмотрены несколько модификаций с разными ёмкостью и производительностью. Это варианты «Начальный», «Оптимальный» и «Скоростной» на основе серверов «Аквариус» T50 D212FW (2U), «Аквариус» T50 D436FW (4U) и «Аквариус» T50 D224FW (2U) соответственно. В первых двух случаях применяются HDD типа NL SAS (7200 RPM), а максимальная вместимость достигает 320 Тбайт и 1,2 Пбайт соответственно. Старшая «скоростная» модель комплектуется накопителями SATA SSD суммарной вместимостью до 1,2 Пбайт. Все системы оснащены двумя портами 10/25GbE SFP28, а опционально могут быть добавлены по четыре разъёма 1GbE RJ-45 и 10GbE RJ-45, два порта 10GbE SFP+ и два порта 100GbE QSFP28 (только у старшей версии). Благодаря решению RuBackup комплексы, как утверждается, обеспечивают надёжную защиту данных от различных рисков, включая сбои оборудования, человеческие ошибки, кибератаки, повреждения и стихийные бедствия. Среди ключевых особенностей систем названы масштабируемость для предприятий и организаций федерального уровня, полная автоматизация процесса резервного копирования, управление его жизненным циклом, эффективное хранение данных с защитой от удаления, изменения и подмены, а также встроенные средства контроля информационной безопасности. «ПАК СРК AQ_ServRuBackup — это сбалансированное архитектурное решение, оптимизирующее затраты на проектирование и интеграцию. Совместное решение способно закрыть потребности как организаций со сложной инфраструктурой корпоративного уровня, так и небольших компаний», — говорит глава «Рубэкап» (входит в «Группу Астра»).

10.06.2024 [22:02], Владимир Мироненко

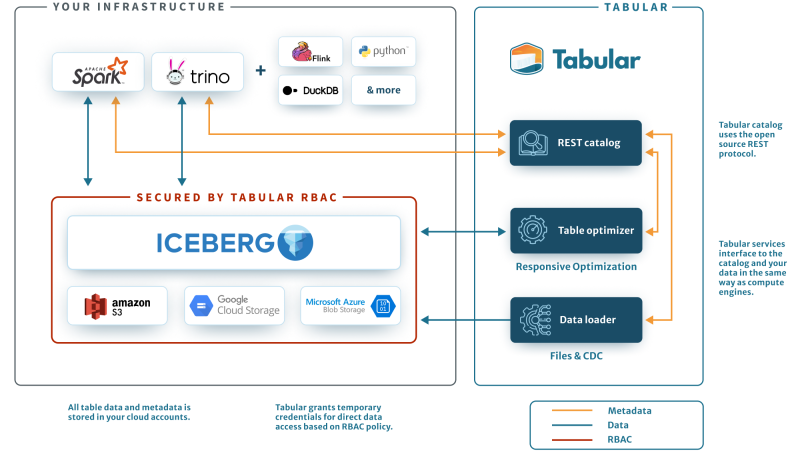

Не хочешь конкурировать — купи: Databricks приобрела Tabular за $1+ млрд, чтобы унифицировать озёра данныхАмериканский стартап в сфере аналитики больших данных и машинного обучения Databricks объявил о приобретении компании по управлению данными Tabular. Точная сумма сделки не раскрывается, но глава Databricks Али Годси (Ali Ghodsi) сообщил в интервью CNBC, что стоимость покупки превышает $1 млрд. Соучредители Tabular присоединятся к Databricks, где будут работать над объединением клиентских баз и сообществ Tabular и Databricks. Компания Tabular была основана ими в 2021 году. Она предлагает продукты для управления данными, созданные на основе Apache Iceberg — проекта, которым создатели Tabular занимались в Netflix и позже передали в дар фонду Apache Software Foundation. Iceberg — открытый формат для таблиц сверхбольших данных. Databricks предлагает объектно-ориентированное озеро данных Lakehouse на базе собственного открытого формата Delta Lake. С момента создания Delta Lake в проекте приняли участие более 500 разработчиков. Более 10 тысю компаний по всему миру используют Delta Lake для обработки в среднем более 4 Эбайт данных каждый день. Это быстрорастущий бизнес, но Iceberg-решения не менее популярны и конкурируют с решениями Databricks, отметил ресурс Blocks & Files. При этом о полной совместимости между Iceberg и Delta Lake речи не было. Но в 2023 году компания также представила UniForm-таблицы, позволяющие работать с Delta Lake, Iceberg и Hudi. А после поглощения Databricks будет тесно сотрудничать с сообществами Delta Lake и Iceberg для разработки совместимых форматов озёр данных. В краткосрочной перспективе это будет реализовано в рамках Delta Lake UniForm, а в долгосрочной перспективе будет создан единый, открытый и общий стандарт. |

|