Лента новостей

|

28.08.2024 [09:14], Владимир Мироненко

Google поделилась подробностями истории создания ИИ-ускорителей TPUВ огромной лаборатории в штаб-квартире Google в Маунтин-Вью (Калифорния, США) установлены сотни серверных стоек с ИИ-ускорителями TPU (Tensor Processing Unit) собственной разработки, с помощью которых производится обучение больших языковых моделей, пишет ресурс CNBC, корреспонденту которого компания устроила небольшую экскурсию. Первое поколение Google TPU, созданное ещё в 2015 году, и представляет собой ASIC для обработки ИИ-нагрузок. Сейчас компания использует такие, хотя и более современные ускорители для обучения и работы собственного чат-бота Gemini. С 2018 года TPU Google доступны облачным клиентам компании. В июле этого года Apple объявила, что использует их для обучения моделей ИИ, лежащих в основе платформы Apple Intelligence. «В мире есть фундаментальное убеждение, что весь ИИ, большие языковые модели, обучаются на (чипах) NVIDIA, и, конечно, на решения NVIDIA приходится львиная доля объёма обучения. Но Google пошла по собственному пути», — отметил гендиректор Futurum Group Дэниел Ньюман (Daniel Newman). Благодаря расширению использованию ИИ подразделение Google Cloud увеличило доход, и в последнем квартальном отчёте холдинг Alphabet сообщил, что выручка от облачных вычислений выросла на 29 %, впервые превысив $10 млрд за квартал. Google была первым провайдером облачных вычислений, создавшим кастомные ИИ-чипы. Лишь спустя три года Amazon Web Services анонсировала свой первый ИИ-ускоритель Inferentia, Microsoft представила ИИ-ускоритель Azure Maia 100 в ноябре 2023 года, а в мае того же года Meta✴ рассказала об семействе MTIA. Однако лидирует на рынке генеративного ИИ компания OpenAI, обученная на ускорителях NVIDIA, тогда как нейросеть Gemini была представлена Google спустя год после презентации ChatGPT. В Google рассказали, что впервые задумались о создании собственного чипа в 2014 году, когда в руководстве решили обсудить, насколько большими вычислительными возможностями нужно обладать, чтобы дать возможность всем пользователям поговорить с поиском Google в течение хотя бы 30 с каждый день. По оценкам, для этого потребовалось бы удвоить количество серверов в дата-центрах. «Мы поняли, что можем создать специальное аппаратное обеспечение, <…> в данном случае тензорные процессоры, для обслуживания [этой задачи] гораздо, гораздо более эффективно. Фактически в 100 раз эффективнее, чем было бы в противном случае», — отметил представитель Google. С выходом второго поколения TPU в 2018 году Google расширила круг выполняемых чипом задач, добавив к инференсу обучение ИИ-моделей. Процесс создания ИИ-ускорителя не только отличается высокой сложностью, но и требует больших затрат. Так что реализация таких проектов в одиночку не по силам даже крупным гиперскейлерам. Поэтому с момента создания первого TPU Google сотрудничает с разработчиком чипов Broadcom, который также помогает её конкуренту Meta✴ в создании собственных ASIC. Broadcom утверждает, что потратила более $3 млрд в рамках реализации совместных проектов. В рамках сотрудничества Google отвечает за собственно вычислительные блоки, а Broadcom занимается разработкой I/O-блоков, SerDes и иных вспомогательных компонентов, а также упаковкой. Самы чипы выпускаются на TSMC. С 2018 года в Google трудятся ещё одни кастомные чипы — Video Coding Unit (VCU) Argos, предназначенной для обработки видео. Что касается TPU, то в этом году клиентам Google будет доступно шестое поколение TPU Trillium. Более того, им станут доступны и первые Arm-процессоры Axion собственной разработки. Google выходит на этот рынок с большим отставанием от конкурентов. Amazon выпустила первый собственный процессор Graviton в 2018 году, Alibaba Yitian 710 появились в 2021 году, а Microsoft анонсировала Azure Cobalt 100 в ноябре. Все эти чипы основаны на архитектуре Arm — более гибкой и энергоэффективной альтернативе x86. Энергоэффективность имеет решающее значение. Согласно последнему экологический отчёту Google, с 2019 по 2023 год выбросы компании выросли почти на 50 %, отчасти из-за увеличения количества ЦОД для ИИ-нагрузок. Для охлаждения ИИ-серверов требуется огромное количество воды. Именно поэтому начиная с третьего поколения TPU компания использует прямое жидкостное охлаждение, которое только теперь становится практически обязательным для современных ИИ-ускорителей вроде NVIDIA Blackwell.

28.08.2024 [00:17], Елена Копытова

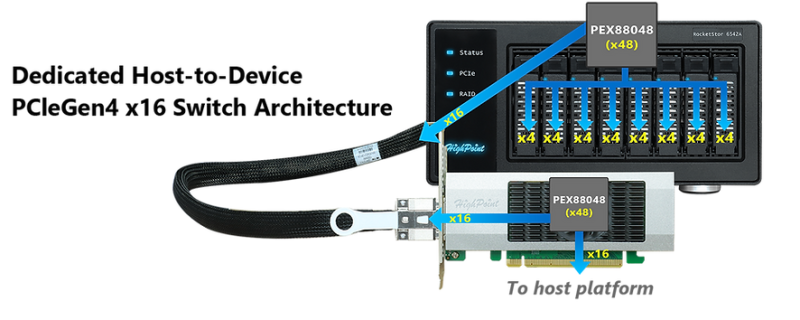

512 Тбайт NVMe: HighPoint представила внешние RAID-массивы RocketStor 6541AW и 6542AW с PCIe 4.0 x16Компания HighPoint представила NVMe DAS с возможностью формирования RAID-массивов и интерфейсом подключения PCIe 4.0 x16. Новая серия включает модели RocketStor 6541AW и 6542AW, которые предназначены для промышленных и периферийных платформ и профессиональных рабочих станций. Хранилища оснащены соответственно четырьмя и восемью вертикальными корзинами с поддержкой горячей замены. Возможна установка NVMe SFF-накопителей U.2/U.3 корпоративного класса суммарной ёмкостью до 0,5 Пбайт. Доступно формирование до четырёх независимых массивов RAID 0/1/10, которые могут быть загрузочными с точки зрения хоста. Каждому накопителю предоставляется четыре линии PCIe 4.0. К хосту хранилище подключается посредством CDFP-кабеля (PCIe 4.0 x16) длиной 1 м и HHFL-карты расширения Highpoint RocketRAID 1544 (тоже PCIe 4.0 x16), которая обеспечивает выделенный x16-канал связи между хостом и устройством. Highpoint подчёркивает, что и в шасси, и в адаптере используются PCIe-коммутаторы Broadcom PEX88048, которые предоставляют 48 линий PCIe 4.0 с низким уровнем задержки, что позволяет получить высокую скорость передачи данных без потерь. Поддерживается установка SED-накопителей и шифрование данных, а сами устройства используют SecureBoot, что позволяет избежать запуска неавторизованного кода во время загрузки. Кроме того, при отключении от «родного» хост-адаптера данные в хранилище становятся недоступными. RocketStor 654x оснащены вентиляторами с низким уровнем шума, а возможность ручной регулировки оборотов позволяет настраивать интенсивность охлаждения в зависимости от условий эксплуатации. Возможно и полное отключение вентиляторов. На изображении задней панели также видны порт USB 2.0 Type-C (для перепрошивки) и LAN-порт RJ45 (для инвентаризации). Габариты RocketStor 6541AW составляют 154,94 × 130,05 × 210,06 мм при массе 5,2 кг, 6542AW — 234,95 × 122,94 × 210,18 мм и 6,7 кг. Диапазон рабочих температур простирается от +5 °C до + 55 °C. Встроенный блок питания имеет мощность 250 Вт. Гарантия составляет два года. Поставки новинок начнутся в сентябре. Пока что на сайте производителя указана только стоимость старшей модели 6542AW, которая составляет $2300.

28.08.2024 [00:10], Владимир Мироненко

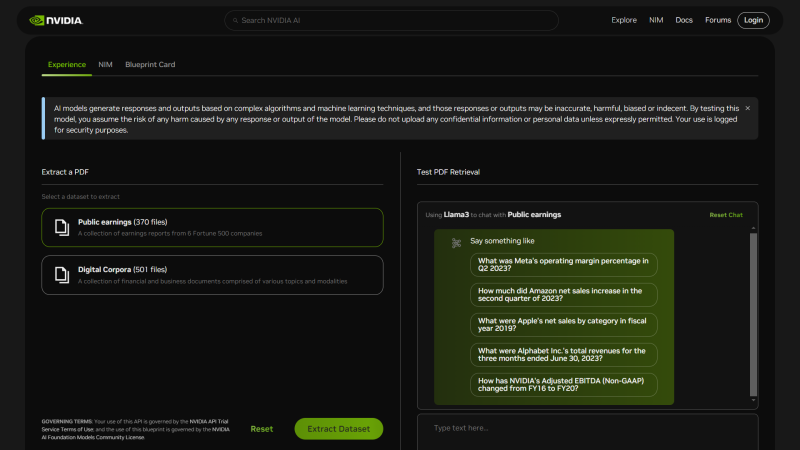

NVIDIA представила шаблоны ИИ-приложений NIM Agent Blueprints для типовых бизнес-задачNVIDIA анонсировала NIM Agent Blueprints, каталог предварительно обученных, настраиваемых программных решений, предоставляющий разработчикам набор инструментов для создания и развёртывания приложений генеративного ИИ для типовых вариантов использования, таких как аватары для обслуживания клиентов, RAG, виртуальный скрининг для разработки лекарственных препаратов и т.д. Предлагая бесплатные шаблоны для частых бизнес-задач, компания помогает разработчикам ускорить создание и вывод на рынок ИИ-приложений. NIM Agent Blueprints включает примеры приложений, созданных с помощью NVIDIA NeMo, NVIDIA NIM и микросервисов партнёров, примеры кода, документацию по настройке и Helm Chart'ы для быстрого развёртывания. Предприятия могут модифицировать NIM Agent Blueprints, используя свои бизнес-данные, и запускать приложения генеративного ИИ в ЦОД и облаках (в том числе в рамках NVIDIA AI Enterprise), постоянно совершенствуя их благодаря обратной связи. На текущий момент NIM Agent Blueprints предлагают готовые рабочие процессы (workflow) для систем обслуживания клиентов, для скрининга с целью автоматизированного поиска необходимых соединений при разработке лекарств и для мультимодального извлечения данных из PDF для RAG, что позволит обрабатывать огромные объёмы бизнес-данных для получения более точных ответов, благодаря чему ИИ-агенты чат-боты службы станут экспертами по темам компании. С примерами можно ознакомиться здесь. Каталог NVIDIA NIM Agent Blueprints вскоре станет доступен у глобальных системных интеграторов и поставщиков технологических решений, включая Accenture, Deloitte, SoftServe и World Wide Technology (WWT). А такие компании как Cisco, Dell, HPE и Lenovo предложат полнофункциональную ИИ-инфраструктуру с ускорителями NVIDIA для развёртывания NIM Agent Blueprints. NVIDIA пообещала, что ежемесячно будут выпускаться дополнительные шаблоны для различных бизнес-кейсов.

27.08.2024 [17:46], Руслан Авдеев

ИИ-ускорители Rebellions Rebel Quad получат 144 Гбайт памяти Samsung HBM3eЮжнокорейский стартап Rebellions представила на днях план развития своих ИИ-ускорителей. Как сообщает Business Korea, компания ускорит выпуск ИИ-чипов нового поколения, которые получат 4-нм модули памяти HBM3e производства Samsung. Samsung же будет отвечать за объединение чипов и HBM в одной упаковке. Изначально к концу 2024 года планировалось наладить выпуск продукта Rebel Single с одним модулем памяти, но потом было решено выпустить гораздо более производительный вариант Rebel Quad с четырьмя 12-слойными (12-Hi) модулями HBM3e суммарной ёмкостью 144 Гбайт, тоже к концу текущего года. Новинка придёт на смену ускорителю ATOM, который оснащён всего лишь 16 Гбайт GDDR6. Использование ёмкой и быстрой HBM3e-памяти считается одним из главных преимуществ Rebel Quad, по этому показателю новинки сравнимы с последними ускорители NVIDIA семейства Blackwell. При этом обещано, что новинки будут значительно энергоэффективнее решений NVIDIA и даже ускорителей Groq. Это по-прежнему серверные ускорители для обработки LLM вроде ChatGPT, но подойдут ли они для обучения ИИ-моделей, пока не уточняется. Сейчас Rebellions ориентируется на поставки комплексных ИИ-решений «стоечного уровня». В рамках концепуии Rebellion Scalable Design (RDS) будет предложены программно-аппаратные комплексы, которые позволят органично взаимодействовать многочисленным ускорителями и серверам с максимальной производительностью и энергоэффективностью. Речь идёт о решении, теоретически способном конкурировать с NVIDIA CUDA.

27.08.2024 [16:32], Сергей Карасёв

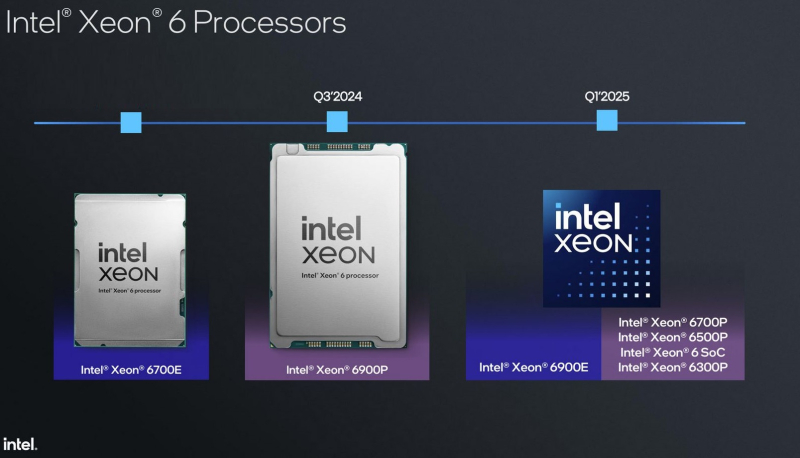

Xeon 6 на границе: Intel Granite Rapids-D получат поддержку PCIe 5.0, 2 × 100GbE, DDR5-5600 и MCR-DIMMКорпорация Intel раскрыла некоторые технические характеристики SoC Xeon 6 поколения Granite Rapids-D, предназначенных для периферийных решений (edge), в том числе на базе платформы Intel Tiber Edge. Изделия, использующие чиплетную компоновку, появятся на рынке в 2025 году. Процессоры базируются на производительных P-ядрах Redwood Cove. Каждое ядро получило по 64 Кбайт L1-кеша для инструкций и данных, а также L2-кеш объёмом 2 Мбайт. Конструкция SoC включает один или два вычислительных тайла, а также тайл ввода-вывода (I/O), отвечающий за реализацию PCIe, CXL и различных вспомогательных ускорителей. Вычислительные блоки производятся по техпроцессу Intel 3, IO-тайл — по техпроцессу Intel 4. Тайлы «сшиты» посредством EMIB. Xeon 6 Granite Rapids-D будут доступны в модификациях с поддержкой четырёх (2DPC) и восьми каналов памяти. Размеры BGA-упаковок — 77,5 × 50 мм и 77,5 × 56,5 мм соответственно. Говорится о поддержке DDR5-5600 м MCR-DIMM, 32 линий PCIe 5.0, 16 линий PCIe 4.0 и 16 линий CXL 2.0. Возможно использование до восьми Ethernet-портов 1/10/25GbE, до четырёх портов 50GbE или двух портов 100GbE. Ethernet-контроллер поддерживает классификацию пакетов и обработку ACL, предлагает различные планировщики и возможность программируемой обработки трафика. Возможности Intel QAT (Quick Assist Technology) тоже значительно расширены. Во-первых, теперь в состав QAT входит медиаускоритель для обработки потокового видео на лету: (де-)кодирования и транскодирования, масштабирования, обрезки кадра и т.д. Говорится как минимум о поддержка 1080p@30 для AVC/HEVC/AV1. Видеопоток при необходимости можно тут же направить к процессорным ядрам с AMX. Во-вторых, появилась возможность в один проход сжать и зашифровать данные с попутной проверкой их целостности. Чипы также получили поддержку Intel DLB (Dynamic Load Balancer), Intel vRAN Boost, Intel Data Streaming Accelerator (DSA), Intel SGX (Software Guard Extensions), Intel TDX (Trust Domain Extensions). Кроме того, были значительно расширены возможности функции Intel RDT (Resource Director Technology), которая теперь позволяет отслеживать и управлять состоянием IO-устройств, включая PCIe, CXL, интегрированных ускорителей и т.д. Встроенные ИИ-возможности обеспечивает более чем 8-кратный прирост быстродействия в Resnet-50 и более чем 6-кратное увеличение производительности в Visual Transformer по сравнению с Xeon D 2899NTN предыдущего поколения (с AVX512 VNNI) благодаря новым инструкциям AMX. Поддерживается работа в режиме FP16. Intel пока не раскрывает максимальное количество вычислительных ядер у Xeon 6 Granite Rapids-D. Но в ходе презентации был упомянут вариант с 42 ядрами, работающий в связке со 128 Гбайт памяти DDR5-5600/4800. Процессоры будут предлагаться в версиях, оптимизированных для вычислительных нагрузок и edge-приложений с ИИ-функциями.

27.08.2024 [14:11], Руслан Авдеев

Чтобы не было как с CrowdStrike: Microsoft соберёт ИБ-компании и обсудит дальнейшее развитие систем защиты WindowsКомпания Microsoft объявила о намерении провести специальную встречу Windows Security Summit, посвящённую недавнему глобальному сбою ОС Windows, связанному с багом в защитном ПО компании CrowdStrike. По данным Microsoft, на мероприятии 10 сентября будут обсуждаться меры по усилению кибербезопасности и защите критической инфраструктуры с партнёрами, включая CrowdStrike. Microsoft намерена разработать меры, предотвращающие повторение недавних событий — по имеющимся сведениям, пострадало не менее 8,5 млн компьютеров под управлением Windows, а ущерб составил миллиарды долларов. Особенно крупные претензии имеются у авиакомпании Delta Air Lines, работа которой была почти парализована. Помимо этой и других авиакомпаний, пострадали IT-системы медицинских организаций, железнодорожных компаний и других объектов критически важной инфраструктуры. Только ущерб компаний из рейтинга Fortune 500 составил порядка $5,4 млрд, не считая бизнесов помельче, прибегавших к отчаянным и необычным мерам для восстановления работоспособности.

Источник изображения: Majid Rangraz/unsplash.com Microsoft даст поставщикам решений для защиты конечных точек площадку для дискуссии по вопросу предотвращения подобных инцидентов в будущем. Будет обсуждаться создание более безопасных систем защиты — причиной катастрофы с ПО CrowdStrike стало то, что во время тестирования обновлений был пропущен баг. Microsoft винит в произошедшем евробюрократов, в своё время заставивших компанию предоставить сторонним разработчикам доступ к ядру операционной системы. По данным анонимного источника в Microsoft, участники встречи, вероятно, будут обсуждать возможность работы их приложений в первую очередь в пользовательском пространстве, имеющем меньше привилегий в сравнении с уровнем ядра. Microsoft пообещала рассказать о достигнутых решениях и договорённостях после завершения саммита.

27.08.2024 [12:08], Сергей Карасёв

Стартап FuriosaAI представил эффективный ИИ-ускоритель RNGD для LLM и мультимодальных моделейЮжнокорейский стартап FuriosaAI на мероприятии анонсировал специализированный чип RNGD (произносится как «Renegade»), который позиционируется в качестве альтернативы ускорителям NVIDIA. Новинка предназначена для работы с большими языковыми моделями (LLM) и мультимодальным ИИ. FuriosaAI основана в 2017 году тремя инженерами, ранее работавшими в AMD, Qualcomm и Samsung. Своё первое решение компания выпустила в 2021 году: чип Warboy представляет собой высокопроизводительный ЦОД-ускоритель, специально разработанный для рабочих нагрузок компьютерного зрения. Новое изделие RNGD, как утверждает FuriosaAI, является результатом многолетних инноваций. Чип изготавливается по 5-нм техпроцессу TSMC. ИИ-ускоритель на базе RNGD выполнен в виде карты расширения PCIe 5.0 x16. Он наделён 48 Гбайт памяти HBM3 с пропускной способностью до 1,5 Тбайт/с и 256 Мбайт памяти SRAM (384 Тбайт/с). Показатель TDP находится на уровне 150 Вт, что позволяет использовать устройство в системах с воздушным охлаждением. Для сравнения: у некоторых ускорителей на базе GPU величина TDP достигает 1000 Вт и более. Утверждается, что RNGD обеспечивает производительность до 512 Тфлопс в режиме FP8 и до 256 Тфлопс в режиме BF16. Быстродействие INT8/INT4 достигает 512/1024 TOPS. Карта позволяет эффективно запускать открытые LLM, такие как Llama 3.1 8B. Говорится, что один PCIe-ускоритель RNGD обеспечивает пропускную способность от 2000 до 3000 токенов в секунду (в зависимости от длины контекста) для моделей с примерно 10 млрд параметров. В системе можно объединить до восьми карт для работы с моделями, насчитывающими около 100 млрд параметров. RNGD основан на архитектуре свёртки тензора (Tensor Contraction Processor, TCP), которая, как отмечается, обеспечивает оптимальный баланс между эффективностью, программируемостью и производительностью. Программный стек состоит из компрессора моделей, сервисного фреймворка, среды выполнения, компилятора, профилировщика, отладчика и набора API для простоты программирования и развёртывания. Говорится, что чипы RNGD можно настроить для выполнения практически любой рабочей нагрузки LLM или мультимодального ИИ.

27.08.2024 [10:42], Сергей Карасёв

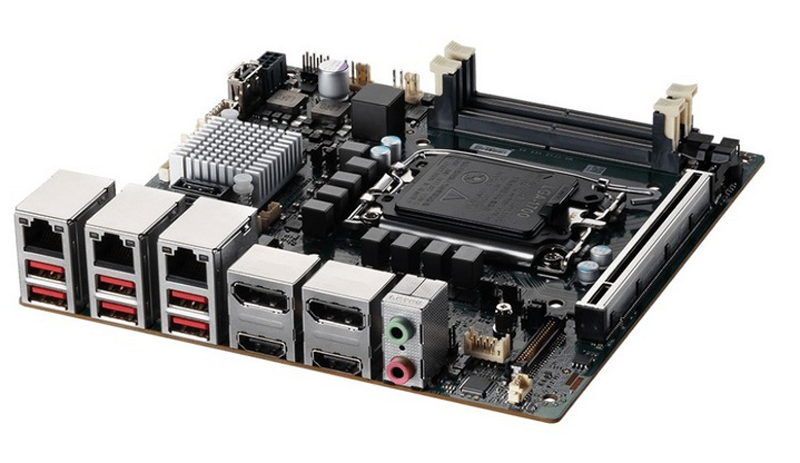

MSI представила плату MS-CF10 формата Mini-ITX для Intel Raptor Lake-S RefreshКомпания MSI анонсировала материнскую плату MS-CF10, предназначенную для создания систем промышленной автоматизации, платформ видеонаблюдения, медицинского оборудования, edge-устройств и пр. Новинка выполнена в формате Mini-ITX с размерами 170 × 170 мм. В зависимости от модификации применяется набор логики Intel R680E, Q670E или H610E. Во всех случаях возможна установка процессора Intel Raptor Lake-S Refresh в исполнении LGA 1700 с показателем TDP до 65 Вт. Имеются два слота SO-DIMM для модулей DDR5-5200 суммарным объёмом до 64 Гбайт. Плата располагает одним слотом PCIe 5.0 x16, коннектором M.2 M-key (PCIe x4; NVMe, SATA-3.0) для SSD формата 2242/2280, разъёмом M.2 E-key (PCIe x1; USB 2.0; CNVi) для адаптера Wi-Fi/Bluetooth (формат 2230) и коннектором М.2 B-key (PCIe x1; USB 3.2 Gen2; USB 2.0) для сотового модема (формат 3042 + слот для SIM-карты). Предусмотрены также два порта SATA 3.0 для накопителей с возможностью формирования массивов RAID 0/1/5 (только у версий на чипсетах Intel R680E и Q670E).

Источник изображения: MSI Все модификации платы оснащены тремя сетевыми портами 2.5GbE (контроллер Intel I226-LM и/или Intel I226-V), звуковым кодеком Realtek ALC897, контроллером ввода/вывода Fintek F81966D-I, чипом TPM 2.0. Возможен вывод изображения одновременно на четыре дисплея: LVDS с разрешением 1920 × 1200 точек @ 60 Гц, а также eDP, HDMI 2.0 и DP с разрешением 4096 × 2304 пикселя @ 60 Гц (во всех трёх случаях). Интерфейсный блок содержит шесть портов USB 3.2 Gen2, три гнезда RJ-45 для сетевых кабелей, аудиогнёзда на 3,5 мм, разъёмы HDMI и DP. Через коннекторы на плате можно задействовать четыре последовательных порта, два порта USB 3.2 Gen1 и три порта USB 2.0. Диапазон рабочих температур — от 0 до +60 °C. Заявлена совместимость с Windows 10 IoT Enterprise 2021 LTSC, Windows 11 IoT Enterprise LTSC и Linux.

27.08.2024 [09:02], Руслан Авдеев

На всё готовое: старые электростанции и промышленные объекты переделывают под ИИ ЦОДБум ИИ-систем привёл к тому, что технологические компании и их поставщики начали рассматривать в качестве места для размещения дата-центров старые электростанции и промышленные площадки. По данным Financial Times, гиперскейлеры вкладывают миллиарды долларов в строительство облачных объектов и ИИ ЦОД, но найти место с подходящей инфраструктурой и доступом к электроэнергии становится всё сложнее. По информации экспертов по недвижимости из Cushman & Wakefield, многие рынки ЦОД ограничены в доступе не только к электричеству, но и к земельным участкам. В ответ всё больше интереса проявляется к малым рынкам и «более сложным площадкам» вроде старых электростанций. В занимающейся недвижимостью группе JLL тоже отмечают, что застройщики больших кампусов ищут новые локации, включая «инфраструктурные площадки» или электростанции. Обычно на такие объекты заглядываются гиперскейлеры вроде Microsoft, Amazon и Google. В некоторых регионах США и Европы угольные станции или производственные площадки давно списаны, но по-прежнему обладают инфраструктурой, необходимой для ЦОД. Промышленные объекты обычно оснащены подходящими линиями электропередач и часто находятся возле источников воды. Так, Microsoft намерена построить ЦОД на территории старых электростанций Eggborough и Skelton Grange возле Лидса на севере Англии и кампус ЦОД в США на месте неудавшегося завода Foxconn. Amazon тоже намерена построить кампус на месте старой станции Birchwood в штате Вирджиния (США). По данным некоторых источников, как минимум одна сделка подобного же рода обсуждается сейчас и в Европе, а Великобритании компания намерена перестроить бывший завод Ford. А в Мадриде намерены превратить в крупный ЦОД бывший завод Coca Cola. Наконец, Nautilus предлагала превратить в дата-центр бывшую бумажную фабрику в штате Мэн. Эксперты предупреждают, что ограничения доступа к электричеству угрожает экспансии ИИ, а недостаток других элементов инфраструктуры вроде кабельных сетей дополнительно ограничивает возможности по поиску площадок для новых дата-центров. В результате растёт интерес к более необычным местам и объектам, поскольку для тренировки ИИ-моделей не слишком важна задержка сигнала. В этом случае смена профиля объектов может оказаться неплохим вариантом. Уже отмечена активность владельцев подобных строений, заинтересованных в превращении своей собственности в ЦОД. Например, Virtus Data Centres недавно приобрела две площадки в Берлине, часть территории ранее была солнечной электростанцией, а также старую фабрику боеприпасов в Великобритании, их планируется превратить в кампусы ЦОД к 2026 году. Недавно бывший завод приобрела в Джорджии (США) Equities Group — на площадке есть трансформаторы, вода, канализация и подведён газ. Тренд отражает и тенденции в майнинговой индустрии, где также происходит смена профиля старых объектов. Некоторые эксперты предупреждают, что подобное перепрофилирование может оказаться долгим, дорогим процессом с массой бюрократических препон и не всегда экономически целесообразным, особенно если объект уже отключен от всех энергетических линий и не обслуживается местными энергокомпаниями. Вернуть всё к работе довольно сложно. Специалисты по недвижимости из группы JLL сообщили, что многое зависит от специфики объекта, стоимости доработки, цен на землю и т.д. Исследователи RMI (Rocky Mountain Institute) и вовсе предлагают объединить электростанции на ископаемом топливе с ЦОД и источниками возобновляемой энергии. Избыток последней, который нельзя передать в энергосеть из-за внешних ограничений можно использовать на месте, например, для питания ЦОД и других объектов, потребляющих много энергии. А тратиться на строительство новых линий электропередач в этом случае не придётся.

26.08.2024 [22:30], Руслан Авдеев

«Сомнительный» 5G, дефицит кадров, импортозамещение, экосистемы и ИБ: печали и надежды российского телеком-рынка

5g

nexign

дефицит

ии

импортозамещение

информационная безопасность

кадры

россия

сети

телекоммуникации

Компания Nexign (Нэксайн) обнародовала результаты исследования, посвящённого телеком-рынку России. Как сообщает пресс-служба компании, участники рынка прогнозируют его рост в ближайшие пять лет благодаря экосистемным решениям, включающим телеком-услуги и партнёрские сервисы, а также сервисы ИБ и комплексные предложения для бизнеса. Рост поддержат ИИ-системы и инвестиции в микросервисную архитектуру. Компания опросила 31 топ-менеджера крупных операторов связи России, Беларуси, Узбекистана и Таджикистана. Опрос показал, что 57 % респондентов ожидают рост рынка связи на 5–10 %, а почти треть — более чем на 30 %. Драйверы роста вроде экосистемных предложений, технологий информационной безопасности и комплексные предложения для бизнеса (услуги связи, облачные сервисы, ИБ-сервисы, аналитика и реклама) рассматриваются как основные. При этом выручка в телеком-отрасли растёт как в России, так и во всё мире, в среднем на 15 % ежегодно. 73 % назвали главным вызовом отрасли дефицит кадров — не хватает высококвалифицированных специалистов в сфере IT и кибербезопасности, причём такая ситуация сохраняется не первый год. Для решения проблемы компании не только увеличивают зарплаты, но и автоматизируют всё больше задач с помощью ИИ. В тройке главных проблем и санкции (47 % опрошенных), а также нехватка телеком-оборудования с параллельным удорожанием (43 %). Импортозамещение довольно хорошо получается в системах биллинга, более половины опрошенных оценивают его довольно высоко, в том числе 7 % — на 10 баллов из 10 возможных. Замена ядра сети происходит не так гладко, 23 % и вовсе оценивают его в 1 балл по шкале от 0 до 10. Другими словами, в первую очередь компании стремились заместить самые востребованные системы, а теперь фокус сместился на более специализированные решения, требующие высокой квалификации и времени на разработку. Российские решения для ядра сети уже развивается. При этом опрошенные в основном не верят в возвращение иностранных вендоров, а 43 % из них считает, что при попытке вернуться их ждёт неудача, поскольку те «созреют» лишь к тому времени, когда рынок будет занять отечественными альтернативами. В Nexign подчёркивают, что в сегменте ядра сети большинство операторов по-прежнему используют комплексные решения Huawei и Oracle, но ситуация будет меняться «в ближайшее время». Ключевыми технологиями, которые окажут самое сильное влияние на IT-стратегию телеком-компаний в ближайшую пятилетку, опрошенные назвали «традиционные» ИИ-системы (в т.ч. машинное обучение и предиктивную аналитику), генеративный ИИ и микросервисуню архитектуру. При этом популярная в мире технология OpenRAN в России пока не вызывает особенного интереса. Нет и 5G в числе ключевых драйверов отечественного рынка на ближайшие годы. Кроме того, хотя 43 % респондентов уверены в том, что старт 5G в стране станет новым источником выручки, 30 % в этом сомневаются. |

|