Лента новостей

|

11.02.2025 [11:35], Сергей Карасёв

QNAP представила стоечное хранилище TS-h765eU с поддержкой накопителей LFF, SFF, E1.S и М.2Компания QNAP Systems анонсировала гибридное стоечное хранилище TS-h765eU в форм-факторе 1U. Устройство выполнено в корпусе уменьшенной глубины, которая составляет 292,1 мм: благодаря этому новинка подходит для применения в помещениях с ограниченным пространством, например, в комнатах видеонаблюдения или небольших офисах. В основу положен процессор Intel Atom x7405C поколения Amston Lake с четырьмя ядрами (до 3,4 ГГц) и показателем TDP в 12 Вт. Объём оперативной памяти DDR5 в базовой конфигурации составляет 8 Гбайт (один слот SO-DIMM) с возможностью расширения до 16 Гбайт. Во фронтальной части NAS расположены четыре отсека для HDD или SSD типоразмера LFF или SFF с интерфейсом SATA-3. В тыльной области находятся три слота для накопителей E1.S NVMe PCIe SSD толщиной 5,9/9,5/15 мм: благодаря специальным адаптерам можно также устанавливать модули M.2 2280 NVMe PCIe SSD. Хранилище располагает двумя сетевыми портами 2.5GbE RJ-45. При необходимости могут быть добавлены два адаптера QXG-ES10G1T (монтируются в слоты E1.S) с портом 10GbE. Устройство получило по одному разъёму USB 3.2 Gen 1 и USB 2.0. Габариты составляют 43 × 430 × 292,1 мм, вес — 4,51 кг. За охлаждение отвечают три вентилятора диаметром 40 мм. Диапазон рабочих температур — от 0 до +40 °C. В качестве программной платформы применяется ОС QuTS hero h5.2.3. Задействована высоконадёжная файловая система ZFS для обеспечения максимальной целостности данных и стабильности. Доступны гибкие средства для резервного копирования, синхронизации и восстановления информации.

11.02.2025 [08:52], Руслан Авдеев

Telia отправила на переработку 70 тонн телеком-оборудования после апгрейда норвежской сети до 5GТелеком-компания Telia отправила в переработку 70 т списанного оборудования после модернизации мобильных сетей Норвегии до уровня 5G, причём часть компонентов после проверки и оценки снова заработало в сетях Telia. За собственно переработку отвечала компания TXO, которая занимается новым и б/у телеком-оборудованием. На утилизацию были отправлены всевозможные сетевые модули, в том числе серверные шкафы, печатные платы, антенны, приёмопередающее оборудование и кабели, а также другие компоненты базовых станций — всего 12 805 компонентов. Из них 622 компонента вернулись в сети Telia, 1723 были перепроданы в 35 стран, а более 8000 — переработаны. TXO использует для оценки компонентов фирменную систему i-JUDGE, которая и даёт возможность определить, что можно перепродать, что использовать повторно, а что годится только на переработку. По словам представителя Telia Norway, в связи с модернизацией мобильной связи скопилось большое количество телеком-оборудования, которое компания желает переработать максимально «экологично». Целью является достижение нулевого уровня отходов к 2030 году. Поэтому переработке и повторному использованию и переработке оборудования отдаётся приоритет со всех действиях компании, в том числе при модернизации мобильных сетей. Подробности о финансовых аспектах сделки не раскрываются, но в январском отчёте TXO, говорится, что только в 2025 году мировые телеком-компании получат до $720 млн от продажи устаревших медных кабелей, а в следующие 15 лет они смогут заработать на них более $10 млрд. Так, BT уже выручила £105 млн (около $140 млн) от продажи таких кабелей в рамках замены старых сетей на ВОЛС, а Sparkle и OEC заявили, что переработают 22 тыс. км подводных кабелей.

10.02.2025 [22:59], Владимир Мироненко

Макрон объявил о французском ответе на американский ИИ-мегапроект Stargate с инвестициями на €109 млрдВ понедельник во Франции стартовал саммит, посвящённый ИИ — AI Action Summit. В преддверии мероприятия президент Франции Эммануэль Макрон (Emmanuel Macron) объявил о том, что объём частных инвестиций в развитие технологий ИИ в стране в ближайшие годы составит порядка €109 млрд. По словам Макрона, для Франции эта сумма, которую выделят компании из ОАЭ, США, Канады и Франции, эквивалентна затратам США в $500 млрд на развитие ИИ в рамках СП Stargate. По всей видимости он исходил из того, что численность населения Франции в пять раз меньше, чему у США. Сравнение со Stargate вызвано и тем, что, как и в американском проекте, большая часть инвестиций будет направлена на развёртывание ЦОД для работы с ИИ. Согласно данным TechCrunch, по состоянию на воскресенье было известно о примерно €83 млрд частных инвестиций в ИИ-проекты во Франции. В частности, €30–50 млрд поступит от ОАЭ при участии фонда MGX, €3 млрд — от французской телекоммуникационной компании Iliad, €10 млрд — от государственного инвестиционного банка Франции Bpifrance и €20 млрд — от канадской компании Brookfield. Как сообщает Data Center Dynamics, большая часть этой суммы — €15 млрд — будет предоставлена Brookfield своему подразделению Data4 для дальнейшего развёртывания сети ЦОД. Data4 ранее планировала увеличить мощность своих ЦОД во Франции с 375 МВт до 500 МВт, но теперь речь идёт о ещё 1 ГВт в течение следующих пяти лет. Остальная часть суммы будет направлена на улучшение инфраструктуры передачи данных, покупку оборудования и финансирование энергетических проектов. Data4 в настоящее время управляет примерно 30 ЦОД во Франции, Италии, Испании, Польше и Люксембурге. В Париже у неё три кампуса, в которых размещено 30 объектов общей мощностью 375 МВт. В своём выступлении Макрон также упомянул в качестве инвесторов программы французские компании Orange и Thales, которые пока не раскрыли объём планируемых инвестиций. Большая часть электроэнергии во Франции производится АЭС, причём больше, чем требуется стране. В понедельник французское правительство и компания Fluidstack подписали меморандум о взаимопонимании с целью строительства гигаваттного ИИ-кластера к концу 2026 года, который будет работать на «чистой» ядерной энергии, с возможностью увеличения мощности к 2028 году. На первом этапе — к 2026 году — кластер будет включать 500 тыс. ИИ-ускорителей следующего поколения. Ожидается, что специально созданный для обучения передовых моделей суперкомпьютер сделает Францию мировым центром ИИ. Также в понедельник было объявлено о партнёрстве технологической компании G42 из ОАЭ с DataOne с целью осуществления инвестиций инфраструктуру Франции. Компании планируют построить в Гренобле современный ИИ ЦОД с использованием ускорителей AMD Instinct. Ожидается, что объект будет полностью введён в эксплуатацию к середине 2025 года. Франция считает, что благодаря потенциалу своей ядерной энергетики она находится в выгодном положении для создания энергоёмких ЦОД. Поскольку Европа владеет всего 3–5 % мировой вычислительной мощности, Макрон выразил надежду в интервью CNN, что это «откроет двери» в будущее для ИИ в Европе. По его словам, этот фактор позволит построить во Франции 20 % всех ЦОД в мире. Великобритания также рассчитывает, что АЭС помогут ей стать ИИ-сверхдержавой. Впрочем, пока что анонсированные инвестиции в ИИ ЦОД здесь практически на порядок меньше.

10.02.2025 [19:33], Сергей Карасёв

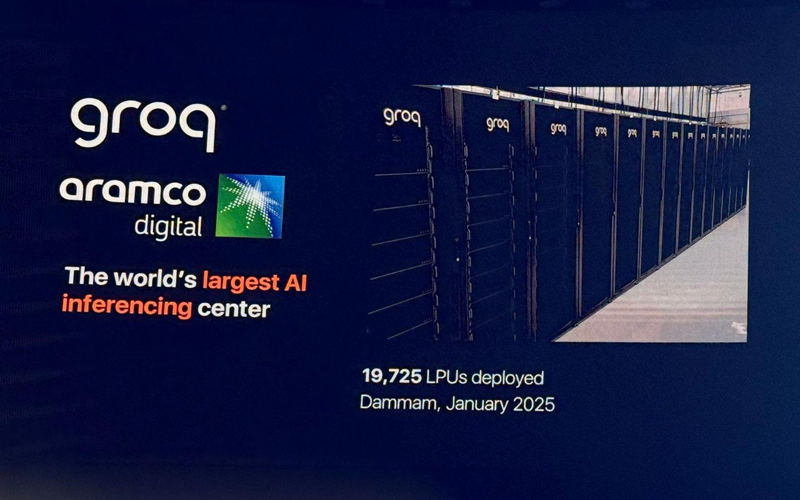

Groq развернула в Саудовской Аравии почти 20 тыс. ИИ-ускорителей LPUКомпании Groq и Aramco Digital объявили об открытии крупнейшего в Европе, на Ближнем Востоке и в Африке (EMEA) вычислительного ИИ-центра, ориентированного на задачи инференса. Площадка располагается в Даммаме в Саудовской Аравии. Groq занимается разработкой ускорителей LPU (Language Processing Unit) для работы с большими языковыми моделями (LLM). Утверждается, что они могут успешно конкурировать с ИИ-ускорителями NVIDIA, AMD и Intel. Aramco Digital, подразделение нефтегазового и химического гиганта Aramco, и Groq сообщили о намерении создать в Саудовской Аравии крупнейший в мире центр по развитию ИИ в марте 2024 года. Тогда говорилось, что Aramco Digital будет сдавать мощности Groq LPU в аренду клиентам на Ближнем Востоке. Предполагается также, что партнёрство с Groq поможет Aramco Digital вывести на рынок управляемую голосом ИИ-модель Norous.

Источник изображения: Twitter/@sundeep Как теперь сообщается, на базе нового ИИ-центра заработал облачный регион GrogCloud, включающий 19 725 LPU. Инвестиции в проект составили $1,5 млрд — совместно от Groq и Aramco Digital. Джонатан Росс (Jonathan Ross), генеральный директор Groq, сообщил, что к концу I квартала 2025 года компания развернёт сможет генерировать не менее 25 млн токенов в секунду. В перспективе планируется повышение данного показателя вплоть до 1 млрд токенов в секунду. С момента запуска GroqCloud в марте 2024 года более 800 тыс. разработчиков по всему миру начали использовать эту платформу на базе LPU Inference Engine через программный интерфейс Groq API. Облако, как утверждается, обеспечивает инференс в реальном времени с меньшей задержкой и большей пропускной способностью, чем у конкурентов. GroqCloud подходит для генеративных и разговорных приложений ИИ. В целом, Groq создаёт высокопроизводительную инфраструктуру ИИ, предназначенную для обслуживания более 4 млрд человек в Саудовской Аравии, на Ближнем Востоке, в Африке и за пределами этого региона. Сделка с Groq является частью крупномасштабного плана Vision-2030, предполагающего переход Саудовской Аравии к инновационной экономике на базе ИИ, которая призвана снизить зависимость страны от добычи нефти и газа.

10.02.2025 [18:33], Руслан Авдеев

Cloud.ru заморозит цены на облака для новых клиентов на три годаПровайдер облачных сервисов и ИИ-технологий Cloud.ru объявил о заморозке цен на пользование облачными услугами. Предложение действительно для новых клиентов — они смогут пользоваться сервисами по фиксированным ценам в течение трёх лет, сообщает пресс-служба компании. Предполагается, что такой подход поможет вести долгосрочное планирование IT-бюджета и эффективно развивать цифровые сегменты бизнеса. Заморозка цен коснётся виртуальных машин, в том числе с GPU, объектных хранилищ, баз данных, а также иных облачных сервисов. Cloud.ru располагает более 100 IaaS- и PaaS-сервисов, ML-платформой на базе суперкомпьютеров и публичным облаком Cloud․ru Evolution на основе собственных разработок и open source. В компании подчёркивают, что использование облачных решений позволит бизнесу быстро запускать новые услуги и цифровые продукты, а также масштабировать нагрузки. По словам коммерческого директора Cloud.ru, компания помогает бизнесам сохранить контроль над IT-инфраструктурой даже под влиянием внешних макроэкономических факторов. В ответ на рост цен на рынке облачных услуг компания предлагает зафиксировать стоимость ряда сервисов — это позволит бизнесу даже в долгосрочной перспективе сохранить предсказуемость затрат на информационные технологии. Специальное предложение действует для новых клиентов, включая как юридических лиц, так и индивидуальных предпринимателей. Для того, чтобы воспользоваться им, необходимо оставить заявку на подключение сервисов Cloud.ru до 31 марта 2025 года. По предварительным оценкам iKS-Consulting, в 2024 году рынок облачных услуг в России вырос на треть, до 165,6 млрд руб. По доле выручки Cloud.ru занимает на нём первое место (IaaS+PaaS).

10.02.2025 [16:05], Руслан Авдеев

Nokia возглавит вице-президент Intel, ответственный за ИИ и ЦОДНовым генеральным директором Nokia 1 апреля 2025 года станет Джастин Хотард (Justin Hotard), исполнительный вице-президент Intel и глава направления DCAI. Компания надеется, что он усилит её позиции в области решений для ИИ ЦОД. Хотард придётся на смену Пекка Лундмарку (Pekka Lundmark), возглавлявшего Nokia с 2020 года. Лундмарк останется консультантом компании до конца 2025 года, а потом покинет её. Ранее Nokia приняла решение диверсифицировать бизнес и найти новые направления роста за пределами традиционной сферы, связанной с телекоммуникационными продуктами для операторов связи. В прошлом году Nokia купила за $2,3 млрд поставщика сетевых решений Infinera, а также избавилась от непрофильного актива Alcatel Submarine Networks (ASN) и вышла из совместного с Huawei предприятия TD Tech. Сейчас компания делает ставку на бизнес, связанный с дата-центрами. В Nokia заявляли, что ЦОД станут драйверами её роста в ближайшие годы, но совсем отказываться от традиционных телекоммуникационных решений компания не намерена. Компания подписала крупное соглашение по обновлению сетевой инфраструктуры ЦОД Microsoft и присоединилась к консорциуму Ultra Ethernet. При этом заниматься развитием собственного облака Nokia не будет. У Хотарда более 25 лет опыта работы на руководящих должностях в крупных технологических компаниях, в т.ч. Symbol Technologies, Motorola, HPE и NCR Corporation, однако в Intel он пришёл только в 2024 году. Ранее Intel покинул главный архитектор Intel Xeon Сайлеша Коттапалли (Sailesh Kottapalli), который присоединился к Qualcomm для работы над серверными Arm-процессорами.

10.02.2025 [14:56], Андрей Крупин

Релиз «Альт Сервер» 10.4: новые инструменты для администраторов и улучшенный контроллер доменовКомпания «Базальт СПО» сообщила о выпуске обновлённой версии операционной системы «Альт Сервер» с программным комплексом «Альт Домен» 10.4. «Альт Сервер» представляет собой комплексное решение на базе Linux с широкой функциональностью, позволяющее разворачивать и поддерживать корпоративную IT-инфраструктуру предприятий, а также использовать разнообразное периферийное оборудование. Платформа зарегистрирована в реестре российского ПО, интегрирована с контроллером доменов «Альт Домен» (Samba DC и FreeIPA), совместима с экосистемой программных продуктов отечественных разработчиков и содержит необходимый инструментарий для запуска и настройки служб и сервисов в сети организации. Дистрибутив выпускается в нескольких вариантах исполнения для процессорных архитектур x86_64, aarch64 и «Эльбрус».

Источник изображения: basealt.ru/alt-server Релиз «Альт Сервер» 10.4 получил обновлённые версии ядер (5.10.233 и 6.1.124 — доступны для выбора в загрузчике), доработанный программный комплекс «Альт Домен» с расширенными функциональными возможностями, поддержкой версий групповых политик и обновлёнными модулями. Также сообщается о включении в состав дистрибутива новых инструментов для администраторов, включая контроль подключения USB-устройств, исправлении уязвимостей в коде ОС, устранении проблем с отображением интерфейса установщика на 4K-мониторах и установкой платформы на NVMe-диски с секторами 4K в режиме UEFI. Отдельное внимание было уделено повышению стабильности и надёжности работы системы. Ознакомиться с подробной информацией об операционной системе «Альт Сервер» можно в документации на сайте «Базальт СПО».

10.02.2025 [14:40], Руслан Авдеев

Сервер в каждый дом: British Gas и Heata протестируют в Великобритании индивидуальные «цифровые котлы»Компания British Gas заключила соглашение с Heata, в рамках которого в Великобритании в тестовом режиме будет развёрнута облачная платформа с серверами, размещёнными в жилых домах. Каждый сервер подключен к системе домашнего отопления, аккумулирующей тепло в ходе работы сервера. Каждый сервер может отдать до 4 кВт∙ч в день, что в теории позволит сэкономить на счетах за газ или электричество до £340/год. Электричество, потребляемое сервером, оплачивается самой Heata. Испытания будут проводить три месяца, на этот период в домах сотрудников British Gas установят 10 «цифровых бойлеров», ресурсы которых будут сдаваться в аренду клиентам Heata. Компании намерены делиться идеями и знаниями, чтобы сделать технологию массовой. Ранее Heata сотрудничала с Civo в рамках схожей пилотной программы, предусматривавшей отопление домов в Великобритании в 2023 году. Есть и другие аналогичные проекты. Так, Deep Green использует GPU-серверы для подогрева бассейнов в Эксмуте и Йоркшире. Civo тоже является партнёром Deep Green. В 2022 году Qarnot порадовала заказчиков новым поколением отопительных устройств QB, созданных совместно с ITRenew. Эти системы используют OCP-серверы, ранее работавшие в дата-центрах гиперскейлеров. Позже компания в качестве эксперимента использовала серверы для приготовления пищи. Возможно, подход с размещением вычислительных мощностей в непосредственной близости от потребителей тепла окажется эффективнее, чем попытки подключения ЦОД к системам центрального отопления.

10.02.2025 [13:16], Андрей Крупин

«Ростех» представил решение для защиты объектов КИИ от программ-шифровальщиковКомпания «РТ-Информационная безопасность» (дочерняя структура госкорпорации «Ростех») представила решение «Антишифр» для противодействия атакам программ-шифровальщиков, блокирующих доступ к данным и требующих выплаты определённой суммы киберпреступникам для возвращения доступа к ценной информации. Новая разработка включена в состав созданной компанией «РТ-Информационная безопасность» защитной платформы RT Protect EDR. Благодаря интеграции с ядром операционной системы Windows на уровне драйвера «Антишифр» позволяет осуществлять анализ всех выполняемых процессов в режиме реального времени и выполнять блокирование вредоносных операций на этапе попытки их исполнения программами-шифровальщиками.

Источник изображения: «РТ-Информационная безопасность» / rt-ib.ru Новый модуль обеспечивает автоматическое принудительное завершение как отдельных вредоносных программ, функционирующих самостоятельно, так и групп приложений, работающих совместно. Кроме того, «Антишифр» проводит автоматическое сохранение важных файлов при попытке их модификации/удаления в локальное защищённое хранилище. Резервирование действует параллельно с другими защитными механизмами, благодаря чему можно восстановить важные файлы после отражения кибератаки. «Организации «Ростеха» задействованы в важнейших технологических проектах России. Практически все наши предприятия — объекты критической информационной инфраструктуры. Программы-шифровальщики представляют огромную опасность для таких компаний. Удачная кибератака может нанести удар не просто по бизнесу, принеся многомиллионные убытки, но даже по национальной безопасности. Статистика говорит, что большинство кибератак в РФ в настоящее время политически мотивированы. Их цель — не получение финансовой выгоды, например выкупа за похищенные данные, а шпионаж и диверсии. «Антишифр» усилит защиту отечественных предприятий от подобных действий», — прокомментировали выпуск нового решения в «Ростехе».

10.02.2025 [13:12], Руслан Авдеев

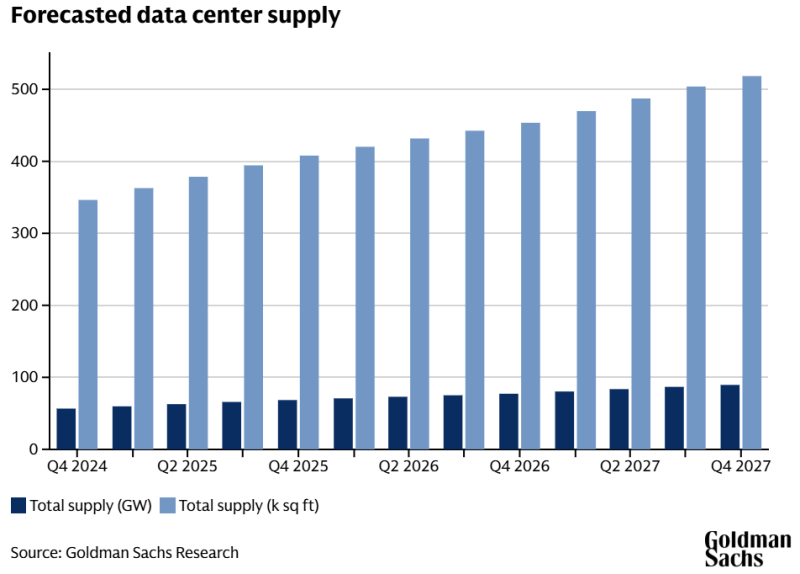

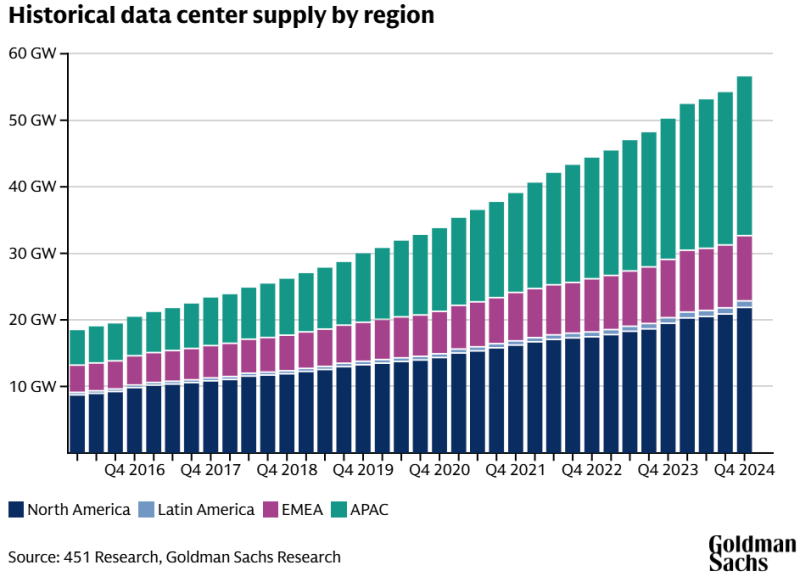

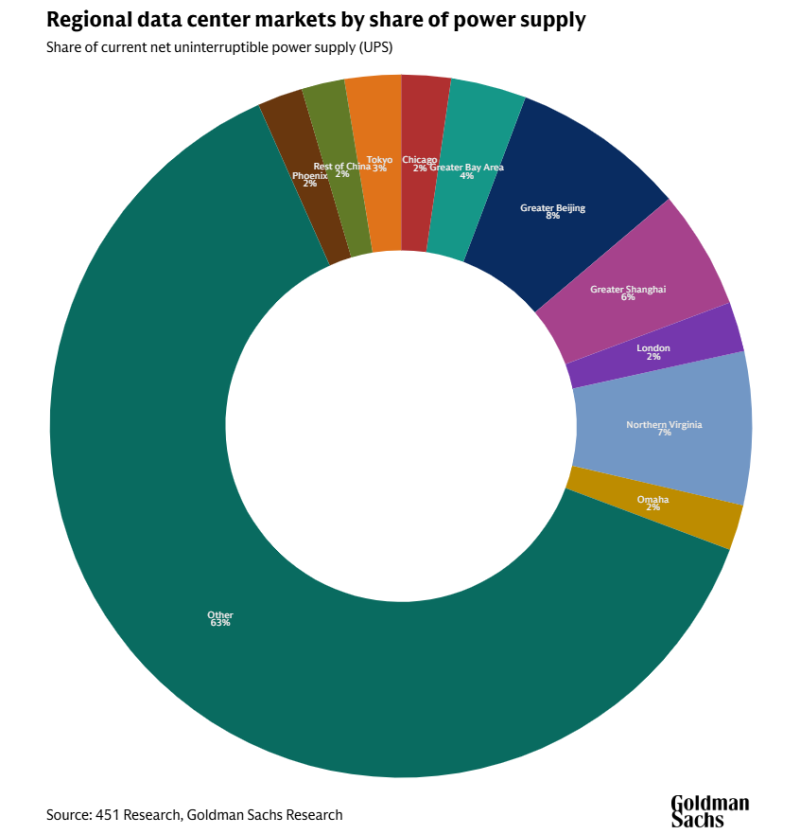

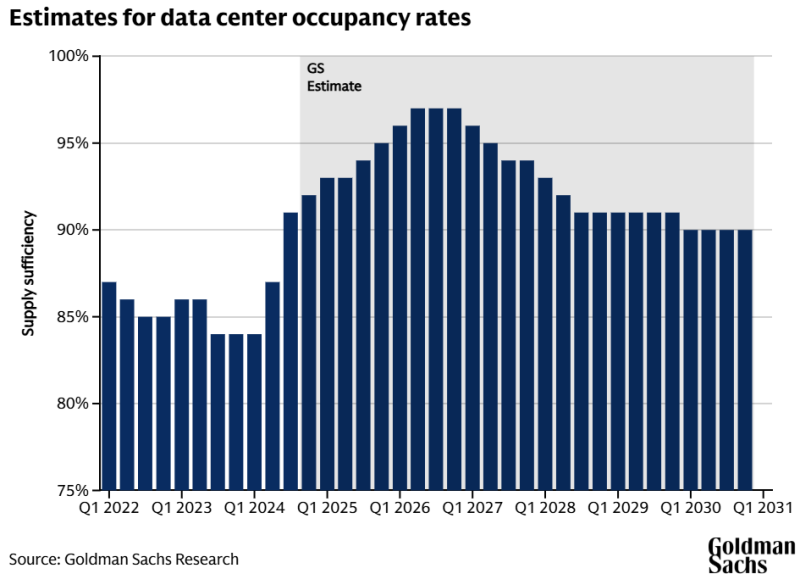

Ненасытный ИИ: энергопотребление ЦОД к 2030 году вырастет более чем вдвоеПо последним прогнозам инвестиционных банкиров Goldman Sachs, потребность ИИ в электричестве приведёт к тому, что всего через пять лет потребление энергии дата-центрами увеличится более чем вдвое. По оценкам финансистов, сегодня индустрия ЦОД в мире потребляет около 55 ГВт. Более половины (54 %) приходится на нагрузки при облачных вычислениях, на традиционные сервисы вроде серверов e-mail и хранилищ данных — ещё 32 %, а на ИИ — 14 %. Моделирование будущего спроса позволяет предположить, что уже к 2027 году он вырастет до 84 ГВт, а доля ИИ составит 27 %. На облачные нагрузки придётся около 50 %, а на традиционные нагрузки — 23 %. Если прогнозы верны, всего за пару лет потребление в энергии взлетит на 59 % и тенденция, вероятно, сохранится и в будущем. К концу 2030 года общая мощность ЦОД должна составить уже 122 ГВт — рост в 165 % в сравнении с 2023 годом. Капитальные затраты Amazon, в основном связанные с AWS, в 2025 году должны составить $100 млрд. Microsoft намерена потратить на инфраструктуру $80 млрд, Google — $75 млрд, а Meta✴ — до $65 млрд. Столь значительные средства преимущественно пойдут на развитие именно ИИ-инфраструктуры. В результате инвестиции потребуются и энергосетям, на модернизацию которых до 2030 года может потребоваться до $720 млрд — немало, но в противном случае нехватка энергии может затормозить развитие ЦОД в ряде регионов. В Goldman Sachs предупреждают, что на модернизацию ЛЭП может уйти несколько лет, что может стать «узким местом» для рынка ЦОД, если регионы не проявят достаточной инициативы. В прошлом году аналитики Bain & Co предупреждали о том, что рост энергопотребления в США способен превысить предложение буквально за пару лет, если энергетические компании не примут мер для наращивания мощностей по производству и распределению электричества. Также сообщалось, что к 2030 году американцы могут столкнуться с ростом счетов за электричество на 70 % — если необходимые меры не принять. В Goldman Sachs, рассчитывают, что в ближайшем будущем баланс спроса и предложения в отрасли ЦОД «ужесточится», а загруженность инфраструктуры ЦОД, составлявшая 85 % в 2023 году, уже в конце 2026 года превысит 95 %. В 2027 году должно начаться замедление темпов роста загруженности благодаря вводу в эксплуатацию новой инфраструктуры. Впрочем, это предположение основано на гипотезе исследователей, предполагающей, что более эффективные ИИ-модели несколько снизят потребность в инфраструктуре. В долгосрочной перспективе, если повышение эффективности приведёт к снижению уровня капитальных затрат, рынок дата-центров станет более устойчивым и будет меньше подвержен циклическим колебаниям. Будучи финансовой компанией, Goldman Sachs заинтересована как в открывающихся инвестиционных возможностях, так и в том, чтобы предупредить о возможном кризисе. Отмечается, что в выигрыше от роста спроса на ИИ окажутся крупные операторы ЦОД, обслуживающие гиперскейлеров и крупных корпоративных клиентов. В прошлом году сообщалось, что аналитики Goldman Sachs не уверены в будущем ИИ, поскольку на него тратится слишком много средств, а польза не вполне очевидна. |

|