Материалы по тегу: hpe

|

29.01.2022 [01:26], Владимир Мироненко

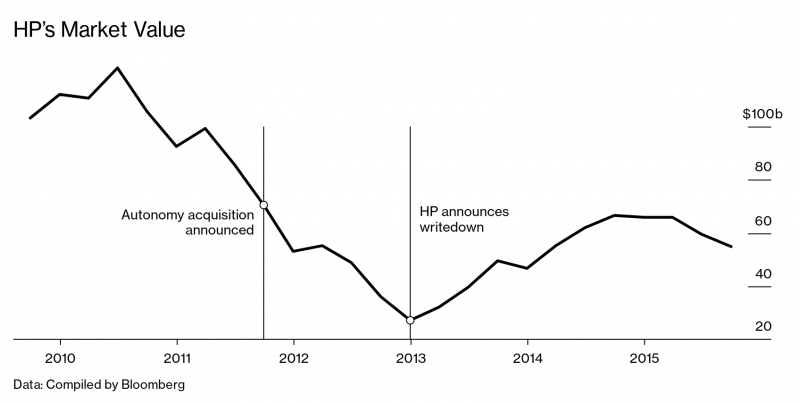

Майк Линч проиграл судебную тяжбу с HP на $5 млрд из-за AutonomyСтало известно, что компания Hewlett Packard (теперь уже HPE) выиграла многомиллиардный иск против британского предпринимателя Майка Линча (Mike Lynch). Девятимесячный судебный процесс, который обошёлся в £40 млн, был одним из самых продолжительных и дорогостоящих в современной британской истории. HP приобрела в 2011 году крупнейшую британскую софтверную компанию Autonomy, основанную Линчем, за $11 млрд, т.е. переплатив почти ⅔ от стоимости акций компании на момент сделки. А год спустя HP была вынуждена списать в убытки активы Autonomy в размере $8,8 млрд, отправив до этого инициатора покупки гендиректора Лео Апотекера (Leo Apotheker) в отставку. HP обвинила Майка Линча в мошенничестве, утверждая, что он и финансовый директор Сушован Хуссейн (Sushovan Hussain) искусственно завышали заявленные доходы Autonomy, показатели роста доходов и валовую прибыль. HP утверждала, что ответчики искажали отчётность с помощью непрофильных продаж, фиктивных транзакций и махинаций с бухгалтерской отчётностью. Иск против Линча и Хуссейна был подан в 2015 году. Хуссейн в 2019 году уже был приговорен в США к 5 годам заключения.

Источник: Bloomberg Quint Судья Роберт Хилдъярд (Robert Hildyard) зачитал в пятницу решение суда, в котором отметил, что HP «склонили к покупке» Autonomy. Он сообщил, что продажа аппаратного обеспечения «позволила Autonomy покрыть недостающие доходы от продаж ПО», и это пришлось скрыть от рынка, чтобы получить одобрение сделки. «Намерения были нечестными — подсудимые прекрасно знали об этом», — подчеркнул судья. Судья также отметил, что сумма компенсации может быть существенно меньше $5 млрд, указанных в иске HP. Адвокат Майка Линча, Келвин Николлс (Kelwin Nicholls) из Clifford Chance заявил, что его клиент намерен подать апелляцию, и назвал результаты слушаний «разочаровывающими». Сегодня же министром внутренних дел Великобритании была одобрена экстрадиции Линча в США, где он предстанет перед американским судом по ещё 17 обвинениям. Сейчас Линч совместно с супругой владеет 16 % компании DarkTrace, капитализация которой составляет около $3,6 млрд.

04.10.2021 [10:00], Алексей Степин

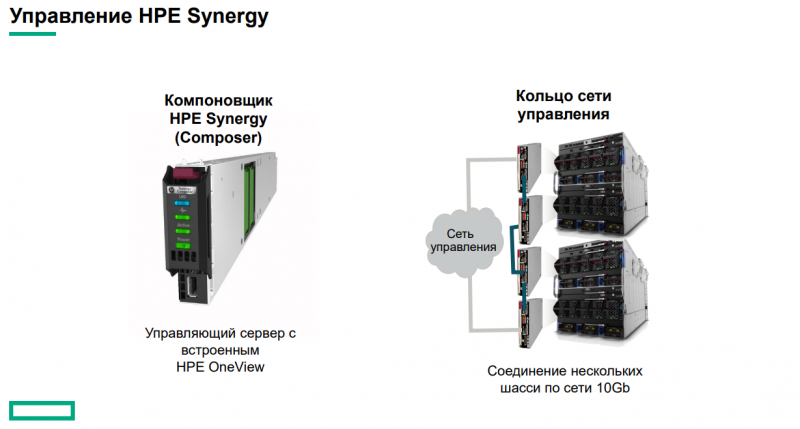

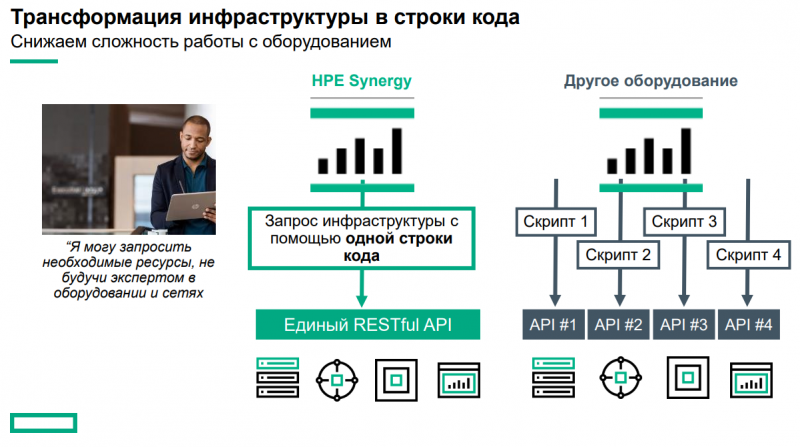

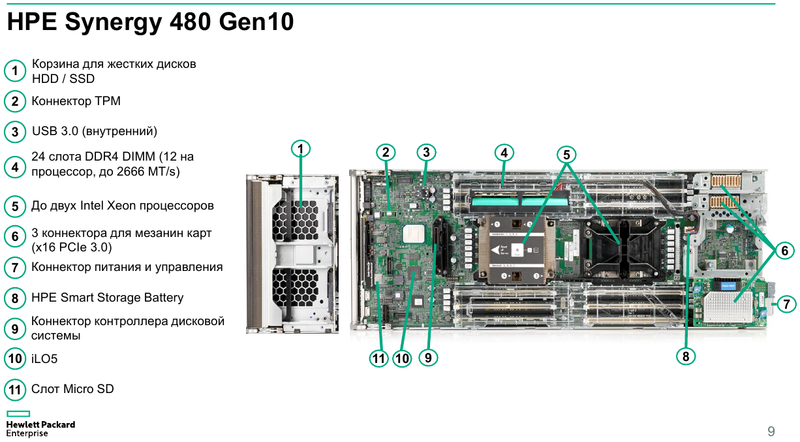

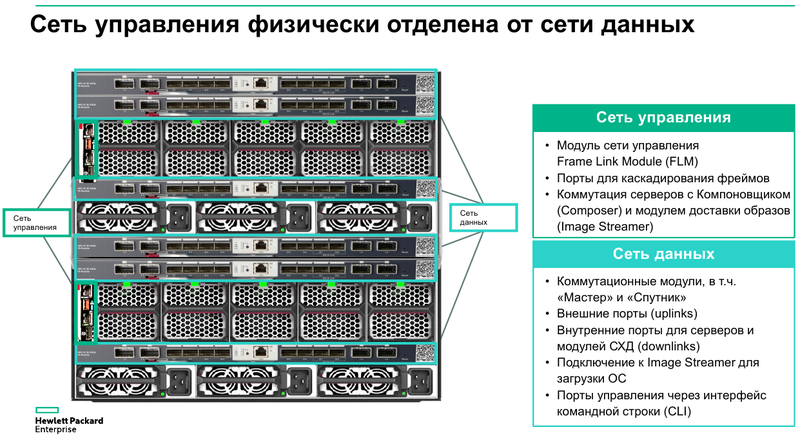

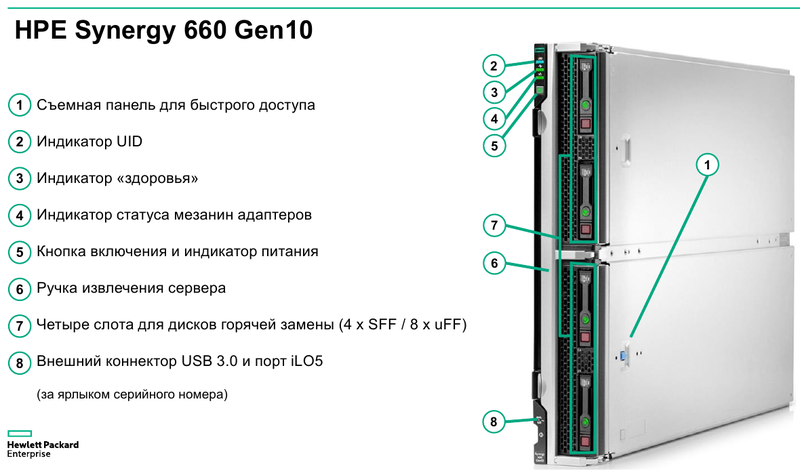

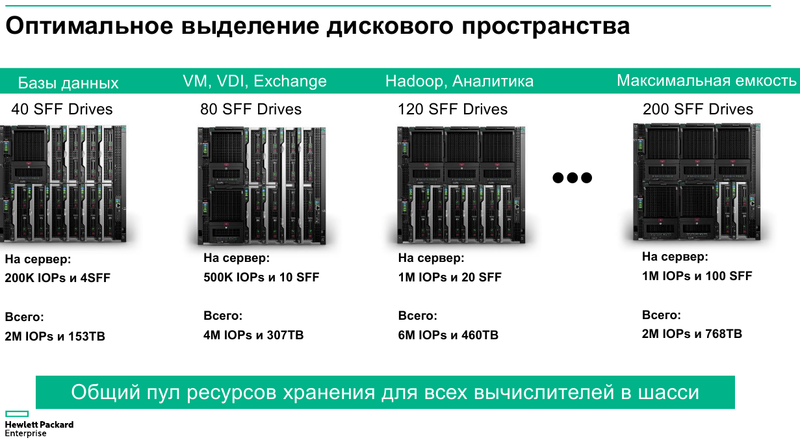

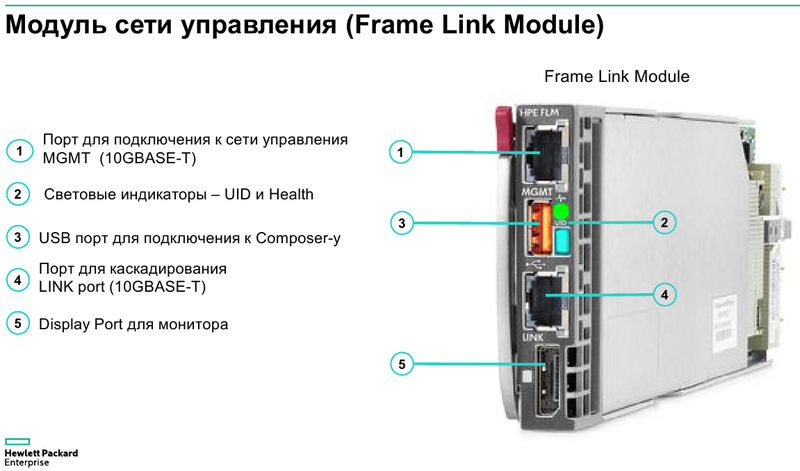

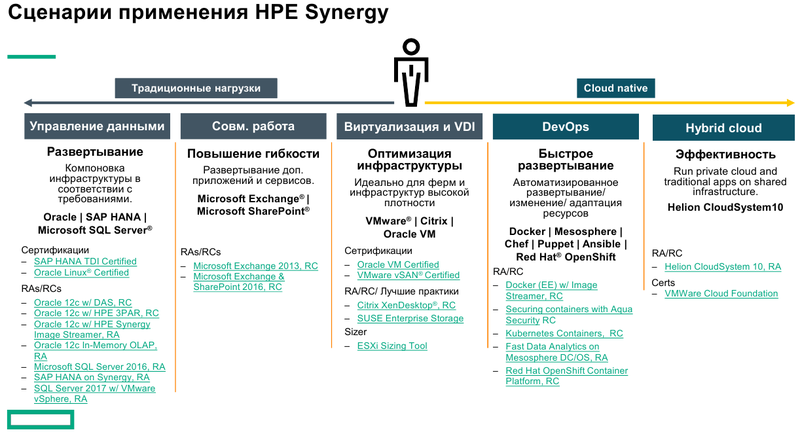

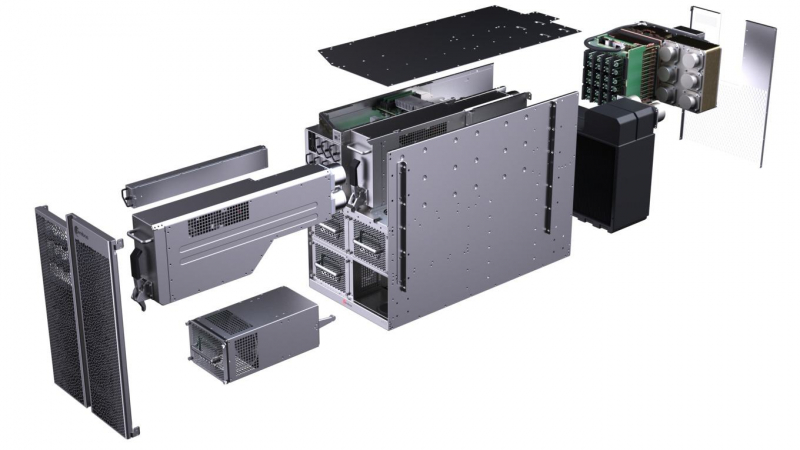

HPE Synergy 12000 как гимн модульности: новая единая ИТ-инфраструктура для любых задачСинергия — эффект совместного действия двух и более факторов, превышающий простую сумму их действий. Слово это пришло к нам из древнегреческого, где означало «единое дело». Но в обычных ЦОД «старой школы» она проявляется далеко не всегда, и расширение, переконфигурирование или смена задачи может стать долгим, затратным предприятием. К тому же в облачную эпоху каждый час простоя инфраструктуры может обернуться серьёзными убытками. Создавая Synergy, HPE позаботилась о том, чтобы максимально унифицировать новую ЦОД-платформу, способную справиться с любым приложением. В основу легла модульно-лезвийная (blade) компоновка, компания называет её «компонуемой». Такая инфраструктура Synergy — это шаг вперёд от обычных гиперконвергентных систем в сторону большей оптимизации и аппаратных, и программных средств.  Единая структура Synergy одинаково хорошо подойдет для любых типов нагрузок. За счёт использования программно определяемой логики, паттернов автоматизации и единой платформы управления OneView затраты на обслуживание ЦОД на базе новой платформы можно существенно снизить, направив высвободившиеся ресурсы на более важные для компании проекты и задачи. Не возникнет и проблем с совместимостью — все компоненты Synergy изначально созданы в рамках единого форм-фактора и являются взаимозаменяемыми. Имеется также задел на будущее: с появлением новых высокоскоростных технологий (фотоники) платформа не устареет, но может быть легко модернизирована. Основные узлы Synergy представляют собой компонуемые модули лезвийного типа Synergy 480 Gen10. Они полностью поддерживают возможность «горячей замены», но самое интересное скрыто внутри: компактная системная плата с двумя Intel Xeon Scalable в окружении 24 слотов DDR4. Поддерживаются все процессоры с теплопакетом до 205 Ватт включительно (до 3,8 ГГц), также поддерживаются модули Optane DCPMM. Имеется специальный слот для дискового контроллера. Само «лезвие» оснащено или двумя SFF-дисками, или четырьмя SSD формата uFF.  Также к узлу можно подключать до трёх мезаниновых карт расширения с интерфейсом PCI Express x16, правда, только версии 3.0. Эти карты предельно компактны. Так, основой для сетевой инфраструктуры может служить адаптер Synergy 6810C, поддерживающий стандарты Ethernet со скоростями 25 и 50 Гбит/с. Он базируется на технологиях Mellanox и поддерживает RoCEv2.  В конструкции изначально предусмотрена резервная батарея (BBU) для сохранения дисковых кешей, тогда как обычный RAID-контроллер не во всякой комплектации имеет BBU. Из прочего отметим наличие системы удалённого мониторинга и управления HPE iLO5 и продвинутую реализацию подключения к системе: за управление данными и питанием отвечает выделенный чип-контроллер.  Есть в вариантах Synergy 480 Gen10 и модуль двойной ширины, предназначенный специально для установки графических или вычислительных ускорителей. Несмотря на скромные габариты, он может принять в себя шесть ускорителей в формате Multi MXM, либо две мощные видеокарты в классическом исполнении. Ещё более производительны модули HPE Synergy 660 Gen10. Они вдвое выше Synergy 480, так что внутри может размещаться уже восемь uFF-накопителей, либо четыре SFF и четыре M.2. Процессорных разъёмов четыре, а количество слотов памяти равно 48. Мезонинов тоже вдвое больше, то есть шесть.  Для высокоплотного хранения данных предлагается использовать модуль Synergy D3940. В нём размещается до 40 накопителей общим объёмом 612 Тбайт, причём поддерживается любое сочетание дисков SAS и SATA. Реализованы операции как на файловом уровне, так и на блочном и даже объектном. Предусмотрено два адаптера ввода/вывода, которые при необходимости быстро заменяются. Сами накопители физически отделены от RAID-контроллеров и связаны с ними независимыми модулями коммутации. Модуль коммутации поддерживает 48 портов SAS, обслуживает до 40 SSD на модуль с производительностью до 50 тыс. IOPS на каждый SSD. Компания хорошо понимает, что за счёт совместимости с оборудованием других производителей охват рынка будет шире, поэтому Synergy легко интегрируется с системами хранения данных, разработанными вне стен HPE. Поддерживаются решения Fibre Channel, FC over Ethernet и iSCSI таких компаний, как Hitachi Data Systems, Net App, IBM и даже извечного конкурента HPE — Dell EMC. На программном уровне обеспечена совместимость с виртуальными SAN Scality, VMWare, Ceph и Microsoft.  Для связи с SAN и LAN предлагаются различные коммутационные модули с портами вплоть до FC32 и 100GbE. Все эти модули объединяются в рамках 10U-шасси HPE Synergy 12000: до 12 вычислительных, 6 коммутационных и 5 модулей хранения данных. Новое шасси во всём лучше HPE Blade System c7000 прошлого поколения. Оно мощнее, лучше охлаждается, имеет более эффективную систему питания, а общая коммутационная плата для узлов поддерживает суммарную скорость передачи данных до 16 Тбит/с и изначально готова к переходу на использование высокоскоростной фотоники.  Шасси позволяет сформировать шасси с оптимальным набором компонентов, и HPE предлагает типовые варианты конфигураций в зависимости от задачи: базы данных, виртуальные машины, платформы аналитики, максимально ёмкие СХД или платформа для вычислений на графических ускорителях. Все компоненты предельно унифицированы, все базовые функции являются программно-определяемыми и унифицированными. Даже кабели придётся подключить только во время установки. После этого систему можно «нарезать» на отдельные фабрики с нужным набором дискового пространства, числа ядер CPU и GPU, объёмом памяти и сетевых подключений.  На уровне фабрик HPE позаботилась о резервировании и физическом разделении сетей управления и данных. Есть отдельное подключение к серверу образов для загрузки операционных систем и отдельные порты управления. Сетевые коммутаторы могут быть типов «Мастер» или «Спутник». Первый отвечает за весь сетевой трафик и обладает минимальными задержками, а второй является повторителем сигнала и содержит ретаймеры; задержка в передаче сетевого пакета не превышает 8 нс. Поддерживаются порты со скоростью 10 и 20 Гбит/с. Дирижёром всего этого оркестра является модуль компоновщика (composer). Он базируется на фирменном управляющем ПО HPE OneView. При необходимости настроить систему на месте в дело вступает модуль сети управления (frame link module), который имеет разъём Display Port для монитора и порт USB. Если обычная процедура ввода в строй нового сервера содержит множество пунктов, от установки его в стойку до настроек BIOS и установки ОС, то в Synergy достаточно установить новый модуль в шасси и применить нужный серверный профиль из шаблона. Остальное система сделает сама.  Компоновщик поддерживает форматы виртуализации Hyper-V и ESXi, а фирменное ядро OneView работает с аппаратными и сетевыми компонентами, но наружу информация предоставляется посредством стандартного API RESTful. Предусмотрено управление как с помощью веб-интерфейса, так и с помощью различного ПО — CHEF, Microsoft PowerShell или System Center; имеется также и фирменное приложение HPE OneView для VMWare. Таким образом, перед нами действительно уникальная, инновационная технология. HPE Synergy образует совершенно новый класс систем, по-настоящему универсальных на всех уровнях построения и конфигурации. Образуемая этим «конструктором» инфраструктура подходит для выполнения любого класса задач, причём разворачивается она по меркам мира ИТ практически мгновенно, буквально одной строкой кода, и сразу в нужных заказчику масштабах, в том числе облачных.  Простои практически исключены, все элементы унифицированы и легко заменяются, управление аппаратными серверами в облаке так же просто, как и традиционными виртуальными машинами. Использование HPE Synergy или модернизация ИТ-экосистемы этой новинкой означает сокращение как финансовых затрат, так и трудовых ресурсов, а единый API позволяет провести такую модернизацию постепенно, но в кратчайшие сроки за счёт совместимости с оборудованием СХД других поставщиков. Кому подойдёт HPE Synergy? Всем, но особенно крупным компаниям, специализирующимся на ресурсоёмких ИТ-задачах любого класса, включая телеком, CAD/CAM, VDI, 3D-моделирование, а также медицину. Более того, именно медикам новинка подойдёт особенно хорошо. Об этом хорошо рассказывает нижеприведённое видео: Сценариев развёртывания Synergy может быть множество, вот лишь некоторые из них:  Сама HPE называет десять причин для выбора Synergy. Они просты и понятны:

При этом заказать Synergy весьма просто: компания готова как к немедленной отправке оплаченного оборудования со склада, так и к компоновке под заказ. В России поставкой систем HPE Synergy занимается компания OCS, авторизованный партнёр Hewlett Packard Enterprise с опытом работы более 25 лет. Системы могут поставляться во все регионы страны, партнёрам предоставляются дополнительные удобные сервисы. Также отметим, что 12 октября в 10:00 по московскому времени состоится веб-семинар, посвящённый новой модульной платформе HPE. Записаться на него можно здесь.

08.09.2021 [19:31], Алексей Степин

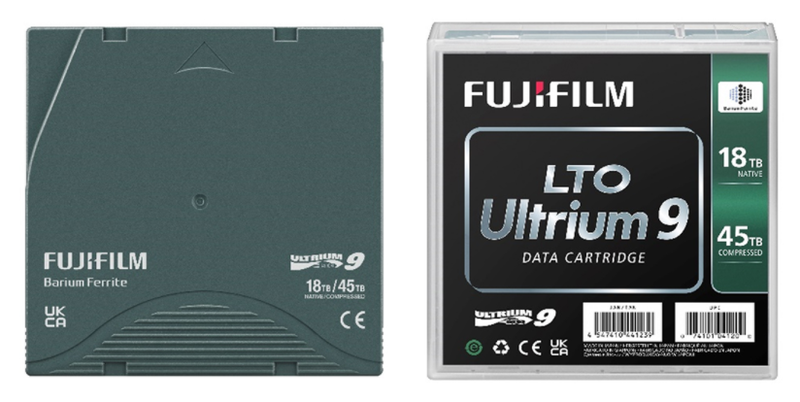

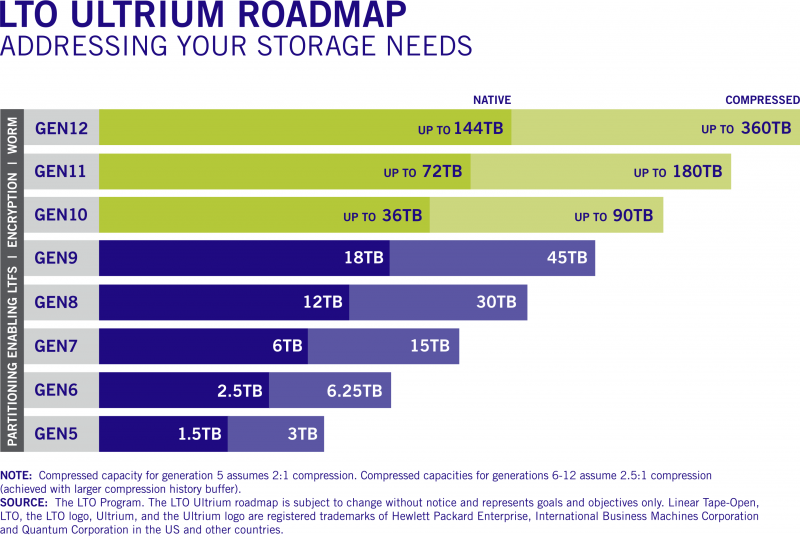

Fujifilm и HPE представили ленточные картриджи LTO-9 ёмкостью 45 ТбайтЛенточные накопители и библиотеки остаются одним из самых популярных вариантов для «холодного» хранения больших объёмов данных, и новые технологии в этой сфере продолжают активно развиваться. Компании Fujifilm и HPE объявили о выпуске ленточных картриджей LTO-9 Ultrium, эффективная ёмкость которых достигает 45 Тбайт. Правда, эта цифра относится к режиму со сжатием данных, «чистая» же ёмкость LTO-9 составляет 18 Тбайт. Для сравнения, картриджи LTO-8 могут хранить до 12 и 30 Тбайт несжатых и сжатых данных соответственно, Хотя налицо паритет с традиционными HDD, темпы прироста ёмкости LTO замедлились: так, при переходе от седьмого поколения к восьмому «чистый» объём вырос вдвое (с 6 до 12 Тбайт), а сейчас мы видим лишь 50% прирост. Тем не менее, в будущем планируется вернуться к удвоению ёмкости в каждом новом поколении. Скорость передачи данных LTO-9 в сравнении c LTO-8 выросла, но ненамного: с 360/750 Мбайт/с до 440/1000 Мбайт/с в режимах без сжатия и со сжатием соответственно.  В новых картриджах Fujifilm используется лента на основе феррита бария (BaFe), покрытие формируется с использованием фирменной технологии NANOCUBIC. Компания заявляет о 50 годах стабильного хранения данных с использованием новой ленты. HPE пока что ограничилась коротким сообщением о выходе RW- и WORM-картриджей. Quantum анонсировала приводы LTO-9, а IBM объявила о совместимости ПО Spectrum Archive с новым стандартом. Наконец, Spectra Logic сообщила о поддержке нового стандарта в своих ленточных библиотеках. Ленточные накопители, пожалуй, являются своеобразными патриархами в мире систем хранения данных — магнитная лента использовалась ещё в первых компьютерах IBM. Однако даже сегодня именно они могут похвастаться одной из самых больших ёмкостей в пересчёте на единицу носителя, а кроме того, имеют и ряд других достоинств, например, повышенную надёжность хранения данных за счёт «пассивного» характера хранения записанной информации.

В будущем темпы роста ёмкостей картриджей LTO будут восстановлены Также ленточные библиотеки могут похвастаться меньшей стоимостью владения, нежели HDD-фермы или облачные хранилища. Среди областей применения ленточных накопителей и библиотек называется сценарий защиты данных от «шифровальщиков» и вымогательства, поскольку при необходимости уцелевшую копию можно просто восстановить с картриджа. Однако при современных объёмах данных даже скорость 3,6 Тбайт/час может оказаться недостаточно быстрой.

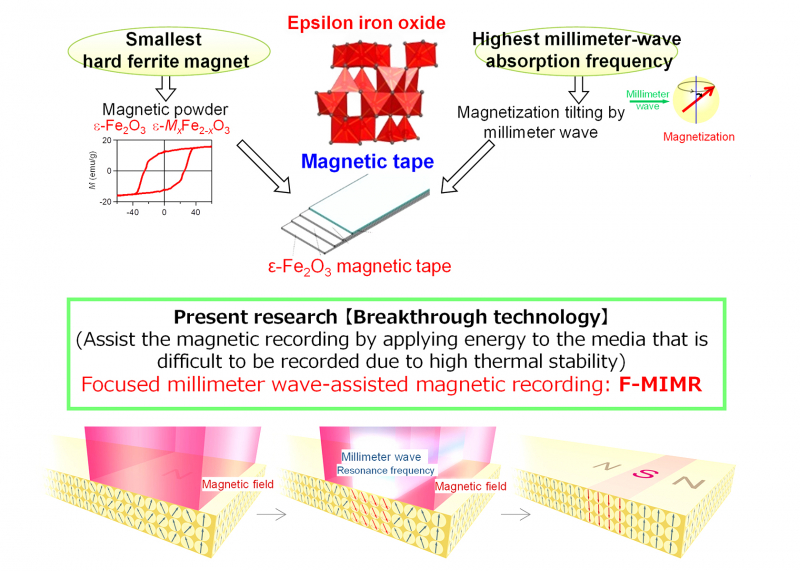

Петабайтные ёмкости потребуют перехода от феррита бария к эпсилон-ферриту железа (ɛ-Fe2O3) Тем не менее, развитие LTO не останавливается. В экспериментальных устройствах ещё в конце 2020 года была достигнута ёмкость 580 Тбайт, а уже 2021 году было объявлено уже о разработке лент и накопителей, способных хранить до 2,5 Пбайт сжатых данных. Так что говорить о смерти ленточных накопителей не приходится, хотя пандемия и повлияла отрицательно на объёмы продаж оборудования LTO.

28.05.2021 [00:33], Владимир Мироненко

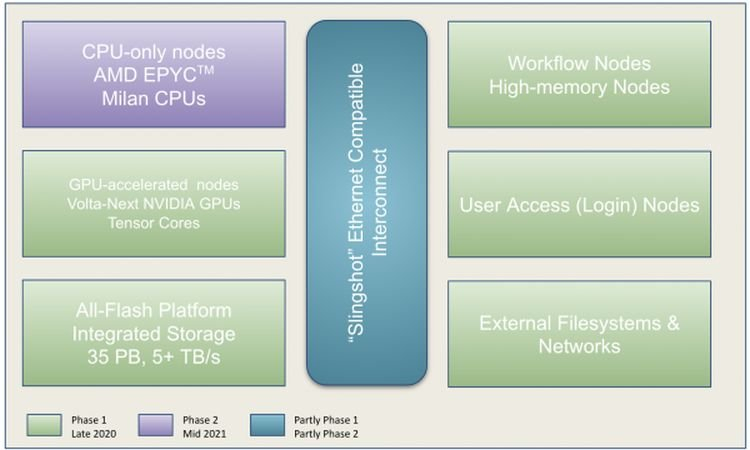

Perlmutter стал самым мощным ИИ-суперкомпьютером в мире: 6 тыс. NVIDIA A100 и 3,8 ЭфлопсВ Национальном вычислительном центре энергетических исследований США (NERSC) Национальной лаборатории им. Лоуренса в Беркли состоялась торжественная церемония, посвящённая официальному запуску суперкомпьютера Perlmutter, также известного как NERSC-9, созданного HPE в партнёрстве с NVIDIA и AMD. Это самый мощный в мире ИИ-суперкомпьютер, базирующийся на 6159 ускорителях NVIDIA A100 и примерно 1500 процессорах AMD EPYC Milan. Его пиковая производительность в вычислениях смешанной точности составляет 3,8 Эфлопс или почти 60 Пфлопс в FP64-вычислениях. Perlmutter основан на платформе HPE Cray EX с прямым жидкостным охлаждением и интерконнектом Slingshot. В состав системы входят как GPU-узлы, так и узлы с процессорами. Для хранения данных используется файловая система Lustre объёмом 35 Пбайт скорость обмена данными более 5 Тбайт/с, которая развёрнута на All-Flash СХД HPE ClusterStor E1000 (тоже, к слову, на базе AMD EPYC). Установка Perlmutter разбита на два этапа. На сегодняшней презентации было объявлено о завершении первого (Phase 1) этапа, который начался в ноябре прошлого года. В его рамках было установлено 1,5 тыс. вычислительных узлов, каждый из которых имеет четыре ускорителя NVIDIA A100, один процессор AMD EPYC Milan и 256 Гбайт памяти. На втором этапе (Phase 2) в конце 2021 года будут добавлены 3 тыс. CPU-узлов c двумя AMD EPYC Milan и 512 Гбайт памяти., а также ещё ещё 20 узлов доступа и четыре узла с большим объёмом памяти.

NERSC Также на первом этапе были развёрнуты служебные узлы, включая 20 узлов доступа пользователей, на которых можно подготавливать контейнеры с приложениями для последующего запуска на суперкомпьютере и использовать Kubernetes для оркестровки. Среда разработки будет включать NVDIA HPC SDK в дополнение к наборам компиляторов CCE (Cray Compiling Environment), GCC и LLVM для поддержки различных средств параллельного программирования, таких как MPI, OpenMP, CUDA и OpenACC для C, C ++ и Fortran. Сообщается, что для Perlmutter готовится более двух десятков заявок на вычисления в области астрофизики, прогнозирования изменений климата и в других сферах. Одной из задач для новой системы станет создание трёхмерной карты видимой Вселенной на основе данных от DESI (Dark Energy Spectroscopic Instrument). Ещё одно направление, для которого задействуют суперкомпьютер, посвящено материаловедению, изучению атомных взаимодействий, которые могут указать путь к созданию более эффективных батарей и биотоплива.

01.10.2020 [23:24], Юрий Поздеев

Сделано в США: HPE возвращается к «белой сборке» серверовHewlett Packard Enterprise (HPE) анонсировала новую систему безопасности цепочки поставок для клиентов из государственного сектора США, которые по тем или иным причинам предпочитают покупать продукцию, произведенную на территории США. Безопасность всей цепочки поставок серверного оборудования достигается за счет строгого соблюдения отраслевых стандартов США, что снижает риски для учреждений государственного сектора. Новую инициативу назвали HPE Trusted Supply Chain. Несколько лет назад HPE представила Silicon Root of Trust — функцию, которая обеспечивает безопасность непосредственно в iLO и создает неизменяемую цифровую подпись. Если прошивка или комплект драйверов для сервера не соответствует этой цифровой подписи, сервер не загрузится и изменения конфигурации не будут приняты. HPE не ограничивается только серверами, но и предлагает подобную систему для сетевой безопасности в решениях от Aruba.  Однако, есть некоторые проблемы с автономностью цепочки поставок: пандемия Covid-19 повлекла массовый сбой в производстве многих электронных компонентов для серверов. Еще одной проблемой стали участившиеся взломы микрочипов для кражи информации с различных устройств. Обе проблемы HPE решает, создавая готовый продукт в той стране, где он продается. В США наблюдается повышенный спрос на безопасные продукты собственного производства, особенно для клиентов из федерального, государственного и финансового секторов, а также организаций здравоохранения. У HPE есть собственная производственная площадка в штате Висконсин, где работает персонал с необходимым допуском. Поскольку весь процесс производства находится под контролем, вероятность нарушения безопасности очень мала. HPE также готова доставить и установить новые серверы в ЦОД заказчика.  Первым продуктом, прошедшим весь этот процесс является сервер HPE Proliant DL380T. Не все компоненты сервера произведены непосредственно в США, но те, что имеют локальное происхождение, уже позволяют официально заявить об американском происхождении оборудования (Country of Origin USA), а не просто об американском производстве (Made in USA). HPE выходит за рамки процесса производства, распространяя повышенную безопасность на весь жизненный цикл продукта:

HPE не останавливается на достигнутом и планирует в следующем году представить подобную программу для Европы. Похоже, что «белая сборка» возвращается. Впрочем, процесс этот начался не сегодня — ещё в прошлом году крупные контрактные производители серверов, которые обслуживали крупных американских и европейских клиентов начали переносить производственные линии из материкового Китая на Тайвань и в Мексику. HPE лишь довела дело до логического завершения.

19.06.2020 [18:09], Юрий Поздеев

HPE анонсировала Superdome Flex 280: 224 ядра Cooper Lake и 24 Тбайт RAMHPE анонсировала Superdome Flex 280 с поддержкой процессоров Intel Xeon третьего поколения, которые вышли недавно. Данная модель дополняет портфель HPE Superdome Flex и ориентирована на средние предприятия, для которых избыточна масштабируемость до 32 сокетов. Оптимально данная модель подойдет для больших баз Oracle, SAP HANA или SQL-сервера. Новинка выпускается в форм-факторе 5U и поддерживает установку 2 или 4 процессоров Intel Xeon Gold или Intel Xeon Platinum. Это выгодно отличает Superdome Flex от других подобных систем, в которых можно использовать только Intel Xeon Platinum, который стоит значительно дороже.  Недавно анонсировали новые процессоры Intel Xeon третьего поколения, в которых не только добавили функции ускорения ИИ, но и поддержку более быстрой памяти DDR4-3200, что должно положительным образом сказаться на производительности. Максимально в одну платформу можно установить до 24 Тбайт оперативной памяти, а если и этого недостаточно, то можно использовать Intel Optane PMem 200 .  Слотов расширения PCIe тоже достаточно для большинства задач — до 32 на одну платформу, при этом можно установить до 16 графических ускорителей NVIDIA. Для локального хранилища можно использовать до 20 накопителей SAS/SATA/NVMe. Масштабируется платформа Superdome Flex 280 до 8 процессоров с шагом в 2 CPU, что позволяет работать с большими базами данных и моделями для ИИ, для которых требуется большой объем оперативной памяти. Суммарно можно получить до 224 ядер и до 24 Тбайт общей памяти. HPE Superdome Flex 280 будет доступен в 4 квартале 2020 года.

09.06.2020 [19:49], Юрий Поздеев

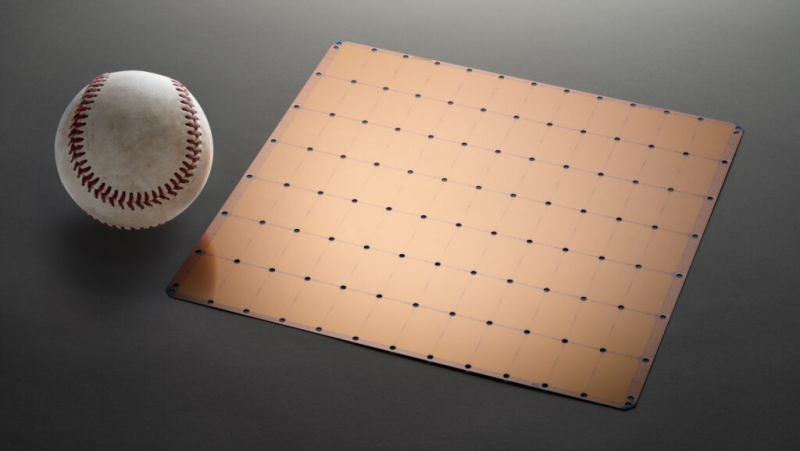

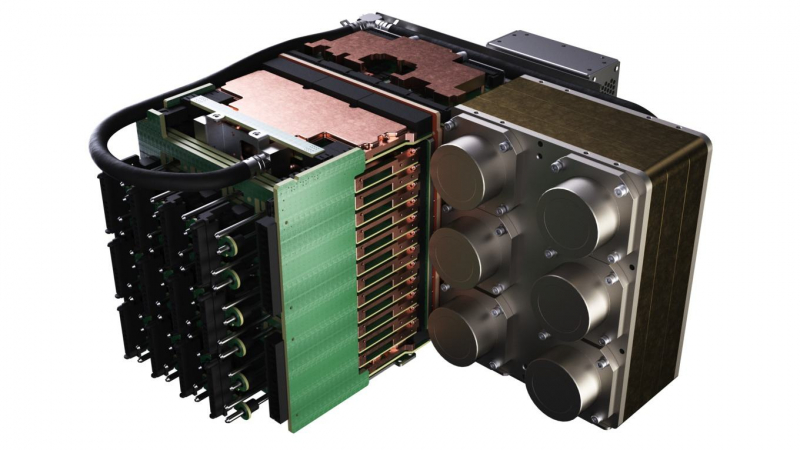

Суперкомпьютер Neocortex: 800 тыс. ядер Cerebras для ИИПиттсбургский суперкомпьютерный центр (PSC) получит $5 млн от Национального научного фонда на создание суперкомпьютера нового типа Neocortex, который объединяет ИИ-серверы Cerebras CS-1 и HPE SuperDome Flex в единую систему с общей памятью. Планируется, что решение будет введено в эксплуатацию до конца 2020 года.  Каждый сервер Cerebras CS-1 имеет процессор Cerebras Wafer Scale Engine (WSE), который содержит 400 000 ядер, оптимизированных для работы с ИИ (46 225 мм2, 1,2 трлн транзисторов). В паре с ними работает HPE SuperDome Flex, который используется для предварительной обработки информации и постобработки после Cerebras. SuperDome Flex представлен в максимальной комплектации, то есть с 32 процессорами Intel Xeon, 24 Тбайт оперативной памяти, 205 Тбайт флеш-памяти и 24 интерфейсными картами.  Каждый сервер Cerebras CS-1 подключается к SuperDome Flex через 12 каналов со скоростью 100 Гбит/с каждый. Процессор WSE способен обрабатывать 9 Пбайт данных в секунду, что, по подсчетам Nystrom, эквивалентно примерно миллиону фильмов в HD-качестве. Характеристики решения действительно впечатляют!

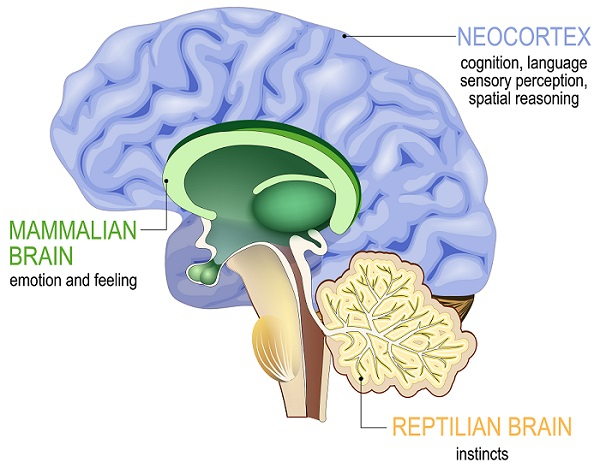

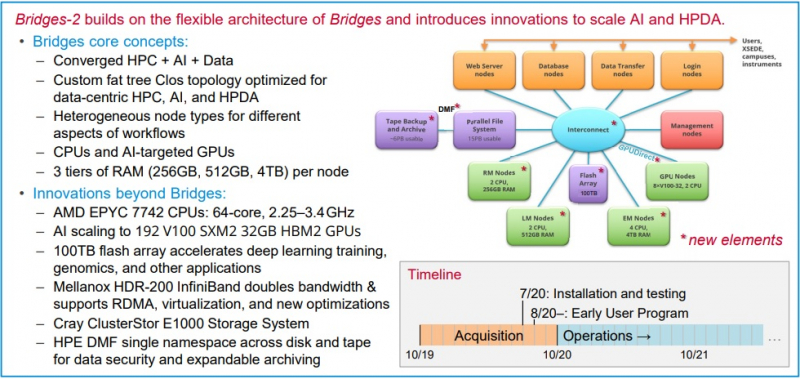

Neocortex назван в честь области мозга, отвечающей за функции высокого порядка, включая когнитивные способности, сновидения и формирование речи Архитектура решения строилась таким образом, чтобы не пришлось разбивать вычислительные блоки на множество узлов — это позволило снизить задержки в обработке информации и ускорить обучение моделей ИИ. Cerebras CS-1 разрабатывался специально для ИИ, поэтому он имеет преимущества перед серверами с графическими ускорителями, которые хорошо справляются с матричными операциями, но имеют многие конструктивные ограничения.  По заявлениям Neocortex, сервер CS-1 будет на несколько порядков мощнее системы PSC Bridges-AI. Один сервер Neocortex CS-1 будет эквивалентен примерно 800-1500 серверов с традиционной архитектурой с использованием графических ускорителей. Задачи, в которых Neocortex покажет себя максимально эффективно относятся к классу нейронных сетей DCIGN (deep convolutional inverse graphics networks) и RNN (recurrent neural networks). Если говорить простыми словами, то это более точное прогнозирование погоды, анализ геномов, поиск новых материалов и разработка новых лекарств.  PSC, помимо Neocortex, запускает еще и новое поколение системы Bridges-2, которое будет развернуто осенью 2020 года. Таким образом, до конца этого года будут введены в эксплуатацию два мощных суперкомпьютера для ИИ. Neocortex и Bridges-2 будут поддерживать самые популярные фреймворки машинного обучения, что позволит создать гибкую и мощную экосистему для ИИ, анализа данных, моделирования и симуляции. До 90% машинного времени Neocortex будет выделяться через XSEDE (Extreme Science and Engineering Discovery Environment), финансируемую NSF организацию, которая координирует совместное использование передовых цифровых услуг, включая суперкомпьютеры и ресурсы для визуализации и анализа данных, с исследователями на национальном уровне.

09.04.2020 [18:32], Алексей Степин

HPE лишит энтузиастов лицензий на OpenVMSНа первый взгляд, в мире серверов царит господство двух операционных систем — Microsoft Windows Server и различных вариантов Linux. Однако есть ещё немало число оборудования с архитектурами, отличными от x86. Иногда оно поддерживается за счет таких явлений, как «хобби-лицензия» на операционную систему OpenVMS, некогда созданную в недрах знаменитой корпорации DEC. Сейчас правами на эту лицензию владеет HPE и, похоже, вскоре она собирается перекрыть кислород последним легальным пользователям VMS-систем, которые не приносят доход.

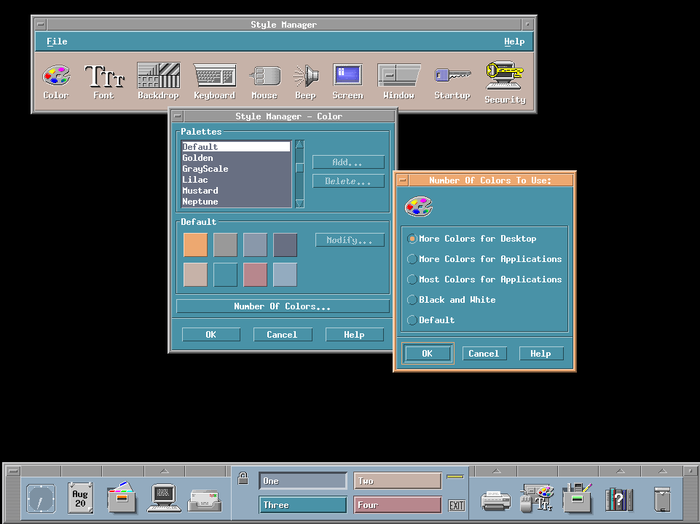

Пример рабочего стола в OpenVMS 8.4 Такие имена, как VAX или Alpha забыты ныне практически всеми, за исключением энтузиастов и тех, кто хочет поддерживать работоспособность устройств, унаследованных у эры разнообразия процессорных архитектур. VMS — весьма почтенная, но передовая на момент создания операционная система, созданная корпорацией Digital Equipment Corporation ещё в 1977 году для платформы VAX. Впоследствии она была портирована на платформы DEC Alpha и Intel Itanium, где, переименованная в OpenVMS, и продолжила свою службу на благо человечества. До недавних пор существовала возможность приобретения «хобби-лицензии», что позволяло официально эксплуатировать систему на платформах VAX, Alpha и HP Integrity, а также в эмуляторах.

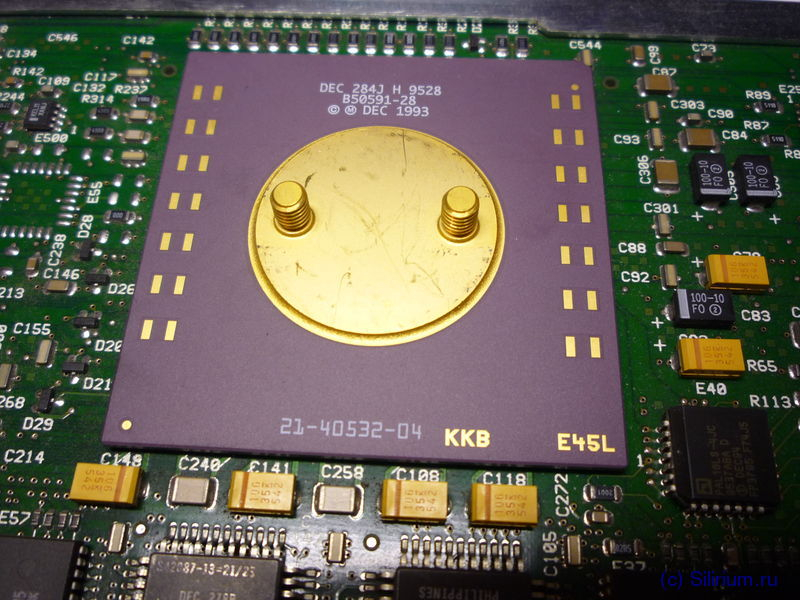

DEC Alpha 21064: 1995 год, 275 МГц, 64 бита, 32 Кбайт L1 и 8 Мбайт внешнего L2 Однако двери закрываются: владеющая правами на выдачу таких лицензий HPE передала соответствующее подразделение в распоряжение VMS Software (VSI) и теперь закрывает свою программу, нацеленную на энтузиастов. Пока на сайте HPE ещё доступна опция продления лицензии на OpenVMS, но компания завершает цикл поддержки OpenVMS V8.4 и последний пакет лицензий будет действовать лишь до 31 декабря 2021 года, после чего пользователям предлагается рассмотреть возможность приобретения коммерческой лицензии. Как минимум, один владелец систем с процессорами Alpha, пользующийся такими лицензиями, нашёлся — и он подтвердил, что цены на них весьма далеки от гуманных: в последний раз стоимость лицензии для системы DS20 составляла почти $25 тыс. Мало какой энтузиаст сможет позволить себе такие затраты для некоммерческого проекта. У VSI есть студенческий вариант лицензионного пакета, но как сообщают пользователи, такой пакет действует всего полгода и получение новых версий является достаточно затруднительным процессом.

30.09.2017 [00:15], Алексей Степин

Терафлопс в космосе: на МКС тестируется компьютер HPE SpaceborneБытует мнение, что в космической отрасли используется всё самое лучшее, включая компьютерные компоненты. Это не совсем так: вы не встретите в космических аппаратах 18-ядерных Xeon и ускорителей Tesla. Во-первых, энергетические резервы за пределами Земли строго ограничены, и даже на МКС никто не будет тратить несколько киловатт на питание «космического суперкомпьютера». Во-вторых, практически вся электроника, работающая за пределами атмосферы, выпускается в специальном радиационно-стойком исполнении. Чаще всего за счёт техпроцессов «кремний на диэлектрике» (SOI) и «сапфировая подложка» (SOS), используется также биполярная логика вместо менее стойкой к внешним излучениям CMOS.

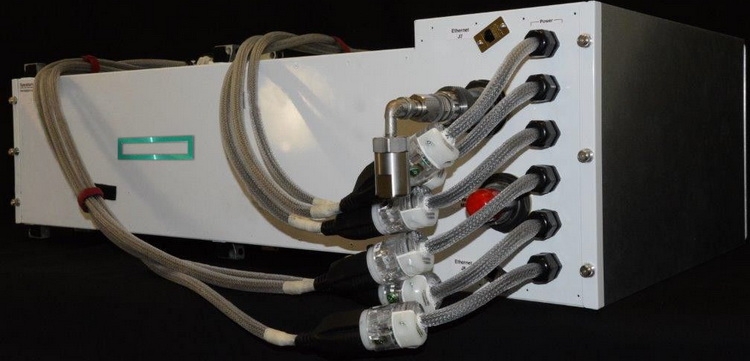

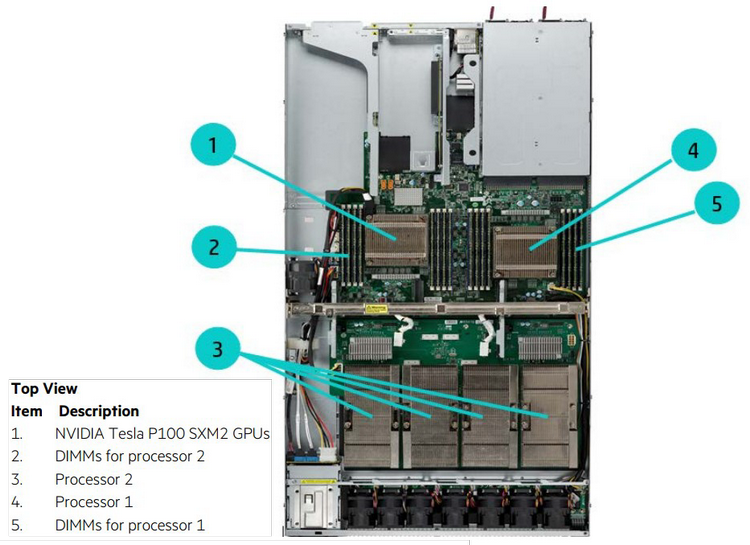

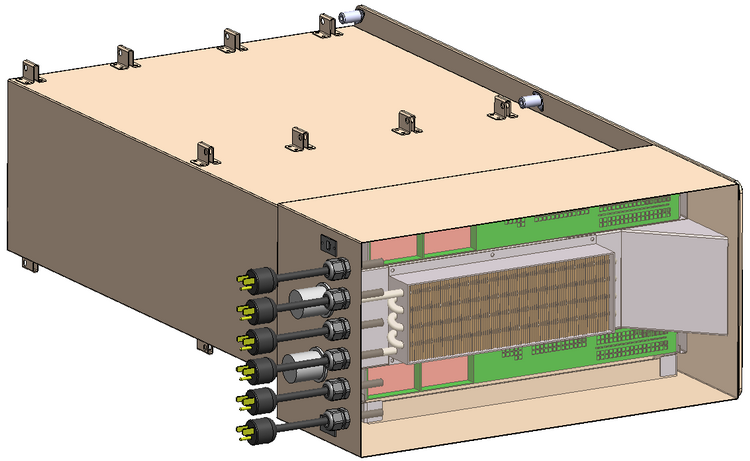

Мини-кластер в космическом исполнении. Охлаждение жидкостное Мощными в космосе считаются такие решения, как BAE Systems серии RAD, особенно новая RAD5500 (от 1 до 4 ядер, 45-нм SOI, PowerPC, 64 бита). Четырёхъядерный вариант RAD5545 развивает производительность более 3,7 гигафлопс при потреблении около 20 ватт. Иными словами, вычислительные мощности в космосе тоже растут, но совсем иными темпами, нежели на Земле. Тому подтверждением служит недавно вступивший в строй на борту Международной космической станции компьютер HPE Spaceborne. Если на Земле мощность суперкомпьютеров измеряется десятками и сотнями петафлопс, то Spaceborne куда скромнее — судя по проведённым тестам, его вычислительная мощность достигает 1 терафлопса. Достигнута она путём сочетания современных процессоров Intel с ускорителями NVIDIA Tesla P100 (NVLink-версия).

Конфигурация каждого из узлов Spaceborne Для космических систем это большое достижение, и не стоит иронизировать над этим показателем производительности. Интересно, что сама по себе система Spaceborne, доставленная на борт станции миссией SpaceX CRS-12, является своего рода экспериментом на тему «как чувствуют себя в космосе обычные компьютерные комплектующие». Это связка из двух серверов HPE Apollo 40 на базе Intel Xeon, объединённая сетью со скоростью 56 Гбит/с. 14 сентября на систему было подано питание (48 и 110 вольт), а недавно проведены первые тесты High Performance LINPACK.

Системы охлаждения и электропитания Spaceborne Пока Spaceborne не будет использоваться для анализа научных данных или управления какими-либо системами станции. Его миссия — продемонстрировать то, насколько живучи обычные серверы в космосе. Результаты постоянных тестов будут сравниваться с аналогичной системой, оставшейся на Земле. Тем не менее, достижение первого терафлопса в космосе является своеобразным мировым рекордом. Это маленький шаг для супервычислений, но большой для всей космической индустрии, поскольку за Spaceborne явно последуют его более совершенные и мощные потомки.

04.04.2017 [13:34], Сергей Юртайкин

HPE отделила подразделение IT-услугКорпорация Hewlett Packard Enterprise (HPE) закрыла сделку по передаче бизнеса в области корпоративных IT-услуг конкурирующей компании Computer Sciences. В результате слияния подразделения HPE Enterprise Services, специализирующегося на услугах консалтинга, аутсорсинга и системной интеграции, с Computer Sciences появилась компания DXC Technology. HPE оценивает свои доход от сделки в $13,5 млрд. Сюда входят стоимость доли HPE в новой компании, дивиденды для акционеров и переданные DXC долги и другие обязательства. Объединение HPE Enterprise Services и Computer Sciences было анонсировано в мае 2016 года. Тогда сообщалось, что сделка создаст поставщика IT-услуг с годовой выручкой в $26 млрд, а оставшийся у HPE бизнес (продажа серверов, систем хранения данных, сетевого оборудования, облачных инфраструктур и др. ) будет приносить компании доход в $33 млрд. В совет директоров DXC Technology вошла генеральный директор HPE Мег Уитмен (Meg Whitman). Компании планируют тесно сотрудничать друг с другом. При этом HPE обещает сохранить и развивать созданное недавно подразделение технических услуг Pointnext. После закрытия сделки с Computer Sciences компания HPE понизила прогноз по доходам. К примеру, по итогам текущего финансового года вендор ожидает прибыль на уровне 27–37 центов на акцию, тогда как прежде предсказывал 60–70 центов. |

|