Материалы по тегу: coreweave

|

23.07.2025 [23:47], Руслан Авдеев

Курируемый OpenAI ИИ-мегапроект Stargate с трудом продвигается вперёд, но самой OpenAI это не мешаетПроект Stargate под руководством SoftBank, OpenAI и Oracle при участии Microsoft, Arm, NVIDIA и MGX должен укрепить лидерство Америки в сфере искусственного интеллекта. Но, как оказалось, проект стоимостью до $500 млрд с трудом сдвинулся с мёртвой точки, а планы его стали намного скромнее, сообщает The Wall Street Journal. Через полгода после анонса Stargate компании-партнёры всё ещё не заключила ни одной сделки по строительству ИИ ЦОД. По данным некоторых источников, знакомых с вопросом, SoftBank и OpenAI, совместно руководящие проектом, имеют разногласия относительно ключевых вопросов партнёрства, включая выбор мест для строительства объектов. Кроме того, хотя в январе компании пообещали немедленно инвестировать в Stargate $100 млрд, сейчас цель намного скромнее — построить к концу году небольшой ЦОД, вероятно, в Огайо (США). Не особенно активный старт препятствует амбициям SoftBank, ранее в этом году выделившей $30 млрд на OpenAI. Это крупнейшая инвестиция в стартап за всю его историю. SoftBank пришлось влезть в долги, продать активы и буквально сделать на компанию судьбоносную для себя ставку. Инвестиции позволили компании принять участие в проекте Stargate. Однако уже весной Softbank столкнулась с трудностями в связи новыми пошлинами США. При этом на словах у компаний дела идут отлично, они готовы построить ЦОД на 10 ГВт в нескольких штатах. Однако OpenAI «устремилась вперёд» без SoftBank, подписывая соглашения об аренде и строительстве ЦОД с другими операторами. Недавно она заключила сделку по аренде у Oracle 4,5 ГВт мощностей и 2 млн ИИ-ускорителей в нескольких штатах в ближайшие три года, согласно которой компания Сэма Альтмана (Sam Altman) будет выплачивать партнёру более $30 млрд/год. Softbank в этой сделке не участвует. Вместе с кампусом Stargate I в техасском Абилине (Abilne), который создаётся усилиями Crusoe Energy и всё той же Oracle, у OpenAI уже законтрактованы 5 ГВт, т.е. ровно столько, сколько она и планировала получить на первом этапе проекта за примерно $100 млрд. Кроме того, ещё одним крупным подрядчиком OpenAI стала CoreWeave. С ней заключены контракты на $16 млрд (11,9 млрд + 4 млрд). Сейчас она активно арендует или скупает ЦОД, преимущественно у бывших майнеров (как и она сама и та же Crusoe). Нюанс в том, что ключевым заказчиком CoreWeave всё это время была Microsoft, которая арендовала мощности в интересах OpenAI. Вторым же по величине клиентом оказалась NVIDIA, которая инвестировала в CoreWeave, первой дала ей дефицитные ИИ-ускорители, а потом сама же арендовала их. При этом между Microsoft и OpenAI сохраняются партнёрские отношения, но разлад между ними очень серьёзен. Впрочем, источники сообщают, что несмотря на медленный старт Stargate и разногласия, в SoftBank оптимистично настроены и намерены вложить в компанию ещё больше средств. Глава SoftBank Масаёси Сон (Masayoshi Son) давно мечтал занять видное место на рынке ИИ и за последние 10 лет вложил более $140 млрд в перспективные стартапы в этой сфере, но упустил возможность присоединиться к OpenAI и конкурентам до запуска ChatGPT, а также потратил средства на некоторые неудачные проекты вроде WeWork. Значительного успеха бизнесмен добился в 2016 году, купив Arm, капитализация который за последние пару лет значительно выросла. Осенью 2024 года Сон сосредоточил внимание на OpenAI, а Сэм Альтман уже тогда имел гигантские амбиции, заявив, что для следующего этапа развития ИИ потребуются триллионы долларов. В январе 2025 года партнёры пообещали Трампу потратить на ИИ в США $500 млрд к 2029 году. На запуск совместного предприятия OpenAI и SoftBank обещали выделить по $18 млрд. Ожидалось, что оно займется разработкой и строительством ЦОД, а затем сдаст их в аренду OpenAI. Говорилось, что Сон станет председателем СП, SoftBank сосредоточится на финансах, а OpenAI — на операционной деятельности. Первоначально партнёрами назывались Oracle и MGX из ОАЭ, но их роль была неизвестна. Сейчас же Oracle говорит, что фактически Stargate ещё нет. По словам людей, знакомых с ситуацией, одним из камней преткновения между OpenAI и SoftBank стал вопрос о том, насколько масштабно следует строить ЦОД на площадках, связанных с SB Energy — разработчиком энергетических решений, поддерживаемым SoftBank. Stargate надеется использовать новую, недорогую конструкцию ЦОД для своего первого проекта в Огайо. Компаниям ещё предстоит найти площадки, построить инфраструктуру, закупить ИИ-чипы и обеспечить питание ЦОД, а также найти инвесторов, которые покроют большую часть расходов и решить другие вопросы. Тем временем обучение новых ИИ-моделей требует всё больше ресурсов и компаниями вроде OpenAI приходится вкладывать всё больше средств задолго до того, как появится прибыль — если появится. Годовой контракт OpenAI с Oracle на $30 млрд приблизительно в три раза превышает годовую выручку, недавно спрогнозированную компанией Альтмана. Она ежегодно теряет миллиарды долларов, рассчитывая, что в будущем её выручка многократно увеличивается за счёт платных услуг и рекламы. Впрочем, не она одна. По слухам, xAI «сжигает» по $1 млрд в месяц в расчёте на будущий успех.

16.07.2025 [12:16], Руслан Авдеев

Пенсильвания получит более $90 млрд инвестиций на развитие ИИ, ЦОД и энергетики

aws

blackstone

brookfield

coreweave

google

hardware

ии

инвестиции

полезные ископаемые

сша

финансы

цод

энергетика

Президент США Дональд Трамп (Donald Trump) объявил о частных инвестициях в Пенсильвании на сумму более $90 млрд, которые связаны с ИИ, технологиями и энергетикой, сообщает The Verge. Пенсильвания лидирует по добыче газа в стране, а сам Трамп неоднократно призывал «бурить и бурить», чтобы спасти энергетику США, и поддержал угольный сектор ради удовлетворения спроса ИИ ЦОД на электричество. BlackStone вложит $25 млрд в развитие ЦОД и энергетической инфраструктуры на северо-востоке Пенсильвании, а First Energy потратит $15 млрд. Enbridge планирует инвестировать $1 млрд в расширение газопроводов в Пенсильванию, Equinor потратит $1,6 млрд на увеличение добычи природного газа в штате и его доставку для гибкой генерации энергии для дата-центров. Capital Power заявила, что потратит на модернизацию «газового объекта» в штате $3 млрд в течение 10 лет. Google намерена инвестировать $25 млрд в строительство ЦОД и ИИ-инфраструктуры в следующие два года в регион PJM (Pennsylvania-New Jersey-Maryland), фактически объединяющий 13 штатов и Вашингтон (округ Колумбия). Кроме того, планируется заключить 20-летний контракт на $3 млрд с Brookfield Energy для развития гидроэнергетики. Кроме того, в апреле сообщалось, что в Пенсильвании построят газовую электростанцию мощностью 4,5 ГВт для ИИ ЦОД на месте заброшенной угольной. CoreWeave объявила о планах инвестировать $6 млрд в ИИ ЦОД в штате. По данным Bloomberg, речь идёт о запуске в Ланкастере (Lancaster) кампуса мощностью 100 МВт в 2026 году с возможным масштабированием до 300 МВт. Примечательно, что объявление сделано после того, как власти Пенсильвании пригрозили отключить штат от сети PJM Interconnection из-за высокого спроса со стороны ИИ ЦОД в соседних штатах. Пенсильвания является нетто-экспортёром электроэнергии и, по данным BAI Group, обеспечивает до четверти энергоснабжения штатов на востоке США и Среднем Западе.

Источник изображения: Addy Mae/unsplash.com Amazon упомянула планы вложить $20 млрд в расширение инфраструктуры облачных вычислений и продвижения ИИ-инноваций в Пенсильвании. Ранее AWS уже получила 650 га для постройки 15 ЦОД в Пенсильвании недалеко от АЭС, но столкнулась с некоторыми проблемами, которые теперь решает. Anthropic потратит $1 млн в течение трёх лет на поддержку программы обучения кибербезопасности, а также $1 млн за три года на исследования в области энергетики в Университете Карнеги-Меллона. Meta✴ же анонсировала партнёрство для поддержки стартапов в сельской местности Пенсильвании на сумму $2,5 млн, а также поддержку обучение представителей малого бизнеса.

15.07.2025 [21:45], Руслан Авдеев

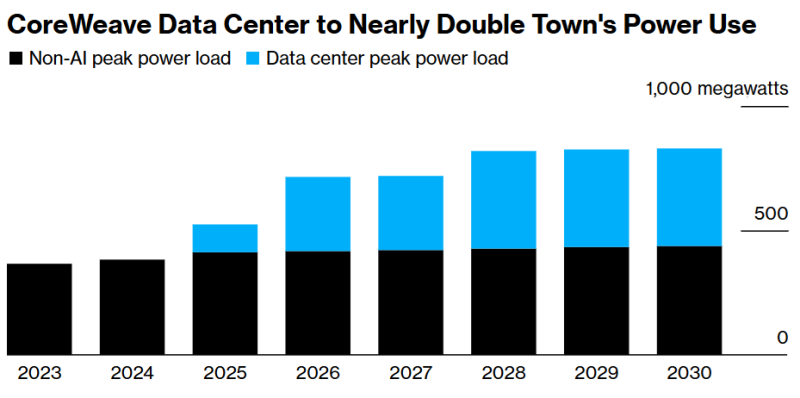

Всё ради OpenAI: дата-центр CoreWeave удвоит энергопотребление техасского городкаКомпания CoreWeave расширит дата-центр в техасском городе Дентон (Denton) в интересах OpenAI. В результате, как прогнозируют эксперты, это удвоит энергопотребление расположенного близ Далласа города — наглядное свидетельство того, как ИИ ЦОД влияют на современную энергосистему, сообщает Bloomberg. Согласно презентации конца 2024 года и электронной корреспонденции, с которой удалось ознакомиться Bloomberg, из-за дата-центра местным властям придётся решать проблему выросшей нагрузки на электросеть. ЦОД строится Core Scientific и будет использоваться OpenAI. При этом буквально на днях CoreWeave объявила о приобретении Core Scientific примерно за $9 млрд ради получения прямого контроля над её кампусами. Население Дентона, расположенного приблизительно в 80 км от Далласа, за последние четверть века почти удвоилось, увеличившись до 166 тыс. человек. Чтобы удовлетворить выросший спрос на электричество, связанный с ИИ-проектами, город перекладывает дополнительные расходы на оператора ЦОД и строит дополнительную сетевую инфраструктуру. По словам представителя коммунальной компании Denton Municipal Electric, для полного обеспечения ЦОД Core Scientific, придётся вложить дополнительные средства в ЛЭП.

Источник изображения: Nils Huenerfuerst/unsplash.com Как и некоторые другие крупные проекты ИИ ЦОД, площадка в Дентоне изначально была ориентирована на майнинг, но в декабре 2024 года было решено сменить её профиль и переключиться на обслуживание ИИ-инфраструктуры. При этом электричества понадобится больше — дата-центр не будет сокращать работу в периоды, когда цены на электроэнергию особенно высоки, что увеличит нагрузку на электросеть. Дата-центр Core Scientific в Дентоне станет крупнейшим объектом компании с потреблением около 390 МВт, на него уйдёт большая часть резервных мощностей города. По данным местных коммунальных служб, это создаст значительную нагрузку на энергосистему, и подключение новых крупных потребителей может привести к перегрузкам. Проблему отчасти планируют смягчить установкой резервных генераторов и аккумуляторов. Дата-центры — крупнейший драйвер энергопотребления в Техасе, новый закон обязывает их использовать резервные генераторы или сокращать нагрузку в чрезвычайных ситуациях.

Источник изображения: Bloomberg ЦОД в Дентоне не получил значимых налоговых льгот. Местные власти ожидают, что объект принесёт более $600 млн в виде налогов. Кроме того, ожидается создание 135 рабочих мест. При этом местный проект гораздо скромнее дата-центра Crusoe в Абилине (Abilene), мощность которого составит 1,2 ГВт. Он создаётся в рамках проекта Stargate при участии Oracle и в интересах OpenAI. Но и он теряется на фоне дата-центра AWS в Индиане, который будет потреблять энергии как половина населения штата. По данным февральского отчёта техасских властей, уже в 2026 году плановые резервы энергосистемы штата могут опуститься буквально до отрицательных значений — энергии будет не хватать из-за дата-центров, нефтегазовых объектов и майнинга криптовалюты. По данным НКО Texas Reliability Entity, оценивающей надёжность систем электроснабжения, огромный новый спрос представляет большую проблему, которая потребует превентивного реагирования, чтобы обычные жители штата не остались без доступа к электричеству. В конце 2024 года Министерство энергетики США сообщало, что в 2028 году на дата-центры США может прийтись уже 12 % энергопотребления всей страны. В июне 2025 года регулятор North American Electric Reliability Corp. (NERC) объявил, что подключение к сетям ЦОД в настоящее время весьма рискованно, поскольку дата-центры несут угрозу электросетям США из-за своей непредсказуемости.

13.07.2025 [10:57], Сергей Карасёв

CoreWeave запустила первые общедоступные инстансы на базе NVIDIA RTX Pro 6000 Blackwell Server EditionОператор ИИ-облака CoreWeave объявил о запуске инстансов с ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition для генеративных приложений, рендеринга в реальном времени и работы с большими языковыми моделями (LLM). Утверждается, что это первые общедоступные облачные экземпляры, построенные на базе названных GPU. Изделия RTX Pro 6000 Blackwell Server Edition на архитектуре Blackwell насчитывают 24 064 ядра CUDA, 752 тензорных ядра пятого поколения и 188 ядер RT четвёртого поколения. В оснащение входят 96 Гбайт памяти GDDR7 с пропускной способностью до 1,6 Тбайт/с. CoreWeave заявляет, что по сравнению с инстансами на основе NVIDIA L40S новые экземпляры обеспечивают 5,6-кратное повышение производительности при LLM-инференсе, 3,5-кратное увеличение быстродействия на операциях преобразования текста в видео и более чем 2-кратное повышение скорости тонкой настройки ИИ-моделей. Заявленная ИИ-производительность в режиме FP4 достигает 3,8 Пфлопс.

Источник изображения: CoreWeave / NVIDIA Инстансы CoreWeave с ускорителями NVIDIA RTX Pro 6000 Blackwell Server Edition доступны в конфигурациях, насчитывающих до восьми GPU. Задействованы два процессора Intel Xeon поколения Emerald Rapids, а также DPU NVIDIA BlueField-3. Экземпляры предоставляют свыше 7 Тбайт пространства для хранения данных на основе NVMe SSD. Говорится о поддержке служб CoreWeave Observability Services, которые отвечают за детальный мониторинг использования ресурсов, а также предоставляют данные о системных ошибках, температуре и пр. Это помогает быстро обнаруживать и устранять проблемы, минимизируя сбои в рабочих процессах. Новые инстансы доступны посредством CoreWeave Kubernetes Service (CKS) и Slurm on Kubernetes (SUNK) в американском регионе CoreWeave US-EAST-04.

08.07.2025 [00:23], Владимир Мироненко

CoreWeave всё-таки купила оператора ЦОД Core Scientific, но в девять раз дороже, чем когда-то планировалаCoreWeave объявила о приобретении Core Scientific, поставщика инфраструктуры ЦОД, за $9 млрд. Благодаря этой сделке CoreWeave получит 1,3 ГВт мощности ЦОД Core Scientific с возможностью добавления более чем 1 ГВт. Год назад CoreWeave уже пыталась купить Core Scientific за $1 млрд, но та посчитала предложенную сумму слишком маленькой. В итоге CoreWeave постепенно нарастила аренду мощностей, став ключевым клиентом Core Scientific. Согласно условиям сделки, акционеры Core Scientific получат 0,1235 новых выпущенных акций CoreWeave класса A за каждую акцию Core Scientific на основе фиксированного обменного коэффициента. Выплата производится исходя из стоимости обыкновенных акций CoreWeave класса A по состоянию на 3 июля 2025 года и премии примерно в 66 % к стоимости акции Core Scientific по состоянию на 25 июня текущего года. Окончательная стоимость сделки будет определена во время её завершения, которое ожидается в IV квартале 2025 года. По оценкам CoreWeave, после закрытия сделки доля акционеров Core Scientific в объединённой компании составит менее 10 %. «Это приобретение ускоряет реализацию нашей стратегии по масштабированию рабочих нагрузок ИИ и HPC», — заявил Майкл Интратор (Michael Intrator), генеральный директор, председатель совета директоров и соучредитель CoreWeave. После объявления о сделке, акции CoreWeave упали на 4,4 % в ходе предварительных торгов в Нью-Йорке, пишет Bloomberg. Акции Core Scientific потеряли в цене 14 %. Core Scientific, как и сама CoreWeave, ранее предлагавшая услуги майнинга, сейчас на фоне дефицита мощностей ЦОД и сложности с их обеспечением электроэнергии из-за бума ИИ-технологий решила выйти за рамки криптовалютного рынка. Согласно прогнозу JPMorgan от октября прошлого года, у криптомайнеров осталось всего девять месяцев, чтобы переключиться на ИИ.

Источник изображения: Core Scientific Согласно пресс-релизу CoreWeave, компания рассчитывает получить значительную экономию средств путём оптимизации бизнес-операций и устранения накладных расходов на аренду ЦОД. Также отмечено, что возможности создания дата-центров Core Scientific дополняют и расширяют обширный опыт CoreWeave в области закупок электроэнергии и земли, строительства и управления инфраструктурными активами. Попутно CoreWeave сокращает зависимость от других колокейшн-партнёров. Как отметил ресурс The Register, у Core Scientific есть десять кампусов ЦОД разной степени готовности в Алабаме, Джорджии, Кентукки, Северной Каролине, Северной Дакоте, Оклахоме и Техасе. Около 500 МВт из 1,3 ГВт имеющихся у Core Scientific мощностей ЦОД в настоящее время потребляются майнинговыми установками. Ещё 590 МВт было выделена CoreWeave в аренду. Провайдеры облачной инфраструктуры спешат расширять свои ЦОД, чтобы идти в ногу со спросом на вычислительные мощности компаний в сфере ИИ, отметил Bloomberg. На прошлой неделе ресурс сообщил, что Oracle дополнительно арендует у Oracle 4,5 ГВт мощностей ЦОД в США. В свою очередь, CoreWeave заключила в начале июня соглашение с Applied Digital об аренде сроком на 15 лет 250 МВт ЦОД за $7 млрд в кампусе в Эллендейле (Ellendale, Северная Дакота). Ещё 200 МВт CoreWeave получила от Galaxy Digital, которая тоже отказалась от криптомайнинга.

05.07.2025 [02:13], Владимир Мироненко

CoreWeave первой в отрасли развернула кластер на базе NVIDIA GB300 NVL72Облачный провайдер CoreWeave объявил о первом в отрасли развёртывании кластера на базе передовой платформы NVIDIA GB300 NVL72, размещённой в интегрированной стоечной системе, поставленной Dell. Развёртыванием кластера занимался оператор ЦОД Switch. Dell заявила, что стоечные системы поставляются собранными и протестированными. Они изначально разработаны для быстрой установки и развёртывания. GB300 NVL72 в исполнении Dell представляет собой интегрированное стоечное решение на базе серверов PowerEdge XE9712 с жидкостным охлаждением, которое объединяет 72 ускорителя NVIDIA Blackwell Ultra, 36 Arm-процессоров NVIDIA Grace на базе Arm-архитектуры, интерконнект NVLink и 18 или 36 DPU NVIDIA BlueField-3 в одну мощную платформу, использующую в работе широкий спектр передовых решений NVIDIA. Каждая стойка GB300 NVL72 оснащена 21 Тбайт HBM3E и 40 Тбайт RAM. В решении используются 800G-сеть с коммутаторами Quantum-X800 InfiniBand и адаптерами ConnectX-8 SuperNIC. Каждая стойка GB300 NVL72 обеспечивает производительность 1,1 Эфлопс в FP4-вычислениях для инференса и 0,36 Эфлопс в FP8 (без разреженности) для обучения, что на 50 % выше по сравнению с GB200 NVL72. Программная инфраструктура NVIDIA DOCA, работающая на NVIDIA BlueField-3, ускоряет рабочие нагрузки ИИ, обеспечивая пользователям скорость сети до 200 Гбит/с и высокопроизводительный доступ к данным ускорителей. Как отметила CoreWeave, новое оборудование означает для клиентов значительный рост производительности при обработке рабочих нагрузок рассуждающих ИИ-моделей.

30.06.2025 [09:52], Руслан Авдеев

CoreWeave снова пытается купить оператора ЦОД Core Scientific, от которого зависит бизнес компанииCoreWeave рассчитывает купить оператора ЦОД Core Scientific, клиентом которого она является. От Core Scientific зависит работа облачной платформы CoreWeave, сообщает Silicon Angle. CoreWeave впервые попыталась купить оператора год назад, предложив $1 млрд, но в итоге стороны несколько раз продляли и расширяли контракты. Это партнёрство может сыграть злую шутку, поскольку сам факт тесного сотрудничества с CoreWeave поднимает цену Core Scientific — акции оператора на фоне сообщений о сделке уже выросли в цене на 30 %. Впрочем, и сама CoreWeave за это время значительно выросла и даже вышла на биржу. Core Scientific была основана в 2017 году для майнинга биткоинов. На биржу она вышла в начале 2022 года, но всего через несколько месяцев подала заявку о банкротстве, чтобы избежать полной ликвидации компании, обойдясь её реструктуризацией. В январе 2024 года Core Scientific вышла из банкротства и переключилась на создание и эксплуатацию ИИ ЦОД. Приблизительно в то же время она заключила первую сделку с CoreWeave. Изначально CoreWeave арендовала 15 МВт ЦОД в Остине (Техас), но с тех пор договор расширили до 590 МВт на шести площадках. Как сообщают в самой Core Scientific, её контракты с облачным провайдером должны принести более $10 млрд в следующие 12 лет. Это довольно внушительная сумма, поэтому CoreWeave, возможно, попытается профинансировать покупку акциями, чтобы не увеличивать долговую нагрузку. На конец декабря 2024 года компания имела около $8 млрд долгов, но с тех пор рефинансировала часть долга. Если сделка по покупке Core Scientific будет закрыта, это будет уже второе крупное приобретение CoreWeave с начала 2025 года. Ранее компания купила за $1,7 млрд поставщика ИИ-инструментов Weights & Biases за $1,7 млрд и интегрировала его решения в своё облако. Сейчас CoreWeave работает над обновлением как программных средств, так и инфраструктуры. В апреле 2025 года компания объявила о скором доступе к тысячам ускорителей NVIDIA Blackwell B200.

03.06.2025 [13:31], Руслан Авдеев

Applied Digital сдаст CoreWeave 250-МВт ЦОД в Северной Дакоте на 15 лет за $7 млрдОператор дата-центров Applied Digital заключил с компанией CoreWeave соглашение сроком на 15 лет. В соответствии с договором последняя арендует 250 МВт в кампусе Polaris Forge 1 в Эллендейле (Ellendale, Северная Дакота), сообщает Datacenter Dynamics. Предполагается, что сделка принесёт Applied Digital около $7 млрд за 15 лет. В рамках соглашения CoreWeave сохранит возможность получить доступ к ещё 150 МВт критической IT-нагрузки в Эллендейле. Первые 100 МВт достанутся CoreWeave в IV квартале 2025 года. Второй дата-центр на 150 МВт пока строится и должен заработать в середине 2026-го. Если CoreWeave будет претендовать на третий дата-центр (150 МВт), то он будет доступен для в 2027 году. Как завили в Applied Digital, поскольку спрос на ИИ постоянно увеличивается, компания может получить значительную финансовую отдачу при поддержке данного, быстро развивающегося сектора. CoreWeave рассматривается как идеальный партнёр для масштабирования роста и инноваций компании. Applied Digital (ранее Applied Blockchain) не занимается майнингом биткоинов, но традиционно размещает у себя на объектах оборудование криптомайнинговых компаний. Как и с другими криптобизнесами, компания в последнее время переориентирует часть своих мощностей для работы с HPC- и ИИ-оборудованием на фоне большого спроса.

Источник изображения: Linhao Zhang/unsplash.com Кампус в Эллендейле начали строить в сентябре 2022 года. Площадка была рассчитана на 400 МВт IT-нагрузки. Компания заявляет, что на участке есть потенциал для развёртывания более чем 1 ГВт, часть мощностей уже находится на разных стадиях проектирования и согласования. Помимо Эллендейла, компания располагает объектом JMS01 в Джеймстауне, расположенном в том же штате. Также она планирует ввести в эксплуатацию кампус на 200 МВт в Айове. Applied Digital привлекла $375 млн для кампуса в Эллендейле в феврале 2025 года, а в мае сообщалось, что компания предложила построить «многомиллиардный» ЦОД в Торонто (Toronto, Южная Дакота), который сможет обеспечить до 430 МВт мощности. В сентябре 2024 года сообщалось, что NVIDIA и другие инвесторы вложили в Applied Digital $160 млн. Ещё $5 млрд в проекты Applied Digital намерена вложить австралийская Macquarie. CoreWeave основана в 2017 году и занималась криптобизнесом, но позже переориентировалась на облачные ИИ-сервисы. В конце 2024 года компания распоряжалась 32 дата-центрами, оснащёнными более 250 тыс. ИИ-ускорителей и более 360 МВт «активной мощности». С 28 марта акции компании торгуются на Nasdaq. Они были предложены по цене $40 за штуку, что позволило компании привлечь $1,5 млрд, хотя изначально обсуждалась более высокая сумма — $5,5 млрд. В числе провайдеров ЦОД, обслуживающих CoreWeave — Lincoln, Chirisa, Flexential, TierPoint, Digital Realty, Switch, DataBank, Galaxy Digital и Core Scientific. Две последние компании модернизируют бывшие криптомайнинговые дата-центры под ИИ-задачи.

18.05.2025 [14:23], Сергей Карасёв

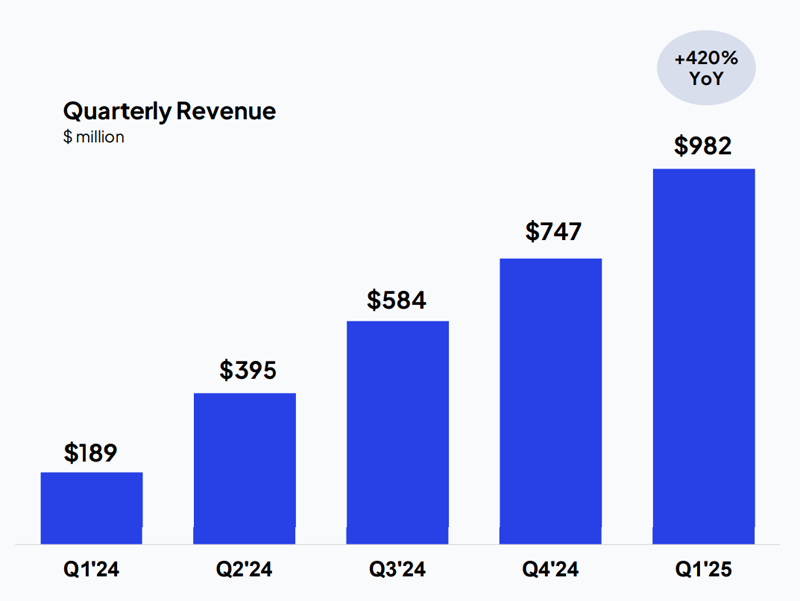

Квартальная выручка CoreWeave взлетела в пять раз, но компания продолжает нести убыткиКомпания CoreWeave отчиталась о работе в I квартале 2025 года. Выручка поставщика облачных услуг для ИИ-задач составила $981,6 млн: это на 420 %, то есть, примерно в пять раз больше по сравнению с результатом за аналогичный период предыдущего года, когда было получено $188,7 млн. Операционные расходы CoreWeave за трёхмесячный период взлетели на 487 % — со $171,8 млн до $1,0 млрд. Часть этой суммы отнесена к единовременным затратам на компенсацию в виде акций в результате завершения первичного публичного размещения (IPO) в конце марта. В ходе этой процедуры компания привлекла $1,5 млрд, хотя изначально планировалось получить до $2,7 млрд. В результате, капитализация CoreWeave оказалась на уровне $19 млрд. По итогам квартала зарегистрированы чистые убытки в размере $314,6 млн, или $1,49 в пересчёте на одну ценную бумагу. Для сравнения: годом ранее убытки компании составляли $129,2 млн, или $0,62 на акцию. Таким образом, чистые потери увеличились на 143 %. На этом фоне стоимость акций CoreWeave упала более чем на 5 %.

Источник изображения: CoreWeave Вместе с тем скорректированный показатель EBITDA (прибыль до вычета процентов, налогов и амортизационных отчислений) достиг $606,1 млн, что на 480 % больше прошлогоднего значения ($104,5 млн). Скорректированная операционная прибыль за I квартал 2025 года составила $162,6 млн против $25,0 млн годом ранее, что соответствует росту на 550 %. В отчёте сказано, что на сегодняшний день CoreWeave оперирует 33 дата-центрами по всей Европе и США. Активная мощность составляет 420 МВт, законтрактованная — 1,6 ГВт. В частности, в течение квартала компания добавила 300 МВт дополнительной контрактной мощности в свой актив: подписаны соглашения с Flexential, Galaxy Digital и Bulk Infrastructure. Кроме того, CoreWeave заключила ряд крупных сделок: достигнут новый договор с OpenAI на сумму $4 млрд до 2029 года. Во II квартале текущего года CoreWeave рассчитывает получить от $1,06 млрд до $1,1 млрд выручки и показать скорректированную операционную прибыль в размере $140–$170 млн. По итогам года в целом, как ожидается, выручка окажется в диапазоне от $4,9 млрд до $5,1 млрд, скорректированная операционная прибыль — от $800 млн до $830 млн.

16.05.2025 [18:25], Руслан Авдеев

Обойдёмся без Microsoft: OpenAI заключила сделку с CoreWeave на $4 млрдКомпания CoreWeave заключила очередную сделку с OpenAI на сумму $4 млрд до 2029 года. По данным Bloomberg, в недавнем финансовом отчёте компания отчиталась о новом соглашении «с крупным предприятием в сфере ИИ», но имя партнёра не называлось. Ранее компании OpenAI уже подписала с CoreWeave сделку на $11,9 млрд, предусматривающую использование вычислительных мощностей последней. Эта сделка не вошла в перечень текущих обязательств CoreWeave (RPO). Партнёрство двух компаний поможет CoreWeave диверсифицировать клиентскую базу, а OpenAI — сократить зависимость от Microsoft, а также собственного ИИ-проекта Stargate с участием SoftBank и Oracle. Впрочем, дело несколько сложнее, потому что якорным заказчиком CoreWeave, обеспечивающим 62 % выручки, была сама Microsoft, которая арендовала ресурсы в интересах OpenAI. Вторым по величине клиентом была NVIDIA. Ходили слухи, что в Microsoft намерены сократить расходы, но в CoreWeave информацию опровергали — ранее речь шла о контракте стоимостью $10 млрд. Ранее эксклюзивным поставщиком облачных сервисов для OpenAI была Microsoft, вложившая в компанию с 2019 года $19 млрд, но в 2024 году было объявлено, что OpenAI будет работать и с Oracle, правда, при посредничестве той же Microsoft. По данным Datacenter Dynamics, после анонса Stargate компании «выяснили отношения» и Microsoft получила почётное звание «ключевого первоначального технологического партнёра», но не получила доли в бизнесе в отличие от Oracle, SoftBank и арабской MGX. Microsoft подтвердила, что партнёрство более не является эксклюзивным, хотя у компании остаётся право «преимущественного выбора» (ROFR). В начале мая The Financial Times заявляла, что условия сотрудничества пересматриваются, а основные разговоры ведутся о том, какую долю должна получить в капитале OpenAI компания Microsoft в обмен на прошлые инвестиции. Источники заявляют также и о пересмотре условий контракта, заключённого компаниями ещё в 2019 году. По имеющимся данным, Microsoft готова отказаться от части доли в будущей коммерческой компании в обмен на доступ передовым к технологиям OpenAI, разработанным после 2030 года, когда текущий контракт закончится. Как сообщают некоторые источники, во многом проблема связана с «высокомерием» OpenAI, желающей денег, но также требующей не вмешиваться в рабочие процессы — Microsoft якобы должна радоваться самому факту такого сотрудничества. Впрочем, по словам близкого к OpenAI источника, Microsoft по-прежнему заинтересована в превращении последней в коммерческую структуру, хотя впереди предстоят сложные переговоры. |

|