Материалы по тегу: aws

|

01.12.2023 [15:52], Руслан Авдеев

AWS представила корпоративную систему биометрической идентификации Amazon One Enterprise — через 3 года после дебюта Amazon One для магазиновAWS представила корпоративную версию системы биометрической идентификации Amazon One Enterprise. Новый сервис основан на решении Amazon One, которое появилось в 2020 году. Оно используется для биометрических платежей в собственных магазинах Amazon, не имеющих кассиров. Посетители Amazon Go могут привязать данные банковской карты к информации об отпечатке ладони. Хотя технология, как это обычно бывает с такими решениями, вызвала опасения среди правозащитников и политиков в связи с возможной утечкой данных, компания продолжила внедрять её, предлагая клиентам различные льготы. Сервис уже появился во всех магазинах сети Whole Foods, принадлежащей Amazon, в США. Также компания заключила соглашения и со сторонними ретейлерами. Проект Amazon One Enterprise стал закономерным развитием предыдущей инициативы. Несмотря на повсеместный переход на удалённую работу, многие компании всё ещё хотят видеть своих сотрудников в офисах хотя бы время от времени. Amazon One Enterprise обеспечивает бесконтактную идентификацию для доступа на такие объекты. Более того, технологию можно использовать и для всевозможного ПО с разграничением доступа, например, для защиты доступа к кадровой или финансовой информации. Заказчикам предлагается на выбор два вида устройств: отдельный модуль, который можно разместить где угодно, и турникет. Возможно совместное использование биометрической идентификации с традиционными средствами, т.е. карточками, PIN-кодами и паролями. AWS подчёркивает, что Amazon One Enterprise отличается от решений для магазинов уровнем обеспечения безопасности. В частности, коллекция отпечатков ладоней сохраняется в облаке AWS отдельно для каждой компании. С помощью точно такого же устройства пользователь может удалить свои данные, а если в течение двух лет он не проявлял никакой активности, данные будут удалены автоматически.

01.12.2023 [12:02], Сергей Карасёв

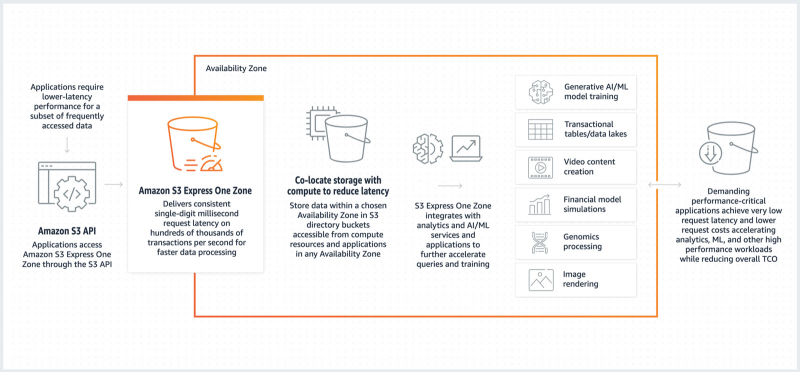

В AWS появилось высокопроизводительное S3-хранилище Express One Zone с миллисекундными задержкамиОблачная платформа AWS объявила о доступности Amazon S3 Express One Zone — нового высокопроизводительного объектного хранилища. Утверждается, что решение обеспечивает в 10 раз более высокую производительность по сравнению со стандартной версией S3, что позволяет ускорить работу приложений с интенсивным использованием данных. Каждая корзина Amazon S3 Express One Zone располагается в определённой локальной зоне, выбранной заказчиком. Там же могут находиться вычислительные ресурсы (EC2, ECS, EKS), что обеспечивает минимальные задержки при обработке запросов. AWS заявляет, что S3 Express One Zone не только быстрее стандартного хранилища S3, но и обеспечивает значительную экономию средств. Утверждается, что стоимость запросов на 50 % ниже по сравнению с обычным хранилищем S3.

Источник изображений: AWS Утверждается, что хранилище Amazon S3 Express One Zone может обслуживать сотни тысяч запросов в секунду с постоянной задержкой, которая измеряет миллисекундами. Сервис способен обрабатывать объекты любого размера, но наибольшая эффективность достигается при работе с небольшими блоками. Доступ к хранилищу можно получить посредством стандартного набора API. Корзины поддерживают заданный набор функций, включая загрузку и копирование файлов по частям (multi-part upload/copy), предварительно назначенные URL-адреса и анализатор доступа. По заявлениям AWS, решение отлично подходит для создания масштабных ИИ-моделей, которым требуется доступ к наборам обучающих данных миллионы раз в минуту. Кроме того, могут решаться ресурсоёмкие задачи в сферах финансового моделирования, обработки мультимедийного контента, формирования и размещения рекламы в реальном времени и пр. Такие приложения обычно хранят данные в течение относительно короткого периода времени, но в течение этого срока обращаются к ним очень часто.

30.11.2023 [15:09], Владимир Мироненко

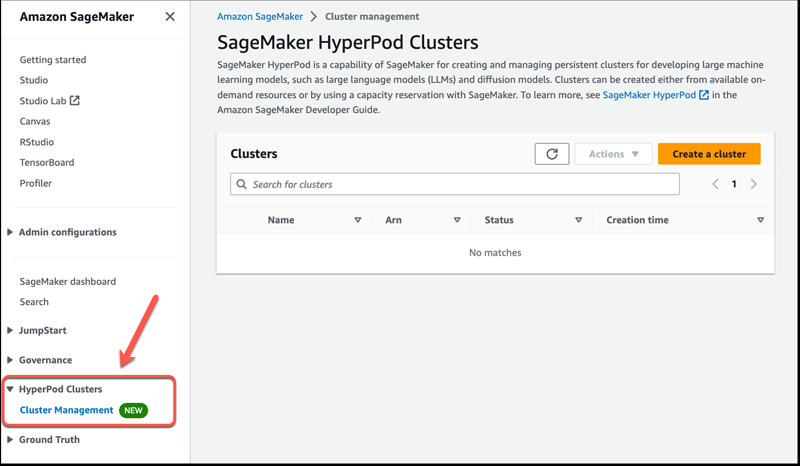

Amazon SageMaker HyperPod обеспечит бесперебойное обучение базовых моделейAmazon Web Services представила сервис Amazon SageMaker HyperPod для обучения и точной настройки больших языковых моделей (LLM). Новинка обеспечивает распределённое обучение для больших обучающих кластеров ИИ, оптимизированное использование вычислительных ресурсов, памяти и сетевых ресурсов кластера, а также гибкую среду обучения, исключающую перерывы. Базовые модели ИИ (FM, foundation model) зачастую слишком сложны, поэтому их обучение приходится проводить на нескольких ускорителях, что является технически сложной задачей, требует узкоспециализированных навыков и может занять недели или месяцы в зависимости от количества задействованного оборудования. При этом возрастает вероятность сбоев, таких как единичный отказ ускорителя. Эти сбои могут нарушить весь процесс обучения и потребовать ручного вмешательства для выявления, изоляции, отладки, устранения неполадок и восстановления после них, что ещё больше задержит процесс обучения. Для бесперебойного обучения модели разработчики должны постоянно сохранять прогресс обучения с помощью контрольных точек, что ещё больше увеличивает временные затраты и отдаляет вывод решения на рынок. SageMaker HyperPod обеспечивает доступ к ИИ-кластерам по требованию. Разработчики могут подготовить кластер с помощью комбинации команд и простых сценариев, что значительно быстрее, чем настройка инфраструктуры вручную. По словам AWS, SageMaker HyperPod может сократить время, необходимое для обучения базовых моделей, более чем на треть.

Изображение: AWS HyperPod предварительно сконфигурирован с использованием распределённых обучающих библиотек SageMaker, которые позволяют автоматически распределять учебные нагрузки между тысячами ускорителей. SageMaker также разделяет данные, на которых обучается модель, на более мелкие и более управляемые части. Hyperpod гарантирует непрерывность обучения моделей и периодическое создание контрольных точек. Когда во время обучения происходит аппаратный сбой, SageMaker HyperPod автоматически обнаруживает его, восстанавливает или заменяет неисправный инстанс и возобновляет обучение с последней контрольной точки, устраняя необходимость в ручном управлении этим процессом и позволяя проводить обучение в распределённой среде без сбоев в течение длительного времени. Вместе с тем клиенты с повышенными требованиями имеют возможность использовать собственный распределённый код для обучения. AWS также предоставляет возможность оснастить ИИ-кластер другими программными компонентами, такими как инструменты отладки. SageMaker HyperPod уже доступен в облачных регионах AWS в Огайо, Северной Вирджинии, Орегоне, Сингапуре, Сиднее, Токио, Франкфурте, Ирландии и Стокгольме.

29.11.2023 [22:43], Владимир Мироненко

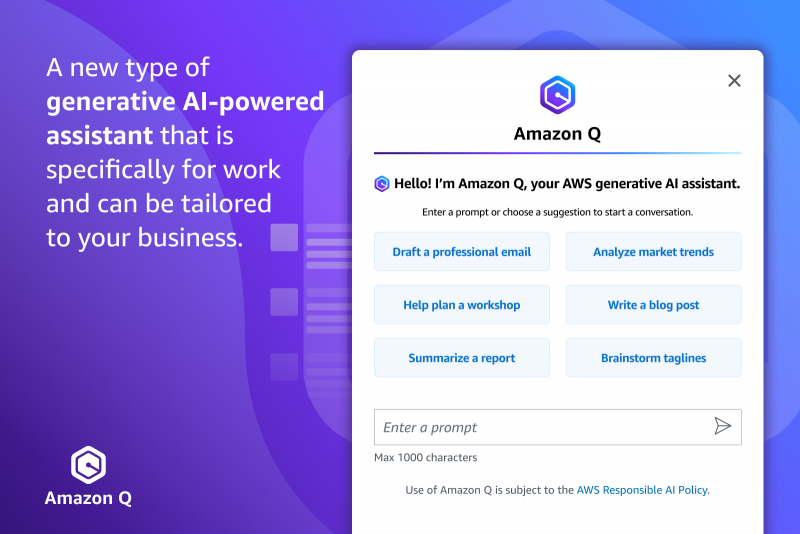

ИИ-ассистент Amazon Q упростит работу IT-специалистов, разработчиков и корпоративных клиентов AWSКомпания Amazon Web Services представила интеллектуального ассистента Amazon Q на базе генеративного ИИ, предназначенного для помощи корпоративным клиентам. Поначалу Amazon Q будет использоваться для нужд разработчиков и поддержки IT-команд. Amazon Q уже доступен в виде превью, причем многие функции бесплатны. В дальнейшем AWS будет брать по $20/мес. за каждого пользователя, а версия с дополнительными функциями для ИТ-специалистов будет стоить $25/мес. «Amazon Q может помочь вам получать быстрые и актуальные ответы на насущные вопросы, решать проблемы, генерировать контент и предпринимать действия, используя данные и опыт, найденные в информационных репозиториях, коде и корпоративных системах вашей компании», — сообщил гендиректор Amazon. Глава AWS считает, что Amazon Q реформирует множество видов деятельности. ИИ-помощник разработан с учётом 17-летнего опыта работы самой AWS и поначалу будет доступен именно внутри экосистемы AWS. Хотя Amazon Q в первую очередь нацелен на разработчиков и ИТ-специалистов, компания планирует в конечном итоге распространить его возможности на весь корпоративный сегмент. Подобно другим ИИ-помощникам он сможет подключаться к различным источникам данных, отвечать на вопросы и составлять резюме, а также предоставлять экспертные сведения или помощь на основе внутренней информации компании. Это потенциально может сделать его конкурентом ChatGPT Enterprise от OpenAI, Copilot for 365 от Microsoft и Duet AI for Workspace от Google. Специалисты смогут получить доступ Amazon Q из консоли AWS. Q расскажет, как использовать сервисы, какие API доступны, к каким сервисам можно подключиться и как они взаимодействуют между собой. Пользователь сможет создавать запросы на естественном языке, а Q подготовит экспертный ответ со ссылками и цитатами. Так, в EC2-консоли Amazon Q даст совет, какой тип инстанса лучше всего подходит для размещения определённого типа приложений в зависимости в зависимости от потребностей клиента. А если возникла проблема с сетью, у Q можно напрямую спросить: «Почему я не могу подключиться по SSH к своему инстансу?». В этом случае помощник подключит его к сетевому анализатору, чтобы устранить неполадки с соединением. AWS интегрировала ИИ-ассистента в поддерживаемые IDE вместе с ИИ-инструментом Amazon CodeWhisperer, так что с Q можно пообщаться непосредственно во время разработки. Например, Amazon Q может разобрать и описать исходный код незнакомого проекта или же в диалоговом режиме в Amazon CodeCatalyst поможет создать новый код, опираясь на описание необходимой функциональности и учитывая лучшие практики, а также имеющуюся кодовую базу и бизнес-сведения. Наконец, функция Amazon Q Transformation, доступная в виде превью для IntelliJ IDEA и Visual Studio Code, позволит автоматизировать обновление кода приложений с Java 8 и 11 до версии 17. А вскоре Q научится преобразовывать .NET-приложения для Windows в кросс-платформенные.

29.11.2023 [13:02], Сергей Карасёв

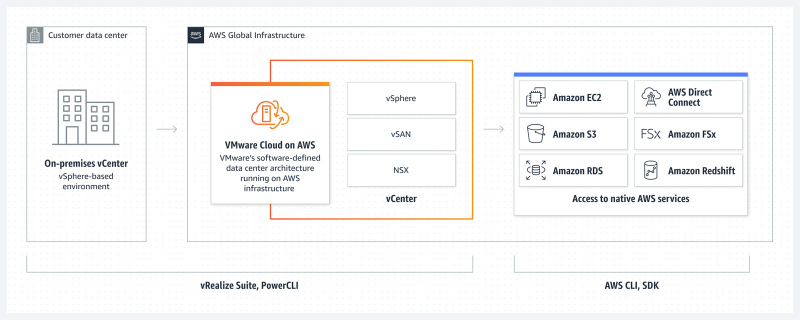

Для VMware Cloud on AWS стали доступны инстансы M7i bare metalКомпания VMware объявила о том, что для платформы VMware Cloud on AWS реализована поддержка инстансов Amazon EC2 M7i bare-metal (m7i.metal-24xl) на базе кастомных Intel Xeon Sapphire Rapids. Конфигурация включает 96 vCPU и около 414 Гбайт памяти. Решение, как отмечается, поможет клиентам ускорить миграцию в облако и модернизацию корпоративных приложений. VMware Cloud on AWS позволяет работать с ПО VMware для программно-определяемых центров обработки данных (SDDC) корпоративного класса в облаке AWS, используя оптимизированный доступ к собственным сервисам AWS. Платформа создана на основе VMware Cloud Foundation. Сервис совмещает решения для вычислений, хранения данных и виртуализации сети (VMware vSphere, VMware vSAN и VMware NSX), а также инструменты управления VMware vCenter Server, оптимизированные для работы в выделенной эластичной инфраструктуре AWS. VMware Cloud on AWS предоставляет однопользовательскую среду с поддержкой от 4 до 16 хостов на каждый кластер vSphere. Объединив M7i bare metal с томами Amazon FSx для NetApp ONTAP и VMware Cloud Flex Storage, клиенты могут расширять хранилище по мере необходимости независимо от вычислительных мощностей, чтобы максимизировать использование ресурсов. Для рабочих нагрузок с интенсивным вводом-выводом, требующих высокой производительности и низких задержек, заказчики могут продолжать использовать существующие экземпляры i3en и i4i с гиперконвергентной архитектурой. В целом, благодаря M7i bare metal пользователи VMware Cloud on AWS смогут ускорить перенос нагрузок в облако, сократить время восстановления после сбоев и атак программ-вымогателей, а также повысить эффективность развёртывания приложений ИИ и машинного обучения при снижении совокупной стоимости владения, сообщает компания.

29.11.2023 [03:43], Владимир Мироненко

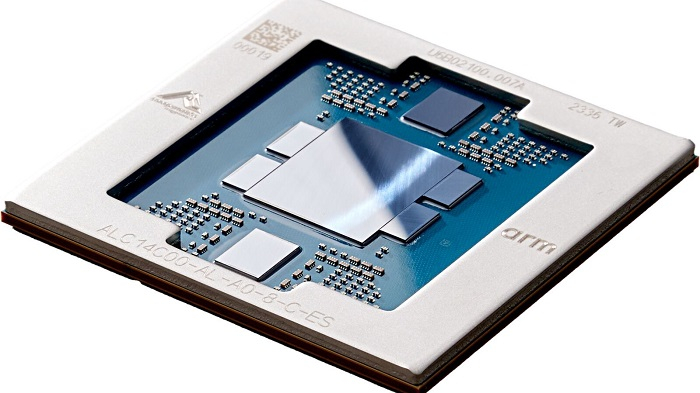

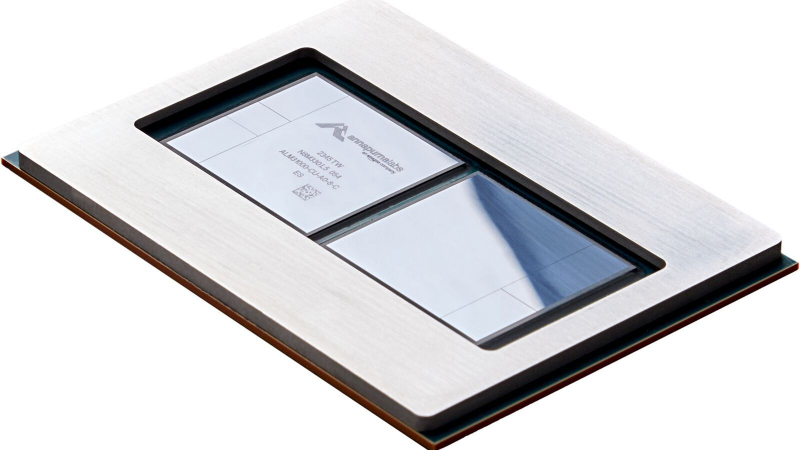

AWS представила 96-ядерный Arm-процессор Graviton4 и ИИ-ускоритель Trainium2Amazon Web Services представила Arm-процессор нового поколения Graviton4 и ИИ-ускоритель Trainium2, предназначенный для обучения нейронных сетей. Всего к текущему моменту компания выпустила уже 2 млн Arm-процессоров Graviton, которыми пользуются более 50 тыс. клиентов. «Graviton4 представляет собой четвёртое поколение процессоров, которое мы выпустили всего за пять лет, и это самый мощный и энергоэффективный чип, который мы когда-либо создавали для широкого спектра рабочих нагрузок», — отметил Дэвид Браун (David Brown), вице-президент по вычислениям и сетям AWS. По сравнению с Graviton3 новый чип производительнее на 30 %, включает на 50 % больше ядер и имеет на 75 % выше пропускную способность памяти. Graviton4 будет иметь до 96 ядер Neoverse V2 Demeter (2 Мбайт L2-кеша на ядро) и 12 каналов DDR5-5600. Кроме того, новый чип получит поддержку шифрования трафика для всех своих аппаратных интерфейсов. Процессор изготавливается по 4-нм техпроцессу TSMC и, вероятно, имеет чиплетную компоновку. Возможно, это первый CPU компании, ориентированный на работу в двухсокетных платформах. Поначалу Graviton4 будет доступен в инстансах R8g (пока в статусе превью), оптимизированных для приложений, интенсивно использующих ресурсы памяти — высокопроизводительные базы данных, in-memory кеши и Big Data. Эти инстансы будут поддерживать более крупные конфигурации, иметь в три раза больше vCPU и в три раза больше памяти по сравнению с инстансами Rg7, которые имели до 64 vCPU и 512 Гбайт ОЗУ. В свою очередь, Trainium 2 предназначен для обучения больших языковых моделей (LLM) и базовых моделей. Сообщается, что ускоритель в сравнении с Trainium 1 вчетверо производительнее и при этом имеет в 3 раза больший объём памяти и в 2 раза более высокую энергоэффективность. Инстансы EC2 Trn2 получат 16 ИИ-ускорителей с возможностью масштабирования до 100 тыс. единиц в составе EC2 UltraCluster, которые суммарно дадут 65 Эфлопс, то есть по 650 Тфлопс на ускоритель. Как утверждает Amazon это позволит обучать LLM с 300 млрд параметров за недели вместо месяцев. Со временем на Graviton4 заработает SAP HANA Cloud, портированием и оптимизацией этой платформы уже занимаются. Oracle также перенесла свою СУБД на Arm, а заодно перевела все свои облачные сервисы на чипы Ampere, в которую в своё время инвестировала. Microsoft же пошла по пути AWS и недавно анонсировала 128-ядерый Arm-процессор (Neoverse N2) Cobalt 100 и ИИ-ускоритель Maia 100 собственной разработки. Всё это может представлять отдалённую угрозу для AMD и Intel. С NVIDIA же все всё равно пока что продолжают дружбу — именно в инфраструктуре AWS, как ожидается, появится самый мощный в мире ИИ-суперкомпьютер на базе новых GH200.

28.11.2023 [22:20], Игорь Осколков

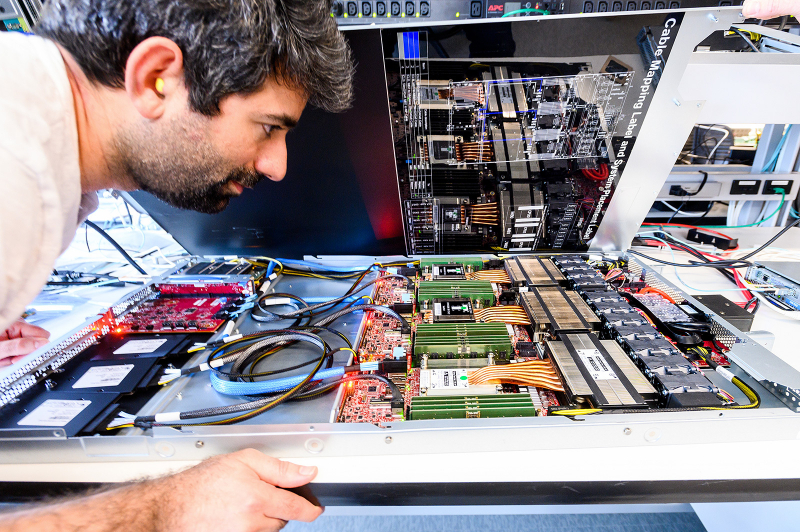

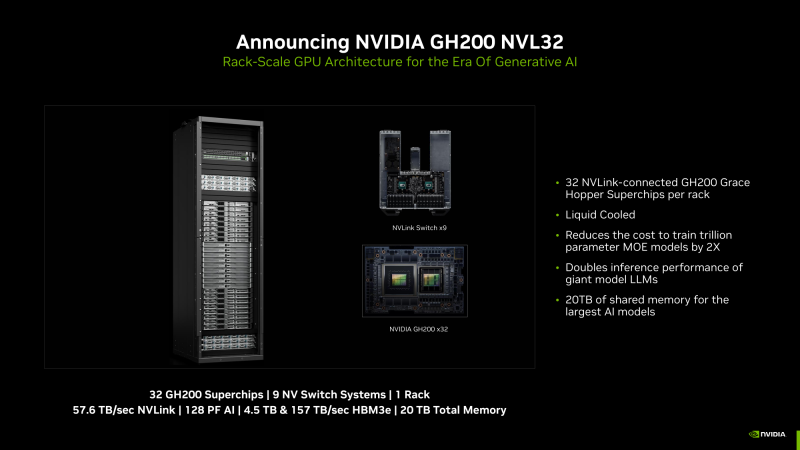

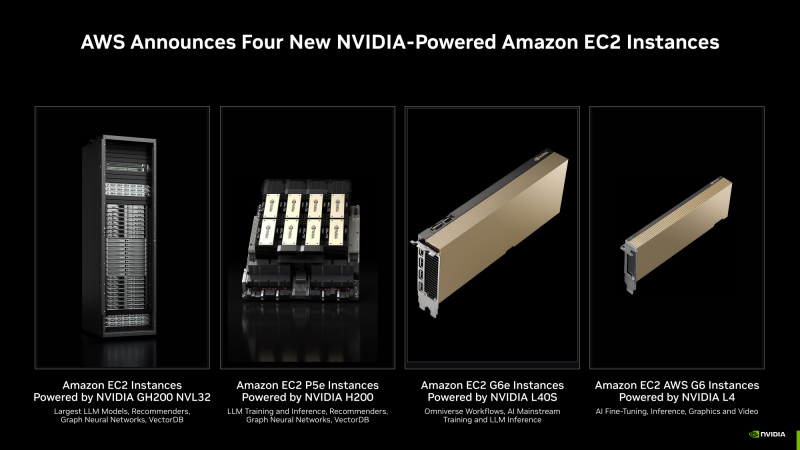

NVIDIA анонсировала суперускоритель GH200 NVL32 и очередной самый мощный в мире ИИ-суперкомпьютер Project CeibaAWS и NVIDIA анонсировали сразу несколько новых совместно разработанных решений для генеративного ИИ. Основным анонсом формально является появление ИИ-облака DGX Cloud в инфраструктуре AWS, вот только облако это отличается от немногочисленных представленных ранее платформ DGX Cloud тем, что оно первом получило гибридные суперчипах GH200 (Grace Hoppper), причём в необычной конфигурации.

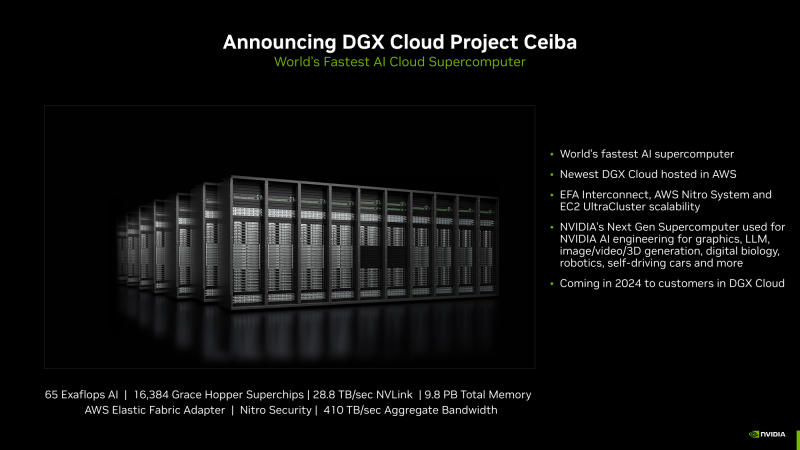

Изображения: NVIDIA В основе AWS DGX Cloud лежит платформа GH200 NVL32, но это уже не какой-нибудь сдвоенный акселератор вроде H100 NVL, а целая, готовая к развёртыванию стойка, включающая сразу 32 ускорителя GH200, провязанных 900-Гбайт/с интерконнектом NVLink. В состав такого суперускорителя входят 9 коммутаторов NVSwitch и 16 двухчиповых узлов с жидкостным охлаждением. По словам NVIDIA, GH200 NVL32 идеально подходит как для обучения, так и для инференса действительно больших LLM с 1 трлн параметров. Простым перемножением количества GH200 на характеристики каждого ускорителя получаются впечатляющие показатели: 128 Пфлопс (FP8), 20 Тбайт оперативной памяти, из которых 4,5 Тбайт приходится на HBM3e с суммарной ПСП 157 Тбайтс, и агрегированная скорость NVLink 57,6 Тбайт/с. И всё это с составе одного EC2-инстанса! Да, новая платформа использует фирменные DPU AWS Nitro и EFA-подключение (400 Гбит/с на каждый GH200). Новые инстансы, пока что безымянные, можно объединять в кластеры EC2 UltraClasters. Одним из таких кластеров станет Project Ceiba, очередной самый мощный в мире ИИ-суперкомпьютер с FP8-производительность 65 Эфлопс, объединяющий сразу 16 384 ускорителя GH200 и имеющий 9,1 Пбайт памяти, а также агрегированную пропускную способность интерконнекта на уровне 410 Тбайт/с (28,8 Тбайт/с NVLink). Он и станет частью облака AWS DGX Cloud, которое будет доступно в начале 2024 года. В скором времени появятся и EC2-инстансы попроще: P5e с NVIDIA H200, G6e с L40S и G6 с L4.

28.11.2023 [16:28], Владимир Мироненко

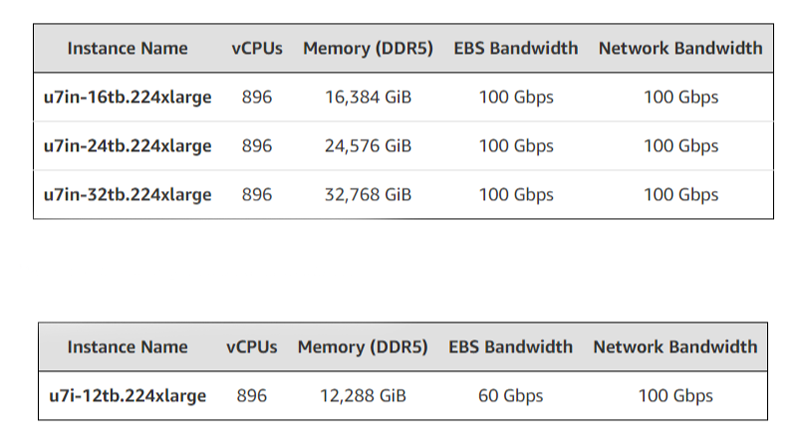

896 vCPU и 32 Тбайт RAM: AWS анонсировала самые крупные инстансы EC2 U7i для in-memory баз данныхОблачная платформа AWS представила инстансы Amazon EC2 U7i, предназначенные для поддержки крупных in-memory СУБД, включая SAP HANA, Oracle и SQL Server. Новые инстансы используют кастомные процессоры Intel Xeon Sapphire Rapids и обеспечивают по сравнению с инстансами EC2 High Memory первого поколения до 125 % большую вычислительную производительность и до 120 % большую производительность памяти. EC2 U7i также обеспечивают в 2,5 раза большую пропускную способность EBS-томов, позволяя наполнять базы данных in-memory со скоростью до 44 Тбайт/час. Инстанс U7i поддерживает подключение до 128 томов EBS gp2/gp3 или io1/io2. Каждый том io2 Block Express может иметь размер до 64 ТиБ и обеспечивать производительность до 256 тыс. IOPS со скоростью до 32 Гбит/с.  Инстансы поддерживают адаптеры ENA Express, обеспечивающем пропускную способность до 25 Гбит/с на каждый сетевой поток. Всего же каждый инстанс может получить 100-Гбит/с подключение для работы с сетью и EBS. Максимальная конфигурация включает 896 vCPU и 32768 ГиБ оперативной памяти. В число поддерживаемых U7i операционных систем входят Red Hat Enterprise Linux и SUSE Enterprise Linux Server. Инстансы U7i в виде превью доступны в регионах US West (Орегон), Азиатско-Тихоокеанском (Сеул) и Европейском (Франкфурт).

28.11.2023 [15:27], Сергей Карасёв

AWS и Kyndril помогут предприятиям во внедрении решений на основе генеративного ИИОблачная платформа Amazon Web Services (AWS) и компания Kyndryl, бывшее подразделение IBM, объявили о заключении многолетнего соглашения о сотрудничестве. Партнёры помогут корпоративным заказчикам в создании и внедрении решений на базе генеративного ИИ и передовых средств машинного обучения. Предполагается, что сотрудничество позволит клиентам AWS и Kyndril ускорить цифровую трансформацию, повысить эффективность работы и задействовать инновационные решения в рамках своего бизнеса.

Источник изображения: pixabay.com По условиям соглашения, Kyndril и AWS создадут площадку Innovation Factory для совместной разработки решений на основе генеративного ИИ и машинного обучения, ориентированных на конкретные сценарии использования. Данная инициатива призвана помочь заказчикам в модернизации облачной стратегии. Кроме того, партнёрство нацелено на расширение возможностей Kyndril по проектированию, внедрению, миграции, улучшению и управлению облачными сервисами AWS в комплексных IT-средах. Стороны помогут ускорить модернизацию систем планирования ресурсов предприятия и других приложений на площадке AWS: это позволит сократить финансовые и временные затраты. Kyndril также сможет увеличить количество своих сотрудников, имеющих сертификаты AWS, что поможет ускорить реализацию проектов по миграции рабочих нагрузок клиентов в облако и по развёртыванию сервисов генеративного ИИ.

27.11.2023 [19:40], Руслан Авдеев

AWS представила тонкий клиент Amazon WorkSpaces Thin Client на базе ТВ-приставки Fire TV CubeКомпания Amazon Web Services (AWS) впервые представила тонкий клиент Amazon WorkSpaces Thin Client — устройства такого рода представляют собой компьютеры с минимумом аппаратных возможностей, с помощью которых можно получать доступ к виртуальным рабочим столам в облаках. До этого у AWS не было собственных решений на рынке тонких клиентов. Компактное устройство подключается к VDI в облаке Amazon. Поддерживается и использование сервиса Amazon WorkSpaces Web, дающего возможность получать доступ к виртуальному рабочему столу непосредственно в браузере. Наконец, тонкий клиент можно интегрировать с сервисом Amazon AppStream. При этом можно использовать AppStream для доступа как ко множеству приложений, так и к единичным. Рабочие файлы не сохраняются локально, поэтому минимизирован риск кражи данных даже в случае хищения самого устройства. Тонкий клиент построен на базе ТВ-приставки Fire TV Cube с восьмиядерным процессором с частотой до 2,2 ГГц, 2 Гбайт RAM, 16 Гбайт постоянной памяти, а также USB- и HDMI-портами, которые оптимизированы для работы с мышью, клавиатурой и монитором, а не телевизором. Устройство продаётся с ОС, прошивкой и ПО, специально разработанными для использования VID. Руководители IT-департаментов смогут легко и централизованно управлять всем парком устройств в AWS Management Console.

Источник изображения: Amazon Новинка стоит $195, а за $280 предлагается комплект с хабом для подключения второго монитора. Продажи ведутся через корпоративный маркетплейс Amazon Business, причём в дальнейшем придётся платить по $6/мес. за обслуживание, мониторинг и поддержку каждого устройства. Amazon WorkSpaces Thin Client уже доступен в США, а в остальных странах он появится в начале 2024 года. Кроме того, консоль для управления парком тонких клиентов пока доступна только в североамериканских и некоторых европейских облачных регионах, а также в Индии. |

|