Материалы по тегу: разработка

|

26.06.2024 [14:44], Сергей Карасёв

Годовой оборот российских разработчиков ПО достиг 2 трлн руб.По итогам 2023 года оборот российских компаний, занимающихся разработкой программных продуктов, составил 1,98 трлн руб. Это на 19,4 % больше по сравнению с предыдущим годом. Такие данные, как сообщает ТАСС, приводятся в исследовании ассоциации «Руссофт». Спрос на отечественное ПО резко возрос на фоне сформировавшейся геополитической обстановки, из-за которой многие зарубежные компании покинули российский рынок. Вместе с тем на показатель совокупного оборота в сегменте софта экспортные доходы стали оказывать меньшее влияние. В 2023 году более 70 % в общем обороте составили продажи на внутреннем рынке. Совокупные зарубежные продажи софтверных компаний снизились в рублевом выражении на 13 % — до 471,5 млрд руб. Вместе с тем объём реализации на рынке РФ увеличился в годовом исчислении на 35,3 %, достигнув 1,51 трлн руб. Говорится, что в России услуги по заказной разработке ПО в 2023 году принесли около 205 млрд руб. против 265 млрд руб. годом ранее. На продажи собственных продуктов пришлось 65,8 % (годом ранее — 78 %) выручки от работы на внутреннем рынке продуктовых компаний и 35,9 % выручки сервисных компаний (10,6 % в 2022 году). Общая выручка в соответствующем сегменте оценивается в 865 млрд руб. Согласно прогнозам, в 2024 году ожидается рост рынка отечественного ПО ещё на 32 %. В результате, его оборот может достичь 2,61 трлн руб. При этом планируется активное продвижение продуктов на дружественных рынках — в частности, в странах СНГ, а также Южной и Восточной Азии.

17.06.2024 [22:49], Илья Коваль

Три квантовых компьютера, NVIDIA DGX Quantum, немножко HPC и облако: в Израиле открыт уникальный центр квантовых вычислений IQCC

aws

gh200

grace

hardware

hpc

nvidia

quantum machines

израиль

квантовые вычисления

квантовый компьютер

облако

разработка

Стартап Quantum Machines, разработчик систем управления квантовыми компьютерами, открыл Израильский центр квантовых вычислений (Israeli Quantum Computing Center, IQCC). Площадка, создание которой было частично профинансировано правительством страны, располагается в Тель-Авивском университете. По словам основателей, это первый в мире центр, располагающий квантовыми компьютерами разных типов, которые интегрированы с системой NVIDIA DGX Quantum, HPC-инфраструктурой и облаком. Приоритетный доступ со скидкой получат исследовательские организации Израиля, но в целом центр будет открыт для компаний со всего света. Как говорят создатели, IQCC — это лучший в мире полигон для создания новых технологий в области квантовых вычислений, а открытая архитектура площадки позволяет регулярно проводить обновления и упрощает дальнейшее масштабирование возможностей и вычислительных мощностей. Сейчас в IQCC установлены 21-кубитный компьютер Galilee от Quantware на сверхпроводящих кубитах (ещё один такой же используется в качестве тестовой платформы) и фотонный компьютер Negev от ORCA (8 кумод). Системы управляются контроллерами OPX1000 от самой Quantum Machines. HPC-инфраструктура представлена DGX A100, четырьмя GH200 и 128 vCPU на базе AMD EPYC 9334 (Genoa). Дополнительные ресурсы можно арендовать в облаке AWS. Для Galilee и Negev доступна интеграция с DGX Quantum, платформой для гибридных квантово-классических вычислений, которая была создана NVIDIA и Quantum Machines и впервые в мире развёрнута именно в IQCC. Управлять компьютерами и разрабатывать ПО можно с использованием Qiskit, QUA, OpenQASM3, QBridge, а также Classiq. К системе организован облачный доступ. В ближайшие месяцы в IQCC будут развёрнуты ещё несколько квантовых компьютеров и QPU.

13.06.2024 [14:41], SN Team

OS Day 2024: архитектура операционных систем и вопрос безопасности ПО20–21 июня года в Москве в новом здании РЭУ им. Г.В. Плеханова пройдет XI научно-практическая конференция OS DAY 2024. Она будет посвящена архитектурным и инженерным решениям в создании российских операционных систем, обеспечивающим безопасность программного обеспечения на различных уровнях. Вместе с разработчиками операционных систем в конференции примут участие производители аппаратных платформ, а также представители заказчиков программно-аппаратных комплексов. Организатором конференции традиционно выступает консорциум научных институтов и коммерческих компаний — вендоров ОС: ИСП РАН, «Лаборатория Касперского», НИЦ «Институт имени Н.Е. Жуковского», НТП «Криптософт», «Открытая мобильная платформа», ГК «Астра», «Базальт СПО», «РЕД СОФТ» и РОСА. Центральной темой OS DAY 2024 станет обеспечение безопасности российских операционных систем на архитектурном уровне. Участники планируют обсуждать модели угроз и инженерные подходы для их отражения. Особенное внимание будет уделено вопросам аппаратной поддержки, созданию полностью доверенной среды исполнения. Доклады, которые прозвучат на конференции, будут посвящены архитектуре механизмов безопасности российских ОС, реализации политик безопасности в программно-аппаратном комплексе на всех уровнях, тенденциям развития механизмов безопасности ОС, ответам на модели угроз. Речь зайдет о доверенных средах исполнения и доверенной загрузке, защите от подмены компонентов ОС, сертификации программного обеспечения. Будет затронута тема перспективы развития отечественных операционных систем и импортозамещения. В рамках конференции запланировано проведение круглого стола «Национальные стандарты по разработке безопасного программного обеспечения». Одна из ключевых тем, которые планируется обсудить на круглом столе, — внедрение единого государственного стандарта ГОСТ Р 56939 «Защита информации. Разработка безопасного программного обеспечения. Общие требования». Проект ГОСТа был создан «Лабораторией Касперского» в соответствии с планом технического комитета по стандартизации «Защита информации» ТК 362 на 2023 год. Готова ли индустрия отечественного ПО к внедрению нового национального стандарта? Какие отрасли готовы к нему лучше и почему? Как следует оценивать результаты его внедрения и каким образом будет происходить проверка процессов разработки безопасного ПО на соответствие положениям нового стандарта? Эти и другие вопросы будут обсуждать представители отрасли и государственных контролирующих органов. Также в ходе OS DAY 2024 состоится выставка технологий, где будут представлены решения, разработанные российскими производителями операционных систем. Конференция проводится при поддержке: РАН, ФСТЭК России, РЭУ им. Г.В. Плеханова, АРПП «Отечественный софт», НП «РУССОФТ». Время и место проведения: 20–21 июня 2024 года, РЭУ им. Г.В. Плеханова. Адрес: Москва, ул. Большая Серпуховская, д. 11, корпус 9, этаж 6. Для участия просьба зарегистрироваться на сайте https://osday.ru. Регистрация на очное участие закрывается 14 июня. Зарегистрированным участникам, выбравшим формат онлайн, будет предоставлен доступ на адрес электронной почты, указанный при регистрации. С дополнительными вопросами просьба обращаться: Анна Новомлинская, исполнительный директор OS DAY, an@ispras.ru. Справка Научно-практическая конференция OS DAY проводится в России ежегодно с 2014 г. Это коммуникационная площадка для теоретиков и практиков системного программирования и разработки операционных платформ, место консолидации российских разработчиков ОС и поиска точек для совместной деятельности. Задачи конференции — определить перспективные направления и технологии в сфере разработки операционных систем, обозначить главные вызовы современной ИТ-отрасли и помочь разработчикам, производителям и заказчикам обменяться опытом. Организует конференцию консорциум OS DAY, в который входят: ИСП РАН, «Лаборатория Касперского», НТП «Криптософт», «Открытая мобильная платформа», Группа Астра, «Базальт СПО», «РЕД СОФТ», НТЦ ИТ РОСА и НИЦ «Институт имени Н.Е. Жуковского». Целью создания сообщества организаторов было определить задачи и возможности России в области разработки операционных платформ, выделить перспективные технологии, обменяться опытом, обозначить вызовы ИТ-отрасли и направления движения.

03.06.2024 [14:18], Руслан Авдеев

GitVerse развернул российское «зеркало» заблокированного Docker HubРоссийский сервис GitVerse оперативно сформировал собственное «зеркало» Docker Hub, так что теперь у пользователей из России есть доступ к актуальным docker-образам. Пресс-служба «СберТеха» («Сбербанк Технологии») сообщает, что сервис уже заработал в режиме «бета» — достаточно будет быстро перенастроить уже имеющиеся клиенты. В «СберТехе» сообщают, что размещённые на площадке образы полностью соответствуют исходным с Docker Hub. Уже опубликована инструкция по применению docker-образов и, там же, инструкция по применению альтернативного клиента podman. По словам генерального директора СберТеха, несмотря на то, что зарубежный сервис заблокирован для российских клиентов, он по-прежнему важен с точки зрения непрерывности рабочих процессов. Именно поэтому компания выпустила обновление GitVerse.

Источник изображения: Luke Peters/unsplash.com Платформа Docker Hub пользовалась большим спросом у российских индивидуальных и корпоративных пользователей, но в конце прошлого месяца доступ к ней был закрыт. Docker Hub активно используется для получения зависимостей и базовых docker-образов в ходе разработки и развёртывания ПО. При этом альтернативные репозитории и «зеркала», созданные неизвестными компаниями или лицами, могут быть опасны в связи с возможными атаками на цепочку поставок.

02.06.2024 [15:30], Владимир Мироненко

NVIDIA объявила о доступности NIM для разработчиков ИИNVIDIA объявила о доступности NVIDIA NIM, микросервисов инференса, которые предоставляют готовые модели в виде заранее оптимизированных контейнеров, доступных для развёртывания в облаках, ЦОД или на рабочих станциях. Это, по словам компании, позволяет разработчикам возможность без труда создавать приложения генеративного ИИ за считанные минуты, хотя ранее на это уходили недели. Сложность приложений генеративного ИИ растёт и часто в них используется несколько моделей с различными возможностями для генерации текста, изображений, видео, речи и т.д. NVIDIA NIM позволяет значительно повысить производительность разработчиков, предоставляя простой стандартизированный способ добавления генеративного ИИ в их приложения. NIM также позволяет компаниям максимизировать свои инвестиции в инфраструктуру. Например, NIM-контейнер с оптимизированным вариантом Meta✴ Llama 3-8B выдаёт втрое больше токенов за единицу времени, чем LLM без оптимизаций. Более 200 технологических партнёров NVIDIA, включая Cadence, Cloudera, Cohesity, DataStax, NetApp, Scale AI и Synopsys, уже используют NIM, чтобы ускорить развёртывание генеративного ИИ для приложений, специфичных для их индустрии, таких как ИИ-помощники, помощники по созданию кода, цифровые человеческие аватары и многое другое. Кроме того, экосистему NIM поддерживают Canonical, Red Hat, Nutanix, VMware, Kinetica и Redis. Доступна и интеграция с KServe. NIM интегрирован в платформу NVIDIA AI Enterprise. Начиная со следующего месяца участники программы NVIDIA Developer Program получат бесплатный доступ к NIM для исследований, разработки и тестирования. Контейнеры NIM могут включать ПО NVIDIA CUDA, NVIDIA Triton Inference Server и NVIDIA TensorRT-LLM. А на ai.nvidia.com уже доступно более 40 готовых моделей, включая Databricks DBRX, Google Gemma, Meta✴ Llama 3, Microsoft Phi-3, Mistral Large, Mixtral 8x22B и Snowflake Arctic. Компания также представила и NVIDIA BioNeMo NIM для биомедицинской сферы. Ведущие провайдеры ИИ-решений и MLOps-платформ, включая Amazon SageMaker, Microsoft Azure AI, Dataiku, DataRobot, deepset, Domino Data Lab, LangChain, Llama Index, Replicate, Run.ai, ServiceNow, Securiti AI и Weights & Biases также внедрили NIM. Hugging Face теперь тоже предлагает NIM-контейнейры и позволяет развернуть модели в различных облаках всего за несколько кликов. Микросервисы NIM также интегрированы в AWS, Google Cloud, Microsoft Azure и Oracle Cloud. Наконец, компетенциями в области NIM обзавелись Accenture, Deloitte, Infosys, Latentview, Quantiphi, SoftServe, TCS и Wipro. Предприятия могут запускать приложения с поддержкой NIM практически в любом месте, в том числе на сертифицированных NVIDIA системах Cisco, Dell, HPE, Lenovo и Supermicro, а также ASRock Rack, ASUS, GIGABYTE, Ingrasys, Inventec, Pegatron, QCT, Wistron и Wiwynn. Более того, например, Foxconn и Pegatron уже используют NIM для разработки предметно-ориентированных LLM для собственных производственных нужд.

28.05.2024 [11:50], Сергей Карасёв

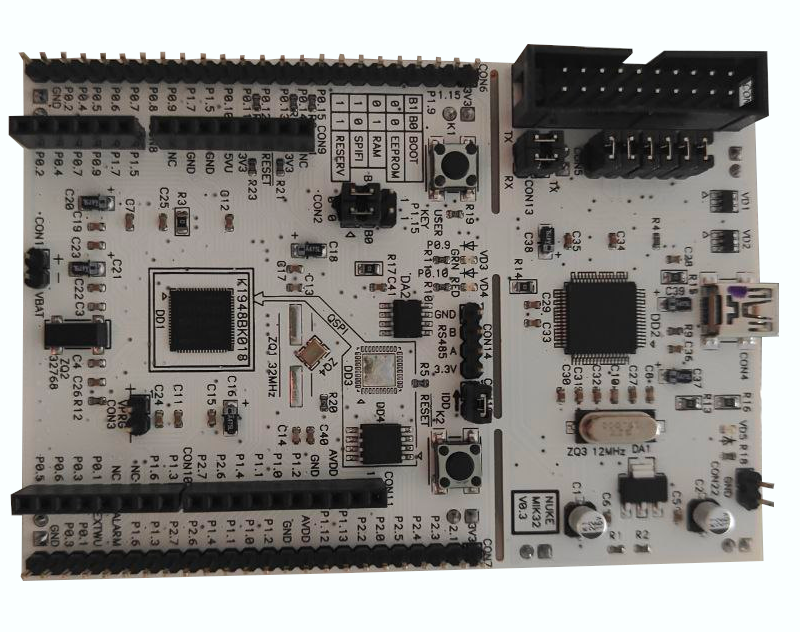

RISC-V DevBoards: стартует первая в России программа раннего доступа к архитектуре RISC-VАльянс RISC-V объявил о начале приёма заявок на участие в RISC-V DevBoards — это первая в России программа раннего доступа к архитектуре RISC-V с использованием отладочных плат для микроконтроллеров. Участие в программе не требует приобретения оборудования — оно предоставляется бесплатно. Отмечается, что участники RISC-V DevBoards смогут одними из первых протестировать возможности отечественных микроконтроллеров на открытой архитектуре RISC-V, а также создать прототипы собственных устройств. На первом этапе будет предоставлен доступ к микроконтроллеру «MIK32 Амур» (К1948ВК018) на базе отладочной платы MIK32. Напомним, изделие «MIK32 Амур», разработанное компанией «Микрон», содержит ядро RISC-V, однократно программируемую память (ПЗУ на 256 бит), ОЗУ ёмкостью 16 Кбайт, а также ПЗУ (EEPROM; 8 Кбайт). В дальнейшем перечень микроконтроллеров, доступных в рамках программы RISC-V DevBoards, планируется расширять.

Источник изображения: Альянс RISC-V / «Микрон» Компания Positive Technologies, входящая в состав Альянса RISC-V, оценит безопасность и уровень защищённости спроектированных устройств. Результаты тестирования лучших проектов будут опубликованы, а о разработке узнают профессионалы российского IT-рынка. Инициатива должна способствовать развитию экосистемы RISC-V в России.

27.05.2024 [14:51], Сергей Карасёв

RISC-V для учёбы: НИУ МИЭТ и YADRO представили микроконтроллер HackeeНациональный исследовательский университет «МИЭТ» и российский производитель вычислительной техники YADRO (ООО «КНС групп») представили учебный микроконтроллер Hackee на открытой архитектуре RISC-V. Новинка предназначена для применения во встраиваемых системах, носимой электронике и оборудовании Интернета вещей (IoT). В основу изделия положено 32-битное ядро SCR1. Тактовая частота составляет 85 МГц. Чип располагает 128 Кбайт оперативной памяти, таймерами, интерфейсами UART, SPI, I2C, CAN, JTAG. Изделие производится на предприятии АО «Микрон» по 180-нм технологии. Отмечается, что Hackee является результатом сотрудничества участников российского Альянса RISC-V — объединения независимых разработчиков вычислительной техники и программного обеспечения на архитектуре RISC-V. Основная цель организации — создание открытого сообщества разработчиков для дальнейшего развития RISC-V в России.

Источник изображения: Альянс RISC-V Нужно отметить, что ранее «Микрон» (входит в ГК «Элемент») представила отечественный микроконтроллер «MIK32 Амур» на базе RISC-V. Решение предназначено для устройств промышленной автоматизации, IoT, беспроводной периферии, интеллектуальных сетей, охранных систем и пр. Причём спрос на это изделие превзошёл ожидания.

22.05.2024 [12:54], Сергей Карасёв

Поставщик данных для обучения ИИ Scale AI привлёк $1 млрдСтартап Scale AI, основанный в 2016 году, объявил о проведении раунда финансирования Series F, в ходе которого привлекла $1 млрд, а оценка компании составила $13,8 млрд. Сложные ИИ-модели обучаются на огромных массивах данных, для сбора и подготовки которых может потребоваться много времени. Scale AI предоставляет облачный сервис Generative AI Data Engine, который ускоряет и упрощает этот процесс. Клиенты Scale AI указывают, данные какого типа им необходимы для обучения ИИ-моделей, после чего стартап занимается подготовкой соответствующих наборов. Кроме того, платформа Scale AI упрощает задачу разметки данных. Поддерживается работа с текстовой информацией, изображениями и аудиоматериалами, а также более специализированными данными, такими как журналы датчиков (лидаров) беспилотных автомобилей.

Источник изображения: Scale AI Scale AI также предоставляет ряд дополнительных услуг. В их число входит сервис проверки новый сетей на наличие уязвимостей, галлюцинаций и других проблем. Для организаций государственного сектора компания разработала чат-бота Donovan, который рассчитан на работу с конфиденциальной информацией. Программу финансирования Series F возглавила Accel. Кроме того, средства предоставили существующие инвесторы — Y Combinator, Nat Friedman, Index Ventures, Founders Fund, Coatue, Thrive Capital, Spark Capital, NVIDIA, Tiger Global Management, Greenoaks и Wellington Management. В число новых инвесторов вошли Cisco Investments, DFJ Growth, Intel Capital, ServiceNow Ventures, AMD Ventures, WCM, Amazon, Elad Gil и Meta✴. Полученные деньги будут направлены на улучшение существующих продуктов и развитие новых проектов.

16.05.2024 [23:59], Владимир Мироненко

3Logic локализует в России китайскую платформу Gitee и перенесёт 100 тыс. open source проектов3Logic Group объявила о создании платформы gitee.ru для хостинга репозиториев ИT-проектов и их совместной разработки, которая позволит отечественным разработчикам и компаниям использовать ПО китайской платформы gitee.com — крупнейшего китайского репозитория ПО с открытым исходным кодом. В создании участвуют входящая в структуру 3Logic Group компания Xellon, специализирующаяся на заказной локализацией китайских ИТ-решений, а также компания Open Source China, создавшая крупнейший в Китае и второй по величине в мире сервис хостинга репозиториев, содержащий 28 млн проектов, в числе пользователей которого более 12 млн разработчиков и 100 тыс. компаний Китая. Как сообщается в пресс-релизе, платформа gitee.ru развёрнута в дата-центре в Москве. В настоящее время ведётся работа по локализации и адаптации сервиса для России, а также разработка инструментов двухсторонней синхронизации репозиториев с gitee.com. Проводится глубокая локализация интерфейсов и сервисов gitee.com, а также наиболее популярных китайских проектов. Команда 3Logic Group локализует документацию по ним, текущие открытые задачи и описания сферы применения ПО. Поставлена задача разместить до конца года на gitee.ru 100 тыс. локализованных проектов с открытым исходным кодом. Платформа будет предоставлять как бесплатные, так и платные услуги хостинга и работы с репозиториями кода. Оплата будет производиться с использованием российских платёжных систем. Сервис предоставит российским корпоративным заказчикам возможность использовать наиболее передовые open source проекты из Китая, в частности, в области LLM и ИИ. Руководитель проекта gitee.ru компании Xellon, заявил, что было принято решение не создавать репозиторий с нуля, а «выстраивать его вокруг уже существующей экспертизы и большого сообщества». Он отметил, что в Китае разработка ПО на основе open source находится на «высочайшем уровне», а «наш проект, с одной стороны, предлагает российским командам и разработчикам хранить свой код на российской инфраструктуре, с другой стороны, иметь доступ к наработкам и выстраивать взаимодействие с китайскими коллегами». Как отметил «Коммерсантъ», в России за последние годы уже появилось несколько отечественных репозиториев, и у экспертов есть сомнения в том, что крупный бизнес захочет использовать китайский открытый код, опасаясь возможных рисков. Кроме того, платформа, по мнению экспертов, вряд ли будет признана российской, что закроет ей доступ в ряд секторов.

13.05.2024 [09:00], Сергей Карасёв

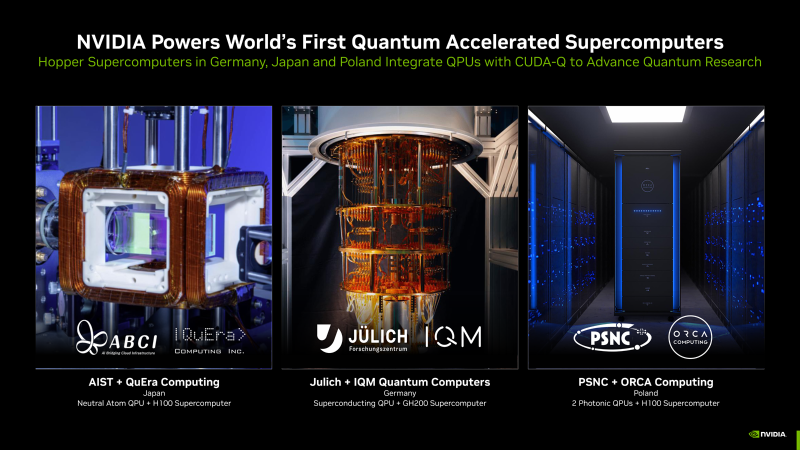

NVIDIA представила гибридные квантовые системы на платформе CUDA-QКомпания NVIDIA сообщила о том, что её платформа CUDA-Q будет использоваться в суперкомпьютерных центрах по всему миру. Она поможет ускорить исследования в области квантовых вычислений, что в перспективе позволит решать наиболее сложные научные задачи. Технология CUDA-Q предназначена для интеграции CPU, GPU и квантовых процессоров (QPU) и разработки приложений для них. Она даёт возможность выполнять сложные симуляции квантовых схем. О намерении использовать CUDA-Q в составе своих НРС-систем объявили организации в Германии, Японии и Польше. В частности, Юлихский суперкомпьютерный центр в Германии (JSC) намерен использовать квантовое решение производства IQM Quantum Computers в качестве дополнения к Jupiter — первому европейскому суперкомпьютеру экзафлопсного класса. Этот комплекс будет смонтирован в Юлихском исследовательском центре (FZJ). Суперкомпьютер Jupiter получит приблизительно 24 тыс. гибридных суперчипов NVIDIA GH200 Grace Hopper. Ещё одной гибридной системой, объединяющей классические и квантовые технологии, станет комплексе ABCI-Q, который расположится в суперкомпьютерном центре ABCI (AI Bridging Cloud Infrastructure) Национального института передовых промышленных наук и технологий Японии (AIST). В состав суперкомпьютера войдут QPU разработки QuEra, а также более 2000 ускорителей NVIDIA H100. Ввод ABCI-Q в эксплуатацию состоится в начале 2025 года. Применять систему планируется при проведении исследований в области ИИ, энергетики, биологии и пр. Вместе с тем Познаньский центр суперкомпьютерных и сетевых технологий (PSNC) в Польше приобрёл две квантовые вычислительные системы британской компании ORCA Computing. Они интегрированы в существующую HPC-инфраструктуру PSNC, которая в числе прочего использует изделия NVIDIA Hopper. Узлы на базе QPU помогут в решении задач в области химии, биологии и машинного обучения. |

|