Материалы по тегу: схд

|

08.04.2025 [08:30], Владимир Мироненко

Поставщики памяти, накопителей и СХД в основном проиграют от торговой войны СШАВведение президентом США пошлин отразится на американских компаниях, у которых компоненты многонациональной цепочки поставок и готовая продукция импортируются в Америку, а также на цене продукции иностранных поставщиков, импортируемой в США, пишет ресурс Blocks & Files. Торговая война также затронет американских поставщиков систем хранения, экспортирующих в те страны, которые в ответ тоже повышают пошлины. Таким образом, можно говорить о трёх группах компаний, которые столкнутся с различными проблемами после роста пошлин. США назначили Китаю самую высокую пошлину в 54 %. И это не предел, поскольку в связи с решением Китая повысить в ответ пошлины на 34 % США, в свою очередь, могут повысить ставку до 104 %, пишет The Register. За Китаем следует Камбоджа с пошлиной в 49 %, Лаос — 48 %, Вьетнам — 46 %, Таиланд — 37 %, Индонезия и Тайвань — по 32 %, Индия — 27 %, Южная Корея — 26 %, Япония — 24 %, Евросоюз — 18,5 %, Филиппины — 18 %. Среди компаний, поставляющих товары в США, введение пошлин может затронуть поставщиков DRAM, NAND, SSD, лент и ленточных приводов, а также тех, кто производит контроллеры СХД и серверные процессоры. Следует учесть, что согласно приложению II Гармонизированного тарифного графика США (HTSUS), полупроводниковые чипы освобождены от пошлин, но не товары, которые содержат их в качестве компонентов. Так, Micron производит DRAM, NAND и SSD. DRAM выпускается в Бойсе (штат Айдахо), а также в Японии, Сингапуре и на Тайване. Освобождение от пошлин может применяться к чипам DRAM и NAND, но не обязательно к SSD, содержащим NAND, поскольку для них нет специального освобождения. На товары будут действовать пошлины для страны происхождения, установленные администрацией США. Samsung, производит DRAM и NAND в основном в Южной Корее, но часть NAND выпускается в Китае. Сборка SSD сосредоточена в Южной Корее, поэтому они, скорее всего, подпадают под 26-% пошлину. SK hynix, производит чипы DRAM, NAND и SSD в Южной Корее, в то время как её дочерняя компания Solidigm производит SSD в Китае. То есть на её ценах отразится 54-% пошлина на SSD из Китая и 26-% — на продукцию из Южной Кореи. Kioxia, производит NAND и SSD в Японии, при ввозе в США её продукты будут облагаться 24-% пошлиной. NAND-память SanDisk производится в Японии (совместно с Kioxia), но часть SSD выпускается на заводах в Китае, что подразумевает применение 54-% пошлины. Это означает, что SSD Kioxia, Samsung и SK hynix, могут оказаться дешевле, чем SSD Sandisk, а вот SSD Solidigm — нет.

Источник изображения: The New York Public Library / Unsplash У HDD Seagate довольно сложная и интегрированная международная цепочка поставок, включающая Китай, Таиланд, Сингапур и Малайзию. Компания производит пластины для дисков и часть самих HDD (например, Exos) в Китае, а двигатели, узлы привода головок и жёсткие диски других серий — в Таиланде. Кроме того, пластины и некоторые другие диски собираются в Сингапуре и Малайзии. Новые пошлины будут применяться при импорте дисков в США и будут зависесть от страны происхождения. Столь резкое увеличение цен из-за пошлин может вызвать шок у клиентов, отметил ресурс Blocks & Files. Western Digital собирает свои диски в Малайзии и Таиланде, и поэтому столкнётся с пошлинами в размере 24 % и 36 % соответственно. Жёсткие диски Toshiba производятся в Китае, на Филиппинах и в Японии, что подразумевает импортные пошлины США в размере 54, 18 и 24 % соответственно. Записываемые диски Blu-ray и DVD производятся в Китае, Индии, Японии и на Тайване — они точно так же будут облагаться пошлинами в зависимости от страны выпуска. IBM производит ленточные накопители, проприетарные и LTO, в Тусоне (штат Аризона), поэтому её коснутся только пошлины на любые компоненты иностранного производства, которые она будет импортировать. Fujifilm производит LTO-накопители в Бедфорде (штат Массачусетс), а Sony — в Японии, что означает 24-процентную пошлину на ввоз в США. Fujifilm — в выигрыше от ввода пошлин, а Sony — наоборот. Контроллеры хранения данных и серверные процессоры в основном производятся Intel, некоторые — компанией AMD. У Intel есть фабрики в Орегоне (Хиллсборо), Аризоне (Чандлер) и Нью-Мексико (Рио-Ранчо). Сборочные, испытательные и упаковочные мощности для CPU имеются в Израиле, Малайзии, Вьетнаме, Китае и Коста-Рике. Часть продукции выпускается завод в графстве Килдэр (Ирландия). AMD во много зависит от тайваньских фабрик TSMC. Однако обе компании, а заодно и производители Arm-чипов, пошлины не затронут. Зато экспорт в Китай подпадёт под ответные 34-% пошлины. Массивы хранения данных в основном производятся в США, где находятся все производства Dell, HPE и NetApp. А вот Hitachi Vantara производит свои хранилища в Японии, поэтому на них будет действовать 24-%. СХД Lenovo фактически являются OEM-массивами NetApp, поэтому она может избежать пошлин. СХД Infinidat выпускаются на производственных мощностях Arrow Electronics, которая имеет глобальную цепочку поставок с США в роли главного хаба. Где именно по факту производятся массивы, Infinidat не говорит. Поставщики неамериканских СХД в США столкнутся с пошлинами в зависимости от страны их базирования. Чтобы избежать этого, компании могут инвестировать в американские подразделения, хотя для многих в нынешней ситуации это может быть не очень целесообразно. Третья группа поставщиков СХД — это американские компании, экспортирующие продукцию, например, в Китай, который в ответ повышает собственные пошлины на ввоз товаров из США — с 10 апреля она составит 34 %. Одним из победителей в этой торговой войне Blocks & Files назвал Huawei, которая не поставляет товары в США.

02.04.2025 [18:50], Сергей Карасёв

QSAN представила СХД серии XN5 типа All-NVMe с процессорами Intel XeonКомпания QSAN Technology анонсировала системы хранения данных (СХД) семейства XN5, предназначенные для работы с ресурсоёмкими нагрузками, связанными с ИИ, машинным обучением, виртуализацией и другими вычислительными процессами. Устройства выполнены в форм-факторе 2U на аппаратной платформе Intel. Новинки относятся к решениям All-NVMe: они рассчитаны на работу с SSD формата SFF U.2 с интерфейсом PCIe 4.0. Во фронтальной части предусмотрены 26 отсеков для таких накопителей, а суммарная внутренняя ёмкость может достигать 798 Тбайт. Поддерживается горячая замена SSD. Анонсированы модели XN5226D-12C и XN5226S-12C. Первая оснащена двумя контроллерами в режиме «активный — активный» с двумя неназванными 12-ядерными процессорами Xeon. В базовую комплектацию входят 32 Гбайт памяти DDR4 с возможностью расширения до 2 Тбайт. Также предусмотрены четыре слота расширения PCIe 4.0 x8, два порта 2.5GbE RJ45 и восемь портов 25GbE SFP28. Модификация XN5226S-12C, в свою очередь, оснащена одним контроллером, одним 12-ядерным процессором Xeon, 16 Гбайт ОЗУ (расширяется до 1 Тбайт), двумя слотами PCIe 4.0 x8, одним портом 2.5GbE RJ45 и четырьмя портами 25GbE SFP28. Устройства могут комплектоваться адаптерами 10GbE SFP+, 10GbE RJ45, FC16 и FC32 с двумя или четырьмя портами. Поддерживается подключение модулей расширения с SFF SSD и LFF HDD с интерфейсом SAS: в максимальной конфигурации количество накопителей достигает 546 штук, а суммарная ёмкость — до 16,8 Пбайт. Возможно формирование массивов RAID 0/1/5/6/10/50/60/5EE/6EE/50EE/60EE. В качестве программной платформы используется QSM 4. Заявлена поддержка протоколов CIFS, NFS, FTP, WebDAV, iSCSI, FCP, NVMe-oF. За электропитание отвечают два блока мощностью 850 Вт с сертификатом 80 Plus Platinum. Охлаждение обеспечивается системой воздушного охлаждения. Габариты составляют 88 × 438 × 573 мм, масса — 19,6 кг (без установленных накопителей). На устройства предоставляется пятилетняя гарантия.

01.04.2025 [16:05], Руслан Авдеев

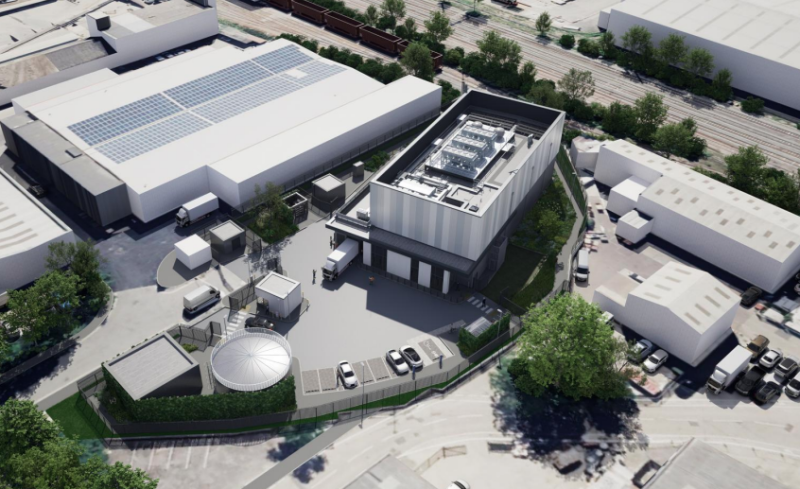

В Лондоне появится экобезопасный ЦОД AWS для ленточных накопителейНа территории технопарка Silverdale Industrial Estate на западе «Большого Лондона» в ближайшие годы появится экобезопасный и энергоэффективный дата-центр компании Amazon (AWS). Проект разрабатывается архитектурным бюро MCA Architects для инвесторов из Mulhaven Properties и представляет собой передовое решение для хранения данных, сообщает портал Blocks & Files. Как сообщается в презентации MCA Architects, предусмотрена полная рекультивация участка площадью 0,44 га — сейчас там находится пустой складской комплекс. На его месте появятся современные здания. В частности, речь идёт об основном здании высотой более 13 м (несколько этажей). Рядом разместится офисное здание высотой около 6 м. Общая площадь застройки — около 3200 м². Будут созданы раздельные въезды и выезды для грузового транспорта. Также предусмотрено внедрение современной системы безопасности и ограждений высотой 2,3–4 м.

Источник изображения: MCA Architects Новый дата-центр предназначен для размещения ленточных накопителей вместо традиционных серверов. Также ЦОД будет получит резервный генератор мощностью 1,08 МВт. Предусмотрено использование системы поддержания микроклимата (температура 16–25 °C, влажность 20–50 %). Водопотребление в сравнении с обычным ЦОД крайне невелико — менее 150 м³ в год, такими объёмами можно буквально пренебречь при расчётах. Особое внимание уделили минимизации воздействия на окружающую среду. Так, выбросы углекислого газа должны быть уменьшены на 15 % в сравнении с нормами Part L 2021 Building Regulations. Одной из главных целей является получение сертификата BREEAM Excellent, одного из самых престижных в области экологического строительства. Дополнительно планируется сбор дождевой воды, использование засухостойких растений, вертикального озеленения фасадов и др. Проект имеет для региона большие перспективы. Общий объём инвестиций AWS в связанные с ЦОД процессы в Великобритании в следующие пять лет составит £8 млрд. В целом с 2010 года инвестиции Amazon в Великобритании превысили £56 млрд. Проект уже вызвал интерес экспертного сообщества. Он демонстрирует возможности интеграции высокотехнологичной инфраструктуры в промышленную застройку и использования одних из самых передовых экорешений в Европе. Приветствуют новые инвестиции и местные власти. Пока проект находится на стадии согласования, строительство может начаться уже в 2025 году, а ввод объекта в эксплуатацию — в 2027 году. Это лишь один из расширяющейся сети ЦОД AWS в Великобритании, включающей уже несколько крупных кампусов, в том числе строящийся к югу от участка комплекс. В январе Trendfocus сообщала, что по итогам 2024 года спрос на ленточные накопители вырос на 12 %.

01.04.2025 [14:03], Сергей Карасёв

XenData представила 1U-устройство Z20 на базе Windows 11 Pro для доступа к облачным хранилищамКомпания XenData анонсировала стоечное решение Z20 Cloud Appliance, призванное повысить удобство управления медиафайлами, хранящимися на облачных платформах. Система функционирует под управлением Windows 11 Pro, а доступ к объектам предоставляется через интуитивно понятный веб-интерфейс. Решение XenData Z20 выполнено в форм-факторе 1U. Применён неназванный процессор Intel Xeon с четырьмя ядрами, работающий в тандеме с 16 Гбайт оперативной памяти. В оснащение входят системный SSD вместимостью 480 Гбайт и SSD на 3,84 Тбайт для локального хранилища. При необходимости могут быть установлены ещё два SSD ёмкостью 3,84 Тбайт каждый. Стандартная конфигурация включает четыре сетевых порта 1GbE. В тыльной части корпуса располагаются три слота OCP, в которые могут устанавливаться двухпортовые адаптеры 10/25GbE SFP+. Предусмотрены один фронтальный и четыре тыльных порта USB 3.2, интерфейсы DisplayPort и D-Sub. Устройство заключено в корпус глубиной 387 мм, а масса составляет 9,5 кг. Базовая конфигурация включает один блок питания мощностью 500 Вт, но при необходимости может быть установлен второй такой же блок. Система XenData Z20 поддерживает работу с публичными облачными хранилищами AWS S3, Microsoft Azure Blob Storage, Seagate Lyve и Wasabi. При этом обеспечивается управление различными уровнями объектного хранилища, доступными в AWS и Azure. Многопользовательский веб-интерфейс позволяет просматривать эскизы изображений, воспроизводить видео-превью, искать нужный контент и пр. Несмотря на то, что устройство оптимизировано для работы именно с медиаконтентом, оно поддерживает файлы любых других типов — от XML до документов Word. Приобрести решение можно по ориентировочной цене $9880.

29.03.2025 [10:44], Сергей Карасёв

OWC представила хранилища данных Jellyfish B24 и S24 для создателей контентаКомпания Other World Computing (OWC) анонсировала стоечные СХД Jellyfish B24 и Jellyfish S24, рассчитанные прежде всего на создателей контента. Обе новинки допускают подключение модулей расширения, что позволяет наращивать вместимость по мере необходимости. Модель Jellyfish B24 на основе HDD представляет собой упрощённую версию мощного решения Jellyfish R24, разработанную для совместной работы небольших команд. Допускается установка 24 накопителей формата LFF суммарной вместимостью до 576 Тбайт. При необходимости можно подключить до четырёх модулей расширения Jellyfish B24-E посредством интерфейса mini-SAS, получив хранилище общей ёмкостью до 2,8 Пбайт.

Источник изображений: OWC Устройство Jellyfish B24 выполнено в форм-факторе 4U. Задействован неназванный процессор Intel Xeon Silver, работающий в тандеме с 64 Гбайт оперативной памяти DDR4 ECC. В оснащение входит кеширующий SSD на 2 Тбайт. Есть два порта 1GbE, а при необходимости могут быть добавлены сетевые интерфейсы 10GbE (RJ45/SFP+), 25GbE (QSFP), 50GbE (QSFP28) и 100GbE (QSFP28). Предусмотрены четыре порта USB 3.0 и разъём D-Sub. За питание отвечает блок мощностью 875 Вт с резервированием. Габариты СХД составляют 432 × 318 × 198 мм, масса — 15,9 кг без установленных накопителей. Поддерживаются протоколы SMB, NFS, FTP и SSH.  Вариант Jellyfish S24, в свою очередь, рассчитан на 24 SSD формата SFF. При подключении модуля расширения Jellyfish S24-E можно получить суммарную вместимость до 736 Тбайт на основе твердотельных накопителей. Добавив четыре модуля Jellyfish R24-E или B24-E, можно создать гибридное хранилище ёмкостью до 2,3 Пбайт. СХД располагает двумя портами 10GbE RJ45 и двумя блоками питания мощностью 650 Вт с возможностью горячей замены. Форм-фактор — 2U. Упомянуты протоколы SMB, NFS, FTP и SSH.

28.03.2025 [13:24], Руслан Авдеев

5 Экзабайт для ИИ: OpenAI может построить специальный дата-центр для хранения за миллиарды долларовКомпания OpenAI может построить дата-центр для хранения данных стоимостью миллиарды долларов, желая снизить зависимость от облачных провайдеров. Разработчик ChatGPT намерен закупить комплектующие и ПО для хранения 5 Эбайт, сообщает The Information. Для размещения необходимой инфраструктуры рассматривается строительство нового дата-центра, доложили журналистам анонимные источники. Впрочем, план также может быть частью стратегии по давлению на Microsoft и других облачных провайдеров для заключения с ними сделок на более выгодных условиях. Не так давно Microsoft, имеющая договорные обязательства с OpenAI, разрешила той пользоваться сторонними облаками. Руководство OpenAI, по слухам, заявило сотрудникам, что компания намерена увеличить объём доступных вычислительных ресурсов для разработчиков до конца года — без учёта ускорителей и сопутствующие инфраструктуры для работы ChatGPT и других продуктов. Также компания надеется утроить общую ёмкость ЦОД, доведя её до 2 ГВт. Сюда входят облачные серверы, которые она арендует у Microsoft. Разработка новых ИИ-моделей требует больших СХД. Если новый ЦОД будет построен, он, вероятно, будет напрямую связан с ИИ-мегапроектом Stargate, совместной инициативой OpenAI, SoftBank и Oracle, а также арабского инвестора MGX — предполагается потратить на инфраструктуру до $500 млрд. ЦОД для хранения данных стремятся строить на территории кампусов с прочей цифровой инфраструктурой, а не выделять отдельные площадки. OpenAI рассматривает возможность размещения хранилища возле объекта первой фазы проекта Stargate, который уже строится в Техасе. Как именно компания намеревается финансировать эти покупки и дополнительное строительство, пока неизвестно. В прошлом году она привлекла $6,6 млрд и теперь ожидает раунд финансирования на $40 млрд, который обеспечит ей капитализацию в $340 млрд. Microsoft была единственным облачным провайдером OpenAI с тех пор, как начала инвестировать в компанию в 2023 году, но требования к вычислительным мощностям растут так быстро, что теперь OpenAI пришлось дополнительно вести дела с Oracle и CoreWeave для обеспечения работы Stargate.

27.03.2025 [09:11], Алексей Степин

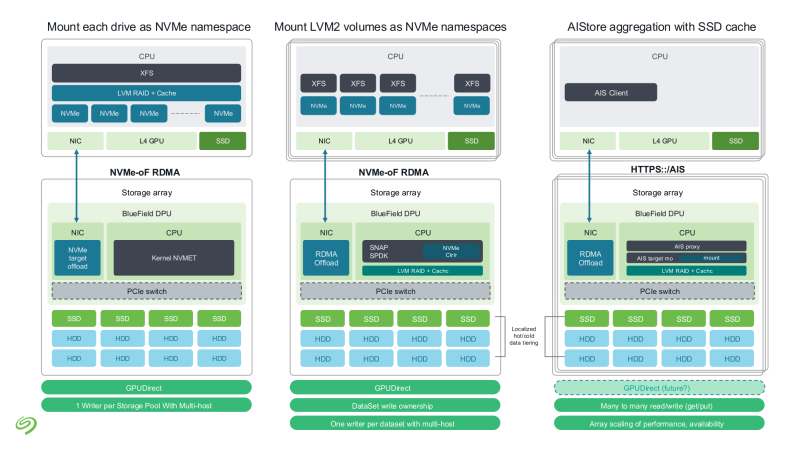

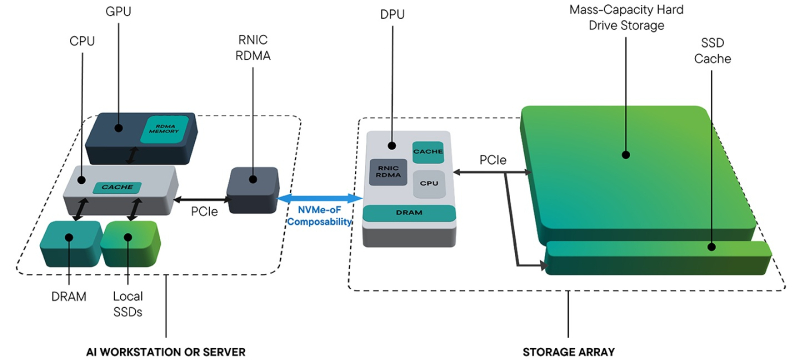

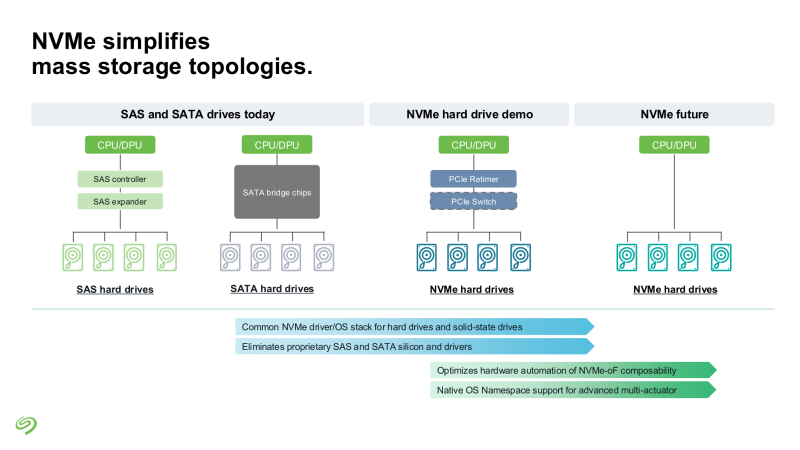

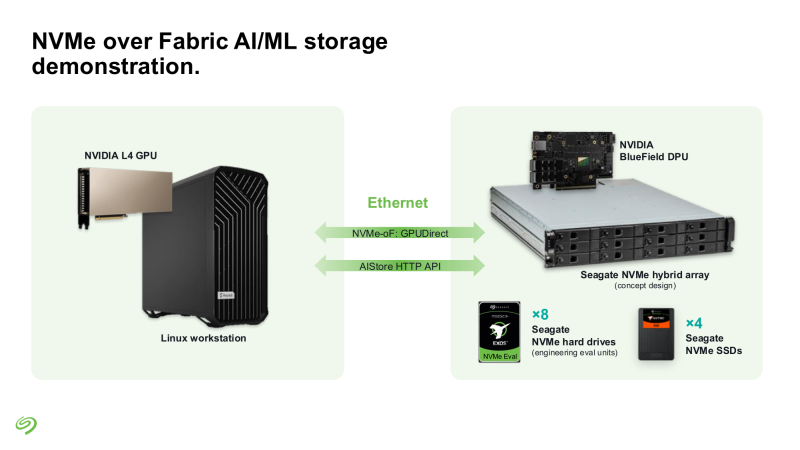

Seagate представила свежие прототипы NVMe HDDSeagate представила своё видение СХД для ИИ-фабрик. Компания отмечает, что объёмы данных, используемых при обучении современных моделей, огромны и, согласно Seagate, хранить их целиком на флеш-массивах невыгодно для большинства предприятий и стартапов. Ответом являются гибридные массивы, сочетающие флеш-память и традиционную дисковую механику. Идея таких СХД не нова сама по себе, но реализация, предлагаемая Seagate, лишена атавизмов — проприетарных контроллеров, преобразования протоколов и всего прочего, на чём держится традиционная инфраструктура SAS/SATA. Основой новой архитектуры станет стандарт NVMe с единым драйвером, который вкупе со средствами ОС позволит слаженно работать SSD и HDD. Это важное отличие от уже имеющихся решений, например, от StorONE, где HDD действительно могут быть использованы в составе хранилища NVM-oF, но подключаются они всё равно по SAS/SATA. На уровне отдельных механических дисков сам по себе переход на NVMe выигрыша не принесёт, поскольку ограничивающим фактором останется время поиска дорожки, но на уровне массива с поддержкой GPUDirect и NVMe-oF выигрыш будет существенным. NVMe-oF упростит масштабирование таких систем и позволит реализовать распределённую архитектуру хранения данных в полной мере, отмечает Blocks & Files.

Источник изображений: Seagate Гибридные массивы в этой схеме напрямую подключаются к GPU-серверам. За счёт агрегации доступа ко множеству накопителей скорость может быть существенно увеличена (о чём говорила когда-то и Toshiba), а простота подключения будет достигнута за счёт единого стандарта — NVMe. В новых массивах предусмотрено место для DPU, благодаря которым и будет реализована поддержка RDMA и GPUDirect. На конференции NVIDIA GTC 2025 Seagate уже продемонстрировала прототип такого массива на базе BlueField-3 и MiniIO AIStore v2.0. Данный прототип был оснащён восемью инженерными образцами NVMe HDD и четырьмя NVMe SSD. Даже будучи на уровне концепта, он показал, что прямое сообщение между ускорителями и подсистемой хранения данных позволяет снизить латентность доступа в ИИ-сценариях. Также благотворное влияние на производительность при обучении ИИ-моделей оказывает применение средств динамического кеширования и иерархизации (tiering). Seagate считает, что у традиционных жёстких дисков с интерфейсом NVMe есть большое будущее, и они найдут своё место во многих отраслях, от медицины и финансовой аналитики до самоуправляемого транспорта и ИИ-фабрик гиперскейлеров. В сравнении с SSD называются следующие преимущества:

В планах компании значится создание NVMe HDD на базе HAMR объёмом до 36 Тбайт и более на платформе Mozaic, а также разработка референсных архитектур и дальнейшее продвижение технологии NVMe-oF. Надо сказать, что опыт создания жёстких дисков с этим интерфейсом у Seagate есть — ещё в ноябре 2021 году компания продемонстрировала дисковую полку с 12 LFF HDD, доступ к которой осуществлялся с помощью PCIe 3.0. За основу была взята модель Exos объёмом 18 Тбайт. Toshiba и Western Digital на тот момент инициативу Seagate не поддержали, и на данный момент ситуация пока остаётся прежней — два других крупных производителя HDD хранят молчание о планах по внедрению NVMe в механические накопители. Если конкуренты всё-таки предложат свою альтернативу, потенциальные заказчики смогут избежать привязки к вендору, да и на популяризации самой технологии NVMe-массивов это скажется благотворно. Тем более что поддержка HDD уже давно прописана в стандарте NVMe 2.0.

25.03.2025 [17:08], Сергей Карасёв

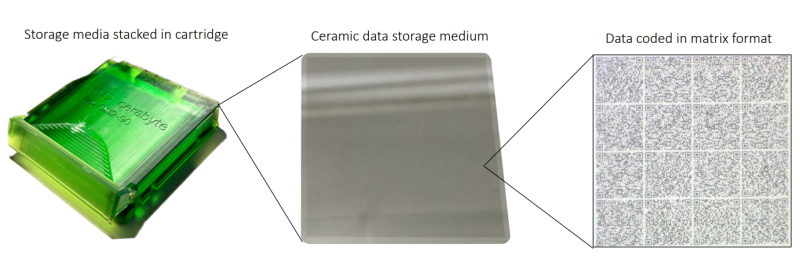

Керамические накопители Cerabyte заинтересовали In-Q-Tel, инвестирующую в перспективные технологии в интересах ЦРУ и др.Немецкая компания Cerabyte, специализирующаяся на разработке систем хранения данных на основе керамики, объявила о привлечении инвестиций со стороны компании In-Q-Tel (IQT), косвенно связанной с американскими спецслужбами. Полученные средства пойдут на ускорение создания продуктов, которые будут поставляться государственным заказчикам. Объём вложений со стороны IQT не раскрывается. Технология Cerabyte предполагает применение стекла или плёнки с тонким керамическим покрытием. Информация записывается при помощи лазера в виде наноразмерных «ямок» по аналогии с QR-кодами: заявленная скорость достигает 2 млн бит на лазерный импульс. Считывание также осуществляется посредством лазера. Одним из ключевых преимуществ технологии Cerabyte является долговечность: данные на таких накопителях могут храниться практически неограниченное количество времени, заявляет компания. Кроме того, обеспечивается высокая ёмкость: по заявлениям разработчика, технология до 2030 года позволит добиться вместимости до 100 Пбайт на стойку при использовании картриджей CeraMemory. In-Q-Tel — американская некоммерческая венчурная фирма, базирующаяся в Арлингтоне (Вирджиния). Она инвестирует в перспективные компании с тем, чтобы обеспечить ЦРУ и другие структуры США передовыми технологическими разработками. Ожидается, что американский государственный сектор будет оперировать огромными объемами данных, сопоставимыми с теми, которыми управляют ведущие интернет-корпорации, включая Meta✴ и Amazon. Причём основная часть такой информации у госструктур будет находиться в «холодном» хранилище в течение длительных периодов времени. Таким образом, технология Cerabyte обеспечит эффективное решение как с точки зрения долговечности, так и с точки зрения вместимости. Нужно отметить, что ранее Cerabyte привлекла инвестиции от компании Pure Storage, которая занимается разработкой All-Flash СХД. Кроме того, Cerabyte получила финансовую поддержку в рамках программы-акселератора Европейского совета по инновациям (EIC).

24.03.2025 [09:03], Владимир Мироненко

От СХД напрямую к ИИ: NVIDIA анонсировала эталонную платформу AI Data Platform для быстрого извлечения данных во время инференсаNVIDIA анонсировала NVIDIA AI Data Platform — настраиваемую эталонную архитектуру, которую ведущие поставщики смогут использовать для создания нового класса ИИ-инфраструктуры для требовательных рабочих нагрузок ИИ-инференса: корпоративных платформ хранения со специализированными ИИ-агентами, использующих ускорители, сетевые решения и ПО NVIDIA. Эти агенты помогут генерировать ответы из имеющихся данных практически в реальном времени, используя ПО NVIDIA AI Enterprise — включая микросервисы NVIDIA NIM для новых моделей NVIDIA Llama Nemotron, а также NVIDIA AI-Q Blueprint. Провайдеры хранилищ смогут оптимизировать свою инфраструктуру для обеспечения работы этих агентов с помощью ускорителей NVIDIA Blackwell, DPU BlueField, сетей Spectrum-X и библиотеки инференса с открытым исходным кодом NVIDIA Dynamo. Ведущие провайдеры платформ данных и хранилищ, включая DDN, Dell, HPE, Hitachi Vantara, IBM, NetApp, Nutanix, Pure Storage, VAST Data и WEKA, сотрудничают с NVIDIA для создания настраиваемых ИИ-платформ данных, которые могут использовать корпоративные данные для рассуждений и ответов на сложные запросы. NVIDIA Blackwell, DPU BlueField и сетевое оборудование Spectrum-X предоставляют механизм для ускорения доступа ИИ-агентов запроса к данным, хранящимся в корпоративных системах. DPU BlueField обеспечивают производительность до 1,6 раз выше, чем хранилища на базе ЦП, при этом снижая энергопотребление до 50 %, а Spectrum-X ускоряет доступ к хранилищам до 48 % по сравнению с традиционным Ethernet, применяя адаптивную маршрутизацию и контроль перегрузки, говорит NVIDIA. ИИ-агенты, созданные с помощью AI-Q Blueprint, подключаются к данным во время инференса, чтобы предоставлять более точные, контекстно-зависимые ответы. Они могут быстро получать доступ к большим объёмам информации и обрабатывать различные типы данных, включая структурированные, полуструктурированные и неструктурированные данные из нескольких источников, в том числе текст, PDF, изображения и видео. Сертифицированные партнёры NVIDIA в области СХД уже сотрудничают с NVIDIA в деле создания новых ИИ-платформ:

20.03.2025 [15:58], Сергей Карасёв

Supermicro анонсировала петабайтное 1U-хранилище All-Flash на базе Arm-суперчипа NVIDIA GraceКомпания Supermicro представила сервер ARS-121L-NE316R в форм-факторе 1U, на базе которого могут формироваться системы хранения данных петабайтной вместимости. В основу новинки положен суперчип NVIDIA Grace со 144 ядрами Arm Neoverse V2 и 960 Гбайт памяти LPDDR5x. Устройство оборудовано 16 фронтальными отсеками для NVMe-накопителей E3.S 1T. При использовании SSD ёмкостью 61,44 Тбайт суммарная вместимость может достигать 983 Тбайт. При этом до 40 серверов могут быть установлены в одну стойку, что обеспечит 39,3 Пбайт «сырой» ёмкости. Новинка располагает двумя внутренними посадочными местами для M.2 NVMe SSD и двумя слотами PCIe 5.0 x16 для карт типоразмера FHHL. Присутствуют сетевой порт управления 1GbE (RJ45), порт USB 3.0 Type-A и разъём mini-DP. Габариты сервера составляют 772,15 × 438,4 × 43,6 мм, масса — 19,8 кг без установленных накопителей. Питание обеспечивают два блока мощностью 1600 Вт с сертификатом 80 Plus Titanium. Применена система воздушного охлаждения с восемью съёмными вентиляторами диаметром 40 мм. Диапазон рабочих температур — от +10 до +35 °C. При необходимости сервер может быть оснащён двумя DPU NVIDIA BlueField-3 или двумя адаптерами ConnectX-8. Система подходит для поддержания рабочих нагрузок с интенсивным обменом данными, таких как ИИ-инференс, аналитика и пр. Отмечается, что при создании новинки Supermicro тесно сотрудничала с NVIDIA и WEKA (разработчик платформ хранения данных). |

|