Материалы по тегу: ice lake-sp

|

30.10.2025 [18:24], Сергей Карасёв

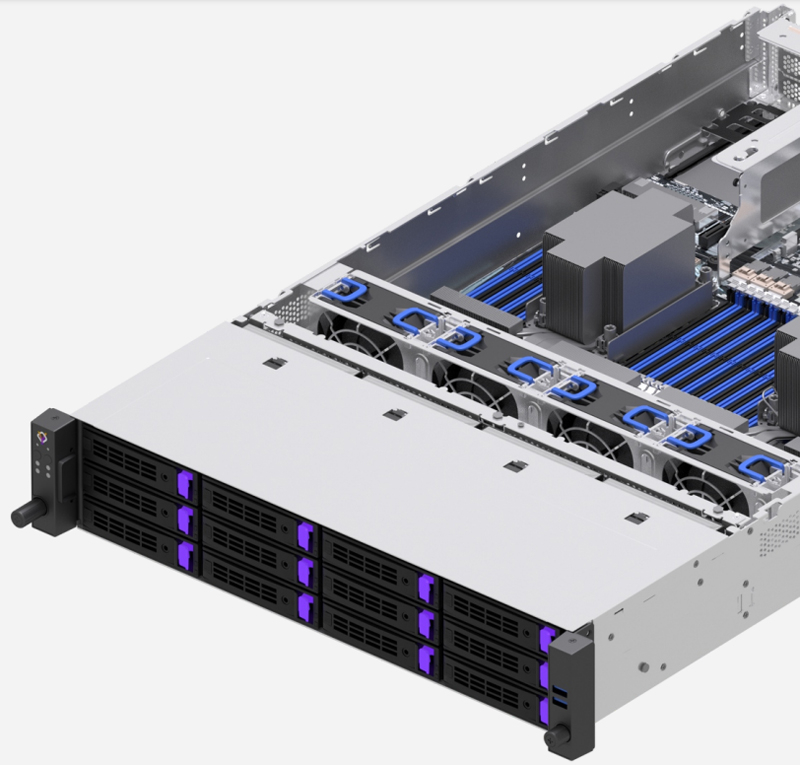

OpenYard представила объектное хранилище Vortex Object на платформе IntelРоссийский разработчик и производитель серверного оборудования OpenYard сообщил о выпуске объектного хранилища Vortex Object, которое, по словам компании, предназначено для масштабируемого и отказоустойчивого хранения неструктурированных данных. Программно-аппаратный комплекс базируется на 2U-сервере OpenYard RS201I-68R. Устройство оснащается процессорами Intel Xeon Gold 6342 поколения Ice Lake-SP (24C/48T) с максимальной частотой 3,5 ГГц. Объём оперативной памяти DDR4 составляет 512 Гбайт на узел. Сервер допускает установку 12 накопителей LFF (173 Тбайт «сырой» ёмкости) и двух накопителей SFF. Упомянуты три слота PCIe 4.0 x16, пять разъёмов PCIe 4.0 x8, по одному слоту OCP 3.0 и OCP 2.0. Есть четыре сетевых порта 25GbE и выделенный сетевой порт 1GbE BMC. Питание обеспечивают два блока мощностью 1600 Вт с резервированием. Решение совместимо с Amazon S3 API, в том числе с расширениями, а также с GeeseFS. Реализованы различные средства безопасности (SAML, тенанты, RBAC, ACL/Policy) и защиты данных (геораспределённый кластер, фактор реплицированния для бакетов или объектов, EC). Управление системой осуществляется через интерфейс UI и CLI-инструменты, а мониторинг и сбор метрик в реальном времени выполняются с помощью Prometheus и Grafana.

Источник изображения: OpenYard Объектное хранилище может применяться в облачных, локальных и гибридных средах. В число возможных сценариев использования входят резервное копирование и архивирование, сбор и аналитика данных, системы видеонаблюдения, хостинг статических сайтов, хранение мультимедийных данных и пр. Минимальная конфигурация включает четыре узла, но допускается масштабирование до десятков стоек. «Релиз Vortex Object — это важный шаг для OpenYard. Мы выходим на новый для нас рынок систем хранения данных, формируя портфель продуктов, способный закрывать все потребности заказчиков. OpenYard двигается от модели производителя серверного оборудования к модели поставщика конечных решений. VortexObject сочетает надёжность, масштабируемость, отказоустойчивость и производительность, востребованные в государственном секторе, больших корпорациях и сервис-провайдерах», — говорит компания.

12.09.2025 [16:30], Сергей Карасёв

«Аквариус» представил российские серверы Aquarius AQserv AS на базе Intel Xeon Ice Lake-SPРоссийская компания «Аквариус» анонсировала двухсокетные серверы семейства Aquarius AQserv AS на аппаратной платформе Intel Xeon Ice Lake-SP. Устройства подходят для широкого спектра задач, включая виртуализацию и развёртывание программно-определяемых хранилищ (SDS), а также построение систем резервного копирования, видеонаблюдения и потокового видео. В серию вошли модели Aquarius AQserv T50 D108AS, Aquarius AQserv T50 D212AS и Aquarius AQserv T50 D436AS в форм-факторе 1U, 2U и 4U соответственно. Младшая допускает установку процессоров с TDP до 185 Вт, две другие — до 235 Вт. Все серверы располагают 16 слотами для модулей DDR4-3200 суммарным объёмом до 4 Тбайт. У версии Aquarius AQserv T50 D108AS во фронтальной части расположены по четыре отсека для накопителей SFF (SAS/SATA) и LFF/SFF (SAS/SATA/NVMe) с возможностью горячей замены. Есть два внутренних коннектора для SSD типоразмера M.2 2280 с интерфейсом PCIe 4.0 x4, а также по одному слоту PCIe 4.0 x16 (x8) и PCIe 4.0 x16 для низкопрофильных карт расширения. Применены два блока питания мощностью 750 Вт с сертификатом 80 PLUS Platinum / Titanium. Модель Aquarius AQserv T50 D212AS, в свою очередь, получила четыре отсека для накопителей LFF/SFF (SAS/SATA/NVMe) и восемь отсеков для устройств LFF/SFF (SAS/SATA) во фронтальной части, два тыльных посадочных места для накопителей SFF (SAS/SATA/NVMe) c горячей заменой и два внутренних коннектора M.2 2280 (PCIe 4.0 x4). Доступны четыре слота PCIe 4.0 x16 и два разъёма PCIe 4.0 x8 для низкопрофильных карт расширения. За питание отвечают два блока мощностью до 2000 Вт с сертификатом 80 PLUS Platinum / Titanium. Старшая версия, Aquarius AQserv T50 D436AS, может нести на борту до 40 накопителей в следующей конфигурации: 24 × LFF/SFF (SAS/SATA) спереди, 2 × SFF SAS/SATA/NVMe) и 12 × LFF/SFF (SAS/SATA) сзади, 2 × M.2 2280 (PCIe 4.0 x4) во внутренней части. Предусмотрены четыре слота PCIe 4.0 x16 и два слота PCIe 4.0 x8. Установлены два блока питания мощностью до 2000 Вт (80 PLUS Platinum / Titanium). Все новинки оборудованы контроллером Aspeed AST2500, двумя портами 2.5GbE (Intel I225/I226) и двумя портами 10GbE (Intel x710), интерфейсами D-Sub и USB 3.2 Gen1 Type-A, последовательным портом. Применена система воздушного охлаждения с быстрозаменяемыми вентиляторами с ШИМ-управлением. Серверы снабжены системой удалённого управления «Аквариус Командир» с выделенным портом, который предоставляет полный контроль через WebUI, а также IPMI 2.0 и Redfish. Кроме того, устройства имеют расширенные возможности администрирования из любой точки мира (KVMoIP и Remote Media Redirection) и поддержку централизованного мониторинга. Заявлена совместимость с Astra Linux 1.7.5 и выше, «Альт Сервер» 10, «РЕД ОС» 7.3 и выше, Windows Server 2016/2019, Red Hat Enterprise Linux Server 8.x и Ubuntu 22.04.

11.08.2025 [19:06], Сергей Карасёв

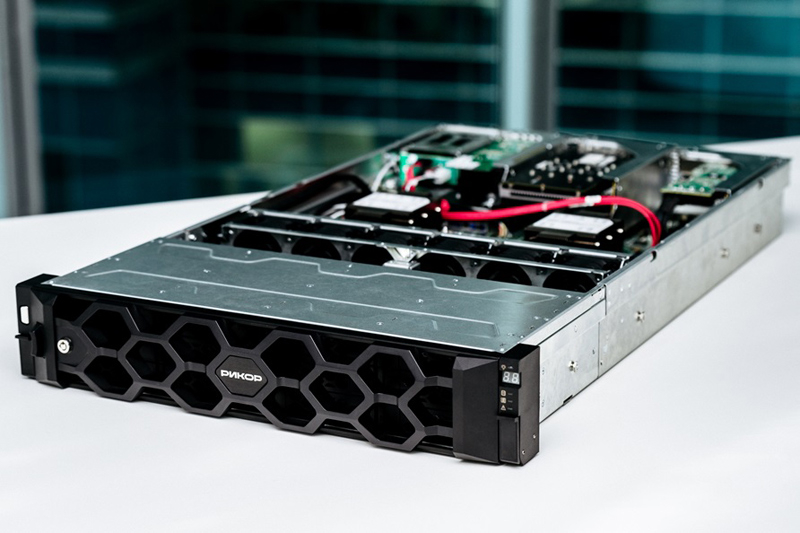

«Рикор» представил российские 1U-серверы RS7104 и RS7110 на базе Intel Xeon Ice Lake-SPКомпания «Рикор» сообщила о разработке новых корпусов типоразмера 1U для своих серверов. Первыми решениями на основе таких шасси стали модели Rikor RS7104 и Rikor RS7110 на платформах RP7104 и RP7110 соответственно, ориентированные на корпоративные, облачные и индустриальные задачи. Оба варианта используют процессоры Intel Xeon Ice Lake-SP. Сервер Rikor RS7104, как отмечается, подходит для работы с бухгалтерскими системами, включая 1С, для управления корпоративной сетью, хранения данных, офисных приложений и базовой инфраструктуры. В свою очередь, Rikor RS7110 предназначен для более ресурсоёмких задач, включая многопользовательские среды, виртуализированные системы и платформы видеонаблюдения. Устройства могут нести на борту два процессора с TDP до 235 Вт и до 8 Тбайт оперативной памяти DDR4 ECC. Предусмотрены два слота расширения PCIe 4.0, а также четыре сетевых порта 1GbE (опционально 10/25/100GbE). Говорится о поддержке удалённого администрирования. Вариант Rikor RS7104 допускает установку четырёх накопителей SFF или LFF с интерфейсом SATA/SAS, а версия Rikor RS7110 — десяти накопителей SFF SATA/SAS/NVMe. Для подключения накопителей на плате доступны четыре интерфейса Slimline SAS x8 (доступен VROC). В обоих случаях используется пассивный baclplane. Серверы располагают двумя внутренними коннекторами M.2 для SSD формата 2280 M-Key с интерфейсом PCIe x4, а также слот MicroSD. Есть два слота PCIe 4.0 x16 для установки плат расширения FHFL, два порта USB 3.0, аналоговый интерфейс D-Sub, последовательный порт RS-232, сетевой порт 1GbE (разъём RJ45 для ASPEED AST2500), интерфейс OCP PCIe 4.0 x16 (4 × RJ45 1GbE — зависит от конфигурации). Питание обеспечивают два блока мощностью от 800 до 2400 Вт с сертификатом 80 PLUS Platinum. Используется система воздушного охлаждения с семью вентиляторами с ШИМ-управлением. Габариты составляют 482 × 46 × 810 мм, масса — около 4 кг. Говорится о совместимости с ОС Astra Linux, РЕД ОС, РОСА, Windows Server 2019/2024, RedHat Linux Server 7.x и Ubuntu 16.04 (LTS), а также с системами виртуализации ORIONsoft zVirt, ROSA Virtualization и SharxDC SharxBase. «Рикор» отмечает, что серверы получили заключение Минпромторга России, подтверждающее их производство на территории страны. Это, как утверждается, предоставляет заказчикам ряд преимуществ. В частности, устройства могут участвовать в государственных и корпоративных тендерах с требованиями по локализации. Решения соответствуют критериям импортозамещения, а также дают право на получение мер господдержки в рамках программ цифровой трансформации.

18.10.2024 [09:25], Сергей Карасёв

«Рикор» представила серверы на базе Intel Xeon Ice Lake-SP, адаптированные для российских заказчиковКомпания «Рикор» анонсировала серверы 7-й серии, которые, как утверждается, отличаются глубоким уровнем локализации: в России произведены печатные платы, некоторые внутренние компоненты и корпус. Устройства включены в Единый реестр российской промышленной продукции Минпромторга РФ. В основу положена аппаратная платформа Intel Xeon Ice Lake-SP. На сегодняшний день в новом семействе представлены модели Rikor 7104 gen.3 PROP и Rikor 7212 gen.3 PROP типоразмера 1U и 2U соответственно. Они оснащены материнской платой на чипсете Intel C621A с возможностью установки двух процессоров с TDP до 175 и 270 Вт. Доступны 32 слота для модулей DDR4-3200 суммарным объёмом до 4 Тбайт. Сервер 1U получил четыре фронтальных отсека для накопителей LFF/SFF с горячей заменой, вариант 2U — 12 отсеков. Кроме того, у старшей версии есть два посадочных места для SFF-устройств в тыльной части. Обе новинки располагают двумя коннекторами для SSD формата М.2. В оснащение входят контроллеры Aspeed AST2500/Rikor BMC, три слота PCIe 4.0, разъём OCP 3.0. Есть два сетевых порта 1GbE RJ45, выделенный сетевой порт управления, четыре порта USB 3.2 Gen1 и два порта USB 2.0, коннектор D-Sub. Питание обеспечивают два блока мощностью 1200 Вт.

Источник изображения: «Рикор» Отмечается, что новая серверная платформа представляет собой результат трёхлетней работы команды инженеров и разработчиков «Рикор». Среди её ключевых преимуществ названы: полная локализация производства, модульная конструкция, возможность горячей замены компонентов (включая блоки питания) и удалённое управление. Серверы, по заявлениям разработчика, подходят для широкого круга организаций — от корпораций федерального масштаба до небольших компаний, использующих оборудование вне дата-центров. Новинки ориентированы на облачные платформы, виртуализацию, терминальные сервисы и высокопроизводительные вычисления. Сейчас компания работает над серверами с Intel Xeon Sapphire Rapids и Emerald Rapids на базе тех же шасси, но с новыми материнскими платами.

13.09.2024 [00:17], Владимир Мироненко

Производительность суперкомпьютера «Сергей Годунов» выросла вдвое — до 114,67 Тфлопс

a100

hardware

hpc

ice lake-sp

intel

nvidia

rtx

xeon

новосибирск

россия

рск

сделано в россии

суперкомпьютер

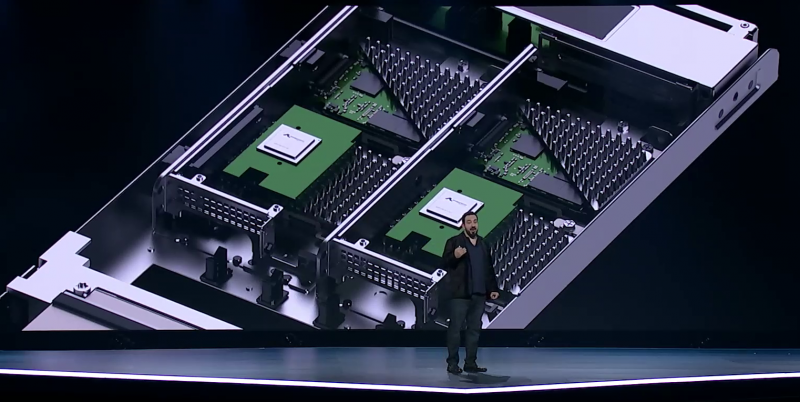

Группа компаний РСК сообщила о завершении плановой модернизации суперкомпьютера «Сергей Годунов» в Институте математики имени С.Л. Соболева Сибирского отделения Российской академии наук (ИМ СО РАН), благодаря чему его суммарная пиковая FP64-производительность теперь составляет 114,67 Тфлопс: 75,87 Тфлопс на CPU и 38,8 Тфлопс на GPU. Работы по запуску машины были завершены РСК в ноябре 2023 года, а её официальное открытие состоялось в феврале этого года. На тот момент производительность суперкомпьютера составляла 54,4 Тфлопс. Директор ИМ СО РАН Андрей Евгеньевич Миронов отметил, что использование нового суперкомпьютера позволило существенно повысить эффективность научных исследований, и выразил уверенность, что он также будет способствовать развитию новых технологий. Миронов сообщил, что после запуска суперкомпьютера появилась возможность решать мультидисциплинарные задачи, моделировать объёмные процессы и предсказывать поведение сложных математических систем. По его словам, на суперкомпьютере проводятся вычисления по критически важным проблемам и задачам, среди которых:

Суперкомпьютер «Сергей Годунов» является основным инструментом для проведения исследований и прикладных разработок в Академгородке Новосибирска и создания технологической платформы под эгидой Научного совета Отделения математических наук РАН по математическому моделированию распространения эпидемий с учётом социальных, экономических и экологических процессов. Он был назван в память об известном советском и российском математике с мировым именем Сергее Константиновиче Годунове. Отечественный суперкомпьютер создан на базе высокоплотной и энергоэффективной платформы «РСК Торнадо» с жидкостным охлаждением. Система включает вычислительные узлы с двумя Intel Xeon Ice Lake-SP, узел на базе четырёх ускорителей NVIDIA A100 и сервер визуализации с большим объёмом памяти: Intel Xeon Platinum 8368, 4 Тбайт RAM, пара NVIDIA RTX 5000 Ada с 32 Гбайт GDDR6.

21.05.2024 [20:29], Сергей Карасёв

Росбанк перевёл процессинг на российские серверы YADRO Vegman R220 G2

hardware

ice lake-sp

intel

xeon

yadro

импортозамещение

миграция

росбанк

россия

сделано в россии

сервер

Росбанк объявил о переводе IT-инфраструктуры своей процессинговой платформы на отечественные серверы нового поколения Yadro. Проект реализован совместно с компанией UCS. Речь идёт о закупке 24 систем Vegman R220 G2, которые были отгружены производителем в кратчайшие сроки — в течение четырёх недель. Yadro Vegman R220 G2 — это двухсокетная 2U-платформа для виртуализации, HPC, облачных приложений, СУБД и других задач. Поддерживается установка двух процессоров Intel Xeon Ice Lake-SP с TDP до 270 Вт. Доступны 32 слота для модулей DDR4-3200/2933 суммарным объёмом до 8 Тбайт. Предлагаются варианты конфигурации с 12 накопителями LFF SAS/SATA (8 × NVMe) спереди и 24 фронтальными SFF-накопителями SAS/SATA (8 × NVMe). Дополнительно предусмотрены 4 посадочных места для устройств SFF SAS/SATA/NVMe сзади. Говорится о поддержке массивов RAID 0/1/10/5/50/6/60. Плюс к этому есть два коннектора M.2 SATA. Сервер поддерживает до 10 слотов PCIe 4.0 с учетом разъёма OCP 3.0. Питание обеспечивают два блока с сертификатом Platinum мощностью до 2600 Вт. Установлены четыре вентилятора на 80 мм с горячей заменой. Упомянуты четыре сетевых порта 1GbE и выделенный порт управления. Диапазон рабочих температур — от +10 до +35 °C. Оборудование внесено в реестр радиоэлектронной продукции Минпромторга и производится на крупнейшем в России заводе полного цикла Ядро Фаб Дубна. «Росбанк постоянно находится в поиске новых продуктовых предложений и решений в области процессинга, способов их реализации и вывода на рынок. Современная аппаратная инфраструктура — фундамент этой системы, поэтому мы выбрали компанию Yadro, доверенного отечественного разработчика и производителя вычислительных платформ», — говорит директор департамента IT-инфраструктуры Росбанка.

18.04.2024 [13:50], Сергей Карасёв

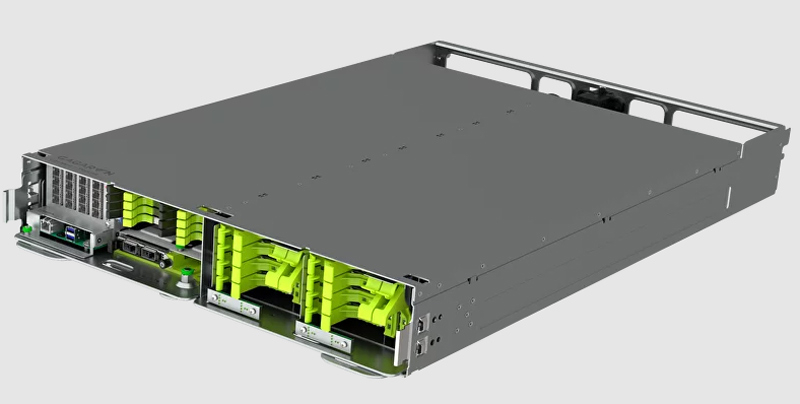

Компания Gagar>n представила OCP-серверы «Оракул Gen 3» и «Простор Gen 1» на базе Intel XeonРоссийская компания Gagar>n, занимающаяся производством оборудования корпоративного класса и ПО, анонсировала OCP-серверы «Оракул Gen 3» и «Простор Gen 1», которые, как утверждается, подходят для решения широкого спектра задач. В основу новинок, разработанных в России, положена аппаратная платформа Intel. Модель «Оракул Gen 3» может применяться для построения горизонтально-масштабируемых систем хранения и обработки данных. Сервер выполнен в формате 2OU и может размещаться в шкафу стандарта OCP Rack v2. Устройство способно нести на борту два процессора Intel Xeon поколения Ice Lake-SP (до 40 ядер; TDP до 270 Вт) и 32 модуля оперативной памяти DDR4-3200 суммарным объёмом до 8 Тбайт. Доступны три слота PCIe 4.0 x16, а также по одному разъёму PCIe 4.0 x8 и OCP 3.0 x16. Основная подсистема хранения данных включает до восьми SFF-накопителей U.2 NVMe/SATA на передней панели с поддержкой горячей замены. Кроме того, в зависимости от модификации допускается дополнительная установка 24 изделий формата SFF с интерфейсом SAS/SATA или 16 накопителей SFF U.2/NVMe или же 12 накопителей LFF с интерфейсом SAS/SATA. Есть и два коннектора M.2 PCIe.

Источник изображений: Gagar>n В свою очередь, сервер «Простор Gen 1» стандарта 2OU комплектуется двумя процессорами Intel Xeon Cascade Lake-SP (до 28 ядер; TDP до 205 Вт). Предусмотрены 12 слотов для модулей DDR4-2933 суммарным объёмом до 1,5 Тбайт. Есть по одному разъёму PCIe 3.0 x16 и OCP 2.0 x16. Возможна установка до четырёх накопителей SFF NVMe SSD с поддержкой горячей замены, а также до 16 изделий SFF NVMe SSD или LFF SAS/SATA HDD. Плюс к этому доступен один коннектор М.2. Система подходит для организации файлового, блочного и объектного хранения. Серверы оснащены сетевым портом 1GbE RJ-45 и портами USB 3.0 Type-A. Применяются вентиляторы охлаждения диаметром 80 мм. Заявлена совместимость с платформами РОСА, Red OS, Astra Linux, ALT Linux, Red Hat, VMware и др.

26.02.2024 [13:44], Сергей Карасёв

В России официально представлен суперкомпьютер «Сергей Годунов» производительностью 54,4 ТфлопсВ Институте математики имени С. Л. Соболева Сибирского отделения Российской академии наук (ИМ СО РАН) официально представлен вычислительный комплекс «Сергей Годунов», названный в честь известного советского и российского математика. Монтажом и тестированием системы занимались специалисты группы компаний РСК. Суперкомпьютер создан на базе высокоплотной и энергоэффективной платформы «РСК Торнадо» с жидкостным охлаждением. Каждый из узлов в составе системы оснащён двумя процессорами Intel Xeon Ice Lake-SP с 38 ядрами, работающими на базовой частоте 2,4 ГГц. Производительность кластера на момент запуска составляет 54,4 Тфлопс. Предполагается, что HPC-комплекс поможет повысить эффективность научных исследований и будет способствовать развитию новых технологий. Среди сфер применения суперкомпьютера названы: медицинская электроакустическая томография; моделирование эпидемиологических, экологических, экономических и социальных процессов; вычислительная аэрогидродинамика и задачи оптимизации турбулентных течений; моделирование и построение сценариев развития системы биосфера-экономика-социум с учётом безуглеродного и устойчивого развития и изменения климата; решение обратных задач геофизики прямым методом на основе подхода Гельфанда-Левитана-Крейна». Отмечается, что монтажные и пуско-наладочные работы в рамках проекта произведены в сжатые сроки — за 3,5 недели. В перспективе возможности системы будут расширяться. В частности, в 2024 году планируется осуществить модернизацию, которая позволит более чем вдвое нарастить производительность — до 120,4 Тфлопс. «У нас появилась возможность решать мультидисциплинарные задачи, моделировать объёмные процессы и предсказывать поведение сложных математических систем. На суперкомпьютере проводятся вычисления по критически важным проблемам и задачам, стоящим перед РФ», — отмечает исполняющий обязанности директора ИМ СО РАН Андрей Миронов. В целом, запущенный комплекс является основным инструментом для проведения исследований и прикладных разработок в академгородке Новосибирска и создания технологической платформы под эгидой Научного совета Отделения математических наук РАН по математическому моделированию распространения эпидемий с учётом социальных, экономических и экологических процессов.

15.12.2023 [00:30], Алексей Степин

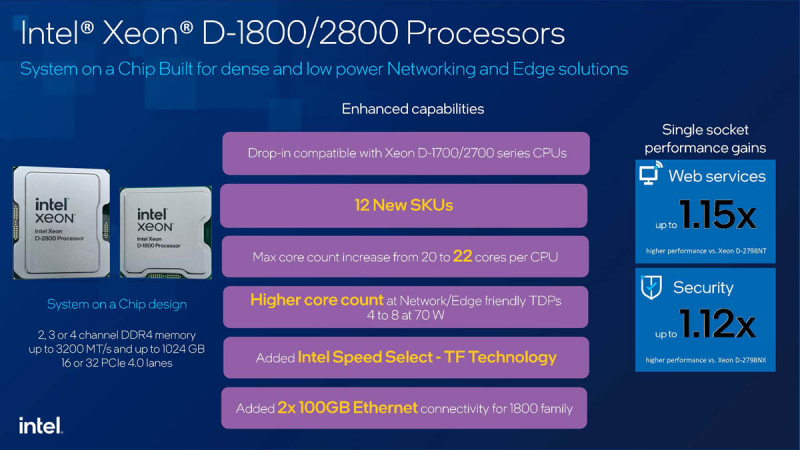

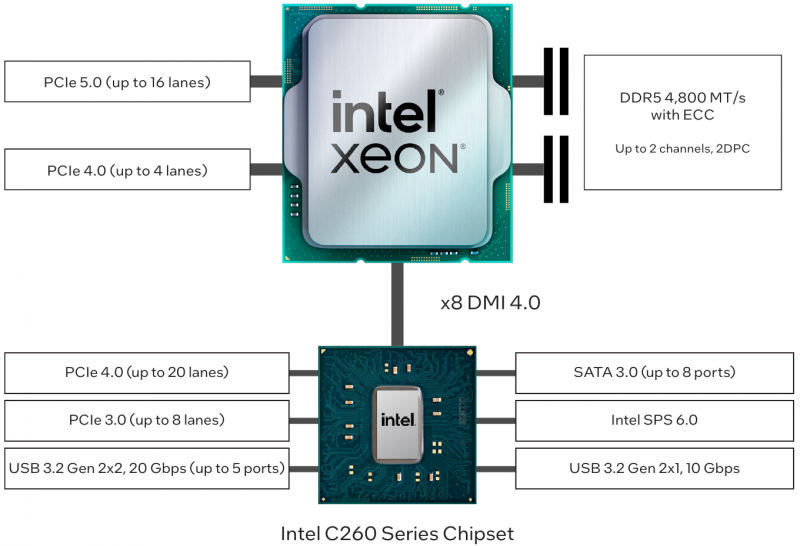

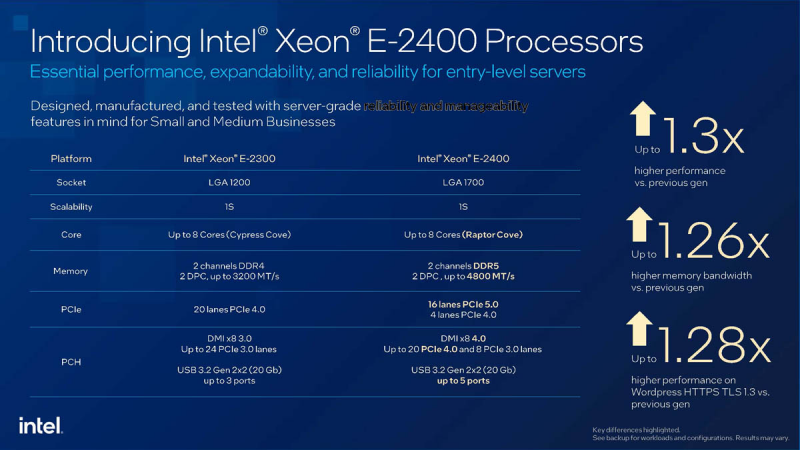

Intel представила процессоры Xeon D-1800/2800 и E-2400 для edge-систем и серверов начального уровняНаряду с анонсом процессоров Xeon Scalable пятого поколения компания Intel обновила и модельные ряды Xeon D и Xeon E. Изменений и нововведений в представленных чипах достаточно много. Так, модельный ряд Xeon D по традиции поделён на две ветви: Xeon D-1800 и Xeon D-2800. Уже сериии Xeon D-1700 и D-2700 были адаптированы для работы в серверах периферийных вычислений и в составе сетевого оборудования. Напомним ключевые моменты:

Всё это характерно и для новых Xeon D-1800 и D-2800, ведь в их основе лежит прежняя архитектура Ice Lake-D. Речь всё ещё идёт о сочетании DDR4 и PCI Express 4.0, однако улучшения всё же есть: оптимизация техпроцесса позволила довести максимальное количество ядер до 22 против 20 у предыдущих моделей при неизменном теплопакете. Небольшой прирост производительности тоже есть — примерно 1,12-1,15х у старшей модели Xeon D-2800. Кроме того, процессоры Xeon D-1800, наконец, получили поддержку двух 100GbE-портов. Одновременно с анонсом новых Xeon D состоялся анонс серии Xeon E-2400, которая заменит Xeon E-2300. Изменений здесь существенно больше. Во-первых, платформа перебралась с LGA 1200 на LGA 1700, а на смену ядрам Cypress Cove пришли Raptor Cove. И хотя E-ядер в составе CPU нет, Intel почему-то решила не активировать поддержку AVX-512. Во-вторых, существенный апгрейд претерпела подсистема памяти: вместо двух каналов DDR4-3200 теперь доступна пара каналов DDR5-4800. Наконец, Xeon E-2400 получили поддержку PCI Express 5.0 — из 20 имеющихся процессорных линий 16 теперь способны работать именно в этом режиме. Подросла версия DMI с 3.0 до 4.0, а PCH новой платформы теперь предоставляет 20 линий PCIe 4.0 и 8 линий PCIe 3.0. Заодно с трёх до пяти выросло количество портов USB 3.2 Gen 2x2 (20 Гбит/с). Максимальное число ядер в новой серии Xeon E осталось прежним — их всё ещё восемь, но благодаря существенно более быстрой памяти и использованию техпроцесса Intel 7 Ultra производительность новинок в среднем в 1,3 раза выше, чем у предшественников. Базовая частота подросла до 3,5 ГГц, в турборежим частота доходит до 5,6 ГГц, но при этом теплопакет не выходит за рамки 95 Вт. Нацелены Intel Xeon E-2400 на рынок серверов и облачных систем начального уровня.

02.05.2022 [01:08], Владимир Мироненко

AWS представила инстансы I4i с Intel Xeon Ice Lake-SP и NVMe-накопителями Nitro SSD собственной разработкиAWS представила инстансы I4i со сверхбыстрым хранилищем. Новинки используют Intel Xeon Ice Lake-SP и NVMe-накопители Nitro SSD, разработанные самой Amazon. I4i обеспечивают снижение задержки операций ввода-вывода до 60 % (разброс тоже ниже на 75 %) по сравнению с инстансами I3, а также до 30 % лучшее соотношение цены и производительности. Благодаря использованию сразу нескольких компонентов Nitro, все физические ресурсы узлов доступны инстансам практически полностью. I4i «предназначены для минимизации задержки и максимизации количества транзакций в секунду (TPS) для рабочих нагрузок, которым требуется очень быстрый доступ к наборам данных среднего размера в локальном хранилище. Сюда входят транзакционные базы данных, такие как MySQL, Oracle DB и Microsoft SQL Server, а также базы данных NoSQL: MongoDB, Couchbase, Aerospike, Redis и т.д.». Они также подходят для рабочих нагрузок, требующих высокую производительность вычислений в пересчёте на Тбайт хранилища, таких как аналитика данных и поисковые системы.

Узлы с Nitro SSD (Изображение: AWS) У всех новинок частота всех ядер в турборежиме составляет 3,5 ГГц; есть поддержка AVX-512 и Intel Total Memory Encryption. Для особо ресурсоёмких задач предлагается инстанс I4i.32xlarge: 128 vCPU, 1 Тбайт RAM (с NUMA), сетевое подключение 75 Гбит/с, 40-Гбит/с доступ к EBS-томам и восемь локальных Nitro SSD суммарной ёмкостью 30 Тбайт. Nitro SSD имеют продвинутую прошивку, отвечающую за реализацию многих функций, включая телеметрию и диагностику на лету, а также управление хранилищем на уровне инстанса для повышения надёжности и обеспечения стабильного уровня производительности. Инстансы I4i уже доступны в регионах AWS US East (Северная Виргиния), US East (Огайо), US West (Орегон) и Европа (Ирландия) по запросу и в качестве спотовых и зарезервированных. Доступны планы Savings, а также выделенные инстансы и выделенные хосты. Клиентам рекомендуется использовать последние AMI, включающие текущие драйверы ENA и поддержку NVMe 1.4. |

|