Материалы по тегу: ff

|

12.03.2025 [00:25], Владимир Мироненко

Meta✴ начала тестирование собственного ускорителя для обучения ИИ-моделейMeta✴ Platforms приступила к тестированию ИИ-ускорителя собственной разработки, который, в случае успеха, позволит ей снизить зависимость от поставок чипов NVIDIA, пишет Reuters со ссылкой на информированные источники. По словам одного из источников, новый чип Meta✴ представляет собой специализированный ускоритель, то есть ASIC, предназначенный для обработки только ИИ-нагрузок. Небольшую пробную партию чипов Meta✴ изготовила тайваньская TSMC. По словам собеседника Reuters, тестирование началось после завершения фазы Tape-out — это заключительный этап разработки чипов перед началом производства, что является значительным маркером успеха в их разработке, отметило Reuters. Обычно этап Tape-out занимает от трёх до шести месяцев, причём без гарантии, что всё пройдёт успешно, и обходится в десятки миллионов долларов. В случае неудачи Meta✴ потребуется диагностировать проблему и начать всё заново. Этот чип представляет собой новое поколение ИИ-ускорителей, разработанных в рамках программы Meta✴ Training and Inference Accelerator (MTIA). Разработка продвигается с переменным успехом уже много лет. В прошлом году Meta✴ добилась определённых успехов — второе поколение ИИ-ускорителей Meta✴ MTIA оказалось втрое быстрее первого. В прошлом году Meta✴ начала использовать MTIAv2 для инференса рекомендательных систем Facebook✴ и Instagram✴.

Источник изображения: Meta✴ Meta✴ сообщила, что планирует к 2026 году начать использовать собственные ИИ-чипы для обучения моделей. Как и в случае с чипом для инференса, новый ИИ-ускоритель сначала пройдёт проверку в работе с рекомендательными системами, после чего его задействуют для приложений генеративного ИИ, таких как чат-бот Meta✴ AI, заявили в Meta✴. Крис Кокс (Chris Cox), директор по продуктам Meta✴, сообщил, что разработка чипов идёт с переменным успехом, отметив, что руководство компании посчитала ИИ-ускоритель для инференса первого поколения «большим успехом». Однако тестовые испытания он провалил, так что в 2022 году компания стала заказывать ускорители NVIDIA. С тех она остаётся крупным клиентом NVIDIA, используя её чипы как для обучения своих моделей, так и для инференса. Meta✴ прогнозирует общие расходы в 2025 году в размере от $114 до $119 млрд, в том числе до $65 млрд капитальных затрат, в основном связанных с расширением ИИ-инфраструктуры. Использование собственных чипов позволит компании значительно снизить затраты на это направление.

08.03.2025 [21:26], Сергей Карасёв

Team Group представила самоуничтожающиеся SSD P250Q, а также DDR5-модули памяти CU-DIMM, CSO-DIMM, (LP)CAMM и CXLКомпания Team Group 2025 анонсировала большое количество новинок для индустриального и коммерческого применения. Дебютировали SSD в различных форм-факторах, модули оперативной памяти, а также флеш-карты micro SD. В частности, представлен накопитель P250Q One-Click Data Destruction SSD, особенность которого заключается в поддержке физического уничтожения флеш-памяти с целью недопустимости извлечения информации. Эта функция дополняет традиционное программное стирание, исключая возможность восстановления конфиденциальных данных. Кроме того, анонсированы накопители RF40 E1.S Enterprise SSD в форм-факторе E1.S для дата-центров. Эти устройства допускают горячую замену, а за отвод тепла отвечает запатентованный медно-графеновый радиатор толщиной всего 0,17 мм. На промышленный сектор ориентированы изделия серий R840 и R250 типоразмера М.2, оснащённые интерфейсом PCIe 5.0 x4. В этих SSD применён контроллер, при производстве которого используется 6-нм технология TSMC. Информация о вместимости и скоростных характеристиках всех перечисленных изделий пока не раскрывается. В список новинок вошли модули оперативной памяти промышленного класса DDR5 стандартов CU-DIMM (Clocked Unbuffered DIMM) и CSO-DIMM (Clocked Small Outline DIMM). Они функционируют на частоте 6400 МГц при напряжении питания 1,1 В. Эти модули могут применяться в серверах, индустриальных ноутбуках повышенной прочности и пр.

Источник изображения: Team Group Анонсированы также модули памяти CAMM2 и LPCAMM2 (Compression Attached Memory Module 2), рассчитанные на промышленные системы, edge-устройства и пр. Такие решения монтируются параллельно материнской плате, благодаря чему занимают меньше места в высоту. Для установки применяются резьбовые стойки. Память соответствует стандарту DDR5-6400.

В число прочих новинок вошли серверные модули памяти CXL 2.0 Server Memory Module. Плюс к этому представлены карты памяти D500R WORM Memory Card и D500N Hidden Memory Card. Первые ориентированы WORM-нагрузки (Write Once, Read Many), что предотвращает стирание или изменение данных. Карты второго типа получили встроенную функцию скрытия разделов.

07.03.2025 [12:12], Сергей Карасёв

Advantech представила SSD объёмом до 30,7 Тбайт — интерфейс PCIe 5.0, память TLC, форматы U.2, E1.S и E3.SКомпания Advantech анонсировала SSD семейства SQFlash EU-2 PCIe/NVMe для дата-центров и платформ корпоративного уровня. Изделия выполнены на основе чипов флеш-памяти 3D TLC, а для обмена данными используется интерфейс PCIe 5.0 х4. Дебютировали решения SQF-CU2 EU-2 в форм-факторе SFF U.2 (SFF-8639), SQF-CE3 EU-2 стандарта E3.S (EDSFF 1C), а также SQF-CE1 EU-2 типоразмера E1.S (EDSFF 1C). Во всех случаях реализована поддержка NVMe 2.0, AES-256 и TCG-OPAL. Диапазон рабочих температур простирается от 0 до +70 °C. Накопители могут выдерживать до одной полной перезаписи в сутки (1 DWPD). Серия SQF-CU2 EU-2 включает модификации вместимостью от 1,9 до 30,7 Тбайт. Заявленная скорость последовательного чтения информации достигает o 14 000 Мбайт/с, скорость последовательной записи — 8500 Мбайт/с. Показатель IOPS при произвольном чтении — до 3 млн, при произвольной записи — до 400 тыс. Размеры устройств составляют 100,2 × 69,85 × 15,0 мм.

Источник изображений: Advantech Изделия SQF-CE3 EU-2, в свою очередь, обладают ёмкостью от 1,9 до 15,3 Тбайт. Скорости последовательного чтения и записи — до 14 000 и 8500 Мбайт/с, величина IOPS при произвольных чтении и записи — до 3 млн и 480 тыс. Габариты — 112,75 × 76,0 × 7,5 мм.  В серию SQF-CE1 EU-2 вошли SSD вместимостью от 1,9 до 7,6 Тбайт. Заявленные скорости последовательного чтения и записи достигают 14 000 и 8300 Мбайт/с, величина IOPS — 3 млн и 220 тыс. при произвольных чтении и записи соответственно. Размеры устройств — 118,75 × 33,75 × 9,0/15,0 мм. Кроме того, компания Advantech представила SSD семейства SQF-CE1 930L-D в формате E1.S с интерфейсом PCIe 4.0 х4. Они имеют вместимость от 480 Гбайт до 3,8 Тбайт. Скорость последовательного чтения информации составляет дo 6800 Мбайт/с, скорость последовательной записи — до 2000 Мбайт/с.

05.03.2025 [18:52], Руслан Авдеев

Meta✴ ведёт переговоры о привлечении $35 млрд на строительство ЦОДУправляющий альтернативными активами Apollo Global Management вероятно, возглавит раунд финансирования для привлечения Meta✴ Platforms приблизительно $35 млрд. По данным источников Bloomberg, средства предназначены для строительства новых дата-центров в США. В самой Meta✴ слухи не комментируют. Ранее она уже озвучила планы потратить $65 млрд на ИИ-инфраструктуру в текущем году. В том числе речь идёт о строительстве гигантского ЦОД и наборе сотрудников. Как сообщают источники, Apollo обсуждала возможность предоставления большей части финансов, но в раунде, вероятно, будет участвовать и KKR & Co. Переговоры о финансировании пока находятся на ранней стадии, и нет гарантии, что сделка будет завершена. Управляющие альтернативными активами договаривались о сотрудничестве с техногигантами и раньше, но потенциальная сделка с Meta✴ всё равно выделяется из общего ряда. Так, Databricks ранее привлекла более $5 млрд от компаний вроде Blackstone, Apollo и Blue Owl Capital, а в прошлом году Apollo возглавила раунд финансирования в объёме $11 млрд в совместное предприятие с Intel. По некоторым оценкам, для удовлетворения спроса на ИИ-инфраструктуру требуются сотни миллиардов долларов. Банкиры и инвесторы желают принять участие в подобных проектах, наблюдая за ИИ-компаниями, проявившими себя за прошедший год. В ходе недавних сделок Apollo вносила часть средств, давая возможность вложиться остальным инвесторам. Это позволяет ей принимать участие в крупных проектах с участием привлекательных для инвестиций корпораций.

Источник изображения: Ruthson Zimmerman/unsplash.com В Meta✴ объявили, что намерены ввести в эксплуатацию около 1 ГВт вычислительных мощностей в 2025 году. Уже анонсировано строительство ЦОД за $10 млрд в Луизиане, для некоторых проектов закуплены новые ускорители. В последние годы Meta✴ довольно активно инвестировала в ИИ, а соответствующие продукты являются приоритетными внутри самой компании. По словам главы компании Марка Цукерберга (Mark Zuckerberg), ИИ-бот Meta✴ AI должен стать самым используемым в мире уже к концу года. Meta✴ также вкладывает большие средства в открытые модели семейства Llama. По словам Цукерберга, выступавшего перед инвесторами в январе, её вложения в ИИ-инфраструктуру в конечном итоге достигнут сотен миллиардов долларов. Впрочем, схожими целями могут похвастаться и компании вроде OpenAI. Последняя вовлечена в ИИ-проект Stargate — инвестиции в него составят порядка $100 млрд только на первом этапе, а в конечном итоге сумма может вырасти до $500 млрд.

27.02.2025 [12:37], Сергей Карасёв

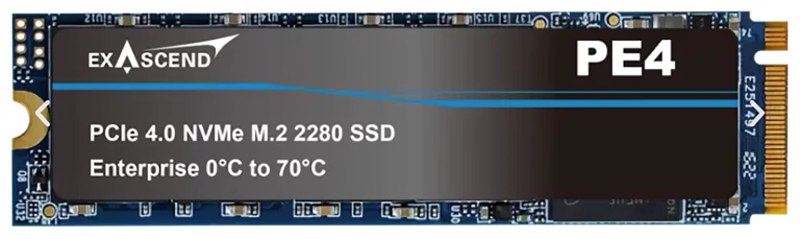

М.2 SSD вместимостью до 15,36 Тбайт: Exascend представила накопители серии PE4Компания Exascend анонсировала SSD семейства PE4 в форм-факторе М.2 2280, способные хранить до 15,36 Тбайт информации. На сегодняшний день это самые вместительные изделия в своём классе. Устройства также доступны в форматах U.2 и E1.S. В основу накопителей положены чипы флеш-памяти 3D TLC NAND, а для обмена данными служит интерфейс PCIe 4.0 (NVMe 1.4). У стандартных (Standard) решений M.2 2280 заявленная скорость последовательного чтения информации достигает 3270 Мбайт/с, скорость последовательной записи — 2980 Мбайт/с. Величина IOPS на операциях произвольного чтения и записи блоками по 4 Кбайт — до 404 тыс. и 52 тыс. соответственно. Вместимость варьируется от 240 Гбайт до 15,36 Тбайт. Помимо стандартных SSD, серия PE4 М.2 2280 включает варианты Pro и Max. Первые используют чипы 3D TLC NAND, а их ёмкость варьируется от 240 Гбайт до 3,84 Тбайт. Скорость чтения/записи — до 3200/3005 Мбайт/с. Значение IOPS при чтении и записи составляет до 381 тыс. и 121 тыс. соответственно. Накопители Max, в свою очередь, построены на чипах pSLC, а их вместимость — от 240 Гбайт до 1,92 Тбайт. Скорость чтения и записи — до 3075 и 2980 Мбайт/с, показатель IOPS при произвольных чтении и записи — до 436 тыс. и 173 тыс.

Источник изображения: Exascend Решения типоразмера U.2 и E1.S также доступны в версиях Standard, Pro и Max. Их ёмкость варьируется от 960 Гбайт до 15,36 Тбайт. Скоростные показатели в целом сопоставимы с таковыми у решений М.2 2280. Все SSD могут эксплуатироваться при температурах от 0 до +70 °C. Значение MTBF (средняя наработка на отказ) достигает 2 млн часов. Говорится о поддержке TCG Opal 2.01, шифрования AES-256, а также аппаратной функции Power Loss Protection (PLP), которая отвечают за сохранность информации при внезапном отключении питания. Производитель предоставляет на изделия пятилетнюю гарантию.

26.02.2025 [13:55], Руслан Авдеев

Meta✴ якобы ведёт переговоры о реализации проекта ИИ ЦОД за $200 млрдКомпания Meta✴ ведёт переговоры о строительстве нового кампуса ЦОД для своих ИИ-проектов. По данным источников, примечательна цена проекта, превышающая $200 млрд, сообщает The Information. Представитель Meta✴ отказался от комментариев, заявив Reuters, что планы строительства дата-центров и капитальные издержки на ближайшее будущее уже раскрыты, а всё прочее — «чистые спекуляции». Руководство компании, по словам The Information, уведомило бизнесы, занимающиеся строительством ЦОД, что IT-гигант рассматривает создание кампуса для проектов, связанных с ИИ, в разных штатах, включая Луизиану, Вайоминг и Техас, и даже посетило потенциальные площадки. Предполагается, что новый объект будет в разы больше, чем ЦОД в Луизиане стоимостью $5 млрд. В январе компании Марк Цукерберг (Mark Zuckerberg) заявил, что в долгосрочной перспективе Meta✴ потратит «сотни миллиардов долларов» на инфраструктуру ИИ. Ранее Meta✴ объявила, что намерена потратить в текущем году до $65 млрд на расширение своей ИИ-инфраструктуры. Для сравнения: Microsoft объявила, что намерена инвестировать $80 млрд в строительство дата-центров в 2025 финансовом году, Amazon (AWS) готова потратить $100 млрд, а Google — $75 млрд. При этом недавно появилась новость, что Microsoft разрывает соглашения об аренде ряда ИИ ЦОД из-за минимального участия в проекте Stargate, который только на первом этапе потребует $100 млрд, а в перспективе не исключены вложения до $500 млрд.

24.02.2025 [15:00], Руслан Авдеев

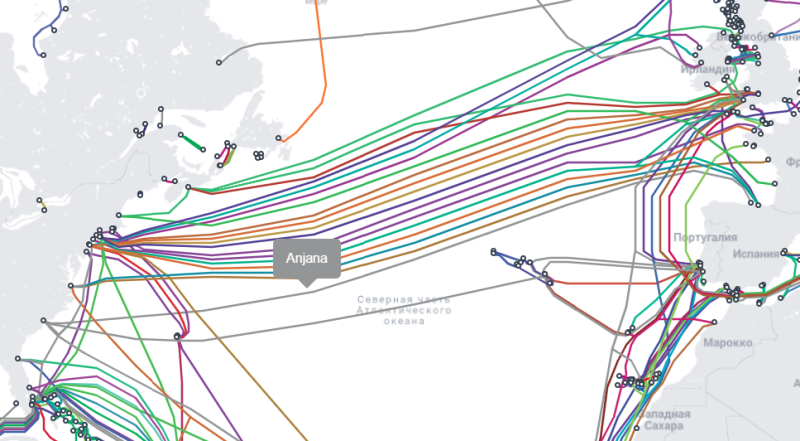

Трансатлантический кабель Meta✴ Anjana установит новый рекорд пропускной способностиИнтернет-кабель Anjana, принадлежащий Meta✴, установил рекорд пропускной способности через Атлантический океан. 24 оптоволоконных пары, каждая из которых способна передавать по 20 Тбит/с, обеспечат рекордную для Атлантики скорость около 500 Тбит/с, пишет Subsea Cables & Internet Infrastructure. Высокая пропускная способность обеспечена благодаря технологии пространственного мультиплексирования (SDM), которая позволяет довести скорость до 200–500 Тбит/с. Ещё одна важная особенность Anjana — его маршрут. Если в 2000 году практически все трансатлантические кабели соединяли Лондон и Нью-Йорк, а европейский трафик проходил через Великобританию, то новая цифровая магистраль соединяет Мертл-Бич (Myrtle Beach, Южная Каролина) и Сантандер (Santander, Испания). В 2008–2015 гг. центр обмена интернет-трафиком сместился с Манхэттена в кампус Equinix в Ашберне (Ashburn) в Алее дата-центров. Кроме того, крупнейшие кабельные системы гиперскейлеров Marea и Dunant были доведены именно до Верджиния-Бич (Virginia Beach, Вирджиния) в обход Нью-Йорка. На другой стороне океана теперь стараются обходить стороной Великобританию, где с 2016 года спецслужбам разрешено прослушивать трафик, предпочитая Францию и Испанию.

Источник изображения: Submarine Cable Map Anjana выводит отказоустойчивость на новый уровень благодаря посадочной станции в Южной Каролине. Из Мертл-Бич Meta✴ способна организовать соединение с крупными телекоммуникационными хабами Атланты, обслуживающими юго-восток Соединённых Штатов, а также перенаправлять трафик на южноамериканские кабели, проходящие через Майами, или в тот же Ашберн. В Европе подключение осуществляется на северном побережье Испании в новом центре Telxius CLS в Сантандере (Santander), который в основном отвечает за питание подводных повторителей. DWDM-техника размещена в 130-МВт дата-центре Merlin Edged в индустриальном парке Arasur недалеко от Бильбао. Между посадочной станцией и ЦОД проложено кольцо из 160 оптоволоконных пар, что позволяет Meta✴ эффективно перенаправлять трафик в Южную Европу, а также в три ключевых международных шлюза обмена трафиком — Марсель, Геную и Лиссабон, обеспечивающим сообщение с Африкой, Ближним востоком, Индией, Северной Африкой и Юго-Восточной Азией. Meta✴ оставляет в запасе возможность продажи части пропускной способности, чтобы компенсировать капитальные затраты на реализацию проекта. Вероятно, одну из оптоволоконных пар или же несколько несущих приобретёт Telxius. На похожих условиях пару волокон или заданную ёмкость, возможно, приобретёт EXA. Операторы являются ключевыми поставщиками подводных пропускных мощностей на трансатлантическом направлении. Anjana должны ввести в эксплуатацию уже в 2025 году. О планах проложить «кабель-рекордсмен» Meta✴ сообщалось ещё весной 2023 года. Впрочем, в октябре того же года сообщалось о готовности и других проектов, например — трансатлантического кабеля Amitié сопоставимой пропускной способности к коммерческой эксплуатации. При этом эксперты отмечают, что гиперскейлеры контролируют большинство подводных кабелей мира — это ставит под угрозу открытость и стабильность интернета.

15.02.2025 [23:59], Сергей Карасёв

50 тыс. км под водой: Meta✴ представила проект Waterworth по созданию самого протяжённого в мире интернет-кабеляКомпания Meta✴ официально анонсировала инициативу Project Waterworth по строительству самого протяжённого в мире подводного интернет-кабеля. После завершения прокладки новая оптоволоконная линия длиной около 50 тыс. км обеспечит высокоскоростную связь в глобальном масштабе, охватив пять континентов. О дорогостоящем проекте сообщалось в декабре прошлого года. Тогда говорилось, что его реализация потребует инвестиций в размере $10 млрд. В результате, Meta✴ получит собственный выделенный канал для передачи данных по всему миру. Это в числе прочего поможет укрепить позиции компании в области ИИ. Подводный кабель Waterworth соединит США, Индию, Бразилию, Южную Африку и другие регионы. Конкретные детали маршрута и сроки реализации проекта не раскрываются. Известно, что линия предусматривает использование 24 пар волокон. Кабель будет проходить на глубине до 7000 м. При развёртывании системы Meta✴ намерена применять усовершенствованные методы заглубления в зонах повышенного риска, таких как мелководье вблизи побережья: это обеспечит улучшенную надёжность и защиту от возможных повреждений якорями морского транспорта.

Источник изображений: Meta✴ Meta✴ заявляет, что многомиллиардный многолетний проект Waterworth поможет в расширении и повышении стабильности глобальных цифровых магистралей благодаря формированию трёх новых океанических коридоров с высокой пропускной способностью. Это, как утверждается, откроет дополнительные возможности в плане внедрения инноваций в области ИИ по всему миру. В частности, Waterworth поможет в укреплении цифровой инфраструктуры в Индии — самой густонаселённой стране мира. Нужно отметить, что Meta✴ участвует в ряде других проектов по прокладке интернет-кабелей, включая Echo и Bifrost, Havhingsten, Amite и Anjana. Кроме того, компания является ключевым владельцем самой протяжённой на данный момент кабельной системы 2Africa. В январе сообщалось, что Meta✴ также проложит тихоокеанский интернет-кабель ORCA, связывающий Тайвань с США. Эксперты отмечают, что теперь именно гиперскейлеры контролируют большинство подводных интернет-кабелей, что ставит под угрозу открытость и стабильность Сети.

14.02.2025 [09:45], Сергей Карасёв

Arm выпустит собственные чипы для ЦОД, а их первым покупателем станет Meta✴Британская компания Arm, 90 % которой принадлежит японскому холдингу SoftBank, выйдет на рынок процессоров для серверов, ориентированных на крупные дата-центры. Как сообщает газета Financial Times, эти изделия дебютируют в текущем году, а их первым заказчиком станет Meta✴ Platforms. Весной 2024 года сообщалось, что Arm намерена разработать собственный ИИ-чип. Тогда говорилось, что его массовый выпуск будет налажен к осени 2025-го на мощностях контрактного производителя. В частности, холдинг SoftBank вёл переговоры на соответствующую тему с TSMC.

Источник изображения: Arm Как теперь стало известно, первым изделием собственной разработки Arm станет серверный CPU, а не ИИ-чип. Архитектура готовящегося решения предполагает возможность кастомизации под нужды заказчика. Этим воспользуется Meta✴, которая активно расширяет инфраструктуру ЦОД, а перспективе намерена потратить «сотни миллиардов долларов» на развитие ИИ-экосистемы. Рене Хаас (Rene Haas), генеральный директор Arm, отметил, что компания намерена официально представить процессор предстоящим летом. При этом вдаваться в подробности о технических характеристиках изделия он не стал. Выход Arm на рынок аппаратных решений будет означать серьёзное изменение бизнес-модели: ранее компания зарабатывала на лицензировании своих разработок другим участникам рынка, в том числе поставщикам решений для дата-центров и облачных платформ. Вместе с тем в ИИ-сегменте Arm увеличивает выручку путём постоянного повышения лицензионных сборов за свои технологии и благодаря взиманию роялти за каждый чип, продаваемый другими компаниями. Недавно также сообщалось, что SoftBank вскоре может заключить сделку по покупке разработчика серверных Arm-чипов Ampere за $6,5 млрд. Таким образом, японский холдинг и подконтрольная ему британская Arm готовятся составить серьёзную конкуренцию другим игрокам рынка процессоров для серверов. У AWS, Google Cloud и Microsoft Azure уже есть собственные серверные Arm-процесоры: Graviton, Axion и Cobalt 100.

13.02.2025 [01:05], Владимир Мироненко

Meta✴ намерена купить разработчика ИИ-ускорителей FuriosaAI, и не одна онаMeta✴ ведет переговоры о приобретении южнокорейского стартапа FuriosaAI, разработчика ИИ-ускорителей, базирующегося в Сеуле (Южная Корея) и Санта-Кларе (США), что позволит ей выпускать собственные кастомные чипы на фоне нехватки ускорителей NVIDIA, сообщил Forbes со ссылкой на информированные источники. По словам одного из источников, сделка может быть заключена уже в этом месяце. Другой источник утверждает, что ещё несколько компаний ведут переговоры о приобретении FuriosaAI. Компанию основал в 2017 году Джун Пайк (June Paik), ранее работавший в Samsung Electronics и AMD и занимающий сейчас пост гендиректора. FuriosaAI привлекла в общей сложности около ₩170 млн (около $115 млн) венчурного финансирования. Среди первых инвесторов были южнокорейский интернет-гигант Naver и базирующаяся в Сеуле DSC Investment. В последнем раунде финансирования, прошедшем на прошлой неделе, FuriosaAI получила ₩2 млрд (около $1,4 млн) от южнокорейской CRIT Ventures. В августе прошлого года FuriosaAI представила энергоэффективный ИИ-ускоритель RNGD, который был разработан в партнёрстве с тайваньским производителем микросхем Global Unichip Corp. По словам компании, RNGD является идеальным выбором для крупномасштабного развёртывания продвинутых моделей генеративного ИИ, таких как Llama 2 и Llama 3, поскольку не уступает передовым ускорителям по производительности, отличаясь при этом низким TDP в пределах 150 Вт. RNGD предназначен для инференса и оснащён HBM3-памятью SK hynix. FuriosaAI сообщила, что RNGD показывает в три раза большую производительность в расчёте на 1 Вт, чем ускорители NVIDIA H100 при запуске продвинутых больших языковых моделей (LLM). Как ожидается, массовое производство RNGD начнётся во II половине 2025 года. При этом сама Meta✴ разработала уже два поколения собственных ИИ-ускорителей для инференса. И если от MTIA v1 в итоге было решено отказаться в пользу в первую очередь продуктов NVIDIA, то MTIA v2, судя по всему, активно внедряются, но их всё ещё не хватает для удовлетворения потребностей компании.

Источник изображения: Meta✴ По данным Forbes, заинтересованность в RNGD также продемонстрировали исследовательская ИИ-лаборатория LG и Saudi Aramco. В сентябре последняя подписала меморандум о взаимопонимании с FuriosaAI и Cerebras Systems, ещё одним производителем ИИ-ускорителей, для «изучения сотрудничества в области суперкомпьютеров и ИИ». Переговоры проходят спустя несколько месяцев после того, как ещё один южнокорейский стартап в сфере ИИ Rebellions, завершил слияние с поддерживаемой SK hynix компанией Sapeon. Объединённая компания, которая осуществляет деятельность под брендом Rebellions, является первым в Южной Корее единорогом в области производства чипов ИИ. |

|