Материалы по тегу: сбой

|

29.05.2025 [13:18], Руслан Авдеев

Перегрев, протечки и нестабильность затормозили массовый выпуск NVIDIA GB200 NVL72, но теперь все проблемы решеныПоставщики ИИ-серверов на базе NVIDIA GB200 NVL72, включая Dell, Foxconn, Inventec и Wistron, увеличили выпуск серверов. Для этого им пришлось решить ряд технических проблем, которые ранее привели к задержкам поставок продуктов клиентам, сообщает The Financial Times. Компании совершили «серии прорывов», что позволило им начать своевременные поставки серверов GB200 NVL72. Как сообщил один из инженеров неназванного производственного партнёра NVIDIA, внутренние тесты выявили «проблемы с подключением» в серверах, но поставщики организовали совместную работу с NVIDIA, и вопрос был решён два или три месяца назад. Впрочем, это не первая проблема с чипами семейства Blackwell. В конце 2024 года стало известно о перегреве суперускорителей NVL72. По слухам, разработчику чипов пришлось просить производителей внести немало изменений в эталонный вариант стоек, чтобы решить проблему. Также поступала информация о проблемах межчипового интерконнекта, программных багах и протечках охлаждающих жидкостей. В результате поставщикам пришлось увеличить число протоколов проверки — оборудование стали тестировать намного внимательнее перед поставками клиентам. При этом производителям уже нужно готовиться к выпуску систем на базе GB300. NVIDIA GB300 NVL72 всё так же использует полностью жидкостное охлаждение. Суперускоритель оснащён 72 чипами Blackwell Ultra и 36 процессорами Grace. В продажу решение должно поступить в III квартале 2025 года.

Источник изображения: NVIDIA Впрочем, как сообщают журналисты, чтобы ускорить внедрение GB300-серверов, NVIDIA отказалась от более совершенного дизайна платы Cordelia позволявшего заменять отдельные компоненты, в пользу текущей версии Bianca, применяемой для GB200. Это решение может усложнить ремонт, но ускорит развёртывание систем. По словам трёх источников, знакомых с вопросом, NVIDIA сообщила поставщикам, что намерена перейти дизайн Cordelia в следующем поколении ИИ-продуктов.

24.05.2025 [22:04], Руслан Авдеев

Пожар в орегонском ЦОД Digital Realty привёл к масштабному сбою X (Twitter)В минувший четверг в дата-центре Digital Realty PDX11 в технопарке Хиллсборо (Hillsboro) в Орегоне произошёл пожар, который привёл к сбоям в социальной сети X (Twitter) Илона Маска (Elon Musk), которая является одним из арендаторов ЦОД. По предварительным данным, возгорание произошло в помещении, где находились аккумуляторы резервного питания, сообщает Wired. Персонал эвакуировали. На устранение инцидента у пожарных ушло несколько часов, но, к счастью, никто не пострадал. По словам местных пожарных, пожар начался в помещении, заполненном (предположительно) литий-ионными аккумуляторами. Хотя такие аккумуляторы распространены в современных ЦОД, именно они нередко и становятся причиной возгораний. Малейшая ошибка в контрле температуры, обслуживании или установке способна привести к неконтролируемому перегреву и возгораниям. Хотя пламя не распространилось за пределы аккумуляторного зала, дым был достаточно густым, чтобы вызвать обеспокоенность. Digital Realty не стала уточнять, кто именно является арендатором её ЦОД. Представители X тоже отказались от комментариев. Впрочем, как сообщает Datacenter Dynamics, с 23 мая в течение нескольких суток в работе X наблюдаются сбои разного масштаба. В официальном аккаунте компания сообщается, что она знает о проблемах и работает над их устранением.

Источник изображения: raquel raclette/unsplash.com До покупки Маском в 2022 году социальная сеть использовала в США три ЦОД: в Сакраменто, Портленде и Атланте. В случае отказа одного дата-центра трафик можно было перенаправить на другие. В конце 2022 года Маск принял неоднозначные меры по сокращению расходов и закрыл площадку в Сакраменто. В результате всего через несколько дней случился крупный сбой, доказавший, что система стала хрупкой — компания поспешила перенести нагрузки в Портленд и Атланту. В итоге дата-центр NTT GDC в Сакраменто достался Tesla. Кроме того, Маск какое-то время отказывался оплачивать услуги облаков Google и Oracle, а поставщик серверов Wiwynn подал к X иск за неоплату счетов и несоблюдение условий контракта. Пожары в дата-центрах — явление не такое уж уникальное. В сентябре 2024 года Alibaba Cloud пострадала от пожара в ЦОД в Сингапуре, от большого пожара в своём время пострадал ЦОД OVHCloud в Страсбурге. Один из крупнейших в истории индустрии инцидентов тоже оказался связан с Li-Ion аккумуляторами, безопасность которых вызывает всё больше вопросов. Основными же причинами отключений ЦОД по-прежнему являются человеческие ошибки и сбои в электроснабжении.

12.05.2025 [16:20], Руслан Авдеев

Сотрудник ЦОД пустил китаянку в серверные Deutsche Bank, но уволили в итоге… осведомителяОдин из бывших менеджеров британской компании Computacenter, управляющей компьютерными системами Deutsche Bank в Нью-Йорке, подал иск в суд на бывшего работодателя и причастных лиц. Он утверждает, что сообщил о несанкционированном доступе к серверным Deutsche Bank, но вместо благодарности его неожиданно уволили, свидетельствует The Register. Между компаниями заключён контракт на поставку IT-услуг на сумму более $50 млн. На серверах хранятся миллионы конфиденциальных записей, в том числе о транзакциях сотен тысяч клиентов. В июле 2023 года Джеймс Папа (James Papa), выступавший сервис-менеджером Computacenter, был уволен после того, как сообщил руководству о том, что его коллега неоднократно допускал свою подругу-китаянку по имени Дженни к серверным помещениям без официального разрешения. Более того, он позволял ей пользоваться ноутбуком, подключенным к сети Deutsche Bank, и своей учётной записью. Папа подал иск, в котором фигурируют Computacenter, Deutsche Bank и один из топ-менеджеров последнего. Он обвиняет стороны в незаконном увольнении. По словам истца, записи с камер видеонаблюдения свидетельствуют о том, что служба безопасности банка впускала женщину в серверную без официального разрешения в нарушение всех протоколов. Более того, визиты повторялись с марта по июнь 2023 года и продолжались даже после того, как Папа приказал сотруднику прекратить подобное. Истец уверяет, что женщина обладала «значительными компьютерными знаниями», поэтому он доложил руководству об инциденте безопасности и посоветовал сообщить о происшествии в Комиссию по ценным бумагам и биржам США (SEC).

Источник изображения: Patrick Amoy/unsplash.com Вместо этого, как утверждает истец, его вызвали на встречу с юристами Computacenter и Deutsche Bank, а также представителями службы безопасности финансовой организации, где провели довольно агрессивный допрос, причём давление только усиливалось, когда он указывал на очевидные недостатки системы безопасности. После одной из таких встреч менеджера отстранили от работы, а вскоре уволили. Папа предполагает, что причина именно в том, что он привлёк внимание к недостаткам в системе безопасности. Также истец утверждает, что SEC так и не уведомили об инцидентах, что является обязательным в таких случаях. По словам юриста истца, его просто сделали «козлом отпущения», переложив вину за нарушения сотрудника. Уже после увольнения истец выяснил, что обе компании отслеживали деятельность женщины по камерам, в том числе то, как она касается серверов банка, но так и не установили ни её личности, ни чем она занималась. В результате инцидента уволили только его. В иске Папа утверждается, что обе компании и вице-президент Deutsche Bank нарушили законы Нью-Йорка о защите информаторов и проявили халатность. Теперь Папа требует $20 млн компенсации «эмоционального, физического и денежного ущерба».

12.05.2025 [08:48], Владимир Мироненко

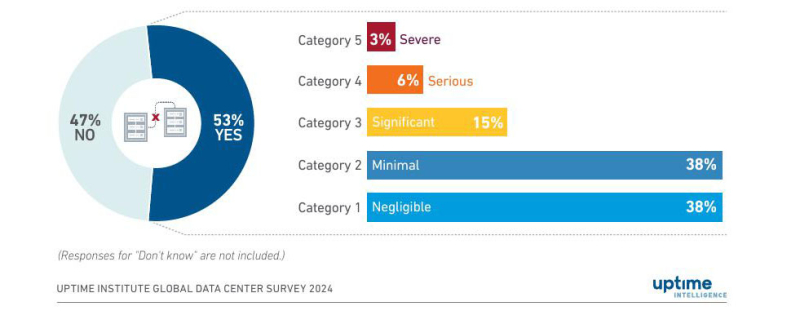

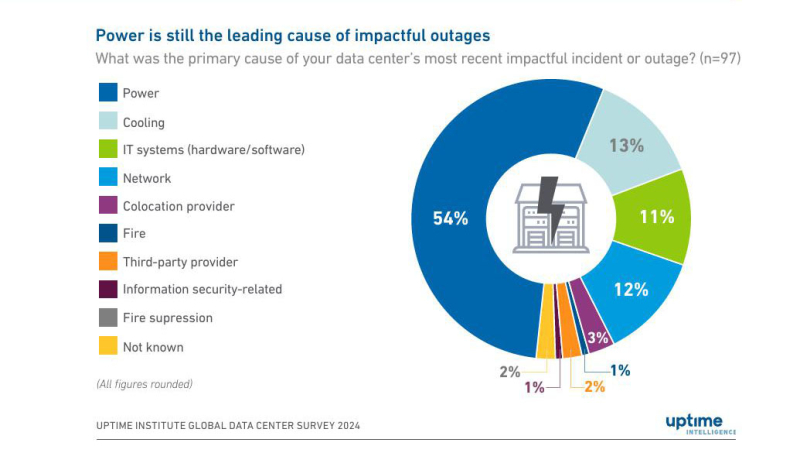

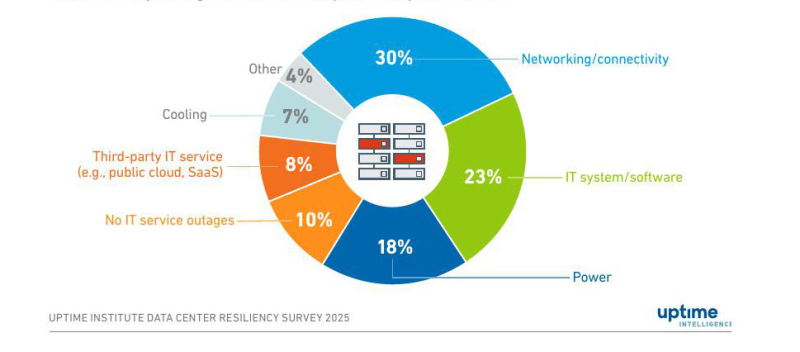

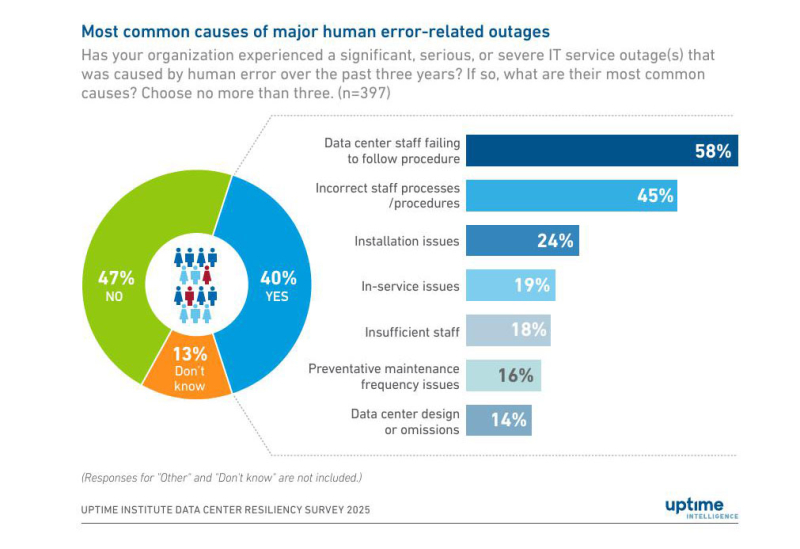

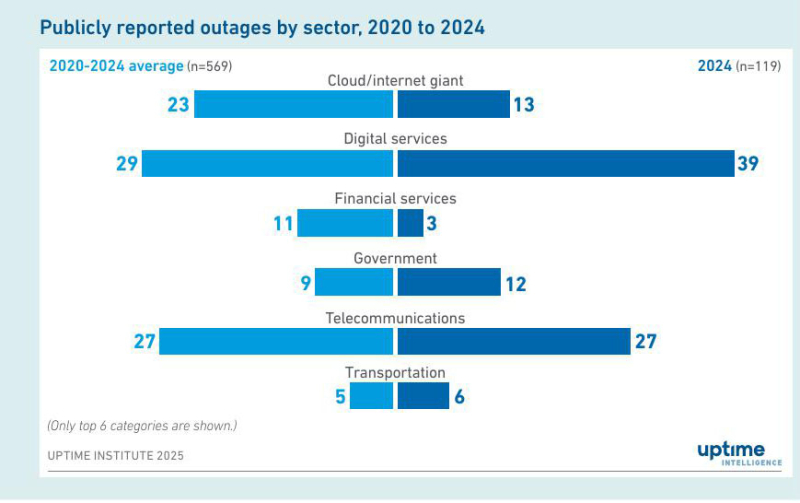

Uptime Institute: человеческие ошибки и сбои в электроснабжении — причина большинства отключений ЦОДПредотвращение перебоев в работе остаётся стратегическим приоритетом для владельцев и операторов ЦОД. Хотя инфраструктурное оборудование улучшилось, сложность современных архитектур и развивающиеся внешние угрозы представляют новые риски, которыми операторы должны активно управлять, отмечено в исследовании Annual outage analysis 2025 организации Uptime Institute, в котором использовались данные опросов участников отрасли ЦОД в 2024–2025 гг. Согласно исследованию, четвёртый год подряд увеличивается время безотказной работы объектов — общая частота сбоев в работе и общий уровень заявленной серьёзности инцидентов продолжают снижаться. Однако количество кибератак растёт, что часто приводит к серьёзным и долговременным последствиям. По данным исследования Uptime Institute Global Data Center Survey 2024, около 53 % операторов ЦОД сообщили о случаях аварийного отключения за последние три года, что продолжает тенденцию снижения показателя по сравнению с предыдущими годами — 60 % сообщений о сбоях в 2022 году, 69 % в 2021 году и 78 % в 2020 году. Но в 2024 году падение замедлилось, сократившись по сравнению с 55 % в 2023 году на 2 п.п. Как сообщается, замедление темпов улучшения не означает самоуспокоенность компаний. В данном случае операторы сталкиваются с растущими внешними рисками, которые в значительной степени находятся вне их контроля, включая ограничения в работе энергосистем, экстремальные погодные условия, сбои в работе сетевых провайдеров и проблемы с ПО сторонних производителей. Также исследователи отметили признаки снижения интенсивности перебоев в работе. Только 9 % зарегистрированных инцидентов в 2024 году были классифицированы как серьёзные — самый низкий уровень с точки зрения времени безотказной работы на сегодняшний день. По мнению аналитиков, это свидетельствуют о том, что текущие инвестиции отрасли в обеспечение безопасности — за счёт резервирования, совершенствования процессов и соблюдения производственной дисциплины — дают ощутимый эффект. В 2024 году выросло количество отключений из-за проблем с ИТ и сетями, составив в общей сложности 23 % от общего числа серьёзных перебоев. Этот рост, вероятно, вызван усложнением IT-инфраструктур и сетей, что приводит к проблемам с управлением изменениями и неправильной конфигурацией. За девять лет мониторинга Uptime общедоступных сообщений о сбоях на долю сторонних поставщиков ИТ-услуг и услуг ЦОД, в том числе облачных и интернет-гигантов, телекоммуникационных компаний и колокейшн–компаний, пришлось около двух третей зарегистрированных сбоев. В 2025 году доля отключений, связанных с человеческими ошибками и вызванных несоблюдением процедур, выросла на 10 п.п. по сравнению с 2024 годом. Как полагают исследователи, это может быть следствием быстрого роста отрасли ЦОД, и вызванной этим нехваткой персонала во многих регионах. В связи с этим больше внимания уделяется обучению персонала и оперативной поддержке в режиме реального времени, что может снизить риски более эффективно, чем улучшение документации и процессов, хотя они тоже важны. Это подтверждают результаты опроса, согласно которому четыре из пяти (80 %) операторов считают, что улучшение управления и процессов позволило бы предотвратить последний инцидент с простоем в их организации. Согласно исследованию, за последние три года около 40 % организаций столкнулись с серьезными перебоями в работе, вызванными человеческими ошибками. В 58 % случаев это было вызвано несоблюдением сотрудниками процедур, а 45 % случаев были связаны с некорректными процессами или процедурами, регламентирующими работу персонала. При этом Uptime утверждает, что рассматривает человеческие ошибки как способствующий фактор, а не как первопричину отключений, хотя они напрямую или косвенно играют роль в большинстве инцидентов. Основной причиной серьёзный аварийных отключений ЦОД остаются проблемы, связанные с питанием. На них приходится более половины всех инцидентов. Более одного из четырёх респондентов сообщили, что в течение последних трёх лет серьезный сбой в работе IT был вызван неполадками в питании объекта. Наиболее часто это связано с отказом ИБП, что недавно привело к шестичасовому отключению Google Cloud. Другие элементы в цепочке питания также могут вызывать такие проблемы, как периодические сбои в подаче энергии и неправильное управление или неправильно настроенное переключение на генераторы, отметили исследователи. Также была указана как растущая проблема нестабильность сети. Растущий спрос, устаревшая инфраструктура, экстремальные погодные условия и изменчивость возобновляемых источников энергии могут увеличить частоту сбоев питания, что подчёркивает необходимость надёжных локальных систем. Как отметил The Register, ЦОД, расположенные вблизи лондонского аэропорта Хитроу, продолжили работу, несмотря на отключение электроэнергии, которое вынудило приостановить приём и отправку большого количества рейсов в марте. Дата-центры Испании и Португалии тоже успешно пережили крупнейший блэкаут в истории стран.

06.05.2025 [17:14], Руслан Авдеев

Китайскому «супероружию» против подводных кабелей на поверку оказалось не меньше сотни летУ страха глаза велики — в 2025 году некоторые СМИ заговорили о грозной китайской технологии для проведения подводных диверсий. Виной всему стал поданный в 2020 году Лишуйским университетом (Lishui University) патент, в котором описано устройство для механического повреждения подводной инфраструктуры. Правда, при ближайшем рассмотрении оказалось, что в изобретении нет ничего революционного и «оружие Судного дня» давно применяется даже в мирных целях, сообщает Telegeography. Фактически речь идёт о крюке-кошке (grapnel), которая представляет собой якорь с лезвиями, который тянут по дну. Оператор следит за натяжением троса, а в случае его ослабления инструмент поднимают и исследуют на предмет наличия следов меди на лезвиях. Хотя китайский патент относительно свежий, в кабельной индустрии о технологии знают более века. Более того, в первую очередь это созидательный, а не разрушительный инструмент. Такими крюками поднимают со дна повреждённые кабели для их последующей починки. Аналогичный патент был зарегистрирован ещё в 1962 году, но фактически такие устройства используются для работы с кабелями с середины XIX века. А сами они были изобретены ещё в Древнем Риме, правда, для абордажа. Более свежая китайская разработка показалась более пугающей — она представляет собой систему с режущим диском, способным разрушать защиту кабелей. Впрочем, сенсации и тут не случилось. Если крюки могут работать на глубине до 9 тыс. м, то новинка — всего до 4 тыс. м. При этом кабели на больших глубинах обычно не имеют серьёзной брони. Стоит отметить, что никаких специальных устройств для повреждения кабелей, по сути, не надо. Ежегодно якорями, рыболовными сетями и подводными оползнями кабели повреждаются более 200 раз.

05.05.2025 [23:50], Руслан Авдеев

ЦОД Испании и Португалии успешно пережили крупнейший блэкаут в истории стран, а вот телеком-инфраструктура испытала серьёзные проблемыНа минувшей неделе Испания и Португалия пережили крупнейшее отключение электричества в истории. Испанский оператор национальной энергосети Red Electrica исключил кибератаку — потеря электроснабжения связывается с инцидентами, касающимися работы солнечных электростанций на юго-западе Испании, вызвавшими нестабильность энергосистемы. В итоге сбои привели к проблемам не только в Испании, но и во Франции и Португалии, сообщает Datacenter Dynamics. При этом индустрия ЦОД с блэкаутом справилась на удивление неплохо. В Испании действуют 156 дата-центров, ещё 41 — в Португалии. В регионе работают как местные игроки, так и гиперскейлеры вроде AWS, Meta✴ и Microsoft. Большинство операторов справилось с проблемой. Например, Equinix сообщила, что ЦОД компании в Испании и Португалии полностью сохранили работоспособность на время блэкаута, резервные системы сработали, как и ожидалось. В Iron Mountain тоже сообщили, что дата-центры сработали без сбоев, а новичок Start Campus объявил, что стабильность сохранялась в течение всего периода. Посадочная станция Barcelona Cable Landing Station тоже сообщила, что работа кабеля не пострадала, как и задачи клиентов, Nabiax объявила, что в её ЦОД в Испании проблем не наблюдалось, а NTT поведала, что объект MAD1 в Мадриде смог перейти на ИБП, а потом на резервное питание. Data4, которая тоже работает в Мадриде, тоже объявила, что на клиентах сбой не сказался. В компании подчеркнули важность создания надёжной цифровой инфраструктуры. В ЦОД Nixval в Валенсии сообщили, что операции не пострадали, при этом у некоторых клиентов не работал телефон, поэтому они вынуждены были явиться в ЦОД лично, чтобы проверить состояние дел. В Global Switch подчеркнули, что гордятся тем, как сработала инфраструктура компании, в Edged тоже заявили, что инфраструктура не пострадала. Провайдер ЦОД Walhalla, правда, отметил, что координация между властями и поставщиками энергии была «нулевой». При этом в телеком-сфере проблемы были гораздо серьёзнее, пострадали интернет-сервисы в Испании, Португалии и за пределами стран. Например, по данным Cloudflare, трафик в Португалии сократился более чем на 50 %, а позже — и на 90 %. Нечто подобное наблюдалось и в Испании (60 % в сравнении с неделей ранее сразу и на 80 % в ближайшие пять часов соответственно). Беспроводным операторам пришлось включить резервные генераторы — там, где они были. В некоторой степени пострадал даже Starlink. Хотя связь не прерывалась, трафик направлялся обходными маршрутами из-за отключения некоторых наземных станций.

28.04.2025 [16:55], Руслан Авдеев

РБК: «Россети» всё чаще срезают чужие интернет-кабели со своих столбовРоссийский электросетевой холдинг «Россети», по словам ряда провайдеров, всё чаще срезает интернет-кабели, подвешенные на опорах линий электропередач — обычно речь идёт о линиях, проложенных от узла связи к абонентам в частном секторе, сообщает РБК. В ассоциации «Ростелесеть», объединяющей 170 региональных операторов связи, пояснили, что ранее «Россетям» операторы платили за использование опор, к которым крепились как магистральный кабель, так и абонентские линии (8–10 шт.), но теперь плату требуют за каждый отдельный кабель. При этом линии, идущие непосредственно к пользователям, формально принадлежат именно абонентам. «Россети» требуют 81 руб. за опору, а таких опор до абонента может быть несколько. Операторы вынуждены или повышать тарифы, или вовсе отказываться от таких линий. В Ассоциации малых операторов связи регионов (АМОР) подтвердили, что до середины 2023 года плату брали за использование опоры без ограничений, а теперь ту же цену требуют за каждый размещённый на опоре кабель, хотя расходы на содержание самих опор никак не изменились.

Источник изображения: American Public Power Association/unsplash.com По имеющимся данным, в домах с малоэтажной застройкой в России проживает около 20 % от всех интернет-пользователей, причём эта доля продолжает расти и скоро может приблизиться к 25 %. Этих абонентов в основном обслуживают «Ростелеком», «ЭР-Телеком» и региональные операторы. Операторы и «Россети» подают друг к другу встречные иски. Провайдеры обвиняют холдинг в монопольном повышении цен и требуют запретить демонтаж кабелей. «Россети» же говорят, что операторы незаконно обогащаются, используя её инфраструктуру, и пытаются переложить затраты на абонентов. Как пояснил РБК представитель «Россетей», «только порядка 4 % от выявленного нелегального подвеса приходится на отдельных небольших операторов связи, которые отказываются от заключения договоров на размещение ВОЛС». При невозможности или нежелании узаконить подобные линии связи, они демонтируются, т.е. срезаются.

24.04.2025 [21:08], Руслан Авдеев

Швеция не нашла следов намеренного повреждения кабелей на Балтике, но Китай всё равно мешает расследованиюШведские власти объявили, что предварительное расследование повреждений кабелей в Балтийском море не выявило признаков диверсии. Ранее сообщалось, что обрыв кабелей C-Lion1 (Финляндия–Германия) и BCS East-West (Литва–Швеция) в ноябре 2024 года, возможно, являлся актом саботажа со стороны экипажа китайского судна Yi Peng 3, напоминает Datacenter Dynamics. По словам следователей, на текущий момент факт намеренного повреждения достоверно не установлен, но следствие всё ещё продолжается. Вместе с тем расследованию серьёзно мешает Китай. Китайские власти позволили следственной группе из представителей близлежащих стран подняться на борт судна, но «препятствовали нормальным следственным процедурам». Шведская сторона говорит, что многое указывает на несчастный случай, но если злоумышленник что-то делает намеренно, он будет принимать меры для того, чтобы избежать обнаружения настолько, насколько это возможно. Ранее было установлено, что судно Yi Peng 3 проходило над кабелями приблизительно в то время, когда они были повреждены. В последнее время в Балтийском море пострадали другие кабели. В частности, в конце 2024 года был повреждён подводный кабель Estlink 2 между Финляндией и Эстонией и трёх интернет-кабелей между этими же странами, а также кабель между Финляндией и Германией. Финские власти даже задержали корабль Eagle S, попавший под подозрение, но в итоге следов диверсии выявлено не было. В январе подводный кабель, связывавший Латвию и шведский остров Готланд (Gotland) стал последней «жертвой» в серии инцидентов в Балтийском море. Латвийские власти заявили, что кабель был повреждён в результате воздействия «внешних факторов». После того, как шведские власти взяли под контроль грузовое судно, ответственное за происшествие, расследование показало, что виноваты, вероятно, погодные условия и вряд ли это было актом саботажа. А в феврале пострадал уже кабель «Ростелекома» между Санкт-Петербургом и Калининградом. Страны НАТО организуют в регионе активную защиту инфраструктуры в Балтийском море в рамках инициативы Baltic Sentry и других проектов. В декабре 2024 года появилась информация о тестировании плавучих беспилотников, Швеция выделила три корабля и самолёт для патрулирования, а Германия объявила о запуске подводного патрульного беспилотника.

21.04.2025 [20:43], Татьяна Золотова

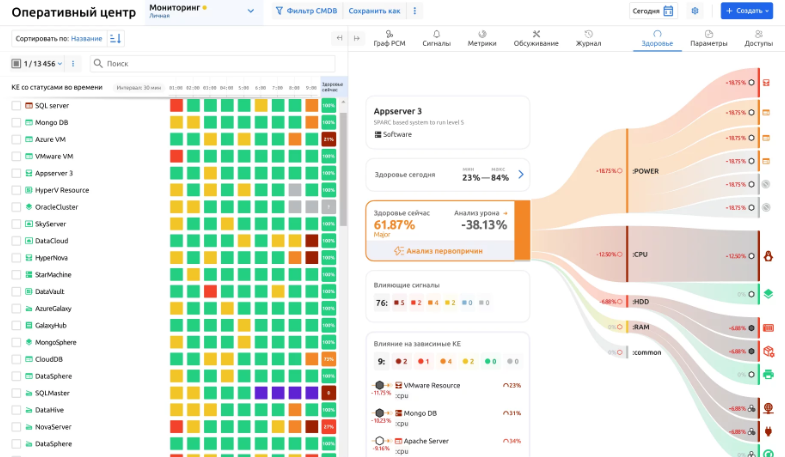

В I квартале 2025 года количество масштабных IT-инцидентов в России выросло на четвертьПо данным разработчика платформы корпоративного ИТ-мониторинга и автоматизации «Монк Диджитал Лаб», в I квартале 2025 года произошел резкий всплеск ИТ-сбоев в ключевых отраслях российской экономики. Количество масштабных инцидентов в российских компаниях выросло на 25 % по сравнению с IV кварталом 2024 года. Об этом сообщила пресс-служба компании. Одной из главных причин такого всплеска специалисты называют участившиеся технические проблемы в инфраструктуре организаций, а также с ростом количества кибератак. Наибольшее количество инцидентов пришлось на финансовый сектор (25 % от общего числа сбоев против 18 % кварталом ранее), телеком (20 %) и ритейл (15 %). Более 50 % инцидентов затронули критичные бизнес-процессы компаний, включая платежные системы, обработку заказов, логистику и доступ к внутренним корпоративным системам. Средняя продолжительность серьезных сбоев составила от 30 минут до 4 часов, но были и инциденты длительностью до 72 часов. Если в 2024 году преобладали точечные технические сбои, то в I квартале 2025 года это уже были многофакторные, цепные инциденты, затрагивающие сразу несколько отраслей. «Первый квартал 2025 года подтвердил, что стабильность ИТ-инфраструктуры — не просто вопрос надежности, а фактор операционной устойчивости и конкурентоспособности бизнеса. Компании, которые выстроили системы мониторинга, реагирования и отказоустойчивости, проходят через кризис с минимальными потерями», — отметил управляющий партнер «Монк Диджитал Лаб».

16.04.2025 [08:46], Руслан Авдеев

Рынок подводных кабелей расширяется и меняется благодаря ИИ, гиперскейлерам и геополитикеГиперскейлеры наращивают инвестиции в подводную кабельную инфраструктуру на фоне глобальной нестабильности и росте потребностей в запасных маршрутах. По прогнозам экспертов, инвестиции останутся на высоком уровне как минимум до 2029 года — на фоне роста спроса на цифровые сервисы и обеспокоенности надёжностью инфраструктуры, сообщает Datacenter Knowledge. По информации издания, в отчёте Analysys Mason за 2024 год указывается, что расходы на новые кабельные системы и эксплуатацию существующих маршрутов вырастут с $7,96 млрд в 2023 году до $9,80 млрд к 2029 году. Пока IT-гиганты вроде AWS, Meta✴ и Google активно вкладывают средства в трансконтинентальные ВОЛС. Инвестиции наращивают и государства, желающие создать резервные линии связи. Кроме того, регуляторы ведут работы над сокращением времени выдачи разрешений для работ над кабельной инфраструктурой. Актуальность проблемы подтверждается многочисленными недавними инцидентами с подводными кабелями в Балтийском и Красном морях, а также у побережья Тайваня — хотя достоверных свидетельств диверсий нет, не подлежит сомнению, что глобальная цифровая инфраструктура оказалась очень уязвимой. На сегодня 95 % межконтинентального трафика (в т.ч. финансовых транзакций на $10 трлн/день), передаётся через подводные кабели. Ёмкость сетей активно расширяется, а участники рынка пытаются усилить их надёжность и минимизировать риски.

Источник изображения: Sheila C/unsplash.com Развитие ИИ и рост спроса со стороны гиперскейлеров и облачных провайдеров способствует увеличению инвестиций в рынок. Ожидается, что к гонке инвестиций присоединятся и развивающиеся сегменты. Энергоёмкое обучение ИИ-моделей стимулирует создание новых рынков на Ближнем Востоке и в Азии в целом. По мнению экспертов, уже сейчас ощущается необходимость появления новых маршрутов, снижении задержек и подключения новых ИИ ЦОД. При этом участие гиперскейлеров трансформирует отрасль. Они совместно инвестируют в каналы связи для поддержки своих облаков, ИИ-приложений и доставки контента. В то же время кабели становятся всё более уязвимыми. В условиях глобальной политической неопределённости подводная и околоземная цифровая инфраструктура может стать целью атак заинтересованных сторон, превращаясь в «геополитическую цель». Помимо самих кабелей, уязвимо и сетевое оборудование, в том числе посадочные станции и др., в т.с. для кибератак. С развитием квантовых вычислений ситуация может усугубиться. По мнению некоторых экспертов с появлением достаточно мощных квантовых вычислений угроза вырастет в разы. Хотя уже ведётся работа над «квантовыми» технологиями защиты, пока их эффективность ограничена. Для противодействия угрозам приходится создавать «избыточные» маршруты, не имеющие единых точек, вывод которых из строя парализует всю инфраструктуру. Например, ключевая стратегия Airtel — создание минимум трёх кабелей на каждое основное направление и гибридных сетей с использованием подводных и наземных кабелей, а также облачной инфраструктуры. Но эксперты подчёркивают, что в мире есть всего лишь 22 судна для ремонта и прокладки подводных кабелей, причём «лишь два из них под флагом США» — они всегда в дефиците.

Источник изображения: Jacob Waldrop/unsplash.com Инновации помогают повысить надёжность инфраструктуры. Например, ИИ-инструменты и распределённое акустическое зондирование позволят выявлять потенциальные повреждения в реальном времени, имеются технологии предупреждения о цунами, а пространственное мультиплексирование и уплотнение повышают эффективность и снижают стоимость связи. Всё популярнее интеграция энергетической и телеком-инфраструктуры — комбинированные кабели, передающих и данные, и электроэнергию. Например, между островом Мэн и Великобританией можно реализовать именно такие системы. Но несмотря на активные инвестиции, не все части мира охвачены стабильной широкополосной связью. Развивающимся рынкам часто не хватает подводной инфраструктуры для удовлетворения растущих цифровых потребностей. Необходимо расширить доступ в стратегически важных зонах вроде Малаккского пролива или Красного моря. |

|