Материалы по тегу: ai

|

01.10.2023 [20:55], Руслан Авдеев

Microsoft ищет более дешёвые в эксплуатации и простые альтернативы языковым моделям OpenAIХотя Microsoft принадлежит 49 % OpenAI, занимающейся разработкой популярных и производительных языковых моделей вроде GPT-4, интересы компаний не всегда совпадают. Как сообщает Silicon Angle, Bing Chat Enterprise первой и ChatGPT Enterprise второй, по сути, конкурируют за одну и ту же целевую аудиторию. Кроме того, Microsoft, стремящаяся внедрить ИИ почти во все свои программные продукты, готовит новые, более простые и менее ресурсоёмкие модели, чем GPT-4. По данным источников в OpenAI, в Microsoft обеспокоены высокой стоимостью эксплуатации передовых ИИ-моделей. Microsoft пытается встроить ИИ во многие продукты, включая Copilot для Windows на базе GPT-4. С учётом того, что пользователей Windows в мире больше 1 млрд, в компании опасаются, что повсеместное распространение ИИ-инструментов приведёт к неконтролируемому росту расходов. По некоторым данным, компания уже поручила части из своих 1,5 тыс. сотрудников ИИ-департамента заняться более экономичными альтернативами — пусть даже они будут не столь «сообразительными». Хотя реализация соответствующих проектов всё ещё находится на ранних стадиях, уже появилась информация, что компания начала внутренние тесты моделей собственной разработки. В частности, «творческий» и «точный» режимы Bing Chat опираются на GPT-4, тогда как «сбалансированный» использует новые модели Prometheus и Turing. Последняя может отвечать только на простые вопросы, а более каверзные она всё равно вынуждена передавать на обработку творению OpenAI. Для программистов у Microsoft есть модель Phi-1 с 1,3 млрд параметров, которая может эффективно генерировать код, но в остальном отстаёт от GPT-4. Ещё одной альтернативой стала разработанная Microsoft модель Orca на основе Meta✴ Llama-2, принадлежащей Meta✴. По некоторым данным, Orca близка по возможностям к моделям OpenAI, но компактнее и требует значительно меньше ресурсов. Считается, что подразделение Microsoft использует около 2 тыс. ускорителей NVIDIA, большинство из которых сегодня и применяется для тренировки более эффективных моделей, имеющих узкую специализацию в отличие от многопрофильной GPT-4. Если раньше состязание на рынке шло за создание ИИ с наибольшими возможностями, то теперь одним из важнейших факторов становится стоимость разработки и обслуживания таких инструментов.

29.09.2023 [13:10], Сергей Карасёв

Akamai откроет семь новых облачных регионов до конца октябряCDN-провайдер Akamai Technologies, по сообщению ресурса Datacenter Dynamics, объявил о планах по открытию семи дополнительных облачных регионов — в Нидерландах, Индонезии, США, Италии, Японии и Бразилии. Предоставление услуг планируется организовать до конца октября. Минувшим летом компания Akamai запустила облачные ЦОД Connected Cloud в Париже, Вашингтоне (округ Колумбия) и Чикаго. Тогда же были раскрыты планы по созданию объектов в Сиэтле и Ченнаи (Индия). Готовящиеся регионы расположатся в Амстердаме, Джакарте, Лос-Анджелесе (Калифорния), Майами (Флорида), Милане, Осаке и Сан-Паулу. Это третий этап развертывания ключевых облачных зон с момента приобретения компанией Akamai провайдера Linode в прошлом году.

Источник изображения: Akamai Всего за три месяца Akamai открыла 13 новых облачных регионов. Сейчас у компании есть зоны в Атланте, Далласе, Фремонте, Ньюарке, Торонто, Франкфурте, Лондоне, Мумбаи, Сингапуре, Сиднее и Токио, а также перечисленные выше объекты. В дальнейшие планы входит развёртывание зон в Сеуле (Южная Корея), Мадриде (Испания) и Окленде (Новая Зеландия). Компания также намерена создать десятки та называемых «распределённых регионов». Они предназначены для предоставления «базовых вычислительных ресурсов в труднодоступных местах, которые недостаточно обслуживаются традиционными облачными провайдерами».

22.09.2023 [10:59], Сергей Карасёв

Intel создаст мощнейший ИИ-суперкомпьютер с тысячами ускорителей Habana Gaudi2Корпорация Intel, по сообщению сайта Datacenter Dynamics, намерена создать один из самых мощных в мире суперкомпьютеров для работы с генеративным ИИ. Ресурсы платформы будет использовать компания Stability AI, реализующая проекты в соответствующей сфере. В основу НРС-платформы лягут процессоры Xeon. Кроме того, говорится об использовании приблизительно 4000 ускорителей Gaudi2. Проект Intel и Stability AI поможет компаниям укрепить позиции на рынке генеративного ИИ. О сроках запуска системы в эксплуатацию и её предполагаемой производительности ничего не сообщается. Ранее Intel обнародовала результаты тестирования Gaudi2 в бенчмарке GPT-J (входит в MLPerf Inference v3.1), основанном на большой языковой модели (LLM) с 6 млрд параметров. По оценкам, Gaudi2 может стать альтернативой решению NVIDIA H100 на ИИ-рынке.

Источник изображения: pixabay.com Тем не менее, H100 по-прежнему превосходит конкурентов в плане обработки ИИ-задач. Ранее NVIDIA анонсировала программное обеспечение TensorRT-LLM с открытым исходным кодом, специально разработанное для ускорения исполнения больших языковых моделей (LLM). По оценкам NVIDIA, применение TensorRT-LLM позволяет вдвое увеличить производительность ускорителя H100 в тесте GPT-J 6B. При использовании модели Llama2 прирост быстродействия по сравнению с А100 достигает 4,6x.

11.09.2023 [19:35], Руслан Авдеев

GPT-3 «выпила» более 320 тыс. литров: ЦОД тратят огромное количество воды для охлаждения ИИ-серверовМногие знают, что ИИ-модели в процессе работы потребляют огромное количество энергии, но не всем известно, что им нужно ещё и очень много чистой воды. Как сообщает Silicon Angle, выяснилось, что ЦОД стоящих за работой ИИ-систем компаний тратят очень много воды, а у техногигантов вроде Google и Microsoft водопотребление только растёт. Как следует из доклада Associated Press, использование ЦОД Microsoft воды выросло с 2021 по 2022 гг. на 34 %, в прошлом году компания потратила 6,4 млрд литров. В тот же период водопотребление Google выросло на 20 %. По данным экспертов, занимавшихся исследованием воздействия генеративных ИИ-систем на окружающую среду, в большей части рост потребления вызван увеличением связанных с ИИ нагрузок. По некоторым оценкам, модель GPT-3 компании OpenAI, стоящая за чат-ботом ChatGPT, ответственна за трату более 320 тыс. л во время тренировки, а ChatGPT и вовсе «выпивает» 0,5 л воды каждую чат-сессию, состоящую из 25-50 запросов. Учитывается и непрямое использование воды, включающее затраты электростанций, питающих ЦОД.

Источник изображения: MartinStr/pixabay.com Для Google статистика оказалась крайне неоднородной и разнится от ЦОД к ЦОД — многое зависит от местоположения, сезона, технологии охлаждения и уровня потребления воды электростанциями. Впрочем, многие специалисты отрасли уверены, что рост потребления воды имеет важное значение, но большие опасения вызывает рост энергопотребления. Дело в том, что значительная часть используемой воды перерабатывается и применяется снова, тогда как об энергии нельзя сказать того же. Кроме того, Microsoft, Google и другие операторы ЦОД сами заинтересованы в сокращении потребления воды, поэтому будут принимать все необходимые меры для этого. Ранее Microsoft сообщала, что намерена стать «водно-положительной», «углеродно-отрицательной» и безотходной уже к 2030 году, а к 2024 году снизить потребление ЦОД воды на 95 % (в сравнении с 2021 годом). Впрочем, до сих пор нет точных определений некоторым терминам, например, никто детально не говорил, о какой «водно-положительности» идёт речь. Можно только предполагать, что компания намерена отдавать в природу больше воды, чем потребляет. Примером может служить Pepsi, которая, пропустив воду сквозь снековое оборудование в районе Мехико, очищает её до уровня питьевой и отправляет на другой завод — для мытья картофеля для чипсов. Таким образом, воды действительно поступает «в оборот» больше, чем изначально забирается из природных источников. В OpenAI, крупнейшим инвестором которой является Microsoft, подчеркнули, что осознают высокие уровни потребления ИИ энергии и воды и активно работают над повышением эффективности в этой сфере. Решением может стать создание для ИИ более эффективных алгоритмов и оборудования, хотя на это уйдёт некоторое время.

08.09.2023 [17:48], Владимир Мироненко

C3 AI выпустила пакет C3 Generative AI Suite с предметно-ориентированными ИИ-инструментами, которые не галлюцинируют и дают корректные ответыC3 AI, разработчик решений для корпоративного ИИ, объявил о выходе пакета C3 Generative AI Suite, включающего 28 новых предложений в области генеративного ИИ, ориентированных на конкретные потребности различных отраслей, бизнес-процессов и корпоративных систем. Согласно заявлению C3 AI, вышедшие в марте 2023 года первоначальные модели C3 Generative AI уже используются целым рядом крупных компаний и организаций, включая Агентство по противоракетной обороне США. C3 Generative AI Suite построен на платформе C3 AI, обеспечивающей единое рабочее пространство для разработки, тестирования и развёртывания моделей ИИ. Компания отметила, что в C3 Generative AI решены проблемы безопасности и достоверности, характерные для больших языковых моделей (LLM), из-за которых не допускается их широкое коммерческое использование на предприятиях. Предложения C3 Generative AI Suite могут быть развернуты на любой облачной платформе и поддерживают широкий спектр ИИ-моделей, включая Falcon 40B, Llama 2, Flan-T5, Azure GPT-3.5, AWS Bedrock Claude 2, Google PaLM 2, OpenAI GPT-3.5 и MPT-7B. Платформа работает со структурированными и неструктурированными данными, а также может проводить оркестрацию инференса и глубокого обучения.

Источник изображения: C3 AI По словам технического директора по продуктам компании, в дополнение к более широким отраслевым и предназначенным для отдельных случаев моделям, C3 AI также предлагает тонко настроенные LLM для конкретных задач, таких как ответы на вопросы, чат, обобщение, поиск и оркестрация. C3 AI рекомендует использовать генеративный ИИ с расширенным поиском (retrieval-augmented generative AI). Фреймворк подходит для извлечения фактов из внешней базы знаний, гарантирующий доступ модели к самой свежей информации. «Такой подход помогает нам отделить LLM от личных данных клиента и избежать многих недостатков использования ориентированного на потребителя генеративного ИИ в корпоративном контексте, таких как отсутствие прослеживаемости и галлюцинации», — сказал Кришнан. «Это позволяет генеративному ИИ C3 минимизировать галлюцинации и предоставлять полные ссылки на источники, чтобы пользователи могли проверять ответы и проводить дальнейшие исследования», — отметил он. C3 AI заявила, что её решения дают детерминированные ответы, а не случайные, и что результаты можно сразу проследить до источника. LLM закрыта брандмауэром от исходных данных, чтобы минимизировать риск утечки данных и кибератак. Компании также могут применять средства обеспечения кибербезопасности, такие как шифрование и многофакторная аутентификация, указывать в настройках, что модели работают только с принадлежащими предприятию и лицензированными данными, и обмениваться LLM с другими компаниями. Все продукты из набора C3 Generative AI Suite уже доступны для установки заказчиком. C3 AI поможет заказчику внедрить своё приложение в производство в течение 12 недель, стоимость услуги — $250 тыс. После этого клиент производит почасовую оплату за использование vCPU/vGPU со скидками за объём.

24.08.2022 [22:42], Владимир Мироненко

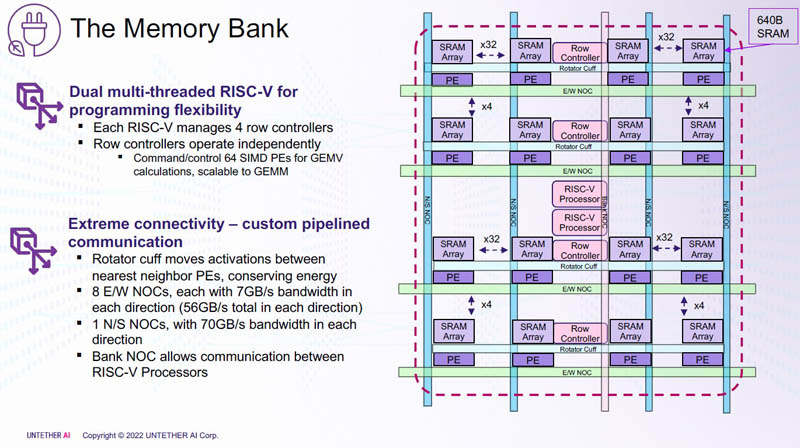

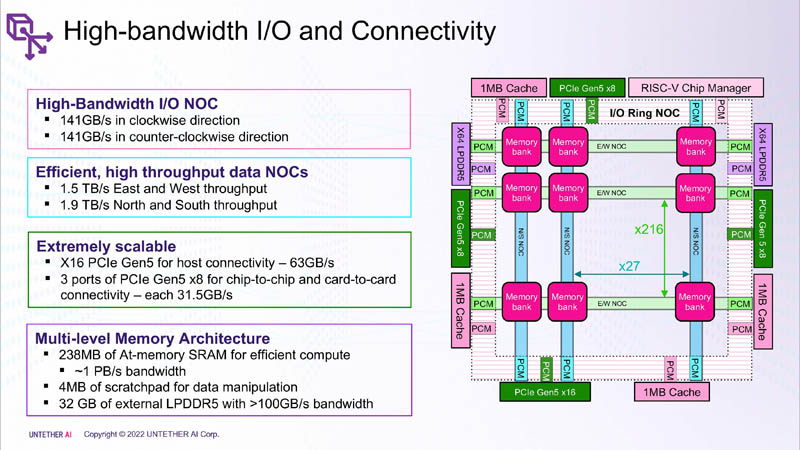

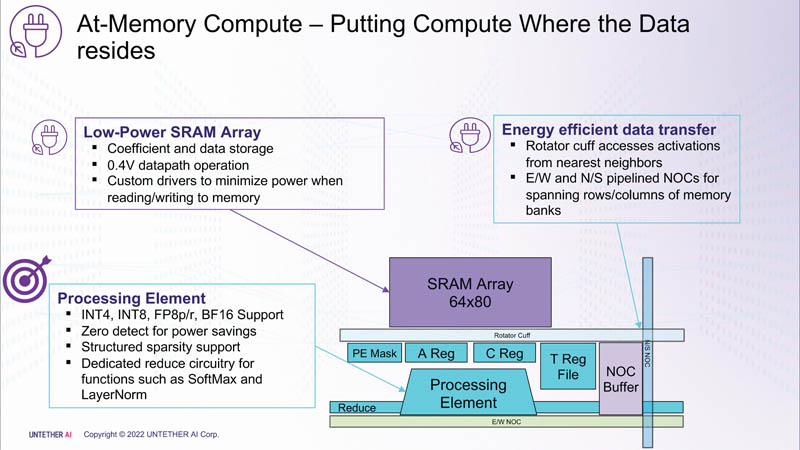

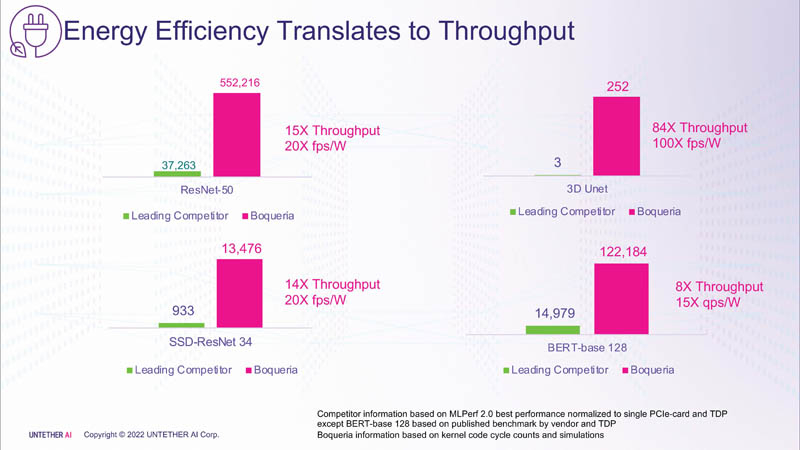

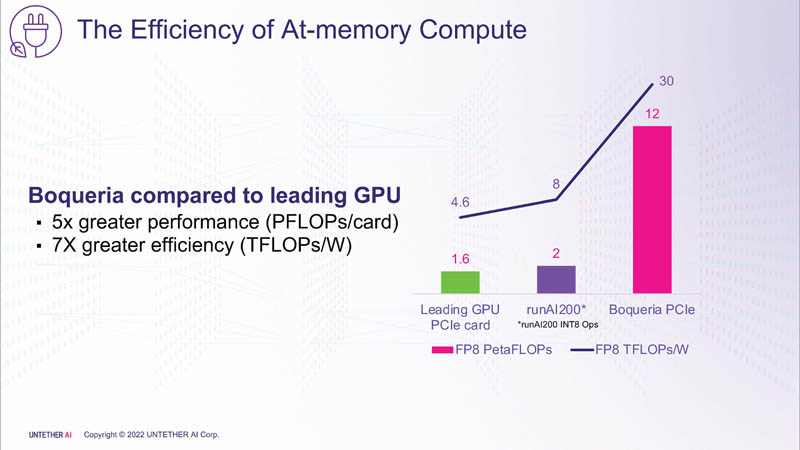

Untether AI представила ИИ-ускоритель speedAI240 — 1,5 тыс. ядер RISC-V и 238 Мбайт SRAM со скоростью 1 Пбайт/сКомпания Untether AI анонсировала ИИ-архитектуру следующего поколения speedAI (кодовое название «Boqueria»), ориентированную на инференс-нагрузки. При энергоэффективности 30 Тфлопс/Вт и производительности до 2 Пфлопс на чип speedAI устанавливает новый стандарт энергоэффективности и плотности вычислений, говорит компания. Поскольку at-memory вычисления в ряде задач значительно энергоэффективнее традиционных архитектур, они могут обеспечить более высокую производительность при одинаковых затратах энергии. Первое поколение устройств runAI в 2020 году Untether AI достигла энергоэффективности на уровне 8 Тфлопс/Вт для INT8-вычислений. Новая архитектура speedAI обеспечивает уже 30 Тфлопс/Вт. .jpg)

Изображения: Untether AI (via ServeTheHome)  Этого удалось добиться благодаря архитектуре второго поколения, использованию более 1400 оптимизированных 7-нм ядер RISC-V (1,35 ГГц) с кастомными инструкциями, энергоэффективному управлению потоком данных и внедрению поддержки FP8. Вкупе это позволило вчетверо поднять эффективность speedAI по сравнению с runAI. Новинка может быть гибко адаптирована к различным архитектурам нейронных сетей. Концептуально speedAI напоминает ещё один тысячеядерный чип RISC-V — Esperanto ET-SoC-1.   Первый член семейства speedAI — speedAI240 — обеспечивает 2 Пфлопс вычислениях в FP8-вычислениях или 1 Пфлопс для BF16-операций. Благодаря этому обеспечивается самая высокая в отрасли эффективность — например, для модели BERT заявленная производительность составляет 750 запросов в секунду на Вт (qps/w), что, по словам компании, в 15 раз выше, чем у современных GPU. Добиться повышения производительности удалось благодаря тесной интеграции вычислительных элементов и памяти.   На каждый блок SRAM объёмом 328 Кбайт приходится 512 вычислительных блоков, поддерживающих работу с форматами INT4, INT8, FP8 и BF16. Каждый вычислительный блок имеет два 32-бит (RV32EMC) кастомных ядра RISC-V с поддержкой четырёх потоков и 64 SIMD. Всего есть 729 блоков, так что суммарно чип несёт 238 Мбайт SRAM и 1458 ядер. Блоки провязаны между собой mesh-сетью, к которой также подключены кольцевая IO-шина, несущая четыре 1-Мбайт блока общего кеша, два контроллера LPDRR5 (64 бит) и порты PCIe 5.0: один x16 для подключения к хосту и три x8 для объединения чипов. Суммарная пропускная способность SRAM составляет около 1 Пбайт/с, mesh-сети — от 1,5 до 1,9 Тбайт/с, IO-шины — 141 Гбайт/c в обоих направлениях, а 32 Гбайт DRAM — чуть больше 100 Гбайт/с. PCIe-интерфейсы позволяют объединить до трёх ускорителей, с шестью speedAI240 чипами у каждого. Решения speedAI будут предлагаться как в виде отдельных чипов, так и в составе готовых PCIe-карт и M.2-модулей. Ожидается, что первые поставки избранным клиентам начнутся в первой половине 2023 года. |

|