Лента новостей

|

29.04.2024 [10:56], Сергей Карасёв

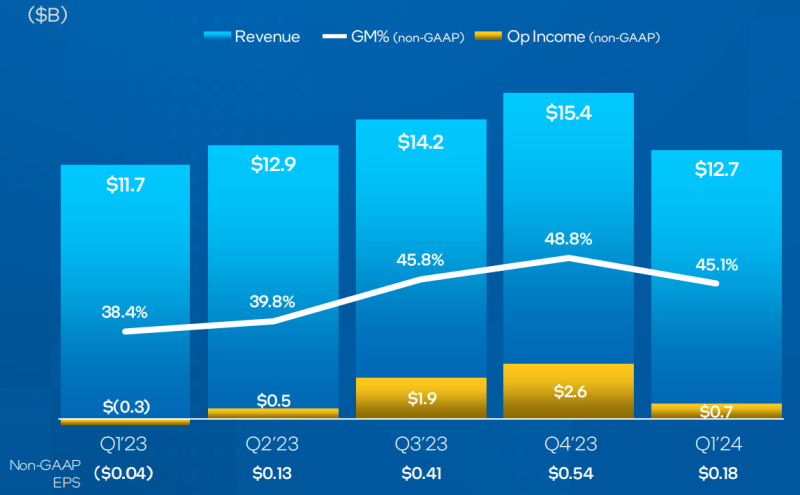

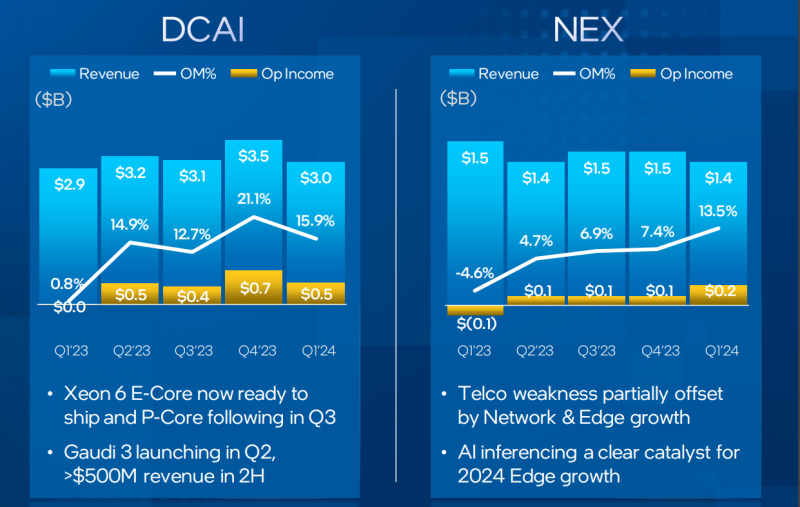

Серверное подразделение Intel нарастило выручку и показало операционную прибыльКорпорация Intel отрапортовала о работе в I четверти 2024 финансового года, которая была закрыта 30 марта. Общая выручка составила приблизительно $12,7 млрд: это на 9 % больше по сравнению с результатом годичной давности, когда компания получила около $11,7 млрд. За отчётный период Intel понесла чистые убытки в размере $0,4 млрд, или $0,09 на одну ценную бумагу. Несмотря на то, что корпорация продолжает показывать потери, ситуация улучшается. Так, в I квартале 2023 финансового года убытки корпорации были в семь раз больше — $2,8 млрд, или $0,66 на акцию. В подразделении Datacenter and AI Group (DCAI), которое отвечает за решения для ЦОД и платформ ИИ, зафиксирована выручка на отметке $3,0 млрд, что на 5 % больше в годовом исчислении. Операционная прибыль при этом составила примерно $482 млн против $22 млн в I четверти 2023 финансового года. Группа Network and Edge Group (NEX), специализирующаяся на сетевых продуктах и периферийных вычислениях, продемонстрировала выручку в размере $1,4 млрд против $1,5 млрд годом ранее: падение по данному направлению — около 8 %. Вместе с тем показана операционная прибыль в $184 млн, тогда как годом ранее были зафиксированы операционные убытки на уровне $69 млн. Выручка в подразделении Intel Foundry Service, задачами которого является контрактное производство чипов, в годовом исчислении уменьшилась на 10 % — с $4,8 млрд до $4,4 млрд. Операционные убытки в этой группе возросли год к году с $2,4 млрд до $2,5 млрд. В отчёте также сказано, что продукция возрождённого бренда Altera в течение квартала принесла $342 млн — это на 58 % меньше прошлогоднего результата, равного $816 млн. При этом показаны операционные убытки на уровне $39 млн, тогда как годом ранее говорилось об операционной прибыли в $290 млн. Во II четверти текущего финансового года Intel рассчитывает получить выручку от $12,5 млрд до $135 млрд. При этом чистые убытки прогнозируются на уровне $0,05 на акцию.

29.04.2024 [10:54], Сергей Карасёв

Хакеры атакуют правительственные сети через дыры в оборудовании CiscoКанадский центр кибербезопасности (CCCS), Отдел кибербезопасности Управления радиотехнической обороны Австралии (ASD) и Национальный центр кибербезопасности Великобритании (NCSC) предупреждают о том, что неизвестная хакерская группировка, предположительно поддерживаемая на государственном уровне, атакует правительственные сети по всему миру. Известно, что нападения проводятся через уязвимости в межсетевых экранах Cisco и, возможно, через дыры в сетевом оборудовании, которое поставляется другими компаниями, включая Microsoft. Корпорация Cisco присвоила кибератакам кодовое имя ArcaneDoor (другие названия — UAT4356 и STORM-1849).

Источник изображения: pixabay.com Вредоносная активность впервые была обнаружена в январе нынешнего года, когда о подозрительных действиях в своей IT-инфраструктуре сообщил один из клиентов Cisco. Последующее расследование показало, что кибератаки осуществлялись как минимум с ноября 2023-го. Выявлены несколько жертв — все они связаны с правительственными организациями разных стран. Говорится, что загадочная хакерская группировка использовала специальные инструменты, «демонстрирующие чёткую направленность на шпионаж» и глубокое понимание архитектуры и принципов работы целевых устройств. Это, по мнению экспертов, является отличительными особенностями опытных киберпреступников, спонсируемых на государственном уровне. Атаки, в частности, осуществляются через уязвимости в оборудовании Cisco Adaptive Security Appliance (ASA) и Firepower Threat Defense (FTD). Информация о дырах содержится в бюллетенях CVE-2024-20353 и CVE-2024-20359 с рейтингом опасности CVSS 8.6 и 6.0 соответственно. Первая из уязвимостей позволяет неаутентифицированному удалённому злоумышленнику организовать DoS-атаку. Вторая брешь даёт возможность локальному нападающему, прошедшему проверку подлинности, выполнить произвольный код с root-привилегиями. После компрометации устройств жертв злоумышленники внедряют два вредоносных имплантата — Line Dancer и Line Runner для загрузки и выполнения произвольного шелл-кода, а также обхода систем безопасности. Компания Cisco уже выпустила исправления для указанных уязвимостей.

28.04.2024 [21:01], Руслан Авдеев

Google начинает строительство четвёртого кампуса ЦОД в Нидерландах за €600 млнКомпания Google начала строительство ЦОД в промышленной зоне Westpoort, расположенном в провинции Гронинген (Нидерланды). Datacenter Dynamics сообщает, что один из топ-менеджеров компании Джаеш Десаи (Jayesh Desai) подтвердил данные о начале работ. Хотя в стране действует мораторий на строительство крупных ЦОД, Гронинген стала исключением из правил в 2022 году, а в конце прошлого года началось строительство третьего дата-центра Google в стране — в Винсхотене той же провинции. Техногигант выделил на проект в Westpoort €600 млн ($643 млн), а всего Google инвестировала в цифровую инфраструктуру в Нидерландах уже €3,8 млрд ($4 млрд). В Google утверждают, что новый кампус позволит создать 125 новых рабочих мест. Также она пообещала сделать своим приоритетом при его реализации экологическую и энергетическую устойчивость. Несколько лет назад компания приобрела участок площадью 20 га, из которых 8 га было отведено под дата-центр. Однако реализация проекта затянулась, в том числе из-за проблем с доступностью энергии и воды. Ранее Google анонсировала заключение соглашения о покупке энергии (PPA) на 479 МВт с операторами ветряных электростанций Crosswind и Ecowende, благодаря которому более 90 % энергетических расходов компании в стране будет приходиться на «безуглеродную» энергетику, пусть и косвенно. IT-гигант также заявил, что намерен инвестировать в Гронингене в проекты по управлению водными ресурсами — предполагается, что к 2030 году компания сможет «возвращать» таким образом в среднем 120 % от объёма воды, используемой её дата-центрами. Сегодня Google имеет два действующих ЦОД в Нидерландах, первый из которых находится в Эмсхавене (тоже Гронинген). Там же компания вложила в завод по обработке воды для охлаждения дата-центра водой одного из каналов и подачи этой воды другим промышленным потребителям региона. Второй ЦОД заработал в 2020 году в Мидденмере к северу от Амстердама. Всего в США, Канаде, Азии, Европе и Южной Америке Google выступает оператором более 135 дата-центров.

28.04.2024 [20:17], Руслан Авдеев

Schneider Electric поможет Terrestrial Energy в развитии и коммерциализации малых атомных реакторовTerrestrial Energy, занимающаяся разработкой малых модульных реакторов (SMR), объединила усилия со Schneider Electric для совместного развития, популяризации и коммерциализации данного направления. Подписанный меморандум о взаимопонимании касается реактора на расплавленной соли (Integral Molten Salt Reactor, ISMR) мощностью 190 МВт. В Terrestrial сообщили, что проект предусматривает быстрое возведение и масштабирование реакторов и снижение цен на электричество. Компания подчёркивает, что такое решение может обеспечить энергией крупные дата-центры и ряд промышленных предприятий — на фоне дефицита энергии для ЦОД может появиться относительно недорогая и экологически безопасная альтернатива магистральному электроснабжению. Компания намерена начать ввод в эксплуатацию IMSR в начале 2030-х годов. В Schneider Electric предлагают использовать технологию т.н. «цифровых двойников» в течение всего жизненного цикла IMSR — это приведёт к сокращению времени вывода продукта на рынок, снижению стоимости и повышению эффективности операций. Компания называет себя лидером цифровой трансформации в области управления и автоматизации энергетики, а также поставщиком с возможностями, ключевыми для надёжной и эффективной работы ISMR-электростанций. Малая атомная энергетика чрезвычайно востребована и активно изучается операторами ЦОД. Equinix подписала соглашение со стартапом Oklo, а блокчейн-компания Standard Power пожелала приобрести 24 SMR у NuScale. Активнее всего ведёт себя Microsoft, которая уже формирует команду для работы над малыми атомными реакторами и даже заключила соглашение со стартапом Helion, хотя никто не знает, сможет ли тот вообще вовремя запустить термоядерный реактор.

28.04.2024 [12:09], Сергей Карасёв

Apple наняла создателя ИИ-кластеров Google, обслуживающих Gemini и BardКомпания Apple, по сообщению ресурса Datacenter Dynamics, приняла на работу Сумита Гупту (Sumit Gupta), бывшего руководителя Google. Он займёт пост директора по продуктам Apple Cloud, на котором займётся развитием облачных технологий, а также решений, связанных с ИИ и машинным обучением. Гупта работал в Google в течение трёх последних лет, исполняя, в частности, обязанности руководителя отдела управления продуктами Google Infrastructure. В числе прочего Гупта отвечал за общую стратегию, бизнес-операции и взаимодействие с клиентами по таким направлениям как базы данных, аналитика, управление ресурсами, чипы TPU и Arm, хранилища и сети. Гупта также занимал должность старшего директора Google по управлению продуктами для инфраструктуры ИИ и машинного обучения. Под его руководством была сформирована программно-аппаратная инфраструктура для больших языковых моделей (LLM), включая семейство Gemini/Bard. Ранее он в течение шести лет работал в IBM, занимая должность директора по стратегии в области ИИ и технического директора по ИИ. А в 2007–2015 гг. Гупта занимал должность главного менеджера дата-центров для задач ИИ в NVIDIA. В Apple Гупта возглавит формируемую команду специалистов по инфраструктуре и облачным технологиям. В описании вакансии Apple говорится, что компания создаёт мультиоблачную платформу, которая будет поддерживать все ключевые сервисы, включая музыку, телевидение, приложения ИИ и машинного обучения. Отмечается, что инфраструктура Apple включает в себя основные платформенные и управляемые сервисы, необходимые для разработки, развёртывания и широкомасштабного внедрения публичного облака. В требованиях к соискателям в числе прочего упомянут предпочтительный опыт работы в рамках облачных платформ Google Cloud и (или) Amazon Web Services (AWS). Необходимо хорошее техническое понимание инфраструктурных услуг и облачных технологий. Диапазон базовой заработной платы для этой должности составляет от $188 тыс. до $351 тыс. в год.

28.04.2024 [11:42], Сергей Карасёв

Thoma Bravo купит за $5,3 млрд британского разработчика ИИ-решений для ИБ DarktraceАмериканская компания Thoma Bravo, специализирующаяся на инвестициях в сферах кибербезопасности и технологий ИИ, сообщила о заключении соглашения по приобретению британского разработчика Darktrace. Сумма сделки составит приблизительно $5,3 млрд. Фирма Thoma Bravo, основанная в 2008 году, имеет представительства в Сан-Франциско, Нью-Йорке, Лондоне и Майами. Этот инвестиционный гигант по состоянию на июль 2023 года заключил более 440 сделок в области ПО и ИБ. В портфолио Thoma Bravo — McAfee, Proofpoint и Sophos. Под управлением Thoma Bravo находятся активы на сумму около $138 млрд.

Источник изображения: pixabay.com Darktrace, учреждённая в 2013 году, базируется в Кембридже. Эта британская компания создаёт продукты на основе ИИ для обеспечения информационной безопасности. Система Darktrace ActiveAI Security Platform способна за считанные секунды обнаруживать и реагировать на известные и неизвестные киберугрозы в рамках всей экосистемы организации, включая облако, приложения, электронную почту, конечные точки, сети и пр. Изначально Thoma Bravo пыталась приобрести Darktrace в 2022 году, но тогда попытка поглощения провалилась. По условиям заключенного теперь соглашения, которое одобрено советом директоров Darktrace, акционеры британского разработчика получат $7,75 за одну ценную бумагу. Это представляет собой премию в размере 44,3 % к средневзвешенной цене акций Darktrace за трёхмесячный период, закончившийся 25 апреля 2024 года. Сделка будет завершена в III или IV квартале 2024 года после получения необходимых разрешений со стороны регулирующих органов. После этого Darktrace превратится в частную компанию и уйдёт с Лондонской фондовой биржи, где, по её мнению, стоимость акций была ниже ожидаемой с момента листинга в 2021 году. Ожидается, что штаб-квартира Darktrace останется в Великобритании.

28.04.2024 [11:21], Сергей Карасёв

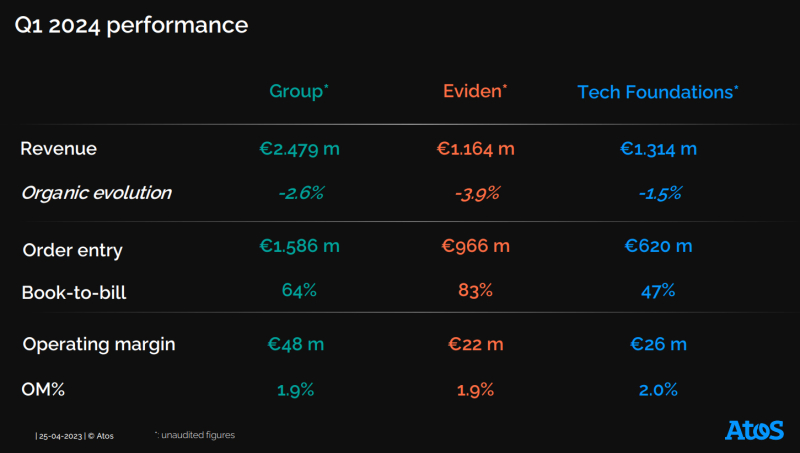

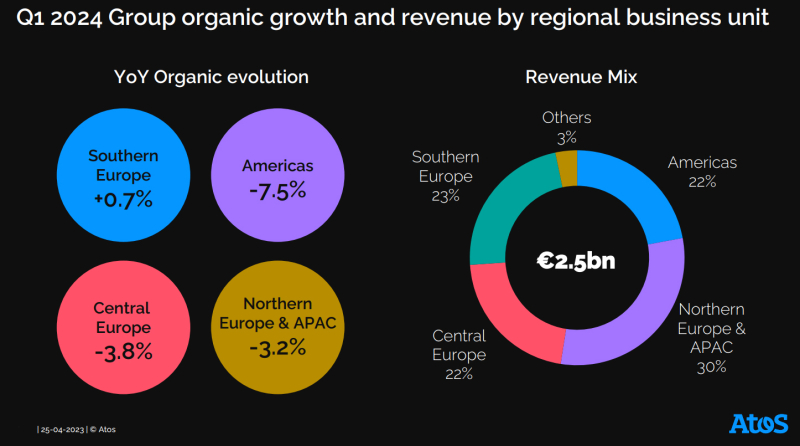

Atos теряет выручку по всем направлениям, а будущее компании всё более туманноФранцузский IT-холдинг Atos, переживающий трудные времена, отчитался о работе в I четверти 2024 года. Суммарная выручка составила €2,48 млрд, что на 2,6 % меньше результата годичной давности, равного €2,55 млрд. Atos продолжает искать способы рефинансирования долга. Квартальная выручка подразделения Eviden, которое специализируется на кибербезопасности и обработке больших данных, составила €1,16 млрд против €1,21 млрд годом ранее. Таким образом, сокращение зафиксировано на уровне 3,9 %. В то время как в континентальной Европе выручка выросла среди клиентов государственного сектора и коммунальных предприятий, на показатели негативно повлияли общий спад в США и сокращение объёма контрактов в Великобритании. В сегменте Tech Foundations, который включает дата-центры, хостинг и аутсорс-сервисы для бизнес-процессов, выручка оказалась на отметке €1,31 млрд против €1,33 млрд в I квартале 2023 года, что соответствует сокращению примерно на 1,5 %. Говорится о замедлении расходов государственного сектора в Центральной Европе, а также об ухудшении ситуации на американском рынке. С географической точки зрения общая выручка Atos в Северной Америке сократилась в годовом исчислении на 7,5 % — до €547 млн. В Северной Европе и Азиатско-Тихоокеанском регионе зафиксировано падение на 3,2 % — до €754 млн. Продажи в Центральной Европе принесли €533 млн, что на 3,8 % меньше в годовом исчислении. В Южной Европе отмечен рост на 0,7 % — до €565 млн. В начале апреля 2024 года Atos сообщила о том, что план её спасения предложил крупнейший акционер — Onepoint. Предполагалось, что компания подготовит предложения по рефинансированию к 26 апреля, но теперь сроки перенесены на 3 мая. Отмечается, что бизнес-план необходимо скорректировать, чтобы отразить текущие коммерческие показатели и тенденции. Вместе с тем положение Atos остаётся шатким: на конец 2023 года её чистый долг составлял €2,23 млрд. Переговоры о продаже активов компании EP Equity Investment (EPEI), которая контролируется чешским миллиардером Даниэлем Кретинским (Daniel Křetínský), провалились. Не удалось достичь соглашения и с европейским аэрокосмическим гигантом Airbus.

28.04.2024 [11:16], Владимир Мироненко

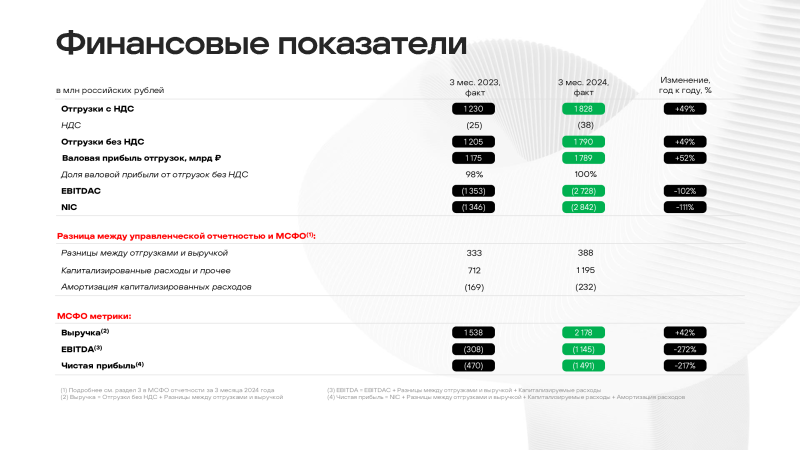

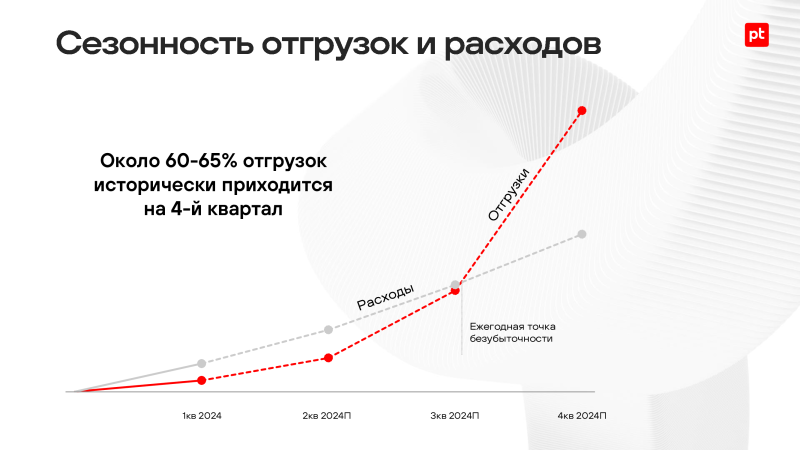

Positive Technologies увеличила в I квартале 2024 года объём отгрузок в 1,5 разаРоссийская компания Positive Technologies, специализирующаяся на разработке решений в сфере информационной безопасности, сообщила неаудированные результаты работы в I квартале 2024 года. Выручка компании за первые три месяца 2024 года составила 2,18 млрд руб., превысив показатель аналогичного периода прошлого года на 42 %. Убытки компании выросли на 217 % с 470 млн руб. в I квартале 2023 года до 1,49 млрд руб. в отчётном периоде, показатель EBITDA снизился на 272 %, с –308 млн руб. до –1,15 млрд руб. При этом объём отгрузок увеличился на 49 % до 1,83 млрд руб., а валовая прибыль отгрузок увеличилась на 52 %, до 1,79 млрд руб. Как отметила компания, «результаты I квартала 2024 года демонстрируют увеличение доходных показателей». Благодаря росту показателей стоимость акций Positive Technologies на Московской бирже увеличилась с начала 2024 года на 46 %. Отрицательные значения в I квартале прибыльности и EBITDA объясняются тем, что для Positive Technologies характерна ярко выраженная сезонность работы: исторически на IV квартал приходится около 60–65% отгрузок. При этом расходы компании распределяются более равномерно по всему году. В рамках стратегии по масштабированию бизнеса, ускорению разработки новых продуктов и выходу в новые технологические и географические сегменты рынка, увеличивает инвестиции в R&D, составившие в отчётном квартале 1,9 млрд руб. по сравнению с 1,0 млрд руб. в прошлом году. Вместе с тем операционные расходы оказалась на 22 % ниже заложенных бюджете. Увеличение инвестиций отразилось на показателе NIC, тоже имеющий в I квартале традиционно отрицательное значение. В отчётном квартале Positive Technologies представила новый сервис PT Knockin для проверки защищённости корпоративной электронной почты. В следующем месяце компания планирует на ежегодном фестивале кибербезопасности Positive Hack Days Fest объявить о запуске коммерческих продаж PT NGFW — межсетевого экрана нового поколения, а также представить коммерческую версию метапродукта MaxPatrol Carbon, предназначенного для подготовки ИТ-инфраструктуры компаний к отражению кибератак.

27.04.2024 [22:33], Татьяна Золотова

«МегаФон» представил транкинговую связь на базе LTE«МегаФон» и компания «Триалинк», предлагающая услуги в рамках системы RONET, разработали российскую профессиональную радиосвязь (транкинг) для экстренных служб и компаний. Решение работает на базе сети LTE как через локальный сервер, так и через облако, сообщает пресс-служба оператора. Контракт партнеры заключили в начале 2024 года, он предусматривает разработку ПО для транкинга и его последующее обслуживание и техподдержку. Для работы требуются специализированные абонентские устройства с клавишей PTT (Push-To-Talk), одним нажатием которой можно вызвать отдельного абонента или группу. Как говорят в пресс-службе оператора, такой вид связи особенно востребован у экстренных служб, в гостиницах, охранных предприятиях, на стадионах горно-обогатительных комбинатах. Если раньше технологии транкинга позволяли лишь общаться голосом, то сейчас востребованы системы PoC (Push to Talk Over Cellular), связывающие абонентов через сотовую сеть. По оценке ИАА «Рустелеком», российский рынок PoC прирастает в деньгах более чем на 60% в год. Новая система может быть бесшовно интегрирована с уже работающими системами профессиональной радиосвязи прежних стандартов. Помимо оперативной голосовой связи решение позволяет в режиме реального времени отслеживать геолокацию всех участников системы, мгновенно передавать файлы и фото, транслировать видео в высоком разрешении.

27.04.2024 [22:12], Владимир Мироненко

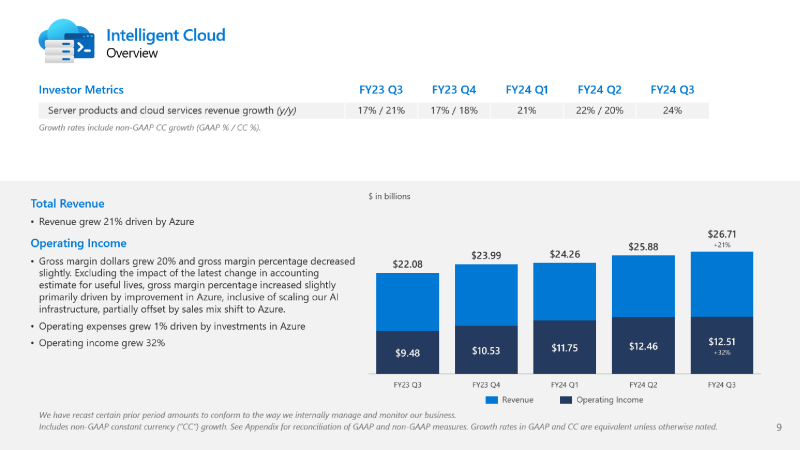

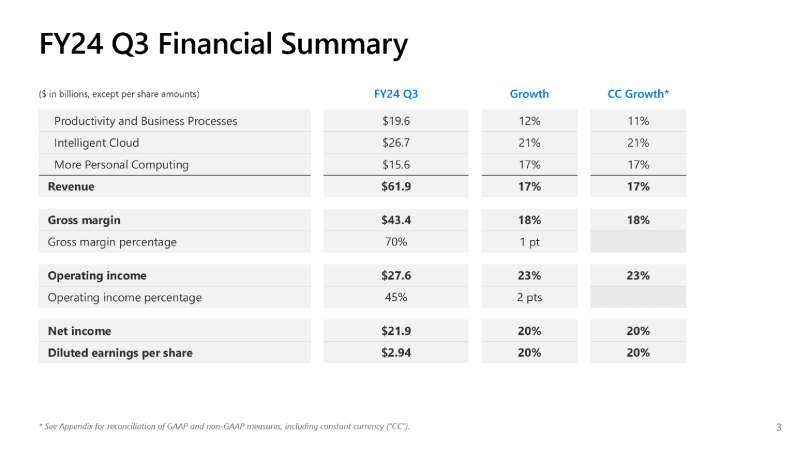

Росту выручки Microsoft в III финансовом квартале способствовало облако и ИИАкции Microsoft выросли в минувшую пятницу на 5 % после отчёта о результатах работы в III квартале 2024 финансового года, завершившемся 31 марта — компания превысила прогнозы аналитиков по выручке и прибыли, в основном благодаря подразделению облачных вычислений. Прибыль (GAAP) Microsoft составила $21,9 млрд или $2,94 на акцию при выручке в $61,9 млрд, что выше показателей аналогичного периода годом ранее на 20 и 17 % соответственно. Согласно прогнозу аналитиков Уолл-стрит, опрошенных Bloomberg, прибыль на акцию III финансовом квартале ожидалась в размере $2,83 при выручке в $60,88 млрд. Рост прибыли был достигнут, несмотря на увеличение компанией капзатрат до $14 млрд с $11,5 млрд в предыдущем квартале. Общий доход Microsoft от коммерческих облачных технологий вырос на 23 % до $35,1 млрд, превысив прогноз Уолл-стрит в размере $33,93 млрд. Выручка сегмента Intelligent Cloud, включающего облачные сервисы, а также Enterprise Services, Windows Server и SQL Server, выросла на 21 % до $26,71 млрд. Прогноз Уолл-стрит — $26,25 млрд. В сегменте Productivity and Business Processes (офисные приложения Office и Office 365, Dynamics CRM) выручка выросла на 11 % до $19,6 млрд. При этом доходы от потребительских продуктов Office и облачных сервисов увеличились на 12 %, а доходы от коммерческих продаж Office 365 — на 15 %. На конец квартала число подписчиков Microsoft 365 составляло 80,8 млн. Microsoft отметила, что росту доходов Azure и других облачных сервисов способствовали сервисы ИИ — в III квартале — на 7 процентных пунктов (п.п.). Во II квартале этот показатель равнялся 6 п.п., в I квартале — 3 п.п. Microsoft впервые опубликовала информацию о процентном вкладе ИИ в рост доходов Azure в IV квартале прошлого года, заявив, что за тот период ИИ увеличил доходы Azure на 1 п.п. «Microsoft Copilot и стек Copilot создают новую эру трансформации ИИ, обеспечивая лучшие результаты бизнеса во всех сферах и отраслях», — заявил гендиректор Microsoft Сатья Наделла (Satya Nadella). Microsoft сообщила, что более 65 % компаний из списка Fortune 500 используют её сервис Azure OpenAI, предлагающий «ведущие в отрасли ИИ-модели», которые можно точно настроить в соответствии с конкретными потребностями клиента. Драйвером роста компании по-прежнему остаётся облако, чему частично способствуют гибридные и мультиоблачные предложения. По словам Наделлы, решение Azure Arc, которое позволяет администраторам управлять локальными и облачными службами с единой консоли, в настоящее время используется 33 тыс. клиентов, что вдвое больше, чем годом ранее. «Мы являемся предпочтительной гиперскейл-платформой для рабочих нагрузок SAP и Oracle», — сказал Наделла, отметив увеличение количества больших сделок Azure с крупнейшими компаниями, лидирующими в разных отраслях. По данным Microsoft, количество сделок клиентов с Azure на сумму более $100 млн увеличилось более чем на 80 % год к году, а количество сделок на сумму более $10 млн выросло более чем вдвое. А аналитической платформой Microsoft Fabric на базе ИИ уже пользуется более 11 тыс. платящих клиентов всего через год с момента её запуска. Также следует отметить, что выручка в сегменте More Personal Computing увеличилась год к году на 17 % до $15,6 млрд. Microsoft опубликовала прогноз, согласно которому её выручка в IV квартале 2024 финансового года составит от $63,5 до $64,5 млрд, что немного меньше прогноза аналитиков в размере $64,7 млрд. |

|