Материалы по тегу: instinct

|

13.06.2025 [00:15], Владимир Мироненко

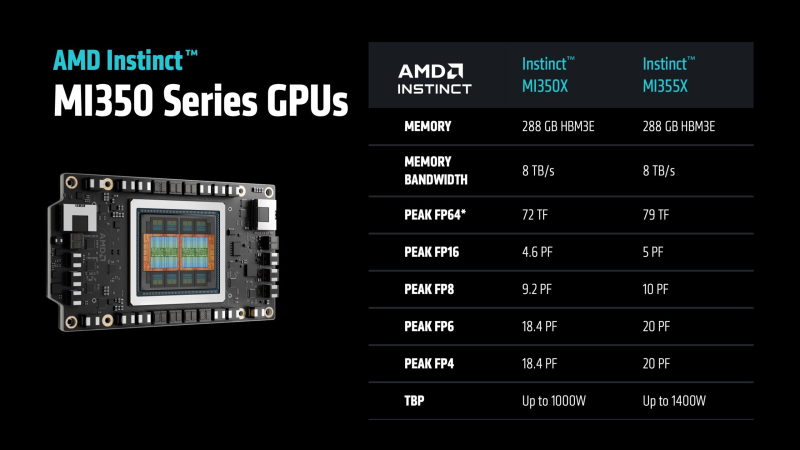

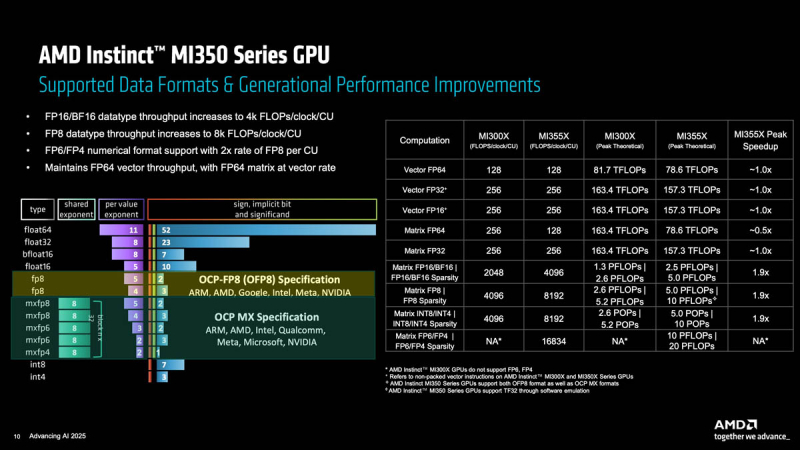

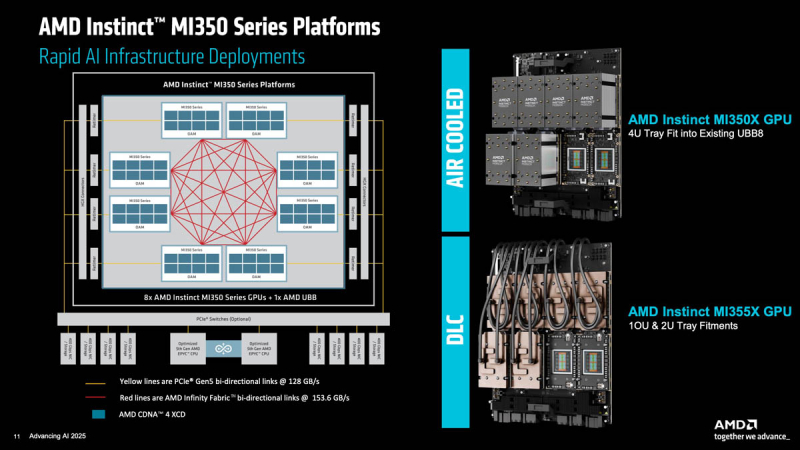

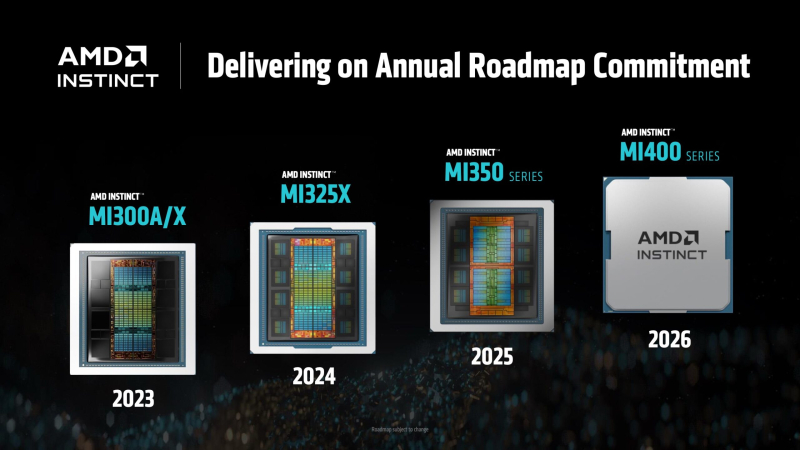

Ускорители AMD Instinct MI355X с архитектурой CDNA 4 потребляют 1400 ВтAMD представила ускоритель Instinct MI355X для ИИ- и HPC-нагрузок, демонстрирующий значительный рост производительности в задачах инференса, но вместе с тем почти удвоенное энергопотребление по сравнению с MI300X 2023 года выпуска, сообщил ресурс ComputerBase. Есть и чуть более простая версия MI350X, менее требовательная к питанию и охлаждению. AMD Instinct MI350X (Antares+) основан на оптимизированной архитектуре CDNA 4, отличающейся эффективной поддержкой новых форматов вычислений, в чём AMD ранее не была сильна. В дополнение к FP16 новый ускоритель поддерживает не только FP8, но также FP6 и FP4, которые актуальны для ИИ-нагрузок, особенно инференса. AMD во многом позиционирует Instinct MI350X как ускоритель для инференса, что имеет смысл, поскольку масштабирование MI350X по-прежнему ограничено лишь восемью ускорителями (UBB8), что снижает их конкурентоспособность по сравнению с ускорителями NVIDIA. Впрочем, для т.н. думающих моделей масштабирование тоже важно, что уже сказалось на продажах MI325X.

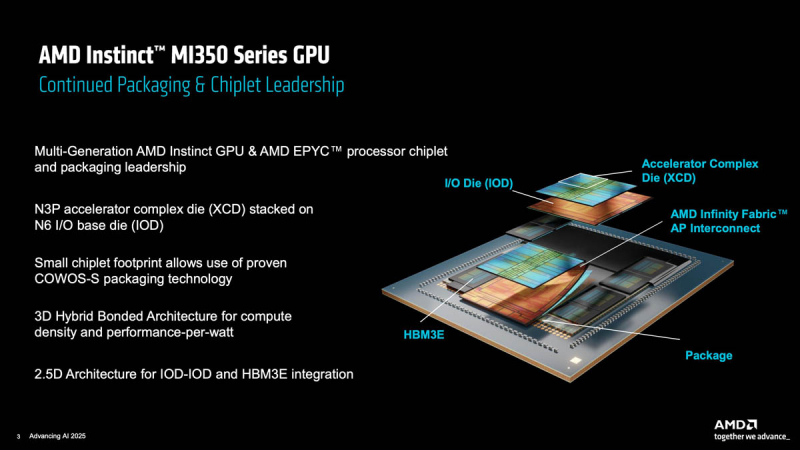

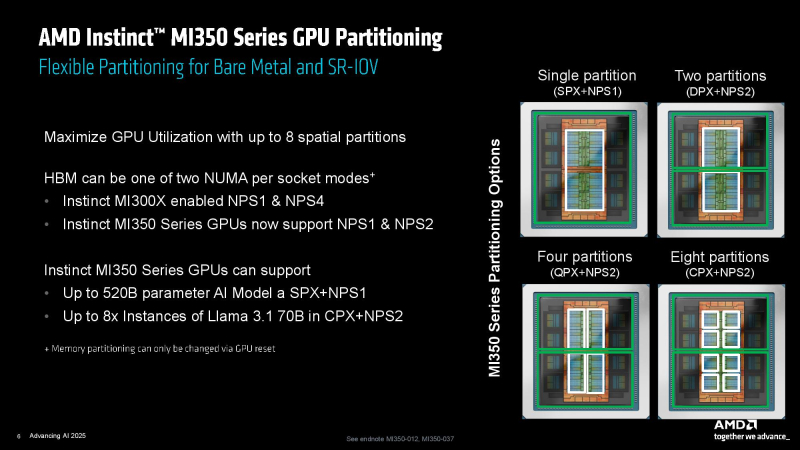

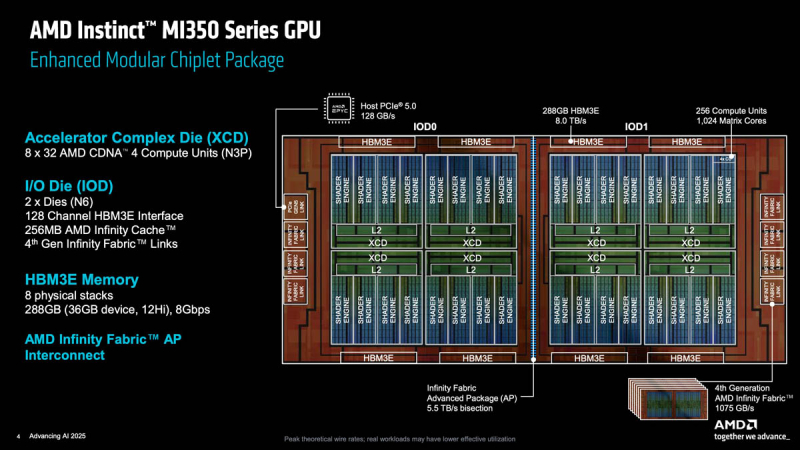

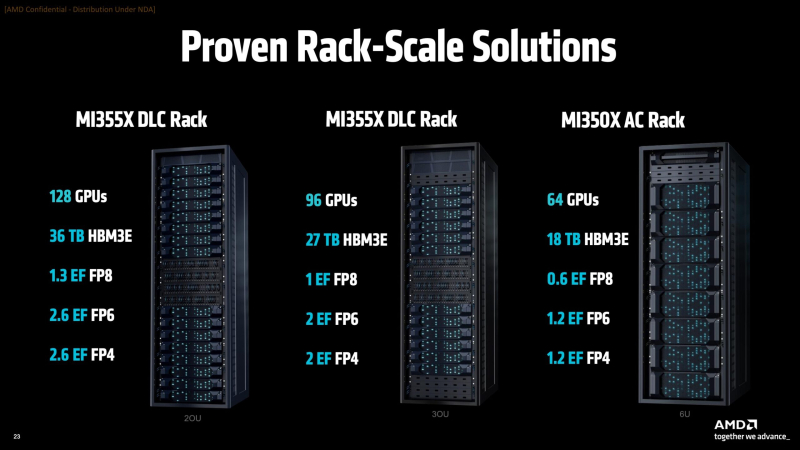

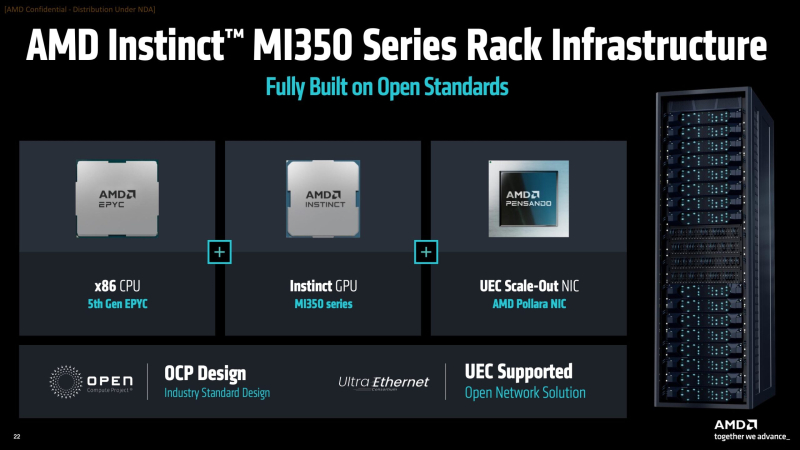

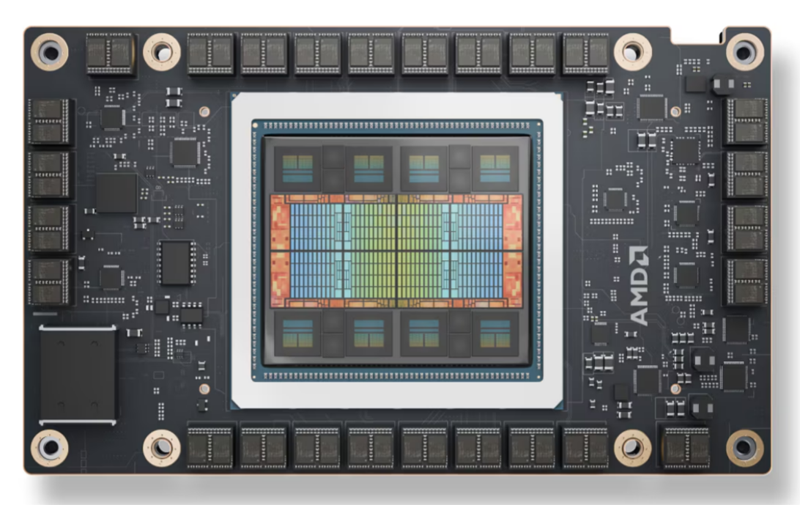

Источник изображений: AMD via ServeTheHome Серия ускорителей AMD Instinct MI350X включает две модели: стандартный ускоритель Instinct MI350X мощностью 1000 Вт, который всё ещё можно использовать с системами воздушного охлаждения, а также более производительный Instinct MI355X до 1400 Вт, рассчитанный исключительно на работу с СЖО. Впрочем, AMD считает, что некоторые из её клиентов смогут использовать воздушное охлаждение для MI355X, пишет Tom's Hardware. В случае СЖО в одну стойку можно упаковать до 16 узлов (128 ускорителей MI355X), а в случае воздушного охлаждения — до 8 узлов (64 ускорителя MI350X). Для вертикального масштабирования предполагается использование UALink, для горизонтального — Ultra Ethernet. Оба ускорителя будут поставляться с 288 Гбайт памяти HBM3E с пропускной способностью до 8 Тбайт/с. Сообщается, что ускоритель MI350X обладает максимальной производительностью в операциях FP4/FP6 в размере 18,45 Пфлопс, тогда как MI355X — до 20,1 Пфлопс. То есть обе модели серии Instinct MI350X превосходят ускоритель NVIDIA B300 (Blackwell Ultra), который с производительностью 15 FP4 Пфлопс. Что интересно, для векторных FP64-вычислений AMD сохранила тот же уровень производительности, что был у MI300X, а матричные FP64-вычисления стали почти вдвое медленнее. Тем не менее, это всё равно лучше, чем почти 30-кратное снижение скорости FP64-расчётов при переходе от B200 к B300. Если сравнивать производительность новых чипов с предшественником, то производительность MI350X в вычислениях с точностью FP8 составляет около 9,3 Пфлопс, в то время как у MI355X, как сообщается, этот показатель составляет 10,1 Пфлопс, что значительно выше, чем 5,22 Пфлопс у Instinct MI325X (во всех случаях речь идёт о разреженных вычислениях). MI355X также превосходит NVIDIA B300 на 0,1 Пфлопс в вычислениях FP8. Формально разница между MI350X и MI355X не так велика, но на практике она может достигать почти 20 % из-за возможности более долго поддерживать частоты при наличии СЖО. В целом, по словам AMD, в ИИ-тестах MI350X/MI355X быстрее MI300X в 2,6–4,2 раза в зависимости от задачи и до 1,3 раз быстрее (G)B200, но при этом значительно дешевле последних. Компоновка MI350X/MI355X напоминает компоновку MI300X. Есть восемь 3-нм (TSMC N3P) XCD-чиплетов, лежащих поверх двух 6-нм (N6) IO-тайлов (IOD) и обрамлённых восемью стеками HBM3E. Переход к двум IOD повлиял и на NUMA-домены, поскольку теперь память можно поделить только пополам. А вот вычислительных инстансов может быть до восьми. Используется комбинированная 3D- и 2.5D-компоновка чиплетов, причём для связи IOD, т.е. двух половинок всего чипа, используется шина Infinity Fabric AP с пропускной способностью 5,5 Тбайт/с. Каждый XCD содержит 36 CU, из которых активно только 32 (для повышения процента годных чипов), и общий L2-кеш объёмом 4 Мбайт. Все XCD подключены к Infinity Cache объёмом 256 Мбайт. Для связи с внешним миром есть один интерфейс PCIe 5.0 x16 (128 Гбайт/с) и семь линий Infinity Fabric (1075 Гбайт/с), которые как раз и позволяют объединить восемь ускорителей по схеме каждый-с-каждым. Технический директор AMD Марк Пейпермастер (Mark Papermaster) заявил, что отрасль продолжит разрабатывать всё более мощные процессоры и ускорители для суперкомпьютеров, чтобы достичь производительности зеттафлопсного уровня примерно через десятилетие. Однако этот рост будет достигаться ценой резкого увеличения энергопотребления, поэтому суперкомпьютер с производительностью такого уровня будет потреблять примерно 500 МВт — половину того, что вырабатывает средний реактор АЭС. Для поддержания роста производительности пропускная способность памяти и масштабирование мощности тоже должны расти. Согласно расчётам AMD, пропускная способность памяти ускорителя должна более чем удваиваться каждые два года, чтобы сохранить соотношение ПСП к Флопс. Это потребует увеличения количества стеков HBM на один ускоритель, что приведёт к появлению более крупных и более энергоёмких ускорителей и модулей. Instinct MI300X имел пиковую мощность 750 Вт, Instinct MI355X имеет пиковую мощность 1400 Вт, в 2026–2027 гг., по словам Пейпермастера, нас ждут ускорители мощностью 1600 Вт, а в конце десятилетия — уже 2000 Вт. У чипов NVIDIA энергопотребление ещё выше — ожидается, что у ускорителей Rubin Ultra с четырьмя вычислительными чиплетами энергопотребление составит до 3600 Вт. На фоне растущего энергопотребления суперкомпьютеры и ускорители также быстро набирают производительность. Согласно презентации AMD на ISC 2025, эффективность производительности увеличилась с примерно 3,2 ГФлопс/Вт в 2010 году до примерно 52 Гфлопс/Вт к моменту появления экзафлопсных систем, таких как Frontier. Поддержание такого темпа роста производительности потребует удвоения энергоэффективности каждые 2,2 года, пишет Tom's Hardware. Прогнозируемая система зетта-класса потребует эффективность на уровне 2140 Гфлопс/Вт, т.е. в 41 раз выше, чем сейчас. AMD считает, что для значительного повышения производительности суперкомпьютеров через десятилетие потребуется не только ряд прорывов в архитектуре чипов, но и прорыв в области памяти и интерконнектов.

19.05.2025 [11:29], Сергей Карасёв

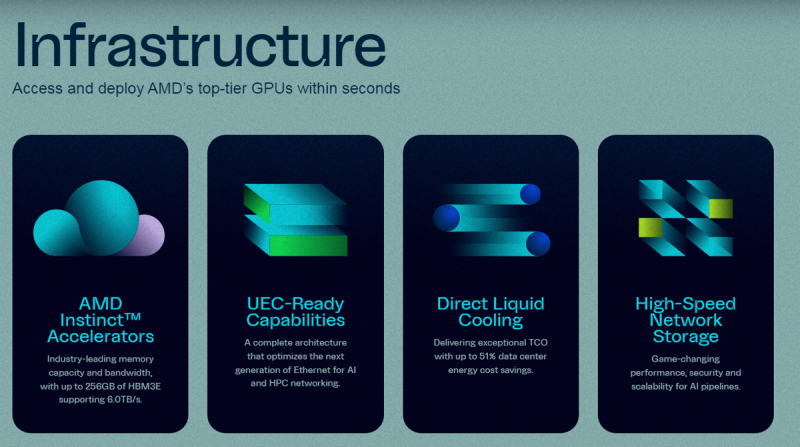

ИИ-облако TensorWave с ускорителями AMD получило ещё $100 млн, в том числе от самой AMDКомпания TensorWave, создающая облачную ИИ-платформу на ускорителях AMD, объявила о проведении раунда финансирования Series A, в ходе которого получено $100 млн. Инвестиционную программу возглавили Magnetar и AMD Ventures при участии Maverick Silicon, Nexus Venture Partners и Prosperity7. В апреле 2024 года TensorWave начала развёртывание облачной ИИ-системы с ускорителями Instinct MI300X. Кроме того, внедряются решения Instinct MI325X. Платформа TensorWave предполагает применение прямого жидкостного охлаждения (DLC) и высокопроизводительного хранилища. Утверждается, что при решении определённых задач, таких как запуск крупных ИИ-моделей в FP16-формате, ускорители AMD обеспечивают преимущества перед изделиями NVIDIA благодаря большему объёму памяти. В результате, ускоряется внедрение сервисов и снижается стоимость услуг для заказчиков. В конце прошлого года стартап TensorWave привлёк $43 млн на закупку ускорителей AMD. В раунде финансирования приняли участие Maverick Capital, Translink Capital, Javelin Venture Partners, Granite Partners и AMD Ventures. Новое финансирование в размере $100 млн по срокам совпало с развёртыванием 8192 ускорителей Instinct MI325X для ИИ-кластера в дата-центре в Тусоне (Аризона, США).

Источник изображения: TensorWave Полученные средства, как ожидается, будут способствовать развитию бизнеса TensorWave, расширению штата и ускорению создания облачной платформы на базе Instinct MI325X. Рынок инфраструктуры ИИ переживает беспрецедентный рост: по оценкам, к 2027 году затраты в данном секторе превысят $400 млрд. Аналитическая фирма Fortune Business Insights подсчитала, что объём мирового рынка ИИ в целом в 2024 году достиг $233 млрд. Прогнозируется, что показатель увеличится примерно до $1,7 трлн долларов к 2032 году. «Финансирование в размере $100 млн поддерживает миссию TensorWave по демократизации доступа к передовым вычислительным ресурсам. Кластер из 8192 ускорителей Instinct MI325X — это только начало», — сказал Даррик Хортон (Darrick Horton), генеральный директор TensorWave.

15.05.2025 [13:51], Владимир Мироненко

Спрос на AMD Instinct MI325X со стороны крупных компаний оказался ниже ожиданий из-за ограниченных возможностей масштабированияОдно из последних предложений AMD для рынка ЦОД — ускоритель AMD Instinct MI325X — не вызвал большого интереса у крупных заказчиков, отдавших предпочтение чипам NVIDIA Blackwell из-за лучшего соотношения цены и производительности, сообщили аналитики SemiAnalysis. После тестовых закупок чипа в 2024 году Microsoft не стала размещать заказы на дальнейшие поставки. Пытаясь привлечь интерес других крупных клиентов, AMD снизила цены на Instinct MI325X. После этого чипы приобрела Oracle и ещё несколько гиперскейлеров, но объёмы закупок не идут ни в какое сравнение с продажами ускорителей NVIDIA. Отсутствие интереса крупных компаний связано с ограничением MI325X в возможности масштабирования лишь до восьми ускорителей, объединённых быстрым интерконнектом, тогда как суперускоритель GB200 NVL72 размер со стойку поддерживает объединение 72 ускорителей. Когда дело касается крупномасштабных рабочих нагрузок ИИ-инференса и рассуждений на on-premise уровне, такая разница имеет решающее значение, отметил ресурс SemiAnalysis. AMD позиционировала MI325X в качестве альтернативы NVIDIA HGX B200 (NVL8) и HGX B300 (NVL16), но даже в этом сегменте NVIDIA имеет преимущество как в чистой производительности, так и в совокупной стоимости владения. Вместе с тем, у MI325X имеются перспективы для менее масштабных развёртываний, не требующих больших кластеров ускорителей, например, для инференса небольших моделей, когда требуется много памяти с большой пропускной способностью. AMD продолжает совершенствовать свою программную экосистему, с которой у неё были очень большие проблемы, и MI325X при условии конкурентоспособной цены может вызвать интерес у компаний, разрабатывающих ИИ-модели среднего размера, считают в SemiAnalysis.

11.03.2025 [18:31], Владимир Мироненко

Oracle построит ИИ-кластер из 30 тыс. ускорителей AMD Instinct MI355X и вдвое увеличит мощность ЦОДКорпорация Oracle сообщила результаты работы в III квартале 2025 финансового года, закончившемся 28 февраля 2025 года. Прибыль и выручка Oracle за квартал оказались ниже прогнозов Уолл-стрит, в связи с чем акции компании упали более чем на 5 %, несмотря на имеющееся большое количестве крупных контрактов на облачные вычисления на будущее, пишет MarketWatch. Выручка Oracle выросла за квартал на 6 % до $14,13 млрд при консенсус-прогнозе аналитиков, опрошенных LSEG, в размере $14,39 млрд. Скорректированная прибыль (Non-GAAP) на акцию тоже оказалась ниже прогноза аналитиков от LSEG — $1,47 против ожидаемых $1,49. Чистая прибыль (GAAP) за отчётный квартал составила $2,94 млрд или $1,02 на разводнённую акцию, по сравнению с $2,40 млрд или $0,85 на разводнённую акцию в III квартале 2024 финансового года. Облачные услуги и поддержка лицензий принесли компании $11,01 млрд (рост год к году на 10 %), что составляет 78 % от её общей выручки. Выручка от лицензирования облачных и локальных продуктов упала на 10 % до $1,13 млрд. Также упали продажи оборудования — на 7 % год к году до $703 млн, и выручка от сервисов — на 1 % до $1,29 млрд. Выручка облачной инфраструктуры (IaaS) выросла на 49 % до $2,7 млрд. За последние три месяца доход от Database MultiCloud на платформах Microsoft, Google и Amazon вырос на 92 %. Потребление ускорителей для обучения ИИ выросло на 244 % за последние 12 месяцев. Эллисон сообщил, что на фоне огромного спроса на инференс компания интегрировала модели OpenAI ChatGPT, xAI Grok и Meta✴ Llama непосредственно с СУБД Oracle 23ai. Этот новый продукт под названием Oracle AI Data Platform позволяет клиентам использовать любую из ведущих в мире ИИ-моделей для анализа всех своих данных, сохраняя при этом их в безопасности. Генеральный директор Oracle Сафра Кац (Safra Catz) сообщила, что в III финансовом квартале Oracle подписала контракты на продажу на рекордную сумму более $48 млрд, увеличив оставшиеся обязательства к исполнению (RPO) на 63 % до более чем $130 млрд, что позволит увеличить общий доход Oracle на 15 % в следующем финансовом году. Следует отметить, что согласно FactSet, аналитики ранее прогнозировали для Oracle в 2026 финансовом году рост продаж на 12,5 %. Вместе с тем капитальные затраты по итогам 2025 финансового года, как ожидается, удвоятся по сравнению с прошлым годом и составят около $16 млрд.

Источник изображения: Oracle По словам Кац, были подписаны облачные соглашения с несколькими ведущими мировыми технологическими компаниями, включая OpenAI, xAI, Meta✴, NVIDIA и AMD, и в ближайшем будущем ожидается подписание первого контракта в рамках проекта Stargate, что позволит Oracle расширить как обучение, так и инференс. Председатель и технический директор Oracle Ларри Эллисон (Larry Ellison) отметил, что спрос со стороны клиентов находится на рекордном уровне и в 2025 календарном году компания удвоит свои мощности ЦОД. Компания находится в процессе развёртывания гигантского ИИ-кластера из 64 тыс. NVIDIA GB200 с жидкостным охлаждением. Кроме того, Oracle построит кластер из 30 тыс. AMD Instinct MI355X. В текущем квартале Oracle ожидает увеличить выручку на 8–10 %. Аналитики ожидали роста примерно на 11 % до $15,91 млрд, согласно LSEG. Компания заявила, что ожидает скорректированную прибыль в размере $1,61–1,65 на акцию. Аналитики прогнозируют скорректированную прибыль на акцию в размере $1,79. Кац также сообщила, что капзатраты Oracle в этом году составят $16 млрд, что более, чем вдвое превышает показатель прошлого года.

20.02.2025 [13:12], Сергей Карасёв

Облако Vultr первым получило ускорители AMD Instinct MI325XVultr, крупнейший в мире частный облачный провайдер, объявил о том, что в его инфраструктуре появились ускорители AMD Instinct MI325X, предназначенные для ресурсоёмких ИИ-нагрузок. Говорится об использовании открытого программного стека ROCm и о поддержке ключевых фреймворков. Vultr стал первым поставщиком облачных услуг, взявшим на вооружение изделия AMD Instinct MI325X. Ускорители развёрнуты в дата-центре компании в Чикаго (Иллинойс, США). Внедрение этих решений является частью усилий по расширению сотрудничества с AMD: в сентябре прошлого года в облаке Vultr появились ускорители Instinct MI300X. Изделия Instinct MI325X несут на борту 256 Гбайт памяти HBM3E с пропускной способностью до 6 Тбайт/с. Пиковая производительность достигает 1,3 Пфлопс в режиме FP16 и 2,6 Пфлопс в режиме FP8. Решения подходят в том числе для задач инференса.

Источник изображения: AMD Отмечается, что Vultr использует ускорители Instinct MI325X в составе серверов Supermicro AS-8126GS-TNMR типоразмера 8U. Эти машины комплектуются двумя процессорами AMD EPYC 9005/9004 с показателем TDP до 500 Вт. Доступны 24 слота для модулей DDR5-6000 суммарным объёмом до 9 Тбайт. Во фронтальной части расположены десять отсеков для SFF-накопителей в конфигурации 8 × NVMe и 2 × SATA. Кроме того, есть два коннектора М.2 (NVMe). Предусмотрены восемь слотов PCIe 5.0 x16 LP и два слота PCIe 5.0 x16 FHHL. За питание отвечают шесть блоков мощностью 5250 Вт с сертификатом Titanium. Применяется воздушное охлаждение. «Ускорители AMD Instinct MI325X устанавливают новые стандарты в области ИИ, обеспечивая невероятную производительность и эффективность для задач инференса», — говорит глава Vultr. Цены на новые инстансы пока не названы.

11.02.2025 [16:24], Владимир Мироненко

ИИ ЦОД за 20 недель: G42 и DataOne построят крупнейший во Франции суперкомьютер на чипах AMD InstinctХолдинг G42 из Абу-Даби (ОАЭ) объявил о стратегических инвестициях во Франции в партнёрстве с недавно образованной DataOne, которая сама себя называет первым в Европе оператором гига-ЦОД для ИИ. Вместе компании в кратчайшие сроки построят в Гренобле ИИ ЦОД, оснащённый ускорителями AMD Instinct. Ожидается, что объект будет полностью введён в эксплуатацию к середине 2025 года. Вычислительные возможности нового ЦОД позволят французским компаниям и учёным разрабатывать передовые модели ИИ, агентов и приложения, а также проводить различные исследования. Реализацией проекта будет заниматься компания Core42, дочернее предприятие G42, совместно с DataOne. По словам главы DataOne Шарля-Антуана Бейни (Charles-Antoine Beyney), на развёртывание крупнейшего ИИ-суперкомпьютера в Европе потребуется всего 20 недель. Для сравнения: кластер xAI Colossus был построен за 122 дня. Как заявила Лиза Су (Lisa Su), председатель и генеральный директор AMD, стратегическое сотрудничество с G42 поможет активизировать французскую экосистему ИИ, предоставив вычислительную мощность, необходимую для поддержки местных стартапов и новаторов, занимающихся передовыми разработками, которые укрепляют французскую экономику. «Работа с G42 является ещё одним примером нашей приверженности объединению открытых экосистем с ведущими в отрасли технологиями ИИ AMD, что обеспечивает возможность государственным учреждениям и частным предприятиям использовать весь потенциал ИИ», — подчеркнула Лиза Су. Инвестиции G42 входят в пакет частных инвестиций в ИИ-инфраструктуру страны на €109 млрд, анонсированный президентом Франции Эммануэле Макроном (Emmanuel Macron) в качестве ответа на представленный в США проект Stargate. Ранее было объявлено о планах ОАЭ вложить при участии фонда MGX €30–50 млрд в проект по созданию кампуса ИИ ЦОД во Франции. В G42 называют инвестиции в ИИ одним из главных направлений своей деятельности. Деятельность холдинга получила поддержку Microsoft, инвестировавшей в него $1,5 млрд. В прошлом году G42 договорился с Cerebras о строительстве в Техасе ИИ-суперкомпьютера со 173 млн ядер.

19.01.2025 [22:43], Сергей Карасёв

Германия запустила «переходный» 48-Пфлопс суперкомпьютер Hunter на базе AMD Instinct MI300AЦентр высокопроизводительных вычислений HLRS при Штутгартском университете в Германии объявил о вводе в эксплуатацию НРС-системы Hunter. Этот суперкомпьютер планируется использовать для решения широко спектра задач в области инженерии, моделирования погоды и климата, биомедицинских исследований, материаловедения и пр. Кроме того, комплекс будет применяться для крупномасштабного моделирования, ИИ-приложений и анализа данных. О создании Hunter сообщалось в конце 2023 года: соглашение на строительство системы стоимостью примерно €15 млн было заключено с HPE. Проект финансируется Федеральным министерством образования и исследований Германии и Министерством науки, исследований и искусств Баден-Вюртемберга. Hunter базируется на той же архитектуре, что El Capitan — самый мощный в мире суперкомпьютер. Задействована платформа Cray EX4000, а каждый из узлов оснащён четырьмя адаптерами HPE Slingshot. Суперкомпьютер использует комбинацию из APU Instinct MI300A и процессоров EPYC Genoa. Как отмечает The Register, в общей сложности система объединяет 188 узлов с жидкостным охлаждением и насчитывает суммарно 752 APU и 512 чипов Epyc с 32 ядрами. Применена СХД HPE Cray Supercomputing Storage Systems E2000, специально разработанная для суперкомпьютеров HPE Cray. HLRS оценивает пиковую теоретическую FP64-производительность Hunter в 48,1 Пфлопс на операциях двойной точности, что практически вдвое выше, чем у предшественника Hawk. В режимах BF16 и FP8 быстродействие, как ожидается, будет варьироваться от 736 Пфлопс до 1,47 Эфлопс. При этом Hunter потребляет на 80% меньше энергии, нежели Hawk. Отмечается, что Hunter задуман как переходная система, которая подготовит почву для суперкомпьютера HLRS следующего поколения под названием Herder. Ввести этот комплекс в эксплуатацию планируется в 2027 году. Предполагается, что он обеспечит производительность «в несколько сотен петафлопс».

17.01.2025 [15:02], Владимир Мироненко

Аналитики снизили рейтинг акций AMD из-за более низких ожиданий по продажам ускорителейАкции Advanced Micro Devices (AMD) могут потерять своё конкурентное преимущество, сообщил аналитик Wolfe Research Крис Касо (Chris Caso), понизив рейтинг акций производителя чипов с Buy (покупать) до Peer Perform (нейтральный), сообщает ресурс Barron's. Аналитик отметил, что после вчерашнего отчёта TSMC о прибыли выросли акции всех компаний по производству оборудования для изготовления пластин — Lam Research, KLA Corporation и Applied Materials. А у AMD, для которой TSMC производит чипы, такого же роста не наблюдалось. Наоборот, её акции упали в четверг на 1,3 % до $118,44. Понизив рейтинг акций AMD, Крис Касо также снял свою целевую цену в $210 за акцию, пояснив свой шаг более низкими, чем прогнозировалось, ожиданиями относительно доходов компании от производства ускорителей для ЦОД. Ускорители являются одним из ключевых продуктов AMD, и Касо утверждает, что бизнес компании по этому направлению «работает ниже ожиданий». Аналитик выразил мнение, что ситуация улучшится после выхода во II половине 2025 года ускорителей AMD Instinct MI350.

Источник изображения: AMD Ранее в этом месяце рейтинг AMD снизили Goldman Sachs и HSBC. Аналитики Goldman понизили свой рейтинг с «Покупать» (Buy) до «Нейтральный» (Peer Perform), сославшись на скромный рост продаж ускорителей для ЦОД на фоне жесткой конкуренции, в то время как команда HSBC понизила рейтинг AMD с «Покупать» (Buy) до «Сокращать позицию» (Reduce) из-за опасений, что акции могут упасть ещё ниже после трёхмесячного спада. Wolfe Research снизила прогнозы выручки и прибыли AMD за I квартал до $6,6 млрд и $0,80 на акцию соответственно, по сравнению с более ранними прогнозами выручки в $7,04 млрд и прибыли в $0,93 на акцию. Скорректированные цифры оказались ниже ожиданий Уолл-стрит в $7,04 млрд по выручке и $0,95 по прибыли на акцию. Компания тоже снизила свой годовой прогноз по выручке и прибыли до $29,9 млрд и $4,19 на акцию соответственно с предыдущих $33,6 млрд и $5,33 на акцию при консенсус-прогнозе аналитиков выручки в размере $32,3 млрд и прибыли в $5,02 на акцию.

28.12.2024 [12:42], Сергей Карасёв

Итальянская нефтегазовая компания Eni запустила суперкомпьютер HPC6 с производительностью 478 ПфлопсИтальянский нефтегазовый гигант Eni запустил вычислительный комплекс HPC6. На сегодняшний день это самый мощный суперкомпьютер в Европе и один из самых производительных в мире: в свежем рейтинге TOP500 он занимает пятую позицию. О подготовке HPC6 сообщалось в начале 2024 года. В основу системы положены процессоры AMD EPYC Milan и ускорители AMD Instinct MI250X. Комплекс выполнен на платформе HPE Cray EX4000 с хранилищем HPE Cray ClusterStor E1000 и интерконнектом HPE Slingshot 11. В общей сложности в состав HPC6 входят 3472 узла, каждый из которых несёт на борту 64-ядерный CPU и четыре ускорителя. Таким образом, суммарное количество ускорителей Instinct MI250X составляет 13 888. Суперкомпьютер обладает FP64-быстродействием 477,9 Пфлопс в тесте Linpack (HPL), тогда как пиковый теоретический показатель достигает 606,97 Пфлопс. Максимальная потребляемая мощность системы составляет 10,17 МВА. Комплекс HPC6 смонтирован на площадке Eni Green Data Center в Феррера-Эрбоньоне: это, как утверждается, один из самых энергоэффективных и экологически чистых дата-центров в Европе. Новый суперкомпьютер оснащён системой прямого жидкостного охлаждения, которая способна рассеивать 96 % вырабатываемого тепла. ЦОД, где располагается HPC6, оборудован массивом солнечных батарей мощностью 1 МВт. Как отмечает ресурс Siliconangle, на создание суперкомпьютера потрачено более €100 млн. Применять комплекс планируется, в частности, для оптимизации работы промышленных предприятий, повышения точности геологических и гидродинамических исследований, разработки источников питания нового поколения, оптимизации цепочки поставок биотоплива, создания инновационных материалов и моделирования поведения плазмы при термоядерном синтезе с магнитным удержанием.

25.12.2024 [01:00], Владимир Мироненко

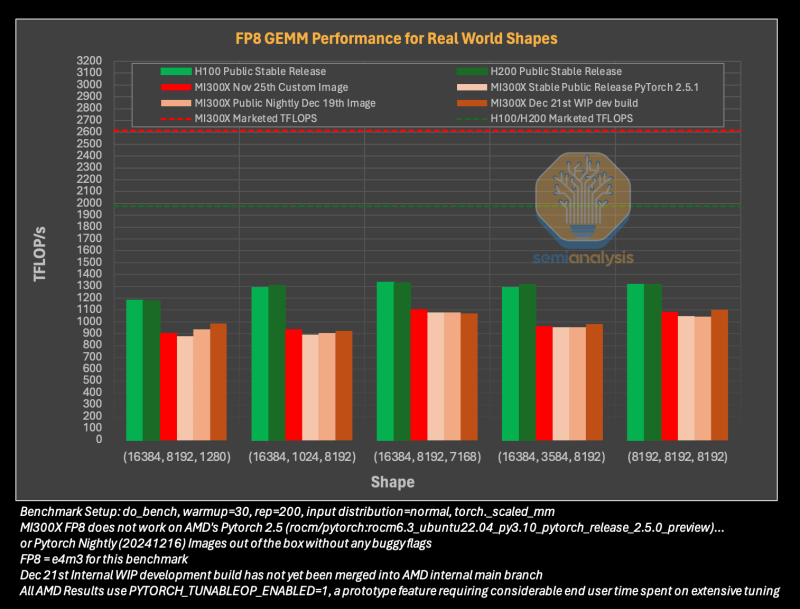

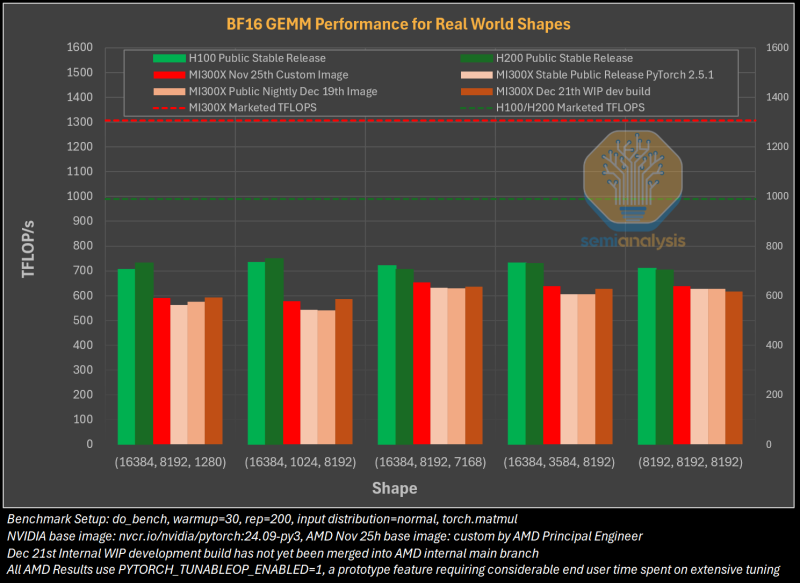

Гладко было на бумаге: забагованное ПО AMD не позволяет раскрыть потенциал ускорителей Instinct MI300XАналитическая компания SemiAnalysis опубликовала результаты исследования, длившегося пять месяцев и выявившего большие проблемы в ПО AMD для работы с ИИ, из-за чего на данном этапе невозможно в полной мере раскрыть имеющийся у ускорителей AMD Instinct MI300X потенциал. Проще говоря, из-за забагованности ПО AMD не может на равных соперничать с лидером рынка ИИ-чипов NVIDIA. При этом примерно три четверти сотрудников последней заняты именно разработкой софта. Как сообщает SemiAnalysis, из-за обилия ошибок в ПО обучение ИИ-моделей с помощью ускорителей AMD практически невозможно без значительной отладки и существенных трудозатрат. Более того, масштабирование процесса обучения как в рамках одного узла, так и на несколько узлов показало ещё более существенное отставание решения AMD. И пока AMD занимается обеспечением базового качества и простоты использования ускорителей, NVIDIA всё дальше уходит в отрыв, добавляя новые функции, библиотеки и повышая производительность своих решений, отметили исследователи.

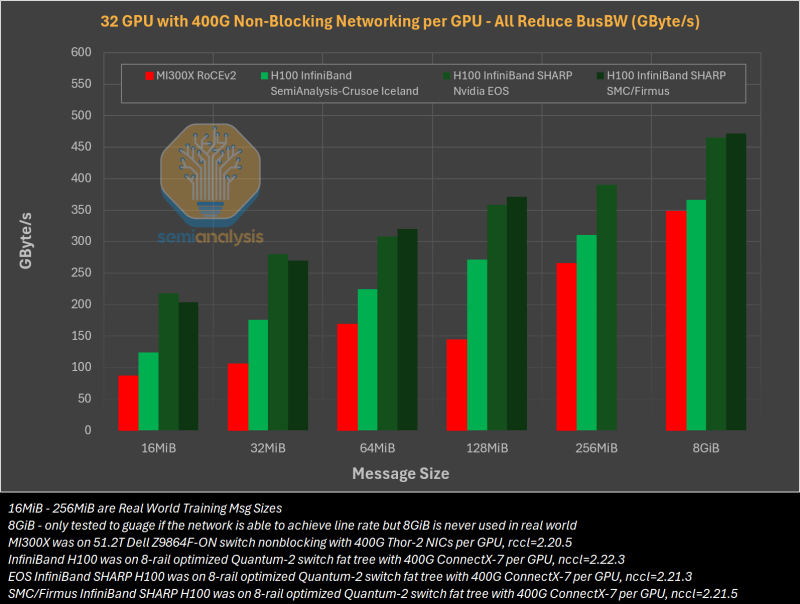

Источник изображений: SemiAnalysis На бумаге чип AMD Instinct MI300X выглядит впечатляюще с FP16-производительностью 1307 Тфлопс и 192 Гбайт памяти HBM3 в сравнении с 989 Тфлопс и 80 Гбайт памяти у NVIDIA H100. К тому же чипы AMD предлагают более низкую общую стоимость владения (TCO) благодаря более низким ценам и использованию более дешёвого интерконнекта на базе Ethernet. Но проблемы с софтом сводят это преимущество на нет и не находят реализации на практике. При этом исследователи отметили, что в NVIDIA H200 объём памяти составляет 141 Гбайт, что означает сокращение разрыва с чипами AMD по этому параметру. Кроме того, внутренняя шина xGMI лишь формально обеспечивает пропускную способность 448 Гбайт/с для связки из восьми ускорителей MI300X. Фактически же P2P-общение между парой ускорителей ограничено 64 Гбайт/с, тогда как для объединения H100 используется NVSwitch, что позволяет любому ускорителю общаться с другим ускорителем на скорости 450 Гбайт/с. А включённый по умолчанию механизм NVLink SHARP делает часть коллективных операций непосредственно внутри коммутатора, снижая объём передаваемых данных. Как отметили в SemiAnalysis, сравнение спецификаций чипов двух компаний похоже на «сравнение камер, когда просто сверяют количество мегапикселей», и AMD просто «играет с числами», не обеспечивая достаточной производительности в реальных задачах. Чтобы получить пригодные для аналитики результаты тестов, специалистам SemiAnalysis пришлось работать напрямую с инженерами AMD над исправлением многочисленных ошибок, в то время как системы на базе NVIDIA работали сразу «из коробки», без необходимости в дополнительной многочасовой отладке и самостоятельной сборке ПО. В качестве показательного примера SemiAnalysis рассказала о случае, когда Tensorwave, крупнейшему провайдеру облачных вычислений на базе ускорителей AMD, пришлось предоставить целой команде специалистов AMD из разных отделов доступ к оборудованию с её же ускорителями, чтобы те устранили проблемы с софтом. Обучение с использованием FP8 в принципе не было возможно без вмешательства инженеров AMD. Со стороны NVIDIA был выделен только один инженер, за помощью к которому фактически не пришлось обращаться. У AMD есть лишь один выход — вложить значительные средства в разработку и тестирование ПО, считают в SemiAnalysis. Аналитики также предложили выделить тысячи чипов MI300X для автоматизированного тестирования, как это делает NVIDIA, и упростить подготовку окружения, одновременно внедряя лучшие настройки по умолчанию. Проблемы с ПО — основная причина, почему AMD не хотела показывать результаты бенчмарка MLPerf и не давала такой возможности другим. В SemiAnalysis отметили, что AMD предстоит немало сделать, чтобы устранить выявленные проблемы. Без серьёзных улучшений своего ПО AMD рискует еще больше отстать от NVIDIA, готовящей к выпуску чипы Blackwell следующего поколения. Для финальных тестов Instinct использовался специально подготовленный инженерами AMD набор ПО, который станет доступен обычным пользователям лишь через один-два квартала. Речь не идёт о Microsoft или Meta✴, которые самостоятельно пишут ПО для Instinct. Один из автором исследования уже провёл встречу с главой AMD Лизой Су (Lisa Su), которая пообещала приложить все усилия для исправления ситуации. |

|