Лента новостей

|

27.02.2024 [16:56], Сергей Карасёв

«Сбербанк» организовал производство собственных серверов«Сбербанк», по сообщению газеты «Ведомости», запустил производство серверов, адаптированных для применения в собственных ЦОД. Оборудование призвано заменить проприетарные программно-аппаратные комплексы сторонних поставщиков, которые практически полностью выведены из эксплуатации. О технических характеристиках серверов «Сбербанка» информации немного. Известно лишь, что они базируются на x86-процессорах AMD и Intel. Банк намерен подать заявку на включение устройств в реестр отечественной радиоэлектронной продукции Минпромторга. Размер инвестиций в проект не уточняется, но говорится, что сборка серверов осуществляется на территории России. В «Сбербанке» отметили, что инициатива не только «решает задачу технологического суверенитета, но и обеспечивает загрузку производственных мощностей и создание новых рабочих мест». Осведомлённые лица уточняют, что производимое оборудование имеет кастомизированный дизайн, оптимизированный специально под условия дата-центров банка. Таким образом, поставлять эти системы сторонним заказчикам не планируется. Вместе с тем собственные потребности «Сбербанка» в серверах оцениваются в несколько десятков тысяч единиц в год, причём этот объём постоянно растёт на фоне развития новых сервисов. Отмечается, что «Сбербанк» для производства серверов может использовать компетенции компании «Элпитех», которая выпускает оборудование для ЦОД. В конце 2022 года эта фирма была куплена компанией «Салютдевайсы», которая ранее называлась SberDevices. Участники рынка также говорят, что для производства серверов могут быть использованы мощности «КНС групп» (YADRO) в Дубне. При этом два года назад банк раскритиковал серверы на базе процессоров «Эльбрус». Развитие собственного серверного направления поможет «Сбербанку» ускорить процесс импортозамещения. Плюс к этому финансовая организация получит возможность укрепить позиции в сегменте облачных услуг. Объём российского рынка серверов в 2023 году оценивается в 150 млрд руб., а по итогам 2024-го рост может составить ещё около 10 %, отмечают «Ведомости».

27.02.2024 [16:18], Руслан Авдеев

Южная Корея планирует построить ещё один кампус ЦОД ёмкостью 1 ГВтВ Южной Корее готовятся создать крупный кластер ЦОД ёмкостью 1 ГВт — кампус будет построен в провинции Канвондо (Gangwon ). По данным Datacenter Dynamics, площадка расположена близ населённых пунктов Каннын и Донхэ на востоке страны и потенциально сможет вместить до 50 объектов ёмкостью 20 МВт каждый. Это будет уже второй кампус такой ёмкости, строительство которого запланировано в Южной Корее. В прошлом году власти анонсировали создание крупного комплекса, включающего до 25 ЦОД по 45 МВт, в провинции Южная Чолла (South Jeolla). Эти дата-центры будут строиться поэтапно до 2037 года, первая фаза предусматривает возведение пяти объектов и подстанции мощностью 300 МВт к 2027 году.

Источник изображения: Daniel Bernard/unsplash.com Как сообщают отраслевые источники, корейское Министерство торговли, промышленности и энергетики (Ministry of Trade, Industry, and Energy) поддержало проект и поможет использовать энергию, генерируемую кластером электростанций региона. В провинции находятся несколько угольных и атомных электростанций, но у них есть проблемы с транспортировкой энергии на дальние расстояния и другие ограничения. По словам одного из источников, на восточном побережье страны имеются проблемы с малой энергоёмкостью местной инфраструктуры. Прямые продажи близлежащим ЦОД позволят электростанциям экономить около 20 % ежегодных эксплуатационных расходов. К счастью, недавно принятые законы теперь позволяют напрямую продавать энергию местным потребителям. Правительство намерено организовать строительство ЦОД на уже существующих промышленных площадках, а также на неиспользуемой земле. Дополнительно правительство инвестирует в два ЦОД, предназначенных для поддержки разработки ИИ-чипов. Эти дата-центры будут способствовать росту новых отраслей.

27.02.2024 [16:08], Сергей Карасёв

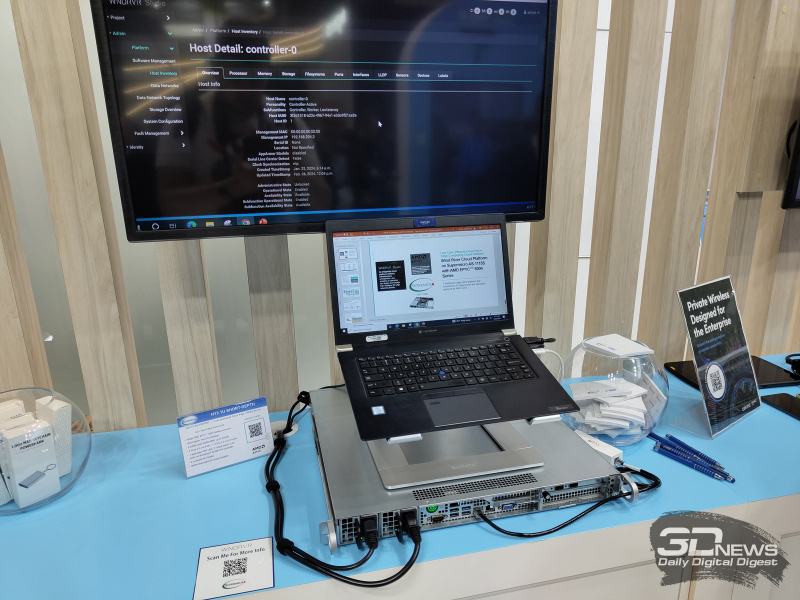

Supermicro анонсировала ИИ- и телеком-серверы на базе AMD EPYC Siena, Intel Xeon Emerald Rapids и NVIDIA Grace Hopper

5g

amd

emerald rapids

epyc

gh200

grace

hardware

intel

mwc 2024

nvidia

siena

supermicro

ии

периферийные вычисления

сервер

Компания Supermicro представила на выставке мобильной индустрии MWC 2024 в Барселоне (Испания) новые серверы для телекоммуникационной отрасли, 5G-инфраструктур, задач ИИ и периферийных вычислений. Дебютировали модели с процессорами AMD EPYC 8004 Siena, Intel Xeon Emerald Rapids и с суперчипами NVIDIA GH200 Grace Hopper. В частности, анонсирована стоечная система ARS-111GL-NHR высокой плотности в форм-факторе 1U на базе GH200. Устройство наделено двумя слотами PCIe 5.0 x16, восемью фронтальными отсеками для накопителей E1.S NVMe и двумя коннекторами для модулей M.2 NVMe. Сервер предназначен для работы с генеративным ИИ и большими языковыми моделями (LLM). На периферийные 5G-платформы ориентировано решение SYS-211E ультрамалой глубины — 298,8 мм. Модель рассчитана на один процессор Xeon Emerald Rapids в исполнении LGA-4677. Есть восемь слотов для модулей DDR5-5600 общей ёмкостью до 2 Тбайт и до шести слотов PCIe 5.0 в различных конфигурациях для карт расширения. Модификация SYS-211E-FRDN13P для сетей Open RAN предлагает 12 портов 25GbE и поддерживает технологию Intel vRAN Boost. Ещё одна новинка — сервер AS-1115S-FWTRT формата 1U с возможностью установки одного процессора EPYC 8004 Siena (до 64 ядер). Реализована поддержка до 576 Гбайт памяти DDR5-4800 (шесть слотов), двух портов 10GbE, двух слотов PCIe 5.0 x16 FHFL и одного слота PCIe 5.0 x16. Решение предназначено для edge-приложений.

Представлены также многоузловая платформа SYS-211SE-31D/A и система высокой плотности SYS-221HE: обе модели выполнены в формате 2U на процессорах Xeon Emerald Rapids. Второй из этих серверов допускает монтаж до трёх двухслотовых ускорителей NVIDIA H100, A10, L40S, A40 или A2. Наконец, анонсирован сервер AS-1115SV типоразмера 1U с поддержкой процессоров EPYC 8004 Siena, 576 Гбайт памяти DDR5, трёх слотов PCIe 5.0 x16 и 10 накопителей SFF.

27.02.2024 [15:58], Андрей Крупин

Платформа серверной виртуализации zVirt получила сертификат ФСТЭК РоссииКомпания Orion soft сообщила о сертификации Федеральной службой по техническому и экспортному контролю защищённой среды виртуализации zVirt по четвёртому уровню доверия. Программный комплекс zVirt построен на базе свободной кроссплатформенной платформы управления виртуализацией oVirt и включает ряд доработок, обеспечивающих стабильность и безопасность, необходимых для размещения бизнес-критичных IT-систем. В продукте реализованы: поддержка SDN (виртуализация сети L2–L4), сбор логов (syslog), интеграция с SIEM-системами, ручное и автоматическое (по расписанию) резервное копирование БД менеджера управления, диаграмма виртуальной инфраструктуры, а также средства репликации виртуальных машин и диагностики. По заверениям компании Orion soft, zVirt покрывает 95 % функциональности VMware vSphere Enterprise Plus и vCenter.  Выданный ФСТЭК России сертификат допускает использование zVirt для защиты информации в государственных информационных системах до 1 класса защищённости включительно, в автоматизированных системах управления производственными и технологическими процессами до 1 класса защищённости включительно, в информационных системах персональных данных до 1 уровня защищённости включительно, в значимых объектах критической информационной инфраструктуры до 1 категории включительно. Продукт может применяться в государственных организациях и ведомствах, финансовом секторе, топливно-энергетическом комплексе, атомной и горнодобывающей промышленности и других стратегических отраслях. В соответствии с новыми требованиями ФСТЭК № 187, в сертифицированной редакции zVirt реализованы модуль доверенной загрузки виртуальных машин, контроль целостности, регистрация событий безопасности и управление доступом. Также были усилены функции резервного копирования, управления потоками информации и защиты памяти, введена идентификация пользователей и установлены ограничения программной среды. Отдельное внимание было уделено мерам защиты централизованного управления образами виртуальных машин.

27.02.2024 [15:30], Руслан Авдеев

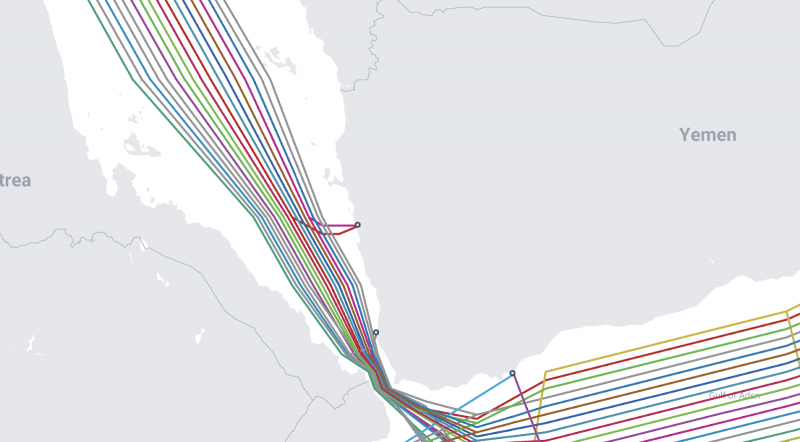

Как минимум один подводный интернет-кабель повреждён в Красном мореПо данным многочисленных источников, несколько подводных кабелей, вероятно, повреждены в Красном море у побережья Йемена. Datacenter Dynamics сообщает, что ряд СМИ уже возложил вину на йеменские хуситские силы. На ремонт, как считается, может уйти до восьми недель. О возможности проблем такого рода эксперты начали говорить ещё в конце прошлого года. Один из операторов кабелей подтвердил нарушение инфраструктуры в регионе, но отказался называть точную причину произошедшего. По данным СМИ, повреждения получили сразу четыре кабеля: AAE-1, Seacom, Europe India Gateway (EIG) и TGN. Правда, Seacom и TGN фактически представляют собой единую кабельную систему, операторами которой выступают Seacom и Tata Communications. NetBlocks подтвердила перебои с интернетом в Джибути (на противоположном от Йемена берегу), где сходятся множество подводных кабелей. Seacom также подтвердила проблемы в системе Seacom/TGN, но воздержалась от обвинений какой-либо из сторон. Предполагается, что пострадал сегмент, ведущий из Момбасы (Кения) в Зафарану (Египет). Сейчас компания пытается оценить возможность ремонта в регионе. В компании подтвердили, что место обрыва имеет важное значение из-за обстановки в регионе — операции по обслуживанию и ремонту здесь сейчас затруднены. В Seacom утверждают, что трафик, предназначавшийся для Европы и других регионов, был автоматически перенаправлен другими маршрутами — по кабельным системам Equiano (фактически в обход Африки), PEACE и WACS. Большую роль играет наличие и наземной инфраструктур. Сервисы клиентам будут предоставляться, но возможно увеличение задержек. По словам некоторых экспертов, судовладельцы, располагающие оборудованием для укладки кабелей, не горят желанием заниматься ремонтом в зоне конфликта. Страховые компании тоже вряд ли согласятся обслуживать корабли, которые попытаются работать в йеменских водах. Кроме того, специализированных судов мало и все они забронированы на месяцы вперёд. На сегодня Азию с Европой через Красное море связывают 17 кабельных систем разной степени готовности. Как и Суэцкий канал в Египте, Баб-эль-Мандебский пролив является «бутылочным горлышком» между Ближним Востоком и Африкой. В районе Красного моря средняя глубина составляет около 490 м, а на некоторых участках — и вовсе 100 м. Другими словами, повредить кабели могут даже слабо оснащённые участники регионального конфликта.

27.02.2024 [13:37], Сергей Карасёв

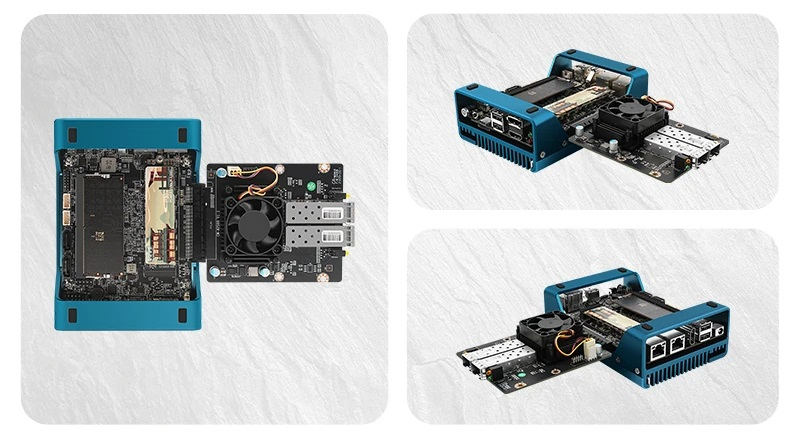

Необычный одноплатный компьютер CWWK Magic Computer на базе Intel Alder Lake-N оснащён слотом PCIe x8Китайская компания CWWK, по сообщению ресурса Liliputing, анонсировала необычный компактный компьютер Magic Computer, на основе которого могут создаваться различные сетевые устройства, оборудование для Интернета вещей, системы хранения и пр. В основу положена аппаратная платформа Intel Alder Lake-N. Изделие имеет оригинальное исполнение. По сути, это одноплатный компьютер, который закреплен в нижней области радиатора охлаждения, одновременно выполняющего функции подставки. Такая конструкция повышает эффективность отвода тепла, но оставляет саму плату незащищённой от внешних воздействий. Доступны модификации с разными процессорами Alder Lake-N, а максимальная конфигурация включает чип Core i3-N305 (8 ядер; 8 потоков; до 3,8 ГГц; 15 Вт). Объём оперативной памяти DDR5-4800/5200/5600 может достигать 32 Гбайт (один слот SO-DIMM). Есть коннектор M.2 (PCIe 3.0 x1) для накопителя формата 2242/2280 (NVMe), два порта SATA-3 и слот microSD. Кроме того, присутствует разъём PCIe x8 (PCIe 3.0 x4) для подключения различных карт расширения, например, сетевого адаптера.

Источник изображения: AliExpress/CWWK Store Устройство располагает двумя коннекторами HDMI 1.4, интерфейсами DisplayPort 1.4 и USB Type-C (DisplayPort Alt mode), двумя сетевыми портами 2.5GbE RJ-45 на базе Intel i226-V, четырьмя портами USB 2.0. Через разъёмы на плате можно задействовать дополнительные интерфейсы, включая последовательный порт. Питание (12–19 В) подаётся через DC-разъём (5,5/2,5 мм) или 4-контактный коннектор. Габариты мини-компьютера составляют 144 × 100 × 48 мм. Диапазон рабочих температур — от 0 до +70 °C. Цена начинается с $214 за barebone-систему и достигает $520 за вариант с 32 Гбайт ОЗУ и SSD вместимостью 2 Тбайт.

27.02.2024 [13:25], Сергей Карасёв

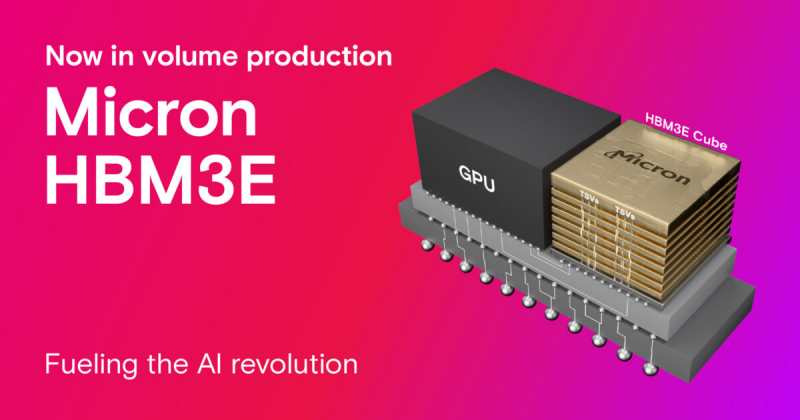

Micron начала массовое производство памяти HBM3E для ускорителей NVIDIA H200Компания Micron Technology объявила о начале массового производства передовой памяти HBM3E. Речь идёт об изделиях ёмкостью 24 Гбайт, предназначенных для ИИ-ускорителей NVIDIA H200, которые появятся на коммерческом рынке во II квартале нынешнего года. Чипы Micron HBM3E выполнены в виде 8-ярусного стека. Заявленная скорость передачи данных превышает 9,2 Гбит/с на контакт, а общая пропускную способность сборки превосходит 1,2 Тбайт/с. Вместе с тем, как утверждается, изделия потребляют примерно на 30 % меньше энергии по сравнению с решениями конкурентов. Micron подчёркивает, что чипы HBM3E объёмом 24 Гбайт позволяют дата-центрам беспрепятственно масштабировать различные ИИ-нагрузки — от обучения сложных нейронных сетей до ускорения инференса. Изделия выполнены по технологии 1β (1-бета) — самому передовому техпроцессу компании. Кроме того, применены другие современные методики упаковки чипов, включая усовершенствованную технологию сквозных соединений TSV (Through-Silicon Via). Micron также сообщила, что уже в марте нынешнего года начнёт распространять образцы 12-ярусных чипов HBM3E ёмкостью 36 Гбайт. Они, как и изделия на 24 Гбайт, обеспечат пропускную способность свыше 1,2 Тбайт/с при высокой энергетической эффективности.

27.02.2024 [13:24], Сергей Карасёв

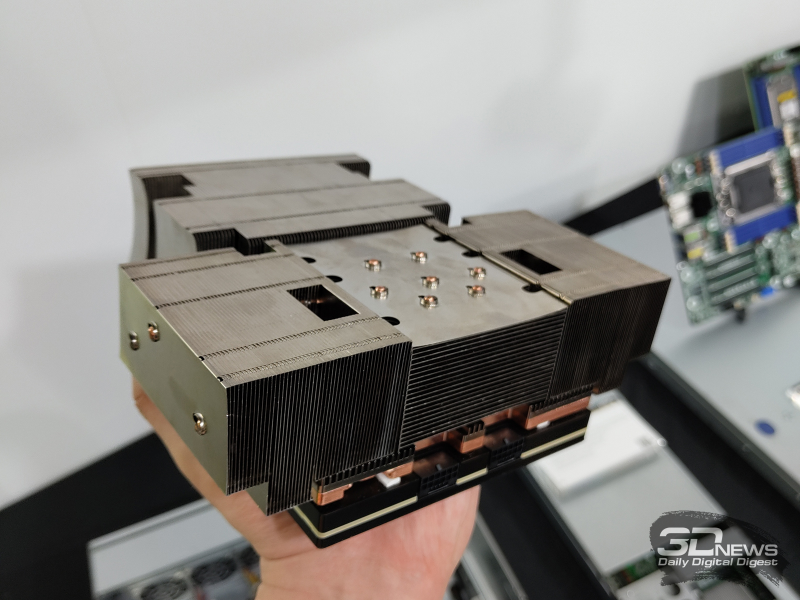

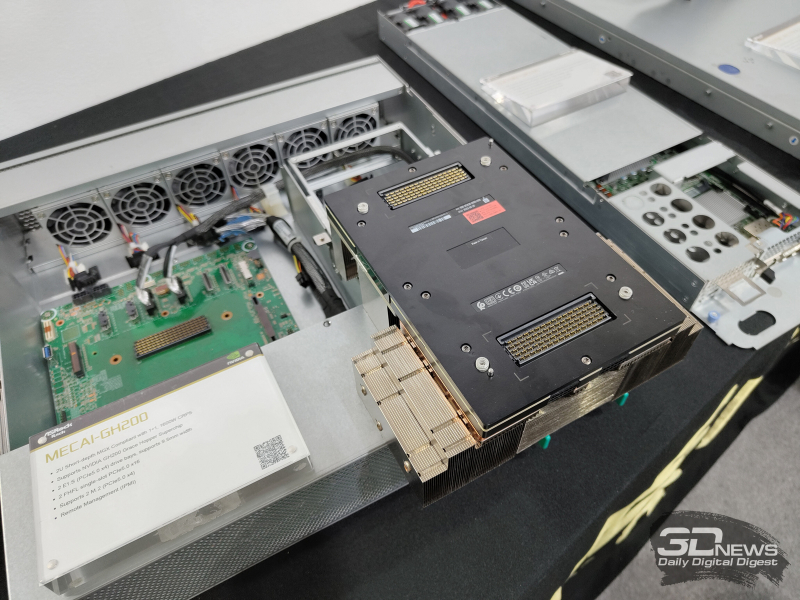

ASRock Rack представила MECAI-GH200 — самый компактный в мире сервер с суперчипом NVIDIA GH200Компания ASRock Rack продемонстрировала сервер MECAI-GH200: это, как утверждается, самая компактная в мире система, оснащённая гибридным суперчипом NVIDIA GH200 Grace Hopper с 72-ядерным Arm-процессором NVIDIA Grace и ускорителем NVIDIA H100 с 96 Гбайт памяти HBM3. Новинка выполнена в 2U-корпусе небольшой глубины. Доступны два посадочных места для накопителей формата E1.S (PCIe 5.0 х4), два коннектора для модулей М.2 (PCIe 5.0 х4) и два слота для карт расширения FHFL с интерфейсом PCIe 5.0 х16. Питание обеспечивают два блока мощностью 1600 Вт. Глубина MECAI-GH200 составляет 450 мм. Сервер предназначен для решения ИИ-задач на периферии. Прочие характеристики сервера пока не раскрываются. «В ASRock Rack мы стремимся обеспечить возможность повсеместного использования ИИ. Для достижения этой цели мы создаём надёжные серверные решения в различных форм-факторах и для различных сценариев», — говорит вице-президент компании Хантер Чен (Hunter Chen). ASRock Rack также представила на выставке MWC 2024 новые barebone-системы и материнские платы для процессоров Intel, AMD и Ampere. Например, впервые демонстрируется плата SIENAD8UD-2L2Q с поддержкой чипов AMD EPYC 8004 Siena и двумя сетевыми портами 25GbE SFP28.

27.02.2024 [00:29], Владимир Мироненко

Broadcom продаст инвесткомпании KKR подразделение VMware EUC за $3,8 млрдПосле приобретения в ноябре 2023 года за $69 млрд VMware компания Broadcom приступила к оптимизации её бизнес-модели и имеющихся активов, скорректировав портфель предложений и установив новые правила работы с OEM-партнёрами VMware. Одним из последних шагов нового владельца станет продажа подразделения VMware EUC (end-user computing) частной инвестиционной компании KKR & Co Inc. за $3,8 млрд. О планах продать EUC компания заявила сразу после закрытия сделки по приобретению VMware. Ещё один актив VMware, который Broadcom намерена продать — подразделение по обеспечению безопасности Carbon Black. KKR сообщила в понедельник, что EUC будет работать как отдельная компания и по-прежнему будет управляться существующей командой во главе с Шанкаром Айером (Shankar Iyer). Как отметил ресурс SiliconANGLE, EUC может дополнить имеющуюся у KKR компанию Alludo (ранее Corel), разработчика ПО для виртуализации Parallels. За свою историю KKR заключила более 60 сделок по приобретению активов компаний, среди которых немало технологических. Какие конкретно продукты EUC перейдут новому владельцу, не уточняется, но среди них наверняка будут решения для VDI. Что касается Broadcom, то в ноябре прошлого года она объявила о планах удвоить в течение следующих трёх лет прибыль VMware. В соответствии с этим планом Broadcom объявила, что в рамках реструктуризации VMware сформирует четыре подразделения, каждое из которых будет отвечать за разные подгруппы продуктов. Затем в декабре стало известно, что более 2000 сотрудников будут уволены в рамках плана по повышению прибыльности компании.

26.02.2024 [23:34], Владимир Мироненко

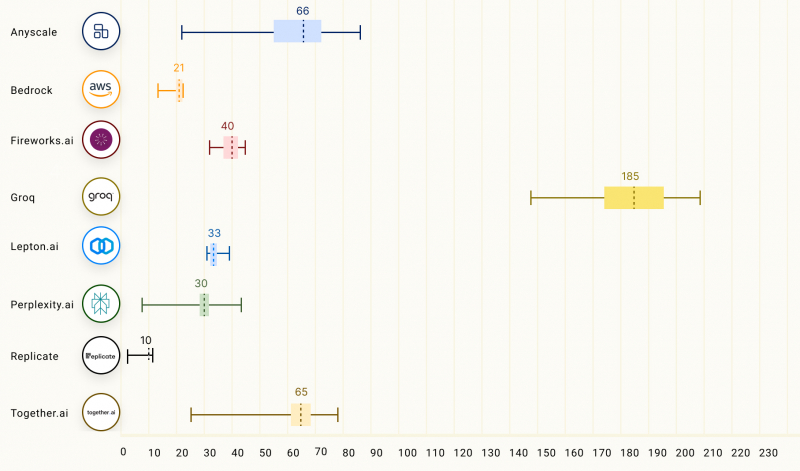

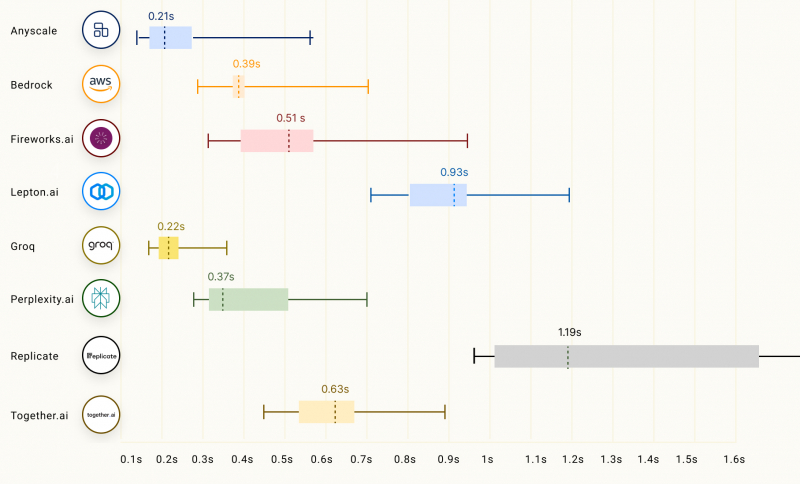

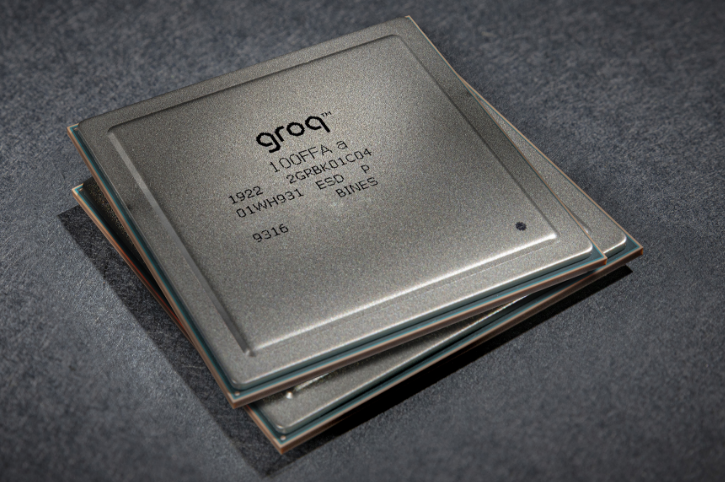

Groq LPU способен успешно конкурировать с ускорителями NVIDIA, AMD и IntelСтартап Groq сообщил о значительных достижениях в области инференса с использованием ускорителя LPU, разработанного для запуска больших языковых моделей (LLM), таких как GPT, Llama и Mistral. Groq LPU имеет один массивно-параллельный тензорный процессор TSP, который обеспечивает производительность до 750 TOPS INT8 и до 188 Тфлопс FP16. LPU Groq оснащён локальной SRAM объемом 230 Мбайт с пропускной способностью 80 Тбайт/с. Как сообщает компания, при запуске модели Mixtral 8x7B ускоритель LPU обеспечил скорость инференса 480 токенов в секунду, что является одним из ведущих показателей инференса в отрасли. В таких моделях, как Llama 2 70B с длиной контекста 4096 токенов, Groq может обеспечить скорость инференса 300 токенов/с, тогда как в меньшей модели Llama 2 7B с 2048 токенами контекста скорость инференса составляет 750 токенов/с.

Изображение: Groq Согласно рейтингу бенчмарка LLMPerf, LPU Groq превосходит результаты систем облачных провайдеров на базе традиционных ИИ-ускорителей в деле запуска LLM Llama в конфигурациях от 7 до 70 млрд параметров. Groq лидирует по скорости инференса и занимает второе место по показателю задержки. Для сравнения, бесплатный чат-бот ChatGPT на базе GPT-3.5 обеспечивает обработку около 40 токенов/с. Текущие LLM с открытым исходным кодом, такие как Mixtral 8x7B, могут превосходить GPT 3.5 в большинстве тестов, и теперь могут работать со скоростью почти 500 токенов/с. Опубликованные данные наглядно подтверждают, что предлагаемый Groq ускоритель LPU Groq значительно превосходит системы для инференса, предлагаемые NVIDIA, AMD и Intel, говорит компания. Groq не раскрывает имена своих заказчиков, но в настоящее время её ИИ-решения используются, например, Аргоннской национальной лабораторией Министерства энергетики США. |

|