Материалы по тегу: цод

|

28.07.2022 [18:12], Руслан Авдеев

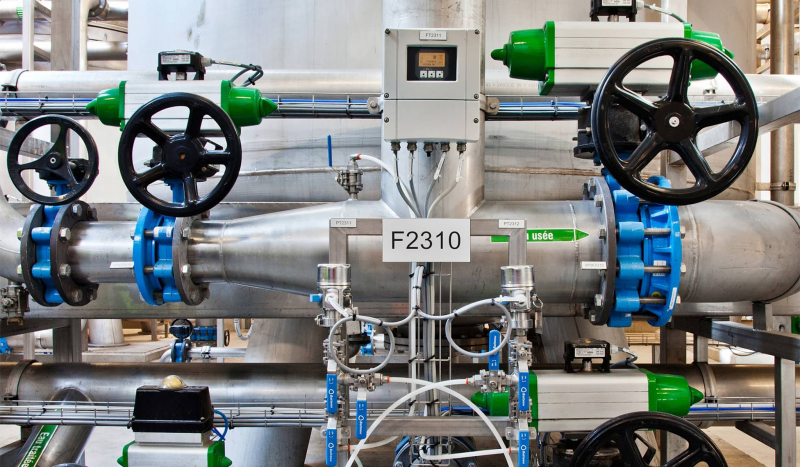

Европейские дата-центры хотят снизить потребление воды до 400 мл/кВт·ч, но только к 2040 годуГруппа Climate Neutral Data Centre Pact (CNDCP), объединяющая 90 % европейских операторов ЦОД, предложила добровольно снизить потребление воды до 400 мл на 1 кВт·ч к 2040 году и добиться углеродной нейтральности намного раньше 2050 года. Соответствующая цель уже поставлена ЕС, но операторы намерены добиваться её без законодательного принуждения и с опережением графика, — сообщает Data Center Dynamics. Хотя использование воды способно оказать значительное влияние на экологию, этот фактор часто недооценивают, учитывая только расход энергии. При этом многие ЦОД активно используют воду для охлаждения оборудования, благодаря чему снижается расход всё той же энергии, но растут затраты самой жидкости, что имеет критическое значение для некоторых регионов. Группу CNDCP сформировали в 2021 году с намерением достичь углеродной нейтральности европейских ЦОД к 2030 году, а также обеспечить достойный ответ прочим экологическим вызовам, в том числе снизить расход воды. Для оценки эффективности использования воды используется коэффициент WUE, который отражает расход воды на каждый затраченный киловатт·час электричества. Например, исследование 2016 года показало, что на тот момент WUE для ЦОД в США составлял в среднем 1,8 л/кВт·ч.

Источник изображения: Christian Lue/unsplash.com Цели поставлены с учётом жизненного цикла уже действующих систем охлаждения, поскольку их немедленная массовая замена может принести больше вреда, чем пользы из-за ущерба экологии в процессе производства самих систем. Поэтому в CNDCP заявили, что все 74 оператора ЦОД, участвовавшие в заключении пакта, добьются потребления не более 400 мл/кВт·ч только к 2040 году. Такой показатель вывели с учётом разницы технологий, климатических и иных условий, характерных для тех или иных ЦОД. Отдельные участники рынка уже заявили о намерении добиться положительного водного баланса для своих дата-центров — ЦОД будут отдавать больше чистой воды, чем потреблять. Так, Meta✴ и Microsoft планируют добиться этой цели к 2030 году. Последняя также начала устанавливать станции для очистки сточных вод ЦОД. А вот Google отметилась тем, что пыталась всеми возможными способами скрыть расход воды своими дата-центрами даже от властей. Помимо ограничения расхода воды, подписанты CNDCP предложили ввести и другие цели для дата-центров. Например, уже сформированы две рабочие группы для подготовки к переходу на «циркулярную экономику» со вторичным использованием материалов и переработкой различных ресурсов. В частном порядке аналогичную инициативу уже несколько лет развивает Microsoft в рамках проекта Circular Center.

27.07.2022 [17:11], Руслан Авдеев

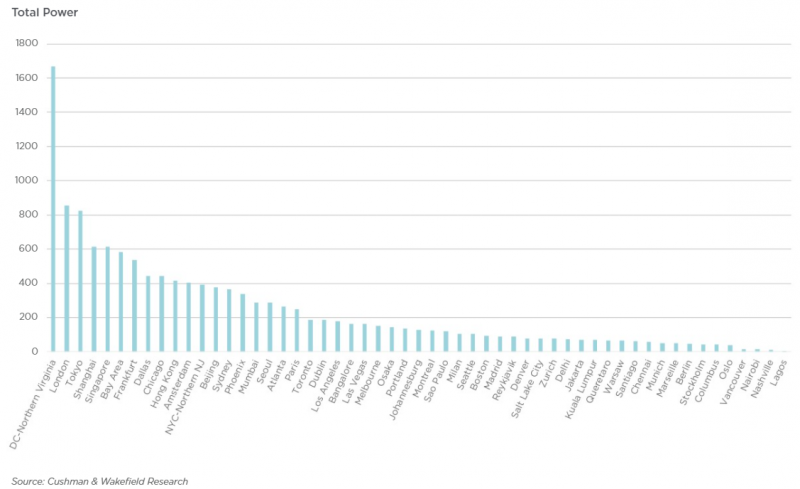

Жители Северной Вирджинии ополчились против крупных дата-центровЖители Северной Вирджинии всё более и более недовольны распространению дата-центров гиперскейл-класса и готовы активно противостоять их строительству. По данным DataCenter Dynamics, вслед за жителями округа Принс-Уильям (Prince William), жалующихся на невыносимый уровень шума ЦОД Amazon, обитатели округа Фокир (Fauquier) потребовали от властей запретить строительство дата-центра той же компании, которая за последний десяток лет вложила в местные ЦОД более $35 млрд. Примечательно, что Северная Вирджиния десятилетиями является едва ли не крупнейшим хабом для строительства дата-центров в мире, последовательно привлекающим новые компании, объекты и инвестиции. Изначально ЦОД концентрировались преимущественно в округе Лаудон, а теперь распространяются на территорию округов Калпепер (Culpeper), Фокир и Принс-Уильям, жители которых начали вести организованную борьбу с инициативами IT-гигантов и местных властей. В наиболее «пострадавшем» округе Лаудон предложили новые правила зонирования для дата-центров, определяющих, где будущие ЦОД можно строить так, чтобы не побеспокоить местных жителей. Кроме того, предложено пересмотреть экологические стандарты строительства и допустимого уровня шума. Ожидается, что в определённых местах будет прекращено и одобрение строительства ЦОД в ускоренном порядке. Жители округа Калпепер подали в суд, требуя аннулировать разрешение на перезонирование и развитие ЦОД Amazon. В округе Фокир Amazon уже купила более 16 га земли, подала заявку на строительство нового дата-центра и договорилась с местной энергосбытовой компанией Dominion Energy. Изначально местные жители протестовали против строительства 230-кВ линий электропередач над их домами, но потом поняли, что они вообще не понадобятся, если дата-центра не будет. Местных жителей беспокоит не только экология и комфортность окружающей среды, но и экономика — скупка земли для ЦОД поднимает её цены. Кроме того, всё чаще задаётся вопрос, почему налоги для жителей не падают по мере развития дата-центров. О полном отказе от ЦОД речь не идёт, поскольку они обеспечивают около трети местных налоговых поступлений.

21.07.2022 [17:27], Руслан Авдеев

Жители Северной Вирджинии жалуются на «катастрофический шум» от дата-центровКак сообщает портал Data Center Dynamics, домовладельцы и гражданские активисты округа Принс-Уильям (Prince William County) в Северной Вирджинии (США), пожаловались на «катастрофический» шум, издаваемый местными ЦОД. Шум доносится из принадлежащих Amazon дата-центров, расположенных на территории кампуса Tanner Way. Сейчас техногигант ведёт строительство в городе Манассасе, но речь идёт не о шуме стройки. По словам активистов, непрекращающийся шум вызван работой систем воздушного охлаждения на крышах ЦОД, создающих неблагоприятную среду обитания для жильцов района Great Oak, состоящего из 291 домохозяйства.

Источник изображения: Elyas Pasban/unsplash.com Круглый стол ассоциации домовладельцев округа совместно с ассоциацией города Манассас направили жёсткую жалобу в Наблюдательный совет округа, сообщив о «чрезвычайном промышленном шуме», продолжающемся круглосуточно и без выходных, никаких мер по устранению которого не принимается. По словам местных активистов, шум загрязняет окрестности непрерывно, чему есть аудио- и видеодоказательства. От наблюдательного совета требуют найти решение проблемы. Активисты напоминают о прецедентах — аналогичные жалобы в Аризоне в 2018 году привели к прекращению развития ЦОД в регионе решением местных властей. По данным активистов, пока руководство совета не смогло напрямую решить проблему с ЦОД, и теперь жители требуют приостановки разрешений на работу дата-центров в округе Принс-Уильям до тех пор, пока проблема не будет устранена. Основная беда в том, что Наблюдательный совет округа намеренно исключил шум от промышленных кондиционеров из правил 1989 года, в соответствии с которыми и строились дата-центры, в результате чего округ потерял законную возможность контролировать работу ЦОД в этом отношении, независимо от того, какой громкости звук издают объекты. Местные жители жалуются на проблемы как с собственным здоровьем, так и с состоянием домашних питомцев. Благодаря местным регуляциям Северная Вирджиния крайне привлекательна для строителей и операторов дата-центров. Текущая ёмкость ЦОД в штате составляет порядка 1,7 ГВт, а через два года, как ожидается, она достигнет 2 ГВт. И это самый крупный в мире рынок ЦОД. Для сравнения — суммарная ёмкость сразу четырёх европейских рынков FLAP только-только добралась до 2 ГВт. Та же Amazon за последний десяток лет вложила в постройку дата-центров в Северной Вирджинии более $35 млрд.

20.07.2022 [15:56], Владимир Мироненко

Аномальная жара привела к сбоям в лондонских дата-центрах Google и Oracle

google cloud platform

hardware

oracle cloud infrastructure

великобритания

облако

охлаждение

сбой

цод

Во вторник, 19 июля, в ЦОД Google Cloud Platform (GCP) в Лондоне произошёл сбой в системе охлаждения, в связи с чем несколько сервисов компании временно вышло из строя. В лондонском регионе облака Oracle тоже возникли проблемы с охлаждением оборудования ЦОД. Сбои произошли из-за рекордной жары в Великобритании — температура превысила +40°C. Некоторые операторы дата-центров были вынуждены принять нестандартные меры, начав обрызгивать водой внешние модули систем кондиционирования, установленные на крыше. Отключение ряда сервисов Google произошло в 18:13 по местному времени (20:13 мск). В журнале статуса оборудования сбой описан как «связанный с охлаждением». Google заявила, что сбой затронул лишь небольшое количество клиентов. В частности, отключение коснулось сервисов Persistent Disk и Autoscaling. Хотя Google утверждает, что сбой продолжался до 22:00 BST (24:00 мск), в означенное время всё ещё поступали жалобы на ошибки в работе Persistent Disk. С подобными проблемами в Лондоне столкнулась и облачная служба Oracle. Проблемы с перегревом у неё начались примерно в 17:00 по местному времени (19:00 мск). Oracle ранее арендовала ресурсы в ЦОД Equinix в лондонском кампусе Слау, но сейчас не раскрывает местонахождение своих мощностей. «В результате несезонных температур в регионе возникла проблема с частью инфраструктуры охлаждения в центре обработки данных на юге Великобритании (в Лондоне), — говорится в сообщении компании. — Это привело к тому, что часть нашей сервисной инфраструктуры пришлось отключить, чтобы предотвратить неконтролируемые сбои оборудования».

20.07.2022 [00:56], Владимир Мироненко

Из-за жары лондонские дата-центры вынуждены охлаждать оборудование на крыше, поливая его водой из шланговВ этом году в Великобритании наблюдается аномальная жара. 19 июля температура воздуха в стране установила новый рекорд, превысив 40° С. Как сообщает Bloomberg, в некоторых британских ЦОД выбрали оригинальный способ борьбы с перегревом оборудования, используя обрызгивание водой внешних модулей систем кондиционирования, установленных на крыше. По словам Адриана Тревельяна (Adrian Trevelyan), директора по послепродажному обслуживанию компании Airedale International, которая поставляет и обслуживает системы охлаждения для ЦОД, многие лондонские дата-центры вынуждены прибегнуть к такому необычному способу охлаждения. Небольшие ЦОД в густонаселённых городских районах, работающие почти на полную мощность, просто требуют экстренного орошения во время жары. Тревельян сообщил, что орошение позволяет снизить температуру воздуха вокруг змеевиков внешнего контура охлаждения, чтобы они продолжали эффективно рассеивать тепло. Он отказался назвать конкретные компании, применяющие такой способ охлаждения, но сказал, что это делают «в пределах (кольцевой автомагистрали) M25 и в городе». Однако от жары страдают не только малые, но и крупные дата-центры, которые всё же имеют запас по охлаждению ключевых подсистем — 10 июля в лондонском ЦОД AWS произошёл перебой питания из-за так называемого «теплового события» (thermal event). Использование полива шлангами может выручить в очень жаркий день, но негативно отразится на сроке службы оборудования, сообщила София Флюкер (Sophia Flucker), директор консалтинговой фирмы Operational Intelligence, отметив, что если используется вода повышенной жёсткости (как в Лондоне), это может привести к накоплению накипи. Флюкер также рассказала, что многие операторы колокации, сдающие мощности в аренду третьим лицам, сталкиваются со штрафами за несоблюдение температурного режима в машинных залах.

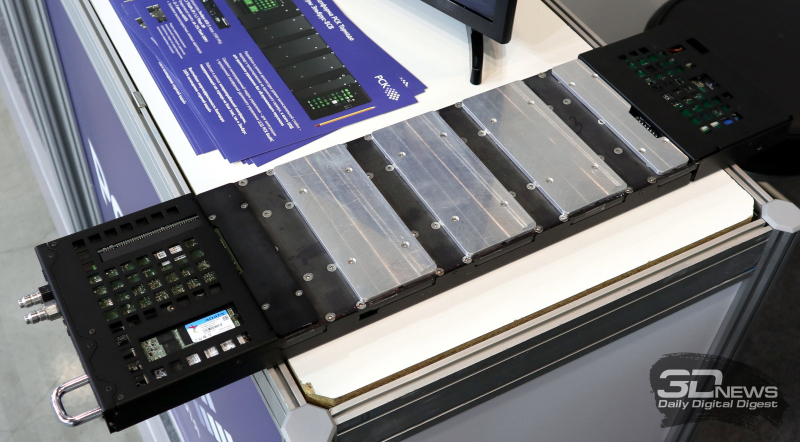

12.07.2022 [00:28], Игорь Осколков

Суперкомпьютер в дорогу: РСК показала на Иннопроме обновлённый мобильный ЦОДГруппа компаний РСК, ведущий российский разработчик суперкомпьютеров и систем для высокопроизводительных вычислений (HPC), дата-центров, облачных платформ и систем хранения данных (СХД) показала на выставке Иннопром-2022 обновлённую версию своей платформы для автономных периферийных вычислений, которая позволяет оперативно, в течение часа силами двух человек, развернуть HPC-кластер практически в любом месте. Решение упаковано в несколько контейнеров (0,7 × 0,7 × 1,1 м), которые можно транспортировать независимо друг от друга и собирать уже на месте. Один контейнер вмещает собственно вычислительную часть, второй — полностью интегрированный модуль распределения теплоносителя с узлом управления, а третий, опциональный — ИБП с инвертором. Дополняет их компактный внешний модуль охлаждения. Вся система имеет весьма солидный запас по возможности отвода тепла — до 60 кВт. Правда, сейчас столько и не требуется. Вычислительный блок фактически является уменьшенной копией платформы «РСК Торнадо»: 2 колонны по 10 слотов. Поэтому мобильная платформа позволяет совмещать в одной системе серверы «Торнадо» с процессорами x86-64 (AMD EPYC и Intel Xeon) и «Эльбрус» (сейчас 8С/8СВ, в перспективе 16С) с любым уровнем TDP, GPGPU-серверы (по два PCIe-ускорителя на сервер, без ограничений по TDP) и серверы хранения (до 12 × M.2 All-Flash). В текущем варианте платформы каждый слот рассчитан на 2 кВт тепловой нагрузки (и столько же по питанию), хотя нынешние серверы укладываются в среднем в 700–800 Вт, а серверы следующего поколения потребуют чуть больше 1 кВт. Подсистема питания имеет два домена, по одному на колонну, и требует однофазный ввод AC 230 В/50 Гц, хотя фактически может работать в диапазоне 105–280 В. Запитать систему можно от генератора, а подстраховать — ИБП. Но возможно и специсполнение с поддержкой 48 В DC. Сетевая подсистема может быть представлена ToR-коммутаторами как двойной (на обе колонны) ширины, так и одиночной. В том числе есть варианты с жидкостным охлаждением. Доступен даже InfiniBand — у Mellanox есть коммутаторы в подходящем форм-факторе, рассчитанные на промышленное применение. Также предоставляется 1 GbE-коммутатор для развёртывания служебной сети. Самая интересная часть — это охлаждение. Как и в «большой» версии платформы здесь используется фирменная СЖО, которая покрывает все компоненты серверов, так что вычислительная часть не требует активного воздушного охлаждения и способна работать даже с закрытыми крышками контейнера. Защиты по какому-либо классу IP в стандартном варианте не предусмотрено, но опять-таки по заказу возможно специсполнение. СЖО всё так же поддерживает охлаждение горячей водой, причём на всех компонентах температура не превышает +45 °C. Для запуска вычислительного модуля необходимо, чтобы он находился в помещении с плюсовой температурой и чтобы не было образования конденсата. А вот внешний контур охлаждения менее прихотлив и способен работать при температурах от -65 °C. Верхний же предел — не менее +40 °C. Требования по питанию у него те же, что и у серверов. Узел управления автоматически отслеживает и регулирует параметры всех компонентов системы во время запуска и работы. По умолчанию используется сценарий защиты оборудования, так что при неблагоприятных условиях серверы могут выключаться. Но возможны и другие сценарии, например, «работа до последнего», когда потеря данных оказывается дороже потери оборудования. Управляется мобильная платформа фирменной системой оркестрации «РСК БазИС», которая позволяет задействовать все возможности компонуемой, программно определяемой инфраструктуры, в том числе для реализации HCI-платформы. «РСК БазИС» предлагает GUI, CLI, открытые API и SDK для интеграции с другими приложениями. Таким образом, заказчик получает полностью интегрированное программно-аппаратное решение, готовое к быстрому развёртыванию и использованию. Изначально платформа создавалась для нужд добывающего сектора, но этой сферой её возможности не ограничиваются. Она также подходит для научных экспедиций и промышленных предприятий (срочная обработка больших массивов данных), медиасферы и обслуживания массовых мероприятий (рендеринг, стриминг с множества камер) и т.д. В общем, везде, где на время требуется действительно мощная, но компактная и удобная в доставке, развёртывании и эксплуатации вычислительная платформа.

17.06.2022 [17:04], Руслан Авдеев

Отголоски Brexit: фондовая биржа Euronext переехала из британского ЦОД в итальянскийФондовая биржа Euronext завершила проект по переносу своего дата-центра из британского Базилдона в кампус IT3 компании Aruba Global Cloud, расположенный в итальянском Бергамо. Миграция планировалась не первый год в связи с несколькими факторами, включая покупку итальянской Borsa Italiana Group, а также Brexit. Компания заявила о наличии «веских оснований» разместить основной дата-центр в стране, где у Euronext имеется большой бизнес. В частности, руководство биржи говорит о предсказуемой нормативной среде — после Brexit перспективы правовых отношений между Великобританией и ЕС остаются неясными. По словам руководства Euronext, миграция мощностей в Италию через год с небольшим после закрытия сделки по приобретению итальянской фондовой биржи Borsa Italiana Group является важной вехой в переносе инфраструктуры на территорию Евросоза. В 2011 году Euronext перенесла ЦОД из Парижа в Лондон, но после приняла решение уйти из Великобритании. Теперь главный ЦОД компании обслуживает 25 % объёмов общеевропейских торгов. Общая площадь дата-центра в Бергамо составит 200 тыс. м2, мощность — 60 МВт. По данным Euronext, новый дата-центр будет полностью запитан от возобновляемых источников, так что будут задествованые солнечная и гидроэнергетика, а также геотермальные источники. В ЦОД используется система динамического естественного охлаждения.

13.06.2022 [16:34], Руслан Авдеев

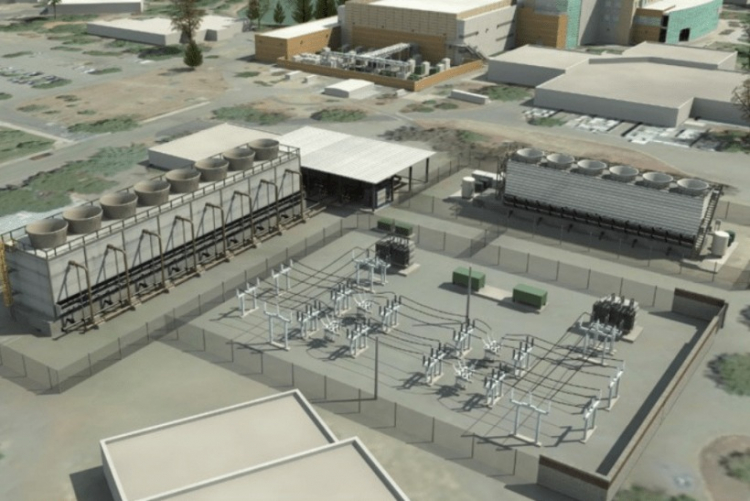

Площадка для будущего 2-Эфлопс суперкомпьютера El Capitan готова: 85 МВт + мощная система охлажденияНациональное управление ядерной безопасности (NNSA) при Министерстве энергетики США официально закончило реконструкцию ЦОД при Ливерморской национальной лаборатории (LLNL) в рамках проекта Exascale Computing Facility Modernization. Обновлены энергетическая система и система охлаждения местного вычислительного центра для использования вычислительных мощностей экзафлопсного уровня. Первой новой действующей системой NNSA станет 2-Эфлопс суперкомпьютер El Capitan, предназначенный для выполнения задач Ливерморской лаборатории, Лос-Аламосской национальной лаборатории и Сандийской национальной лаборатории. По словам представителя NNSA, экзафлопсные вычисления помогут стране в важных, неотложных проектах модернизации вооружений.

Источник изображения: Department of Energy Обновление позволит Ливерморской лаборатории выполнять ресурсоёмкие задачи, 3D-моделирование и симуляцию процессов, связанных с реализацией военных проектов — это необходимо для того, чтобы соответствовать требованиям к сертификации Программы сопровождения ядерного арсенала, реализуемой под эгидой NNSA, основной миссией которой декларируется расширение возможностей американских средств ядерного сдерживания. Сейчас стадия обновления ЦОД завершена и намечен переход к следующим этапам. В результате реализации проекта более, чем удвоилась охлаждающая мощность объекта — теперь он способен ежедневно поглощать количество тепла, достаточного для того, чтобы растопить 28 тыс. тонн льда. Энергетическая мощность ЦОД увеличена с 45 до 85 МВт, а в процессе строительства были обновили линии электропередач, подстанции и управляющее оборудование. Ожидается, что итоговая производительность El Capitan составит более 2 Эфлопс, а потреблять он будет порядка 30–35 МВт. Проработать он должен до 2029 года, однако параллельно будет строиться ещё один суперкомпьютер нового поколения. Некоторые предполагают, что подобные площадки станут последними в своём роде, в первую очередь из-за проблем с электропитанием.

24.05.2022 [14:09], Андрей Крупин

Selectel приступила к строительству в Москве нового 20-МВт дата-центра на 2 тыс. стоекКомпания Selectel, являющаяся специализированным поставщиком IT-решений на базе собственной сети дата-центров в Москве, Санкт-Петербурге и Ленинградской области, планирует ввести в эксплуатацию ещё один вычислительный комплекс. Новый центр обработки данных под названием «Юрловский» будет развёрнут в Москве и рассчитан на 2 тыс. серверных стоек. Дата-центр проектируется в соответствии с уровнем надёжности Tier IV. Основная ёмкость центра обработки данных будет задействована для предоставления облачных сервисов Infrastructure as a Service (IaaS). Особенностью ЦОД станет самый большой единый машинный зал в России площадью 4500 м2, в котором компания планирует разместить до 80 тыс. серверов. Общая подведённая мощность объекта составит 20 МВт, средняя мощность на стойку — 8 кВт. Selectel уже получила технические условия на подключение к ближайшему питающему центру с верхним уровнем напряжения 500 кВ, который расположен в 700 м от кампуса. Подключение будет выполнено по второй категории надёжности, то есть будет проложено две линии от независимых ячеек на подстанции, а между ними на стороне подстанции будет организован автоматический ввод резерва. Дата-центр «Юрловский» будет построен с применением технологии охлаждения без использования фреоновых систем, что позволит минимизировать воздействие на окружающую среду. ЦОД будет охлаждаться наружным воздухом (технология фрикулинга), а в качестве доохлаждения будут использоваться адиабатические маты. Предполагается, что эти и другие меры позволят Selectel экономить электроэнергию и занимать меньше полезной площади машинного зала. Среднегодовой коэффициент эффективности использования энергии (Power Usage Effectiveness, PUE) будет в диапазоне от 1,1 до 1,15. Таким образом, «Юрловский» станет самым «зелёным» дата-центром Selectel. В инфраструктуре дата-центра «Юрловский» будет задействована схема резервирования 6/5N — для каждой части на 1000 стоек будет выделено пять рабочих кластеров и один резервный. Фактически работать будут все шесть, но один можно в любой момент отключить. Кроме того, такой подход позволяет добиться физической изоляции резервируемых кластеров друг от друга. А автоматизации бесперебойной подачи питания и непрерывное охлаждение обеспечат возможность проводить любые профилактические и ремонтные работы без приостановки оказания услуг. Для поддержания связности новый ЦОД будет подключен несколькими независимым ВОЛС к MSK-IX (M9) и ЦОД «Берзарина», который уже имеется независимые подключения к нескольким IX. Вопрос с закупкой оборудования компания намерена решать в конце текущего года, поскольку в текущей ситуации прогнозировать что-либо затруднительно. На текущем этапе Selectel занимается проектированием и выполняет общестроительные работы. Ввод объекта в коммерческую эксплуатацию запланирован на 2023 год, однако сроки могут быть скорректированы в зависимости от ситуации на рынке. Инвестиции в проект оцениваются в миллиарды рублей.

29.04.2022 [21:35], Руслан Авдеев

Новые дата-центры Meta✴ для метавселенной будут построены из «зелёного» бетона, созданного с помощью ИИКомпания Meta✴ приступила к расширению кампуса дата-центров DeKalb в штате Иллинойс (США), которые, как предполагается, будут применяться для дальнейшего развития метавселенной. Для того, чтобы разработать материал для новых построек, Meta✴ прибегла к помощи искусственного интеллекта — специально подобранные «зелёные» компоненты позволят частично заменить традиционный бетон. Цемент является основой множества современных строительных материалов, применяемых в промышленных масштабах — по имеющейся статистике на его производство приходится порядка 8 % всех углеродных выбросов в мире. Для того, чтобы создать более приемлемую для экологии альтернативу, Meta✴ объединила усилия с Университетом Иллинойса в Урбане-Шампейне (UIUC), Массачусетским технологическим институтом (MIT) и IBM.

Источник изображения: tech.fb.com При участии системы искусственного интеллекта была обработана база данных со сведениями о характеристиках и компонентах бетонов. В результате проведённой работы была подобрана смесь летучей золы и шлака, способная частично заменить классический цемент. Полученные данные были переданы поставщику бетона — компании Ozinga, которая оптимизировала смесь исходя из своего опыта и доступности материалов, сохранив при этом необходимую прочность. Новый «зелёный» бетон, по оценкам Meta✴, обеспечивает на 40 % меньший углеродный выброс при создании. Помимо двух уже строящихся зданий для кампуса будут построены ещё три с использованием новых технологий. По имеющимся сведениям, новую смесь уже применили при строительстве второстепенных объектов. Общая площадь зданий ЦОД составит более 222 тыс. м2.

Источник изображения: tech.fb.com Как и многие штаты, Иллинойс предложил в 2019 году налоговые льготы на ЦОД-оборудование для привлечения операторов. Meta✴ так и не воспользовалась данными преимуществами, но от послаблений при расчётах налога на собственность не отказалась. После введения объектов в эксплуатацию новые ЦОД не только будут способствовать расширению метавселенной, но и обеспечат работой более 200 человек. На момент первого анонса проекта Meta✴ обещала, что кампус будет использовать 100 % возобновляемой энергии, а строения получат золотой сертификат Leadership in Energy and Environmental Design (LEED) за экологическую безопасность конструкции. Общий объёмы инвестиций в кампус в Иллинойсе составят более $1 млрд. Ранее сообщалась, что Meta✴ активно наращивает инвестиции в строительство ЦОД и сетевую инфраструктуру по всему миру. |

|