Материалы по тегу: software

|

01.12.2023 [13:20], Андрей Крупин

«Гарда технологии» представила новую версию сервиса данных о киберугрозахРоссийский разработчик систем информационной безопасности «Гарда технологии» (входит в «ИКС Холдинг») сообщил об обновлении сервиса «Гарда TI» (Threat Intelligence), предоставляющего актуальные сведения о признаках и индикаторах вредоносной активности на основе данных из открытых и собственных источников аналитического центра группы компаний «Гарда». В новой версии «Гарда TI» данные аналитики о хакерских группировках, методах и тактиках атак предоставляют заказчикам более полную информацию об индикаторах компрометации для повышения эффективности противодействия угрозам. Обновились связи между индикаторами, благодаря чему специалисты ИБ-служб могут сократить время реакции на вредоносную активность и самостоятельно проводить анализ угроз.

Источник изображения: freepik.com Кроме прочего, в базе «Гарда TI» стали доступны новые типы индикаторов: JA3/JA3S-отпечатки. Использование таких отпечатков позволяет точнее анализировать паттерны поведения злоумышленников и идентифицировать необычные или вредоносные активности в сети. Это помогает в обнаружении кибератак, инсайдерских активностей, вредоносного программного обеспечения, детектировании угроз в шифрованном трафике и ранее неизвестных угроз нулевого дня. Также сообщается о повышении удобства пользовательского интерфейса сервиса. Система «Гарда TI» зарегистрирована в реестре отечественного ПО, что подтверждает соответствие продукта требованиям российского законодательства, предоставляет возможность беспрепятственного использования в организациях, относящихся к органам государственной власти и критической информационной инфраструктуре.

30.11.2023 [15:09], Владимир Мироненко

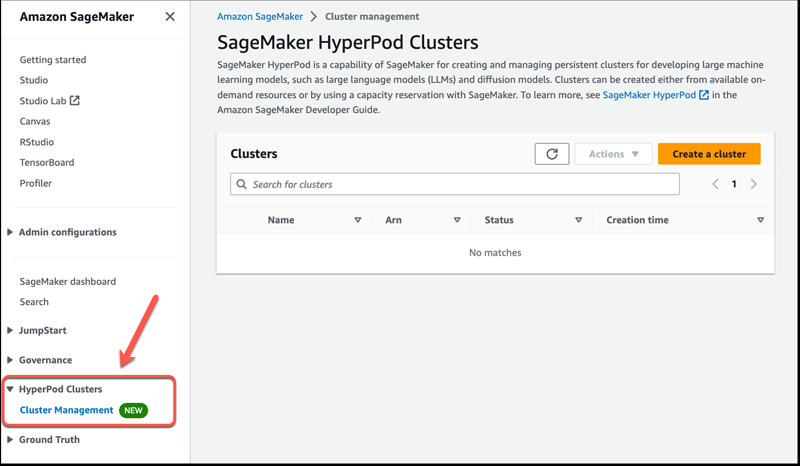

Amazon SageMaker HyperPod обеспечит бесперебойное обучение базовых моделейAmazon Web Services представила сервис Amazon SageMaker HyperPod для обучения и точной настройки больших языковых моделей (LLM). Новинка обеспечивает распределённое обучение для больших обучающих кластеров ИИ, оптимизированное использование вычислительных ресурсов, памяти и сетевых ресурсов кластера, а также гибкую среду обучения, исключающую перерывы. Базовые модели ИИ (FM, foundation model) зачастую слишком сложны, поэтому их обучение приходится проводить на нескольких ускорителях, что является технически сложной задачей, требует узкоспециализированных навыков и может занять недели или месяцы в зависимости от количества задействованного оборудования. При этом возрастает вероятность сбоев, таких как единичный отказ ускорителя. Эти сбои могут нарушить весь процесс обучения и потребовать ручного вмешательства для выявления, изоляции, отладки, устранения неполадок и восстановления после них, что ещё больше задержит процесс обучения. Для бесперебойного обучения модели разработчики должны постоянно сохранять прогресс обучения с помощью контрольных точек, что ещё больше увеличивает временные затраты и отдаляет вывод решения на рынок. SageMaker HyperPod обеспечивает доступ к ИИ-кластерам по требованию. Разработчики могут подготовить кластер с помощью комбинации команд и простых сценариев, что значительно быстрее, чем настройка инфраструктуры вручную. По словам AWS, SageMaker HyperPod может сократить время, необходимое для обучения базовых моделей, более чем на треть.

Изображение: AWS HyperPod предварительно сконфигурирован с использованием распределённых обучающих библиотек SageMaker, которые позволяют автоматически распределять учебные нагрузки между тысячами ускорителей. SageMaker также разделяет данные, на которых обучается модель, на более мелкие и более управляемые части. Hyperpod гарантирует непрерывность обучения моделей и периодическое создание контрольных точек. Когда во время обучения происходит аппаратный сбой, SageMaker HyperPod автоматически обнаруживает его, восстанавливает или заменяет неисправный инстанс и возобновляет обучение с последней контрольной точки, устраняя необходимость в ручном управлении этим процессом и позволяя проводить обучение в распределённой среде без сбоев в течение длительного времени. Вместе с тем клиенты с повышенными требованиями имеют возможность использовать собственный распределённый код для обучения. AWS также предоставляет возможность оснастить ИИ-кластер другими программными компонентами, такими как инструменты отладки. SageMaker HyperPod уже доступен в облачных регионах AWS в Огайо, Северной Вирджинии, Орегоне, Сингапуре, Сиднее, Токио, Франкфурте, Ирландии и Стокгольме.

30.11.2023 [14:15], Сергей Карасёв

Выручка Synopsys бьёт рекорды, а чистая прибыль быстро растётКомпания Synopsys обнародовала показатели работы в IV квартале и 2023 финансовом году в целом, который был завершён 31 октября. Американский разработчик САПР для электроники зафиксировал рекордную выручку и показал значительный рост чистой прибыли. За трёхмесячный период Synopsys получила $1,6 млрд выручки, что является историческим максимумом. Это на 25 % больше результата за последнюю четверть 2022 финансового года, когда показатель равнялся приблизительно $1,3 млрд. Компания подчёркивает, что благодаря активным исследованиям и разработкам смогла улучшить показатели деятельности даже в условиях кризиса и макроэкономических неопределённостей. Чистая квартальная прибыль в годовом исчислении поднялась более чем в два раза — со $153,5 млн до $349,2 млн. Прибыль в пересчёте на одну ценную бумагу составила $2,26 против $0,99 годом ранее. Выручка по итогам 2023 финансового года в целом также оказалась рекордной — примерно $5,8 млрд. Для сравнения: годом ранее Synopsys получила около $5,1 млрд. Таким образом, рост оказался на уровне 15 %. Чистая годовая прибыль достигла $1,2 млрд, или $7,92 на акцию, по сравнению с $984,6 млн, или $6,29 на одну ценную бумагу, в 2022 финансовом году. В I четверти 2024 финансового года, которая продлится до 31 января, Synopsys рассчитывает получить выручку от $1,63 млрд до $1,66 млрд и показать при этом прибыль в диапазоне от $2,4 до $2,5 на акцию. В наступившем финансовом году в целом выручка, как ожидается, составит от $6,57 млрд до $6,63 млрд, чистая прибыль — от $9,07 до $9,25 на одну ценную бумагу.

30.11.2023 [13:57], Андрей Крупин

Состоялся релиз Solar DAG — комплексного решения по управлению и контролю доступа к даннымКомпания «Солар» объявила о выпуске нового продукта Solar DAG, предлагающего рынку единый подход к контролю хранения и использования конфиденциальной информации. Solar DAG представляет собой комплексное решение по управлению и контролю доступа к данным, которые хранятся и обрабатываются в неструктурированном и полуструктурированном виде на различных системах хранения, что позволяет минимизировать риски утечки конфиденциальной информации. Продукт помогает определить критичную и ценную информацию в общем массиве данных, что позволяет сконцентрировать внимание внутренних служб безопасности организации именно на её защите.

Источник изображения: freepik.com Комплекс Solar DAG обеспечивает контроль над всеми действиями, которые потенциально несут риск неправомерного использования данных. Решение обладает высокой производительностью и ориентировано на клиентов сегмента Enterprise. Возможность потоковой обработки до 100 миллионов событий на системах хранения данных в день и высокая скорость контентного анализа — до 1,5 Тбайт в сутки — а также скорость выполнения запросов при построении отчётов позволяют работать с внушительными объёмами информации и контролировать действия большого количества сотрудников организации. Предприятия с развитой филиальной инфраструктурой могут контролировать файловые серверы по всей сети благодаря поддержке работы в геораспределенном режиме. В рамках централизованного использования системы Solar DAG позволяет настроить области видимости для администраторов каждого филиала в отдельности, что исключает возможность несанкционированного доступа к информации и статистике, которая находится вне зоны его ответственности.

30.11.2023 [03:10], Игорь Осколков

ИИ в один клик: llamafile позволяет запустить большую языковую модель сразу в шести ОС и на двух архитектурахMozilla представила первый релиз инструмента llamafile, позволяющего упаковать веса большой языковой модели (LLM) в исполняемый файл, который без установки можно запустить практически на любой современной платформе, причём ещё и с поддержкой GPU-ускорения в большинстве случаев. Это упрощает дистрибуцию и запуск моделей на ПК и серверах. llamafile распространяется под лицензией Apache 2.0 и использует открытые инструменты llama.cpp и Cosmopolitan Libc. Утилита принимает GGUF-файл с весами модели, упаковывает его и отдаёт унифицированный бинарный файл, который запускается в macOS, Windows, Linux, FreeBSD, OpenBSD и NetBSD. Готовый файл предоставляет либо интерфейс командной строки, либо запускает веб-сервер с интерфейсом чат-бота.

Источник: GitHub / Mozilla Ocho Поддерживаются платформы x86-64 и ARM64, причём в первом случае автоматически определяется тип CPU и по возможности используются наиболее современные векторные инструкции. llamafile может использовать ускорители NVIDIA, а в случае платформы Apple задействовать Metal. Разработчики успешно протестировали инструмент в Linux (в облаке Google Cloud) и Windows с картой NVIDIA, в macOS и на NVIDIA Jetson. Впрочем, некоторые нюансы всё же есть. Так, в Windows размер исполняемого файла не может превышать 4 Гбайт, поэтому большие модели вынужденно хранятся в отдельном файле. В macOS на платформе Apple Silicon перед первым запуском всё же придётся установить Xcode, а в Linux, возможно, понадобится обновить некоторые компоненты. Подробности и примеры готовых моделей можно найти в репозитории проекта.

29.11.2023 [23:40], Руслан Авдеев

NVIDIA NeMo Retriever позволит компаниям дополнять ИИ-модели собственными даннымиNVIDIA представила сервис NeMo Retriever, позволяет компаниям дополнять данные для чат-ботов, ИИ-помощников и похожих инструментов специализированными сведениями — для получения более точных ответов на запросы. Сервис стал частью облачного семейства инструментов NVIDIA NeMo, позволяющих создавать, настраивать и внедрять модели генеративного ИИ. RAG (Retrieval Augmented Generation), метод улучшения производительности больших языковых моделей (LLM), позволяет повысить точность и безопасность ИИ-инструментов благодаря заполнению пробелов в «знаниях» языковых моделей с помощью сведений из внешних источников. Обучение каждой модели — чрезвычайно ресурсоёмкий процесс — обычно осуществляется довольно редко, а то и вовсе единожды. При этом до следующего обновления модель не имеет доступа к полной и актуальной информации, что может привести к неточностям, ошибкам и т.н. галлюцинациям. NeMo Retriever позволяет быстро дополнить LLM свежими сведениями в виде баз данных, HTML-страниц, PDF-файлов, изображений, видео и т.п. Другими словами, базовая модель с добавлением специализированных материалов станет заметно эрудированнее и «сообразительнее». При этом данные могут храниться где угодно — как в облаках, так и на собственных серверах компаний. Технология чрезвычайно полезна, поскольку обеспечивает сотрудникам компании работу с полезными данными, закрытыми для широкой публики, при этом пользуясь всеми преимуществами ИИ. В отличие от открытых RAG-инструментов, NVIDIA, по данным самой компании, предлагает готовое к коммерческому использованию решение для доступных на рынке ИИ-моделей, уже оптимизированных для RAG и имеющих поддержку, а также регулярно получающих обновления безопасности. Другими словами, корпоративные клиенты могут брать готовые ИИ-модели и дополнять их собственными данными без отдельной ресурсоёмкой тренировки. NeMo Retriever позволит добавить соответствующие возможности универсальной облачной платформе NVIDIA AI Enterprise, предназначенной для оптимизации разработки ИИ-приложений. Регистрация разработчиков для раннего доступа к NeMo Retriever уже началась. Cadence Design Systems, Dropbox, SAP SE и ServiceNow уже работают с NVIDIA над внедрением RAG в свои внутренние ИИ-инструменты.

29.11.2023 [22:43], Владимир Мироненко

ИИ-ассистент Amazon Q упростит работу IT-специалистов, разработчиков и корпоративных клиентов AWSКомпания Amazon Web Services представила интеллектуального ассистента Amazon Q на базе генеративного ИИ, предназначенного для помощи корпоративным клиентам. Поначалу Amazon Q будет использоваться для нужд разработчиков и поддержки IT-команд. Amazon Q уже доступен в виде превью, причем многие функции бесплатны. В дальнейшем AWS будет брать по $20/мес. за каждого пользователя, а версия с дополнительными функциями для ИТ-специалистов будет стоить $25/мес. «Amazon Q может помочь вам получать быстрые и актуальные ответы на насущные вопросы, решать проблемы, генерировать контент и предпринимать действия, используя данные и опыт, найденные в информационных репозиториях, коде и корпоративных системах вашей компании», — сообщил гендиректор Amazon. Глава AWS считает, что Amazon Q реформирует множество видов деятельности. ИИ-помощник разработан с учётом 17-летнего опыта работы самой AWS и поначалу будет доступен именно внутри экосистемы AWS. Хотя Amazon Q в первую очередь нацелен на разработчиков и ИТ-специалистов, компания планирует в конечном итоге распространить его возможности на весь корпоративный сегмент. Подобно другим ИИ-помощникам он сможет подключаться к различным источникам данных, отвечать на вопросы и составлять резюме, а также предоставлять экспертные сведения или помощь на основе внутренней информации компании. Это потенциально может сделать его конкурентом ChatGPT Enterprise от OpenAI, Copilot for 365 от Microsoft и Duet AI for Workspace от Google. Специалисты смогут получить доступ Amazon Q из консоли AWS. Q расскажет, как использовать сервисы, какие API доступны, к каким сервисам можно подключиться и как они взаимодействуют между собой. Пользователь сможет создавать запросы на естественном языке, а Q подготовит экспертный ответ со ссылками и цитатами. Так, в EC2-консоли Amazon Q даст совет, какой тип инстанса лучше всего подходит для размещения определённого типа приложений в зависимости в зависимости от потребностей клиента. А если возникла проблема с сетью, у Q можно напрямую спросить: «Почему я не могу подключиться по SSH к своему инстансу?». В этом случае помощник подключит его к сетевому анализатору, чтобы устранить неполадки с соединением. AWS интегрировала ИИ-ассистента в поддерживаемые IDE вместе с ИИ-инструментом Amazon CodeWhisperer, так что с Q можно пообщаться непосредственно во время разработки. Например, Amazon Q может разобрать и описать исходный код незнакомого проекта или же в диалоговом режиме в Amazon CodeCatalyst поможет создать новый код, опираясь на описание необходимой функциональности и учитывая лучшие практики, а также имеющуюся кодовую базу и бизнес-сведения. Наконец, функция Amazon Q Transformation, доступная в виде превью для IntelliJ IDEA и Visual Studio Code, позволит автоматизировать обновление кода приложений с Java 8 и 11 до версии 17. А вскоре Q научится преобразовывать .NET-приложения для Windows в кросс-платформенные.

29.11.2023 [17:07], Андрей Крупин

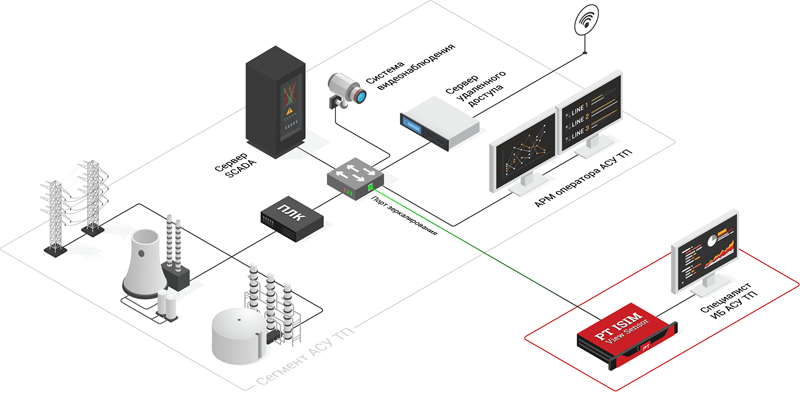

Система PT Industrial Security Incident Manager дополнилась средствами мониторинга энергообъектовКомпания Positive Technologies сообщила о выпуске новой версии комплексного решения PT Industrial Security Incident Manager 4.4 (PT ISIM 4.4), предназначенного для защиты автоматизированных систем управления технологическими процессами (АСУ ТП). Представленный российским разработчиком продукт осуществляет сбор и анализ сетевого трафика в инфраструктуре предприятия. PT ISIM обеспечивает поиск следов нарушений информационной безопасности в сетях АСУ ТП, помогает на ранней стадии выявлять кибератаки, активность вредоносного ПО, неавторизованные действия персонала (в том числе злоумышленные) и обеспечивает соответствие требованиям законодательства (187-ФЗ, приказы ФСТЭК № 31, 239, ГосСОПКА).  PT Industrial Security Incident Manager 4.4 включает в себя расширенный контроль сетевых коммуникаций на современных цифровых энергообъектах по стандарту МЭК-61850. В продукте появился новый microView Sensor, который устанавливается на компактные промышленные ПК и предназначен для использования на небольших объектах автоматизации: подстанциях 6–10 кВ, тепловых пунктах, в цехах и инженерных системах ЦОД и зданий. Решение может выявлять аномальные сетевые соединения, отказы и ошибки коммуникации по протоколам MMS и GOOSE, свидетельствующие о неправильной эксплуатации, некорректной настройке оборудования или попытках компрометации устройств. Также упростился пользовательский интерфейс PT ISIM 4.4. Обновление предыдущих версий теперь полностью централизованно для всех поддерживаемых операционных систем — ручное обновление дополнительных модулей не требуется.

29.11.2023 [16:20], Андрей Крупин

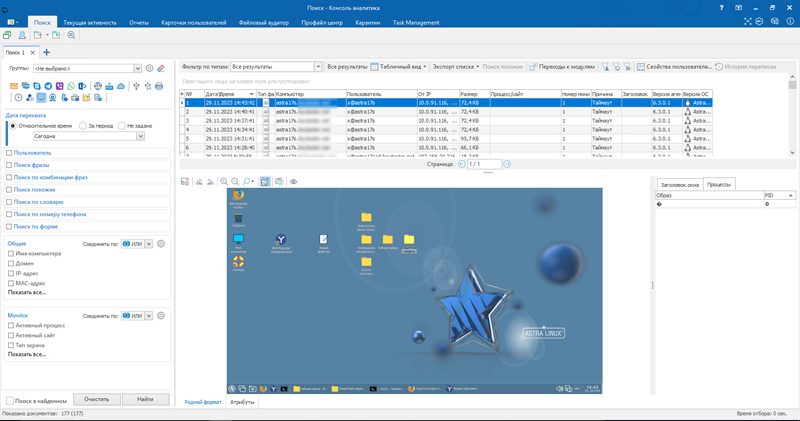

Linux-версия DLP-системы «СёрчИнформ КИБ» получила расширенные функциональные возможностиКомпания «СёрчИнформ» объявила о выпуске обновлённой Linux-версии программного комплекса «Контур информационной безопасности» (КИБ). Платформа «СёрчИнформ КИБ» относится к классу систем Data Loss Prevention (DLP) и предназначена для предотвращения утечек конфиденциальной информации в корпоративных сетях, управления рисками и всесторонней защиты бизнеса от внутренних угроз. Решение состоит из модулей, каждый из которых контролирует свой канал передачи информации. Система показывает, какой путь проходят данные, и делает прозрачными все коммуникации. Обновлённая Linux-версия DLP-системы получила расширенные средства контроля веб-камеры, монитора и пользовательской активности. Так, с помощью модуля CameraController ИБ-службы могут создавать снимки пользователя за ПК и просматривать происходящее в зоне видимости веб-камеры в режиме реального времени. MonitorController записывает видео с экранов рабочих станций и делает контрольные снимки, если настроена съёмка по расписанию. Наконец, модуль ProgramController анализирует пользовательскую активность в веб-браузерах и оценивает, насколько продуктивно сотрудники проводят время в интернете.  Полученные сведения складываются в отчёты, по которым можно судить о дисциплине и эффективности работы сотрудника. Кроме того, ИИ-инструменты позволяют выявлять нетипичные угрозы. Например, аналитический движок сравнивает снимки CameraController с образцовым фото пользователя и с помощью распознавания лиц выявляет, что за ПК чужак или никого нет (возможно несанкционированное удалённое подключение), и сигнализирует службе ИБ. Также распознавание работает для телефонов и позволяет выявлять попытки «слить» данные, сфотографировав экран на смартфон. «Обновление уравняло возможности Linux-версии «СёрчИнформ КИБ» с версией для Windows — мы наконец адаптировали все модули. Это актуальные новости для госсектора и субъектов критической информационной инфраструктуры, которые в рамках импортозамещения перешли на российские операционные системы на базе Linux», — отмечают разработчики.

28.11.2023 [15:27], Сергей Карасёв

AWS и Kyndril помогут предприятиям во внедрении решений на основе генеративного ИИОблачная платформа Amazon Web Services (AWS) и компания Kyndryl, бывшее подразделение IBM, объявили о заключении многолетнего соглашения о сотрудничестве. Партнёры помогут корпоративным заказчикам в создании и внедрении решений на базе генеративного ИИ и передовых средств машинного обучения. Предполагается, что сотрудничество позволит клиентам AWS и Kyndril ускорить цифровую трансформацию, повысить эффективность работы и задействовать инновационные решения в рамках своего бизнеса.

Источник изображения: pixabay.com По условиям соглашения, Kyndril и AWS создадут площадку Innovation Factory для совместной разработки решений на основе генеративного ИИ и машинного обучения, ориентированных на конкретные сценарии использования. Данная инициатива призвана помочь заказчикам в модернизации облачной стратегии. Кроме того, партнёрство нацелено на расширение возможностей Kyndril по проектированию, внедрению, миграции, улучшению и управлению облачными сервисами AWS в комплексных IT-средах. Стороны помогут ускорить модернизацию систем планирования ресурсов предприятия и других приложений на площадке AWS: это позволит сократить финансовые и временные затраты. Kyndril также сможет увеличить количество своих сотрудников, имеющих сертификаты AWS, что поможет ускорить реализацию проектов по миграции рабочих нагрузок клиентов в облако и по развёртыванию сервисов генеративного ИИ. |

|