Материалы по тегу: llm

|

15.02.2024 [21:44], Сергей Карасёв

«Норбит» создал российскую большую языковую модель для быстрого внедрения ИИ в бизнес-процессыСистемный IT-интегратор «Норбит», входящий в группу «Ланит», сообщил о разработке собственной большой языковой модели (LLM), получившей название Norbit GPT. Решение, ориентированное на корпоративных пользователей, может быть развёрнуто как в облаке, так и в локальной инфраструктуре заказчика. Утверждается, что Norbit GPT позволяет компаниям быстро внедрять средства генеративного ИИ в свои бизнес-процессы. Использование таких инструментов может помочь повысить производительность, снизить издержки и получить конкурентные преимущества. Модель дообучена на большом массиве русскоязычных данных. При этом её можно кастомизировать под специфику и задачи клиента, используя корпоративные массивы информации — например, регламенты, библиотеки, сервисные обращения и др. Возможность развёртывания on-premise минимизирует риски утечки персональной и конфиденциальной информации. С помощью API модель можно интегрировать с информационными системами компании. Norbit GPT подходит для генерации текстов, обобщения информации, обработки и анализа данных, а также для подготовки ответов на обращения пользователей в службу поддержки или запросов в базу знаний компании. Таким образом, можно автоматизировать процесс выполнения рутинных задач, что поможет снизить нагрузку на сотрудников и повысить эффективность бизнес-процессов. В частности, LLM может оказывать помощь в подготовке маркетинговых материалов, написании писем, разработке программного кода, проверке документов, классификации резюме и пр. «GPT-технологии кардинально меняют бизнес, модифицируют подходы к созданию контента, управлению и решению рутинных задач. Если в ваших бизнес-процессах есть направления, в которых задействованы большие объёмы текстовых данных, мы можем предложить пилотный проект автоматизации на основе Norbit GPT и варианты его интеграции в корпоративную информационную инфраструктуру», — говорит «Норбит».

14.02.2024 [23:00], Сергей Карасёв

Поговорить с машинами: Nokia представила ИИ-помощника MX Workmate для промышленных работниковКомпания Nokia анонсировала специализированный набор инструментов MX Workmate, который позволяет работникам промышленных предприятий «общаться» с машинами. В основу решения положены технологии генеративного ИИ и большая языковая модель (LLM). Отмечается, что организации по всему миру сталкиваются с нехваткой квалифицированной рабочей силы. Исследование, проведённое консалтинговой фирмой Korn Ferry, говорит о том, что к 2030 году дефицит технических специалистов в глобальном масштабе может достичь 85 млн человек. Это эквивалентно $8,5 трлн потенциальных потерянных доходов. Внедрение ИИ-инструментов может частично облегчить кадровую проблему. ИИ-помощник MX Workmate использует машинные данные для генерации сообщений на естественном языке. Это облегчает взаимодействие сотрудников предприятий с различным оборудованием, а также повышает эффективность работы и безопасность. В частности, MX Workmate позволяет работникам в режиме реального времени получать понятную информацию о состоянии производства, объемах и качестве выпускаемой продукции и пр. Кроме того, система выдаёт рекомендации по улучшению показателей. Используя Nokia Team Comms, сотрудники смогут задавать вопросы помощнику. Быстро анализируя поступающую информацию, ИИ-инструмент может выдавать ранние предупреждения о возможных неисправностях или грядущих поломках. Это упростит профилактическое обслуживание и поможет избежать серьёзных сбоев оборудования, минимизировав тем самым время простоя. Благодаря непрерывной оценке рисков MX Workmate может оперативно генерировать инструкции для работников в случае возникновения чрезвычайной ситуации: таким образом, сотрудники предприятий смогут действовать максимально безопасно. В целом, как утверждается, Nokia MX Workmate — это первое решение на основе генеративного ИИ, разработанное специально для производственных площадок. Помощник обеспечивает контекстно-зависимый обмен информацией в режиме реального времени между работниками и сложными системами безопасным способом с использованием естественного человеческого языка.

11.02.2024 [21:37], Владимир Мироненко

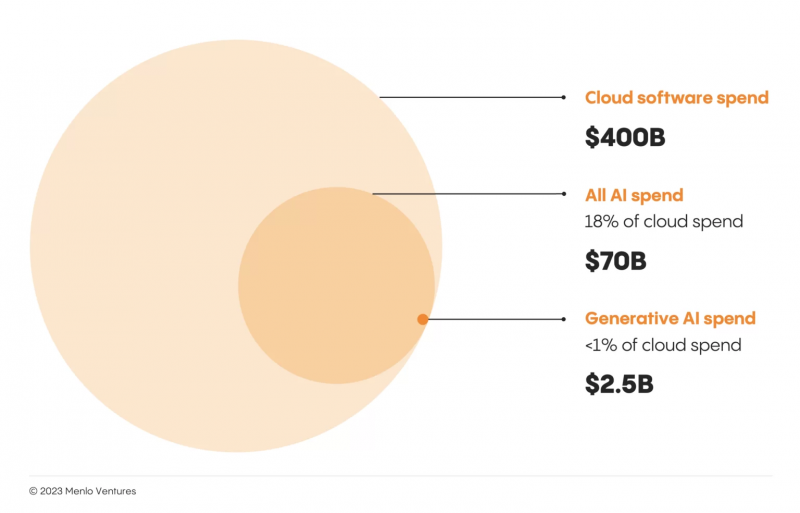

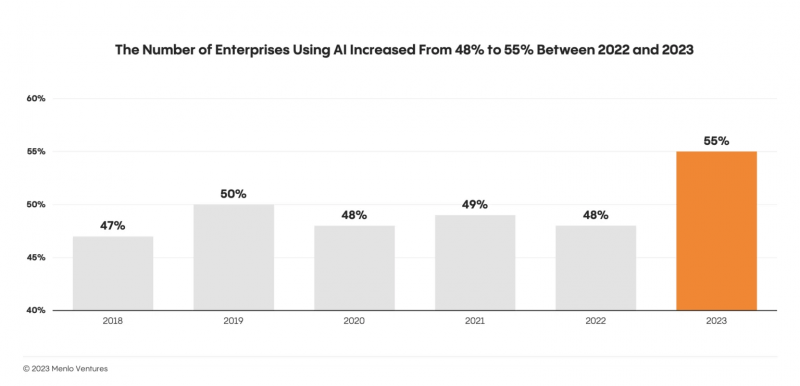

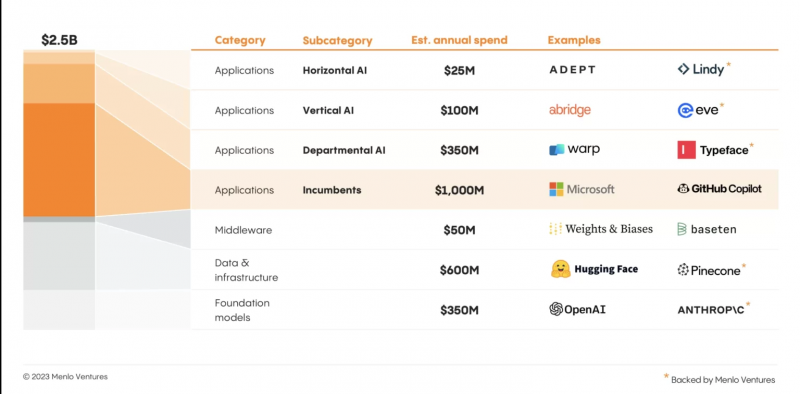

Menlo Ventures: запуск ChatGPT стал поворотным моментом, но рынок генеративного ИИ находится в зачаточном состоянииВенчурная компания Menlo Ventures опубликовала результаты исследования «Состояние генеративного ИИ на предприятиях». Чтобы получить представление о текущем уровне внедрения генеративного ИИ в корпоративном сегменте, исследователи опросили более 450 руководителей предприятий в США и Европе. Несмотря на шумиху вокруг данной технологи, исследование показало, что корпоративные инвестиции в генеративный ИИ по-прежнему малы по сравнению с другими категориями ПО. По оценкам Menlo Ventures, инвестиции предприятий в генеративный ИИ в 2023 году составят $2,5 млрд, что гораздо меньше расходов предприятий на традиционный ИИ ($70 млрд) и облачное ПО ($400 млрд). Следует отметить, что ИИ не является чем-то новым для предприятий, которые использовали традиционные технологии ИИ (компьютерное зрение, глубокое обучение и т. д.) задолго до появления генеративного ИИ. Половина участников опроса до 2023 года внедрила ту или иную форму ИИ, например, в продукты для клиентов или в системы внутренней автоматизации. Но запуск ChatGPT стал поворотным моментом: стратегия развития ИИ внезапно стала горячей темой среди руководителей, а принятие технологии возросло. Исследование показало, что после пяти лет застоя:

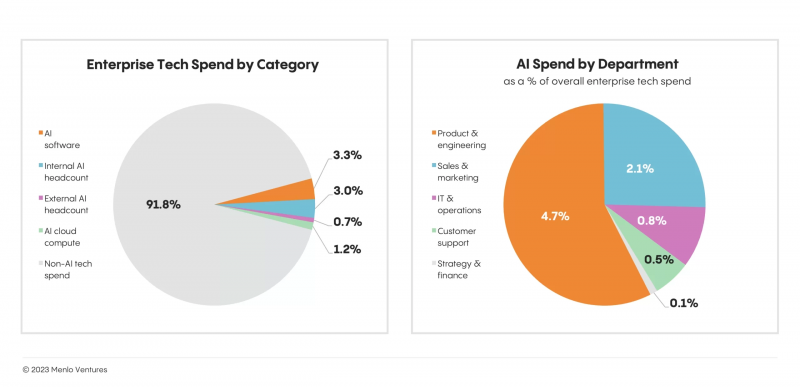

Инвестиции в генеративный ИИ способствовали увеличению расходов на ИИ вообще. При это 80 % респондентов сообщили о покупке стороннего ПО для генеративного ИИ вместо попыток самостоятельно создать такие решения. Говоря об опыте внедрения новых революционных технологий, аналитики отметили, что за первое десятилетие своего существования облако достигло 30 % расходов на корпоративное ПО; уровень проникновения интернета за тот же период достиг 45 %, а мобильной связи — 80 %. В 2023 году предприятия потратили около $2,5 млрд на генеративный ИИ, что способствовало развитию таких инструментов, как GitHub Copilot и Hugging Face (оба заработали десятки миллионов долларов). Но рынок всё ещё находится в зачаточном состоянии и корпоративные инвестиции в генеративный ИИ по-прежнему составляют менее 1 % всех расходов на облако. Что важно, популярность генеративного ИИ также стимулировала спрос на классические платформы для работы с данными, такие как Dataiku и Databricks. В настоящее время больше всего средств на генеративный ИИ тратят продуктовые и инженерные отделы. Причём они тратят больше (4,7 % всех расходов на технологии), чем все остальные отделы вместе взятые (3,5 %). При создании собственных систем ИИ предприятия вкладывают значительные средства в персонал и технологии, поручая традиционным разработчикам и специалистам по обработке данных создавать внутреннюю инфраструктуру, а некоторые нанимают дополнительных специалистов (ML-инженеров, исследователей и т. д.). Предприятия также вкладывают значительные средства в сторонние решения, составляющие основу современного стека ИИ. Как ожидают исследователи, по мере того как решения будут развиваться и приносить большую ценность, инвестиции в генеративный ИИ будут увеличиваться во всех подразделениях компаний. Тем не менее, согласно прогнозу Menlo Ventures, несмотря на ажиотаж, внедрение генеративного ИИ на предприятиях будет носить умеренный характер, как и раннее внедрение облачных технологий. Многие стартапы первой волны все еще пытаются дифференцироваться, что затрудняет завоевание позиций на рынке. Menlo Ventures прогнозирует, что рынок продолжит отдавать предпочтение игрокам, которые внедряют ИИ в существующие продукты. В борьбе за долю рынка генеративного ИИ существующие игроки быстро перешли к «стратегии встроенного ИИ». Исследователи ожидают, что их существующее преимущество сохранится в течение следующих нескольких лет, пока не станут преобладать новые и более мощные подходы вроде автономных агентов и многоэтапного размышления. Кроме того, Menlo Ventures полагает, что мощные контекстно-зависимые рабочие процессы с большим объёмом данных станут ключом к внедрению генеративного ИИ на предприятии. Аналитики Menlo Ventures определили три области, которые имеют огромный потенциал для развития стартапов:

20.09.2023 [20:05], Алексей Степин

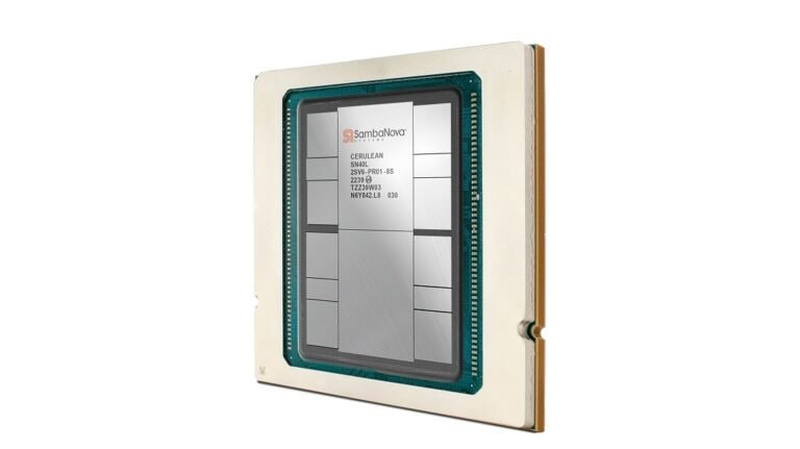

SambaNova представила ИИ-ускоритель SN40L с памятью HBM3, который в разы быстрее GPUБум больших языковых моделей (LLM) неизбежно порождает появление на рынке нового специализированного класса процессоров и ускорителей — и нередко такие решения оказываются эффективнее традиционного подхода с применением GPU. Компания SambaNova Systems, разработчик таких ускорителей и систем на их основе, представила новое, третье поколение ИИ-процессоров под названием SN40L. Осенью 2022 года компания представила чип SN30 на базе уникальной тайловой архитектуры с программным управлением, уже тогда вполне осознавая тенденцию к увеличению объёмов данных в нейросетях: чип получил 640 Мбайт SRAM-кеша и комплектовался оперативной памятью объёмом 1 Тбайт.

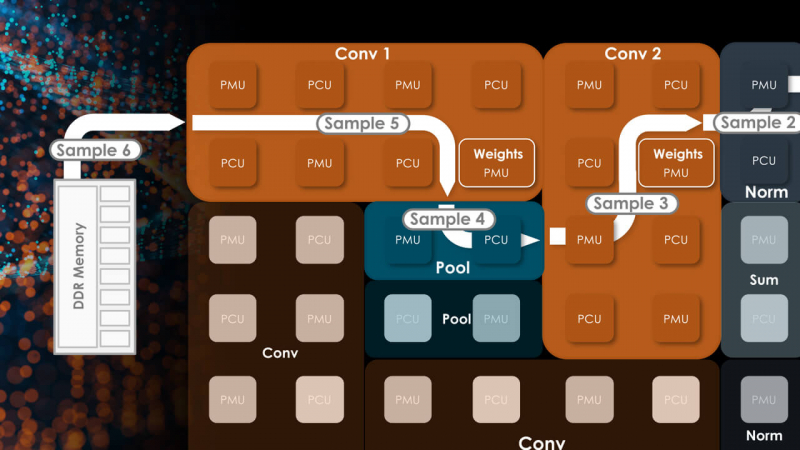

Источник изображений здесь и далее: SambaNova (via EE Times) Эта наработка легла и в основу новейшего SN40L. Благодаря переходу от 7-нм техпроцесса TSMC к более совершенному 5-нм разработчикам удалось нарастить количество ядер до 1040, но их архитектура осталась прежней. Впрочем, с учётом реконфигурируемости недостатком это не является. Чип SN40L состоит из двух больших чиплетов, на которые приходится 520 Мбайт SRAM-кеша, 1,5 Тбайт DDR5 DRAM, а также 64 Гбайт высокоскоростной HBM3. Последняя была добавлена в SN40L в качестве буфера между сверхбыстрой SRAM и относительно медленной DDR. Это должно улучшить показатели чипа при работе в режиме LLM-инференса. Для эффективного использования HBM3 программный стек SambaNova был соответствующим образом доработан.

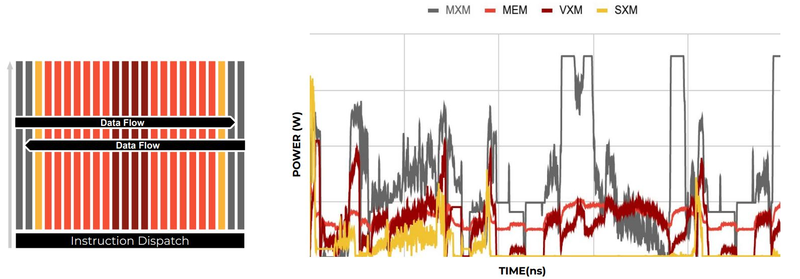

Тайловая архитектура SambaNova состоит из вычислительных тайлов PCU, SRAM-тайлов PMU, управляющей логики и меш-интерконнекта По сведениям SambaNova, восьмипроцессорная система на базе SN40L сможет запускать и обслуживать ИИ-модель поистине титанических «габаритов» — с 5 трлн параметров и глубиной запроса более 256к. В описываемой модели речь идёт о наборе экспертных моделей с LLM Llama-2 в качестве своеобразного дирижёра этого оркестра. Архитектура с традиционными GPU потребовала бы для запуска этой же модели 24 сервера с 8 ускорителями каждый; впрочем, модель ускорителей не уточняется. Как и прежде, сторонним клиентам чипы SN40L и отдельные вычислительные узлы на их основе поставляться не будут. Компания продолжит использовать модель Dataflow-as-a-Service (DaaS) — расширяемую платформу ИИ-сервисов по подписке, включающей в себя услуги по установке оборудования, вводу его в строй и управлению в рамках сервиса. Однако SN40L появится в рамках этой услуги позднее, а дебютирует он в составе облачной службы SambaNova Suite.

15.09.2023 [20:52], Алексей Степин

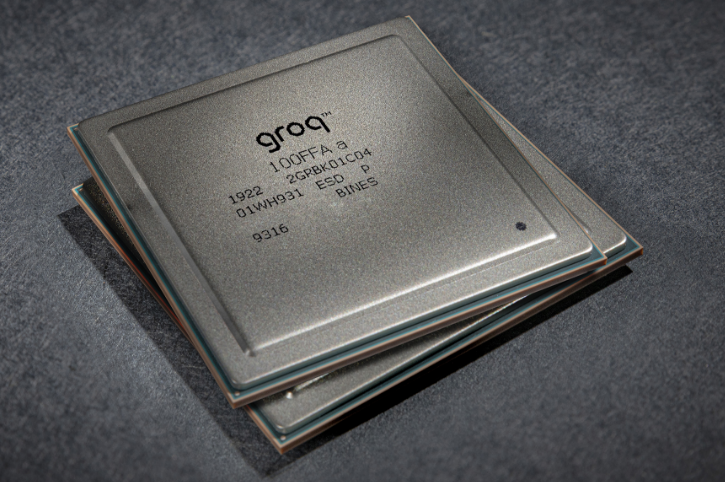

Groq назвала свои ИИ-чипы TSP четырёхлетней давности идеальными для LLM-инференсаТензорный процессор TSP, разработанный стартапом Groq, был анонсирован ещё осенью 2019 года и его уже нельзя назвать новым. Тем не менее, как сообщает Groq, TSP всё ещё является достаточно мощным решением для инференса больших языковых моделей (LLM). Теперь Groq позиционирует своё детище как LPU (Language Processing Unit) и продвигает его в качестве идеальной платформы для запуска больших языковых моделей (LLM). Согласно имеющимся данным, в этом качестве четырёхлетний процессор проявляет себя весьма неплохо. Groq открыто хвастается своим преимуществом над GPU, но в последних раундах MLPerf участвовать не желает.

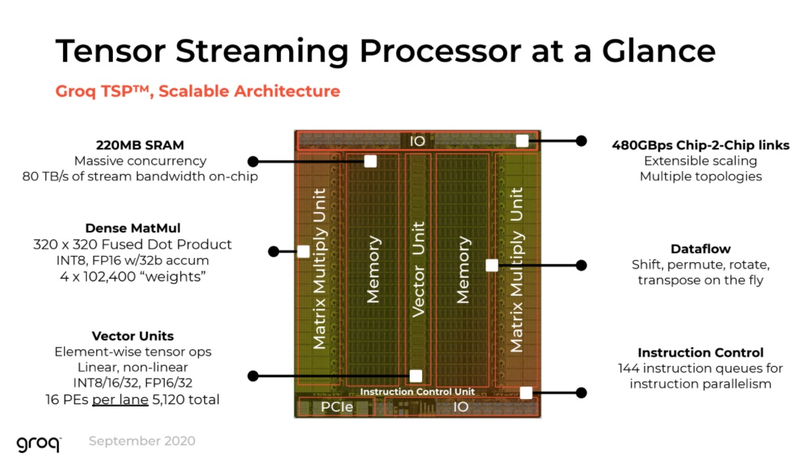

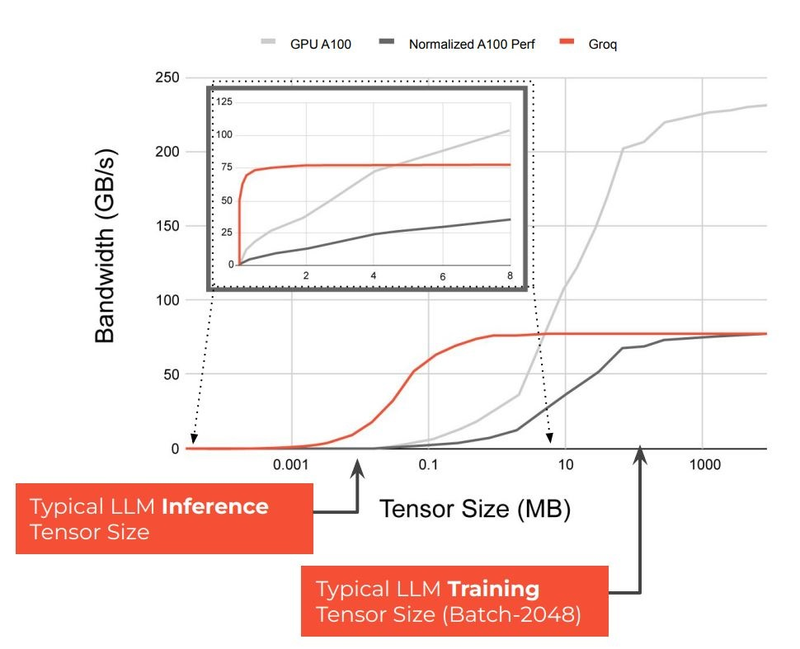

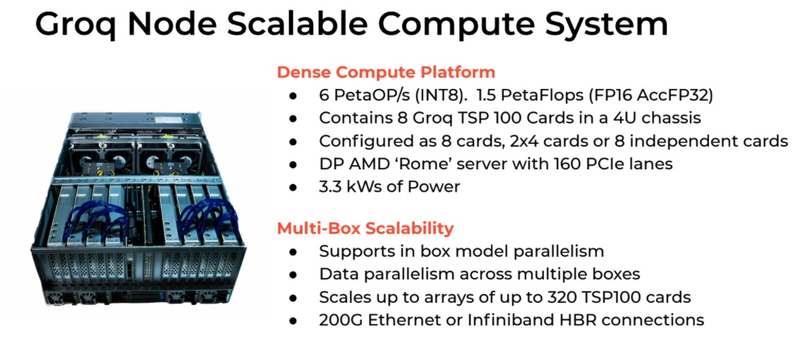

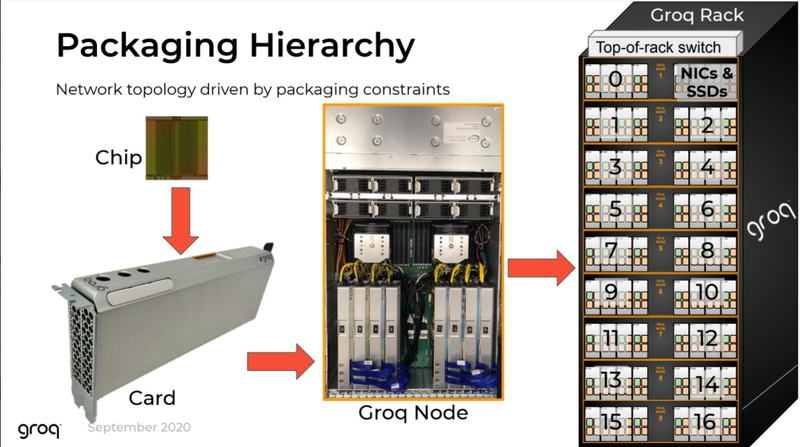

Источник изображений здесь и далее: Groq В своё время Groq разработала не только сам тензорный процессор, но и дизайн ускорителя на его основе, а также продумала вопрос взаимодействия нескольких TSP в составе вычислительного узла с дальнейшим масштабированием до уровня мини-кластера. Именно для такого кластера и опубликованы свежие данные о производительности Groq в сфере LLM.  Система разработки, содержащая в своём составе 640 процессоров Groq TSP, была успешно использована для запуска модели Meta✴ Llama-2 с 70 млрд параметров. Как показали результаты тестов, модель на данной платформе работает с производительностью 240 токенов в секунду на пользователя. Для адаптации и развёртывания Llama-2, по словам создателей Groq, потребовалось всего несколько дней. В настоящее время усилия Groq будут сконцентрированы на адаптации имеющейся платформы в сфере LLM-инференса, поскольку данный сектор рынка растёт быстрее, нежели сектор обучения ИИ-моделей. Для LLM-инференса важнее умение эффективно масштабировать потоки небольших блоков (8–16 Кбайт) на большое количество чипов.  В этом Groq TSP превосходит NVIDIA A100: если в сравнении двух серверов выиграет решение NVIDIA, то уже при 40 серверах показатели латентности у Groq TSP будут намного лучше. В распоряжении Groq имеется пара 10-стоечных кластеров с 640 процессорами, один из которых используется для разработки, а второй — в качестве облачной платформы для клиентов Groq в области финансовых услуг. Работает система Groq и в Аргоннской национальной лаборатории (ALCF), где она используется для исследований в области термоядерной энергетики.  В настоящее время Groq TSP производятся на мощностях GlobalFoundries, а упаковка чипов происходит в Канаде, но компания работает над вторым поколением своих процессоров, которое будет производиться уже на заводе Samsung в Техасе. Параллельно Groq работает над созданием 8-чипового ускорителя на базе TSP первого поколения. Это делается для уплотнения вычислений, а также для более полного использования проприетарного интерконнекта и обхода ограничений, накладываемых шиной PCIe 4.0. Также ведётся дальнейшая оптимизация ПО для кремния первого поколения.  Простота и скорость разработки ПО для платформы Groq TSP объясняется историей создания этого процессора — начала Groq с создания компилятора и лишь затем принялась за проектирование кремния с учётом особенностей этого компилятора. Перекладывание на плечи компилятора всех задач оркестрации вычислений позволило существенно упростить дизайн TSP, а также сделать предсказуемыми показатели производительности и латентности ещё на этапе сборки ПО. При этом архитектура Groq TSP вообще не предусматривает использования «ядер» (kernels), то есть не требует блоков низкоуровневого кода, предназначенного для общения непосредственно с аппаратной частью. В случае с TSP любая задача разбивается на набор небольших инструкций, реализованных в кремнии и выполняемых непосредственно чипом.

Компилятор Groq позволяет визуализировать и предсказывать энергопотребление с точностью до наносекунд. Источник: Groq Предсказуемость Groq TSP распространяется и на энергопотребление: оно полностью профилируется ещё на этапе компиляции, так что пики и провалы можно спрогнозировать с точностью вплоть до наносекунд. Это позволяет добиться от платформы более надёжного функционирования, избежав так называемой «тихой» порчи данных — сбоев, происходящих в результате резких всплесков энергетических и тепловых параметров кремния.

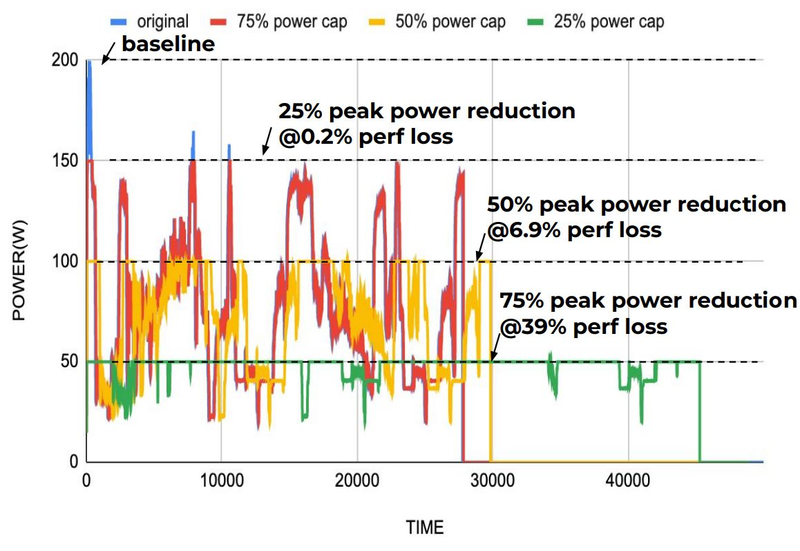

Энергопотребление Groq TSP поддаётся тонкой настройке на уровне программного обеспечения. Источник: Groq Что касается будущего LLM-инференса, то Groq считает, что этой отрасли есть, куда расти. В настоящее время LLM дают ответ на запрос сразу, и затем пользователи могут уточнить его в последующих итерациях, но в будущем они начнут «рефлексировать» — то есть, «продумывать» несколько вариантов одновременно, используя совокупный результат для более точного «вывода» и ответа. Разумеется, такой механизм потребует больших вычислительных мощностей, и здесь масштабируемая и предсказуемая архитектура Groq TSP может прийтись как нельзя более к месту. |

|