Материалы по тегу: intel

|

03.08.2024 [12:33], Сергей Карасёв

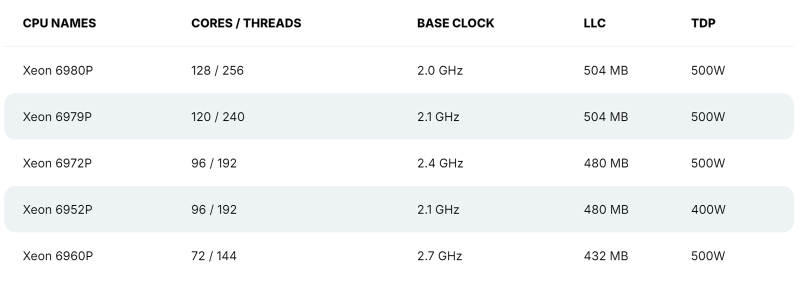

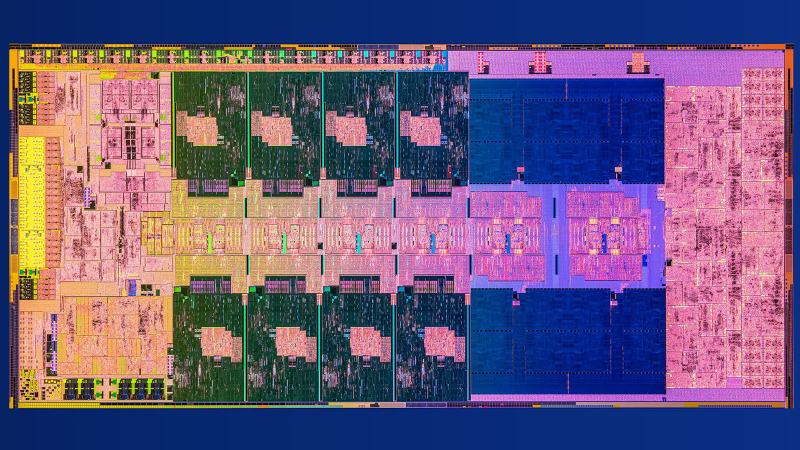

128 P-ядер, 504 Мбайт кеша и TDP 500 Вт: утекли характеристики Intel Xeon Granite RapidsВ распоряжении сетевых источников, по сообщению ресурса VideoCardz, оказалась информация о характеристиках части процессоров Intel Xeon 6 семейства Granite Rapids, в основу которых лягут производительные ядра P-core. Речь идёт о чипах Xeon 6900P, которые, как ожидается, появятся на рынке в текущем квартале. Формальная презентация Xeon 6 Granite Rapids состоялась в начале июня текущего года — вместе с изделиями Xeon 6 Sierra Forest, построенными на энергоэффективных ядрах E-core. Для платформы Xeon 6 предусмотрено использование разъёмов LGA-4710 и LGA-7529: в первом случае заявлена поддержка чипов с TDP до 350 Вт и 8-канальной памяти, во втором — 500 Вт и 12-канальной памяти. При этом в обоих вариантах возможно построение двухсокетных серверов. Как стало известно, в семейство Xeon 6 Granite Rapids войдут модели с 32, 44, 56, 72, 96, 120 и 128 ядрами Redwood Cove. Они получат поддержку SMT и до 504 Мбайт L3-кеша. Величина TDP составит до 500 Вт. В частности, говорится о подготовке процессоров Xeon Platinum 6980P, 6979P, 6972P, 6952P и 6960P. Их базовая тактовая частота варьируется от 2,0 до 2,7 ГГц (см. характеристики). Для чипов Xeon 6 Granite Rapids заявлена поддержка памяти DDR5-6400 и MCR-8800, до 96 линий PCIe Gen 5.0/CXL 2.0 и до 6 линий UPI 2.0.

02.08.2024 [22:44], Владимир Мироненко

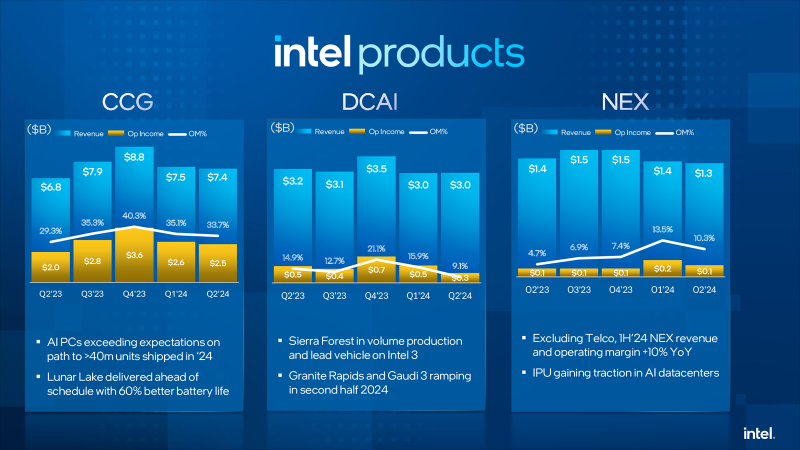

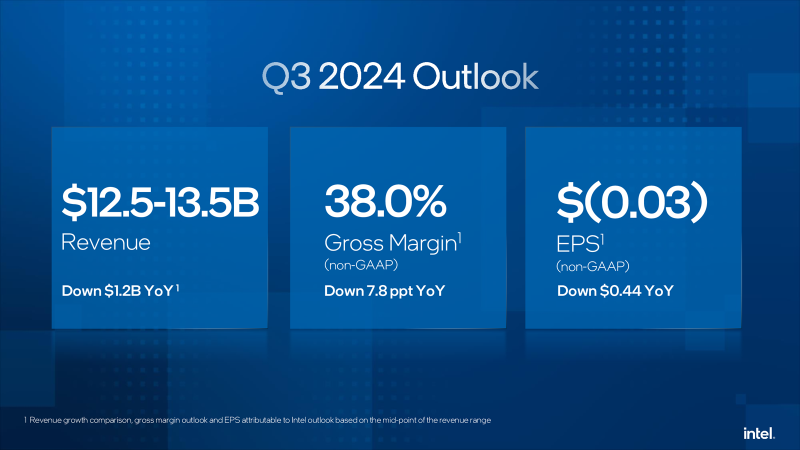

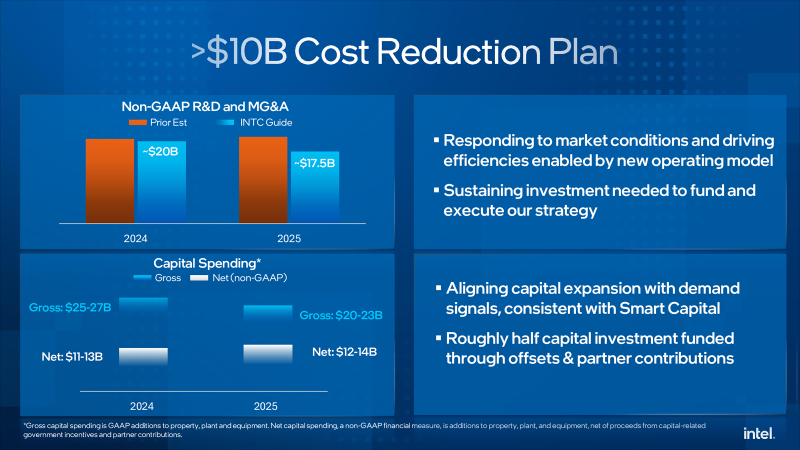

Intel пережила рекордное падение стоимости акций, но надеется со временем отыграться благодаря сегменту ЦОД и ИИКомпания Intel объявила результаты II квартала 2024 года, завершившегося 29 июня. Выручка компании составила $12,83 млрд, что меньше на 1 % год к году, а также ниже консенсус-прогноза аналитиков, опрошенных LSEG, равного $12,94 млрд. Intel завершила квартал с убытками в размере $1,61 млрд или $0,38 на акцию, хотя годом ранее у неё была чистая прибыль в размере $1,48 млрд или $0,35 на акцию. Скорректированная прибыль (Non-GAAP) составила $85 млн или $0,02 на акцию (падение год к году на 85 %), что ниже консенсус-прогноза аналитиков в размере $0,10 на акцию. Рынок отреагировал на результаты Intel, а также слабый прогноз на текущий квартал падением стоимости акций, обрушившейся на 26 % после открытия торгов в Нью-Йорке в пятницу, сократив рыночную стоимость компании примерно на $32 млрд. Это было самое большое дневное падение акций по крайней мере с 1982 года, пишет Bloomberg. Выручка когда-то самого прибыльного подразделения Datacenter and AI Group (DCAI), поставляющего решения для ЦОД и платформ ИИ, снизилась по сравнению с аналогичным кварталом прошлого года на 3 % до $3,05 млрд, оказавшись также ниже консенсунс-прогноза StreetAccount в размере $3,14 млрд. Как отметил ресурс Bloomberg, «это подразделение пока не достигло ничего похожего на присутствие на рынке NVIDIA в чипах-ускорителях, используемых в системах ИИ». Intel объявила, что более 130 млн процессоров Intel Xeon обеспечивают работу ЦОД по всему миру. У подразделения Network and Edge Group (NEX), специализирующегося на сетевых продуктах и периферийных вычислениях, выручка сократилась на 1 % до $1,34 млрд. Выручка подразделения Intel Foundry Service, занимающегося контрактным производством чипов, составила $4,32 млрд (рост год к году — 4 %). Группа Intel Client Computing, которая производит чипы для ПК, принесла $7,41 млрд, превысив прошлогодний результат на 9 % при консенсус-прогнозе аналитиков, опрошенных StreetAccount, в $7,42 млрд. В III квартале Intel прогнозирует скорректированный чистый убыток в размере $0,03 на акцию при выручке в ранее объявленном диапазоне $12,5–$13,5 млрд. Согласно прогнозу аналитиков, опрошенных LSEG, у компании показатель скорректированной прибыли составит $0,35 на акцию при выручке $14,35 млрд. По словам финансового директора Intel Дэйва Зинссера (Dave Zinsser), доход DCAI должен последовательно расти во II половине финансового года, «поскольку спрос на традиционные серверы немного улучшается». В текущем квартале компания планирует начать выпуск процессоров Xeon 6 на базе производительных ядер P-core (Granite Rapids). Также готовятся к выпуску в этом квартале ИИ-ускорители Gaudi3. Intel также объявила план сокращения расходов, включающий ряд инициатив по созданию устойчивого финансового драйвера, который ускорит рост прибыли и обеспечит дальнейшую операционную эффективность и гибкость, а также создаст возможности для постоянных стратегических инвестиций в технологии и лидерство в производстве. План предполагает структурную и операционную перестройку компании, сокращение штата, а также снижение операционных расходов и капитальных затрат более чем на $10 млрд в 2025 году. Так, компания намерена оптимизировать свою деятельность и существенно сократит расходы и численность персонала (более чем на 15 %,), сократив траты на НИОКР и маркетинг, общие и административные расходы (MG&A) без учёта GAAP примерно на $20 млрд в 2024 году и примерно на $17,5 млрд в 2025 году, с дальнейшим сокращением в 2026 году. Большую часть увольнений, которые коснутся по подсчётам ресурса The Verge около 19 тыс. сотрудников, компания намерена произвести до конца 2024 года. Также предполагается сократить валовые капитальные затраты в 2024 году более чем на 20 % по сравнению с предыдущими прогнозами, в результате они составят за год от $25 до $27 млрд, а чистые капитальные затраты в 2024 году будут находиться в диапазоне от $11 до $13 млрд. В 2025 году компания планирует валовые капитальные расходы от $20 до $23 млрд и чистые капитальные расходы от $12 до $14 млрд. Также, начиная с IV квартала, компания прекращает выплачивать дивиденды.

30.07.2024 [11:24], Сергей Карасёв

Одноплатный компьютер iBase IB962 на платформе Intel Meteor Lake рассчитан на ИИ-задачиКомпания iBase Technology представила одноплатный компьютер IB962, предназначенный для построения систем автоматизации, оборудования для ретейл-сферы и здравоохранения, а также периферийных устройств с поддержкой ИИ. В основу новинки положена аппаратная платформа Intel Meteor Lake U/H. Изделие имеет размеры 102 × 147 мм. В зависимости от модификации устанавливается процессор Core Ultra 7-165H (6P+8E+2LPE; 22 потока; до 5,0 ГГц) или Core Ultra 7-165U (2P+8E+2LPE; 14 потоков; до 4,9 ГГц). В первом случае присутствует графический контроллер Intel Arc, во втором — Intel Graphics Xe. Чипы наделены нейромодулем Intel AI Boost NPU для ускорения выполнения операций, связанных с ИИ.

Источник изображения: iBase Новинка снабжена двумя слотами SO-DIMM для модулей DDR5-5600 суммарным объёмом до 64 Гбайт. Есть коннекторы M.2 M-Key 2280 для SSD (NVMe; PCIe x4), M.2 E-Key 2230 для адаптера Wi-Fi и M.2 В–Key 3052 для сотового модема 5G/4G. Предусмотрены два порта SATA-3 для накопителей, сетевые контроллеры Intel I226LM 2.5GbE и Intel I226V 2.5GbE, а также I/O-чип Fintek F81804U-I. Одноплатный компьютер располагает двумя последовательными портами RS232/422/485, двумя гнёздами RJ-45 для сетевых кабелей, тремя портами USB 3.2 Type-A, портом USB 2.0, интерфейсами HDMI, DP++, LVDS и eDP. Возможен одновременный вывод изображения на несколько дисплеев высокого разрешения. За безопасность отвечает чип TPM. Имеется звуковой кодек ALC888S. Диапазон рабочих температур простирается от 0 до +60 °C. Напряжение питания может варьироваться от 12 до 24 В.

23.07.2024 [09:58], Сергей Карасёв

MSI представила индустриальный ПК MS-C907 с чипом Intel Alder Lake-N и двумя портами 2.5GbEКомпания MSI анонсировала компактный компьютер MS-C907, ориентированный на промышленный и коммерческий секторы. Устройство может применяться для создания систем автоматизации и контроля, построения информационных терминалов, транспортных ПК, ретейл-платформ и пр. Новинка заключена в корпус с габаритами 200 × 150 × 55 мм, а масса составляет 1,38 кг. Ребристая внешняя поверхность выполняет функции радиатора для отвода тепла. Диапазон рабочих температур простирается от -10 до +40 °C. Возможен монтаж на DIN-рейку или крепление VESA.

Источник изображения: MSI Установлен чип поколения Intel Alder Lake-N. Это может быть изделие Core i3-N305 (8C/8T; до 3,8 ГГц; 15 Вт) или Processor N97 (4C/4T; до 3,6 ГГц; 12 Вт). Применено пассивное охлаждение. Объём оперативной памяти DDR5-4800 достигает 16 Гбайт (один слот SO-DIMM). Предусмотрено посадочное место для одного SFF-накопителя (SSD/HDD) с интерфейсом SATA 3.0. В оснащение входят два сетевых контроллера Intel I225-V стандарта 2.5GbE, звуковой кодек Realtek ALC897 HD Audio, TPM-контроллер Infineon SLB9672VU2.0, а также коннекторы M.2 B key 2242/3042/2280 (SATA/PCIe x1) и M.2 E key 2230 (PCIe x1, USB 2.0), что позволяет добавить модуль беспроводной связи и (или) сотовый модем. Поддерживается вывод изображения одновременно на два монитора через интерфейсы HDMI (3840 × 2160 пикселей; 30 Гц) и DisplayPort (4096 × 2304 точки; 60 Гц). В набор разъёмов входят два гнезда RJ-45 для сетевых кабелей, шесть портов USB 2.0, по два порта USB 3.2 Gen2 и USB 3.2 Gen1, два последовательных порта, аудиовход и аудиовыход на 3,5 мм. Возможно подключение четырёх антенн беспроводной связи. Питание (9–36 В) подаётся через DC-разъём. Заявлена совместимость с Windows 10 IoT Enterprise 2021 LTSC, Windows 11 IoT Enterprise и Linux.

22.07.2024 [09:12], Сергей Карасёв

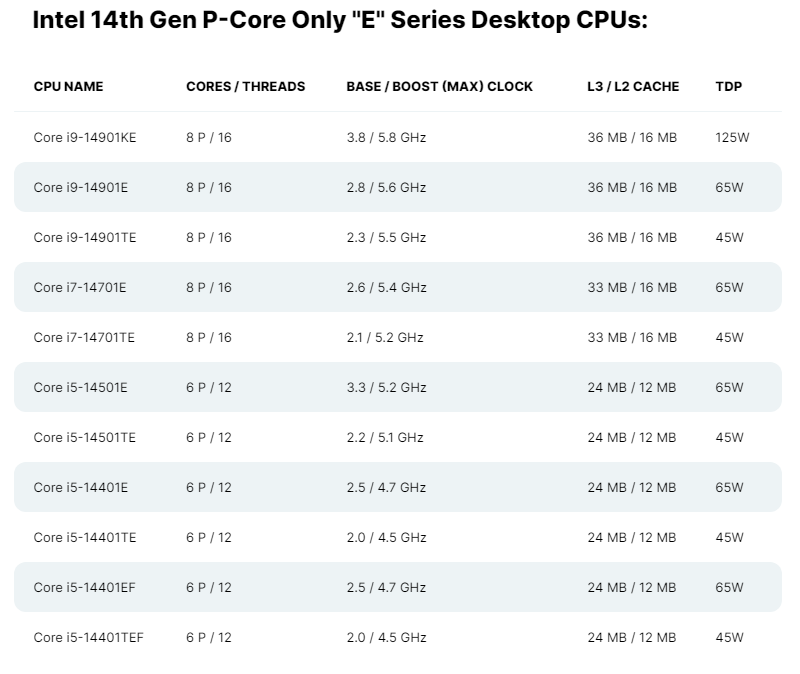

Intel представила чипы Raptor Lake Refresh с отключёнными E-ядрами для встраиваемых устройствКомпания Intel, по сообщению ресурса Wccftech, анонсировала процессоры Raptor Lake Refresh (Core 14-го поколения) для встраиваемых устройств. У этих чипов деактивирован кластер энергоэффективных Е-ядер (Gracemont) — они оперируют только производительными Р-ядрами (Raptor Cove). В общей сложности перечислены 11 моделей: Core i9-14901KE, Core i9-14901E, Core i9-14901TE, Core i7-14701E, Core i7-14701TE, Core i5-14501E, Core i5-14501TE, Core i5-14401E, Core i5-14401TE, Core i5-14401EF и Core i5-14401TEF. Они имеют исполнение LGA1700, а показатель TDP варьируется от 45 до 125 Вт. На вершине семейства располагается изделие Core i9-14901KE с восемью ядрами (16 потоков), базовая частота которого составляет 3,8 ГГц с возможностью динамического повышения до 5,8 ГГц. Объём кеша третьего уровня равен 36 Мбайт. Индекс «К» в обозначении указывает на возможность разгона. Возможно, данная особенность заинтересует DIY-энтузиастов.

Источник изображения: Wccftech В зависимости от модификации новые процессоры насчитывают шесть или восемь Р-ядер, при этом все чипы поддерживают технологию многопоточности. Возможна работа с двухканальной оперативной памятью DDR4/DDR5. Изделия с индексом «F» не имеют встроенного графического контроллера, тогда как модели «Т» обладают повышенной энергоэффективностью. Среди прочего упомянута поддержка PCIe 5.0 x16, PCIe 4.0 x4 (NVMe) и DMI 4.0 x8.

20.07.2024 [14:49], Сергей Карасёв

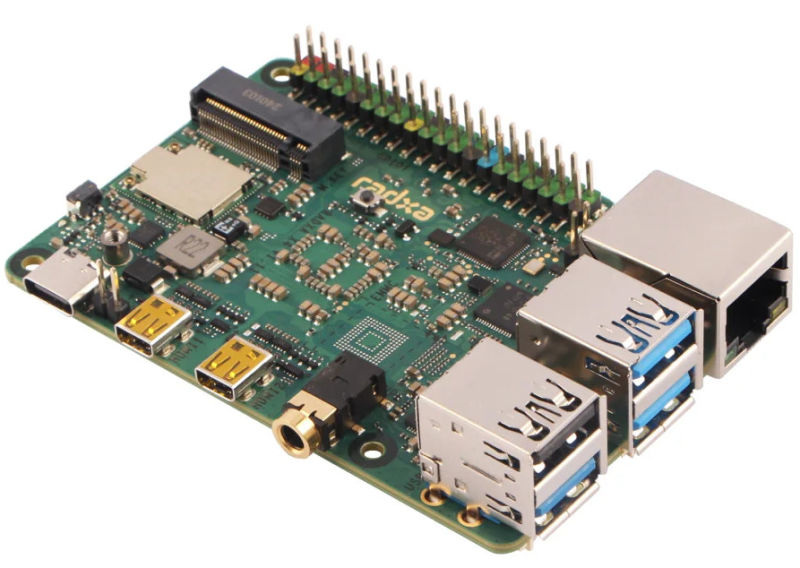

Intel N100 + Raspberry Pi RP2040: Radxa представила одноплатный компьютер X4Компания Radxa, по сообщению ресурса CNX-Software, выпустила одноплатный компьютер Radxa X4, который рассматривается в качестве альтернативы Raspberry Pi 5. Устройство выполнено на аппаратной платформе Intel Alder Lake-N, а в качестве ОС может применяться Windows 10/11, Debian или Ubuntu Linux. Новинка имеет размеры 85 × 56 × 20 мм. Используется чип Intel Processor N100 (4C/4T; до 3,4 ГГц; 6 Вт), работающий в тандеме с микроконтроллером Raspberry Pi RP2040 (два ядра Cortex-M0+), который отвечает за IO-функции. Объём оперативной памяти LPDDR5 может составлять 4 или 8 Гбайт (в будущем — 16 Гбайт). Предусмотрен коннектор M.2 M-Key 2230 для SSD с интерфейсом PCIe 3.0 x4 (NVMe). Кроме того, может быть добавлен флеш-модуль eMMC. В оснащение включён адаптер 2.5GbE с опциональной поддержкой PoE. Модель с 4 Гбайт ОЗУ укомплектована контроллерами Wi-Fi 5 и Bluetooth 5, а версия с 8 Гбайт памяти — Wi-Fi 6 и Bluetooth 5.2. В набор разъёмов входят два интерфейса micro-HDMI 2.0 с поддержкой 4Kp60, аудиогнездо на 3,5 мм, три порта USB 3.2 и порт USB 2.0, разъём USB Type-C (возможна подача питания) и гнездо RJ-45 для сетевого кабеля. Имеется 40-контактная колодка GPIO с поддержкой 2 × SPI, 2 × UART, 2 × I2C, 16 × PWM, 8 × PIO (Programmable IO), 1 × DC (5 В). Упомянут коннектор для подсоединения вентилятора охлаждения. Диапазон рабочих температур — от 0 до +60 °C. Цена Radxa X4 с 4 Гбайт ОЗУ составляет приблизительно $60, а за версию с 8 Гбайт памяти придется заплатить на $20 больше.

19.07.2024 [01:10], Владимир Мироненко

Круг замкнулся: отвечавшая за Xeon Лиза Спелман покинула Intel и возглавила отделившуюся от Intel Cornelis NetworksПоставщик сетевых решений Cornelis Networks объявил о назначении с 15 августа гендиректором Лизы Спелман (Lisa Spelman, на фото ниже). Она сменит на этом посту Филипа Мерфи (Philip Murphy), который займёт должность президента и главного операционного директора. Спелман переходит в Cornelis Networks из Intel, где она занимала руководящие должности на протяжении более двух десятилетий. До недавнего времени Спелман была корпоративным вице-президентом группы DCAI (ЦОД и ИИ) и генеральным менеджером подразделения Xeon Products and Solutions. Она также занимала ряд руководящих должностей в других подразделениях Intel. Как сообщил Мерфи, Спелман обладает беспрецедентной широтой и глубиной знаний во всех аспектах построения и масштабирования успешного бизнеса. По его словам, клиенты компании уже знают Спелман и верят в её способность помочь им создать необходимую инфраструктуру следующего поколения. Интерконнект Omni-Path, от которого в своё время отказалась Intel и который в итоге достался Cornelis Networks, используется научными, академическими, государственными и коммерческими организациями по всему миру. Впрочем, в последнем рейтинге TOP500 доля систем с этим интерконнектом составляет всего 6,4 %, а на решения именно Cornelis приходится и вовсе менее 1 %. Сейчас компания готовится к старту поставок решений следующего поколения CN5000, разработанных специально для сред ИИ и HPC и позволяющих удовлетворить растущие требования к масштабируемости сетевой инфраструктуры. Спелман отметила, что одной из самых серьёзных проблем, с которой компании сталкиваются при развитии ИИ-инфраструктуры — это наличие высокоэффективного интерконнекта, объединяющего CPU, GPU и ускорители: «Способность объединить эти ресурсы высокоэффективным способом влияет на конкурентоспособность организации в мире ИИ».

08.07.2024 [11:29], Сергей Карасёв

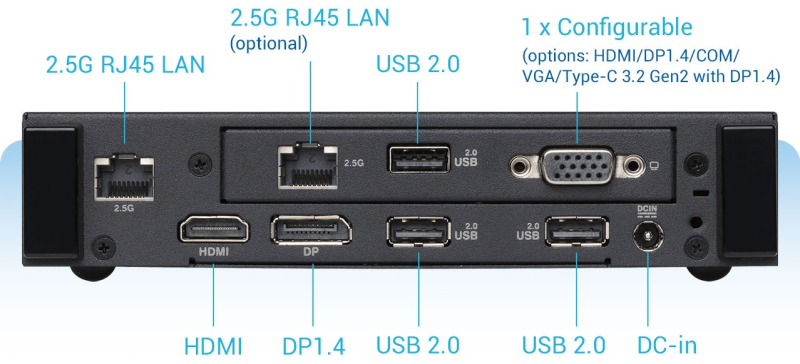

Компактный компьютер ASUS ExpertCenter PN43 оснащён двумя портами 2.5GbEКомпания ASUS анонсировала компьютер небольшого форм-фактора ExpertCenter PN43, предназначенный для использования в бизнес-сфере. В основу устройства положена аппаратная платформа Intel Alder Lake-N, а в качестве ОС может применяться Windows 11 Pro. Доступны модификации с чипом Intel Processor N200 (4C/4T; до 3,7 ГГц; 6 Вт), Intel Processor N100 (4C/4T; до 3,4 ГГц; 6 Вт) и Intel Processor N97 (4C/4T; до 3,6 ГГц; 12 Вт). Есть один слот для модуля памяти DDR4 SO-DIMM ёмкостью до 32 Гбайт и коннектор M.2 2280 для SSD с интерфейсом PCIe 3.0 x4. Устройство заключено в корпус с габаритами 166,2 × 119,7 × 33,9 мм, а масса составляет 0,7 кг. В оснащение входят адаптеры Intel Wi-Fi 6E (Gig+) 2 × 2 и Bluetooth 5.3, двухпортовый сетевой контроллер 2.5GbE. Питание подаётся от внешнего блока мощностью 65 Вт. Допускается монтаж при помощи крепления VESA. На фронтальную панель выведены четыре порта USB 3.2 Gen1 Type-A, гнездо для микрофона и аудиовыход. Сзади располагаются три порта USB 2.0, интерфейсы DisplayPort 1.4 и HDMI 2.1 (до 4K; 60 Гц), два гнезда RJ-45 для сетевых кабелей, конфигурируемый разъём (USB Type-C, D-Sub или последовательный порт), гнездо для блока питания. Возможен одновременный вывод изображения на два дисплея формата 4K или на три монитора Full HD. ASUS ExpertCenter PN43 предлагается в модификациях с активным (вентилятор) и пассивным охлаждением. Верхняя и боковые панели имеют перфорацию для циркуляции воздуха.

08.07.2024 [11:29], Сергей Карасёв

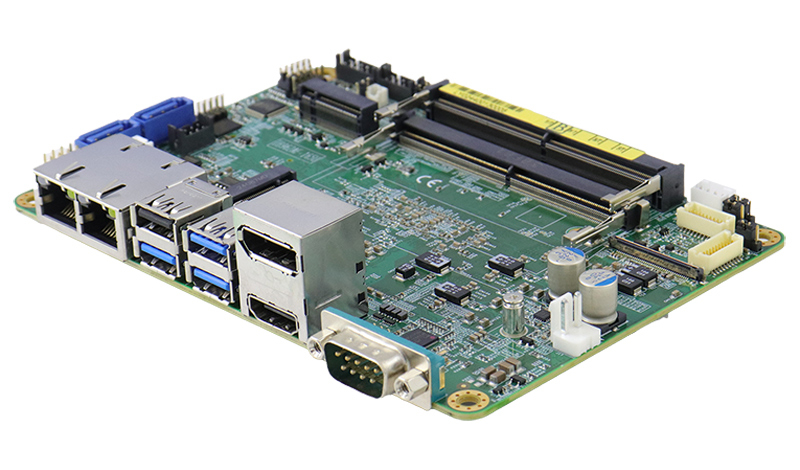

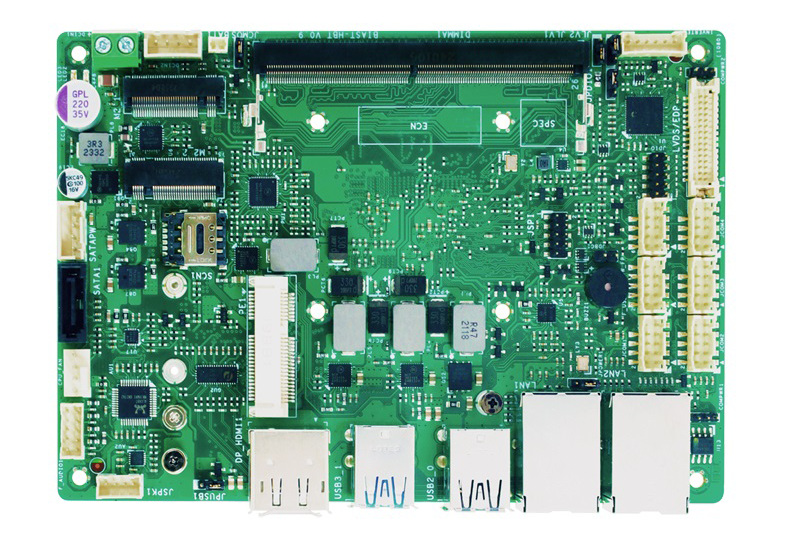

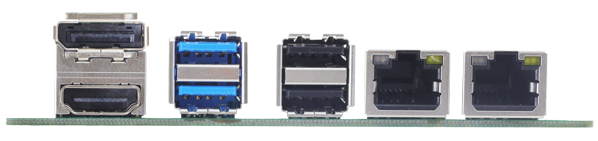

Индустриальная плата Biostar Biast-Pat оснащена процессором Intel Amston LakeКомпания Biostar представила материнскую плату Biast-Pat, ориентированную на промышленный сектор. На базе новинки могут создаваться системы автоматизации, edge-компьютеры, устройства для интеллектуального Интернета вещей (AIoT) и пр. Основой служит платформа Intel Amston Lake. Размеры составляют 148 × 102 мм. Стандартная версия имеет диапазон рабочих температур от 0 до +60 °C. Кроме того, опционально предлагается модификация, которая может эксплуатироваться при температурах от -40 до +85 °C. Установлен процессор Intel Atom x7433RE с четырьмя ядрами (до 3,4 ГГц; 9 Вт) и ускорителем Intel UHD Graphics. Предусмотрен слот SO-DIMM для модуля оперативной памяти DDR5-4800 ёмкостью до 16 Гбайт. В оснащение входят звуковой кодек Realtek ALC897 HD Audio и сетевой контроллер Intel I226-V с двумя портами 2.5GbE.

Источник изображения: Biostar Материнская плата располагает коннектором M.2 Key B (USB 3.2, PCIe х1, слот SIM) для сотового модема 4G/5G, разъёмом M.2 Key M (PCIe x1) для SSD формата 2242/2280, портом SATA-3 для накопителя. Опционально может быть установлен ИИ-ускоритель Hailo-8 с производительностью до 26 TOPS.  Для вывода изображения могут быть задействованы интерфейсы LVDS и eDP, HDMI2.0b (до 4096 × 2160 пикселей; 60 Гц) и DP++ (до 4096 × 2160 точек; 60 Гц). Новинка несёт на борту IO-чип ITE IT8786. Есть по два порта USB 2.0 и USB 3.0, а также два гнезда RJ-45 для сетевых кабелей. Через разъёмы на самой плате можно использовать последовательные порты RS232/422/485. Заявлена совместимость с операционными системами Windows 10 Pro/IoT Enterprise, Windows 11 и Linux.

04.07.2024 [11:49], Руслан Авдеев

MSI представила сверхкомпактный ПК MS-C918 с Intel N100 и Windows 11 IoT EnterpriseКомпания MSI представила очередной мини-компьютер размером с ладонь — MS-C918. Новинка рассчитана на применение в офисе, для обеспечения работы цифровых вывесок, конференц-систем и др. Новинка оснащена четырёхъядерным процессором Intel N100, до 4 Гбайт оперативной памяти LPDDR5 и 128 Гбайт постоянной eMMC с предустановленной ОС Windows 11 IoT Enterprise. Мини-ПК получил да порта HDMI 2.0, включая один с поддержкой HDMI CEC, гигабитным Ethernet-интерфейсом, Wi-Fi 6E и Bluetooth 5.2, а также тремя портами USB 3.2/2.0.

Источник изображения: MSI Спецификации:

Источник изображения: MSI Возможен монтаж с помощью VESA-креплений. По умолчанию компьютер оснащается 64-бит Windows 11 IoT Enterprise версии 22H2 с поддержкой в течение минимум 10 лет. В самой компании характеризуют мини-ПК как «небольшую промышленную коробочку», хотя на работу в действительно жёстких промышленных средах и за пределами помещений она не рассчитана. |

|