Материалы по тегу: in-memory

|

13.06.2024 [10:48], Сергей Карасёв

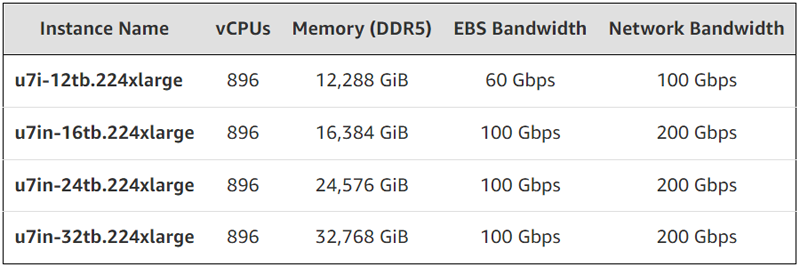

896 vCPU и 32 Тбайт памяти: AWS объявила о доступности сверхбольших инстансов EC2 U7iОблачная платформа Amazon Web Services (AWS) сообщила о доступности инстансов Elastic Compute Cloud (EC2) U7i, оптимизированных для резидентных (in-memory) баз данных. В основу положены кастомизированные процессоры Intel Xeon поколения Sapphire Rapids. Утверждается, что по сравнению с инстансами EC2 High Memory предыдущего поколения экземпляры U7i обеспечивают на 135 % более высокую вычислительную производительность и на 115 % большую производительность памяти. При этом пропускная способность EBS-томов увеличена в 2,5 раза. Инстансы поддерживают подключение до 128 томов EBS gp2/gp3 или io1/io2. Каждый том io2 Block Express может иметь размер до 64 ТиБ и обеспечивать производительность до 256 тыс. IOPS со скоростью до 32 Гбит/с. Все конфигурации включают 896 vCPU, а объём оперативной памяти варьируется от 12 288 до 32 768 ГиБ. Благодаря системе AWS Nitro вся память доступна для использования. Пропускная способность EBS составляет 60 Гбит/с у младшей версии и 100 Гбит/с у всех остальных. Пропускная способность сети — соответственно 100 и 200 Гбит/с.

Источник изображения: AWS Среди поддерживаемых ОС названы Amazon Linux, Red Hat Enterprise Linux, SUSE Linux Enterprise Server, Ubuntu и Windows Server. Говорится о возможности работы с крупными СУБД, в частности, SAP HANA, Oracle и SQL Server. Инстансы EC2 U7i были представлены в качестве предварительной версии в ноябре 2023 года. Теперь они доступны для клиентов в американских регионах AWS US East (Северная Вирджиния) и US West (Орегон), а также в Азиатско-Тихоокеанском регионе (Сеул, Сидней). Позднее в текущем году будут запущены более мощные инстансы с увеличенной вычислительной производительностью.

21.05.2024 [19:37], Сергей Карасёв

Российский сервер с четырьмя Intel Xeon Sapphire Rapids: Fplus представила платформу «Буран-SR242»

fplus

hardware

in-memory

intel

sapphire rapids

xeon

импортозамещение

марвел

россия

сделано в россии

сервер

Компания Fplus анонсировала первый, по её словам, российский сервер, поддерживающих установку четырёх процессоров. Система под названием «Буран-SR242» (SR-242E31-624T) предназначена для решения ИИ-задач, работы с большими данными, создания цифровых двойников, НРС-нагрузок и пр. Сервер выполнен в форм-факторе 2U на платформе Intel Xeon Sapphire Rapids. Каждый из четырёх процессоров (TDP до 350 Вт) может насчитывать до 60 ядер. Поддерживается до 16 Тбайт оперативной памяти DDR5 в виде 64 модулей. Во фронтальной части располагаются 24 отсека для SFF-накопителей SAS/SATA/NVMe, а сзади находятся ещё два посадочных места для SFF-устройств SATA. Кроме того, можно установить два модуля M.2 SATA/NVMe объёмом до 4 Тбайт каждый. Упомянута поддержка массивов RAID 0/1/10/1E/5/50/6/60. По заявлениям Fplus, новинка сконструирована так, чтобы заказчики могли легко интегрировать её в уже существующую IT-инфраструктуру. Четырехсокетное исполнение позволяет наращивать производительность постепенно и таким образом уменьшать размер первоначальных инвестиций, говорит компания. Кроме того, возможна установка двух двухслотовых карт расширения с TDP до 300 Вт. Слоты расширения выполнены по схеме 6 × PCIe 5.0 и 2 × PCIe 4.0. Есть выделенный порт PCIe 5.0 для карты OCP 3.0. Питание обеспечивают два блока с сертификатом Platinum мощностью до 2700 Вт. За охлаждение отвечают шесть вентиляторов диаметром 60 мм с резервированием N+1 и возможностью горячей замены. Диапазон рабочих температур простирается от 10 до +35 °C. Fplus полностью контролирует процесс разработки и производства сервера, а на площадке компании реализуются меры по повышению качества конечной продукции. Физические модули TPM 2.0 (Trust Platform Module) и TCM 2.0 (Trusted Cryptography Module) служат для хранения криптографических ключей, применяемых при обновлении внутреннего ПО. «Выпускать "Бураны" будут на нескольких площадках в России, в том числе на заводе Fplus в Подмосковье. Производственный процесс выстроен с учётом балльной системы локализации, чтобы в дальнейшем устройства вошли в реестр Минпромторга», — отмечает компания. Говорится также, что до сих пор в сегменте четырёхсокетных серверов доминировали зарубежные производители — почти все объёмы закрывались параллельным импортом. Системы с поддержкой четырёх процессоров также есть в ассортименте «DатаРу».

24.08.2022 [22:42], Владимир Мироненко

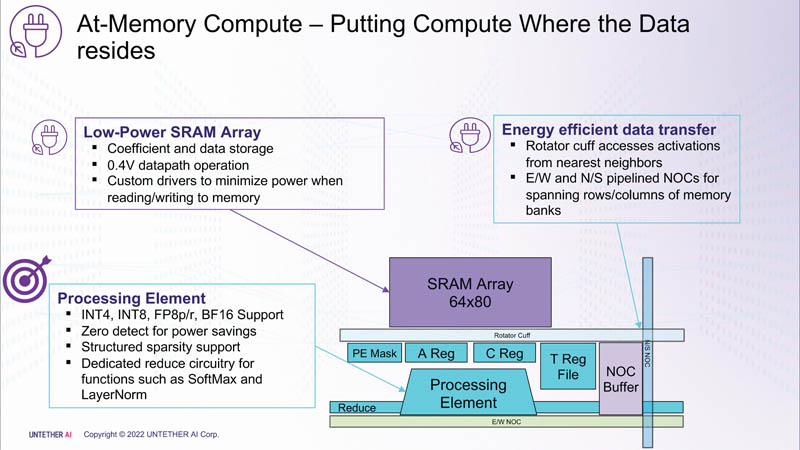

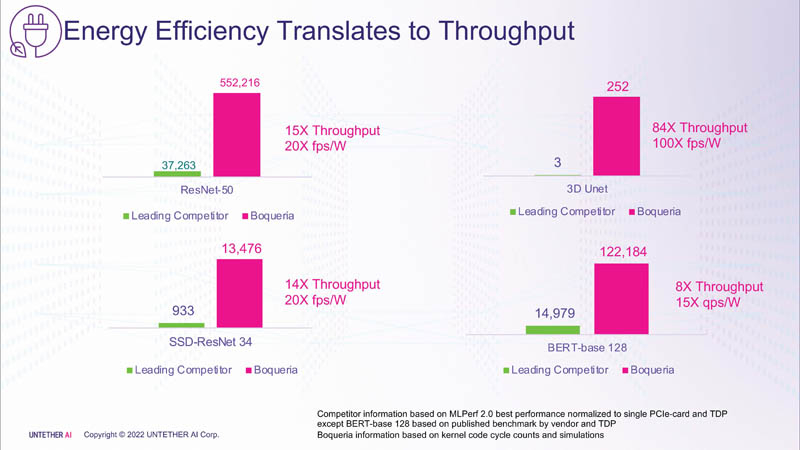

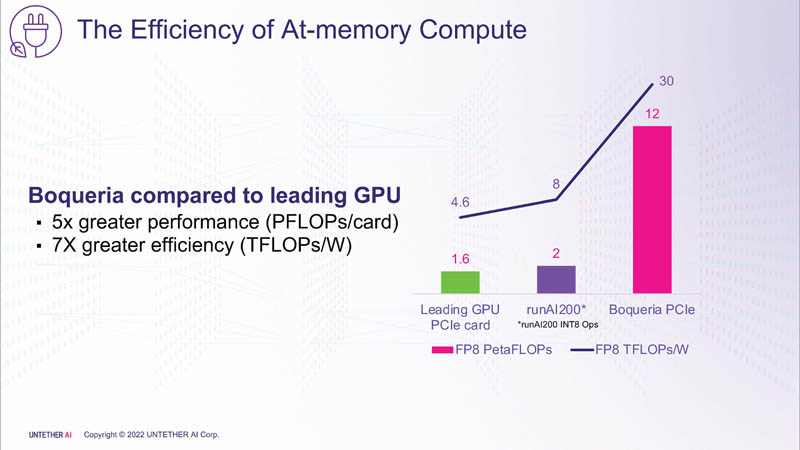

Untether AI представила ИИ-ускоритель speedAI240 — 1,5 тыс. ядер RISC-V и 238 Мбайт SRAM со скоростью 1 Пбайт/сКомпания Untether AI анонсировала ИИ-архитектуру следующего поколения speedAI (кодовое название «Boqueria»), ориентированную на инференс-нагрузки. При энергоэффективности 30 Тфлопс/Вт и производительности до 2 Пфлопс на чип speedAI устанавливает новый стандарт энергоэффективности и плотности вычислений, говорит компания. Поскольку at-memory вычисления в ряде задач значительно энергоэффективнее традиционных архитектур, они могут обеспечить более высокую производительность при одинаковых затратах энергии. Первое поколение устройств runAI в 2020 году Untether AI достигла энергоэффективности на уровне 8 Тфлопс/Вт для INT8-вычислений. Новая архитектура speedAI обеспечивает уже 30 Тфлопс/Вт. .jpg)

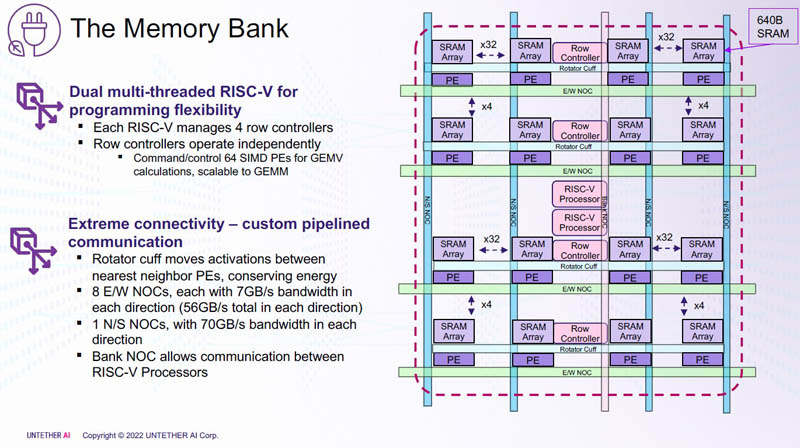

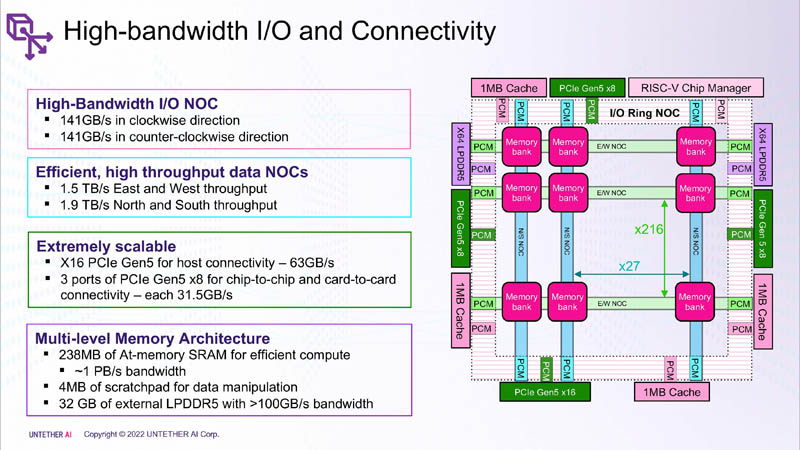

Изображения: Untether AI (via ServeTheHome)  Этого удалось добиться благодаря архитектуре второго поколения, использованию более 1400 оптимизированных 7-нм ядер RISC-V (1,35 ГГц) с кастомными инструкциями, энергоэффективному управлению потоком данных и внедрению поддержки FP8. Вкупе это позволило вчетверо поднять эффективность speedAI по сравнению с runAI. Новинка может быть гибко адаптирована к различным архитектурам нейронных сетей. Концептуально speedAI напоминает ещё один тысячеядерный чип RISC-V — Esperanto ET-SoC-1.   Первый член семейства speedAI — speedAI240 — обеспечивает 2 Пфлопс вычислениях в FP8-вычислениях или 1 Пфлопс для BF16-операций. Благодаря этому обеспечивается самая высокая в отрасли эффективность — например, для модели BERT заявленная производительность составляет 750 запросов в секунду на Вт (qps/w), что, по словам компании, в 15 раз выше, чем у современных GPU. Добиться повышения производительности удалось благодаря тесной интеграции вычислительных элементов и памяти.   На каждый блок SRAM объёмом 328 Кбайт приходится 512 вычислительных блоков, поддерживающих работу с форматами INT4, INT8, FP8 и BF16. Каждый вычислительный блок имеет два 32-бит (RV32EMC) кастомных ядра RISC-V с поддержкой четырёх потоков и 64 SIMD. Всего есть 729 блоков, так что суммарно чип несёт 238 Мбайт SRAM и 1458 ядер. Блоки провязаны между собой mesh-сетью, к которой также подключены кольцевая IO-шина, несущая четыре 1-Мбайт блока общего кеша, два контроллера LPDRR5 (64 бит) и порты PCIe 5.0: один x16 для подключения к хосту и три x8 для объединения чипов. Суммарная пропускная способность SRAM составляет около 1 Пбайт/с, mesh-сети — от 1,5 до 1,9 Тбайт/с, IO-шины — 141 Гбайт/c в обоих направлениях, а 32 Гбайт DRAM — чуть больше 100 Гбайт/с. PCIe-интерфейсы позволяют объединить до трёх ускорителей, с шестью speedAI240 чипами у каждого. Решения speedAI будут предлагаться как в виде отдельных чипов, так и в составе готовых PCIe-карт и M.2-модулей. Ожидается, что первые поставки избранным клиентам начнутся в первой половине 2023 года. |

|