Материалы по тегу: электропитание

|

03.10.2025 [17:41], Руслан Авдеев

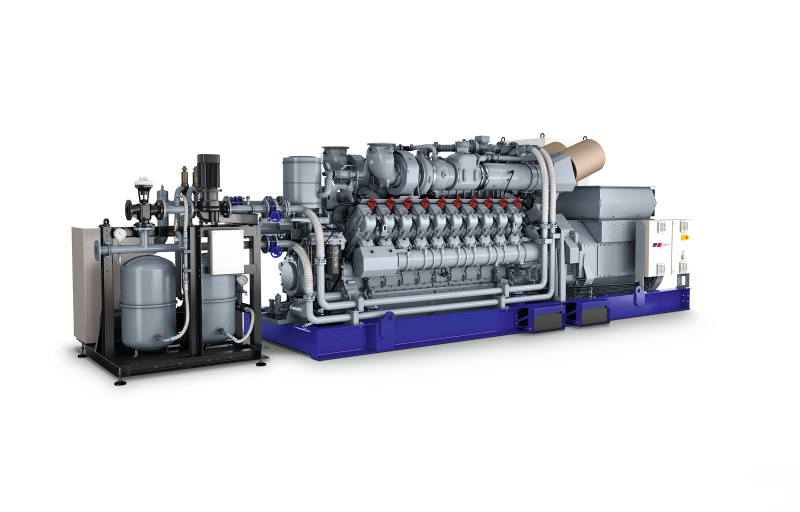

До 2,8 МВт за 45 с: Rolls-Royce представила газовый генератор mtu 20V4000 L64 для дата-центровRolls-Royce представил 20-цилиндровый газовый генератор mtu 20V4000 L64, созданный специально для дата-центров. Отличительной чертой новинки является возможность выхода на полную мощность 2,8 МВт всего за 45 с, тогда как нынешним генераторам серии mtu 4000 для этого требуется 120 с. Отсутствие редуктора делает новую модель компактной и оптимальной для рынка ЦОД в качестве как резервного, так и основного источника питания. Новый генератор станет доступен в 2026 году. По информации Rolls-Royce, он будет иметь на 10 % большую производительность в сравнении с уже имеющимися в продаже моделями. Модель ориентирована в первую очередь на североамериканский рынок, т.к. генерирует ток с частотой 60 Гц. В компании полагают, что природный газа всё активнее будет использоваться для питания ИИ ЦОД, в частности в Северной Америке, где он относительно недорог и широко доступен. Компания заявила, что генератор оптимально подойдёт для дата-центров в местах, где ёмкости энергосети недостаточно для новых нагрузок вводящихся в эксплуатацию ЦОД. Таким образом, использование генератора в качестве независимой электростанции позволит операторам ЦОД получать электричество быстрее, чем ждать стабильного сетевого подключения. Решение большой мощности с быстрым запуском более привлекательно для клиентов, считает компания. Как заявляют в Rolls-Royce Power Systems, с учётом того, что энергопотребление дата-центров в мире должно удвоиться к 2030 году, клиентам понадобятся эффективные, устойчивые и безопасные решения. Именно поэтому компания продолжит активно инвестировать в расширение портфолио генераторов и различные технологии, чтобы обеспечить клиентам наилучшие решения, в том числе соответствующие требованиям будущего. В августе 2025 года Rolls-Royce объединила усилия с производителем синтетического топлива e-fuel — Ineratec для использования e-diesel в качестве альтернативы дизельному топливу, полученному из нефти. Основной фокус пока делается на немецком секторе рынка ЦОД, где Rolls-Royce пытается внедрить использование e-diesel на своих резервных энергетических установках в дата-центрах. Помимо газовых генераторов, Rolls-Royce занимает и разработкой малых модульных реакторов (SMR). Сообщается, что Rolls-Royce сделала ставку на малые модульные реакторы (SMR). Это должно помочь удовлетворить спрос на электроэнергию со стороны ИИ ЦОД. По словам руководства компании, такая стратегия может вывести промышленного гиганта в лидеры Лондонской фондовой биржи.

27.09.2025 [16:44], Руслан Авдеев

Horizon Fuel Cell представила 3-МВт модуль с водородными топливными элементами для замены дизель-генераторовHorizon Fuel Cell представила 40′ модуль Horizon Packs мощностью 3 МВт для резервного питания дата-центров. По словам компании, её ячейки способно вырабатывать на 100 % больше энергии, чем стандартные элементы с протонообменной мембраной (PEM), и на 300 % — чем твердооксидные топливные элементы (SOFC), набирающие популярность на рынке ЦОД, сообщает Datacenter Dynamics. Как сообщают в Horizon, подобная компактность решения возможна благодаря использованию 400-кВт элементов, созданных для большегрузных автомобилей на водороде. В компании заявляют, что новое контейнерное решение идеально вписывается в инфраструктуру ЦОД благодаря высокой мощности на единицу объёма, компактности и низкому уровню углеродных выбросов — выхлопом в данном случае является обычная вода. Также компания предложила и модули хранения водорода (1 т), которые также размещаются в стандартных 40′ контейнерах. Комплект из нескольких модулей способен обеспечить от 8 до 40 часов резервного электроснабжения, при этом совокупная стоимость владения (TCO) при массовом развёртывании будет сопоставима с таковой у дизельных генераторов.

Источник изображения: Horizon Fuel Cell Horizon основана в 2003 году, штаб-квартира компании расположена в Сингапуре. Компания заявляет об установленной производственной мощности более 1,5 ГВт в год. Сегодня она предлагает широкий спектр топливных ячеек PEM, а также различные решения для хранения водорода. Пока Horizon размещает системы на топливных элементах преимущественно на химических производствах, где водород является побочным продуктов, но не прочь освоить и рынок ЦОД. Топливные элементы на водороде начали набирать популярность на рынке ЦОД среди операторов, ищущих автономные решения с низким уровнем углеродных выбросов. Самым заметным игроком на рынке является Bloom Energy, предлагающая твердооксидные элементы компаниям вроде CoreWeave, AWS и др. В июле 2025 года компания стала первой, заключившей прямое соглашение с гиперскейлером — компанией Oracle по обеспечению энергией всего ЦОД с помощью SOFC. Также она заключила соглашение и с Equinix и американской энергетической группой American Electric Power. Несколько операторов дата-центров также экспериментировали с использованием водородных топливных элементов для резервного питания своих объектов. Так, в 2024 году Microsoft и Caterpillar реализовали специальный демонстрационный проект по питанию ЦОД в Шайенне (Cheyenne, Вайоминг), оборудование успешно снабжала дата-центр энергией в течение двух суток.

21.09.2025 [13:40], Сергей Карасёв

Schneider Electric готовит стойки NVIDIA GB300 NVL72 мощностью 142 кВтКомпания Schneider Electric анонсировала две эталонные платформы, призванные ускорить построение инфраструктур для дата-центров, ориентированных на ресурсоёмкие нагрузки ИИ и НРС. Разработка систем ведётся в партнёрстве с NVIDIA. Один из проектов предусматривает создание референсных стоек для суперускорителей NVIDIA GB300 NVL72. Такие стойки смогут обеспечивать мощность до 142 кВт. Предусмотрено использование жидкостного охлаждения. В одном машинном зале могут быть расположены три кластера GB300 NVL72, насчитывающих в общей сложности до 1152 ускорителей. Отмечается, что в основу решения положены наработки и опыт, полученные в ходе реализации аналогичного проекта для NVIDIA GB200 NVL72. Клиентам будет доступна специальная среда моделирования на базе вычислительной гидродинамики (CFD): могут применяться цифровые двойники для оценки различных конфигураций электропитания и охлаждения с целью оптимизации платформ под определённые нужды.

Источник изображения: Schneider Electric Второй эталонный проект, как утверждается, представляет собой первую и единственную в отрасли платформу, предполагающую интеграцию систем управления питанием и жидкостным охлаждением, включая решения Motivair (контрольный пакет акций этой фирмы Schneider Electric приобрела в конце 2024 года). Для новой платформы заявлена совместимость с NVIDIA Mission Control — программным обеспечением NVIDIA для контроля производственных процессов и оркестрации работы ИИ-систем, включая управление кластерами и рабочими нагрузками. В таких системах могут применяться суперускорители GB300 NVL72 и GB200 NVL72. Подчёркивается, что новые эталонные решения являются результатом продолжающегося сотрудничества Schneider Electric и NVIDIA, которое направлено на удовлетворение растущих потребностей операторов дата-центров в области ИИ.

19.09.2025 [09:27], Руслан Авдеев

Ирландия разрешит ЦОД подключаться к электростанциям на ископаемом топливе — в качестве временной мерыИрландия намерена временно разрешить дата-центрам использовать электричество, полученное от электростанций на ископаемом топливе. Это лишь подчёркивает конфликт целей — достижения экономического роста и борьбы с изменениями климата, сообщает Bloomberg. Пока у строителей ЦОД нет официальных указаний относительно реализации февральского предложения местного регулятора — фактически оно предоставляло бы возможность операторам ЦОД заниматься генерацией энергии самостоятельно. По словам источника, знакомого с позицией властей, предполагалось даже разрешить прокладку кабелей к действующим электростанциям на природном газе. В июле также было опубликовано временное положение о частных ЛЭП, хотя в опубликованном проекте об ископаемом топливе не упоминалось вовсе. Представители властей заявляли, что частные линии электропередачи должны ускорить внедрение возобновляемых источников энергии и систем её накопления/хранения. AWS, Google и Microsoft уже призывали власти Ирландии дать возможность строить частные ЛЭП для подключения своих ЦОД к возобновляемым источникам энергии.

Источник изображения: Wallace Bentt/unsplash.com Спрос на ЦОД истощает энергетические возможности по всему миру, от Испании, до соседней Великобритании, где всерьёз рассчитывают расширить рынок ИИ с помощью американского бизнеса, но полагаются на развитие атомной энергетики. Ирландия, как самый зрелый рынок ЦОД в регионе, испытывает самую большую нагрузку, но целый ряд факторов мешают модернизации энергосистемы и инвестициям. По словам экспертов, мало конкретных данных о том, как удастся добиться лидирующих позиций в области ИИ и защиты климата. Позиция регуляторов ещё не до конца выработана, но, вероятно, будет обнародована в ближайшее время. Политику в отношении частных энергосетей намерены законодательно закрепить, возможно, до конца следующего года. Пока правительство Ирландии работает над устранением некоторых ограничений в сфере электроснабжения. В марте власти одобрили планы создания аварийной СПГ-станции для повышения энергетической безопасности, это ещё один из признаков того, что цели по борьбе с климатическими изменениями всё труднее согласовать с другими национальными приоритетами. Как сообщает Bloomberg, Евросоюз в целом сталкивается с противодействием со стороны отдельных государств, пытаясь добиться целей по борьбе с климатическими изменениями к 2040 году. Многие обеспокоены влиянием этих целей на состояние промышленности и домохозяйств.

18.09.2025 [09:02], Руслан Авдеев

Вы нам — SMR, мы вам — ядерное топливо: американские и британские компании подписали целый ряд соглашению по развитию АЭС для питания ЦОДБританский Ноттингемшир готовится принять первый в Европе дата-центр с питанием от малого модульного реактора (SMR). Holtec International, EDF UK и Tritax Management подписали Меморандум о взаимопонимании, предусматривающий создание ЦОД мощностью 1 ГВт, запитанного от SMR Holtec, сообщает Datacenter Dynamics. Объекты планируют разместить на месте бывшей угольной электростанции Cottam, закрытой в 2019 году. Для проекта потребуется около 365 га: порядка 60 га для дата-центра ЦОД и 100 га для SMR, который построит компания EDF, опираясь на дизайн Holtec-300 SMR. Tritax сосредоточится исключительно на строительстве ЦОД силами своей специализированной энергетической группы. Участок идеально подходит для подобного проекта, поскольку имеются коммуникации для подключения к энергосети и необходимая критическая инфраструктура. Запуск запланирован на конец десятилетия. ЦОД войдёт в суперкластер Trent Valley Supercluster, представленный британскому правительству в качестве «зоны роста ИИ». Если первоначально электроснабжение будет осуществляться через сеть и с помощью возобновляемых источников энергии, то в 2030 году планируется ввести в эксплуатацию SMR неназванной мощности. Установка Holtec-300 SMR в норме рассчитана на 300 МВт. Пока проект оценивают регуляторы США и Великобритании. Ранее Holtec уже заявляла о намерении построить два блока SMR-300 в ходе перезапуска АЭС Palisades в Мичигане (США).

Источник изображения: Serena Repice Lentini/unsplash.com Сообщается, что SMR в новом британском проекте потенциально обойдутся в $15 млрд и позволят создать тысячи рабочих мест. Благодаря новой инициативе Великобритания имеет возможность вступить в «клуб» стран, внедряющих SMR-300. Дополнительно проект должен привлечь в страну инвестиции, в т.ч. на производство ядерного топлива, производство турбин Arabelle и сопутствующие сервисы Framatome. Holtec International и EDF UK взаимодействуют с правительствами Великобритании и США, включая структуры Great British Energy – Nuclear и Фонд национального благосостояния. Кроме того, было объявлено и ещё о четырёх проектах. Так, американский разработчик SMR X-energy заключил соглашение с британской энергокомпанией Centrica по развёртыванию до 12 SMR в Хартлпуле (Hartlepool) в рамках более широкой британской программы по развёртыванию 6 ГВт ядерных мощностей. Экономический эффект от полного внедрения оценивается более чем в £40 млрд ($51 млрд). Ещё один разработчик SMR — Last Energy — совместно с британской логистической DP World построит один из первых микрореакторов в логистическом хабе London Gateway. Проект с частными инвестициями в объёме £80 млн ($102 млн) призван обеспечить «чистый» источник энергии для будущего расширения хаба. Наконец, разработчик микрореакторов TerraPower, поддерживаемый Биллом Гейтсом, объединился с инженерами из KBR для изучения возможности размещения в Великобритании свих натриевых реакторов, которые также можно интегрировать с гигаваттными системами накопления тепловой энергии.

EDF Urenco, занятая обогащением урана, подписала с американским разработчиком SMR Radiant соглашение на £4 млн ($5,1 млн) на поставку уранового топлива HALEU в США. Urenco строит при поддержке властей фабрику по производству топлива в Великобритании, а также рассматривает возможность строительства завода в Соединённых Штатах. Все сделки связаны с компаниями, которые либо уже сотрудничают с рынком ЦОД, либо проявили интерес к соответствующему сектору. X-energy поддерживается Amazon (AWS) , которая напрямую инвестировала в компанию и согласилась закупать энергию после того, как её продукт выйдет на рынок, в рамках партнёрства с американской энергетической компанией Energy Northwest. Ранее в 2025 году Last Energy подписала соглашение о строительстве 30 микрореакторов по 20 МВт на участке площадью 80 га в Техасе, для обслуживания рынка ЦОД в США. В августе калифорнийская Radiant, занимающаяся микрореакторами, заключила соглашение с разработчиком ЦОД Equinix на поставку 20 SMR Kaleidos мощностью 1,2 МВт. Наконец, в январе TerraPower подписала меморандум о взаимопонимании с Sabey Data Centers (SDC) с целью изучения возможности развёртывания SMR Natrium мощностью 345 МВт в действующих и будущих ЦОД SDC.

17.09.2025 [17:21], Руслан Авдеев

xAI готовится установить рекорд по созданию гигаваттного ИИ ЦОД Colossus 2Хотя 300-МВт ИИ-суперкомпьютер Colossus 1 с десятками тысяч ускорителей стал крупнейшим из функционирующих объединённых кластеров (не считая платформ Google на собственных чипах TPU), компания xAI задаёт новые стандарты проектом Colossus 2. На этот раз xAI готовится потягаться с конкурентами вроде OpenAI, Meta✴ и Anthropic, уже строящих кампусы гигаваттного уровня, сообщает SemiAnalysis. По оценкам аналитиков, новый единый ИИ-кластер xAI превзойдёт аналогичные проекты Meta✴ и Anthropic уже в III квартале 2025 года. Мощности будут готовы для установки ускорителей и создания крупнейшего отдельного кампуса ЦОД в мире. Для покупки чипов xAI ещё предстоит привлечь средства, но квоты на ускорители NVIDIA уже выделила, так что в начале 2026 года можно начать полнофункциональное обучение новых моделей. Работа над Colossus 2 стартовала в марте 2025 года, когда xAI приобрела огромный склад в Мемфисе и две прилегающих площадки общей площадью около 40 га. К 22 августа эксперты насчитали у объекта 119 чиллеров, что примерно соответствует 200 МВт холодоснабжения. Этого достаточно, чтобы обеспечить работу около 110 тыс. GB200 NVL72. По словам главы компании Илона Маска (Elon Musk), часть суперускорителей была развёрнута уже в июле. Утверждается, что за 6 мес. компания сделала то, на что у Oracle, Crusoe и OpenAI ушло 15. Для питания кластера компания выбрала необычную схему. Ранее xAI пообещала не ставить в Мемфисе новые газовые турбины, поскольку столкнулась с активным противодействием экологов и местного населения, и не солгала. Энергетический хаб для Colossus 2 просто разместили «через дорогу» — в штате Миссисипи. В середине 2025 года компания приобрела бывшую электростанцию Duke Energy в Саутхейвене (Southaven), а власти штата дали временное разрешение на использование газовых генераторов до 12 месяцев без специальных бюрократических процедур. Для транспортировки, хранения и распределения энергии строит инфраструктуру, включающую энергохранилища Tesla Megapack и ЛЭП. Для Colossus 2 в Саутхейвене развёрнуто семь турбин Titan 350 общей мощностью 266 МВт. xAI прибегла к аренде генераторов, в частности, у Solaris Energy Infrastructure (SEI). У последней имеются газовые турбины общей мощностью 600 МВт, из которых 400 МВт выделено xAI. Общий объём заказов SEI составлят 1,7 ГВт, из которых ⅔ приходится на xAI (1,14 ГВт). Из них 240 МВт отведено для питания Colossus 1 (уже установлено 12 турбин Titan 130 общей мощностью 198 МВт). Оставшиеся 900 МВт получит совместное предприятие Solaris (50,1 %) и xAI (49,9 %). xAI настолько спешит, что часть турбин Solaris сама временно арендовала у других компаний. Капитальные издержки нового бизнеса составили $112 млн во II квартале 2025 года. Solaris рассчитывает, что ко II кварталу 2027 году она сможет предоставить xAI генераторы мощностью более 1,1 ГВт. xAI оставила за собой право дозаказать у Solaris ещё 425 МВт и, вероятно, воспользуется этой возможностью, доведя совокупную мощность генераторов до более чем 1,5 ГВт. Впрочем, запросы будут зависеть от итоговой конфигурации ЦОД. По оценкам SemiAnalysis, у xAI есть несколько вариантов создания единого дата-центра мощностью более 1 ГВт. Будущее проекта предсказать довольно трудно, но с учётом нужды в средствах, не исключена масштабная экспансия на Ближний Восток, с которым Маск имеет довольно тесные связи. Так, саудовская Kingdom Holding Company, фактически контролируемая государством, владела долей в Twitter в 2022 году. Ей же принадлежала $800-млн доля в xAI до её слияния с X. В подконтрольные Маску структуры инвестировали частная Vy Capital, государственный фонд MGX из ОАЭ, катарская QIA и др. По некоторым данным, xAI готовит новый раунд финансирования при оценке компании в $200 млрд, где инвесторы Ближнего Востока могут сыграть немалую роль.

16.09.2025 [15:30], Сергей Карасёв

Eaton представила решение для обнаружения скачков энергопотребления в ИИ-системахАмериканская корпорация Eaton объявила о разработке, как утверждается, первого в отрасли решения для выявления значительных колебаний энергопотребления в рамках вычислительных инфраструктур, ориентированных на задачи ИИ. Как отмечается, стремительное внедрение ИИ приводит к быстрому росту нагрузки на дата-центры, а следовательно, к повышению их энергопотребления. Гиперскейлеры используют мощные серверы, оборудованные передовыми GPU и специализированными ASIC. При этом повышается вероятность непредвиденных всплесков энергопотребления из-за интенсивных вычислений, связанных с задачами ИИ. Такие скачки могут нанести серьёзный ущерб как инфраструктуре самого ЦОД, так и энергосети — в том случае, если она не рассчитана на столь значительные колебания нагрузки. Новое решение Eaton призвано решить проблему. Система реализована в виде дополнения для платформы анализа событий Eaton Power Xpert Quality (PXQ). Разработанный инструмент предназначен для обнаружения так называемых субсинхронных колебаний (SubSynchronous Oscillations, SSO) в энергосистемах дата-центров. Это колебания способны привести к перегреву трансформаторов, повреждению оборудования и другим негативным последствиям, устранение которых может потребовать значительных финансовых затрат. PXQ — это универсальная платформа для распределительных устройств, щитов и блоков распределения электроэнергии (PDU), которая использует сложную аналитику данных от периферийного оборудования для выявления и устранения проблем в электросетях. Интеграция инструмента обнаружения SSO осуществляется путём удалённого программного обновления. Eaton подчёркивает, что средства детектирования SSO позволят операторам принимать превентивные меры для минимизации негативных эффектов — до того, как скачки энергопотребления нанесут непоправимый ущерб дата-центрам и электросети.

15.09.2025 [12:27], Сергей Карасёв

Квартальные затраты на рынке физической инфраструктуры ЦОД приблизились к $9 млрд — продажи СЖО подскочили на 156 %По оценкам Dell'Oro Group, расходы на мировом рынке физической инфраструктуры дата-центров во II квартале текущего года достигли $8,9 млрд. Это на 18 % больше по сравнению с аналогичным периодом 2024-го, когда объём отрасли оценивался примерно в $7,5 млрд. Аналитики учитывают затраты на системы охлаждения, питания и пр. Отмечается, что основным драйвером рынка является стремительное внедрение ИИ, на фоне которого операторы ЦОД и гиперскейлеры активно наращивают вычислительные мощности. Третий квартал подряд рост расходов на инфраструктуру ЦОД в годовом исчислении превышает 10 %. В сегменте систем охлаждения зафиксирован рост на 29 % по отношению ко II четверти 2024 года. При этом продажи решений прямого жидкостного охлаждения (DLC) подскочили на 156 %. Как отмечает Dell'Oro Group, такие системы фактически становятся стандартом для крупных вычислительных кластеров ИИ. В сфере распределения энергии затраты поднялись в годовом исчислении на 26 %. Драйвером данного сектора является внедрение серверных стоек с высокой плотностью размещения оборудования для поддержания ресурсоёмких нагрузок ИИ. Выручка в секторе ИБП выросла на 13 %, достигнув $3,3 млрд. При этом наибольший спрос наблюдался в области трёхфазных решений мощностью 251 кВА и больше. В географическом плане во II квартале 2025 года лидировала Северная Америка с ростом около 23 %: затраты на строительство дата-центров в США достигли исторического максимума. В Европе, на Ближнем Востоке и в Африке (EMEA), а также в Азиатско-Тихоокеанском регионе темпы ниже, но в дальнейшем ожидается повышение рыночной активности. В мировом масштабе более 80 % роста во II квартале текущего года пришлось на гиперскейлеров и колокейшн-провайдеров, что указывает на их центральную роль в развитии ИИ ЦОД.

10.09.2025 [09:46], Руслан Авдеев

Data4 получит от французских АЭС 40 МВт для своих ЦОДНа фоне неослабевающего спроса на электричество для дата-центров европейский оператор ЦОД Data4 заключил с государственной компания Électricité de France (EDF) 12-летний контракт на поставку с 2026 года 40 МВт от французских АЭС, сообщает The Register. Это первый в стране долговременный договор Nuclear Production Allocation Contract (CAPN), позволяющий получать энергию по цене, не зависящей от волатильности рынков. Он дополнит имеющиеся долгосрочные соглашения о закупке солнечной и ветряной энергии (PPA) Data4 управляет дата-центрами во Франции, Испании, Польше, Германии и Греции. По расчётам экспертов, она владеет не менее 1,5 ГВт мощностей. Заключение контракта CAPN — часть более широкой стратегии Data4 по интеграции во все свои операции низкоуглеродной и возобновляемой энергии с повышением устойчивости эксплуатации ЦОД. Многие компании в Европе и за её пределами уже начали требовать от поставщиков энергии данные об экоустойчивости в рамках локальных нормативов, вроде европейской директивы CSRD. В Data4 сообщают, что в сочетании с PPA новый контракт гарантирует экоустойчивый, надёжный и постоянный доступ к «низкоуглеродной» энергии по контролируемой цене. Франция может считаться идеальной страной для подобного соглашения, поскольку порядка 70 % электричества здесь вырабатывается именно АЭС. Кроме того, как заявляют в EDF, инициатива полностью соответствует обязательствам государственной корпорации по поддержке развития ЦОД и обеспечению энергетического и промышленного суверенитета страны.

Источник изображения: Jametlene Reskp/unsplash.com Ранее EDF предложила операторам дата-центров доступ к собственным землям для строительства новых кампусов ЦОД с «благоприятными условиями» для подключения к электросетям, что позволит ускорить ввод проектов в эксплуатацию на несколько лет. EDF также выступила в числе партнёров строительства гигантского ИИ ЦОД близ Парижа. Комплекс мощностью 1,4 ГВт — проект совместного предприятия NVIDIA, Mistral AI, Французского национального инвестиционного банка и инвестиционного фонда MGX из ОАЭ. Кроме того, от АЭС запитают и 1-ГВт кампус Fluidstack. АЭС сегодня рассматриваются, как способ удовлетворить растущие энергетические потребности индустрии ЦОД. По мнению некоторых экспертов, ядерная энергетика будет поддерживать мировой энергетический баланс ещё долгие годы, но масштабные инвестиции в эту отрасль не решают ключевой проблемы — на строительство АЭС уходит много времени, а потребности ИИ в электричестве растут уже сейчас. В марте 2025 года сообщалось, что Amazon, Meta✴ и Google совместно с крупнейшими мировыми компаниями и банками помогут утроить мощность АЭС во всём мире уже к 2050 году.

09.09.2025 [23:00], Руслан Авдеев

Fermi America, стоящая за мегапроектом 11-ГВт ИИ ЦОД HyperGrid с питанием от АЭС, собралась на биржу

fermi america

hardware

ipo

westinghouse

аэс

ии

полезные ископаемые

сша

финансы

цод

электропитание

энергетика

Стоящая за проектом строительства 11-ГВт кампуса ИИ ЦОД HyperGrid в Амарилло (Техас) Fermi America подала заявку на IPO. Она намерена разместить обыкновенные акции на бирже Nasdaq Global Select Market, но их количество и ценовой диапазон пока не определены, сообщает пресс-служба компании. UBS Investment Bank, Cantor и Mizuho станут главными андеррайтерами, а Macquarie Capital, Stifel и Truist Securities — дополнительными. По данным Datacenter Dynamics, Fermi работает над Project Matador, в рамках которого и предполагается построить 11-ГВт кампус площадью 167 га. В проекте участвует объединение технических университетов штата (Texas Tech University System). Кампус построят на территории Техасского технологического университета (Texas Tech University, TTU). Сооснователем компании является бывший министр энергетики и бывший губернатор Техаса Рик Перри (Rick Perry). Ввод в эксплуатацию первой очереди на 1 ГВт запланирован на конец 2026 года, но само строительство ещё не начато. Fermi будет использовать локальные источники энергии, включая газовые, солнечные и ветряные электростанции. В июле компания приобрела более 600 МВт мощностей в рамках двух сделок — в том числе девять газовых генераторов, которые в 2026 помогут получть ЦОД до 1 ГВт. Впрочем, газовые турбины будут основным источником энергии лишь в краткосрочной перспективе — Fermi намерена разместить на площадке четыре PWR-реактора Westinghouse AP1000 поколения III+ c электрической мощностью около 1,1 ГВт. Fermi и Westinghouse подали регуляторам совместную заявку Combined Operating License Application (COLA), чтобы ускорить получение разрешений.

Источник изображения: Fermi America Параллельно Fermi подписала два других «атомных» соглашения — меморандумы о взаимопонимании с южнокорейскими Hyundai и Doosan Enerbility, поскольку есть риск не уложиться в сроки и бюджеты. Последний энергоблок AP1000 заработал в США в 2023 году, на семь лет позже запланированного. На АЭС ушло на $17 млрд больше запланированного, причём сама Westinghouse в процессе строительства прошла через банкротство. В сентябре Fermi успешно привлекла $100 млн в раунде финансирования серии C, который возглавила австралийская Macquarie Group. Последняя также открыла для Fermi кредитную линию на $250 млн. Это не первая компания, предложившая концепцию прямого питания ЦОД от АЭС. AWS потратила $650 млн, чтобы приобрести кампус около АЭС Susquehanna. Microsoft намерена возродить АЭС Three Mile Island, Мета✴ выкупила всю энергию АЭС Clinton Clean Energy Center на 20 лет вперёд, а Oracle объявила о намерении развернуть три SMR общей мощностью более 1 ГВт. |

|