Материалы по тегу: цод

|

15.09.2020 [19:33], Алексей Степин

Microsoft Natick может стать будущим периферийных ЦОД, надёжность доказанаЛюбой современный ЦОД — это не только помещение, занимающее определённую площадь, но ещё и серьёзные системы питания и, особенно, охлаждения. Ряд компаний считает, что с точки зрения последнего фактора имеет смысл рассмотреть возможность размещения ЦОД под водой, на дне моря, где температура постоянна и достаточно низка. В их числе Microsoft со своей разработкой Project Natick. Первый прототип Natick, доказавший работоспособность концепции, успешно проработал 105 дней в водах Калифорнийского залива, однако действительно серьёзная мощность была достигнута лишь во второй фазе, о которой и идёт речь в данной заметке. Второй прототип Natick являет собой 12,2-метровый цилиндрический контейнер стандарта ISO 40, внутри размещено 12 стоек с 864 серверами Microsoft (в составе присутствуют ПЛИС-ускорители) и СХД общим объёмом 27,6 Пбайт. Система охлаждения во втором варианте была разработана французской группой Naval Group на основе теплообменников, использующихся в современных подводных лодках.  На этот раз местом размещения подводного ЦОД был выбран район Оркнейских островов в 193 километрах (120 миль) от берега, глубина погружения составляла примерно 35 метров. Для питания и данных использовался общий кабель, содержащий как силовые линии, способные передать около четверти мегаватта, так и оптические волокна. Проект создавался с прицелом на пятилетний срок работы без обслуживания, с прицелом на 20 лет в будущем. Для обеспечения повышенной надёжности внутреннее пространство контейнера заполнено азотом, который практически инертен и способствует уменьшению износа оборудования.  14 сентября Microsoft сообщила об окончании второй фазы Project Natick, которая продлилась два года. Сам контейнер был извлечён из моря ещё летом, и специалисты и эксперты занялись изучением состояния аппаратного обеспечения, входившего в состав второго прототипа автономного ЦОД. Результат проекта признан очень успешным, возглавляющий Project Natick Бен Катлер (Ben Cutler) заявил, что «дело сделано, и второй вариант Natick можно с полным правом назвать подходящим строительным блоком». Согласно статистике, около 50% населения планеты проживает недалеко от берега моря, поэтому размещение подводных ЦОД в прибрежных областях вполне оправдано, а Европейский центр морской энергетики (Europetn Marine Energy Centre) вообще говорит о возможности использования для питания таких ЦОД приливных турбин и волновых конвертеров, что сделает их практически автономными, не считая оптоволоконного подключения.

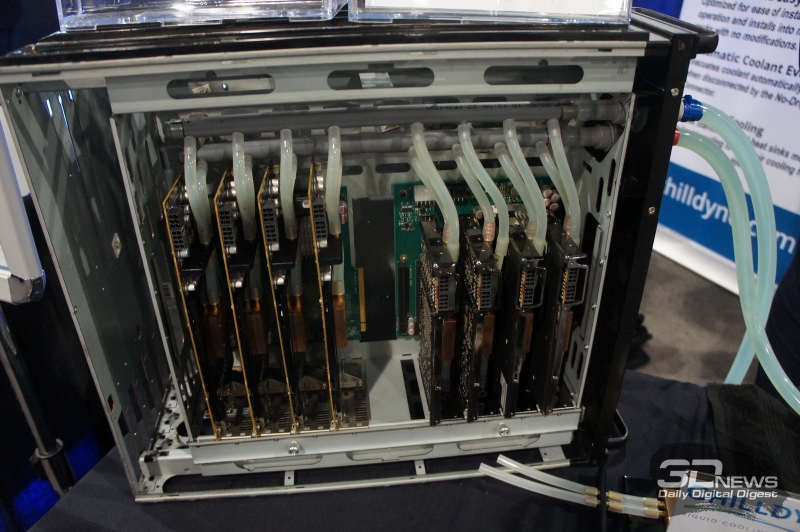

Часть системы охлаждения Natick Тонкости функционирования Natick ещё предстоит изучить, но предварительные результаты оказались несколько обескураживающими: ЦОД в герметичном контейнере, покоившийся на дне моря, и, естественно, лишённый обслуживания, оказался в восемь раз надёжнее, нежели его копия, расположенная на суше. Причины примерно ясны: стабильные температуры, отсутствие окисляющей атмосферной среды, а также каких-либо серьёзных вибраций. Компания считает, что эти данные могут помочь и в проектировании более надёжных наземных ЦОД.  Microsoft признала, что проект всё ещё далёк от завершения, но считает, что стандартный ЦОД Azure в подводном варианте уже может быть создан. Вице-президент отдела Azure по системам класса mission critical Вильям Чэппел (William Chappell) отметил, что его команда особенно заинтересована в пост-квантовых методах шифрования, критичных для такого рода периферийных центров обработки данных. Также заявлено, что Natick успешно может служить в качестве периферийного ЦОД или ЦОД с повышенной безопасностью; последнее достаточно очевидно — получить доступ к оборудованию, находящемуся под водой, намного сложнее, нежели в обычном ЦОД. Надёжнее в этом плане может быть только сервер на орбите, но по понятным причинам такое решение намного дороже и сложнее, нежели Natick, оно менее мощное, а также не гарантирует постоянной низкой латентности, которая может быть критичной в edge-сценариях использования.

28.07.2020 [11:38], Юрий Поздеев

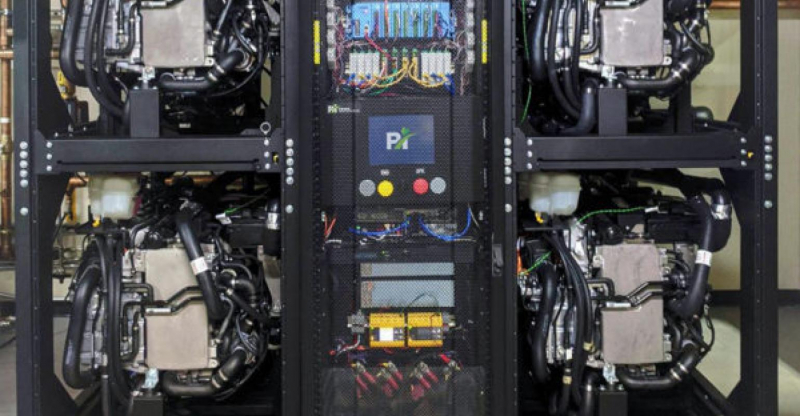

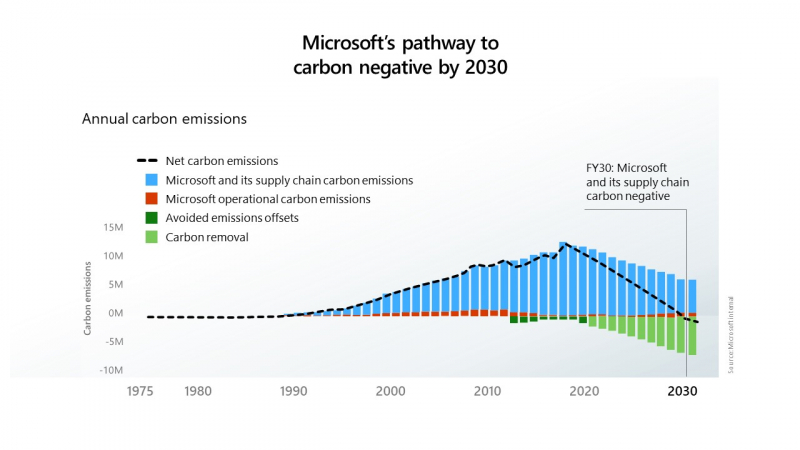

Водород вместо дизеля: Microsoft Azure получит новые источники резервного питанияMicrosoft сообщила, что успешно протестировала использование водородных топливных элементов для резервного питания своих серверов в центрах обработки данных. Это первый шаг к внедрению новых технологий, исключающих использование дизельного топлива в системах аварийного питания. Водород хранился в резервуарах на трейлерах, припаркованных возле лаборатории в Солт-Лейк-Сити, штат Юта. Такой вариант хранения водорода был продемонстрирован в ходе эксперимента, но в дальнейшем планируется использовать стационарные резервуары. Microsoft намерена прекратить использование дизельного топлива к 2030 году в рамках своих инициатив по снижению вредных выбросов.  В эксперименте использовалась нагрузка в виде 10 стоек облачных серверов Microsoft Azure: в течение 48 часов использовалась 250-КВт система на топливных элементах. Такое время работы от топливных элементов выбрано не случайно, поскольку большинство перебоев в подаче электроэнергии длятся менее 48 часов.  Ранее для подобной задачи использовались шесть дизель-генераторов. Следующим шагом Microsoft планирует испытать систему резервного питания на топливных элементах мощностью 3 МВт, чтобы продемонстрировать как масштабируется система для больших дата-центров.  Дизельные генераторы на данный момент являются оптимальным выбором для большинства ЦОД, однако Microsoft стремится к сокращению выбросов углекислого газа и хочет полностью отказаться от дизельного топлива к 2030 году. Цель амбициозная, но достижимая. Пока основным препятствием к ее осуществлению является цена. Водород сам по себе до сих пор остается дорогим топливом, а его транспортировка и хранения обходятся еще дороже. Следует также учесть, что водород более взрывоопасен, чем дизельное топливо, поэтому его хранение может стать большой проблемой для дата-центров, расположенных в крупных городах. Кроме радикальных мер по переводу аварийного питания дата-центров на водород, Microsoft рассматривает и более реальные альтернативы в виде питания генераторов от природного газа, который дает намного меньше выбросов, по сравнению с дизельным топливом, также рассматривается синтетическое дизельное топливо, которое при сгорании выделяет меньше углерода. Проектами по созданию более экологичных источников питания занимаются и другие компании: Rolls-Royce и Daimler Truck AG разработают топливные элементы для ЦОД, а Keppel и Mitsubishi намереваются создать водородную электростанцию. Ещё одной альтернативой могут стать ёмкие аккумуляторы — оператор Switch для своего дата-центра в Неваде построит комплекс из солнечной электростанции мощностью 127 МВт и модулей Tesla MegaPack суммарной ёмкостью 240 МВт∙ч

13.07.2020 [13:58], Юрий Поздеев

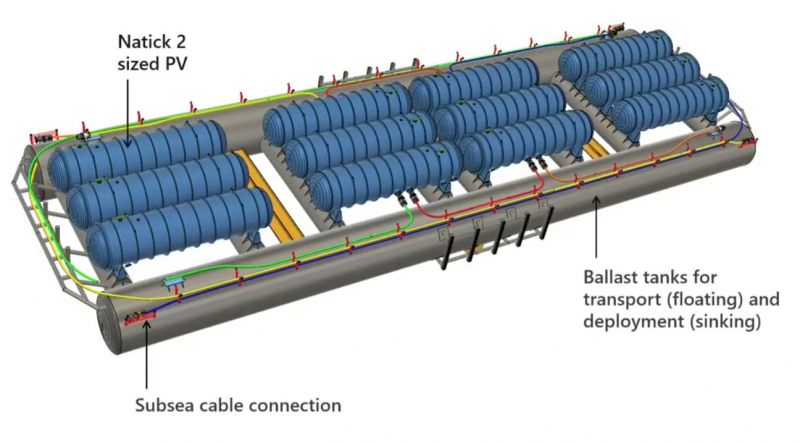

Microsoft продемонстрировала Natick 3 — подводный дата-центр третьего поколенияMicrosoft одновременно решает ряд инженерных задач с проектом Microsoft Azure Natick: снижает эксплуатационные расходы и обеспечивает меньшие задержки для дата-центров. Что же из себя представляет этот уникальный проект?  Начнем с истории: первый концепт Natick представлял собой стойку с серверами в стальной оболочке, которую опустили в океан, чтобы проверить работоспособность идеи. Попытка была удачной, Microsoft доказала, что можно использовать обычные серверы, развернутые в компактном корпусе на расстоянии 200 км в океане, что примерно давало задержку в 1 мс (2 мс в обе стороны). Видео с экспериментальным дата-центром Natick: Первая версия Natick была развернута у берегов Калифорнии и проработала 105 дней, что подтвердило жизнеспособность концепта. Два года спустя Microsoft Research погрузила под воду 14 стоек с серверами у побережья Шотландии. Этот регион был выбран не случайно: именно здесь используется множество возобновляемых источников энергии, что позволило сделать новый Natick еще более экологичным. Видео с демонстрацией Natick второго поколения: После более чем года работы Natick второго поколения Microsoft поделилась некоторыми данными: с точки зрения эффективности энергопотребления Natick демонстрирует коэффициент PUE в 1,07 — это очень мало для текущего производственного центра обработки данных. Низкий PUE означает снижение эксплуатационных расходов, а также делает Natick более экологичным. Обычный наземный дата-центр использует 4,8 литра воды на кВт/ч, при этом Natick не потребляет воду для работы, однако использует ее по-другому (споры с экологами по поводу нагрева океана и влияния на окружающую среду не закончились какими-то конструктивными выводами, по информации от самой Microsoft, влияние Natick на окружающую среду ничтожно мало). Этот аспект особенно актуален для стран, в которых существует дефицит воды и охлаждение дата-центров превращается в существенную проблему. Цилиндрический корпус Natick имеет вакуумную герметизацию, что означает, что серверы и ИТ оборудование избавлены от многих вредных факторов, таких как влажность и пыль. Кроме того, учитывая, насколько хорошо вода поглощает тепло и насколько велики океаны, можно утверждать, что на глубине 200 метров для дата-центра будет поддерживаться постоянная температура, без колебаний, свойственных наземным ЦОД (особенно это актуально для жарких регионов, где приходится использовать системы охлаждения с большим запасом). Natick 2 был рассчитан на эксплуатацию в течение пяти лет без технического обслуживания. Так что же Microsoft может предложить сегодня?  Natick третьего поколения представляет собой множество цилиндрических корпусов, закрепленных на большой стальной раме, в которой проложены коммутационные кабели и кабели питания. Общий размер составляет более 90 м (300 футов), с каждой стороны конструкции есть балластные цистерны для транспортировки и упрощения установки. Natick 3 состоит из 12 цилиндрических корпусов, общая мощность системы достигает 5 МВт, при необходимости могут быть построены и более крупные структуры, так как конструкция модульная и позволяет легко масштабировать мощность при необходимости. Microsoft не единственная компания, которая ведёт разработки в области подводных дата-центров, существуют еще разработки Nautilus Fata Technologies и более мелкие стартапы, однако они находятся только в самом начале пути и не имеют опыта промышленной эксплуатации дата-центров. Одно можно сказать точно: данное направление будет развиваться и в скором будущем мы увидим еще не одно подобное решение.

15.03.2020 [00:40], Андрей Крупин

Видео: как устроен дата-центр «Росэнергоатома» вблизи Калининской АЭСРоссийский энергетический концерн «Росэнергоатом» (входит состав госкорпорации «Росатом») разместил на своей странице в социальной сети «ВКонтакте» ролик, рассказывающий об особенностях работы центра обработки данных «Калининский», расположенного вблизи Калининской АЭС в Тверской области. Территориальная приближённость ЦОД «Калининский» к атомной электростанции обусловлена необходимостью обеспечения объекта надёжным источником электроснабжения.  Вычислительный комплекс «Калининский» был введён в эксплуатацию весной 2018 года и является первым дата-центром проекта «Менделеев» концерна «Росэнергоатом» по созданию сети центров обработки данных на площадках атомной отрасли РФ и за рубежом, соединённых высокоскоростными каналами связи в единую территориально распределённую катастрофоустойчивую информационную инфраструктуру. Дата-центр «Калининский» включает три здания с машинными залами общей площадью 38000 кв. метров и 4800 серверными стойками с проектной мощностью потребления электроэнергии от 6 кВт в расчёте на одну стойку. Подведённая мощность дата-центра составляет 48 МВт. Рядом с ЦОД развёрнута инфраструктурная площадка для размещения сторонними компаниями модульных и контейнерных центров обработки данных мощностью 32 МВт (проектом предполагается размещение до 30 модульных и контейнерных ЦОД по одному мегаватту каждый). Таким образом «Калининский» является одним из самых крупных дата-центров в России и позволяет разместить в машинных залах до 10 тысяч стоек с оборудованием суммарной мощностью до 80 МВт. В ближайших планах «Росэнергоатома» — строительство ЦОД в Сосновом Бору (Ленинградская область) и Иннополисе (Республика Татарстан).

25.11.2019 [16:29], Андрей Созинов

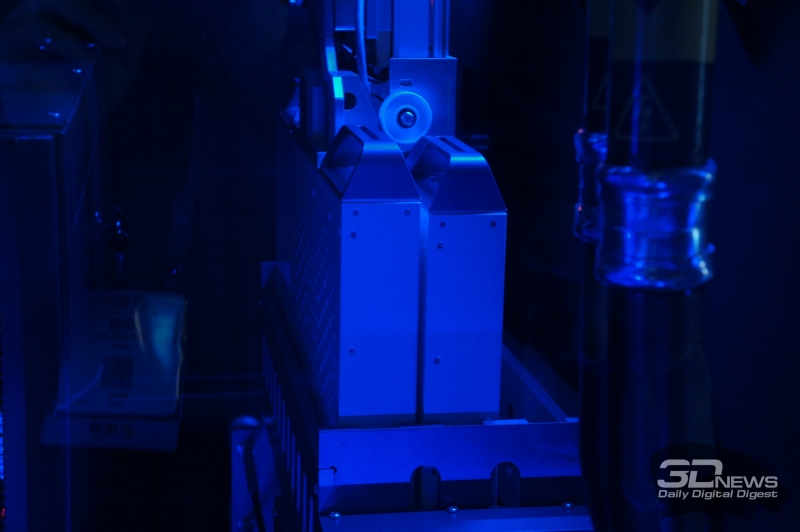

SC19: TMGcore OTTO — автономный роботизированный микро-ЦОД с иммерсионной СЖОКомпания TMGcore представила в рамках прошедшей конференции SC19 свою весьма необычную систему OTTO. Новинка является модульной платформой для создания автономных ЦОД, которая характеризуется высокой плотностью размещения аппаратного обеспечения, использует двухфазную иммерсионную систему жидкостного охлаждения, а также обладает роботизированной системой замены серверов.

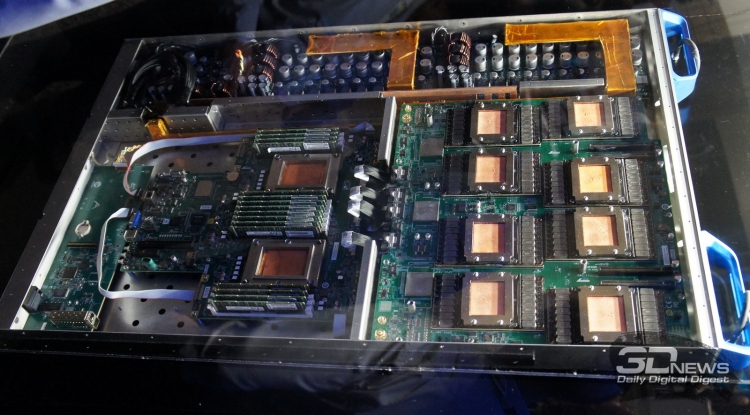

Версия OTTO на 600 кВт Первое, что отмечает производитель в системе OTTO — это высокая плотность размещения аппаратного обеспечения. Система состоит из довольно компактных серверов, которые размещены в резервуаре с охлаждающей жидкость. Собственно, использование двухфазной иммерсионной системы жидкостного охлаждения и позволяет размещать «железо» с максимальной плотностью.

Версия OTTO на 60 кВт Всего OTTO будет доступна в трёх вариантах, рассчитанных на 60, 120 и 600 кВт. Системы состоят из одного или нескольких резервуаров для размещения серверов. Один такой резервуар имеет 12 слотов высотой 1U, в десяти из которых располагаются сервера, а ещё в двух — блоки питания. Также каждый резервуар снабжён шиной питания с рабочей мощностью 60 кВт. Отметим, что площадь, занимаемая самой большой 600-кВт системой OTTO составляет всего 14,9 м2. В состав системы OTTO могут входить как эталонные серверы HydroBlades от самой TMGcore, так и решения от других производителей, прошедшие сертификацию «OTTO Ready». В последнем случае серверы должны использовать корпуса и компоновку, которые позволяют использовать их в иммерсионной системе охлаждения. Например, таким сервером является Dell EMC PowerEdge C4140. В рамках конференции SC19 был продемонстрирован и фирменный сервер OTTOblade G1611. При высоте всего 1U он включает два процессора Intel Xeon Scalable, до 16 графических процессоров NVIDIA V100, до 1,5 Тбайт оперативной памяти и два 10- или 100-гигабитных интерфейса Ethernet либо одиночный InfiniBand 100G. Такой сервер обладает производительность в 2000 Тфлопс при вычислениях на тензорных ядрах.  Мощность описанной абзацем выше машины составляет 6 кВт, то есть в системе OTTO может работать от 10 до 100 таких машин. И охладить столь компактную и мощную систему способна только двухфазная погружная система жидкостного охлаждения. Он состоит из резервуара, заполненного охлаждающей жидкостью от 3M и Solvay, и теплообменника для конденсации испарившейся жидкости. Для замены неисправных серверов система OTTO оснащена роботизированной рукой, которая способна производить замены в полностью автоматическом режиме. В корпусе OTTO имеется специальный отсек с резервными серверами, а также отсек для неисправных систем. Такой подход позволяет производить замену серверов без остановки всей системы, и позволяет избежать контакта человека с СЖО во время работы.  Изначально TMGcore специализировалась на системах для майнинга с иммерсионным охлаждением, а после перенесла свои разработки на обычные системы. Поэтому, в частности, описанный выше OTTOblade G1611 с натяжкой можно отнести к HPC-решениям, так как у него довольно слабый интерконнект, не слишком хорошо подходящий для решения классических задач. Впрочем, если рассматривать OTTO как именно автономный или пограничный (edge) микро-ЦОД, то решение имеет право на жизнь.

21.11.2019 [13:11], Алексей Степин

SC19: СЖО Chilldyne Cool-Flo для ЦОД исключает протечкиВыгоды от использования жидкостного охлаждения очевидны. Оно открывает путь к более плотному размещению вычислительных узлов, и сама эффективность охлаждения существенно выше. Но существуют у таких систем и серьезные недостатки. Главной опасностью систем СЖО является возможность протечки теплоносителя. Такой сценарий может вывести из строя весьма дорогостоящее оборудование. Компания Chilldyne утверждает, что данную проблему ей удалось решить, и демонстрирует на SC19 систему охлаждения Cool-Flo с «отрицательным давлением».

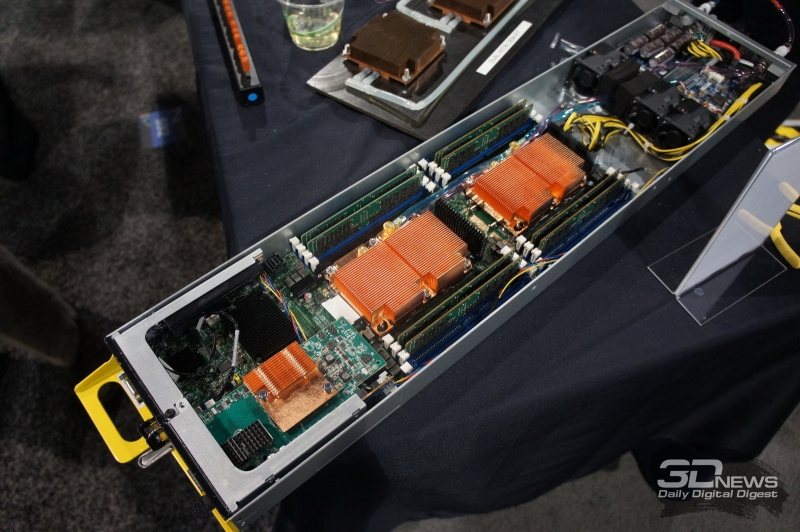

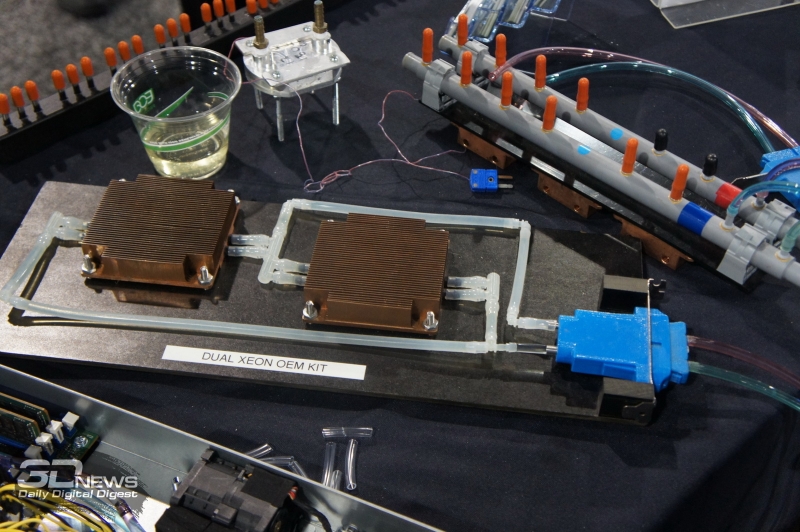

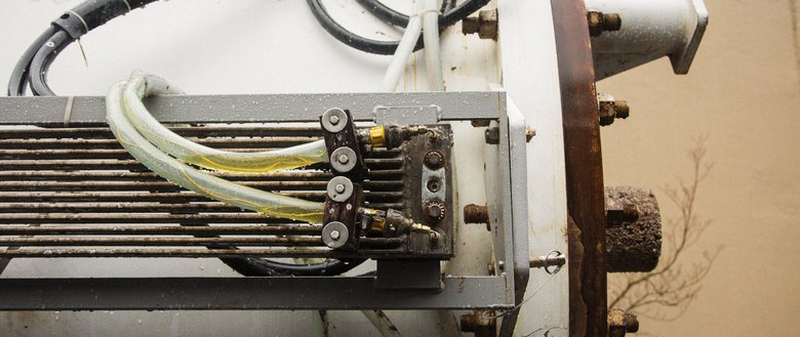

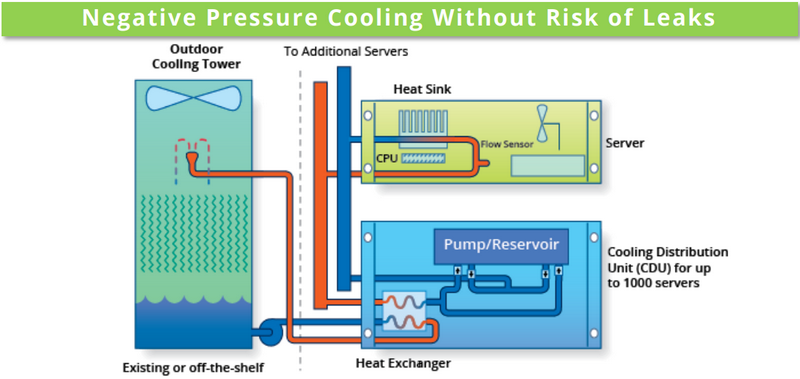

Принципиальная схема Chilldyne Cool-Flo. Обратите внимание на направление движения жидкости Главный принцип можно сравнить с вентилятором, работающим не на обдув, а на откачку воздуха из корпуса системы. Если в классическом контуре СЖО насосы нагнетают холодную жидкость в водоблоки, то насосы Cool-Flo, напротив, откачивают горячую. Если герметичность контура будет нарушена, то произойдёт не классический «залив» системной платы, а наоборот, вся жидкость будет выкачана, и вслед за ней в систему попадет воздух. В таком сценарии возможен простой, но не повреждение драгоценного оборудования, поскольку контакт с жидкостью практически исключён. К тому же, сама вероятность разгерметизации серьёзно уменьшена из-за «отрицательного давления», снижающего механическую нагрузку на элементы контура. Давление в нем составляет менее 1 атмосферы, что исключает выдавливание жидкости наружу. Из прочих преимуществ системы Cool-Flo можно назвать низкую стоимость развёртывания и совместимость с существующей инфраструктурой воздушного охлаждения. Серьёзные монтажные работы с привлечением сторонних специалистов требуются только для установки CDU (системы распределения теплоносителя) и внешней башни-градирни, а монтаж стоек и серверов может осуществляться техническим персоналом ЦОД. Технически же в качестве водоблоков Cool-Flo может использовать модернизированные радиаторы воздушного охлаждения ЦП либо версии с теплоотводной пластиной; последний вариант идеально подходит для плотного размещения ускорителей на базе GPU и других чипов с высоким уровнем тепловыделения. В первом случае вентиляторы серверов могут работать на пониженной скорости, создавая дополнительный обдув элементов системы.

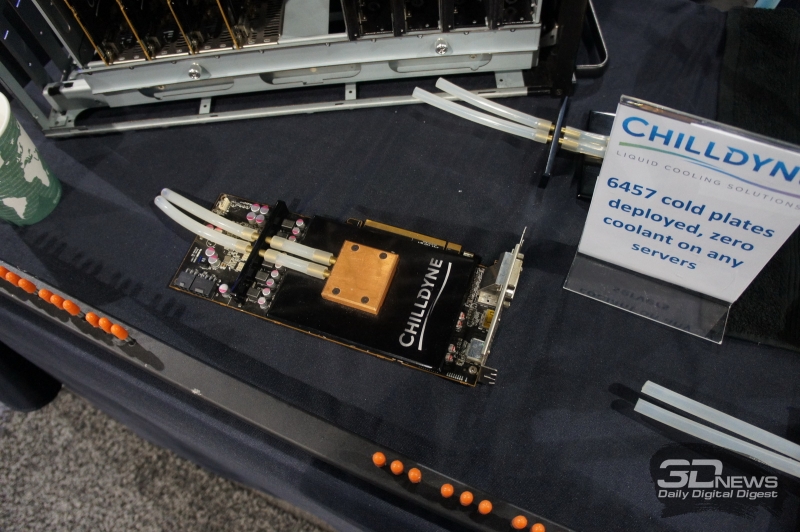

Графический ускоритель с дополнительной пластиной охлаждения. Ни одной протечки на более чем 6 тысяч плат На выставке SC19 Chilldyne продемонстрировала как OEM-комплекты для процессоров Xeon, так и варианты для ускорителей AMD Radeon и NVIDIA Tesla. Переделка сервера, по сути, заключается в установке водоблоков и специальной заглушки с фирменным разъёмом No-Drip, напоминающим двухконтактную силовую розетку и допускающим «горячее» подключение или отключение сервера от главного контура системы. Система распределения теплоносителя Cool-Flo CDU300 выполнена в виде стандартного шкафа, имеющего на передней панели экран с сенсорным управлением. Она рассчитана на температуру жидкости в районе 15‒30 градусов и при разнице температур 15 градусов способна отвести 300 киловатт тепла. Производительность водяных насосов составляет 300 литров в минуту при давлении в главном контуре менее 0,5 атмосфер. Предусмотрена полная система мониторинга (включая контроль качества теплоносителя) и удалённого управления, один шкаф может обслуживать до шести контуров охлаждения. Имеется возможность резервирования: резервный модуль CDU находится в активном режиме, но потребляет минимум энергии, а при необходимости мгновенно включается в работу. Компания-разработчик считает, что при использовании Cool-Flo в ЦОД можно избавиться от так называемых «горячих рядов», снизить затраты на вентиляцию и кондиционирование воздуха практически до нуля и на 75% снизить мощность, потребляемую вентиляторами серверов. Chilldyne оценивает стоимость 1 мегаватта охлаждения в $580 тысяч, в то время как классическая воздушная реализация может обойтись более чем в $1,2 миллиона. За четыре года эксплуатации ЦОД, оснащённого системой Cool-Flo экономия может составить почти $100 тысяч, и это не считая вышеупомянутых сниженных затрат на оснащение. С учётом пониженного риска повреждения оборудования в результате возможных протечек выигрыш может быть даже более серьёзным.

07.12.2016 [14:50], Андрей Крупин

Видео: как работает дата-центр «Яндекса» в ФинляндииКомпания «Яндекс» разместила на своей странице видеохостинга YouTube ролик, рассказывающий об особенностях работы самого энергоэффективного центра обработки данных (ЦОД) российского интернет-гиганта, расположенного в городе Мянтсяля в шестидесяти километрах от Хельсинки (Финляндия). Финский центр обработки данных «Яндекса» является одиннадцатым по счёту ЦОД компании и первым, созданным в соответствие с концепцией GreenField, предполагающей проектирование и строительство здания под дата-центр «с нуля». Площадь вычислительного комплекса составляет 3400 кв. м, его проектная мощность достигает 40 МВт. Объект подключён к двум независимым магистральным источникам электроэнергии по 110 киловольт каждый. Для резервирования энерговводов предусмотрено резервное питание от семи установок DRUPS, за счёт кинетической энергии вращающихся барабанов обеспечивающих автономную работу систем дата-центра на момент запуска дизель-генераторных источников бесперебойного питания. Особенностью дата-центра «Яндекса» в Финляндии является система охлаждения, функционирующая по принципу Free Cooling (для охлаждения оборудования применяется наружный воздух) и позволяющая использовать тепло от серверов в полезных целях — для отопления жилых домов Мянтсяля. Серверы финского ЦОД «Яндекса» охлаждаются уличным воздухом, который впоследствии нагнетается в теплообменники, а те, в свою очередь, нагревают воду до 30-45 градусов. После этого станция донагрева увеличивает температуру воды до 55-60 градусов, которая затем поступает в городскую сеть. Такое сотрудничество с городом позволяет «Яндексу» экономить до трети расходов на электроэнергию, потребляемую дата-центром. «Яндекс» намерен и впредь совершенствовать систему охлаждения серверов уличным воздухом. Задействованные в финском ЦОД энергоэффективные технологии и инновационные решения компания планирует использовать в строящемся во Владимире центре обработки данных. Запуск нового дата-центра ожидается в первом квартале 2017 года. |

|