Бывший глава Google Эрик Шмидт (Eric Schmidt) опубликовал статью «Стратегия сверхразума» (Superintelligence Strategy), написанную в соавторстве с Дэном Хендриксом (Dan Hendrycks), директором Центра безопасности ИИ, и Александром Вангом (Alexandr Wang), основателем и генеральным директором Scale AI, в которой высказывается мнение о том, что США следует воздержаться от реализации аналога «Манхэттенского проекта» для достижения превосходства в области ИИ, поскольку это спровоцирует упреждающие киберответы со стороны, например, Китая, пишет The Register.

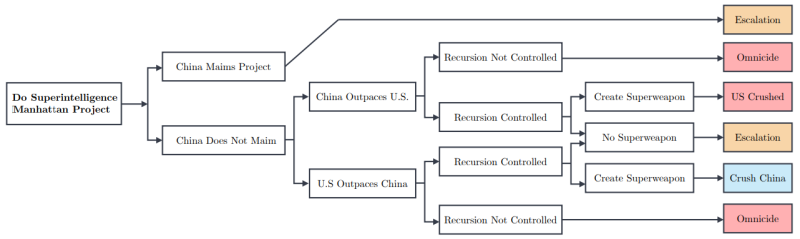

Авторы статьи утверждают, что любое государство, которое создаст супер-ИИ, будет представлять прямую угрозу для других стран, и они, стремясь обеспечить собственное выживание, будут вынуждены саботировать такие проекты ИИ. Любая «агрессивная попытка одностороннего доминирования в области ИИ приведёт к превентивному саботажу со стороны конкурентов», который может быть реализован в виде шпионажа, кибератак, тайных операций по деградации обучения моделей и даже прямого физического удара по ИИ ЦОД.

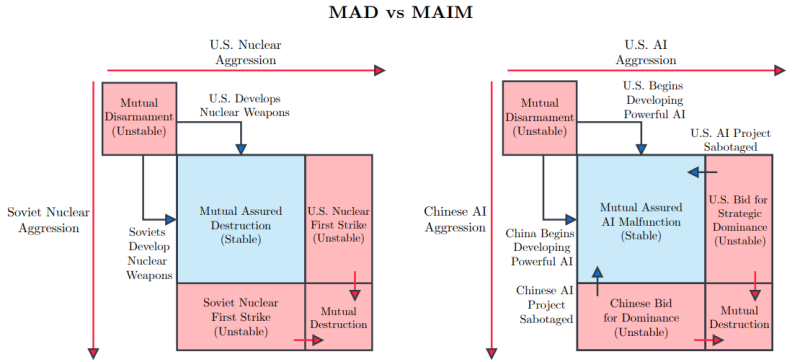

Авторы считают, что в области ИИ мы уже близки к доктрине взаимного гарантированного уничтожения (Mutual Assured Destruction, MAD) времён Холодной войны. Авторы дали нынешнему положению название «гарантированное взаимное несрабатывание ИИ» (Mutual Assured AI Malfunction, MAIM), при котором проекты ИИ, разрабатываемые государствами, ограничены взаимными угрозами саботажа.

Вместе с тем ИИ, как и ядерные программы в своё время, может принести пользу человечеству во многих областях, от прорывов в разработке лекарств до автоматизации процессов производства, использование ИИ важно для экономического роста и прогресса в современном мире. Согласно статье, государства могут выбрать одну из трех стратегий.

- Полное невмешательстве в деятельность разработчиков ИИ, чипов и моделей.

- Всемирный добровольный мораторий, призванный остановить дальнейшее развитие ИИ, либо немедленно, либо после обнаружения определённых опасностей, таких как способность ИИ ко взлому или полностью автономной работе.

- Всеобщая монополия на разработку путём создания международного консорциума на манер ЦЕРН, который возглавит глобальную разработку ИИ.

Комментируя предложение Комиссии по обзору экономики и безопасности США и Китая (USCC) о госфинансирования США своего рода «Манхэттенского проекта» по созданию суперинтеллекта в какому-нибудь укромном уголке страны, авторы статьи предупредили, что Китай отреагирует на этот шаг, что приведёт лишь к длительному дисбалансу сил и постоянной нестабильности.

Авторы статьи считают, что государства должны отдавать приоритет доктрине сдерживания, а не победе в гонке за искусственный сверхразум. MAIM подразумевает, что попытки любого государства достичь стратегической монополии в области ИИ столкнутся с ответными мерами со стороны других стран, а также приведут к соглашениям, направленным на ограничение поставок ИИ-чипов и open source моделей, которые по смыслу будут аналогичны соглашениям о контроле над ядерным оружием.

Чтобы обезопасить себя от атак на государственном уровне с целью замедлить развитие ИИ, в статье предлагается строить ЦОД в удалённых местах, чтобы минимизировать возможный ущерб, пишет Data Center Dynamics. Тот, кто хочет нанести ущерб работе других стран в сфере ИИ, может начать с кибератак: «Государства могут “отравить” данные, испортить веса и градиенты моделей, нарушить работу ПО, которое обрабатывают ошибки ускорителей и управляет питанием и охлаждением…».

Снизить вероятность атак поможет и прозрачность разработок. ИИ можно использовать для оценки безопасности других ИИ-проектов, что позволит избежать атак на «гражданские» ЦОД. Вместе с тем не помешает и прозрачность цепочек поставок. Поскольку ИИ-ускорители существуют в реальном, а не виртуальном мире, отследить их перемещение не так уж трудно. Таким образом, даже устаревшие или признанные негодными чипы не смогут попасть на чёрный рынок — их предлагается утилизировать с той же степенью ответственности, что и химические или ядерные материалы.

Впрочем, соблюдение всех этих рекомендаций не устранит главную проблему — зависимость от Тайваня в плане производства передовых чипов, которая является критической для США, говорят авторы статьи. Поэтому западным странам следует разработать гарантированные цепочки поставок ИИ-чипов. Для этого потребуются значительные инвестиции, но это необходимо для обеспечения конкурентоспособности.

Источники: