Материалы по тегу: llm

|

22.08.2023 [20:39], Алексей Степин

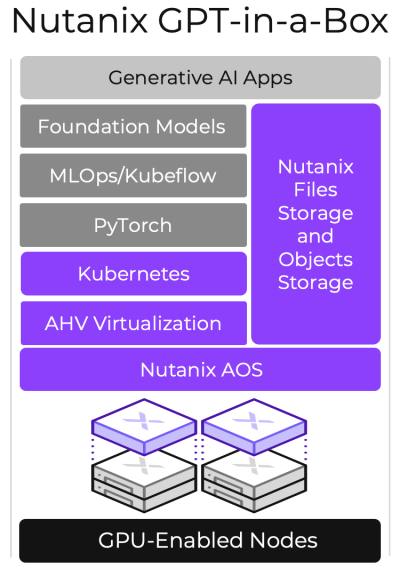

ИИ-из-коробки: Nutanix представила GPT-in-a-Box для быстрого развёртывания LLM-инфраструктурВ эпоху быстрого развития ИИ-систем многие компании интересуются данной темой, в частности, большими языковыми моделями, но они обеспокоены сохранностью и целостностью собственных данных, чего не могут полностью гарантировать облачные сервисы. Специально для таких случаев компания Nutanix, разработчик решений для мультиоблачных и гиперконвергентных инфраструктур, предложила своё решение — платформу GPT-in-a-Box. За этим названием скрывается программно-определяемая ИИ-платформа, базирующаяся на разработках Nutanix, открытых фреймворках, включая PyTorch и KubeFlow, и вычислительных узлах, оснащённых ускорителями NVIDIA. Она позволяет в кратчайшие сроки развернуть защищённую ИИ-среду в ЦОД или на периферии заказчика. Комплекс задействует файловое и объектное хранилище Nutanix Unified Storage, а также Kubernetes-платформу Karbon 2 с пробросом ускорителей. В число поддерживаемых базовых языковых моделей входят Llama2, Falcon LLM и MosaicML, но возможен запуск и других GPT-моделей, а также тонкая подстройка с использованием данных из интегрированного хранилища. При этом GPT-in-a-Box вовсе не требует повышенных затрат, связанных с поддержкой, масштабированием и администрированием. Система функционирует в рамках Nutanix Cloud Platform, которая сертифицирована для NVIDIA AI Enterprise.

14.08.2023 [22:25], Руслан Авдеев

ИИ для телекома: SK Telecom вложила $100 млн в стартап Anthropic, чтобы получить кастомную большую языковую модель для своего бизнесаЮжнокорейский телеком-оператор SK Telecom инвестировал $100 млн в стартап Anthropic, основанный бывшими топ-менеджерами OpenAI и занимающийся генеративным ИИ. Как сообщает DataCenter Dynamics, сделка предусматривает не только инвестиции, но и совместную работу над большими языковыми моделями (LLM), специально оптимизированными для телекоммуникационных компаний. На первом этапе будет создан специальный вариант более общей модели Claude. Новый вариант научится понимать корейский, японский, английский, немецкий, испанский и арабский языки. Курировать работу будет один из основателей стартапа и его главный научный сотрудник Джаред Каплан (Jared Kaplan). Готовая модель поступит в распоряжение группы Global Telco AI Alliance, основанной в прошлом месяце SK Telecom, Deutsche Telekom, e& и Singtel. LLM будет применяться для обслуживания клиентов телеком-сервисов, а также для маркетинга, продаж и других целей. По словам Anthropic, SK Telecom намерена использовать ИИ для «преображения» телекоммуникационной отрасли. Стартап намерен объединить свои навыки в сфере ИИ с опытом SK Telecom в телекоммуникационном бизнесе. При этом последняя уже работает над LLM — в феврале появилась информация о том, что южнокорейская компания удвоила мощность ИИ-суперкомпьютера Titan, ответственного за работу корейского варианта GPT-3 — модели Aidat (A dot).

Источник изображения: Anthropic С самого начала своего существования Anthropic была хорошо воспринята техногигантами. Среди её инвесторов уже числится Google, вложившая в стартап $300 млн, а всего компания привлекла более $1,5 млрд, причём в числе инвесторов, получивших долю в компании, оказалось и другое подразделение SK Group — SK Telecom Ventures.

10.08.2023 [17:04], Владимир Мироненко

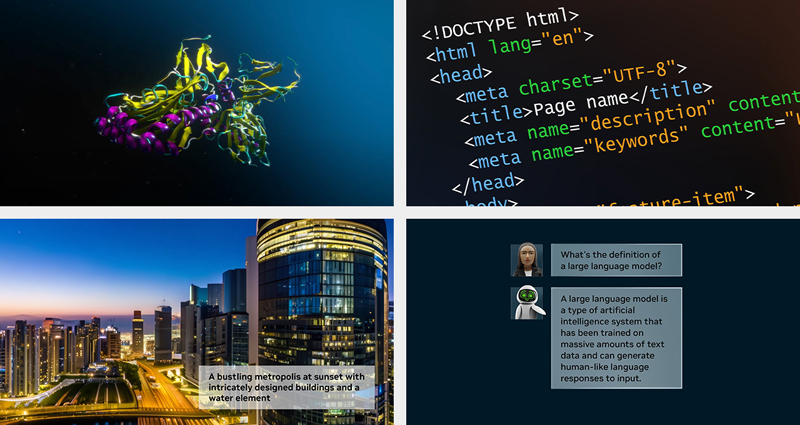

NVIDIA AI Workbench ускорит внедрение генеративного ИИ предприятиямиNVIDIA анонсировала набор инструментов NVIDIA AI Workbench, который позволяет разработчикам быстро создавать, тестировать и настраивать предварительно обученные модели генеративного ИИ на платформах NVIDIA — от ПК и рабочих станций до ЦОД, публичного облака и сервиса NVIDIA DGX Cloud. Сервис AI Workbench доступен через упрощённый интерфейс, работающий в локальной системе. С его помощью разработчики могут настраивать и тестировать модели из популярных репозиториев, таких как Hugging Face, GitHub и NVIDIA NGC, используя проприетарные данные, а также получать доступ к облачным ресурсам, когда возникает необходимость в масштабировании. Затем готовые модели можно развернуть на нескольких платформах.

Источник изображения: NVIDIA Вице-президент NVIDIA по корпоративным вычислениям, говорит, что причиной создания AI Workbench является сложность и трудоёмкость настройки больших моделей ИИ. Проекты ИИ корпоративного масштаба могут потребовать поиска нужной платформы и инструментов в нескольких репозиториях, а также наличие навыков настройки модели для конкретного варианта использования. Задача ещё больше усложняется, когда проекты необходимо перемещать из одной инфраструктуры в другую. NVIDIA AI Workbench позволит разработчики настраивать и запускать генеративный ИИ всего за несколько кликов. Он позволяет объединить все необходимые модели, фреймворки, наборы для разработки ПО, открытые библиотеки и ИИ-платформы NVIDIA в единый набор инструментов для разработчиков. По словам NVIDIA, решение AI Workbench уже используют Dell Technologies, HPE, HP, Lambda, Lenovo, Supermicro и многие другие вендоры. NVIDIA также анонсировала четвертую версию своей программной ИИ-платформы NVIDIA AI Enterprise, которая предлагает инструменты, необходимые для внедрения и настройки генеративного ИИ. Платформа включает фреймворк NVIDIA NeMo, службу NVIDIA Triton и ПО NVIDIA Base Command Manager Essentials. NVIDIA AI Enterprise 4.0 будет интегрирована в маркетплейсы партнёров компании, включая AWS, Google Cloud Platform и Microsoft Azure, а также Oracle Cloud Infrastructure. |

|