Материалы по тегу: eurohpc

|

14.05.2024 [19:23], Руслан Авдеев

В Ирландии посчитали «постыдным» отсутствие национального суперкомпьютера. Предыдущий списали в 2023 годуЧлен партии Sinn Féin и нижней палаты ирландского парламента Луиза О’Райли (Louise O'Reilly) раскритиковала местное правительство за неспособность приобрести новый суперкомпьютер. Datacenter Dynamics сообщает, что политик привлекла внимание исполнительной власти к необходимости подготовки новой национальной HPC-платформы варианта взамен недавно списанной. По её словам, HPC-системы являются сердцем пятой промышленной революции, ключевым фактором роста ирландской экономики и обеспечения прямых иностранных инвестиций. Ранее у Ирландии имелся суперкомпьютер Kay, размещавшийся в центре ICHEC Ирландского национального университета (его части — University College Galway). Запущенный в 2018 году 665-Тфлопс суперкомпьютер, ранее использовавшийся властями, учёными и бизнесом, вывели из эксплуатации в ноябре 2023 года.

Источник изображения: Jason Murphy/unsplash.com О’Райли заявляет, что у правительства достаточно возможностей для приобретения новой машины. Тем не менее, по её данным, несмотря на предупреждения о необходимости покупки суперкомпьютера, на поставку которого может уйти около трёх лет, власти не сделали ни шагу к приобретению системы. Пока же ирландским структурам приходится или просить об использовании суперкомпьютеров чужие государства, или прибегать к услугам частных компаний. Другими словами, как считает О’Райли, неспособность правительства инвестировать в критическую инфраструктуру «опозорила» Ирландию в глазах европейского и мирового технологического сообщества и лишит страну целого поколения талантов, отправившихся искать места получше, а также не даст привлекать прямые иностранные инвестиции в должных объёмах в секторы вроде ИИ, машинного обучения и квантовых вычислений. Как считает депутат, новый суперкомпьютер должен быть построен при участии консорциума EuroHPC. Последний ещё в 2022 году объявил о выборе пяти площадок для следующего поколения суперкомпьютеров, одной из которых должна была стать Ирландия. Страна должна была получить суперкомпьютер CASPIr, причём EuroHPC готов оплатить до 35 % стоимости системы. CASPIr должен быть в 25 раз производительнее Kay.

10.04.2024 [19:53], Руслан Авдеев

Индия и Евросоюз наконец договорились о развитии совместных HPC-проектовИндия и ЕС договорились о главных этапах совместного HPC-проекта, соглашение о реализации которого было заключено почти два года назад. Однако подвижки в этой сфере наметились только сейчас, когда Евросоюз начал недвусмысленно намекать, что пора бы взяться за дело, передаёт The Register. Соответствующий пакт был подписан в ноябре 2022 года. На тот момент Индия и ЕС намеревались углубить технологическое сотрудничество в квантовых вычислениях и HPC и обозначили основные цели, включая совместное продвижение исследований в области HPC-технологий. Правда, после этого долгое время практически ничего не происходило. В феврале 2024 года Евросоюз выпустил со своей стороны призыв к развитию сотрудничества в области HPC с Индией, оптимизации и совместной разработке HPC-приложений в сферах общего интереса, а также к обмену исследователями и инженерами между регионами. В Евросоюзе рассчитывают на:

При этом в документе не указывается, какими именно способами будут достигаться названные цели. Впрочем, у Индии уже есть соображения на этот счёт. Министерство электроники и информационных технологий страны призвало исследователей предложить варианты использования HPC для анализа климатических изменений, применения в биоинформатике, для борьбы со стихийными бедствиями вроде пожаров, цунами, оползнями и землетрясениями. Также в министерстве надеются получить предложения по разработке интегрированной системы раннего предупреждения для борьбы с «каскадными» эффектами комплексных угроз. Предложения должны уделять внимание оптимизации специализированных приложений и кодов, чёткому планированию работ, учёту KPI и демонстрации убедительных результатов выгоды от сотрудничества. Претендентам рекомендуется сосредоточиться на конкретных технических задачах. В заявке должен быть чётко оговорен вклад как индийских учёных, так и их коллег из Евросоюза. В заявке следует указать сферы и методики разработки, а также потенциальных пользователей готовых продуктов в Индии и ЕС. Одобренные предложения обеспечат возможность ускоренного доступа к HPC-мощностям как в Индии, так и в Евросоюзе. Индийская Суперкомпьютерная миссия (Supercomputing Mission) располагает 28 суперкомпьютерами, но из них только семь имеют производительность более 1 Пфлопс. В рамках EuroHPC уже развёрнуто восемь суперкомпьютеров, причём одна только система LUMI имеет производительность 386 Пфлопс. Ни в Индии, ни в Евросоюзе не сообщали, когда и как именно будут реализованы одобренные предложения учёных и специалистов.

10.03.2024 [22:13], Сергей Карасёв

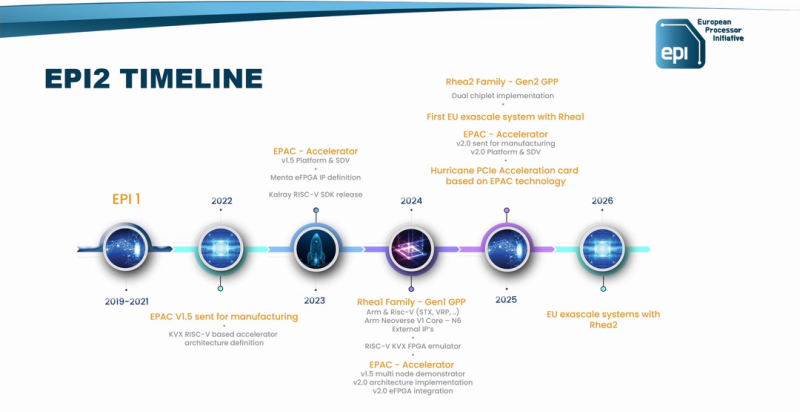

Arm-процессор SiPearl Rhea2 для европейских суперкомпьютеров выйдет в 2025 годуКонсорциум European Processor Initiative (EPI) раскрыл планы по выпуску HPC-процессоров нового поколения с архитектурой Arm. Речь идёт о чипах Rhea2, которые, как ожидается, войдут в состав следующего европейского суперкомпьютера экзафлопсного уровня. Разработчиком изделий Rhea является французская компания SiPearl. Процессор первого поколения на базе Arm Neoverse V1 обладает высокой энергетической эффективностью. Он производится на предприятии TSMC с использованием 6-нм технологии N6. Чип станет основой одного из блоков экзафлопсного суперкомпьютера Jupiter, который в нынешнем году будет запущен в Юлихском исследовательском центре (FZJ) в Германии. О процессоре Rhea2 информации пока не слишком много. Известно, что он получит двухчиплетную компоновку. Ожидается, что будет реализована поддержка памяти HBM и DDR5. Разработчик переведёт Rhea2 на более «тонкий» по сравнению с чипом первого поколения техпроцесс. Сообщается, что Rhea2 дебютирует в 2025 году. Процессор будет задействован в новом европейском НРС-комплексе — вероятно, в системе «Жюль Верн» (Jules Vernes), которая расположится во Франции. Ввод этого суперкомпьютера в эксплуатацию запланирован на 2026 год. Создание машины финансируется Евросоюзом, Францией и Нидерландами, а её управление возьмёт на себя Французское национальное агентство по высокопроизводительным вычислениям (GENCI), которое на 49 % принадлежит французскому правительству. Генеральный директор SiPearl Филипп Ноттон (Philippe Notton) отметил, что разработка чипа Rhea2 проходит быстрее, поскольку компания многому научилась при создании изделия первого поколения и учла допущенные ошибки. Он добавил, что SiPearl сотрудничает со многими партнёрами, включая NVIDIA, AMD и Intel, но вдаваться в подробности о характеристиках Rhea2 не стал. Эксперты полагают, что Rhea2 будет использовать ядра Neoverse 3 (Poseidon).

12.02.2024 [08:54], Сергей Карасёв

EuroHPC развернёт в Европе специализированные индустриальные суперкомпьютерыЕвропейское совместное предприятие по развитию высокопроизводительных вычислений (EuroHPC JU) объявило о начале приёма заявок от заинтересованных площадок для размещения специализированных суперкомпьютеров промышленного уровня. Речь идёт о вычислительных комплексах не ниже среднего класса, специально разработанных с учётом норм безопасности, конфиденциальности и целостности данных в индустриальном сегменте. К таким системам обычно предъявляются более высокие требования, нежели к суперкомпьютерам для решения научных задач.

Суперкомпьютер Leonardo. Источник изображения: EuroHPC JU / Cineca EuroHPC JU планирует закупить новые вычислительные комплексы совместно с консорциумом частных партнёров. С выбранными площадками будут заключены соглашения о размещении и эксплуатации оборудования. EuroHPC JU приобретёт как минимум один промышленный суперкомпьютер в 2024 году. Подробности о проекте не раскрываются, но известно, что общий вклад ЕС в его реализацию составит €12,2 млн. Новые промышленные суперкомпьютеры будут совместно финансироваться из бюджета EuroHPC JU, полученного в рамках Программы «Цифровая Европа» (DEP), а также за счёт взносов государств-участников организации. При этом EuroHPC JU покроет до 35 % затрат на приобретение вычислительных комплексов. Развёртывание этих систем поможет удовлетворить растущий спрос на вычислительные ресурсы со стороны индустриальных заказчиков. В целом, инициатива должна способствовать «повышению инновационного потенциала предприятий в Европе».

29.11.2022 [12:20], Сергей Карасёв

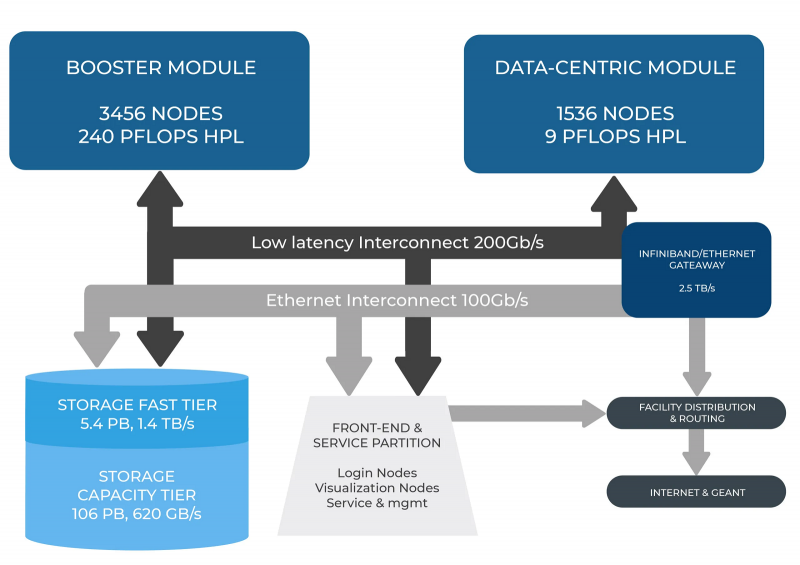

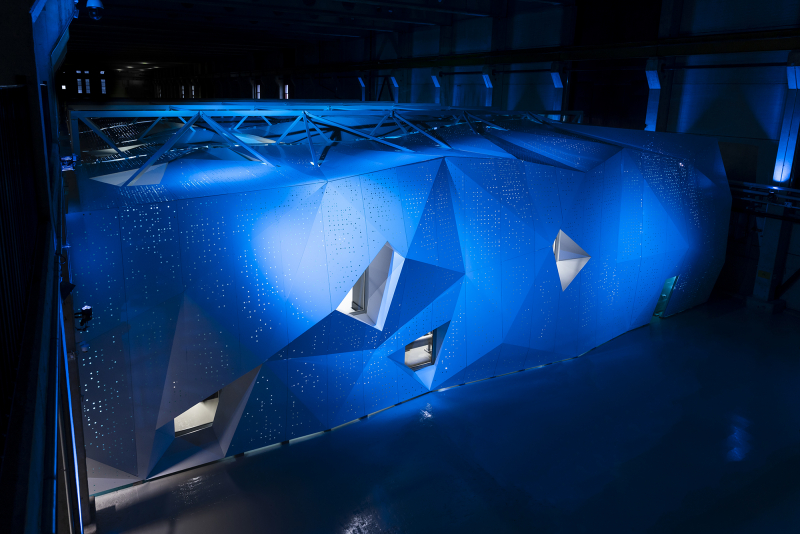

В Италии официально запущен суперкомпьютер Leonardo — четвёртая по мощности HPC-система в миреСовместная инициатива по высокопроизводительным вычислениям в Европе EuroHPC JU и некоммерческий консорциум CINECA, состоящий из 69 итальянских университетов и 21 национальных исследовательских центров, провели церемонию запуска суперкомпьютера Leonardo. В основу комплекса положены платформы Atos BullSequana X2610 и X2135. Система Leonardo состоит из двух секций — общего назначения и с ускорителями вычислений (Booster). Когда строительство системы будет завершено, первая будет включать 1536 узлов, каждый из которых содержит два процессора Intel Xeon Sapphire Rapids с 56 ядрами и TDP в 350 Вт, 512 Гбайт оперативной памяти DDR5-4800, интерконнект NVIDIA InfiniBand HDR100 и NVMe-накопитель на 8 Тбайт.

Источник изображения: HPCwire Секция Booster объединяет 3456 узлов, каждый из которых содержит один чип Intel Xeon 8358 с 32 ядрами, 512 Гбайт ОЗУ стандарта DDR4-3200, четыре кастомных ускорителя NVIDIA A100 с 64 Гбайт HBM2-памяти, а также два адаптера NVIDIA InfiniBand HDR100. Кроме того, в состав комплекса входят 18 узлов для визуализации: 6,4 Тбайт NVMe SSD и два ускорителя NVIDIA RTX 8000 (48 Гбайт) в каждом. Вычислительный комплекс объединён фабрикой с топологией Dragonfly+. Для хранения данных служит двухуровневая система. Производительный блок (5,4 Пбайт, 1400 Гбайт/с) содержит 31 модуль DDN Exascaler ES400NVX2, каждый из которых укомплектован 24 NVMe SSD вместимостью 7,68 Тбайт и четырьмя адаптерами InfiniBand HDR. Второй уровень большой ёмкости (106 Пбайт, чтение/запись 744/620 Гбайт/с) состоит из 31 массива DDN EXAScaler SFA799X с 82 SAS HDD (7200 PRM) на 18 Тбайт и четырьмя адаптерами InfiniBand HDR. Каждый из массивов включает два JBOD-модуля с 82 дисками на 18 Тбайт. Для хранения метаданных используются 4 модуля DDN EXAScaler SFA400NVX: 24 × 7,68 Тбайт NVMe + 4 × InfiniBand HDR. В настоящее время Leonardo обеспечивает производительность более 174 Пфлопс. Ожидается, что суперкомпьютер будет полностью запущен в первой половине 2023 года, а его пиковое быстродействие составит 250 Пфлопс. Уже сейчас система занимает четвёртое место в последнем рейтинге самых мощных суперкомпьютеров мира TOP500. В Европе Leonardo является второй по мощности системой после LUMI. Leonardo оборудован системой жидкостного охлаждения для повышения энергоэффективности. Кроме того, предусмотрена возможность регулировки энергопотребления для обеспечения баланса между расходом электричества и производительностью. Суперкомпьютер ориентирован на решение высокоинтенсивных вычислительных задач, таких как обработка данных, ИИ и машинное обучение. Половина вычислительных ресурсов Leonardo будет предоставлена пользователям EuroHPC.

15.06.2022 [23:40], Алексей Степин

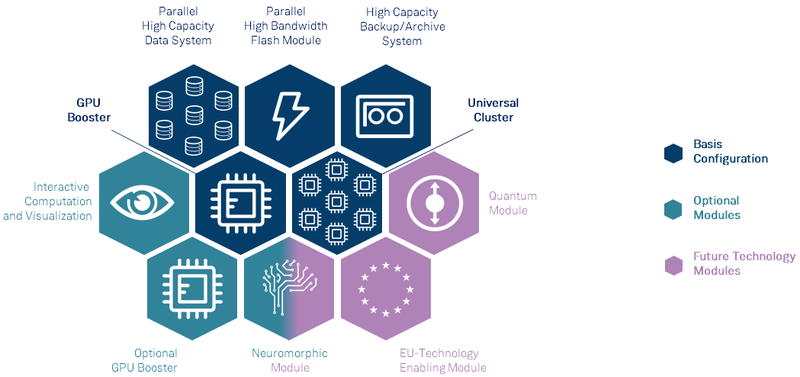

Анонсирован первый европейский суперкомпьютер экзафлопсного класса — JUPITERВсемирная гонка суперкомпьютеров экзафлопсного класса продолжается, и теперь в игру, наконец, вступил Евросоюз — консорциума EuroHPC сегодня раскрыл некоторые подробности о первой европейской система подобного уровня. Им станет машина под названием JUPITER (Joint Undertaking Pioneer for Innovative and Transformative Exascale Research), которая должна будет войти в строй в следующем году. Система будет смонтирована в Юлихском исследовательском центре (FZJ) в Германии. Сведений об аппаратной начинке JUPITER пока не так много, но в конструкции нового HPC-монстра будет применён тот же модульный подход, что был опробован на его предшественнике, суперкомпьютере JUWELS. Последний вступил в строй в 2018 году и на данный момент содержит несколько кластеров и бустеров с различной архитектурой.

Архитектура европейской экзафлопсной системы включает необычные средства. Источник: FZJ Новая система получит отдельные модули, куда входят вычислительные узлы, пулы памяти, узлы с различными ускорителями, узлы визуализации и т.д. Более того, она может быть дополнена блоками, которые содержат нейроморфные и квантовые системы, а также любые вычислительные модули, построенные на технологиях Евросоюза. Стоимость JUPITER оценивается примерно в €502 млн. Половину оплатит EuroHPC, четверть предоставит Министерство образования и науки Германии, оставшаяся четверть придётся на долю Министерства культуры и науки Северной Рейн-Вестфалии.

Машинный зал JUWELS. Источник: FZJ Проектировщики уделят серьёзное внимание энергоэффективности новой системы. Ожидается, что её потребление составит около 15 МВт, то есть она будет экономичнее нынешнего лидера TOP500 в лице Frontier. Для питания JUPITER планируется задействовать возобновляемые источники энергии, а СЖО будет использовать теплоноситель с относительно высокой рабочей температурой. Рассматривается возможность утилизации выделяемого системой тепла, как это реализовано в финском LUMI.

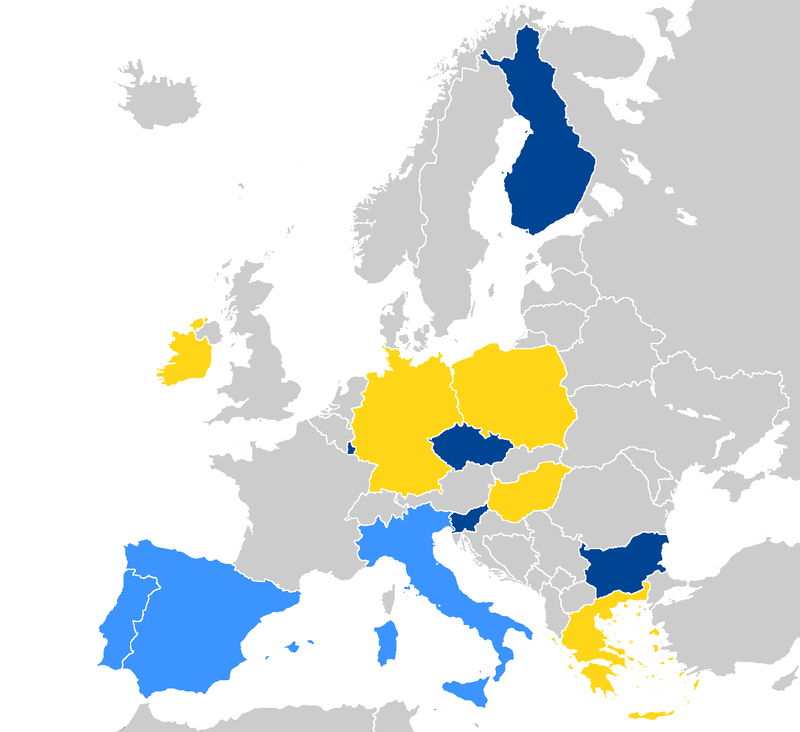

Страны, уже запустившие системы EuroHPC отмечены тёмно-синим, светло-синие — в процессе, жёлтым отмечены новички. Источник: EuroHPC Консорциум также анонсировал ещё четыре, более скромных суперкомпьютера. Это греческий DAEDALUS, венгерский LEVENTE, ирландский CASPIr и польский EHPCPL. В течение следующих нескольких лет EuroHPC планирует ввести в строй ещё минимум два суперкомпьютера экзафлопсного класса, так что гонка за зеттафлопом станет ещё интереснее. Впрочем, и Европе, и США надо опасаться в первую очередь Китая.

14.06.2022 [16:33], Владимир Мироненко

В Финляндии официально запущен LUMI, самый мощный суперкомпьютер в ЕвропеHPE и EuroHPC официально ввели в эксплуатацию вычислительную систему LUMI, установленную в ЦОД центре IT Center for Science (CSC) в Каяани (Финляндия), которая на данный момент считается самым мощным суперкомпьютером в Европе. LUMI — это первая система предэкзафлопсного класса, созданная в рамках совместного европейского проекта EuroHPC. LUMI будет в основном использоваться для решения важных для общества задач, включая исследования в области изменения климата, медицины, наук о жизни и т.д. Система будет применяться для приложений, связанных с высокопроизводительными вычислениями (HPC), искусственным интеллектом и аналитикой данных, а также в областях их пересечения. Для отдельных пользователей суперкомпьютер будет доступен в рамках второй пилотной фазы в августе, а полностью укомплектованная система станет общедоступной в конце сентября. Суперкомпьютер стоимостью €202 млн принадлежит EuroHPC (JU). Половина из этой суммы была предоставлена Евросоюзом, четверть — Финляндией, а остальная часть средств поступила от остальных членов консорциума, включающего 10 стран. По состоянию на 30 мая LUMI занимал третье место в списке TOP500 самых быстрых суперкомпьютеров мира. Сейчас его производительность составляет 151,9 Пфлопс при энергопотреблении 2,9 МВт. LUMI (снег в переводе с финского) базируется на системе HPE Cray EX. Система состоит из двух комплексов. Блок с ускорителями включает 2560 узлов, каждый из которых состоит из одного 64-ядерного кастомного процессора AMD EPYC Trento и четырёх AMD Instinct MI250X. Второй блок под названием LUMI-C содержит только 64-ядерные CPU AMD EPYC Milan в 1536 двухсокетных узлах, имеющих от 256 Гбайт до 1 Тбайт RAM. LUMI также имеет 64 GPU NVIDIA A40, используемых для рабочих нагрузок визуализации, и узлы с увеличенным объёмом памяти (до 32 Тбайт на кластер). Основной интерконнект — Slingshot 11. Хранилище LUMI построено на базе СХД Cray ClusterStor E1000 c ФС Lustre: 8 Пбайт SSD + 80 Пбайт HDD. Также есть объектное Ceph-хранилище ёмкостью 30 Пбайт. Агрегированная пропускная способность СХД составит 2 Тбайт/с. В ближайшее время суперкомпьютер получит дополнительные узлы. После завершения всех работ производительность суперкомпьютера, как ожидается, вырастет примерно до 375 Пфлопс, а пиковая производительность потенциально превысит 550 Пфлопс. Общая площадь комплекса составит порядка 300 м2, а энергопотребление вырастет до 8,5 МВт. Впрочем, запас у площадки солидный — от ГЭС она может получить до 200 МВт. «Мусорное» тепло идёт на обогрев местных домов. |

|