Материалы по тегу: h100

|

16.05.2024 [14:22], Руслан Авдеев

xAI Илона Маска потратит $10 млрд на облачные ИИ-серверы Oracle для чат-бота GrokИИ-стартап Илона Маска (Elon Musk) xAI готов потратить $10 млрд на серверы в облаке Oracle. По данным The Information, ссылающейся на осведомлённые источники, компании ведут переговоры о долгосрочном сотрудничестве, которое сделает детище Маска одним из крупнейших клиентов Oracle. Предполагается, что xAI требуется больше вычислительных ресурсов для соперничества с OpenAI, Anthropic и другими компаниями, уже заключившими многомиллиардные инвестиционные сделки с Microsoft и AWS соответственно. Это позволяет им получать доступ к облачной инфраструктуре для обучения и запуска больших языковых моделей (LLM). Например, Microsoft и OpenAI, по слухам, готовы потратить $100 млрд на кампус ЦОД Stargate ёмкостью 5 ГВт. Пока Micosoft вынуждена сама арендовать часть ИИ-ускорителей у Oracle. В прошлом году xAI представила чат-бот Grok, доступный платным пользователям соцсети X, а сейчас разрабатывается вторая версия. Имеются сведения, что xAI завершает раунд привлечения инвестиций в размере $6 млрд, а Маск уже заявил, что полученные средства будут потрачены на аренду инфраструктуры. В прошлом месяце миллиардер заявил, что новинка обучается на 20 тыс. ускорителей NVIDIA, но для Grok 3.0 потребуется уже 100 тыс. ускорителей. Маск и основатель Oracle Ларри Эллисон (Larry Ellison) крепко дружат, кроме того, Элиссон входил в совет директоров Tesla. В декабре прошлого года он заявлял, что xAI уже является крупнейшим клиентом Oracle и утверждал, что у облачного гиганта достаточно ускорителей для Grok первого поколения, но, по его признанию, в xAI хотят намного больше. Сейчас xAI арендует у Oracle 15 тыс. ускорителей NVIDIA H100. Tesla, ещё одно детище Маска, уже ввела в эксплуатацию ИИ-ресурсы, эквивалентные по производительности 35 тыс. H100. ИИ-инфраструктура стала выгодным источником дохода для облачного оператора, в марте Эллисон заявлял, что компания строит новые ЦОД, включая некий «крупнейший в мире» объект. Примечательно, что после покупки социальной сети Twitter (ныне X), Маск и его менеджмент не хотели платить за услуги Oracle (а также AWS и Google), пытаясь оптимизировать расходы.

13.05.2024 [11:12], Сергей Карасёв

Supermicro представила ИИ-серверы на базе Intel Gaudi3 и AMD Instinct MI300XКомпания Supermicro анонсировала новые серверы для задач ИИ и НРС. Дебютировали системы высокой плотности с жидкостным охлаждением, а также устройства, оборудованные высокопроизводительными ускорителями AMD, Intel и NVIDIA.

Источник изображений: Supermicro В частности, представлены серверы SYS-421GE-TNHR2-LCC и AS-4125GS-TNHR2-LCC в форм-факторе 4U, оснащённые СЖО. Первая из этих моделей рассчитана на установку двух процессоров Intel Xeon Emerald Rapids или Xeon Sapphire Rapids (до 385 Вт), а также 32 модулей DDR5-5600. Второй сервер поддерживает два чипа AMD EPYC 9004 Genoa с показателем TDP до 400 Вт и 24 модуля DDR5-4800. Обе новинки могут быть оборудованы восемью ускорителями NVIDIA H100 (SXM). В одной стойке могут размещаться до восьми серверов, что в сумме даст 64 ускорителя. При этом общая заявленная производительность такого кластера на операциях FP16 превышает 126 Пфлопс. Серверы оборудованы восемью фронтальными отсеками для SFF-накопителей NVMe. Питание обеспечивают четыре блока мощностью 5250 Вт с сертификатом Titanium. Слоты расширения выполнены по схеме 8 × PCIe 5.0 x16 LP и 2 × PCIe 5.0 x16 FHHL. На ISC 2024 компания Supermicro также демонстрирует сервер типоразмера 8U, оборудованный ускорителями Intel Gaudi3. Это одна из первых систем такого рода. Кроме того, представлена система AS-8125GS-TNMR2 формата 8U, рассчитанная на восемь ускорителей AMD Instinct MI300X. Этот сервер может комплектоваться двумя процессорами EPYC 9004 с TDP до 400 Вт, 24 модулями оперативной памяти DDR5-4800, фронтальными накопителями SFF (16 × NVMe и 2 × SATA), двумя модулями M.2 NVMe. Установлены шесть блоков питания на 3000 Вт с сертификатом Titanium. Наконец, Supermicro готовит серверы формата 4U с жидкостным охлаждением, которые могут оснащаться восемью ускорителями NVIDIA H100 и H200. Компания демонстрирует на конференции ISC 2024 и другие системы для приложений ИИ, а также задач НРС.

12.05.2024 [21:57], Сергей Карасёв

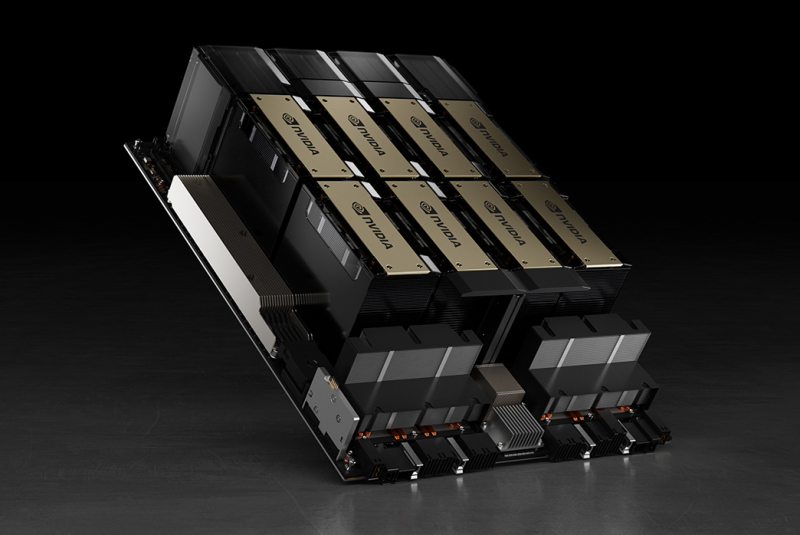

ИИ федерального значения: правительственные учреждения США получат 17-Пфлопс суперкомпьютер на базе NVIDIA DGX SuperPOD H100Компания NVIDIA сообщила о том, что её система DGX SuperPOD ляжет в основу нового вычислительного комплекса для задач ИИ, который будет использоваться различными правительственными учреждениями США для проведения исследований в области климатологии, здравоохранения и кибербезопасности. Внедрением суперкомпьютера занимается MITRE — американская некоммерческая организация, специализирующаяся в области системной инженерии. Она ведёт разработки и исследования в интересах госорганов США, включая Министерство обороны (DoD), Федеральное управление гражданской авиации (FAA) и пр. Система DGX SuperPOD станет основой вычислительной платформы MITRE Federal AI Sandbox, доступ к ресурсам которой будет предоставляться различным организациям на федеральном уровне. Государственные учреждения смогут сообща использовать суперкомпьютер для обучения больших языковых моделей (LLM), развёртывания генеративных приложений и других современных ИИ-решений. В состав MITRE Federal AI Sandbox войдут 32 системы NVIDIA DGX H100, а общее количество ускорителей NVIDIA H100 составит 256 штук. Производительность на операциях ИИ будет достигать примерно 1 Эфлопс. Быстродействие FP64 — приблизительно 17 Пфлопс. Ввод суперкомпьютера в эксплуатацию состоится позднее в текущем году. «Развёртывание MITRE DGX SuperPOD поможет ускорить реализацию инициатив федерального правительства США в области ИИ. Технологии ИИ обладают огромным потенциалом для улучшения государственных услуг в гражданской области и решения серьёзных проблем, в том числе в сфере кибербезопасности», — сказал Энтони Роббинс (Anthony Robbins), вице-президент NVIDIA.

10.05.2024 [23:47], Сергей Карасёв

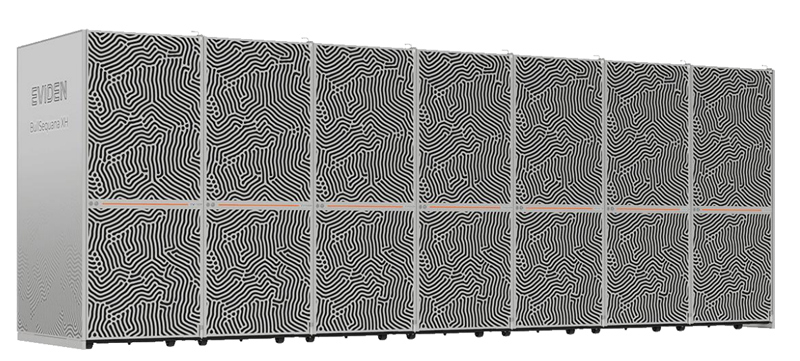

Eviden представила семейство ИИ-серверов BullSequana AIКомпания Eviden (дочерняя структура Atos) анонсировала серверы серии BullSequana AI, предназначенные для решения ИИ-задач. В зависимости от модификации и уровня производительности устройства подходят для различных сценариев использования — от НРС-платформ до периферийных вычислений. Наиболее производительными серверами семейства являются решения BullSequana AI 1200H. Они могут применяться в составе облачных и гибридных инфраструктур, а также в дата-центрах заказчиков. По сути, это суперкомпьютер корпоративного уровня, специально разработанный для ресурсоёмких задач, таких как точная настройка ИИ-систем или обучение больших языковых моделей (LLM). Конфигурация BullSequana AI 1200H включает суперчипы NVIDIA Grace Hopper, а также интерконнект NVIDIA Quantum-2 InfiniBand. Задействовано программное обеспечение Eviden Jarvice XE, Eviden Smart Energy Management Suite, Eviden Smart Management Center и NVIDIA AI Enterprise. Серверы BullSequana AI 1200H, насчитывающие в общей сложности 1456 ускорителей NVIDIA H100, выбраны для модернизации французского суперкомпьютера Jean Zay. Производительность этого НРС-комплекса увеличится более чем в три раза — с 36,85 до 125,9 Пфлопс. Кроме того, в новое семейство серверов вошли производительные устройства BullSequana AI 800, системы BullSequana AI 600 с воздушным и гибридным охлаждением, модели BullSequana AI 200 для частных и гибридных облачных сред, а также BullSequana AI 100 для периферийных вычислений. В целом, как отмечается, каждая модель BullSequana AI предлагает различные уровни производительности, масштабируемости и гибкости. Таким образом, заказчики могут подобрать наиболее подходящий для себя вариант в зависимости от конкретного варианта использования, бюджета и размера бизнеса.

26.04.2024 [11:46], Сергей Карасёв

HPE построила самый мощный в Польше суперкомпьютер Helios производительностью 35 ПфлопсКомпания HPE сообщила о создании нового суперкомпьютера под названием Helios для Академического компьютерного центра Cyfronet Научно-технического университета AGH в Кракове (Польша). Вычислительный комплекс будет использоваться для решения ресурсоёмких задач, связанных с ИИ. На сегодняшний день Helios — самая высокопроизводительная система в Польше. Она обеспечивает теоретическую пиковую производительность на уровне 35 Пфлопс, что более чем в четыре раза превосходит показатель предыдущего флагманского суперкомпьютера Cyfronet. Пиковое быстродействие на ИИ-операциях достигает 1,8 Эфлопс. В основу Helios положены узлы HPE Cray EX. Комплекс состоит из трёх сегментов. Один из них предназначен для традиционных вычислений, еще один — для рабочих нагрузок, связанных с обработкой больших данных. Третий сегмент оптимизирован для ИИ-задач: он использует суперчипы NVIDIA. Суперкомпьютер планируется применять при реализации проектов в области химии, медицины, создания передовых материалов, астрономии и защиты окружающей среды. Раздел общего назначения использует процессоры AMD EPYC поколения Genoa. Общее количество вычислительных ядер Zen 4 составляет 75 264, объём оперативной памяти DDR5 — 200 Тбайт. Сегмент для работы с большими данными основан на платформе HPE Cray Supercomputing XD665 с чипами EPYC Genoa, памятью DDR5-4800, быстрыми накопителями NVMe и ускорителями NVIDIA H100, суммарное количество которых равно 24.

Источник изображения: HPE Наконец, ИИ-раздел объединяет 440 суперчипов NVIDIA GH200 Grace Hopper для компьютерного моделирования с интенсивным использованием графики, поддержки приложений на основе генеративного ИИ и пр. Все компоненты вычислительного комплекса связаны друг с другом посредством 200G-интерконнекта HPE Slingshot. Комплекс Helios оснащён Lustre-хранилищем общей вместимостью 17,5 Пбайт на базе HPE Cray ClusterStor E1000.

15.04.2024 [14:23], Сергей Карасёв

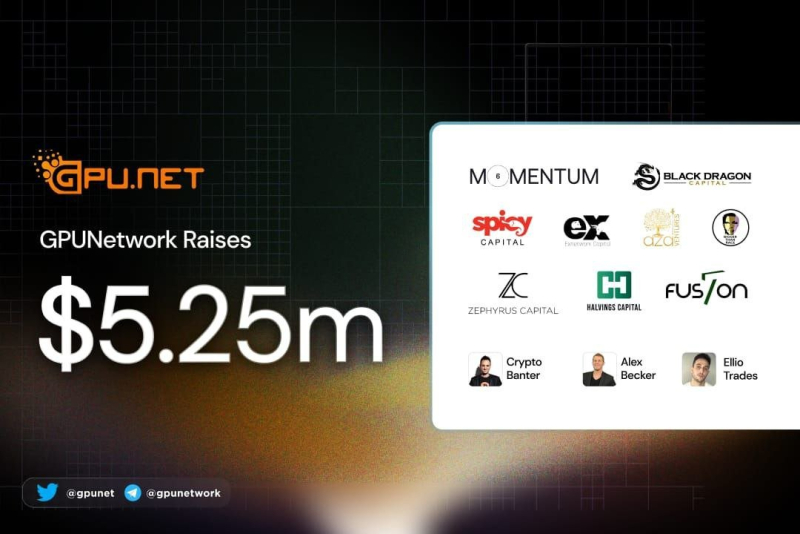

Стартап в области децентрализованных облачных ИИ-вычислений GPUnet получил на развитие $5,25 млнМолодая компания GPUnet, занимающаяся технологиями облачных вычислений, сообщила о проведении раунда финансирования Series A, в ходе которого привлечено $5,25 млн. В число инвесторов вошли Momentum6, Spicy Capital, Exnetwork, Blackdragon, Zephyrus Capital, Aza Ventures, F7 Foundation, Halvings Capital и Bigger than Race. Стартап GPUnet создаёт платформу децентрализованных облачных вычислений на базе GPU. Отмечается, что в свете стремительного развития технологий ИИ ускорители на базе GPU превратились в дефицитный ресурс. Вместе с тем в мировом масштабе четыре крупнейших поставщика облачных услуг — Amazon, Google, Microsoft и Oracle — контролируют 80 % соответствующих мощностей. В результате компании и исследовательские организации вынуждены либо подписываться на сервисы по значительной цене, либо закупать собственное оборудование. Но во втором случае требуются навыки управления ЦОД, а поставки ускорителей занимают много времени. GPUnet рассчитывает решить перечисленные проблемы путём объединения в единую сеть ресурсов независимых операторов дата-центров, которые специализируются на «вычислениях для проектов Web3», в частности, для майнинга. Отмечается, что такие операторы зачастую располагают ценными вычислительными ресурсами в небольших кластерах. GPUnet планирует использовать архитектуру распределённых вычислений, чтобы объединить кластеры в единую экосистему, создав удобную облачную среду для разработчиков и исследователей. На веб-сайте GPUnet говорится, что посредством новой платформы клиенты получают доступ к ускорителям NVIDIA. В частности, стоимость аренды H100 составляет $5/час, A100 — $1,5/час, А10 — $1/час. К 2030 году GPUnet рассчитывает объединить в своей экосистеме до 1 млн GPU.

12.04.2024 [21:28], Сергей Карасёв

Dell сумела сократить сроки поставок ИИ-серверов, но теперь компания полагается не только на ускорители NVIDIA, но и на Intel Gaudi3Компании Dell, по сообщению The Register, удалось сократить сроки поставок серверов для задач ИИ в несколько раз. Речь идёт о высокопроизводительных системах с ускорителями на основе GPU, в том числе NVIDIA H100. Спрос на них настолько высок, что производители не справляются с потоком заказов. О текущей ситуации в отрасли рассказал руководитель тайваньского подразделения Dell Теренс Ляо (Terence Liao). В конце 2023 года срок поставок серверов Dell, оборудованных ускорителями H100, составлял в среднем 39 недель, или около 8–9 месяцев. По словам Ляо, с февраля 2024-го отгрузки продукции NVIDIA значительно улучшились, и Dell смогла уменьшить сроки поставок серверов до 8–12 недель, или 2–3 месяцев. Таким образом, время выполнения заказов уменьшилось в три–четыре раза. Тем не менее, дефицит высокопроизводительных ИИ-ускорителей сохраняется. Связано это в том числе с возможностями TSMC по выпуску чипов с применением технологии CoWoS (Chip on Wafer on Substrate). Именно компоновка CoWoS применяется при изготовлении Н100. В сентябре 2023 года спрос на передовые технологии упаковки чипов был настолько высоким, что TSMC заявила о способности удовлетворить только 80 % заказов. Вместе с тем TSMC сообщила о намерении расширить производственные мощности CoWoS на 20 % — это поможет смягчить проблему дефицита ИИ-ускорителей. Между тем Dell приходится искать альтернативы ускорителям NVIDIA. В частности, она намерена использовать ИИ-ускорители Intel Gaudi3. Поддержка Gaudi3 заявлена для сервера Dell XE9680, который также поддерживает ускорители AMD Instinct MI300X. Эта ИИ-платформа наделена 32 слотами для модулей памяти DDR5, восемью разъёмами PCIe 5.0 и шестью портами OSFP 800GbE. Возможна установка 16 накопителей EDSFF3.

05.04.2024 [14:30], Владимир Мироненко

Представлены российские HPC-узлы «РСК Экзастрим ИИ» с восемью ускорителями и фирменной СЖОГруппа компаний РСК представила модульное решение «РСК Экзастрим ИИ», предназначенное, как видно из названия, для развития ИИ-инфраструктуры в России. Новинка представляет собой серверный узел высотой 2U на базе Intel Xeon Sapphire Rapids, который включает до восьми ускорителей, например, NVIDIA H100. 32 слота DDR5 позволяют установить до 8 Тбайт RAM. В узел можно установить до восьми SSD в форм-факторе EDSFF E1.S общим объёмом до 20 Тбайт. Надлежащий температурный режим обеспечивает фирменная СЖО РСК с температурой хладоносителя +40–+50 °C. Спецификации устройства также включают до четырёх подключений Infiniband HDR/NDR, поддержку сети 10GbE и фирменный блок питания с жидкостным охлаждением.

Источник изображений: РСК Пиковая производительность «РСК Экзастрим ИИ» при использовании ускорителей NVIDIA H100 составляет 208/408 Тфлопс (FP64/TF64). В универсальном шкафу «РСК Экзастрим» высотой 42U можно разместить до 21 вычислительного узла «РСК Экзастрим ИИ», благодаря чему суммарная пиковая производительного такой стойки составит 4,368/8,568 Пфлопс (FP64/TF64) при энергопотреблении всего 115 кВт.

29.03.2024 [21:54], Сергей Карасёв

Eviden увеличит производительность французского суперкомпьютера Jean Zay более чем втроеФранцузское национальное агентство по высокопроизводительным вычислениям (GENCI) и Национальный центр научных исследований (CNRS) заключили соглашение с компанией Eviden (дочерняя структура Atos) о модернизации НРС-комплекса Jean Zay. Ожидается, что производительность этого суперкомпьютера увеличится приблизительно в 3,5 раза. В рамках проекта Eviden оборудует комплекс 1456 ускорителями NVIDIA H100 в дополнение к 416 ускорителям NVIDIA A100 и 1832 ускорителям NVIDIA V100, которые задействованы в настоящее время. Модернизация предполагает использование 14 стоек суперкомпьютерной платформы Eviden BullSequana XH3000. В общей сложности будут задействованы 364 двухпроцессорных узла на базе Intel Xeon Sapphire Rapids с 48 ядрами. Каждый сервер получит 512 Гбайт оперативной памяти и четыре ускорителя NVIDIA H100 SXM5. Говорится об использовании адаптеров NVIDIA ConnectX-7.

Источник изображения: Eviden Проект также предусматривает комплексное обновление подсистемы хранения данных. Она будет состоять из флеш-массива вместимостью 4,3 Пбайт со скоростями чтения/записи свыше 1 Тбайт/с и дискового массива ёмкостью 39 Пбайт со скоростями чтения/записи более 300 Гбайт/с. Компоненты СХД поставит компания DataDirect Networks (DDN). Для обоих уровней хранения предусмотрено использование файловой системы Lustre.

Фото: Photothèque CNRS/Cyril Frésillon Ожидается, что модернизация позволит увеличить пиковую производительность Jean Zay с 36,85 до 125,9 Пфлопс. Проект получил финансирование в рамках национальной инвестиционной программы «Франция 2030». Усовершенствованный суперкомпьютер будет использоваться для решения ресурсоёмких задач, в том числе в области ИИ. Отмечается, что Jean Zay — это один из наиболее экологичных суперкомпьютеров в Европе. Отчасти это достигается благодаря использованию генерируемого машиной тепла для обогрева более 1000 зданий в кампусе Париж-Сакле.

23.03.2024 [16:02], Сергей Карасёв

Supermicro представила ИИ-системы SuperCluster с ускорителями NVIDIA H100/H200 и суперчипами GH200Компания Supermicro анонсировала вычислительные кластеры SuperCluster с ускорителями NVIDIA, предназначенные для обработки наиболее ресурсоёмких приложений ИИ и обучения больших языковых моделей (LLM). Дебютировали системы, оснащённые жидкостным и воздушным охлаждением. В частности, представлен комплекс SuperCluster в составе пяти стоек на основе 4U-узлов СЖО. Каждый из узлов может нести на борту два процессора Intel Xeon Sapphire Rapids / Xeon Emerald Rapids или два чипа AMD EPYC 9004 (Genoa), дополненные памятью DDR5-5600. Доступны восемь фронтальных отсеков для SFF-накопителей NVMe и два слота M.2 NVMe. Каждый из узлов рассчитан на установку восьми ускорителей NVIDIA H100 или H200. Таким образом, в общей сложности SuperCluster с 32 узлами насчитывает до 256 ускорителей. Говорится о применении интерконнекта NVIDIA Quantum-2 InfiniBand, а также Ethernet-технологии NVIDIA Spectrum-X. Используется платформа для работы с ИИ-приложениями NVIDIA AI Enterprise 5.0, которая теперь включает микросервисы на базе загружаемых контейнеров.

Источник изображений: Supermicro Ещё одна система SuperCluster предусматривает конфигурацию из девяти стоек с узлами в форм-факторе 8U с воздушным охлаждением. У таких узлов во фронтальной части находятся 12 отсеков для SFF-накопителей NVMe и три отсека для SFF-устройств с интерфейсом SATA. В остальном характеристики аналогичны решениям типоразмера 4U. Общее количество узлов в системе равно 32.  Кроме того, вышел комплекс SuperCluster с девятью стойками на основе узлов 1U с воздушным охлаждением. Эти узлы комплектуются суперчипом NVIDIA GH200 Grace Hopper. Есть восемь посадочных мест для накопителей E1.S NVMe и два коннектора M.2 NVMe. В кластере объединены 256 узлов. Отмечается, что данная система оптимизирована для задач инференса в облачном масштабе. |

|