Материалы по тегу: облако

|

16.05.2024 [23:30], Алексей Степин

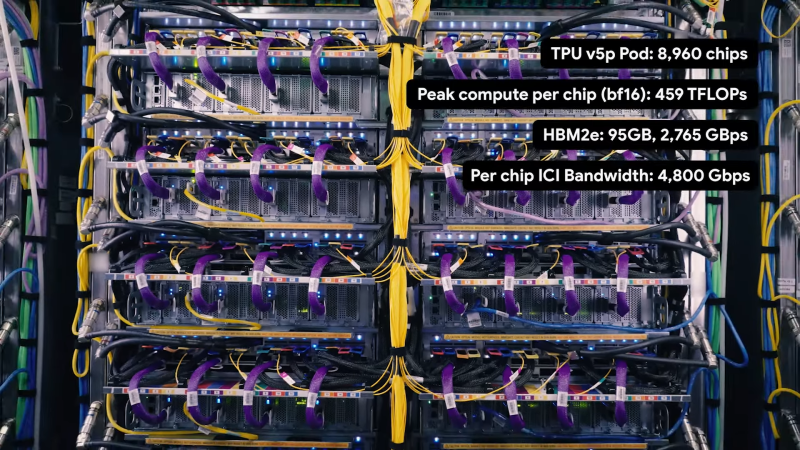

Шестое поколение ускорителей Google TPU v6 готово к обучению ИИ-моделей следующего поколенияGoogle успешно занимается разработкой ИИ-ускорителей порядка 10 лет. В прошлом году компания заявила, что четвёртое поколение TPU в связке с фирменными оптическими коммутаторами превосходит кластеры на базе NVIDIA A100 с интерконнектом InfiniBand, а к концу того же года было представлено уже пятое поколение, причём в двух вариантах: энергоэффективные TPU v5e для малых и средних ИИ-моделей и высокопроизводительные TPU v5p для больших моделей. Сбавлять темпа компания явно не собирается — не прошло и полугода, как было анонсировано последнее, шестое поколение TPU, получившее, наконец, собственное имя — Trillium. Клиентам Gooogle Cloud новинка станет доступна до конца этого года, в том числе в составе AI Hypercomputer. Сведений об архитектуре и особенностях Trillium пока не очень много, но согласно заявлениям разработчиков, он в 4,7 раза быстрее TPU v5e.

Источник: The Verge Ранее аналитик Патрик Мурхед (Patrick Moorhead) опубликовал любопытное фото, на котором глава подразделения кастомных чипов Broadcom держит в руках некий XPU, разработанный для «крупной ИИ-компании». Не исключено, что сделан он именно для Google. На снимке видна чиплетная сборка из двух крупных кристаллов в окружении 12 стеков HBM-памяти. Любопытно и то, что TPU v6 нарекли точно так же, как и проект Arm шестилетней давности по созданию нового поколения ИИ-ускорителей. Пропускная способность 32 Гбайт набортной HBM-памяти составляет 1,6 Тбайт/с. Межчиповый интерконнект ICI имеет пропускную способность до 3,2 Тбит/с, хотя в TPU v5p скорости ICI уже 4,8 Тбит/с. По словам Google, новый чип получился на 67% энергоэффективнее TPU v5e. Складывается ощущение, что компания сознательно избегает сравнения с TPU v5p. Но это объяснимо, поскольку заявленный почти пятикратный прирост производительности в сравнении с TPU v5e даёт примерно 926 Тфлопс в режиме BF16 и 1847 Топс в INT8, что практически вдвое выше показателей TPU v5p.

Кластер Google на базе TPU v5e. Источник: Google При этом компания не бравирует высокими цифрами в INT4/FP4, как это делает NVIDIA в случае с Blackwell. Согласно опубликованным данным, прирост производительности достигнут за счёт расширения блоков перемножения матриц (MXU) и прироста тактовой частоты. В новом TPU также использовано новое, третье поколение блоков SparseCore, предназначенных для ускорения работы с ИИ-модели, часто использующихся в системах ранжирования и рекомендаций. Масштабируется Trillium практически так же, как TPU v5e — в составе одного блока («пода») могут работать до 256 чипов. Эти «поды» формируют кластер с технологией Multislice, позволяющий задействовать в одной задаче до 4096 чипов. В таких кластерах на помощь приходят DPU Titanium, берущие на себя обслуживание IO-операций, сети, виртуализации, безопасности и доверенных вычислений. Размеры кластера могут достигать сотен «подов». Google полагает, что TPU v6 готовы к приходу ИИ-моделей нового поколения и имеет для этого все основания: ориентировочно каждый Trillium с его 32 Гбайт быстрой памяти может оперировать примерно 30 млрд параметров, а речь, напомним, в перспективе идёт о десятках тысяч таких чипов в одном кластере. В качестве интерконнекта в таких системах используется платформа Google Jupiter с оптической коммутацией, совокупная пропускная способность которой уже сейчас превышает 6 Пбайт/с.

16.05.2024 [14:22], Руслан Авдеев

xAI Илона Маска потратит $10 млрд на облачные ИИ-серверы Oracle для чат-бота GrokИИ-стартап Илона Маска (Elon Musk) xAI готов потратить $10 млрд на серверы в облаке Oracle. По данным The Information, ссылающейся на осведомлённые источники, компании ведут переговоры о долгосрочном сотрудничестве, которое сделает детище Маска одним из крупнейших клиентов Oracle. Предполагается, что xAI требуется больше вычислительных ресурсов для соперничества с OpenAI, Anthropic и другими компаниями, уже заключившими многомиллиардные инвестиционные сделки с Microsoft и AWS соответственно. Это позволяет им получать доступ к облачной инфраструктуре для обучения и запуска больших языковых моделей (LLM). Например, Microsoft и OpenAI, по слухам, готовы потратить $100 млрд на кампус ЦОД Stargate ёмкостью 5 ГВт. Пока Micosoft вынуждена сама арендовать часть ИИ-ускорителей у Oracle. В прошлом году xAI представила чат-бот Grok, доступный платным пользователям соцсети X, а сейчас разрабатывается вторая версия. Имеются сведения, что xAI завершает раунд привлечения инвестиций в размере $6 млрд, а Маск уже заявил, что полученные средства будут потрачены на аренду инфраструктуры. В прошлом месяце миллиардер заявил, что новинка обучается на 20 тыс. ускорителей NVIDIA, но для Grok 3.0 потребуется уже 100 тыс. ускорителей. Маск и основатель Oracle Ларри Эллисон (Larry Ellison) крепко дружат, кроме того, Элиссон входил в совет директоров Tesla. В декабре прошлого года он заявлял, что xAI уже является крупнейшим клиентом Oracle и утверждал, что у облачного гиганта достаточно ускорителей для Grok первого поколения, но, по его признанию, в xAI хотят намного больше. Сейчас xAI арендует у Oracle 15 тыс. ускорителей NVIDIA H100. Tesla, ещё одно детище Маска, уже ввела в эксплуатацию ИИ-ресурсы, эквивалентные по производительности 35 тыс. H100. ИИ-инфраструктура стала выгодным источником дохода для облачного оператора, в марте Эллисон заявлял, что компания строит новые ЦОД, включая некий «крупнейший в мире» объект. Примечательно, что после покупки социальной сети Twitter (ныне X), Маск и его менеджмент не хотели платить за услуги Oracle (а также AWS и Google), пытаясь оптимизировать расходы.

16.05.2024 [01:15], Владимир Мироненко

МТС вложит в облачную платформу MWS 7,5 млрд рублейМТС сообщила о планах своей дочерней компании MWS (MTS Web Services), которой будут переданы все облачные сервисы CloudMTS, ЦОД-инфраструктура МТС, а также некоторые ИБ-сервисы МТС RED. До конца этого года MWS, как ожидается, запустит целый ряд новых сервисов и направлений и займётся разработкой обновлённой публичной облачной платформы, в создание которой до конца 2025 года будет вложено более 7,5 млрд руб. Публичная облачная платформа MWS задумана как экосистема инфраструктурных и сетевых сервисов, инструментов для хранения и обработки данных, PaaS и решений для защиты облачной инфраструктуры собственной разработки. Её создание ведётся в соответствии со стандартами информационной безопасности и защиты персональных данных, говорит компания. Согласно планам MWS, платформа станет доступной для бизнеса и пользователей в 2025 году. MWS также работает над усилением собственной информационной безопасности, для чего интегрирует в своё облако ряд сервисов МТС RED. Решения МТС RED будут обеспечивать защиту всех облачных сервисов компании, включая не связанные с кибербезопасностью, например, инфраструктурных, сетевых, бизнес-приложений, сред разработки и т.д. Как утверждает компания, это сделает миграцию в облако ещё более безопасной.

Источник изображения: MWS Планы MWS на этот год также включают запуск более 30 новых продуктов Enterprise-уровня, в числе которых сервисы по хранению, вычислению и информационной безопасности, базы данных, сетевые и корпоративные сервисы, приложения для разработчиков. Также будет развёрнут выделенный сегмент облака полностью на российском софте и оборудовании. В 2024 году MWS планирует запустить ещё одно новое направление — ИИ-облако. Оно будет включать виртуальную инфраструктуру с ускорителями, специализированное ПО для разработки, обучения и развертывания ML-моделей, уже готовые ИИ-модели для разных индустрий и направлений, доступные по API, и ИИ-сервисы по модели SaaS. Кроме того, в случае необходимости заказчику будет предоставлена команда экспертов на всех этапах внедрения и использования ИИ. А для удовлетворения растущего спроса GPU-мощности компании будут увеличены в два раза. Для решения особых ИТ-задач бизнеса будет создано подразделение Professional Services, специалисты которого помогут клиентам провести аудит ИТ-инфраструктуры и ИБ-решений предприятия, составить стратегию их облачного развития, а также провести миграцию в выделенный сегмент виртуальной инфраструктуры и взять на себя поддержку гибридных и частных инсталляций. При этом специалисты будут привлекать и интегрировать в облако партнёрские решения по модели SaaS в самых разных отраслях.

15.05.2024 [00:43], Владимир Мироненко

В AWS смена руководства — вместо Адама Селипски облачное направление возглавит Мэтт ГарманAmazon объявила о кадровых перестановках в облачном подразделении Amazon Web Services (AWS), пишет The Register. Гендиректор Amazon Энди Ясси (Andy Jassy) сообщил в служебном письме для сотрудников, что гендиректор AWS Адам Селипски (Adam Selipsky) покидает компанию, чтобы заняться новыми проектами. Вместо него с 3 июня этот пост займёт Мэтт Гарман (Matt Garman), в настоящее время занимающий должность старшего вице-президента по продажам и маркетингу AWS. Селипски был одним из первых вице-президентов Amazon, нанятых в AWS в 2005 году. Он в течение 11 лет руководил отделом продаж, маркетинга и поддержки, после чего в 2016 году покинул компанию, чтобы возглавить разработчика ПО для визуализации данных Tableau. Затем он вернулся в Amazon в 2021 году на пост гендиректора AWS. Энди Ясси, возглавлявший AWS вплоть до ухода Джеффа Безоса (Jeff Bezos) в 2021 году, поблагодарил в письме Селипски за 15 лет работы в компании. Он отметил, что Селипски «взял на себя управление в разгар пандемии» и «принял правильное долгосрочное решение, чтобы помочь клиентам более эффективно расходовать средства, даже если это означало снижение в краткосрочной перспективе доходов для AWS». Ясси также признался, что всегда знал, что Селипски будет недолго работать в компании после прихода в 2021 году. Согласно договорённости, Селипски должен был за это время помочь в подготовке следующего поколения лидеров. Еще до прихода Селипски на пост гендиректора AWS многие считали Гармана одним из главных претендентов на эту должность. Мэтт Гарман был принят в Amazon в качестве стажёра в 2005 году и с 2006 года работал в компании в качестве одного из первых менеджеров по продуктам AWS. Затем он возглавля несколько ключевых продуктовых подразделений, включая Amazon EC2, после чего стал руководителем отдела продаж и маркетинга. В своём письме Ясси отметил, что Гарман, ветеран компании с 18-летним стажем, обладает «необычайно сильным набором навыков и опыта для своей новой должности». AWS по-прежнему является лидером в сфере облачных технологий и остаётся одним из самых прибыльных бизнес-подразделений Amazon. В последнем квартале AWS принесла Amazon 67,2 % её всей прибыли. Её положению на рынке угрожает быстрорастущий облачный бизнес Microsoft Azure. Когда Селипский занял пост гендиректора AWS в 2021 году, аналитики подсчитали, что размеры бизнеса Azure составляли примерно 61 % от AWS, а в настоящее время этот показатель приближается к 77 %. Тем не менее, AWS на облачном рынке имеет долю около 31 %, ещё 25 % занимает Microsoft Azure, а 11 % — у Google Cloud.

14.05.2024 [00:19], Руслан Авдеев

Microsoft потратит €4 млрд на ЦОД для ИИ и облаков во Франции, а AWS постарается не отстатьMicrosoft планирует инвестировать €4 млрд ($4,31 млрд) на создание инфраструктуры ЦОД во Франции и заключение соглашений о покупке «зелёной» энергии (PPA). Планы по развитию бизнеса в стране имеет и основной конкурент в лице Amazon. Новый ЦОД Microsoft построят близ города Мюлуз (Mulhouse) на востоке Франции, а уже существующие площадки в Париже и Марселе IT-гигант намерен расширить. Реализацию нового проекта анонсировали 13 мая на инвестиционном саммите Choose France, проводимом главой страны Эммануэлем Макроном (Emmanuel Macron). Уже имеющиеся во Франции ЦОД Microsoft открыла в 2017 году. По словам президента Microsoft Брэда Смита (Brad Smith), крупные инвестиции демонстрируют приверженность компании к поддержке цифровых инноваций и экономического развития Франции. Компания строит в стране передовую облачную и ИИ-инфраструктуру, а к 2027 году намерена обучить работе с ИИ 1 млн человек и поддержать 2,5 тыс. местных ИИ-стартапов. Реализация нового плана предполагает поставку более 25 тыс. самых современных ИИ-ускорителей к концу 2025 года. При этом не сообщается, какое оборудование будет закупаться. На фоне планов Microsoft иметь к концу 2024 года 1,8 млн ускорителей — это просто капля в море.

Источник изображения: Microsoft Ранее появлялась информация о намерении превратить в ЦОД бывший автозавод в Ренне на западе страны, но ничего подобного в ходе последнего анонса не упоминалось. Также Microsoft упомянула о покупке PPA, но о сертификатах на какую именно возобновляемую энергию шла речь, не сказала. По данным компании, к концу 2024 года она оплатит экоустойчивые энергопроекты во Франции приблизительно на 100 МВт. Ранее уже появлялась информация, что облачный бизнес Microsoft ищет людей для расширения присутствия в Европе, Африке и на Ближнем Востоке, с поиском свободных площадок для новых ЦОД. Microsoft — не единственный гиперскейлер, желающий активно развиваться во Франции. Amazon также планирует инвестировать в цифровую инфраструктуру страны — компания готова выделить €1,2 млрд ($1,29 млрд) и обещает создать 3 тыс. рабочих мест. Деньги в основном пойдут на облачные проекты во Франции, связанные с ИИ-решениями, а также логистические сервисы для системы доставок Amazon. По информации компании, речь идёт о развитии облачной инфраструктуры в Париже — рабочие места будут создаваться дополнительно к тем 2 тыс., которые компания уже обещала обеспечить во Франции в 2024 году. Текущие вливания являются частью инвестицонного плана объёмом €6 млрд, который Amazon реализует в 2017–2031 гг.

13.05.2024 [22:33], Владимир Мироненко

Ресурсы в обмен на технологии: Alibaba Cloud предлагает ИИ-стартапам GPU-мощности за долю в компанииКитайский гигант электронной коммерции Alibaba по примеру Microsoft, финансировавшей успешный ИИ-стартап OpenAI, пытается расширить своё присутствие на рынке ИИ-технологий с помощью инвестиций в китайские стартапы в области генеративного ИИ. Разница лишь в том, что Alibaba предлагает большей частью не традиционное финансирование деньгами, а кредиты на использование своей облачной инфраструктуры для обучения ИИ-моделей, пишет газета Financial Times. В числе стартапов, пользующихся поддержкой Alibaba, газета назвала Moonshot, Zhipu, MiniMax и 01.ai, которые разрабатывают локальные версии американских приложений, таких как ChatGPT и чат-бот-аватар Character.ai. Так, в феврале этого года Alibaba возглавила раунд финансирования Moonshot AI, разработчика ИИ-решений для компаний в сфере электронной коммерции, включая чат-бот Kimi AI, привлёкшего $1 млрд инвестиций, после чего его рыночная стоимость оценивалась в $2,5 млрд. По словам источников Financial Times, Alibaba инвестировала в Moonshot AI $800 млн, но лишь чуть больше половины было предоставлено деньгами, а остальная часть поступила в виде кредитов на облачные вычисления. Как утверждают источники, в течение 2023 года глава Alibaba Эдди Юнмин У (Eddie Yongming Wu) лично контролировал выделение инвестиций четырём ведущим ИИ-стартапам Китая, что говорит о том, какое значение компания придаёт этому направлению. После отказа из-за санкций США от амбициозного плана реструктуризации, предполагавшего проведение IPO облачным подразделением, на фоне растущей конкуренцией со стороны ByteDance и PDD Holdings на своём основном рынке электронной коммерции, Alibaba пытается найти новые драйверы роста. После отмены реструктуризации Эдди Юнмин У взял под личный контроль облачный бизнес, сделав ставку на ИИ в скорректированной стратегии по стимулированию роста компании. Порядок выделения инвестиций Alibaba в Moonshot повторяет подход Microsoft и Amazon, согласно которому денежные средства передаются ИИ-стартапам при условии, что те будут использовать их для обучения и запуска моделей в облаках Azure и AWS соответственно. Разница заключается в том, что в случае Alibaba напрямую деньги никогда не передаются китайским стартапам. Вместо этого они хранятся на условном депонировании, который компания может считать поступающим доходом. «Предоставление вычислений на самом деле более ценно, чем наличные, — заявил китайский эксперт в области ИИ. — Из-за нехватки чипов очень сложно получить доступ к кластеру Alibaba из 10 тыс. ускорителей». Alibaba Cloud и другие игроки успели приобрести крупные объёмы современных ускорителей NVIDIA, в том числе урезанные A800 и H800, прежде чем США ввели ограничения. И теперь компания стремится извлечь из владения ими выгоду, прежде чем они устареют. Крупнейшие интернет-компании Китая, в том числе Alibaba, Meituan, Xiaohongshu и Tencent, играют огромную роль в финансировании новой волны ИИ-стартапов по сравнению с предыдущим поколением стартапов, где доминировали компании SenseTime и Megvii, специализирующиеся на разработке решений для распознавания лиц и видеонаблюдения.

11.05.2024 [13:52], Сергей Карасёв

CoreWeave вложит £1 млрд в ИИ ЦОД в ВеликобританииКомпания CoreWeave, специализирующаяся на предоставлении облачных услуг для решения ИИ-задач, по сообщению Datacenter Dynamics, намерена активно развивать бизнес в Великобритании. В ближайшее время в соответствующие проекты планируется инвестировать £1 млрд (приблизительно $1,25 млрд). Отмечается, что CoreWeave уже открыла представительство в Лондоне, которое станет европейской штаб-квартирой компании. В 2024 году CoreWeave намерена запустить в Великобритании два дата-центра с последующим развитием инфраструктуры в 2025-м. Подробности об этих ЦОД пока не раскрываются. Майк Интратор (Mike Intrator), соучредитель и генеральный директор CoreWeave, заявил, что укрепление присутствия в Великобритании является важной вехой на пути дальнейшего развития компании. CoreWeave рассчитывает разворачивать облачные сервисы на местном рынке, предоставляя клиентам вычислительные ресурсы для внедрения приложений ИИ.

Источник изображения: CoreWeave Стартап CoreWeave, основанный в 2017 году, изначально занимался майнингом криптовалют. Затем компания переориентировалась на вычисления общего назначения и хостинг проектов генеративного ИИ. Недавно CoreWeave привлекла финансирование в размере $1,1 млрд, получив оценку в $19 млрд. CoreWeave заявляет, что её сервисы с ускорителями NVIDIA позволяют клиентам выполнять задачи более эффективно и с повышенной производительностью, нежели традиционные публичные облака. На сегодняшний день CoreWave предоставляет услуги из трёх ЦОД-регионов. Это площадки US East в Уихокене (Нью-Джерси), US West в Лас-Вегасе (Невада) и US Central в Чикаго (Иллинойс). К концу 2024 года компания рассчитывает управлять в общей сложности 28 дата-центрами. В частности, CoreWeave намерена потратить не менее $1,6 млрд на ЦОД в городе Плано (Техас).

11.05.2024 [00:11], Сергей Карасёв

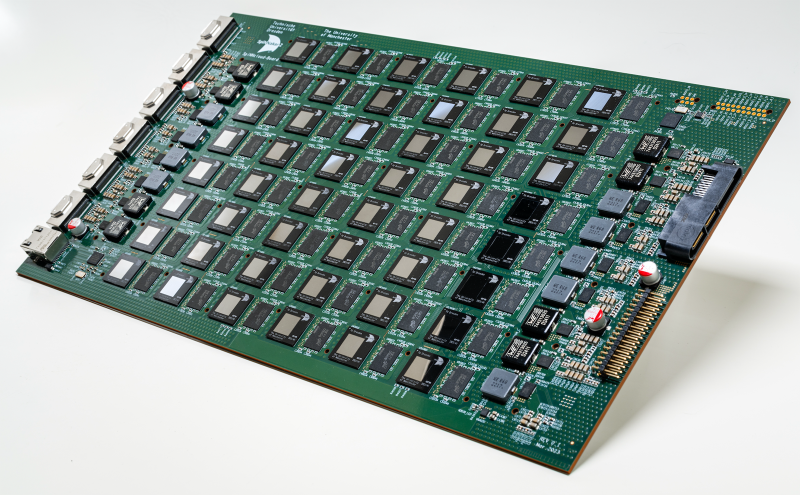

SpiNNcloud представила первый коммерческий «нейроморфный суперкомпьютер» SpiNNaker2 на базе ArmКомпания SpiNNcloud Systems анонсировала «нейроморфный суперкомпьютер» — гибридную высокопроизводительную вычислительную ИИ-систему, основанную, по словам компании, на принципах работы человеческого мозга. Утверждается, что это первое коммерчески доступное решение данного типа. Изделие базируется на архитектуре, разработанной Стивом Фербером (Steve Furber), одним из создателей оригинального процессора Arm. Идея заключается в применении большого количества маломощных чипов для более эффективной обработки ИИ-задач и других рабочих нагрузок. SpiNNaker2 представляет собой специализированную серверную плату с 48 чипами, каждый из которых насчитывает 152 ядра Arm. Таким образом, общее количество ядер составляет 7296. В состав чипов также входят различные дополнительные узлы, включая распределённые GPU-подобные блоки для ускорения обработки нейроморфных, гибридных и обычных моделей ИИ. В одну стойку могут монтироваться до 90 плат SpiNNaker2. Масштабирование осуществляется путём объединения таких стоек в кластер. В результате, как утверждается, возможно эмулирование в реальном времени как минимум 10 млрд взаимосвязанных нейронов. На операциях машинного обучения производительность может достигать 0,3 Эопс (1018 операций в секунду). Для сравнения — исследовательский нейроморфный компьютер Intel Hala Point поддерживает до 1,15 млрд нейронов и производительность до 30 Попс. От традиционных ИИ-платформ на базе GPU новое решение отличается универсальностью, говорит компания. Благодаря использованию многочисленных асинхронных блоков с низким энергопотреблением достигается более эффективное управление рабочими нагрузками. Со II половины 2024 года изделия SpiNNaker2 будут доступны в составе облачной платформы. В I половине 2025-го планируется организовать поставки самостоятельных систем. В число первых заказчиков SpiNNaker2 вошли Национальные лаборатории Сандия (Sandia National Laboratories), Технический университет Мюнхена (TUM) и Гёттингенский университет (Universität Göttingen).

09.05.2024 [21:40], Владимир Мироненко

Google Cloud случайно удалила частное облако австралийского пенсионного фонда UniSuper. И запасное тожеОколо недели более полумиллиона участников австралийского пенсионного фонда UniSuper не имели доступа к своим аккаунтам из-за сбоя, который привёл к удалению частного облака фонда в Google Cloud, пишет The Guardian. Главы UniSuper и Google Cloud выступили с совместным заявлением, согласно которому это был «отдельный, “единственный в своем роде случай”, который никогда раньше не происходил ни с одним из клиентов Google Cloud во всем мире». В Google Cloud отметили, что «сбой произошёл из-за беспрецедентной последовательности событий, в результате которых непреднамеренная неправильная конфигурация во время предоставления услуг частного облака UniSuper в конечном итоге привела к удалению подписки фонда на частное облако». Облачный провайдер заявил, что выявил события, которые привели к этому сбою, и принял меры, чтобы это больше не повторилось.

Источник изображения: UniSuper UniSuper дублирует данные в двух географических регионах, чтобы восстановить работу в случае потери одного из них. Но поскольку была удалена облачная подписка фонда целиком, это привело к потере в обоих облачных регионах. К счастью, фонд имел резервные копии у другого провайдера, поэтому данные удалось восстановить. Ранее UniSuper распределял рабочие нагрузки между сервисами Azure и двумя собственными ЦОД, но в прошлом году перенёс большую часть нагрузок на платформу Google Cloud Platform. UniSuper управляет средствами на сумму около $125 млрд. К полудню четверга по австралийскому времени облачная инфраструктура UniSuper восстановила работу, а участники фонда получили доступ к своим аккаунтам. Вместе с тем балансы счетов пока не будут обновляться, хотя, как сообщается, часть операций уже доступна, а финансы участников не пострадали. Google также заверила членов UniSuper, что сбой не был вызван кибератакой и, следовательно, их конфиденциальные данные не были раскрыты неавторизованным лицам. Сбои облачных сервисов случались и раньше, причём с ним сталкивались и основные провайдеры, включая AWS и Microsoft Azure. Но они справлялись с проблемами довольно быстро, чего не произошло в случае с UniSuper. Это может нанести ущерб Google с репутационной точки зрения и вызвать у клиентов недоверие к компании как поставщику услуг, говорит глава EEITrend. «На устранение сбоя в облаке UniSuper в Google Cloud в Австралии ушло необычно много времени, что негативно влияет на репутацию Google Cloud в регионе», — отметил он.

09.05.2024 [14:22], Сергей Карасёв

Стартап в сфере облачной безопасности Wiz привлёк $1 млрд, получив оценку в $12 млрдБыстрорастущий стартап Wiz, специализирующийся на средствах облачной безопасности, объявил о проведении крупного раунда финансирования, в ходе которого на дальнейшее развитие привлечён $1 млрд. При этом компания получила рыночную оценку на уровне $12 млрд. В качестве ключевых инвесторов выступили фонд Andreessen Horowitz, Lightspeed Venture Partners и Thrive Capital. Таким образом, в общей сложности стартап Wiz, основанный около четырёх лет назад, на сегодняшний день получил приблизительно $1,9 млрд внешний инвестиций. Wiz создаёт платформу, предоставляющую клиентам комплексную облачную защиту. Отмечается, что корпоративная облачная среда может включать более сотни программных компонентов с тысячами настроек. Wiz предлагает систему обеспечения безопасности всех этих элементов по типу единого окна. Компания заявляет, что её решение может устранять риски, связанные с облачными инстансами, всевозможными функциями, базами данных и пр. Средства кибербезопасности выявляют угрозы, собирая телеметрию из систем компании и сканируя её на наличие аномалий. Зачастую для получения таких данных применяются специальные программные агенты, которые клиентам приходится интегрировать во все защищаемые инстансы. На это требуются время и дополнительные усилия. Wiz утверждает, что её платформа ничуть не хуже собирает нужные данные без использования агентов. Такой подход не только устраняет ручную работу, но и позволяет избежать необходимости поддерживать эти агенты с течением времени. Причём на развертывание платформы Wiz требуется всего несколько минут. Система Wiz способна обнаруживать уязвимости в Kubernetes, сценариях «инфраструктура как код» и других низкоуровневых компонентах. Кроме того, платформа выявляет другие проблемы: например, она может предупреждать, когда облачная директория, содержащая конфиденциальные данные, доступна аномально большому количеству пользователей. Система также отслеживает попытки хакеров эксплуатировать уязвимости. Для каждого выявленного нарушения платформа генерирует графики и диаграммы, демонстрирующие, какие системы были скомпрометированы и в каком порядке. Далее администраторы могут использовать набор встроенных инструментов реагирования на инциденты. |

|