Материалы по тегу: ускоритель

|

16.05.2024 [23:30], Алексей Степин

Шестое поколение ускорителей Google TPU v6 готово к обучению ИИ-моделей следующего поколенияGoogle успешно занимается разработкой ИИ-ускорителей порядка 10 лет. В прошлом году компания заявила, что четвёртое поколение TPU в связке с фирменными оптическими коммутаторами превосходит кластеры на базе NVIDIA A100 с интерконнектом InfiniBand, а к концу того же года было представлено уже пятое поколение, причём в двух вариантах: энергоэффективные TPU v5e для малых и средних ИИ-моделей и высокопроизводительные TPU v5p для больших моделей. Сбавлять темпа компания явно не собирается — не прошло и полугода, как было анонсировано последнее, шестое поколение TPU, получившее, наконец, собственное имя — Trillium. Клиентам Gooogle Cloud новинка станет доступна до конца этого года, в том числе в составе AI Hypercomputer. Сведений об архитектуре и особенностях Trillium пока не очень много, но согласно заявлениям разработчиков, он в 4,7 раза быстрее TPU v5e.

Источник: The Verge Ранее аналитик Патрик Мурхед (Patrick Moorhead) опубликовал любопытное фото, на котором глава подразделения кастомных чипов Broadcom держит в руках некий XPU, разработанный для «крупной ИИ-компании». Не исключено, что сделан он именно для Google. На снимке видна чиплетная сборка из двух крупных кристаллов в окружении 12 стеков HBM-памяти. Любопытно и то, что TPU v6 нарекли точно так же, как и проект Arm шестилетней давности по созданию нового поколения ИИ-ускорителей. Пропускная способность 32 Гбайт набортной HBM-памяти составляет 1,6 Тбайт/с. Межчиповый интерконнект ICI имеет пропускную способность до 3,2 Тбит/с, хотя в TPU v5p скорости ICI уже 4,8 Тбит/с. По словам Google, новый чип получился на 67% энергоэффективнее TPU v5e. Складывается ощущение, что компания сознательно избегает сравнения с TPU v5p. Но это объяснимо, поскольку заявленный почти пятикратный прирост производительности в сравнении с TPU v5e даёт примерно 926 Тфлопс в режиме BF16 и 1847 Топс в INT8, что практически вдвое выше показателей TPU v5p.

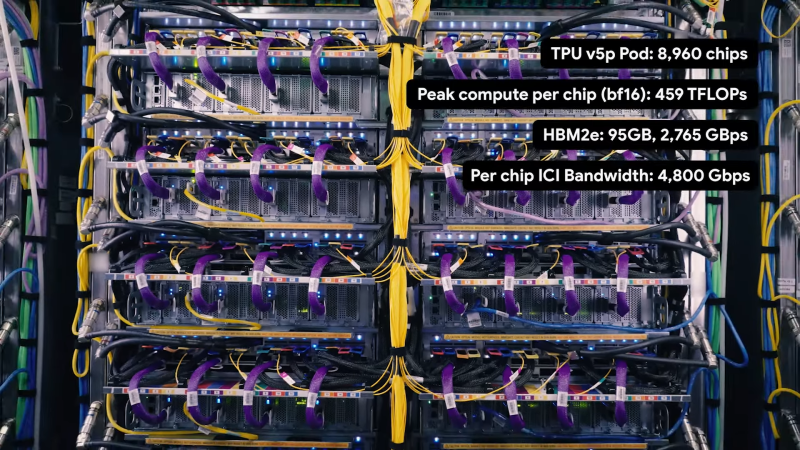

Кластер Google на базе TPU v5e. Источник: Google При этом компания не бравирует высокими цифрами в INT4/FP4, как это делает NVIDIA в случае с Blackwell. Согласно опубликованным данным, прирост производительности достигнут за счёт расширения блоков перемножения матриц (MXU) и прироста тактовой частоты. В новом TPU также использовано новое, третье поколение блоков SparseCore, предназначенных для ускорения работы с ИИ-модели, часто использующихся в системах ранжирования и рекомендаций. Масштабируется Trillium практически так же, как TPU v5e — в составе одного блока («пода») могут работать до 256 чипов. Эти «поды» формируют кластер с технологией Multislice, позволяющий задействовать в одной задаче до 4096 чипов. В таких кластерах на помощь приходят DPU Titanium, берущие на себя обслуживание IO-операций, сети, виртуализации, безопасности и доверенных вычислений. Размеры кластера могут достигать сотен «подов». Google полагает, что TPU v6 готовы к приходу ИИ-моделей нового поколения и имеет для этого все основания: ориентировочно каждый Trillium с его 32 Гбайт быстрой памяти может оперировать примерно 30 млрд параметров, а речь, напомним, в перспективе идёт о десятках тысяч таких чипов в одном кластере. В качестве интерконнекта в таких системах используется платформа Google Jupiter с оптической коммутацией, совокупная пропускная способность которой уже сейчас превышает 6 Пбайт/с.

11.05.2024 [13:46], Сергей Карасёв

Южнокорейский разработчик ИИ-чипов Deepx привлек более $80 млнЮжнокорейский стартап Deepx, занимающийся разработкой специализированных чипов для задач ИИ, сообщил о проведении раунда финансирования Series C, в ходе которого на развитие получено $80,5 млн. В инвестиционной программе принимают участие SkyLake Equity Partners, BNW Investments, AJU IB и TimeFolio Asset Management. Deepx была основана в 2018 году бывшим инженером Apple и Cisco Локвоном Кимом (Lokwon Kim). В настоящее время в Deepx работает около 65 человек. Компания подала примерно 260 патентных заявок в США, Китае и Южной Корее на различные разработки, связанные с ИИ. Полученные средства Deepx намерена направить на ускорение разработки и коммерциализации своих продуктов. Отмечается, что стартап ведёт переговоры более чем со 100 потенциальными клиентами и стратегическими партнёрами.

Источник изображения: Deepx Deepx проектирует ИИ-процессоры для разных сфер применения. Это, в частности, изделия DX-V1 и DX-V3 для бытовой электроники, DX-M1 для промышленных роботов и периферийных вычислений, а также DX-H1 для серверов. Производительность этих чипов на ИИ-операциях варьируется от 5 до 400 TOPS. Архитектура решений Deepx предусматривает сокращение интенсивности обмена данными с памятью DRAM, что позволяет повысить общую эффективность вычислений. Помимо аппаратных компонентов, Deepx предоставляет программную платформу DXNN, которая позволяет автоматически компилировать модели ИИ в формат, поддерживаемый чипами компании. Причём компилятор производит оптимизацию (квантование) моделей для улучшения производительности.

07.05.2024 [21:26], Руслан Авдеев

Apple работает над собственными серверными ИИ-ускорителямиКомпания Apple занимается разработкой собственных ИИ-полупроводников для дата-центров, передаёт The Wall Street Journal. В перспективе это поможет ей в «гонке вооружений», развернувшейся на рынке ИИ-решений. И у Apple есть ресурсы для создания передовых ИИ-чипов. В последние десять лет компания уже выбилась в лидеры полупроводниковой индустрии, представляя всё новые чипсеты для мобильных устройств и компьютеров Mac-серии. Как свидетельствуют источники СМИ, серверный проект Project ACDC (Apple Chips in Data Center) задействует компетенции компании в деле создания решений для ЦОД. Недавно сообщалось, что Apple наняла создателя ИИ-кластеров Google. Реализацию проекта Apple начала несколько лет назад, но данных о том, когда будут готовые первые чипы, пока нет. По имеющимся данным, компания уже тесно сотрудничает с TSMC. Предполагается, что чипы для серверов Apple будут оптимизированы для запуска ИИ-моделей, а не их обучения — на этом рынке по-прежнему будет доминировать NVIDIA. Время поджимает, поскольку Google и Microsoft уже имеют собственные ИИ-ускорители, хотя и разных классов — TPU и Maia 100. Обе компании имеют компетенции в области LLM, а Microsoft весьма дружна с OpenAI, которая тоже не прочь заняться «железом». Такое положение дел не устраивает инвесторов Apple, поскольку компания не продемонстрировала никаких впечатляющих успехов в соответствующей сфере, в то время как цена акций конкурентов продолжает расти на фоне новостей об их достижениях. В Apple пытаются убедить инвесторов, что это лишь временное явление и скоро грядут анонсы, связанные с ИИ. Опыт Apple в сфере разработки современных полупроводников должен помочь в создании ИИ-чипов. Сегодня компания представила 3-нм процессор M4 с самым мощным, по её словам, NPU в мире. Хотя компания добилась определённых успехов в разработке чипов для потребительской и профессиональной электроники, определённые задачи даются ей с трудом. Например, она всё ещё бьётся над созданием собственного беспроводного модуля. Хотя в Apple предпочли бы, чтобы большинство ИИ-вычислений осуществлялись силами самих чипов, некоторые задачи будут по-прежнему выполняться в облаке, где и пригодятся новые полупроводники. Это позволит компании лучше контролировать свою стратегию развития в сфере ИИ.

30.04.2024 [11:24], Сергей Карасёв

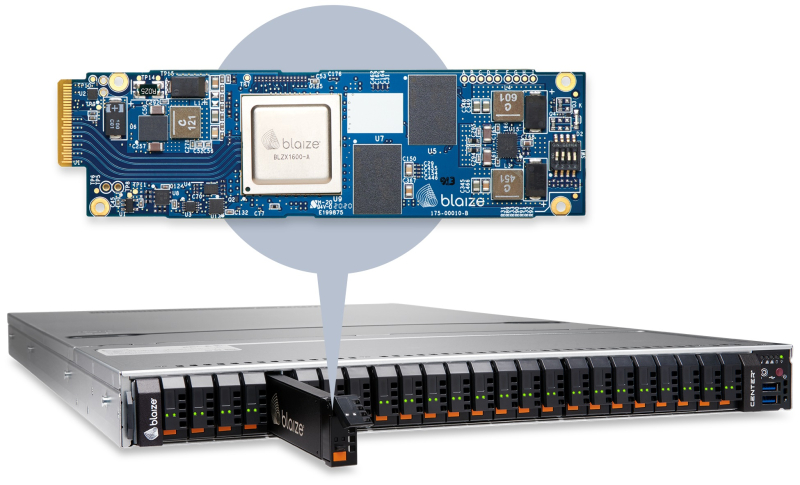

Разработчик ИИ-чипов для ЦОД и периферийных систем Blaize получил на развитие $106 млнСтартап в области ИИ Blaize объявил о проведении раунда финансирования, в ходе которого привлечено $106 млн. Деньги предоставили существующие и новые инвесторы, включая Bess Ventures, Franklin Templeton, DENSO, Mercedes Benz, Temasek, Rizvi Traverse, Ava Investors и BurTech LP LLC. Blaize разрабатывает специализированные чипы, предназначенные для ускорения выполнения ИИ-задач в дата-центрах и на периферии. Утверждается, что по сравнению с традиционными ускорителями на базе GPU и FPGA устройства Blaize обеспечивают более высокую энергетическую эффективность. В основе архитектуры решений Blaize лежит обработка графов, а многие модели ИИ можно как раз представить представить в виде графов. Платформа Blaize включает специализированное ПО Blaize AI Studio и Blaize Picasso SDK, предоставляющее клиентам удобные средства для быстрого создания и развёртывания ИИ-приложений. В ассортименте Blaize присутствуют различные ИИ-устройства на основе чипа Blaize 1600 SoC, содержащего 16 ядер GSP (Graph Streaming Processor). Заявленная ИИ-производительность достигает 16 TOPS. В частности, доступны модуль Blaize Xplorer X600M M.2 (PCIe 3.0 х4; 2 Гбайт LPDDR4), ускоритель Blaize Xplorer X1600E EDSFF (PCIe 3.0 х4; 4 Гбайт LPDDR4), карта расширения Blaize Xplorer X1600P PCIe (PCIe 3.0 х4; 4 Гбайт LPDDR4), ускоритель Xplorer X1600P-Q PCIe на базе четырёх чипов Blaize 1600 SoC (PCIe 3.0 х16; 16 Гбайт LPDDR4), встраиваемое решение Blaize Pathfinder P1600 Embedded System on Module, а также сервер Blaize Inference Server на базе 24 ускорителей Blaize Xplorer X1600E EDSFF. Привлечённые средства Blaize будет использовать для дальнейшей разработки и коммерциализации продуктов. В декабре 2023-го стартап сообщил о намерении выйти на биржу посредством SPAC-сделки с BurTech Acquisition Corp. Ожидается, что это позволит получить $71 млн при оценке компании в $894 млн.

25.04.2024 [12:00], Сергей Карасёв

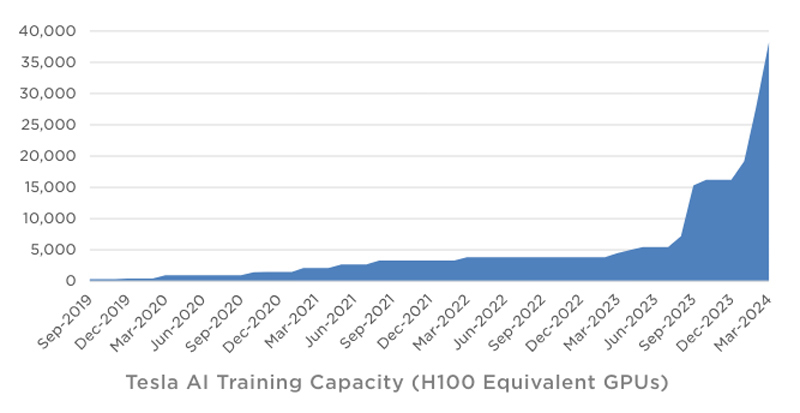

Tesla в течение квартала инвестировала в ИИ-инфраструктуру около $1 млрдКомпания Tesla обнародовала показатели деятельности в I квартале 2024 года. Выручка производителя электромобилей составила $21,3 млрд, что на 9 % меньше результата годичной давности. Предприятие Илона Маска не смогло оправдать ожидания аналитиков, которые называли сумму на уровне $22,34 млрд. Показатели ухудшаются на фоне сокращения продаж автомобилей под давлением китайских конкурентов. Чистая квартальная прибыль Tesla составила $1,13 млрд. Это на 55 % меньше по сравнению с показателем за I четверть 2023-го, когда компания заработала $2,51 млрд. Как отмечает ресурс Datacenter Dynamics, в январе–марте 2024 года Tesla инвестировала в развитие ИИ-инфраструктуры около $1 млрд. По словам Маска, компании удалось преодолеть трудности в плане расширения мощностей для обучения ИИ. На текущий момент Tesla ввела в эксплуатацию ресурсы, эквивалентные по производительности 35 тыс. ускорителей NVIDIA H100. К концу года, согласно заявлениям Маска, этот показатель приблизится к 85 тыс.

Источник изображения: Tesla Учитывая, что в презентации говорится об «эквиваленте Н100», компания может применять различные ИИ-решения, включая собственные чипы Tesla D1. В целом, Tesla увеличила мощности для обучения ИИ более чем на 130 % в I квартале 2024-го. Ожидается, что суперкомпьютер Dojo поможет увеличить рыночную стоимость Tesla на $500 млрд. Маск также сообщил, что в перспективе электромобили Tesla смогут выполнять функции распределённой edge-платформы для инференса. Идея заключается в том, чтобы задействовать вычислительные мощности автомобилей во время простоя для выполнения задач ИИ. Глава Tesla предлагает представить будущее, в котором по всему миру насчитывается 100 млн электромобилей компании. Каждый из них теоретически может обладать мощностью на уровне 1 кВт, что в сумме даёт 100 ГВт для инференса. Даже с учётом того, что каждая из этих машин будет эксплуатироваться около 7 часов ежедневно, остаётся более 100 часов в неделю для обслуживания ИИ-нагрузок.

24.04.2024 [20:50], Руслан Авдеев

Китайские телеком-гиганты потратят миллиарды долларов на оптовые закупки ИИ-серверовChina Mobile, одна из ключевых в Китае телеком-компаний, насчитывающая более миллиарда клиентов, намерена приобрести 8 тыс. ИИ-серверов. По информации The Register, представители IT-гиганта рассчитывают, что оборудование заработает до 2025 года. Приобретение планируют разбить на заказы для семи отдельных вендоров. Местные СМИ уже сообщают, что речь идёт о крупнейшей централизованной закупке ИИ-серверов в Китае за всю историю. Общая стоимость оборудования может перевалить за ¥15 млрд — $2 млрд. Причём компания не одинока в своём стремлении обзавестись передовыми аппаратными решениями. Спешно организуют закупки ИИ-серверов на фоне антикитайских санкций и другие телеком-гиганты Поднебесной. China Unicom, по слухам, в прошлом месяце занялась закупками 2,5 тыс. серверов, схожие действия предпринимались и China Telecom. Что именно компании намерены делать с полученными серверами, не уточняется. Впрочем, China Mobile выступает оператором крупного облака, поэтому ИИ-серверы компании безусловно пригодятся. Также не исключено, что бизнес будет использовать ИИ и для обслуживания клиентов, хотя нужно ли для этого такое количество серверов — вопрос отдельный. Главный интерес представляет даже не сфера применения ИИ-ускорителей, а их источники. В Китае пока не создано решений современного мирового уровня и даже передовые модели Huawei серии Ascend не способны на равных тягаться с новейшими решениями NVIDIA. Хотя в теории американские производители ускорителей могут получить от властей США экспортную лицензию, подав заявку в индивидуальном порядке, вряд ли такое разрешение получит подконтрольная государству China Mobile. Более того, она наряду с China Unicom и China Telecom отнесена Пентагоном к «структурам, идентифицированным как китайские военные компании», а санкции США декларировались именно как меры, призванные помешать военным КНР в получении передовых технологий. В числе официально доступных китайским телеком-компаниям вариантов — покупка западных ускорителей с искусственно ухудшенной функциональностью, не подпадающих под санкции. В числе неофициальных — обыкновенная контрабанда или, как ходят слухи, закупка через фирмы-прослойки готовых серверов с уже установленными ускорителями.

23.04.2024 [11:45], Сергей Карасёв

Samsung откроет в Кремниевой долине лабораторию по созданию ИИ-чипов на базе RISC-V, чтобы побороться с NVIDIAКомпания Samsung Electronics, по сообщению ресурса Business Korea, откроет новую научно-исследовательскую и опытно-конструкторскую (R&D) лабораторию в Кремниевой долине. Её специалисты займутся прежде всего созданием ИИ-чипов на открытой архитектуре RISC-V. По имеющейся информации, Технологический институт Samsung SAIT (Samsung Advanced Institute of Technology) учредил исследовательский центр Advanced Processor Lab (APL). Южнокорейская компания намерена расширить свои возможности в области разработки ИИ-решений, чтобы в перспективе бросить вызов американским корпорациям, в числе которых называется NVIDIA. Около месяца назад Samsung сформировала лабораторию Semiconductor AGI Computing Lab, сотрудники которой разрабатывают чипы следующего поколения для ИИ-приложений. Офисы данного подразделения располагаются в Южной Корее и США. Основным направлением исследований являются системы «общего искусственного интеллекта» (Artificial General Intelligence, AGI). В заявлении в LinkedIn глава Samsung Semiconductor Ке Хён Гён (Kye Hyun Kyung) отметил, что на первом этапе лаборатория сосредоточит усилия на разработке чипов для больших языковых моделей (LLM), тогда как реализация проектов в области AGI начнётся позднее.

Источник изображения: pixabay.com Между тем власти США в рамках «Закона о чипах» выделили Samsung $6,4 млрд безвозвратных субсидий на строительство предприятий в Техасе. По условиям соглашения, в городе Тейлоре будут построены два завода по выпуску полупроводниковых изделий с нормами 4 и 2 нм. «Мы считаем, что полупроводниковые технологии нового поколения, созданные с использованием ИИ и компьютерной техники, сыграют ключевую роль в повышении качества жизни. Именно поэтому SAIT тесно сотрудничает с учёными и экспертами в поисках новых долгосрочных драйверов роста для Samsung», — говорит Гёйонг Джин (Gyoyoung Jin), президент SAIT.

22.04.2024 [21:30], Сергей Карасёв

Microsoft к концу 2024 года планирует использовать до 1,8 млн ИИ-ускорителей на базе GPUКорпорация Microsoft, по сообщению ресурса Business Insider, в течение 2024 года намерена утроить количество ускорителей на базе GPU в составе своей вычислительной ИИ-инфраструктуры. В результате, как ожидается, к декабрю общее количество таких изделий, находящихся в распоряжении редмондского гиганта, может достичь 1,8 млн. Два года назад у Microsoft было несколько сотен тысяч ускорителей, в том числе FPGA и ASIC. Microsoft в партнёрстве с OpenAI реализует комплексную программу по развитию ИИ-систем. В частности, планируется строительство масштабного кампуса ЦОД под названием Stargate стоимостью $100 млрд. Средства, как уточняет Business Insider, пойдут в том числе на закупку GPU-ускорителей. Аналитики DA Davidson подсчитали, что в прошлом году Microsoft потратила приблизительно $4,5 млрд на приобретение ИИ-ускорителей NVIDIA. Один из руководителей Microsoft подтвердил, что эта цифра близка к фактическим расходам корпорации в рассматриваемом сегменте. Microsoft также проектирует собственные ИИ-чипы, которые помогут снизить зависимость от сторонних поставщиков. Так, она уже представила свой первый ИИ-ускоритель Maia 100, который спроектирован под задачи облачного обучения и инференса в сценариях с использованием моделей OpenAI, Bing, GitHub Copilot и ChatGPT в инфраструктуре Azure. Однако некоторые специалисты относятся скептически к этим усилиям Microsoft, поскольку корпорация на годы отстаёт от NVIDIA в плане создания мощных ИИ-решений. Business Insider со ссылкой на документацию Microsoft сообщает, что во II половине 2023-го корпорация развернула «рекордные мощности GPU». Однако конкретные цифры и тип ускорителей не раскрываются. Другие крупные IT-компании и облачные провайдеры также продолжают наращивать ИИ-ресурсы. Например, Meta✴, как ожидается, к концу 2024 года будет иметь в своём распоряжении около 350 тыс. NVIDIA H100 и неназванное количество ускорителей собственной разработки MTIA v1 и MTIA v2. Некоторые игроки рынка присматриваются к конкурирующим решениям. Так, Dell намерена использовать ИИ-ускорители Intel Gaudi3, а стартап TensorWave разворачивает ИИ-облако из 20 тыс. ускорителей AMD Instinct MI300X.

18.04.2024 [12:20], Сергей Карасёв

Rivos, разработчик ИИ-ускорителей на базе RISC-V, получил на развитие более $250 млнКалифорнийский стартап Rivos, основанный в 2021 году, сообщил о проведении раунда финансирования Series-A3, в ходе которого на развитие привлечено более $250 млн. Ключевым инвестором стала фирма Matrix Capital Management. Кроме того, средства предоставили Intel Capital, Dell Technologies Capital, MediaTek и др. Rivos занимается разработкой чипов на открытой архитектуре RISC-V для приложений ИИ и больших языковых моделей (LLM). Изделия планируется изготавливать на предприятии TSMC с применением 3-нм технологии. Предполагается, что такие решения станут менее дорогой альтернативой ускорителям NVIDIA. Привлеченные средства стартап направит на ускорение разработки чипов и коммерциализацию решений. При этом ориентировочные сроки начала массового производства таких изделий пока не раскрываются.

Источник изображения: pixabay.com На сегодняшний день Rivos раскрывает лишь общую информацию о характеристиках своих чипов. В их состав войдёт узел Data Parallel Accelerator и вычислительные ядра с архитектурой RISC-V. Узлы чипа получат доступ к памяти DDR DRAM и HBM. Rivos также предоставит набор специальных программных инструментов для своих чипов. С их помощью разработчики смогут развёртывать и обучать модели ИИ. По имеющейся информации, Rivos нацеливается на приложения ИИ, которые смогут работать с PyTorch и JAX.

15.04.2024 [15:15], Сергей Карасёв

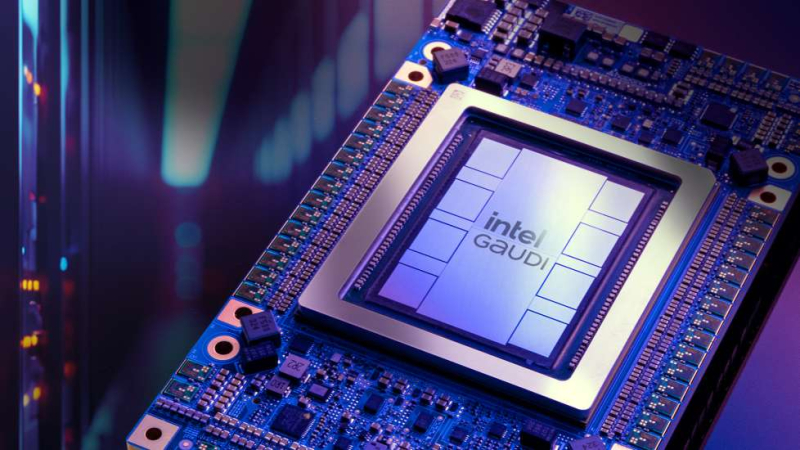

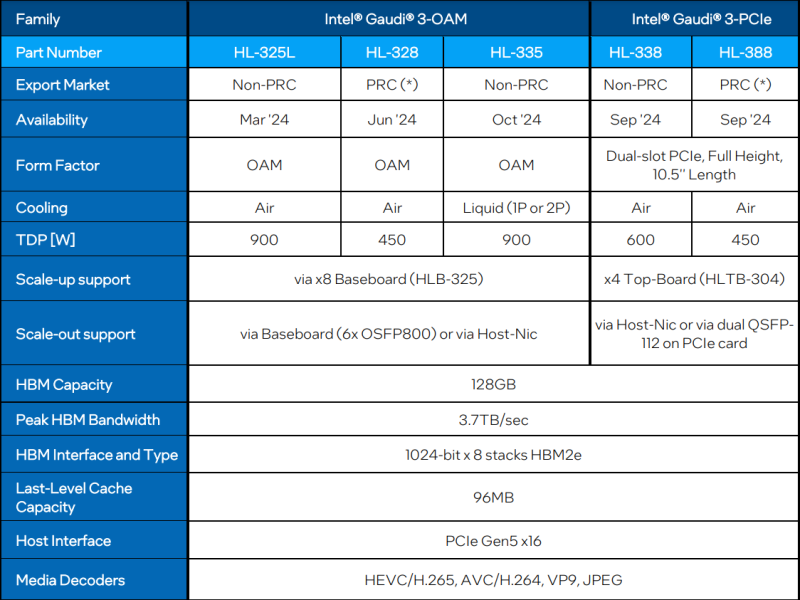

Intel готовит «урезанные» версии ИИ-ускорителя Gaudi3 для КитаяКорпорация Intel, как отмечает ресурс The Register, готовит специализированные модификации ИИ-ускорителя Gaudi3 для китайского рынка. Эти варианты из-за санкционных ограничений со стороны США будут отличаться от стандартных версий пониженным TDP и «урезанной» производительностью. Intel официально представила Gaudi3 менее недели назад. Изделие имеет чиплетную компоновку: оно состоит из двух одинаковых кристаллов с быстрым интерконнектом. В оснащение входят 128 Гбайт памяти HBM2e. Заявленная производительность FP8 и BF16 достигает 1835 Тфлопс (MME — блоки матричной математики). В семейство Gaudi3 входят ОАМ-версии HL-325L и HL-335 с показателем TDP в 900 Вт, а также PCIe-вариант HL-338 с TDP на уровне 600 Вт. Для Китая Intel предложит ОАМ-ускоритель HL-328 и PCIe-модификацию HL-388 — их поставки начнутся в июне и сентябре нынешнего года соответственно. Как и обычные изделия, ускорители для китайских заказчиков содержат два кристалла, а конфигурация памяти не изменилась — 128 Гбайт HBM2e с пропускной способностью 3,7 Тбайт/с. Вместе с тем величина TDP в обоих случаях снижена до 450 Вт. В соответствии с экспортными ограничениями со стороны США, в Китай запрещаются поставки чипов с производительностью BF16 более 150 Тфлопс. Как именно Intel ограничивает быстродействие в китайских версиях Gaudi3, не ясно. Это может достигаться за счёт снижения тактовой частоты или какого-то другого метода. При этом возможность объединения таких ускорителей в группы остаётся. Отмечается также, что в Китай, по всей видимости, не будут поставляться варианты Gaudi3 с жидкостным охлаждением. NVIDIA уже дважды меняла характеристики ускорителей, чтобы обойти санкции США в отношении Китая, причём компания успела выпустить существенный объём продукции, которую в итоге пришлось направить на другие рынки. Многие китайские компании успели накопить запасы ускорителей, которых хватит на ближайшие пару лет. AMD, как выяснилось, тоже подготовила «урезанную» версию ускорителя Instinct MI309, но Министерство торговли США всё равно не разрешило поставлять её Китаю. |

|