Материалы по тегу: mlcommons

|

17.04.2024 [16:33], Руслан Авдеев

Запрос со звёздочкой: MLCommons анонсировала бенчмарк для оценки безопасности ИИ — AI Safety v0.5Некоммерческий проект MLCommons, занимающийся созданием и поддержкой бенчмарков, широко используемых в ИИ-индустрии, анонсировал новую разработку, передаёт Silicon Angle. Речь идёт об инструменте, позволяющем оценивать безопасность ИИ-систем. Консорциум объявил о создании соответствующей рабочей группы AIS в конце 2023 года. AI Safety v0.5 находится на стадии proof-of-concept и позволяет оценивать большие языковые модели (LLM), стоящие за современными чат-ботами, анализируя ответы на запросы из «опасных категорий». Необходимость в появлении такого инструмента давно назрела, поскольку технологию оказалось довольно легко использовать в неблаговидных и даже опасных целях. Например, ботов можно применять для подготовки фишинговых атак и совершения других киберпреступлений, а также для распространения дезинформации и разжигания ненависти. Хотя измерить безопасность довольно сложно с учётом того, что ИИ используется в самых разных целях, в MLCommons создали инструмент, способный разбираться с широким спектром угроз. Например, он может оценивать, как бот отвечает на запрос о рецептах изготовления бомбы, что отвечать полиции, если пойман за созданием взрывного устройства и т.п. Каждая модель «допрашивается» серией тестовых запросов, ответы на которые потом подлежат проверке. LLM оценивается как по каждой из категорий угроз, так и по уровню безопасности в целом. Бенчмарк включает более 43 тыс. промтов. Методика позволяет классифицировать угрозы, конвертируя ответы в понятные даже непрофессионалам характеристики, вроде «высокий риск», «умеренно-высокий риск» и т.д. Представители организации заявляют, что LLM чрезвычайно трудно оценивать по ряду причин, но ИИ в любом случае нуждается в точных измерениях, понятных людям и имеющих прикладное значение. Работа над бенчмарком продолжается, всего идентифицированы 13 опасных категорий, но только семь из них пока оцениваются в рамках исходного проекта. Речь идёт о темах, связанных с насильственными и ненасильственными преступлениями, оружием массового уничтожения, суицидами и др., ведётся разработка и для новых категорий — всё это позволит создавать более «зрелые» модели с низким уровнем риска. В будущем планируется оценивать не только текстовые модели, но и системы генерации изображений. Бенчмарк AI Safety v0.5 уже доступен для экспериментов и организация надеется, что исходные тесты сообществом позволят выпустить усовершенствованную версию v1.0 позже в текущем году. В MLCommons заявляют, что по мере развития ИИ-технологий придётся иметь дело не только с известными опасностями, но и новыми, которые могут возникнуть позже — поэтому платформа открыта для предложений новых тестов и интерпретации результатов.

29.10.2023 [16:37], Сергей Карасёв

MLCommons создал рабочую группу по безопасности ИИКонсорциум MLCommons объявил о формировании специализированной рабочей группы в области обеспечения безопасности ИИ — структуры AI Safety (AIS). Она разработает платформу и набор тестов для безопасного и этичного применения ИИ в различных сценариях. Отмечается, что ИИ-системы потенциально могут принести значительную пользу обществу, но существуют и проблемы, такие как дезинформация и предвзятость. Кроме того, средства генеративного ИИ могут применяться для создания дипфейков и написания вредоносного кода.

Источник изображения: pixabay.com Новая инициатива предусматривает оценку безопасности различных систем ИИ в соответствии с отраслевыми стандартами. После проведения тестирования с применением набора определённых критериев будут формироваться информативные и понятные оценки. Приоритетом AIS станет развитие более строгих и надёжных технологий тестирования безопасности ИИ. Рабочая группа будет опираться на технический и эксплуатационный опыт своих участников и сообщества ИИ в целом. На первом этапе внимание планируется сосредоточить на разработке критериев безопасности для больших языковых моделей (LLM). В состав рабочей группы войдут специалисты Anthropic, Coactive AI, Google, Inflection, Intel, Meta✴, Microsoft, NVIDIA, OpenAI и Qualcomm Technologies, а также эксперты ряда научных организаций, в том числе из Эйндховенского университета, Стэнфордского университета и Чикагского университета.

18.07.2023 [22:14], Владимир Мироненко

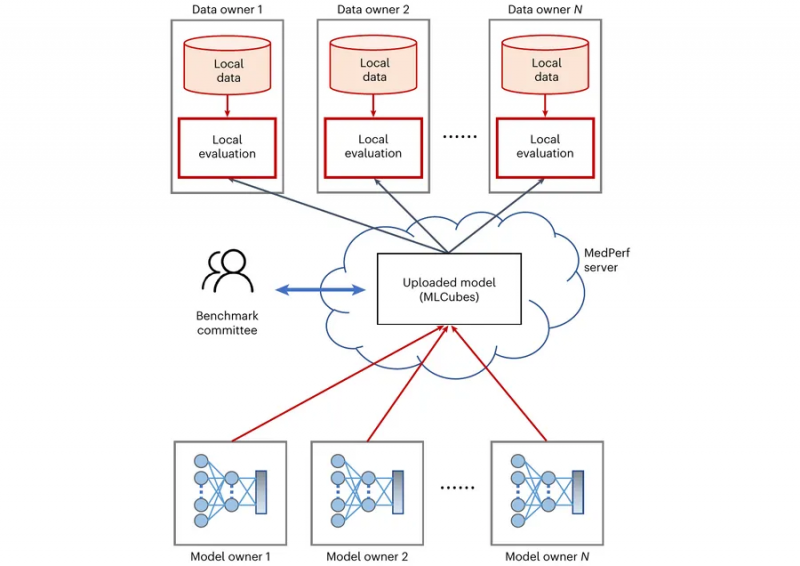

MLCommons анонсировал бенчмарк MedPerf для медицинского ИИКонсорциум MLCommons объявил о доступности открытого бенчмарка MedPerf, с помощью которого компании смогут безопасно проверять ИИ-модели для медицинской сферы на реальных данных без раскрытия последних, пишет SiliconANGLE. MedPerf поможет «катализировать более широкое внедрение медицинского ИИ», что приведёт к более эффективной и рентабельной клинической практике. ИИ-бенчмарки MLPerf консорциума MLCommons уже стали отраслевым стандартом для тестирования и проверки моделей ИИ. Согласно статье, подготовленной MLCommons Medical Working Group для журнала Nature Machine Intelligence, медицинский ИИ обладает огромным потенциалом для развития здравоохранения. Для раскрытия этого потенциала необходим систематический количественный метод оценки эффективности ИИ-моделей с помощью крупномасштабных гетерогенных датасетов, которые могут охватывать широкий спектр групп пациентов. По словам создателей, MedPerf как раз предлагает последовательную и строгую методологию для количественной оценки производительности медицинских ИИ-моделей для реальных приложений. При этом MedPerf обеспечивает полную конфиденциальность данных и защиту интеллектуальной собственности каждой модели, гарантируя, что любые используемые данные никогда не покинут системы провайдера медицинских сервисов. Кроме того, используемый метод совместного проектирования поддерживает нейтральный и научный подход к клинической проверке ИИ и позволяет выявить новые варианты приложений, где ИИ может повысить клиническую эффективность. MLCommons заявил, что его бенчмарки оказали положительное влияние на развитие технологий ИИ во многих отраслях, и что предлагаемый бенчмарк для медицинского ИИ поможет ускорить развитие отрасли здравоохранения. В частности, MedPerf поможет ускорить внедрение ИИ в медицине, предоставив разработчикам лучший способ обслуживания недостаточно представленных групп пациентов. MedPerf уже прошёл валидацию в рамках Federated Tumor Segmentation Challenge и четырёх других академических пилотных исследований. |

|