Материалы по тегу: epyc

|

15.02.2024 [14:26], Сергей Карасёв

Samsung и Vodafone осуществили первый в отрасли звонок в сети Open RAN на базе серверов с AMD EPYC SienaКомпании Samsung Electronics и Vodafone в сотрудничестве с AMD объявили о совершении первого в отрасли соединения в сети радиодоступа с архитектурой Open RAN на базе оборудования с процессорами EPYC. Целью эксперимента стала оценка производительности, энергоэффективности и совместимости решений партнёров. Пропускная способность сети превысила 1 Гбит/с при применении многопользовательского оборудования. Эксперимент был успешно проведён в научно-исследовательской лаборатории Samsung в Корее. Участники проекта использовали совместимый с O-RAN софт виртуализации Samsung (vRAN). Были задействованы специализированные телеком-серверы Supermicro, оборудованные процессорами AMD EPYC 8004 Siena, которые как раз и ориентированы на подобные задачи. Кроме того, применялась контейнерная платформа Wind River Studio CaaS (Container-as-a-Service). Концепция Open RAN, как ожидается, позволит радикально сократить расходы операторов связи на инфраструктуру благодаря использованию облачного ПО и оборудования от различных поставщиков вместо проприетарных систем какого-то одного производителя. Впрочем, на практике даже O-RAN сети нередко строятся на оборудовании одного поставщика.

Источник изображения: Samsung Отмечается, что Samsung стала стратегическим партнёром Vodafone в рамках внедрения концепции Open RAN по модернизации устаревших сетей и развитию экосистемы нового типа в июне 2021 года. С тех пор стороны расширяют сотрудничество. А в сентябре 2023-го Samsung объявила о сотрудничестве с AMD для продвижения 5G vRAN. У Intel есть специализированные процессоры Xeon EE со встроенным ускорителем vRAN Boost.

04.02.2024 [14:47], Сергей Карасёв

SoftIron, разработчик «первого настоящего частного облака», представил обновлённые узлы на чипах AMD, NVIDIA и SocionextКомпания SoftIron, позиционирующая себя в качестве разработчика «первого настоящего частного облака», анонсировала новые аппаратные решения, позволяющие поддерживать ресурсоёмкие приложения. Представленные устройства ориентированы на корпоративных и государственных заказчиков. SoftIron заявляет, что 76 % предприятий хотят запустить частное облако. Однако существующие решения не могут обеспечить тот же набор сервисов и возможностей, которые дают публичные облака. SoftIron предлагает платформу HyperCloud, которая, как утверждается, позволяет решить проблему путём развёртывания полнофункциональной локальной облачной инфраструктуры. Одним из преимуществ HyperCloud компания SoftIron называет быстроту внедрения: в базовой конфигурации система занимает половину серверной стойки, а на ввод в эксплуатацию требуется примерно полдня. Кроме того, HyperCloud обладает гибкой масштабируемостью: клиенты смогут наращивать вычислительные ресурсы, СХД и сетевые компоненты. Узлы HyperCloud можно добавлять или удалять по необходимости, а HyperCloud автоматически перенастраивает и перераспределяет рабочие нагрузки, хранилище и т. д. Платформа поддерживает простые в использовании порталы и развёртывание по модели «инфраструктура как код» на основе API.

Источник изображения: SoftIron В число представленных аппаратных решений вошли новые вычислительные модули на процессорах AMD EPYC с 64 ядрами (128 потоков), а также GPU-узлы с ускорителями NVIDIA. Кроме того, дебютировали решения на базе ASIC разработки Socionext. Для хранения данных SoftIron теперь предлагает узлы на базе HDD общей ёмкостью 48, 72, 120, 144, 216 и 240 Тбайт. Дополнительно клиенты могут заказать производительные решения на основе SSD на 56 и 112 Тбайт, а также узлы с NVMe SSD вместимостью 26 и 52 Тбайт. Анонсированы и новые сетевые модули с поддержкой 1GbE, 25GbE и 100GbE.

02.02.2024 [13:29], Сергей Карасёв

Lenovo построит в Германии энергоэффективный суперкомпьютер на базе AMD EPYC Genoa и NVIDIA H100

amd

epyc

genoa

h100

hardware

hpc

lenovo

nvidia

германия

отопление

суперкомпьютер

энергоэффективность

Компания Lenovo объявила о заключении контракта с Падерборнским университетом в Германии (University of Paderborn) на создание нового НРС-комплекса, мощности которого будут использоваться для обеспечения исследований в рамках Национальной программы высокопроизводительных вычислений (NHR). В основу суперкомпьютера лягут двухузловые серверы ThinkSystem SD665 V3. Конфигурация каждого узла включает два процессора AMD EPYC Genoa и до 24 модулей оперативной памяти DDR5-4800. Применена технология прямого жидкостного охлаждения Lenovo Neptune Direct Water Cooling (DWC). Кроме того, НРС-комплекс будет использовать GPU-серверы ThinkSystem SD665-N V3, несущие на борту четыре ускорителя NVIDIA H100, связанные между собой посредством NVLink. Общее количество ядер составит более 136 тыс. Для подсистемы хранения выбрана платформа IBM ESS 3500, обеспечивающая возможности гибкого использования SSD (NVMe) и HDD. Новый суперкомпьютер расположится в Падерборнском центре параллельных вычислений (PC2). Монтаж оборудования планируется произвести во II половине текущего года. За интеграцию будет отвечать pro-com DATENSYSTEME GmbH. Ожидается, что по сравнению с нынешней системой центра Noctua 2 (на изображении), построенной Atos, готовящийся суперкомпьютер будет обладать примерно вдвое более высокой производительностью. Быстродействие Noctua 2 составляет до 4,19 Пфлопс (Linpack) для CPU-ядер и до 1,7 Пфлопс (Linpack) для GPU-блоков.

Источник изображения: University of Paderborn Особое внимание при строительстве суперкомпьютера будет уделяться энергетической эффективности. Благодаря использованию источников питания с жидкостным охлаждением и полностью изолированных стоек более 97 % вырабатываемого тепла может быть передано непосредственно в систему циркуляции тёплой воды. Применение теплообменников и блоков распределения охлаждающей жидкости (CDU) обеспечивает температуру носителя в обратном контуре выше 45 °C, что позволяет повторно использовать генерируемое тепло.

25.01.2024 [14:41], Сергей Карасёв

Для звёзд — Xeon, для гравитации — EPYC: Lenovo обновила HPC-кластер Кардиффского университетаКомпания Lenovo поставила в Кардиффский университет в Великобритании 90 серверов ThinkSystem, которые позволили поднять производительность кластера Hawk HPC приблизительно в два раза. Система применяется для решения сложных задач в таких областях, как астрофизика и наука о жизни. Lenovo и британский поставщик IT-решений Logicalis предоставили HPC-ресурсы для двух исследовательских групп в Кардиффском университете. Одна из них — научная коллаборация, участвующая в проекте лазерно-интерферометрической гравитационно-волновой обсерватории (LIGO). Эта инициатива нацелена на обнаружение гравитационных волн. Сообщается, что для проекта LIGO компания Lenovo предоставила 75 серверов ThinkSystem SR645, оснащённых процессорами AMD EPYC Genoa. Эти системы поддерживают до 6 Тбайт оперативной памяти DDR5-4800 в виде 24 модулей и до трёх ускорителей PCIe (2 × PCIe 5.0 и 1 × PCIe 4.0). Отмечается, что установка серверов позволила удвоить вычислительные мощности, доступные исследователям. Вторая исследовательская группа в Кардиффском университете, изучающая процессы звёздообразования, получила 15 серверов Lenovo ThinkSystem SR630 на платформе Intel Xeon Sapphire Rapids и два сервера хранения ThinkSystem SR650 с возможностью установки 20 накопителей LFF или 40 накопителей SFF. Группа сосредоточена на анализе спиральных галактик, таких как наш Млечный Путь. Приобретённые серверы помогут в выполнении сложных задач моделирования.

24.01.2024 [13:55], Сергей Карасёв

Итальянская нефтегазовая компания Eni получит 600-Пфлопс суперкомпьютер HPC6 на базе AMD Instinct MI250XИтальянская нефтегазовая компания Eni, по сообщению ресурса Inside HPC, заказала суперкомпьютер HPE Cray EX4000 на аппаратной платформе AMD. Быстродействие этой машины, как ожидается, составит около 600 Пфлопс. Известно, что в состав системы, получившей название HPC6, войдут 3472 узла, каждый из которых получит 64-ядерный процессор AMD EPYC и четыре ускорителя AMD Instinct MI250X. Таким образом, общее количество ускорителей составит 13 888. Судя по всему, компания смогла достаточно полно адаптировать своё ПО для работы на современных ускорителях AMD, эксперименты с которыми она начала ещё несколько лет назад. Комплекс будет использовать хранилище HPE Cray ClusterStor E1000 с интерконнектом HPE Slingshot. Узлы суперкомпьютера будут организованы в 28 стоек. Предусмотрено применение технологии прямого жидкостного охлаждения, которая, по заявлениям Eni, рассеивает 96 % вырабатываемого тепла. Максимальная потребляемая мощность — 10,17 МВт.

Источник изображения: AMD Новый суперкомпьютер разместится в ЦОД Eni Green Data Center в Феррера-Эрбоньоне, который, как утверждается, является одним из самых энергоэффективных и экологически чистых вычислительных центров в Европе. По производительности HPC6 значительно превзойдёт комплексы HPC4 и HPC5, совокупная вычислительная мощность которых составляет 70 Пфлопс. При производительности 600 Пфлопс система HPC6 займёт второе место в текущем списке TOP500 самых мощных суперкомпьютеров мира.

08.01.2024 [00:28], Алексей Степин

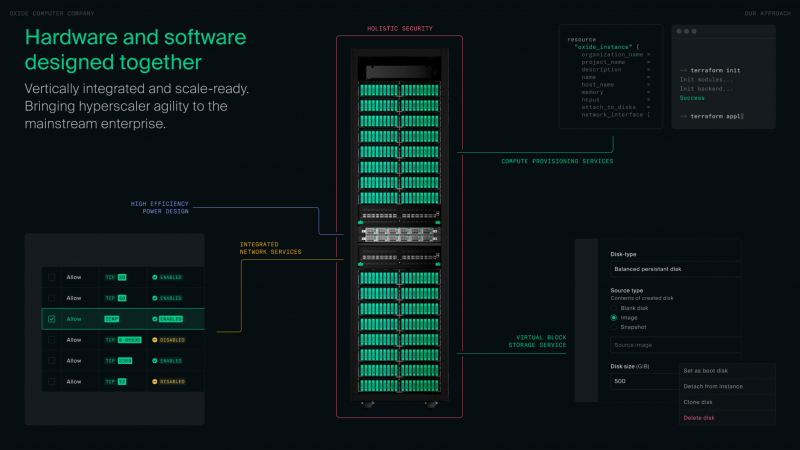

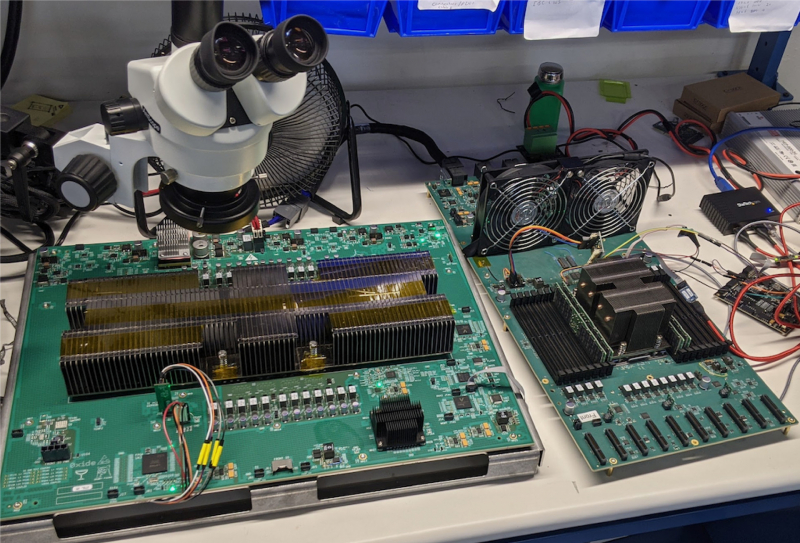

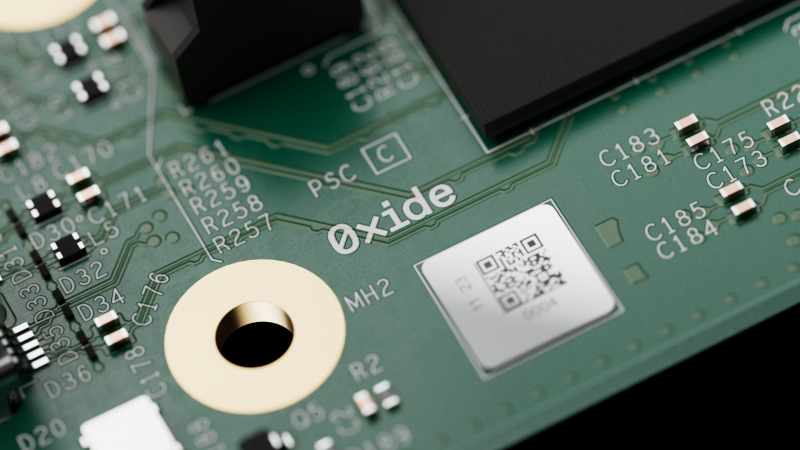

Oxide Cloud Computer: переизобретая облакоПубличные облака очень популярны, но не всегда в должной мере отвечают поставленным целям и задачам компании. В то же время, классическая серверная инфраструктура дорога в содержании, хлопотна в настройке и не всегда безопасна — не в последнюю очередь из-за фрагментированности программных и аппаратных архитектур, уходящей корнями в далёкое прошлое. Компания Oxide Computer заявила, что разработанная ею интегрированная платформа должна вернуть компьютерным системам нового поколения холизм, присущий самым ранним вычислительным решениям, когда аппаратное и программное обеспечение создавалось совместно и с взаимным учётом особенностей. Разлад, по мнению Oxide, начался в этой сфере давно — с появлением BIOS, отделившей «железо» от системного ПО. В дальнейшем этот разрыв только нарастал, как и степень закрытости компонентов вкупе со всё большим и большим количеством слоёв абстракций. Появление UEFI лишь усугубило эту проблему. Причём речь здесь не только о прошивках: можно вспомнить SMM и интеграцию в процессоры «вспомогательных ядер», обслуживающих I/O-подсистемы, но полностью скрытых от системного ПО. По мнению Oxide, такой подход представляет серьёзную угрозу безопасности, поскольку со стороны «железа» операционной системе доступно всё меньше информации об истинных аппаратных возможностях и ресурсах сервера. Появление BIOS с открытым кодом проблемы не решает — вспомогательные аппаратные компоненты сегодня не просто слишком сложны, но и работают под управлением проприетарных прошивок, а информации в открытом доступе о них крайне мало. Крупные гиперскейлеры борются с этой фрагментацией путём создания собственных, уникальных решений. Oxide Computer же решила распространить этот подход на традиционный корпоративный рынок. В своих новых системах компания отказалась не только от традиционных прошивок BIOS и UEFI, но и от использования закрытых BMC и сервисных процессоров, равно как и блоков Root-of-Trust (RoT). Вместо них используются чипы STM32H753 и LP55S28, работающие под управлением специально разработанной для этих целей операционной системы Hubris, полностью открытой, написанной на языке Rust. Полностью избавиться от проприетарности на платформе AMD невозможно, поскольку Platform Security Processor (PSP) отвечает за старт и инициализацию процессора и памяти. Но вот дальнейший процесс загрузки управляется не BIOS/UEFI, а фирменной открытой ОС Helios, часть которой «живёт» в SPI-памяти. Helios является своего рода наследницей illumos, восходящей ещё к OpenSolaris. Стек включает гипервизор bhyve, Propolis для работы с VMM, а также Omicron для управления всей платформой в целом на уровне стойки. Естественно, для подсистемы хранения задействованы ZFS-пулы. Результатом работ Oxide стала платформа под названием Cloud Computer. Для неё не просто было разработано уникальное программное обеспечение — практически с нуля была создана и вся аппаратная часть, от вычислительных узлов до сетевых коммутаторов и подсистемы питания. Об этом компания рассказывает в своём блоге. При этом практически вся программная часть этого программно-аппаратного комплекса открыта, но вот аппаратную часть кому-то со стороны просто так повторить вряд ли удастся. Oxide позиционирует Cloud Computer в качестве универсальной платформы для частных облаков, обеспечивающей единство архитектуры и удобства конфигурирования с гибкостью и простотой использования публичных облаков. По словам компании, развёртывание облака на базе Oxide Cloud Computer занимает считаные часы, что является заслугой в том числе и уникальной архитектуры новинки. Фактически для первичного запуска системы достаточно подключить питание и сеть. Платформа (фактически готовая стойка) может включать в себя 16, 24 или 32 вычислительных узла на базе 64-ядерных процессоров AMD EPYC 7713P (Milan) с 512 или 1 Тбайт RAM, что даёт до 2048 ядер и до 32 Тбайт памяти на стойку. Каждый узел имеет 10 U.2-отсеков и комплектуется NVMe SSD объёмом 3,2 Тбайт, так что суммарный объём хранилища может достигать 931,5 Тбайт. В качестве интерконнекта используется 100GbE, в состав системы входит два программируемых коммутатора на базе Intel Tofino 2 (12,8 Тбит/с). В них также применяется ПО Oxide, написанное на P4. Подсистема хранения использует OpenZFS для построения распределённого блочного хранилища и реализует проактивную защиту данных, быстрое снятие снимков, их преобразование в дисковые образы и обратно, а также многое другое. Шифрование данных обеспечивается на всех уровнях, а за безопасность и хранение ключей отвечает фирменный RoT-контроллер, упомянутый ранее. Полка питания содержит 6 БП (5+1), максимальная потребляемая стойкой мощность не превышает 15 кВт. Питание у системы трёхфазное. Высота стойки Oxide составляет 2354 мм, ширина — стандартные 600 мм, глубина — 1060 мм. Платформа может генерировать почти 61500 BTU/час и нуждается в соответствующем воздушном охлаждении. Система работоспособна при температурах окружающей среды в пределах от +2 до +35 °C при относительно влажности не выше 80 %. Масса стойки составляет до 1145 кг.

19.12.2023 [14:40], Руслан Авдеев

Пентагон получил 9-Пфлопс суперкомпьютер Carpenter: 280 тыс. ядер AMD и 563 Тбайт RAMАмериканское военное ведомство ввело в эксплуатацию новый суперкомпьютер. По данным Datacenter Dynamics, Центр исследований и разработок армии США (ERDC) представил систему Carpenter производительностью 9 Пфлопс, названную в честь капрала Уильяма Кайла Карпентера (William Cyle Carpenter). Впервые ERDC поделился планами строительства нового суперкомпьютера в августе прошлого года, изначально ожидалось, что машина получит по два чипа на узел, каждый со 192 ядрами и 384 Гбайт памяти, и 200G-интерконнект. Суперкомпьютер построен в лаборатории Army Computing Lab в Виксбурге (Миссисипи). Система, базирующаяся на платформе HPE Cray EX4000, оснащена 277 248 вычислительными ядрами AMD EPYC и 563 Тбайт памяти. О наличии каких-либо ускорителей не сообщается. Первый суперкомпьютер ERDC получил в 1990 году, а в 1992 году центр начал реализацию проекта High Performance Computing Modernization Program (HPCMP). В частности, она позволяет учёным Пентагона получать доступ к мощностям для разработки, тестирования и оценки оборонных систем. В ведении ERDC также находятся суперкомпьютеры Freeman и Onyx. Последний должны были «отправить на покой» ещё в августе этого года, но он всё ещё числится в ноябрьском списке TOP500, равно как и система Topaz 2015 года.

18.12.2023 [13:18], Сергей Карасёв

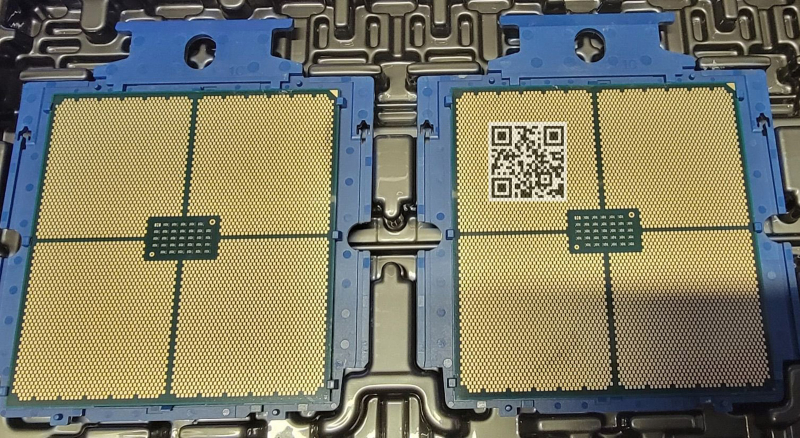

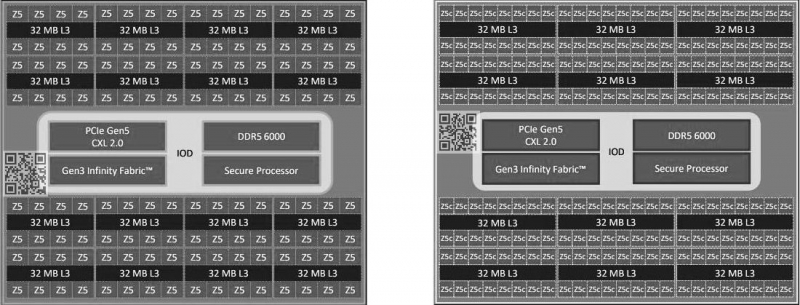

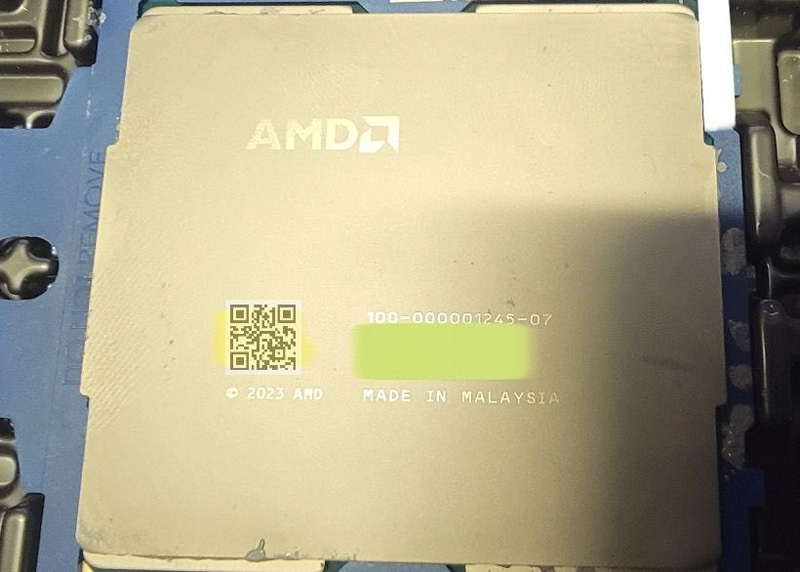

Процессор AMD EPYC Turin показался на «живых» фото: до 192 ядер Zen5cСетевые источники, по сообщению ресурса VideoCardz, обнародовали «живые» фотографии и новые данные о процессорах AMD EPYC пятого поколения с кодовым именем Turin (EPYC 7005). Эти чипы ориентированы на серверы для дата-центров и облачных платформ. О разработке процессоров EPYC Turin компания AMD говорила ещё в начале лета 2022 года. Тогда отмечалось, что будут доступны три разновидности кристаллов: обычные (Zen 5), с 3D V-Cache и «облачные» (Zen 5c) с высокой плотностью. Ожидается, что на коммерческом рынке изделия появятся до конца 2024 года.

Источник изображений: YuuKi_AnS Теперь сообщается, что процессоры EPYC Turin будут использовать существующий сокет SP5 (LGA 6096). Они получат поддержку 12 каналов памяти DDR5-6000, а также стандартов CXL 2.0 и PCIe 5.0. Конструкция стандартных изделий EPYC Turin предусматривает использование 16 вычислительных чиплетов CCD (до восьми ядер в каждом) и унифицированного чиплета IOD, выполняющего роль хаба ввода-вывода. Количество ядер Zen 5 может достигать 128 (256 потоков инструкций). В изделиях с высокой плотностью задействованы 12 чиплетов CCD (до 16 ядер в каждом), а суммарное число ядер Zen 5с составляет до 192 (384 потока). Для каждого из вычислительных чиплетов предусмотрено наличие 32 Мбайт кеша L3, что в сумме даёт до 512/384 Мбайт. Показатель TDP достигает 550 Вт. На фотографиях якобы запечатлён инженерный образец чипа EPYC Turin с шифром 100-00001245-07. Процессор произведён в Малайзии в 2023 году.

09.12.2023 [23:16], Сергей Карасёв

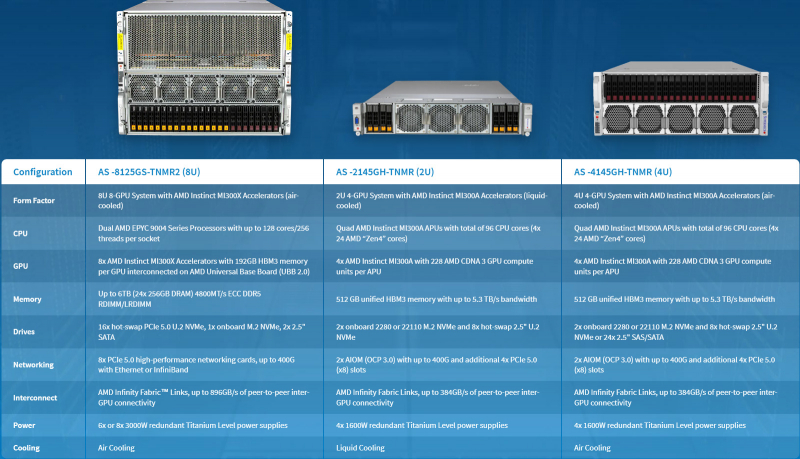

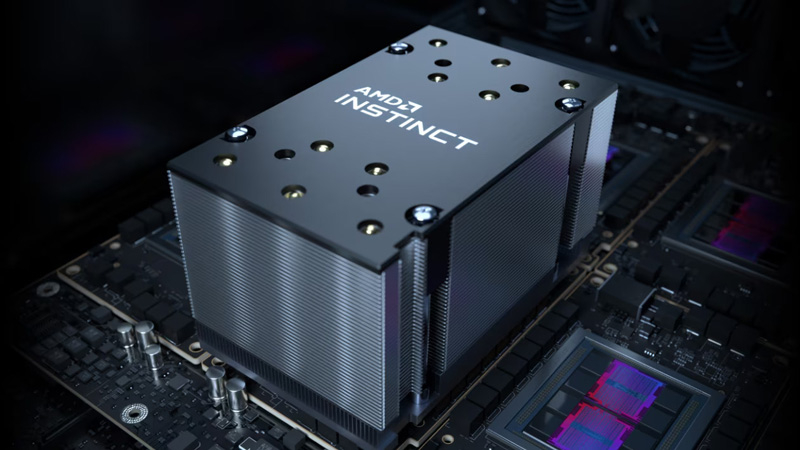

Supermicro представила ИИ-серверы с ускорителями AMD Instinct MI300 и СЖОКомпания Supermicro анонсировала серверы AS-8125GS-TNMR2, AS-4145GH-TNMR и AS-2145GH-TNMR, предназначенные для задач НРС и ИИ, в том числе для обучения больших языковых моделей (LLM). Новинки выполнены на аппаратной платформе AMD и оборудованы ускорителями серии Instinct MI300. Модель AS-8125GS-TNMR2 соответствует типоразмеру 8U. Она оснащена двумя процессорами AMD EPYC Genoa с показателем TDP до 400 Вт и восемью ускорителями Instinct MI300X со 192 Гбайт памяти HBM3. Объём оперативной памяти DDR5-4800 RDIMM/LRDIMM может достигать 6 Тбайт (24 слота). Доступны 18 отсеков для SFF-накопителей NVMe/SATA и коннектор M.2 NVMe. Предусмотрены восемь слотов для карт PCIe 5.0 x16 LP и два слота для карт PCIe 5.0 x16 FHFL. Задействована система воздушного охлаждения. Питание обеспечивают шесть или восемь блоков мощностью 3000 Вт с сертификатом 80 Plus Titanium.

Источник изображений: Supermicro Серверы AS-4145GH-TNMR и AS-2145GH-TNMR выполнены в форм-факторе 4U и 2U соответственно. Первый наделён системой воздушного охлаждения, второй — жидкостного. При этом оба получили четыре чипа Instinct MI300A (24 ядра EPYC Genoa, ускоритель CDNA 3 и 128 Гбайт памяти HBM3). Устройство AS-4145GH-TNMR располагает 24 отсеками для накопителей SFF NVMe/SAS/SATA с возможностью горячей замены и двумя разъёмами для модулей M.2 NVMe или SATA. Есть шесть слотов PCIe 5.0 x16 FHHL и два разъёма PCIe 5.0 x16 AIOM. Задействованы четыре блока питания на 1600 Вт с сертификатом 80 Plus Titanium. Сервер AS-2145GH-TNMR получил восемь посадочных мест для накопителей SFF NVMe/SAS/SATA и два разъёма для SSD M.2 NVMe или SATA. Доступны четыре слота PCIe 5.0 x16 FHHL и два слота PCIe 5.0 x16 AIOM. За питание отвечают четыре блока на 1600 Вт с сертификатом 80 Plus Titanium.

08.12.2023 [16:31], Сергей Карасёв

Gigabyte представила серверы с ускорителями AMD Instinct MI300 для задач ИИ и HPCКомпания Giga Computing (Gigabyte) анонсировала серверы G383-R80, G593-ZX1 и G593-ZX2 на аппаратной платформе AMD, предназначенные для решения ресурсоёмких задач: это могут быть приложения ИИ и HPC. Все новинки оборудованы ускорителями серии Instinct MI300. Модель G383-R80, выполненная в формате 3U, несёт на борту четыре чипа Instinct MI300A (24 ядра EPYC Genoa, ускоритель CDNA 3 и 128 Гбайт памяти HBM3). Во фронтальной части расположены 8 отсеков для SFF-накопителей NVMe SSD.

Источник изображений: Gigabyte Могут быть задействованы до 12 слотов расширения для карт FHFL с интерфейсом PCIe 5.0. Есть слот для SSD стандарта М.2 2280/22110 с интерфейсом PCIe 5.0 x4, два сетевых порта 10GbE (Broadcom BCM57416), выделенный порт управления 1GbE, контроллер Aspeed AST2600, два порта USB 3.2 Gen1 и разъём D-Sub. Питание обеспечивают четыре блока мощностью 2200 Вт каждый с сертификатом 80 Plus Titanium. Серверы G593-ZX1 и G593-ZX2, в свою очередь, имеют типоразмер 5U. Они комплектуются двумя процессорами AMD EPYC Genoa с показателем TDP до 300 Вт и восемью ускорителями Instinct MI300X OAM со 192 Гбайт памяти HBM3. Для модулей ОЗУ стандарта DDR5-4800 доступны 24 разъёма. Спереди находятся восемь отсеков для SFF-накопителей NVMe SSD.  Эти серверы оборудованы двумя слотами для SSD формата М.2 2280/22110 с интерфейсом PCIe 3.0 (по одному х1 и х4), двумя портами 10GbE (Intel X710-AT2), выделенным сетевым портом управления 1GbE, контроллером Aspeed AST2600, двумя портами USB 3.2 Gen1 и разъёмом D-Sub. Предусмотрены четыре слота PCIe 5.0 x16 для карт FHHL и восемь слотов PCIe 5.0 x16 для LP-карт. Версия G593-ZX1 получила восемь root-портов, модель G593-ZX2 — четыре. Установлены шесть блоков питания на 3000 Вт с сертификатом 80 Plus Titanium. |

|