Материалы по тегу: rockport networks

|

26.05.2022 [23:16], Алексей Степин

Институт вычислительной космологии протестирует безкоммутаторную сеть Rockport NetworksИз всех существующих сетевых технологий большая часть полагается на два типа устройств: сетевые адаптеры и коммутаторы, но Rockport Networks идёт дальше и предлагает отказаться от последних. В её технологии используются только пассивные оптоволоконные разветвители, в которых топология сети задается пассивными оптическим модулями. У такого подхода есть свои достоинства, которые уже оценили некоторые разработчики суперкомпьютеров. К примеру, такая сеть позволяет обойтись существенно меньшим количеством кабелей, а производительность оказывается в ряде случаев даже выше, нежели у InfiniBand класса 200G. Список заинтересованных в технологиях Rockport пополнился Институтом вычислительной космологии (ICC) Даремского университета, который решил протестировать их в одной из итераций своей «космологической машины» (COSMA).

Пассивный разветвитель Rockport Networks. Источник: Rockport В течение года безкоммутаторная сеть Rockport проходила проверку на тестовом кластере DINE (Durham Intelligent NIC Environment) и были получены обнадёживающие результаты, давшие в итоге этой технологии «зелёный свет» в более масштабный проект.

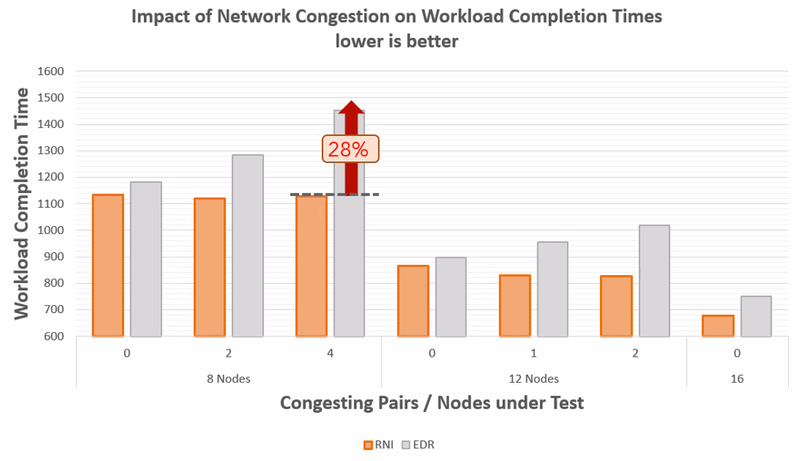

Источник: Durham University Вкратце, перевод 16 узлов тестовой системы из 24 на технологии Rockport позволил существенно снизить негативное влияние «сетевых заторов» (network congestion) на время обсчёта задачи; в некоторых сценариях традиционная архитектура IB оказалась хуже почти на 30%. В связи с позитивными результатами ICC получила финансирование сразу от двух научных программ Соединённого Королевства — DiRAC и ExCALIBUR.

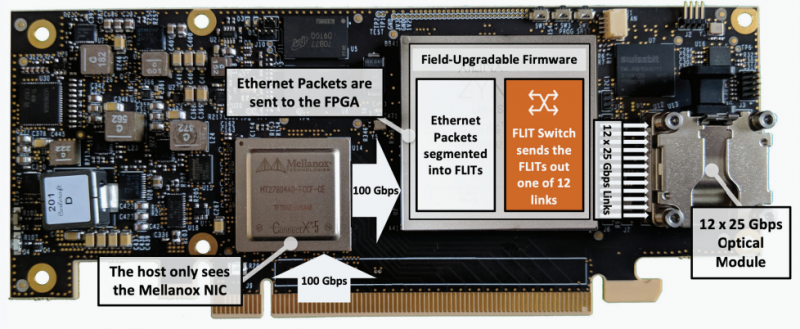

Адаптер Rockport NC1225: всё дело в волшебной ПЛИС. Источник: Rockport Целью является модернизация COSMA7, кластера из 452 двухпроцессорных узлов на базе Intel Xeon Gold 5120. На первой стадии половина узлов будет переведена с использования InfiniBand на сеть Rockport, что позволит провести более масштабное сравнение технологий, причём на реальных научных задачах, а не синтетических тестах. При этом модернизации системного и прикладного ПО не потребуется, поскольку со стороны хост-системы адаптеры Rockport видны как обычные карты Mellanox ConnectX-5, а весь роутинг и обработка пакетов осуществляется уровнем выше, силами набортной ПЛИС. Похожий эксперимент проходит в Техасском центре продвинутых вычислений (Texas Advanced Computing Center), где 396 из 8008 узлов суперкомпьютера Frontera также были переведены на использование интерконнекта Rockport Networks. |

|