Материалы по тегу: ems

|

29.02.2024 [13:01], Владимир Мироненко

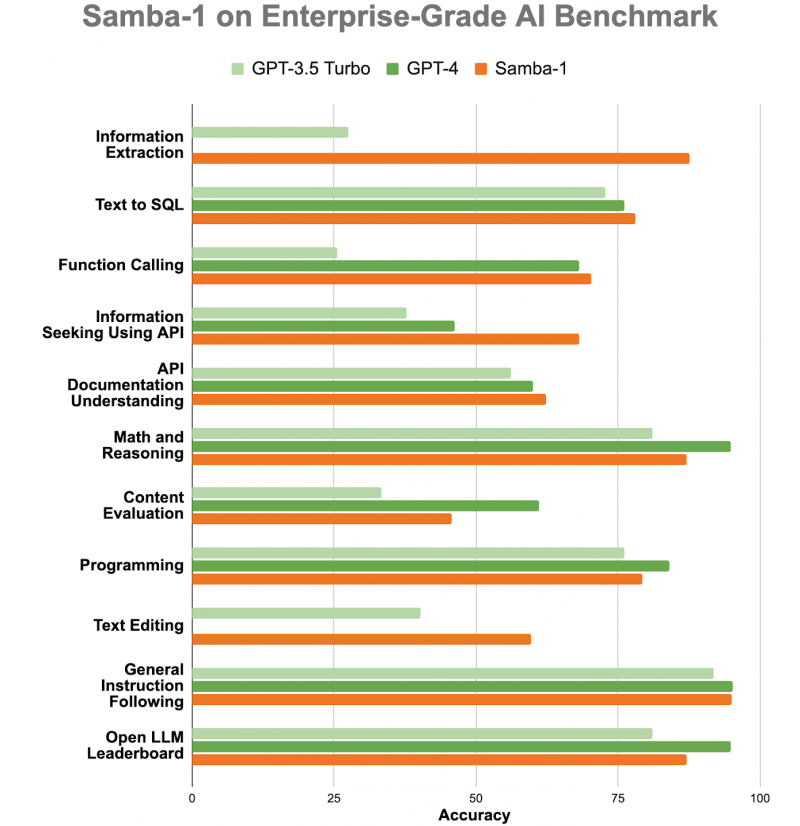

ИИ-консилиум: корпоративная LLM Samba-1 c 1 трлн параметров объединила более 50 открытых моделейСтартап SambaNova Systems представил Samba-1, модель генеративного ИИ с 1 трлн параметров, предназначенную для использования предприятиями. SambaNova описывает новую модель как «объединение экспертных архитектур» (Composition of Experts, CoE), которое включает более 50 открытых моделей генеративного ИИ высочайшего качества, в том числе Llama2 7B/13B/70B, Mistral 7B, DeepSeek Coder 1.3B/6.7B/33B, Falcon 40B, DePlot, CLIP, Llava. В частности, Llama 2 может генерировать текст, создавать программный код и решать математические задачи. Есть и более специализированные LLM, такие как DePlot от Google, которая может вводить информацию из диаграмм и других визуализаций данных в электронную таблицу. Samba-1 уже используется клиентами и партнёрами SambaNova, включая Accenture и NetApp. SambaNova позиционирует Samba-1 как первую модель с 1 трлн параметров для предприятий с регулируемой деятельностью, которая является приватной, безопасной и на порядок более эффективной, чем любая другая модель такого размера. Заказчик может установить контроль доступа к данным для отдельных пользователей. Желающие могут ознакомиться с работой модели. По словам главы SambaNova, Samba-1 оптимизирована для работы с чипом SN40L, выпущенным стартапом прошлой осенью. «Samba-1 способна конкурировать с GPT-4, но она лучше подходит для предприятий, поскольку её можно развернуть как локально, так и в частном облаке, чтобы клиенты могли точно настроить модель с использованием своих личных данных, не отдавая их в открытый доступ», — добавил он. SambaNova утверждает, что инференс этой модели обходится в десять раз дешевле, чем для конкурирующих LLM. Получив запрос, Samba-1 решает, какая из её внутренних моделей лучше всего приспособлена для его обработки, и поручает ей сгенерировать ответ. То есть активируется только одна из относительно небольших моделей, тогда как традиционные монолитные LLM требуют активации целиком. Стартап SambaNova привлёк около $1 млрд инвестиций от ряда компаний, включая Intel Capital и GV (инвестиционное подразделение Alphabet Inc). По итогам раунда финансирования в начале 2021 года рыночная стоимость стартапа оценивается в более чем $5 млрд.

24.11.2023 [17:14], Сергей Карасёв

Лос-Аламосская национальная лаборатория внедрит обновлённые ИИ-системы SambaNovaЛос-Аламосская национальная лаборатория (LANL) Министерства энергетики США (DOE) заключила соглашение о сотрудничестве со стартапом SambaNova Systems, который специализируется на разработке ИИ-решений. Финансовые условия договора не раскрываются, но ранее стартап уже поставлял LANL свои решения. В рамках партнёрства LANL расширит применение программно-аппаратных комплексов SambaNova DataScale. Речь идёт о системе DataScale SN30, содержащей восемь ускорителей собственной разработки Cardinal SN30, суммарно имеющих 5 Гбайт SRAM и 8 Тбайт DRAM. Конфигурация комплекса может включать от одного до трёх узлов SN30. Кроме того, LANL внедрит решение SambaNova Suite для генеративного ИИ. Эта платформа предоставляет различные ИИ-модели, оптимизированные для корпоративных и государственных организаций. Они могут быть развёрнуты локально или в облаке с возможностью адаптации к собственному набору данных заказчика.

Источник изображения: SambaNova Новое многолетнее соглашение между LANL и SambaNova является расширением действующего партнёрства между сторонами. Лаборатория будет использовать технологии SambaNova для решения широкого спектра задач, связанных с ИИ и большими языковыми моделями (LLM), в том числе в интересах национальной безопасности. Отмечается, что платформа SambaNova Suite предлагает быстрый и эффективный способ развёртывания генеративного ИИ для реализации самых сложных проектов.

16.11.2023 [16:15], Сергей Карасёв

iXsystems представила двухконтроллерные All-Flash СХД TrueNAS F-Series на базе NVMe SSDКомпания iXsystems анонсировала СХД семейства TrueNAS F-Series в форм-факторе 2U. Устройства выполнены на основе NVMe SSD и оснащены двумя контроллерами, а заявленная доступность достигает 99,999 %. Изделия подходят для решения задач в области ИИ, машинного обучения, виртуализации и пр. В серию вошли модификации F60 и F100. Они выполнены в корпусе глубиной 686 мм. Допускается установка 24 накопителей SFF. Каждый из контроллеров наделён 512 Гбайт DRAM-кеша. Предусмотрены два сетевых порта 10GbE и порт управления. Модель TrueNAS F60 располагает четырьмя оптическими портами 40/100GbE, модификация TrueNAS F100 — шестью. Максимальная пропускная способность хранилищ составляет соответственно 20 Гбайт/с и 30 Гбайт/с.

Источник изображения: iXsystems Вместимость достигает 720 Тбайт при использовании SSD на 30 Тбайт. При использовании СХД и дополнительных полок максимальная общая ёмкость составляет 2,1 Пбайт у F60 (две полки) и 3,5 Пбайт у F100 (четыре полки), а эффективная ёмкость послек компресии и дедупликации — 4 Пбайт и 7 Пбайт соответственно. Источник изображения: iXsystems Реализована поддержка SMB v1/2/3, NFSv3/v4, AFP, FTP, WebDAV, iSCSI, OpenStack Cinder, S3, Minio. Для СХД доступно обновлённое ПО TrueNAS SCALE версии 23.10, основанное на ядре Linux 6.1 и OpenZFS 2.2. Оно предлагает возможности виртуализации KVM, поддержку контейнеров, интеграцию с Kubernetes и функции масштабирования до 1200 накопителей. В версии TrueNAS SCALE 23.10 улучшен пользовательский интерфейс. Габариты СХД составляют 686 × 483 × 89 мм, вес — 19,5 кг без установленных накопителей. Диапазон рабочих температур — от +5 до +35 °C. Пробные поставки СХД TrueNAS F-Series уже начались. Стоимость версии F60 начинается с $60 тыс., модификации F100 — со $100 тыс.

13.11.2023 [16:16], Сергей Карасёв

OSS представила защищённый ИИ-сервер Gen 5 AI Transportable на базе NVIDIA H100Компания One Stop Systems (OSS) на конференции по высокопроизводительным вычислениям SC23 представила сервер Gen 5 AI Transportable, предназначенный для решения задач ИИ и машинного обучения на периферии. Устройство, рассчитанное на монтаж в стойку, выполнено в корпусе уменьшенной глубины. Новинка соответствует американским военным стандартам в плане устойчивости к ударам, вибрации, диапазону рабочих температур и пр. Сервер может применяться в составе мобильных дата-центров, на борту грузовиков, самолётов и подводных лодок. Возможна установка четырёх ускорителей NVIDIA H100 и до 16 NVMe SSD суммарной вместимостью до 1 Пбайт. Говорится о поддержке до 35 одновременных ИИ-нагрузок. Кроме того, могут применяться сетевые решения стандарта 400 Гбит/с. При необходимости можно подключить NAS-хранилище в усиленном исполнении.

Источник изображения: OSS Для сервера доступны различные варианты охлаждения: воздушное, автономное жидкостное или внешний теплообменник с жидкостным контуром. Поддерживаются различные варианты организации питания с переменным и постоянным током для использования на суше, в воздухе и море. При использовании СЖО ускорители H100, по всей видимости, комплектуются водоблоком EK-Pro NVIDIA H100 GPU WB. Реализована фирменная архитектура Open Split-Flow: она обеспечивает высокую эффективность охлаждения даже при небольшой скорости потока жидкости, что позволяет применять не слишком мощные помпы или помпы, работающие с невысокой скоростью. Микроканалы, фрезерованные на станке с ЧПУ, обладают минимальным гидравлическим сопротивлением потоку. Водоблок имеет однослотовое исполнение. Предусмотрено проприетарное ПО U-BMC (Unified Baseboard Management Controller) для динамического управления скоростью вентиляторов, мониторинга системы и пр. Сервер подходит для монтажа в большинство 19″ стоек.

09.11.2023 [03:15], Алексей Степин

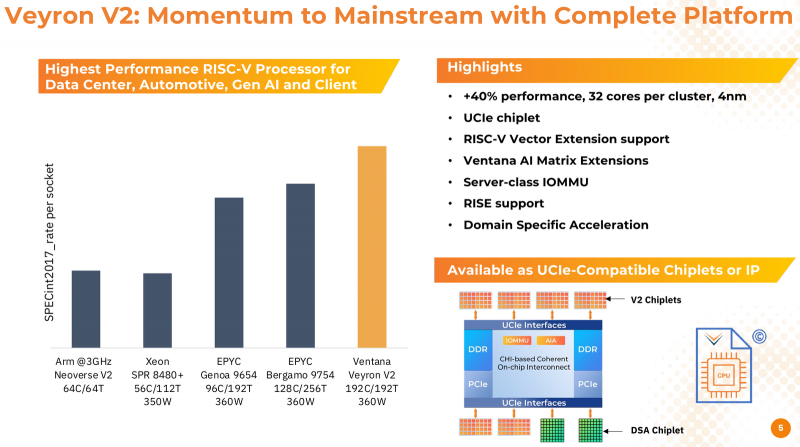

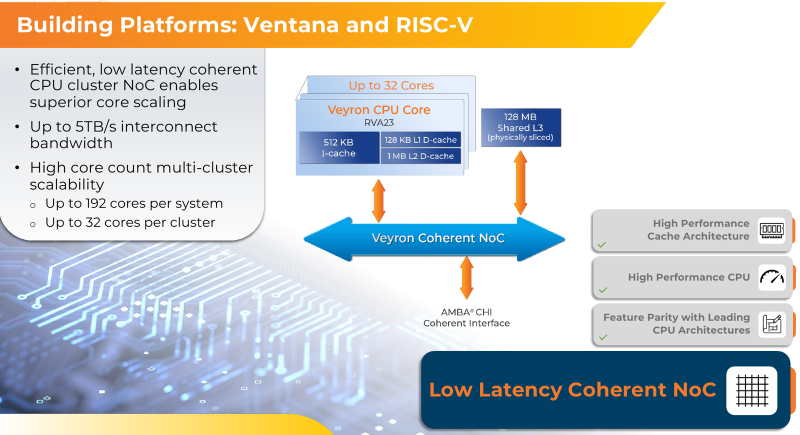

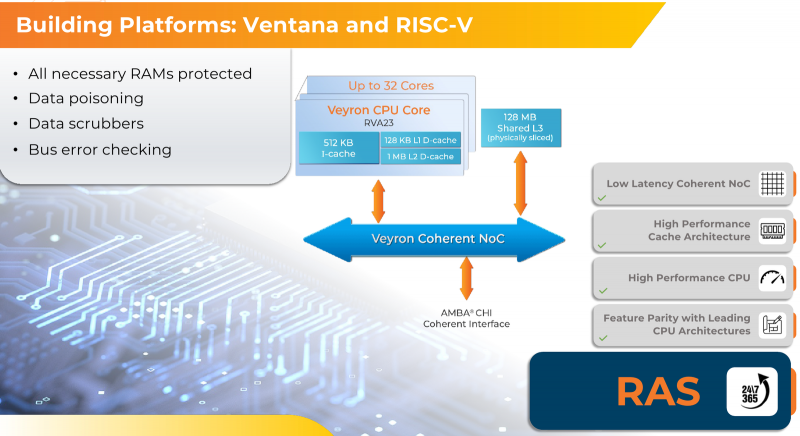

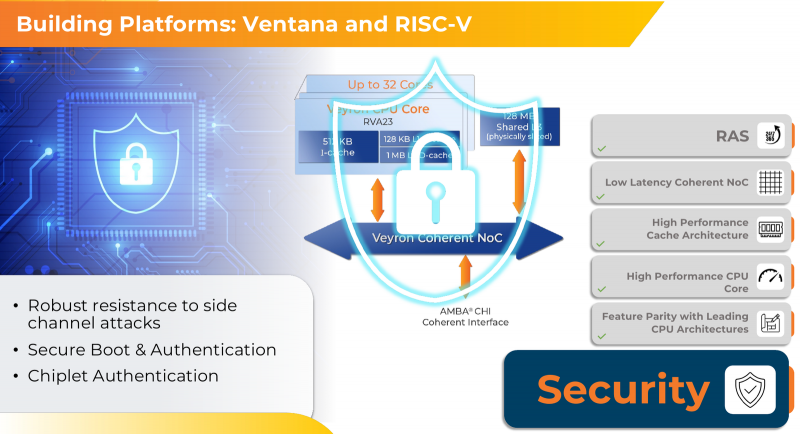

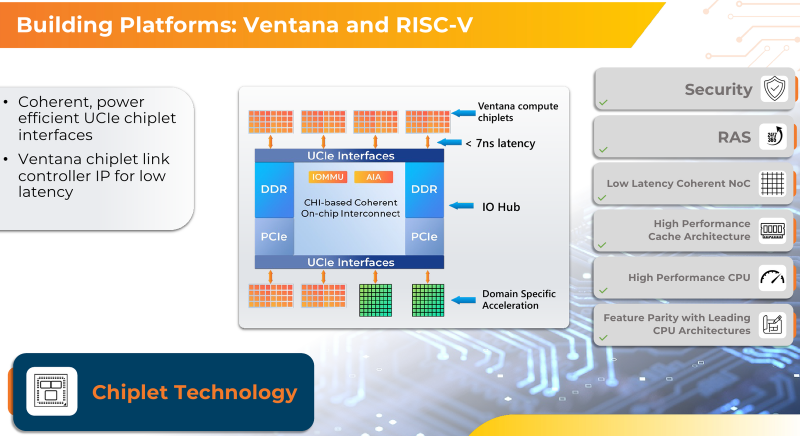

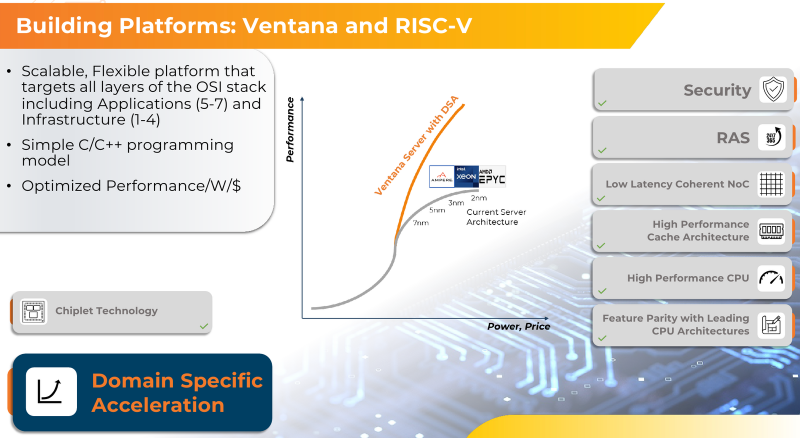

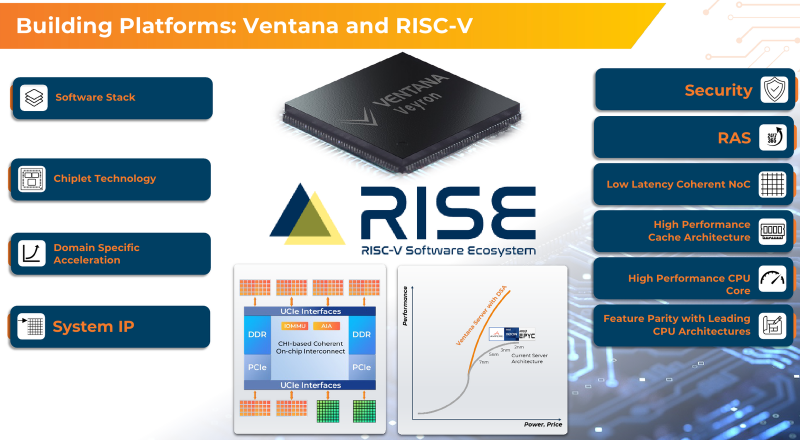

RISC-V с приправой: модульные 192-ядерные серверные процессоры Ventana Veyron V2 можно дополнить ускорителямиВ 2022 года компания Ventana Micro Systems анонсировала первые по-настоящему серверные RISC-V процессоры Veyron V1. Анонс чипов, обещающих потягаться на равных с лучшими x86-процессорами с архитектурой x86, прозвучал громко. Популярности, впрочем, Veyron V1 не снискал, но на днях компания анонсировала второе поколение чипов Veyron V2, более полно воплотившее в себе принципы модульного дизайна и получившее ряд усовершенствований. Как и в первом поколении, компания-разработчик продолжает придерживаться концепции «процессора-конструктора» с чиплетным дизайном. В центре 4-нм Veyron V2 по-прежнему лежит I/O-хаб на базе AMBA CHI, охватывающий контроллеры памяти и шины PCI Express, а также блоки IOMMU и AIA. К нему посредством интерфейса UCIe подключаются вычислительные чиплеты. Латентность UCIe-подключения составляет менее 7 нс.

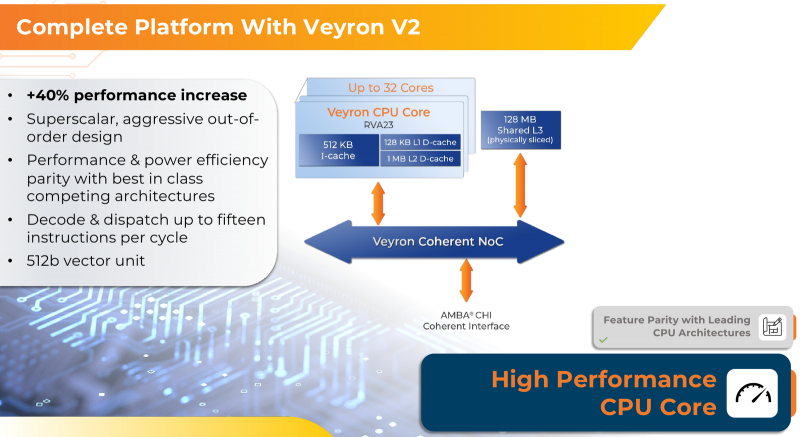

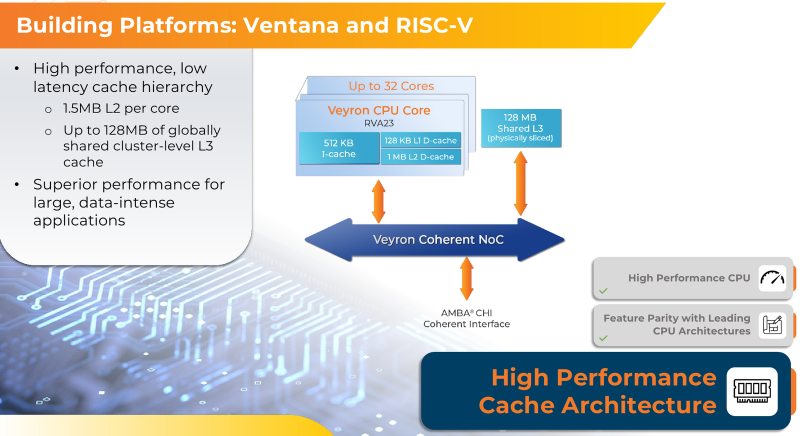

Источник изображений здесь и далее: Ventana Micro Systems Чиплеты эти могут быть разных видов: либо с ядрами общего назначения (по 32 ядра на чиплет), образующие собственно процессор Veyron V2, либо содержащие специфические сопроцессоры под конкретную задачу (domain-specific acceleration, DSA). Последние могуть быть представлены FPGA, ИИ-ускорителями и т.д. Более того, Ventana по желанию заказчика может оптимизировать и I/O-хаб для повышения эффективности работы ядер CPU с сопроцессорами. В классическом варианте Veyron V2 может иметь до шести чиплетов с RV64GC-ядрами V2, что в сумме даёт 192 ядра. Поддержка SMT отсутствует. Удельная производительность в пересчёте на ядро получается несколько ниже, чем у AMD Zen 4c, но согласно результатам тестов, предоставленных Ventana, 192-ядерный Veyron V2 заметно опережает AMD EPYC Bergamo 9754 (128C/256T) при аналогичном теплопакете в 360 Вт. Столь неплохой результат достигнут за счёт оптимизации архитектуры Veyron: по сравнению с первым поколением говорится о 40 % прибавке производительности. Что немаловажно, во втором поколении процессоров Veyron была реализована поддержка 512-бит векторных расширений, фирменных матричных расширений, а также целого ряда других спецификаций. В целом ради совместимости разработчики предпочли остаться в рамках общего профиля RVA23. Сами ядра V2 используют суперскалярный дизайн с агрессивным внеочередным исполнением и продвинутым предсказанием ветвлений. Возможно декодирование и обработка до 15 инструкций за такт. Объём L1-кешей составляет 512 Кбайт для инструкций и 128 Кбайт для данных, дополнительно каждое ядро имеет свой кеш L2 объёмом 1 Мбайт. Общий для всего 32-ядерного чиплета L3-кеш имеет объём 128 Мбайт. Производительность внутренней когерентной шины составляет до 5 Тбайт/с. Позиционируемый в качестве решения для гиперскейлеров, крупных ЦОД и HPC, Veyron V2 имеет развитые средства предотвращения ошибок и защиты данных, от ECC-кешей и поддержки Secure Boot до аутентификации на уровне чиплета и продвинутых RAS-функций. Кроме того, реализована защита от атак по сторонним каналам. Несмотря на то, что мир RISC-V пока ещё похож на «Дикий Запад», Ventana старается опираться на развитые и популярные стандарты: в частности, это выражается в применении UCIe для подключения чиплетов, поддержку гипервизоров первого и второго типа, вложенную виртуализацию и совместимость с программной экосистемой RISC-V RISE. Подход Ventana позволит избежать недостатков, свойственных дискретным PCIe-ускорителям (высокая латентность, энергопотребление и стоимость) и сложным монолитным SoC (очень высокая стоимость разработки и сроки), снизить время и стоимость стоимость новых решений, а также обеспечить более низкий уровень энергопотребления. В общем, компания явно целится в гиперскейлеров. Видение сценариев применения DSA у Ventana очень широкий — от БД-ускорителей и блоков компрессии-декомпрессии данных до поддержки специфических алгоритмов в задачах аналитики и транскодеров в системах доставки контента. Также становятся ненужными дискретные DPU. Первым партнёром Ventana стала Imagination Technologies, крупный разработчик GPU. В качестве вариантов физической реализации новой платформы Ventana предлагает компактный 1U-сервер, содержащий один чип Veyron V2 со 192 ядрами, работающими на частотах до 3,6 ГГц, и 12 каналами DDR5-5600. Вероятнее всего, производителем новой платформы станет GIGABYTE. Ожидать первых поставок следует не ранее II квартала 2024 года. В целом, видение высокопроизводительной модульной платформы, продвигаемое Ventana, выглядит перспективно, а упор на применение DSA может выгодно отличать её большинства Arm-серверов, конкурирующих с решениями Intel/AMD лоб в лоб. Вопрос лишь в поддержке со стороны разработчиков программного обеспечения — и здесь может сыграть ставка разработчиков на максимально открытые, широкие стандарты.

20.09.2023 [20:05], Алексей Степин

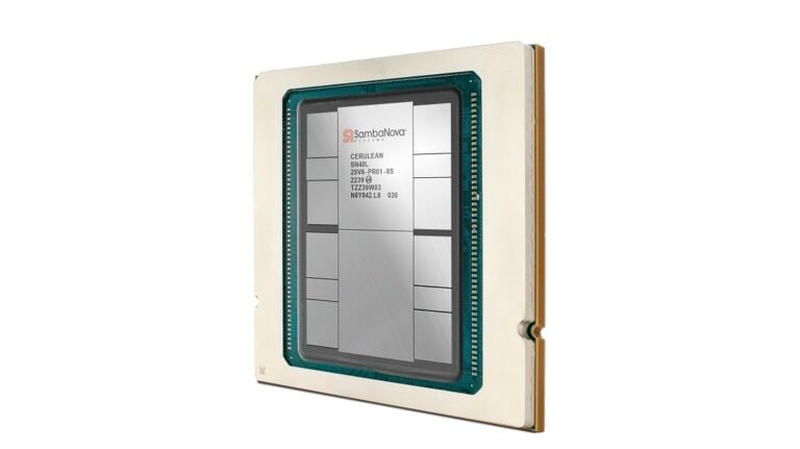

SambaNova представила ИИ-ускоритель SN40L с памятью HBM3, который в разы быстрее GPUБум больших языковых моделей (LLM) неизбежно порождает появление на рынке нового специализированного класса процессоров и ускорителей — и нередко такие решения оказываются эффективнее традиционного подхода с применением GPU. Компания SambaNova Systems, разработчик таких ускорителей и систем на их основе, представила новое, третье поколение ИИ-процессоров под названием SN40L. Осенью 2022 года компания представила чип SN30 на базе уникальной тайловой архитектуры с программным управлением, уже тогда вполне осознавая тенденцию к увеличению объёмов данных в нейросетях: чип получил 640 Мбайт SRAM-кеша и комплектовался оперативной памятью объёмом 1 Тбайт.

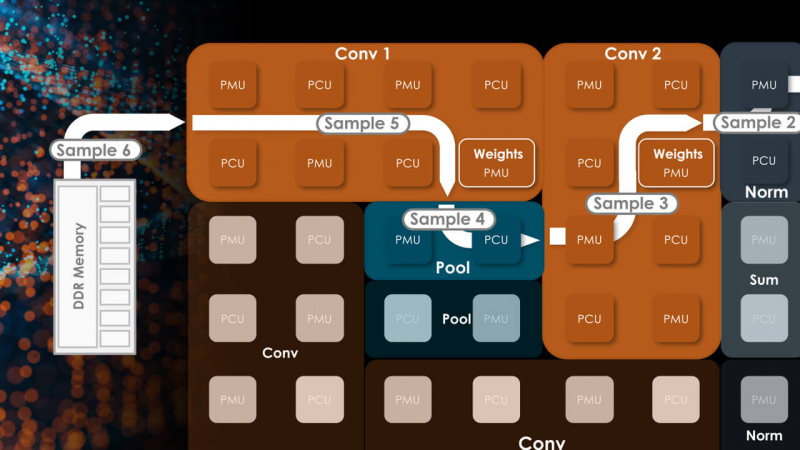

Источник изображений здесь и далее: SambaNova (via EE Times) Эта наработка легла и в основу новейшего SN40L. Благодаря переходу от 7-нм техпроцесса TSMC к более совершенному 5-нм разработчикам удалось нарастить количество ядер до 1040, но их архитектура осталась прежней. Впрочем, с учётом реконфигурируемости недостатком это не является. Чип SN40L состоит из двух больших чиплетов, на которые приходится 520 Мбайт SRAM-кеша, 1,5 Тбайт DDR5 DRAM, а также 64 Гбайт высокоскоростной HBM3. Последняя была добавлена в SN40L в качестве буфера между сверхбыстрой SRAM и относительно медленной DDR. Это должно улучшить показатели чипа при работе в режиме LLM-инференса. Для эффективного использования HBM3 программный стек SambaNova был соответствующим образом доработан.

Тайловая архитектура SambaNova состоит из вычислительных тайлов PCU, SRAM-тайлов PMU, управляющей логики и меш-интерконнекта По сведениям SambaNova, восьмипроцессорная система на базе SN40L сможет запускать и обслуживать ИИ-модель поистине титанических «габаритов» — с 5 трлн параметров и глубиной запроса более 256к. В описываемой модели речь идёт о наборе экспертных моделей с LLM Llama-2 в качестве своеобразного дирижёра этого оркестра. Архитектура с традиционными GPU потребовала бы для запуска этой же модели 24 сервера с 8 ускорителями каждый; впрочем, модель ускорителей не уточняется. Как и прежде, сторонним клиентам чипы SN40L и отдельные вычислительные узлы на их основе поставляться не будут. Компания продолжит использовать модель Dataflow-as-a-Service (DaaS) — расширяемую платформу ИИ-сервисов по подписке, включающей в себя услуги по установке оборудования, вводу его в строй и управлению в рамках сервиса. Однако SN40L появится в рамках этой услуги позднее, а дебютирует он в составе облачной службы SambaNova Suite.

04.08.2023 [13:12], Сергей Карасёв

Группа «Рексофт» купила технологическую компанию RNT GroupГруппа «Рексофт», российский разработчик цифровых решений, сообщила о приобретении 100% компании RNT Group, которая является правообладателем ООО «ЭПАМ Систэмз», дочерней структуры EPAM в России. Финансовые условия сделки не раскрываются. Американский разработчик ПО с белорусскими корнями EPAM в связи со сложившейся геополитической обстановкой принял решение покинуть российский рынок. Денежные потери, связанные с этой процедурой, превысили $75 млн.

Источник изображения: pixabay.com Сделка по объединению «Рексофт» и RNT Group уже получила одобрение государственных регуляторов в России и США и была юридически завершена. Соглашение не предусматривает опцион на обратный выкуп. Планируется, что основные шаги по объединению активов займут около года. После слияния общий штат сотрудников превысит 1500 человек. «Рексофт» (Reksoft) — российская многопрофильная технологическая компания, оказывающая полный спектр услуг в области цифровой трансформации предприятий: от формирования бизнес-стратегии и управления до внедрения информационных систем, заказной разработки ПО и поддержки. В свою очередь, RNT Group предоставляет заказчикам услуги по технологическому консалтингу, разработке цифровых решений и построению гибких и масштабируемых платформ для высокой нагрузки и большого количества пользователей. «Объединение с RNT Group, одной из лучших команд в сфере инжиниринга ПО и заказной разработки, стало для нас важным этапом реализации нашей стратегии поставки передовых бизнес-решений под ключ», — отметил Александр Егоров, генеральный директор группы «Рексофт».

06.07.2023 [14:36], Сергей Карасёв

Разработчик систем прямого жидкостного охлаждения CoolIT привлёк средства от MubadalaИнвестиционная компания Mubadala из Абу-Даби (ОАЭ), по сообщению ресурса Datacenter Dynamics, предоставила средства на развитие фирмы CoolIT — разработчика систем прямого жидкостного охлаждения (DLC). CoolIT была основана в 2001 году и сейчас является одним из лидеров рынка серверных СЖО. В частности, именно её решения используются в Frontier, самом производительном суперкомпьютере в мире по версии TOP500. Отмечается, что Mubadala инвестировала в CoolIT ещё в мае нынешнего года, но финансовые условия этого раунда финансирования не раскрываются. Известно лишь, что в нём приняла участие глобальная инвестиционная компания KKR, которая ранее заключила соглашение по приобретению CoolIT.

Источник изображения: CoolIT «Ожидается, что к 2030 году индустрия дата-центров будет потреблять 8 % мировой энергии. Поэтому жидкостное охлаждение играет жизненно важную роль в сокращении вредных выбросов в сегменте ЦОД», — сказал Абдулла Шадид (Abdulla Shadid), руководитель группы Impact Investing в Mubadala. В ходе более ранних раундов финансирования CoolIT привлекла приблизительно $10 млн. В число инвесторов вошли Банк делового развития Канады, nVent, Kline Hill Partners, Vistara Capital Partners, Inovia Partners, AVAC Group и Chart Venture Partners.

03.05.2023 [18:13], Сергей Карасёв

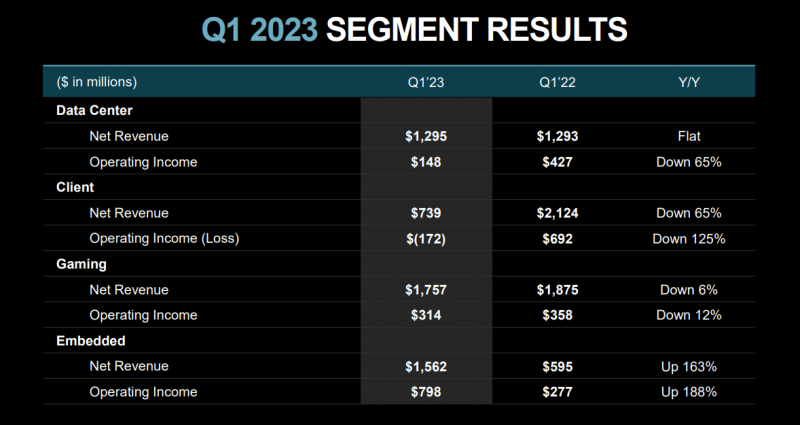

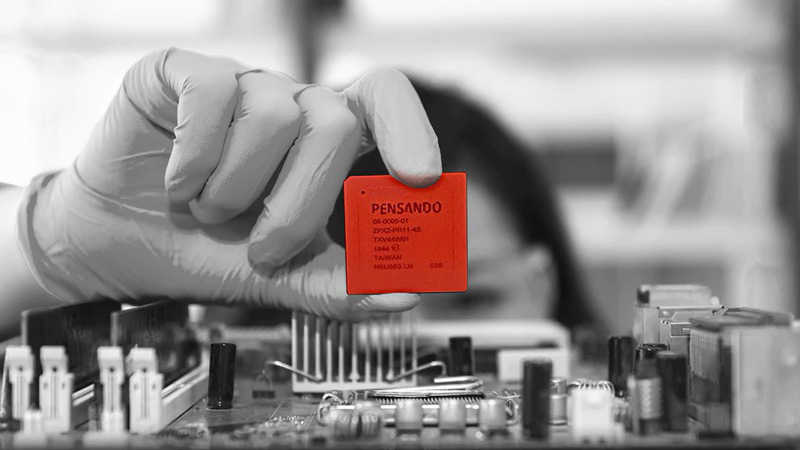

В не слишком удачном квартальном отчёте AMD отметила, что в облаке Microsoft Azure появились DPU Pensando, а серверные решения помогут ей заработать во втором полугодииКомпания AMD, по сообщению ресурса The Register, нашла крупного заказчика для DPU (Data Processing Unit) семейства Pensando: им стало облако Microsoft Azure. Доступ к этим специализированным ускорителям теперь предоставляется клиентам по модели «как услуга». Это тем более любопытно, что Microsoft недавно поглотила разработчика DPU Fungible. О поставках DPU Pensando в интересах Microsoft сообщила президент и исполнительный директор AMD Лиза Су (Lisa Su) в ходе оглашения финансовых показателей за I квартал 2023 года. Ускорители применяются в составе недавно анонсированной службы Microsoft Accelerated Connections. Гиперскейлеры зачастую используют DPU, но делают это для поддержания работы собственных сервисов. В случае Azure доступ к таким ускорителям предоставляется сторонним заказчикам.

Источник изображения: AMD В финансовом отчёте AMD говорится, что выручка по итогам I четверти 2023-го составила $5,35 млрд. Это примерно на 9 % меньше результата годичной давности, равнявшегося $5,89 млрд. Компания понесла чистые убытки в размере $139 млн, или 9 центов в пересчёте на одну ценную бумагу. Для сравнения: в I квартале 2022 года AMD продемонстрировала чистую прибыль на уровне $786 млн, или 56 центов на акцию. Выручка подразделения ЦОД за год практически не изменилась: она составила $1,30 млрд против $1,29 млрд в I четверти 2022-го. При этом операционная прибыль рухнула в годовом исчислении на 65 % — с $427 млн до $148 млн. По направлению встраиваемых систем квартальная выручка за год взлетела на 163 % — с $595 млн до $1,56 млрд. Операционная прибыль в этой группе поднялась на 188 %, достигнув $798 млн. По словам госпожи Су, AMD ожидает, что спрос на серверы во втором квартале 2023 года «остается смешанным». При этом компания рассматривает в качестве потенциальных областей роста ЦОД-сегмент и рынок встраиваемых систем. Увеличению продаж должно способствовать бурное развитие технологий ИИ. Компания ожидает, что на рынке будут востребованы процессоры Genoa и Bergamo, а также ускорители MI300 и решения Xilinx.

03.05.2023 [13:58], Сергей Карасёв

KKR купит разработчика систем прямого жидкостного охлаждения CoolITГлобальная инвестиционная компания KKR сообщила о заключении соглашения по приобретению фирмы CoolIT Systems (CoolIT) — известного канадского разработчика систем прямого жидкостного охлаждения DLC (Direct Liquid Cooling). Финансовые условия договора не раскрываются. CoolIT была основана в 2001 году. Компания занимается проектированием и производством решений жидкостного охлаждения для ЦОД и ПК. В частности, как сообщается, запатентованная DLC-технология Split-Flow повышает надёжность и срок службы оборудования, снижает эксплуатационные расходы, сокращает энергопотребление и выбросы углерода. При этом достигается возможность повышения плотности монтажа серверных компонентов по сравнению с традиционными методами воздушного охлаждения.

Источник изображения: CoolIT Ожидается, что, получив доступ к ресурсам и капиталу KKR, компания CoolIT сможет ускорить развитие своих технологий и вывод инновационных решений на коммерческий рынок. Речь идёт о поставках продуктов для дата-центров, облачных платформ, систем НРС и пр. KKR в рамках сделки рассчитывает на дальнейшее масштабирование одного из лучших в своём классе решений DLC. Отмечается также, что KKR инвестирует в CoolIT в рамках своей стратегии Global Impact. Эта инициатива, в частности, направлена на поддержку компаний, которые вносят ощутимый вклад в достижение одной или нескольких Целей устойчивого развития ООН. Ожидается, что сделка будет закрыта во втором квартале 2023 года при условии получения необходимых разрешений со стороны регулирующих органов. |

|