Напоминаем, что попытки повторить действия автора могут привести к потере гарантии на оборудование и даже к выходу его из строя. Материал приведен исключительно в ознакомительных целях. Если же вы собираетесь воспроизводить действия, описанные ниже, настоятельно советуем внимательно прочитать статью до конца хотя бы один раз. Редакция 3DNews не несет никакой ответственности за любые возможные последствия.

Если вы ни разу не сталкивались с Proxmox Virtual Environment, то стоит сказать буквально несколько слов об этой системе виртуализации. Proxmox VE базируется на дистрибутиве Debian и для виртуализации использует KVM в паре с OpenVZ. В первом случае мы можем виртуализировать практически любую ОС, а во втором – Linux-системы, для ряда которых есть готовые шаблоны. Всё это обёрнуто в красивый и удобный веб-интерфейс вкупе с RESTful API для управления ВМ и мониторинга их состояния. Несколько хостов с Proxmox VE можно объединить в кластер с возможностью “живой” миграции гостевых систем, резервным копированием, отказоустойчивостью и прочими полезными функциями. Естественно, Proxmox VE далеко не единственная система виртуализации с такой функциональностью, но, несомненно, одна из лучших среди бесплатных и открrfытых.

Минимальные системные требования для Proxmox VE 2 таковы: 64-битный процессор с поддержкой аппаратной виртуализации, 1 Гбайт RAM, жёсткий диск и сетевая карта. Впрочем, рекомендуется использовать многоядерные CPU, хотя бы 4 Гбайт памяти, аппаратный RAID-массив на быстрых дисках и несколько сетевых интерфейсов. Реальные системные требования, конечно же, зависят от того, какие гостевые системы и в каком количестве вы планируете виртуализировать. Скачать установочный ISO-образ можно на официальном сайте.

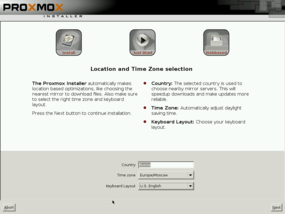

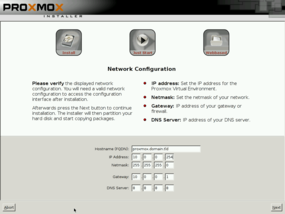

Процесс инсталляции Proxmox практически полностью автоматизирован – от вас потребуется только задать часовой пояс, раскладку клавиатуры (русской по умолчанию нет в списке выбора), пароль и адрес электронной почты администратора, а также сетевые параметры.

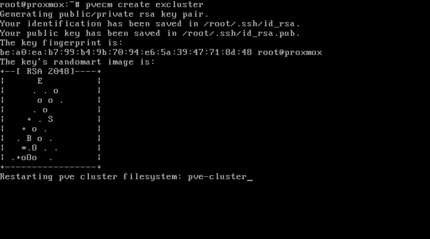

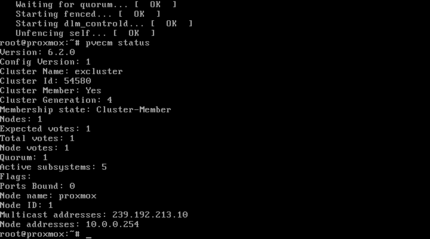

После перезагрузки в приветствии будет указан адрес и порт веб-интерфейса, через который осуществляется управление системой. Точно так же надо установить Proxmox на вторую машину, которую мы добавим в кластер. Делается это всё из командной строки. Входим в систему на машине, которая будет мастером (хотя на самом деле Proxmox уже не single-master система), с логином root и паролем, заданным во время инсталляции. Даём команду на создание кластера, где вместо clustername указываем его имя, а после этого проверяем статус.

pvecm create clustername pvecm status

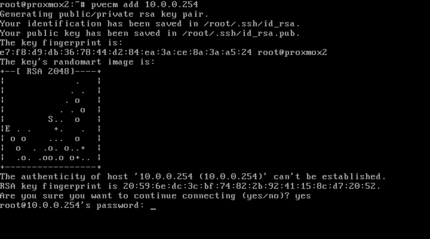

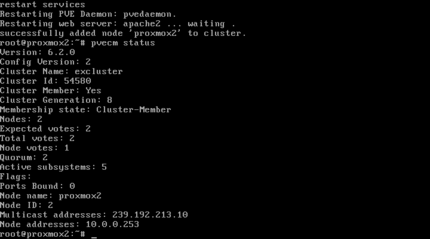

На второй машине, которая станет одним из узлов, даём команду подключиться к мастеру (вместо 10.0.0.254 укажите его истинный IP-адрес) и ещё раз проверяем статус. Обратите внимание, что на узлах не должно быть никаких ВМ, а все они должны находиться в одной сети с разрешённым мультикастом. После этого можно отключить клавиатуру с монитором и управлять системой через веб-интерфейс любого из её узлов.

pvecm add 10.0.0.254 pvecm status

Перед этим рекомендуется обновить на каждом из узлов систему (если вы вдруг не делаете это регулярно), поэтапно остановив или смигрировав все контейнеры и ВМ.

aptitude update aptitude full-upgrade

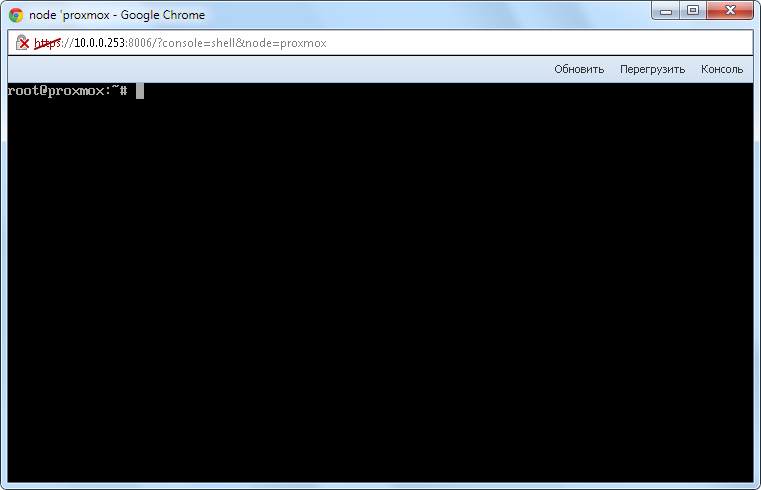

Веб-интерфейс работает через https и на порту 8006. Также доступно подключение SSH/SFTP. По умолчанию логин – root, тип авторизации – PAM. При входе можно выбрать язык интерфейса (есть и русский). Кстати, в Opera ряд функций будет недоступен. Прямо в веб-интерфейсе можно подключиться к консоли любого из серверов – необходимо лишь наличие Java-плагина в браузере.

Proxmox поддерживает достаточно гибкую политику доступа. Можно создавать пользователей, объединять их в группы и давать им различные разрешения в соответствии с предустановленными ролями. Аутентификация доступна как через PAM, так и через собственный сервер Proxmox. Дополнительно можно подключить к системе AD/LDAP-сервер.

Общесистемных настроек не так уж много – раскладка клавиатуры да прокси-сервер. Также можно посмотреть общую сводку по состоянию системы и настроить отказоустойчивые ВМ. Тут же создаются пулы (группы) виртуальных машин и/или хранилищ. Пулы нужны для более удобного управления и распределения прав для группы ресурсов.

Здесь также можно добавить хранилища и настроить резервирование. В качестве хранилища могут выступать локальные директории или LVM-группы и внешние ресурсы iSCSI или NFS. К резервному копированию мы ещё вернёмся, а пока для примера добавим NFS-хранилище. От нас потребуется указать его ID (имя), адрес и один из ресурсов, список которых автоматически “подтягивается” при указании адреса. Также необходимо указать, каким узлам разрешён доступ к хранилищу, максимальное число резервных копий и типы данных, доступных для хранения, – образы дисков или контейнеры ВМ, бэкапы, шаблоны или ISO-образы.

Для каждого из хранилищ можно просмотреть его состояние, указать разрешения для пользователей и групп, а также прямо из веб-интерфейса загрузить готовые или свои собственные шаблоны и дампы OpenVZ или же установочные ISO-образы. Для примера мы скачаем шаблон для веб-сервера с предустановленным Wordpress, который впоследствии запустим в одном из контейнеров.

Для узлов кластера доступно чуть больше параметров для просмотра и редактирования. Можно просмотреть информацию о нагрузке на узел и о запущенных сервисах, пролистать системный лог и список последних задач, изменить параметры сетевых интерфейсов, а также просмотреть число ошибок UBC для контейнеров. В общем, почти всё, что нужно.

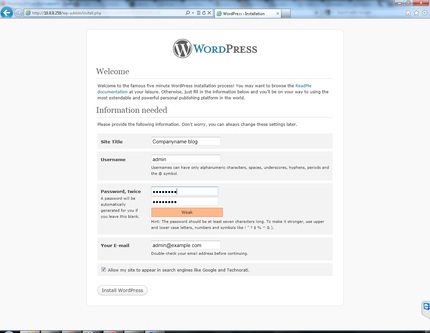

Итак, с веб-интерфейсом немножко разобрались. Попробуем создать свой первый контейнер. Делается это элементарно. Кликаем на “Создать CT” (Create CT) и поэтапно указываем необходимые параметры. Выбираем узел, где будет запущена ВМ, и хранилище, в котором будет располагаться образ системы. Указываем имя хоста, пул и пароль для root-доступа. Затем выбираем один из загруженных шаблонов из нужного хранилища и ставим ограничения на выделяемые ВМ ресурсы. Осталось указать тип сетевого подключения (venet сгодится для большинства случаев) и напоследок перепроверить, все ли параметры контейнера указаны верно. Через некоторое время контейнер будет готов к запуску.

Все эти параметры можно поменять и после создания контейнера, а также просмотреть его состояние, лог загрузки, ошибки и настроить права доступа к нему.

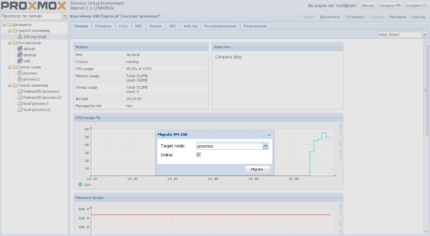

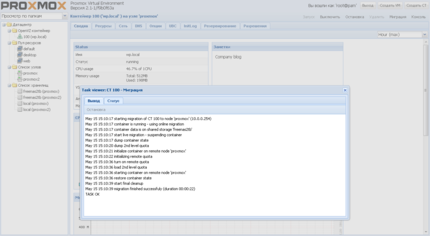

Ну и конечно, в любой момент можно запустить миграцию контейнера с одного узла на другой. В том числе и без остановки ВМ. Из веб-интерфейса вы можете также подключиться к её консоли.

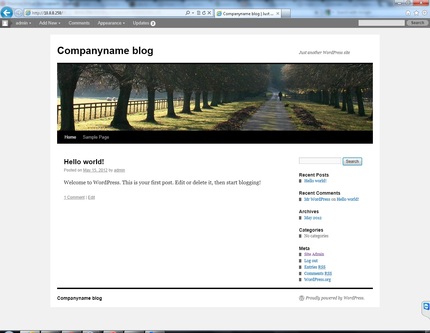

В нашем примере мы буквально за пять минут запустили блог на Wordpress без лишних заморочек. Для OpenVZ в Proxmox есть более полусотни готовых шаблонов для наиболее частых задач. Впрочем, сделать собственный шаблон на базе уже имеющихся не так уж сложно.

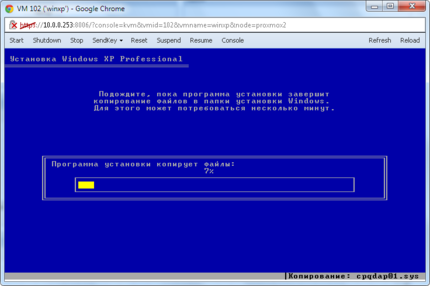

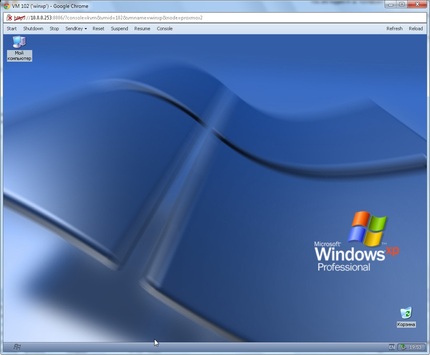

Создание KVM-машин ничуть не сложнее. Опять-таки надо выбрать узел, имя и пул. В качестве гостевой ОС можно использовать Windows 2000 и старше, Linux-дистрибутивы и прочие ОС. Для установки используется либо ISO-образ их хранилища, либо оптический привод одного из узлов. Затем выбирается тип, шина (IDE/SCSI/VIRTIO), число и объём накопителей, а также формат образа диска (QEMU/RAW/VMDK) и параметры кеширования. Далее, как обычно, задаются ограничения по памяти и CPU, выбираются тип и параметры сетевого интерфейса и ещё раз проверяется правильность настроек создаваемой виртуальной машины.

Как и в случае с контейнерами, доступны мониторинг состояния ВМ, вывод ошибок, смена параметров и миграция с одного узла на другой. К сожалению, пока не реализован удобный и простой импорт ВМ из уже имеющихся систем виртуализации внутрь Proxmox VE.

Точно так же мы можем подключиться из веб-интерфейса к виртуальной машине.

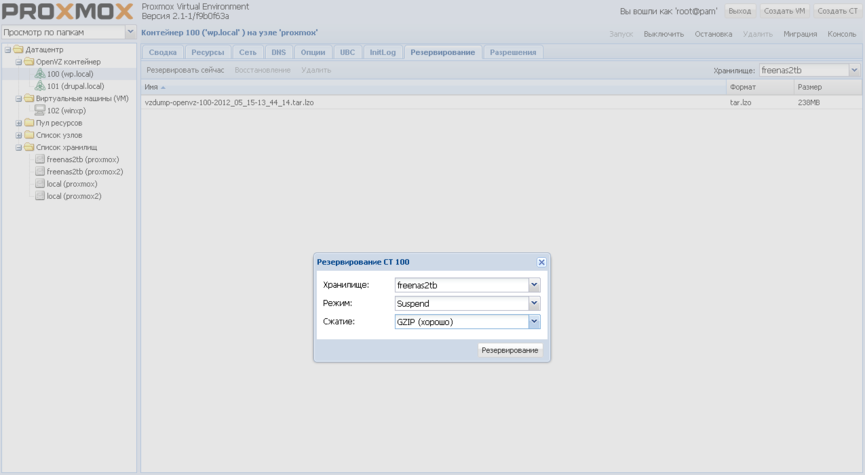

Во-первых, в настройках любой из виртуальных машин на соответствующей вкладке можно сразу же запустить резервное копирование или просмотреть уже имеющиеся бэкапы и при необходимости откатиться к любому из них. На выбор доступно три режима копирования: с полной остановкой и выключением ВМ (самый долгий), с приостановкой работы на время копирования (минимальная задержка для OpenVZ и заметно дольше для KVM), а также с использованием LVM-снапшотов без остановки системы.

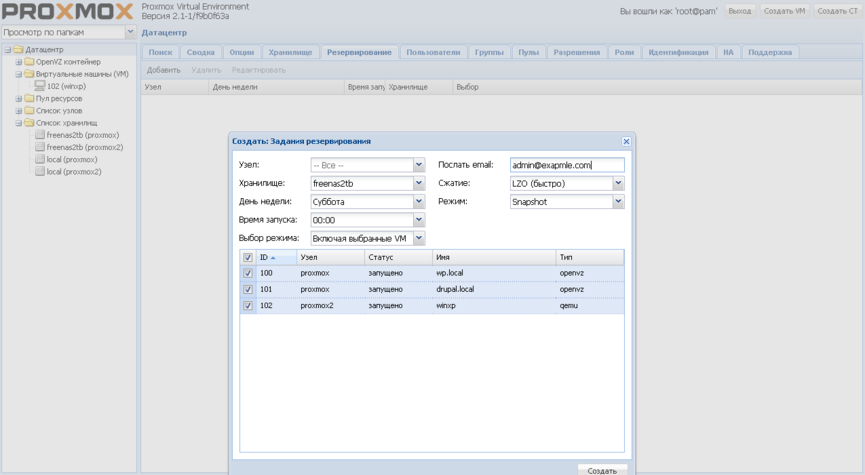

Во-вторых, в Proxmox есть глобальные настройки создания бэкапов по расписанию с возможностью выбора узлов и/или ВМ, режима копирования и уведомлением по почте. Во всех случаях доступно три варианта сжатия копий: без сжатия, LZO и GZIP. Восстановление из бэкапа делается в настройках конкретной машины.

Итак, мы рассмотрели простейший случай развёртывания небольшого кластера на базе Proxmox VE второй версии. Как видите, всё довольно просто настраивается и удобно управляется. Естественно, Proxmox не лишён определённых недостатков. Кому-то не понравится старое ядро, большинству будет недостаточно встроенных средств мониторинга и так далее. Тем не менее это действительно одна из лучших систем управления виртуализацией. За рамками статьи осталось описание таких полезных вещей, как утилиты командной строки или, например, режим High Availability. Более подробную документацию можно найти в вики проекта (правда, в ней пока не все статьи актуальны для второй версии). И ещё: учтите, что вторая версия вышла совсем недавно, поэтому в ней наверняка есть некоторые баги и не до конца реализованные функции. Так что, перед тем как ставить Proxmox VE на “боевые” сервера, хорошенько протестируйте эту систему в тестовом окружении и не забывайте про регулярные обновления. Удачи!